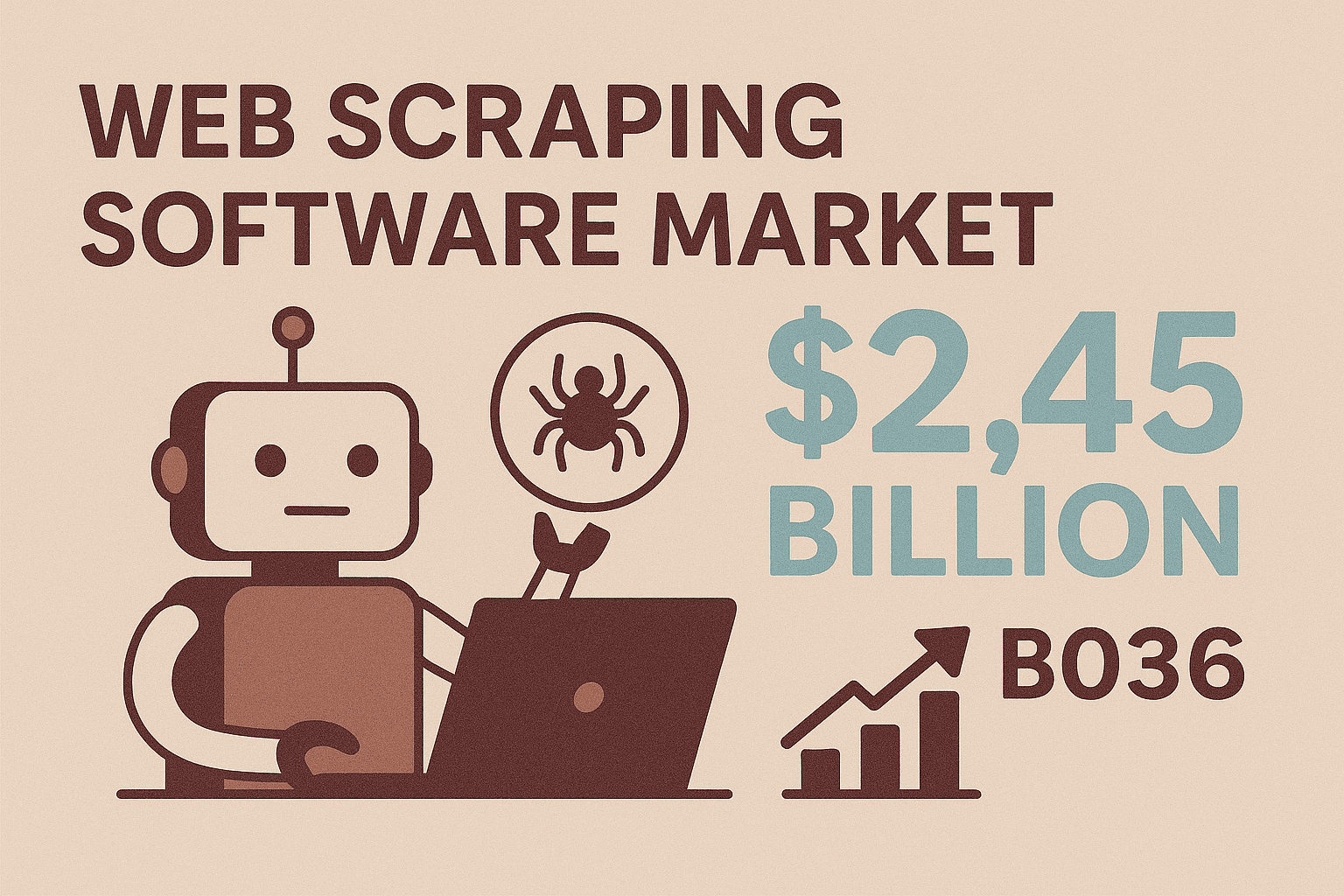

看著腳本在網站上自動飛奔抓資料,自己只要在旁邊喝杯咖啡,真的超有成就感。以前「螢幕爬蟲」還代表著沒完沒了的複製貼上,或是一直拜託 IT 幫忙匯出資料的日子,早就過去了。現在,java 螢幕爬蟲已經被廣泛用在開發銷售名單、即時價格監控等各種場景,而且不再只是資深工程師的專利。根據預測,網頁爬蟲軟體市場到 2036 年會衝到 ,代表各行各業都想用自動化、彈性的方式,把網路上的公開資訊變成有用的商業數據。

如果你是企業用戶、業務或開發者,想從沒有 API 的網站抓結構化資料,java 螢幕爬蟲絕對值得學起來。這篇教學會從基礎觀念開始,介紹熱門 Java 爬蟲函式庫、常見挑戰與解法,還有怎麼善用 這種無程式碼工具來大幅提升效率。不管你想自己寫爬蟲,還是想靠 AI 幫你自動化,都能在這裡找到實用步驟和實戰建議,讓你更聰明、更輕鬆地抓網路資料。

如果你是企業用戶、業務或開發者,想從沒有 API 的網站抓結構化資料,java 螢幕爬蟲絕對值得學起來。這篇教學會從基礎觀念開始,介紹熱門 Java 爬蟲函式庫、常見挑戰與解法,還有怎麼善用 這種無程式碼工具來大幅提升效率。不管你想自己寫爬蟲,還是想靠 AI 幫你自動化,都能在這裡找到實用步驟和實戰建議,讓你更聰明、更輕鬆地抓網路資料。

Java 螢幕爬蟲基礎:什麼是螢幕爬蟲?為什麼重要?

先來聊聊基本概念。java 螢幕爬蟲,就是用 Java 程式自動化從網站抓資料——讓電腦模擬人類在網頁上操作,把你要的資訊撈下來。跟 API 不一樣,API(如果有的話)會直接給你結構化資料,但螢幕爬蟲是直接跟網站前端互動,就像人在 Chrome 或 Firefox 上點一樣。

為什麼這很重要?因為大部分網站——尤其是電商、房仲、B2B 產業目錄——根本沒公開 API 或批次匯出功能。螢幕爬蟲就是解鎖這些「被困住」資料的最佳解法。用 Java,你可以自訂擷取規則、處理登入、模擬點擊,甚至解析複雜的動態內容。這也是為什麼 java 螢幕爬蟲特別適合需要高度客製化、現成工具搞不定的商業需求。

而且需求只會越來越大。導入現代爬蟲工具(尤其是 AI 驅動的)企業,資料擷取任務平均可省下 ,準確率甚至高達 99%。這代表你可以把更多時間花在有價值的分析,而不是重複性勞動。

Java 螢幕爬蟲的關鍵商業應用

那 java 螢幕爬蟲實際上能怎麼用?這裡整理幾個最有感的商業場景:

| 應用場景 | 商業價值 | 實際案例 |

|---|---|---|

| 潛在客戶開發 | 自動收集名單,擴大銷售漏斗,節省大量時間 | 從 LinkedIn 或線上目錄抓取姓名、職稱、Email、電話 |

| 價格監控 | 即時追蹤競爭對手價格,動態調整定價,減少分析人力 | 爬取電商網站每日價格與庫存 |

| 產品資料擷取 | 整合多來源商品資訊,保持目錄即時更新 | 從供應商或競爭對手網站抓取商品名稱、規格、圖片、評論 |

| 市場調查 | 大規模、即時收集資料供分析 | 擷取數百筆商品評論或房地產資訊做趨勢分析 |

| 競爭分析 | 掌握市場動態、監控新功能、分析口碑 | 彙整競爭對手產品頁、顧客評論或新聞報導 |

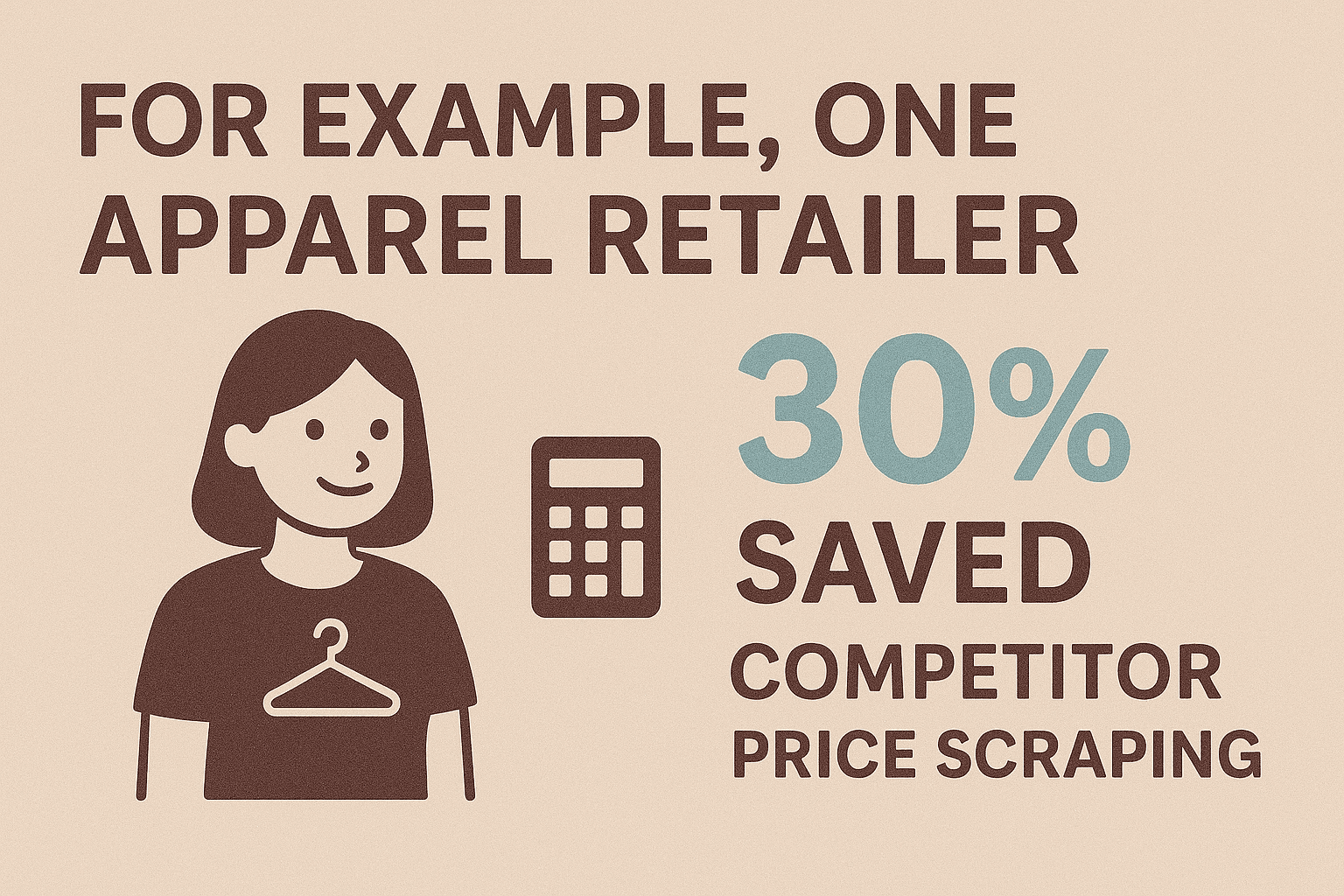

舉例來說,有服飾零售商自動化競爭對手價格爬取後,,同時獲得即時市場情報。業務團隊也能用爬蟲快速建立名單,省下原本要花好幾週的手動整理。而全球 ,讓電商業者更仰賴爬蟲來維持競爭力。

總結:只要你需要網站資料、又沒有 API,螢幕爬蟲通常就是唯一的解法。

總結:只要你需要網站資料、又沒有 API,螢幕爬蟲通常就是唯一的解法。

入門必備:Java 螢幕爬蟲常用工具與函式庫

Java 生態圈有很多強大的爬蟲函式庫,就算不是專職工程師也能很快上手。這裡幫你整理最熱門的選擇:

1. Selenium WebDriver

- 功能說明: 自動操作真實瀏覽器(Chrome、Firefox),能互動動態、JavaScript 網站。

- 適用情境: 需要登入、點擊、模擬用戶行為的網站。

- 優點: 只要人看得到的內容都能抓,適合複雜流程。

- 缺點: 執行速度較慢、資源吃比較多,要安裝瀏覽器驅動。

範例程式碼:

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- 功能說明: 用簡單 API 抓取並解析靜態 HTML。

- 適用情境: 靜態頁面、部落格、新聞、商品列表等。

- 優點: 輕量、快速、超好用,還能容錯處理不規則 HTML。

- 缺點: 沒辦法執行 JavaScript 或 AJAX 載入的內容。

範例程式碼:

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- 功能說明: 在 Java 裡模擬無頭瀏覽器,支援部分 JavaScript。

- 適用情境: 需要瀏覽器行為但不想用 Selenium 的中度動態網站。

- 優點: 不用外部瀏覽器,支援 HTTP、Cookie、簡單腳本。

- 缺點: 對現代 JS 框架支援度不如 Selenium。

範例程式碼:

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. 其他推薦

- WebMagic、Gecco: 適合大規模爬取與多頁資料擷取的高階框架。

- Htmleasy: 超簡單,適合快速原型開發。

Java 螢幕爬蟲函式庫比較

| 函式庫 | 動態內容支援 | 易用性 | 最佳應用情境 |

|---|---|---|---|

| Selenium | 支援 | 中等 | JS 複雜網站、登入、互動流程 |

| Jsoup | 不支援 | 容易 | 靜態頁面、快速原型 |

| HtmlUnit | 部分支援 | 中等 | 輕量無頭爬蟲、簡單 JS |

| Htmleasy | 不支援 | 非常容易 | 簡單靜態網站、快速抓取 |

| WebMagic/Gecco | 不支援 (JS) | 中等 | 大規模爬取、多頁資料 |

快速上手檢查清單:

- 選對函式庫(動態用 Selenium,靜態用 Jsoup)。

- 設定 Java 專案(用 Maven/Gradle 加依賴)。

- 用瀏覽器開發者工具檢查目標網站 HTML 結構。

- 先寫個測試爬蟲,抓一個簡單元素。

- 擴充擷取邏輯,處理分頁。

- 匯出資料(CSV、JSON 或直接寫進資料庫)。

實作教學:打造你的第一個 Java 螢幕爬蟲

以下用 Jsoup 示範怎麼從電商頁面抓商品名稱和價格。

步驟 1:專案設定

在 Maven pom.xml 加入 Jsoup:

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>步驟 2:抓取網頁

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();步驟 3:解析並擷取資料

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}步驟 4:處理分頁

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // 重複擷取邏輯

6 nextLink = doc.selectFirst("a.next");

7}步驟 5:資料匯出(CSV 範例)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Product Name,Price\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();或匯出成 JSON:

1List<Product> products = new ArrayList<>();

2// 在迴圈中填入 products

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());資料輸出格式選擇:JSON、CSV 與更多

- CSV: 適合匯入 Excel、快速分析或分享給非技術同事。

- JSON: 方便程式處理、API 或儲存巢狀資料。

- Excel: 需要原生

.xlsx可用 Apache POI。 - 資料庫: 直接用 JDBC 寫入,適合長期儲存。

根據後續需求選最適合的格式。多數商業用戶偏好 CSV 或 Excel。

克服挑戰:Java 螢幕爬蟲常見問題與解法

螢幕爬蟲不是完全沒阻礙,這裡整理常見難題和對策:

1. 動態內容(JavaScript/AJAX)

- 問題: 資料在頁面渲染後才載入,Jsoup 抓不到。

- 解法: 用 Selenium 操控真實瀏覽器,或分析 AJAX 請求直接模擬。

2. 反爬蟲機制

- 問題: 網站封鎖或限制自動請求。

- 解法: 控制抓取頻率、隨機 User-Agent、輪換 IP、模擬人類行為。大規模爬取可用代理服務或 Selenium 隱身插件。

3. 網站結構變動

- 問題: HTML 結構改變導致選擇器失效。

- 解法: 把選擇器集中管理,優先用穩定的 CSS class 或 data 屬性,並記錄錯誤方便排查。隨時準備調整爬蟲。

4. 資料品質與清理

- 問題: 格式不一、缺值或雜訊多。

- 解法: 用 Java 字串處理和正則表達式即時清理,統一格式(像電話、價格),妥善處理 null 值。

5. 效能與規模

- 問題: 幾千頁資料抓太慢。

- 解法: 用 Java 並行工具(ExecutorService、執行緒池)平行抓,但不要對目標網站太兇。結果即時寫檔避免記憶體爆掉。

更多最佳實踐可以參考 。

為什麼 Thunderbit 是 Java 螢幕爬蟲的最佳拍檔?

接下來聊聊最常見的痛點:維護。自己寫 java 螢幕爬蟲,網站一改版或加上反爬蟲機制,維護起來真的很花時間。這時候, 就超好用。

Thunderbit 是一款 AI 驅動、無程式碼的網頁爬蟲 Chrome 擴充功能,專為商業用戶、業務、行銷人員設計,讓你不用寫一行程式碼就能自動化網路資料收集。它對 Java 開發者和非技術人員都很有幫助,原因如下:

- AI 智慧欄位偵測: 點一下「AI 建議欄位」,Thunderbit 會自動分析頁面,推薦最適合擷取的欄位(像商品名稱、價格、Email 等)。

- 兩步完成爬取: 一鍵讓 AI 找資料,再一鍵開始擷取,完全不用設定選擇器或寫腳本。

- 子頁面擷取: Thunderbit 可自動追蹤連結(像商品詳情頁),自動補充更多資料,完全不用手動編碼。

- 即時範本: 針對熱門網站(Amazon、Zillow、Shopify)提供一鍵套用的結構化爬蟲範本。

- 資料型態辨識: 能自動判斷 Email、電話、日期、圖片等,匯出乾淨、可直接用的資料。

- 無程式碼門檻: 團隊任何人都能用,讓工程師專心做更有價值的事。

- 免維護: 網站結構變動時,只要再點一次「AI 建議欄位」,Thunderbit AI 會自動適應。

Thunderbit 超適合臨時專案、原型開發,或你需要快速抓資料又不想寫程式時,效率直接拉滿。

Thunderbit 結合 Java:打造完整資料自動化流程

當你把 Thunderbit 的易用性和 Java 的強大處理能力結合,資料流程就能無縫自動化。操作步驟如下:

- 用 Thunderbit 擷取資料: 先用 Thunderbit 從目標網站抓資料,可排程定時爬取,或直接套用熱門網站範本。

- 匯出資料: 把結果匯出成 CSV、Excel、、Airtable 或 Notion,Java 都能輕鬆讀取。

- 用 Java 處理: 寫 Java 程式讀取匯出資料(像用 Google Sheets API 或直接讀 CSV),進行清理、加值,並整合到內部系統(CRM、資料庫、分析平台)。

- 自動化流程: 設定 Thunderbit 定時執行,每次爬取後自動觸發 Java 處理腳本,讓整個資料流程全自動運作。

舉例: 假設業務團隊每週一都要最新名單,Thunderbit 負責爬取並匯出到 Google Sheets,Java 程式自動讀取、去重、匯入 CRM。網站結構變動時,只需調整 Thunderbit 設定,Java 程式完全不用重寫。

這種混合模式讓你同時享有 Thunderbit 的彈性和 Java 的強大整合力。

進階技巧:Java 螢幕爬蟲的自動化與擴展

隨著需求變大,你可以這樣擴展和自動化:

- 平行處理: 用 Java 執行緒池同時抓多頁,但要控制併發數避免被封鎖。

- 排程: 用 Java Quartz 套件自動排程,或直接用 Thunderbit 內建排程(用自然語言描述即可)。

- 錯誤處理: 加入重試、逾時、失敗通知(Email 或 Slack)。

- 雲端爬取: Thunderbit 雲端模式可同時抓 50 頁,適合大規模任務又不佔用本機資源。

- 維護管理: 文件化爬蟲、集中管理選擇器、記錄異常方便排查。用 Thunderbit 時,多數更新只要再點一次「AI 建議欄位」就好。

如果要抓數百萬頁,建議用 Apache Nutch 這種分散式框架或雲端爬蟲 API,但多數商業應用,Thunderbit 搭配 Java 就能輕鬆搞定。

結論與重點整理

java 螢幕爬蟲是解鎖網路資料的超強工具,不管你是要建立名單、追蹤競爭對手,還是做市場調查,都能大幅提升效率。重點如下:

- Java 提供彈性與控制力,適合需要自訂、複雜邏輯的爬蟲,尤其是登入、動態內容或特殊商業需求。

- Thunderbit 帶來 AI 驅動、無程式碼的簡單體驗,讓任何人都能快速上手,設定時間從數小時縮短到幾分鐘。

- 兩者結合,可打造快速又穩定的資料流程:Thunderbit 負責擷取,Java 負責處理與整合。

- 自動化與擴展,用平行處理、排程、雲端爬取,免除繁瑣維護。

- 未來趨勢是混合模式: 隨著 Thunderbit 等 AI 工具越來越聰明,最佳做法將是程式碼與無程式碼並用,效率最大化。

準備好提升你的資料擷取效率了嗎?,試著打造你的第一個 Java 爬蟲,看看能省下多少時間和精力。更多技巧和深度教學,歡迎來 挖寶。

常見問題

1. 什麼是 java 螢幕爬蟲?和一般網頁爬蟲有什麼不同?

java 螢幕爬蟲就是用 Java 程式直接從網站前端(也就是瀏覽器看到的畫面)抓資料,特別適合沒有 API 的情境。其實這也是一種網頁爬蟲,只是「螢幕爬蟲」強調像人類一樣從畫面抓資料,而不是從後端結構化來源。

2. 什麼時候該用 Java 寫爬蟲,而不是無程式碼工具?

當你需要自訂邏輯、處理複雜登入、互動動態內容,或要和內部系統深度整合時,建議用 Java。Thunderbit 這類無程式碼工具則適合快速任務、原型開發,或讓非技術人員也能參與。

3. java 螢幕爬蟲最常見的挑戰有哪些?怎麼解決?

常見問題有動態內容(用 Selenium 解決)、反爬蟲(加延遲、代理、真實 headers)、網站結構變動(集中管理選擇器)、資料清理(用 Java 字串和正則處理)。大規模任務則需用並行和健全錯誤處理。

4. Thunderbit 如何補足 java 螢幕爬蟲?

Thunderbit 的 AI Chrome 擴充功能讓你不用寫程式就能從任何網站抓資料,適合臨時任務、原型開發,或你想省下維護時間時。匯出資料格式也能直接給 Java 處理,打造無縫資料流程。

5. Thunderbit 和 Java 能自動化整個資料流程嗎?

當然可以!用 Thunderbit 定時爬取,匯出到 Google Sheets 或 CSV,再用 Java 程式自動讀取、處理、整合。這種混合模式兼具 Thunderbit 的速度與彈性,以及 Java 的強大整合力。