2025 年的網路世界真的超級熱鬧——你現在在網路上看到的流量,其實有一半都不是人類在操作。沒錯,現在超過 50% 的網路活動都是機器人和爬蟲在跑(),而真正「有幫助」的好爬蟲(像搜尋引擎、社群媒體預覽、分析工具)其實只佔很小一部分。剩下的那些?說好聽是來幫忙,其實大多數時候都在搗蛋。身為一個長期在 打造自動化和 AI 工具的工程師,我很清楚一個爬蟲的好壞,會直接影響你的 SEO 排名、數據分析、頻寬消耗,甚至可能引發資安危機。

如果你有經營網站、管理企業數位資產,或只是想守住自己的網路家園,現在比任何時候都更需要搞清楚「誰」在敲你伺服器的門。所以我整理了這份 2025 年最重要的爬蟲清單指南——帶你認識這些機器人、怎麼辨識、以及如何讓好爬蟲順利通行、壞爬蟲無法亂來。

什麼是「知名」爬蟲?User-Agent、IP 與驗證方法

先來釐清基本觀念:什麼叫「知名」爬蟲?簡單說,就是那些會用固定 user-agent(像 Googlebot/2.1 或 bingbot/2.0)自我標示,並且(理論上)會從公開的 IP 範圍或 ASN 區塊來抓資料的機器人()。主流大廠像 Google、Microsoft、百度、Yandex、DuckDuckGo 都會公開自家爬蟲的說明文件,甚至直接給你官方 IP 清單或 JSON 檔(、、)。

但問題來了:只看 user-agent 很危險。因為偽裝太簡單,很多惡意爬蟲會假冒 Googlebot 或 Bingbot 混進你的網站()。所以最保險的做法是雙重驗證:同時檢查 user-agent 和 IP(或 ASN),用反向 DNS 查詢或官方清單來比對。如果你用 ,這些流程都能自動化——從日誌提取、user-agent 比對、IP 交叉驗證,快速建立一份即時又可靠的爬蟲清單。

如何善用這份爬蟲清單

那麼,拿到一份知名爬蟲清單後該怎麼用?這裡有幾個實用建議:

- 白名單管理: 確保你想要的爬蟲(搜尋引擎、社群預覽)不會被防火牆、CDN 或 WAF 誤擋。用官方 IP 和 user-agent 精準設置白名單。

- 分析數據過濾: 把機器人流量從網站分析中排除,讓你的數據只反映真實訪客,而不是 Googlebot、AhrefsBot 在你網站上繞圈圈()。

- 爬蟲管理: 對於過於頻繁的 SEO 工具爬蟲,設置 crawl-delay 或限速規則,對未知或惡意爬蟲則直接封鎖或驗證。

- 自動化日誌分析: 利用 AI 工具(像 Thunderbit)自動提取、分類、標註日誌中的爬蟲活動,方便你追蹤趨勢、辨識偽裝者,並隨時調整政策。

維護爬蟲清單不是「設好就沒事」的工作。新爬蟲不斷冒出來,舊的行為也會變,攻擊者每年都在進化。用 Thunderbit 自動抓取官方文件或 GitHub 資源,真的能幫你省下超多時間和麻煩。

1. Thunderbit:AI 驅動的爬蟲識別與數據管理

不只是人工智慧網頁爬蟲,更是專為團隊打造的數據助理,幫你全面掌握和管理爬蟲流量。Thunderbit 有哪些厲害的地方?

- 語意前處理: Thunderbit 會先把網頁和日誌轉成 Markdown 結構化內容,讓 AI 能真正理解上下文、欄位和邏輯。這對於複雜、動態或 JavaScript 很重的頁面(像 Facebook Marketplace 或長留言串)特別有效,傳統 DOM 型爬蟲常常搞不定。

- 雙重驗證: Thunderbit 能自動收集官方爬蟲 IP 文件和 ASN 清單,並和你的伺服器日誌比對,建立一份真正可信的「爬蟲白名單」,省去人工交叉檢查的麻煩。

- 自動化日誌提取: 只要把原始日誌交給 Thunderbit,就能自動轉成結構化表格(Excel、Sheets、Airtable),還會標註高頻訪客、可疑路徑和知名機器人。你還能把結果串接到 WAF 或 CDN,自動封鎖、限速或加上驗證碼。

- 合規與稽核: Thunderbit 的語意提取會保留完整稽核紀錄——誰、什麼時候、怎麼存取過你的網站,方便應對 GDPR、CCPA 等合規需求。

很多團隊用 Thunderbit 之後,爬蟲管理工作量直接少掉 80%,終於能清楚分辨哪些機器人是幫手、哪些是麻煩、哪些又是假冒的。

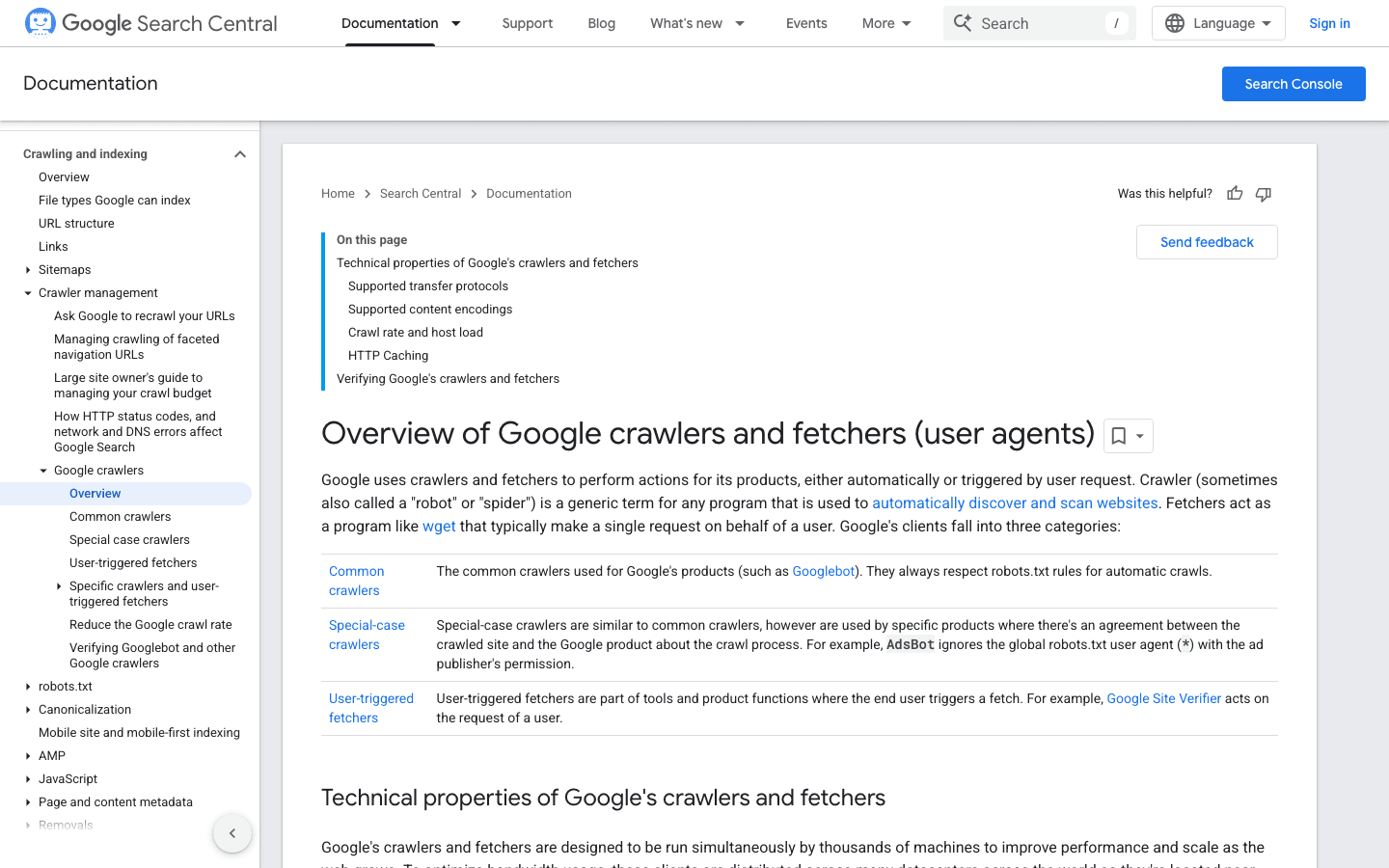

2. Googlebot:搜尋引擎的標竿

是網頁爬蟲的黃金標準,負責讓你的網站被 Google 搜尋收錄——如果擋掉它,等於自家網站直接掛上「暫停營業」的牌子。

- User-Agent:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - 驗證方式: 用 或 。

- 管理建議: 一定要讓 Googlebot 通行。用 robots.txt 指導(不要封鎖)它抓取,必要時可在 Google Search Console 調整抓取速率。

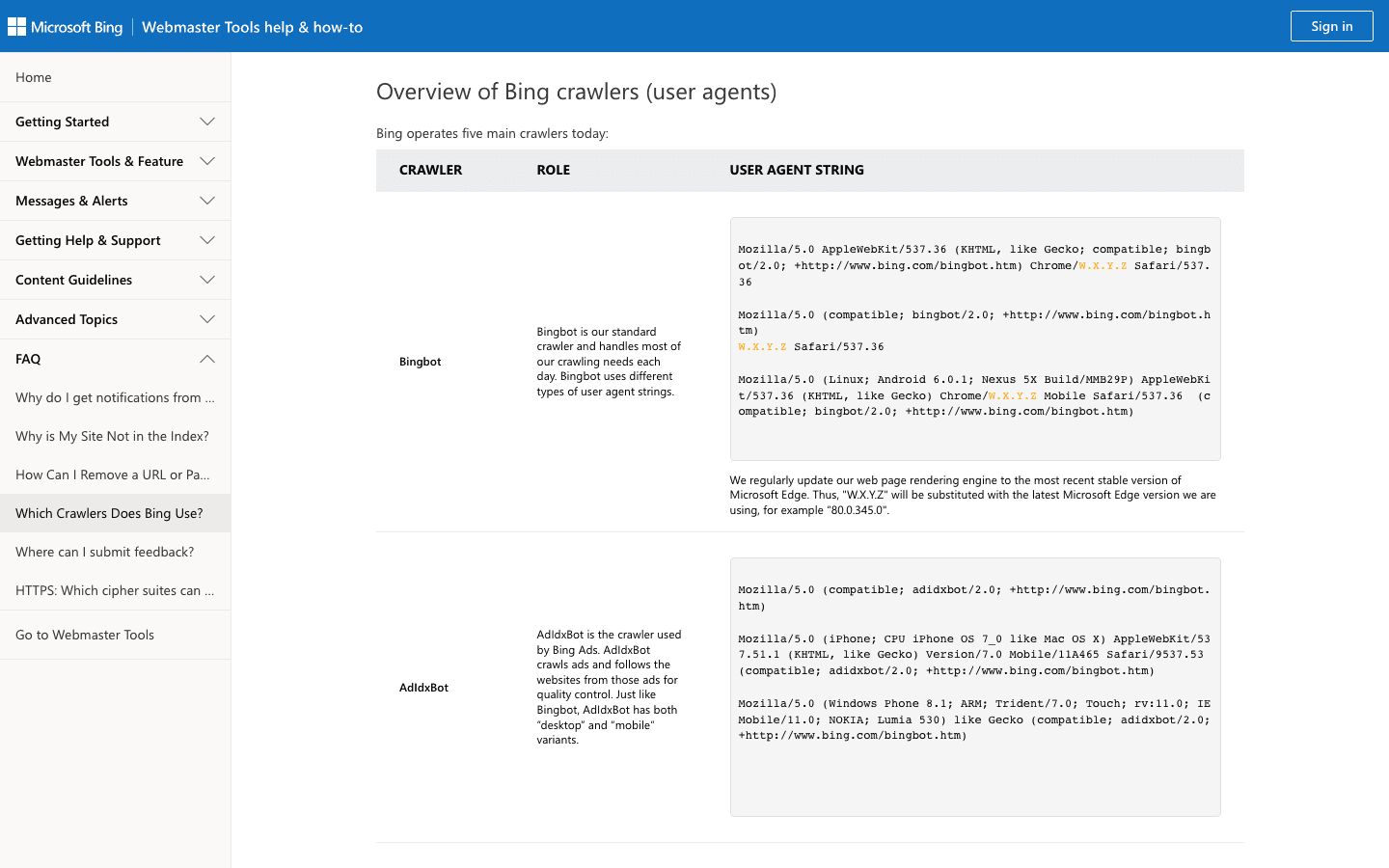

3. Bingbot:微軟的網路探索者

為 Bing 和 Yahoo 搜尋提供資料,是多數網站僅次於 Googlebot 的重要爬蟲。

- User-Agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - 驗證方式: 用 和 。

- 管理建議: 允許 Bingbot,並可在 Bing Webmaster Tools 調整抓取速率,利用 robots.txt 微調規則。

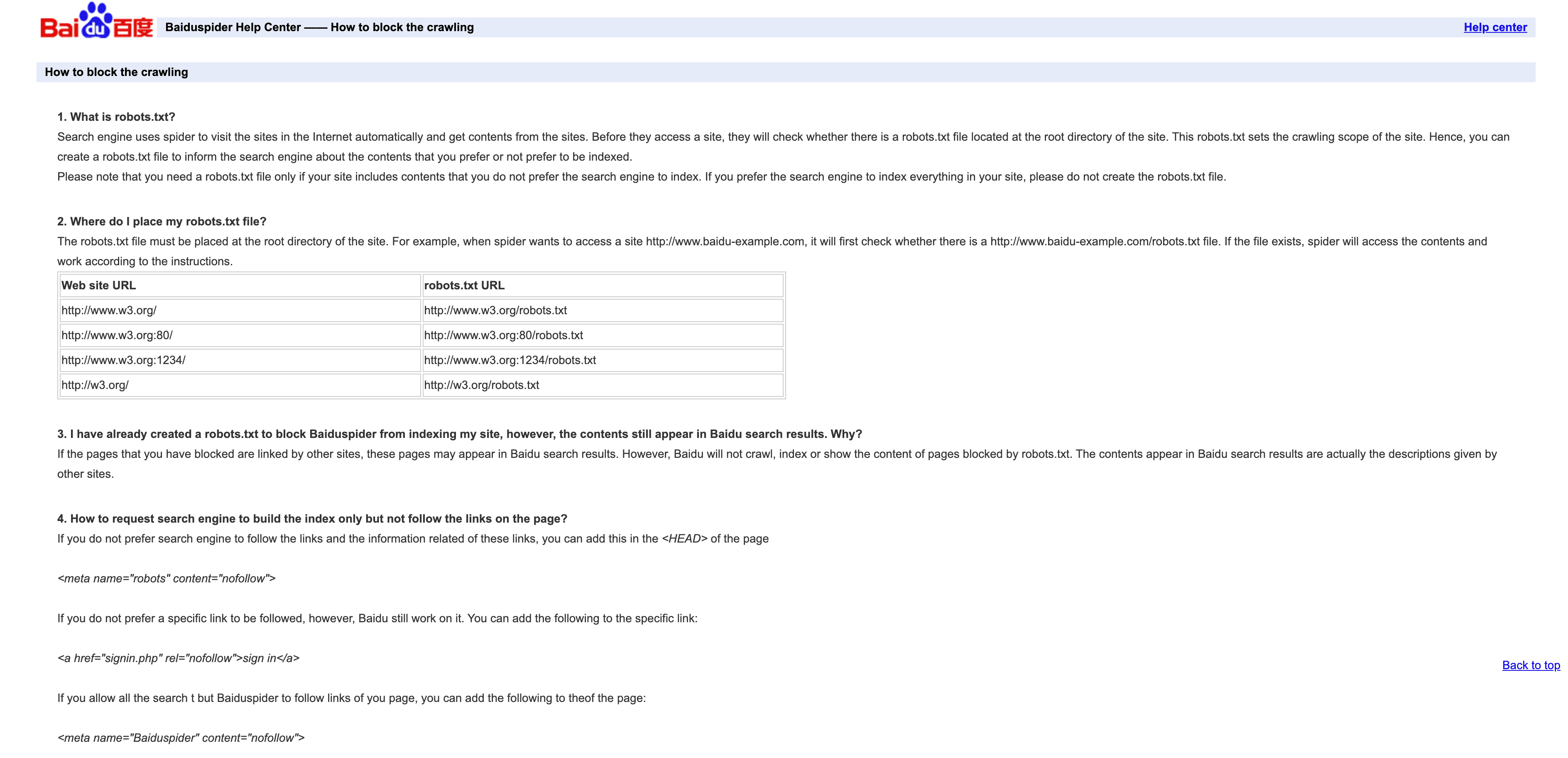

4. Baiduspider:中國主流搜尋爬蟲

是進入中國搜尋市場的關鍵角色。

- User-Agent:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - 驗證方式: 沒有官方 IP 清單,可用反向 DNS 查

.baidu.com,但有其限制。 - 管理建議: 想要中國流量建議允許。可用 robots.txt 設定規則,但 Baiduspider 有時會忽略。若不需要中國 SEO,可考慮限速或封鎖以省頻寬。

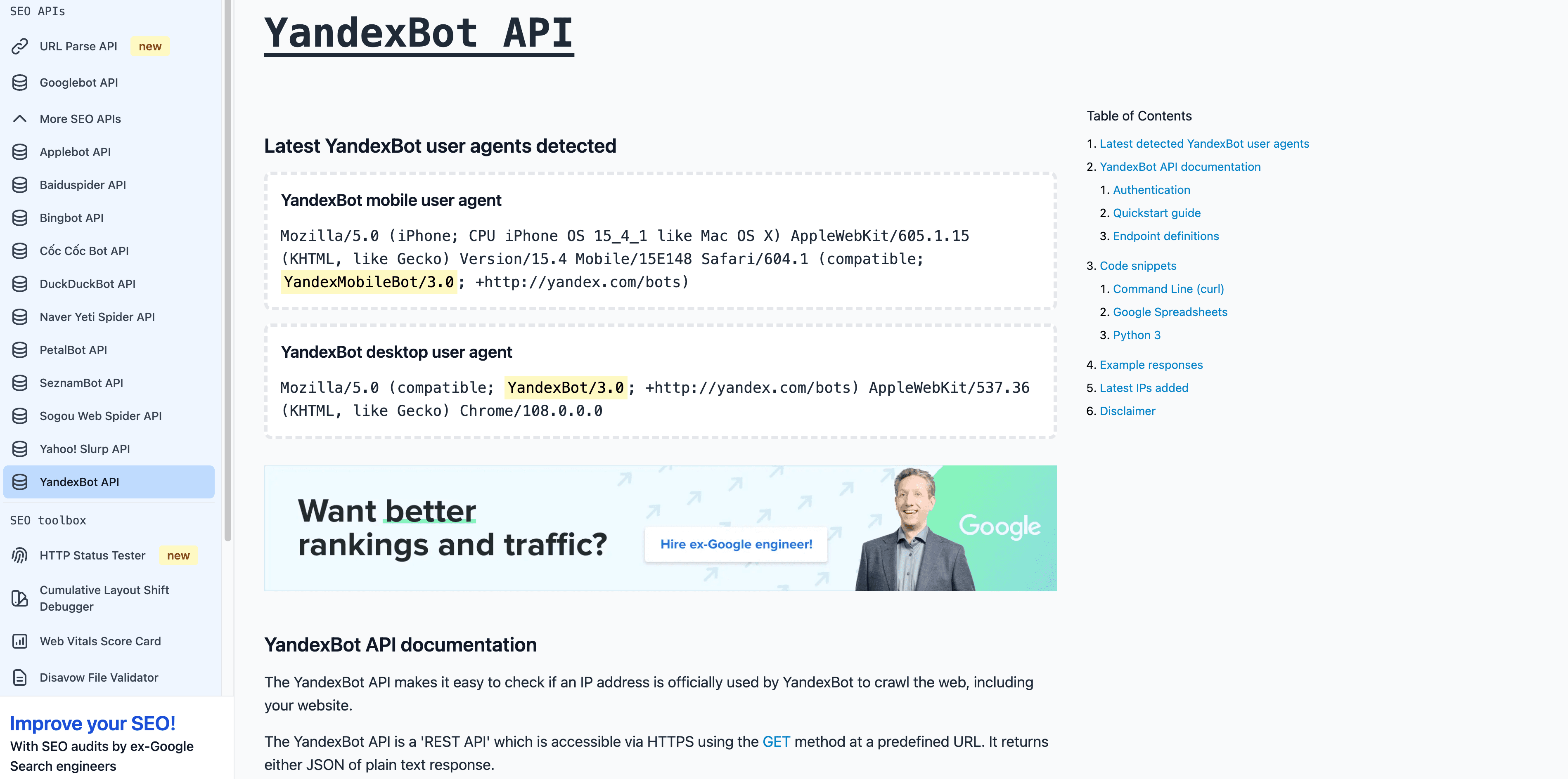

5. YandexBot:俄語市場搜尋爬蟲

是俄羅斯和獨聯體市場的必備爬蟲。

- User-Agent:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - 驗證方式: 反向 DNS 結尾應為

.yandex.ru、.yandex.net或.yandex.com。 - 管理建議: 目標是俄語用戶就建議允許。可用 Yandex Webmaster 控制抓取。

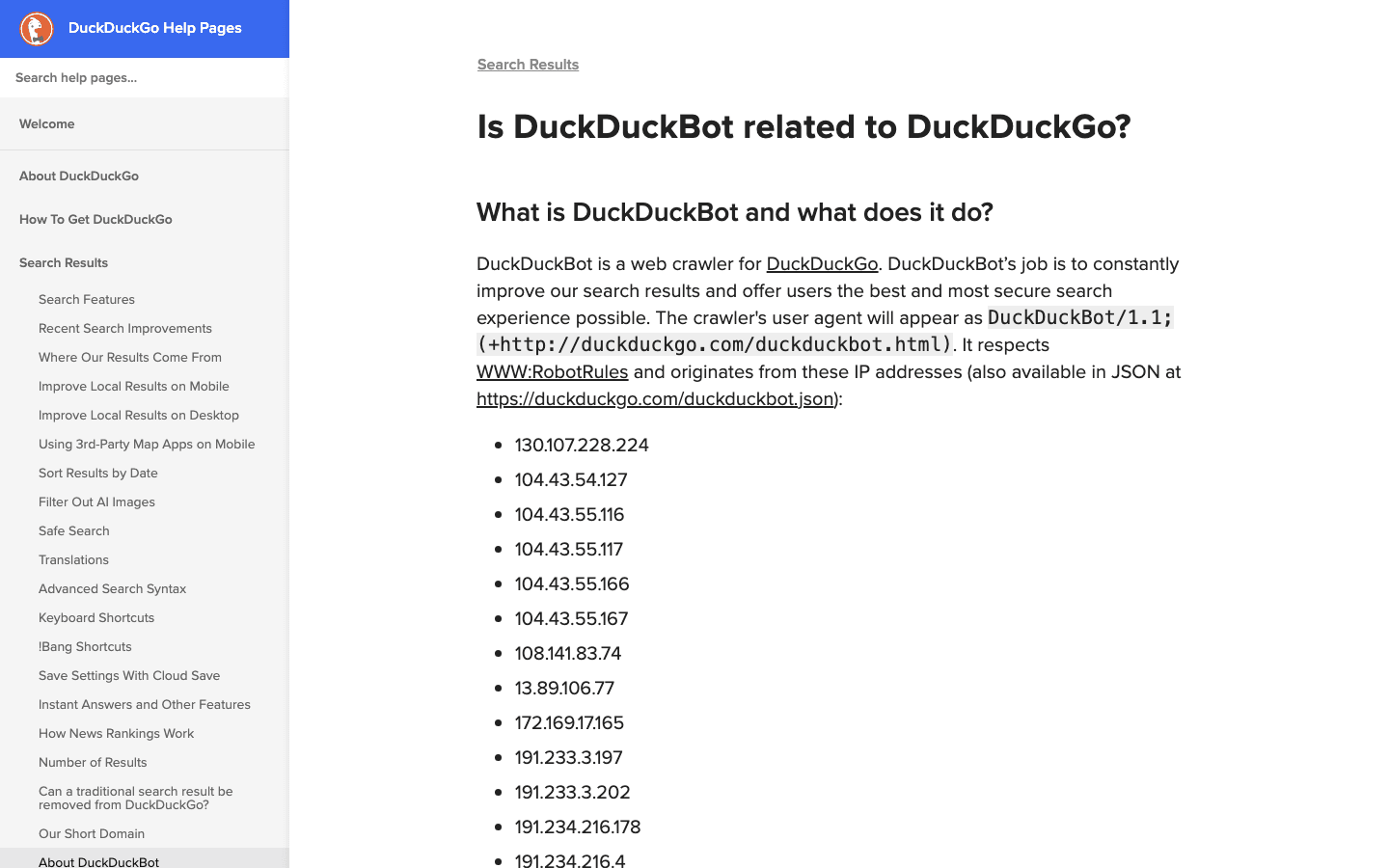

6. DuckDuckBot:重視隱私的搜尋爬蟲

是 DuckDuckGo 的隱私導向搜尋爬蟲。

- User-Agent:

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - 驗證方式: 。

- 管理建議: 除非完全不在意隱私用戶,否則建議允許。抓取頻率低,管理起來很簡單。

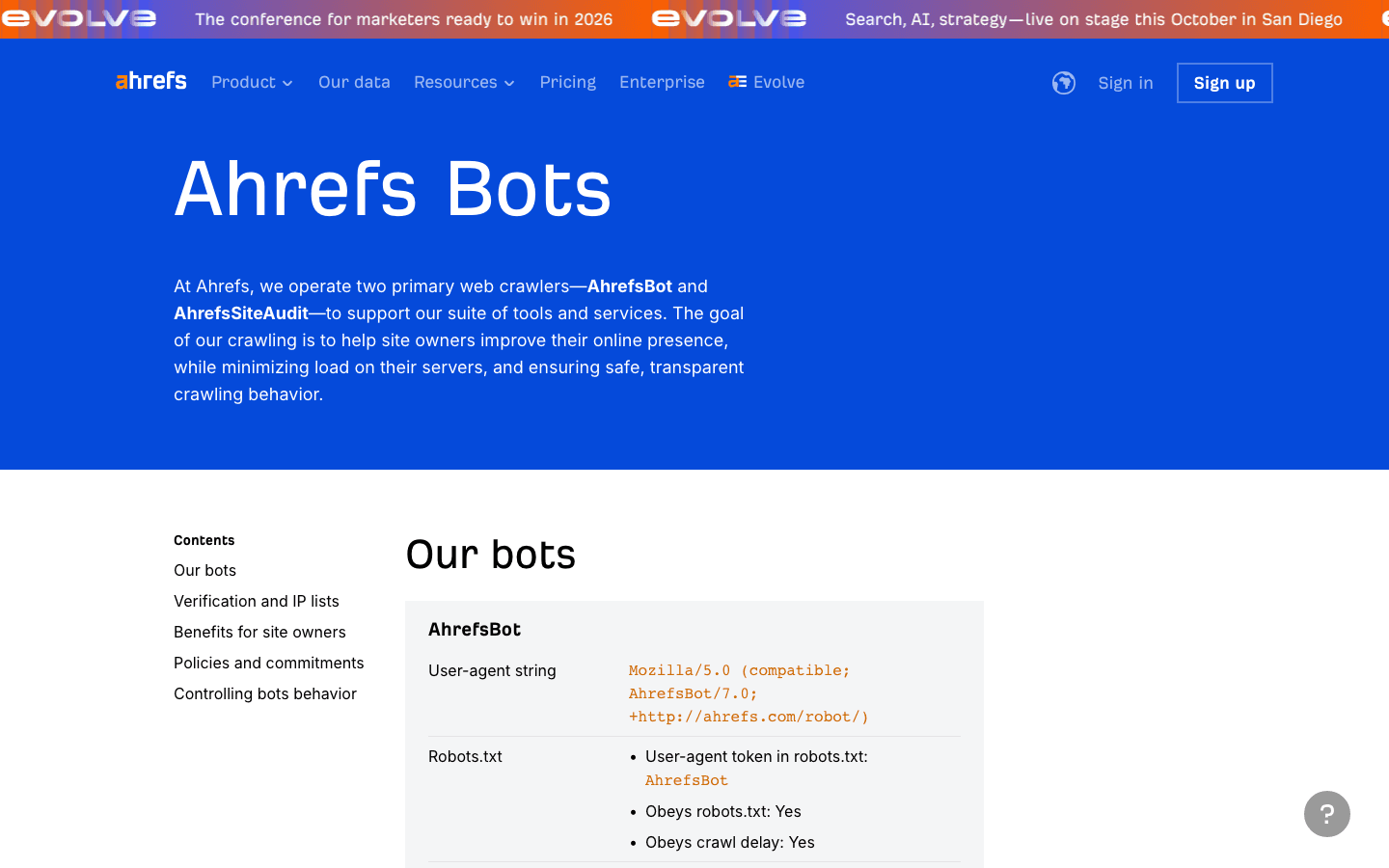

7. AhrefsBot:SEO 與反向連結分析

是熱門的 SEO 工具爬蟲,適合做反向連結分析,但流量消耗比較大。

- User-Agent:

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - 驗證方式: 沒有公開 IP 清單,只能用 UA 和反向 DNS 驗證。

- 管理建議: 有用 Ahrefs 建議允許。可用 robots.txt 設定 crawl-delay 或封鎖。也可。

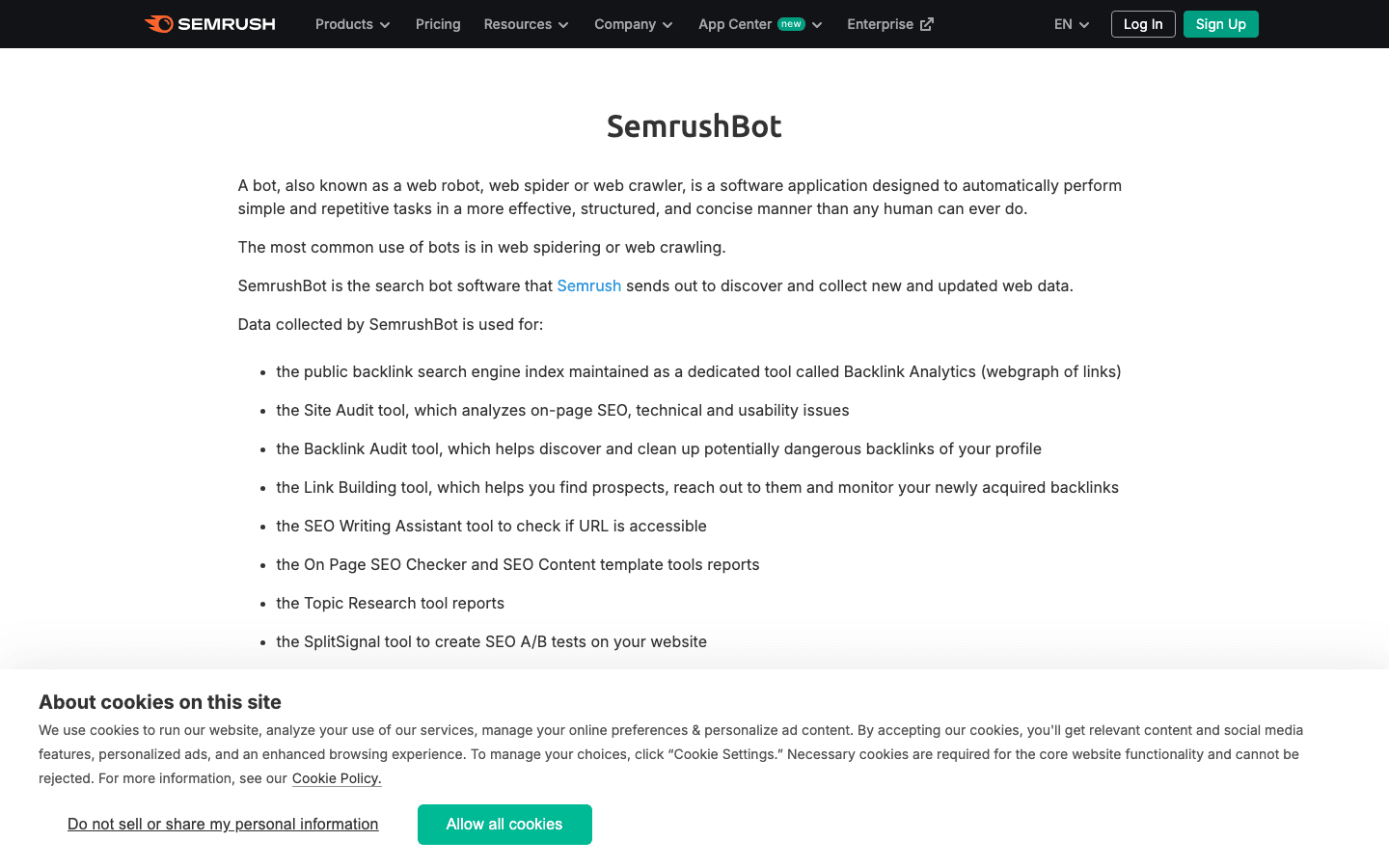

8. SemrushBot:競爭對手 SEO 洞察

是另一大 SEO 工具爬蟲。

- User-Agent:

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(還有如SemrushBot-BA、SemrushBot-SI等變體) - 驗證方式: 主要靠 user-agent,沒有公開 IP 清單。

- 管理建議: 有用 Semrush 建議允許,否則可用 robots.txt 或伺服器規則限速或封鎖。

9. FacebookExternalHit:社群媒體預覽爬蟲

用於 Facebook 和 Instagram 連結預覽時抓取 Open Graph 資料。

- User-Agent:

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - 驗證方式: 主要看 user-agent,IP 屬於 Facebook ASN。

- 管理建議: 建議允許,否則 Facebook/Instagram 分享時不會顯示縮圖或摘要。

10. Twitterbot:X(Twitter)連結預覽爬蟲

用於 X(Twitter)抓取 Twitter Card 資料。

- User-Agent:

Twitterbot/1.0 - 驗證方式: 主要看 user-agent,Twitter ASN(AS13414)。

- 管理建議: 建議允許,並加上 Twitter Card meta 標籤,這樣預覽效果最好。

一覽表:主流爬蟲快速比較

| 爬蟲 | 用途 | User-Agent 範例 | 驗證方式 | 商業影響 | 管理建議 |

|---|---|---|---|---|---|

| Thunderbit | AI 日誌/爬蟲分析 | N/A(工具,非爬蟲) | N/A | 數據管理、機器人分類 | 用於日誌提取、白名單建立 |

| Googlebot | Google 搜尋收錄 | Googlebot/2.1 | DNS & IP 清單 | SEO 關鍵 | 必須允許,Search Console 管理 |

| Bingbot | Bing/Yahoo 搜尋 | bingbot/2.0 | DNS & IP 清單 | Bing/Yahoo SEO 重要 | 允許,Bing Webmaster Tools 管理 |

| Baiduspider | 百度搜尋(中國) | Baiduspider/2.0 | 反向 DNS、UA 字串 | 中國 SEO 關鍵 | 目標中國建議允許,注意頻寬 |

| YandexBot | Yandex 搜尋(俄羅斯) | YandexBot/3.0 | 反向 DNS 至 .yandex.ru | 俄羅斯/東歐市場關鍵 | 目標 RU/CIS 建議允許,Yandex 工具管理 |

| DuckDuckBot | DuckDuckGo 搜尋 | DuckDuckBot/1.1 | 官方 IP 清單 | 隱私用戶族群 | 允許,影響低 |

| AhrefsBot | SEO/反向連結分析 | AhrefsBot/7.0 | UA 字串、反向 DNS | SEO 工具,流量大 | 允許/限速/封鎖,robots.txt 管理 |

| SemrushBot | SEO/競爭分析 | SemrushBot/1.0(含變體) | UA 字串 | SEO 工具,可能較積極 | 允許/限速/封鎖,robots.txt 管理 |

| FacebookExternalHit | 社群連結預覽 | facebookexternalhit/1.1 | UA 字串、Facebook ASN | 社群互動 | 允許預覽,使用 OG 標籤 |

| Twitterbot | Twitter 連結預覽 | Twitterbot/1.0 | UA 字串、Twitter ASN | Twitter 互動 | 允許預覽,使用 Twitter Card 標籤 |

2025 年爬蟲清單管理最佳實踐

- 定期更新: 爬蟲生態變化超快,建議每季檢查一次,並用 Thunderbit 等工具自動抓取、比對官方清單()。

- 驗證而非信任: 一定要同時檢查 user-agent 和 IP/ASN,別讓偽裝者混進來影響你的數據或偷資料()。

- 白名單好爬蟲: 搜尋和社群爬蟲絕對不能被防火牆或反機器人規則誤擋。

- 限速或封鎖過度爬蟲: 對於太積極的 SEO 工具,利用 robots.txt、crawl-delay 或伺服器規則控管。

- 自動化日誌分析: 用 AI 工具(像 Thunderbit)自動提取、分類、標註爬蟲活動,省時又能發現趨勢。

- 平衡 SEO、分析與資安: 別擋掉對你有幫助的爬蟲,也別讓壞爬蟲亂來。

結語:讓你的爬蟲清單隨時有效、可用

到了 2025 年,管理爬蟲清單早就不是 IT 人員的例行公事,而是關乎 SEO、數據分析、資安和合規的關鍵任務。當機器人流量已經超過一半,你一定要清楚知道誰在拜訪、目的為何、該怎麼應對。保持清單最新、能自動化就自動化,並善用 這類工具,才能在這個機器人橫行的網路世界中穩穩站住腳。

常見問答

1. 為什麼要維護最新的爬蟲清單?

因為現在超過一半的網路流量來自機器人,真正有益的只佔少數。保持清單最新,才能讓好爬蟲(SEO、社群預覽)順利通行,壞爬蟲則能及時封鎖或限速,保護你的數據、頻寬和資安。

2. 如何分辨爬蟲是真還是假?

絕對不能只看 user-agent,一定要用官方清單或反向 DNS 查 IP 或 ASN。Thunderbit 這類工具能自動比對日誌和官方 bot IP、user-agent,省時又精準。

3. 如果有未知爬蟲抓取我的網站怎麼辦?

先查 user-agent 和 IP,若不在白名單、也不是已知爬蟲,建議限速、驗證或直接封鎖。可以用 AI 工具持續監控、分類新出現的爬蟲。

4. Thunderbit 如何協助爬蟲管理?

Thunderbit 利用 AI 從日誌中提取、結構化、分類爬蟲活動,讓你輕鬆建立白名單、辨識偽裝者、自動執行政策。它的語意前處理對複雜或動態網站特別強大。

5. 如果誤封 Googlebot 或 Bingbot 會有什麼風險?

封鎖搜尋引擎爬蟲會讓你的網站從搜尋結果消失,流量大減。一定要檢查防火牆、robots.txt 和反機器人規則,避免誤擋最重要的爬蟲。

延伸閱讀: