什麼是亞馬遜網頁爬蟲

亞馬遜網頁爬蟲是一種可以自動從 抓取資料的工具或軟體。它能批量擷取商品資訊、價格、評論、庫存狀態等各種數據。使用亞馬遜網頁爬蟲的主要目的是做市場調查、價格比價或競爭分析。你也能收集用戶評論、做關鍵字研究,深入了解產品的優缺點。

亞馬遜網頁爬蟲的主要功能

- 自動化數據擷取:再也不用一條條手動複製貼上,爬蟲能自動從網頁抓下你要的資料。

- 自訂抓取內容:可以根據需求調整爬蟲,精準擷取特定欄位,方便做有針對性的分析。

- 數據匯出:輕鬆把抓到的資料匯出成 Excel、CSV 或 JSON 等常見格式,後續分析超方便。

- 定時更新:能設定定期自動抓取,讓你的亞馬遜商品資料庫隨時保持最新。

- 評論擷取:經常需要從評論區抓優缺點,幫助你做競爭分析。

為什麼要用亞馬遜網頁爬蟲

亞馬遜是全球電商龍頭,商品種類超多、價格有競爭力、購物體驗又順暢。它讓企業能接觸全球消費者,協助商家拓展市場。消費者信任亞馬遜作為主要線上購物平台,商家也能在這裡享有穩定銷售環境。再加上亞馬遜物流體系超完善,商家能提供快速又高效的配送,顧客滿意度自然提升。亞馬遜還有各種行銷工具,像是贊助商品廣告、品牌推廣等,幫助商品曝光、提升銷售。

對電商企業來說,分析亞馬遜上的銷售數據非常重要。透過亞馬遜網頁爬蟲,企業能收集大量數據,洞察市場趨勢、了解消費者行為,優化商品策略、管理庫存。這有助於企業在亞馬遜平台上有效擴展,提升銷售和品牌知名度,實現長遠成長。以下是亞馬遜網頁爬蟲的幾種應用方式:

市場調查

-

SKU 選品

選對 SKU(庫存單位) 是電商成功的關鍵,影響商品組合、供應鏈效率和庫存管理。用亞馬遜網頁爬蟲,你可以從數百萬商品中精準抓取數據,分析銷售趨勢和消費者偏好。像是抓取亞馬遜商品詳情頁,就能快速取得價格、評論數、賣家評分等關鍵資訊,深入做市場分析。這些數據能幫你判斷 SKU 是否有市場潛力,找出表現最好的商品。透過同類商品比較,企業能優化選品策略,增加熱賣 SKU 庫存,減少滯銷品,提升庫存周轉率。

-

洞察消費趨勢

大量抓取商品評論、評分和用戶回饋,能幫你快速掌握消費需求變化。像是分析評論內容,可以發現消費者最在意的產品特點,例如「價格實惠」或「耐用度高」。這些資訊對產品開發、定價策略和行銷規劃都很重要。再加上分析購買頻率和銷售趨勢,還能預測季節性銷售波動,提前規劃庫存和行銷活動。

競爭分析

-

價格監控

在競爭激烈的市場,價格監控是電商必備的工作。亞馬遜網頁爬蟲能即時抓取商品價格,追蹤競爭對手的價格變動,確保你的定價策略有競爭力。這對實施動態定價策略特別有用。收集同類商品價格資訊後,企業可以建立彈性定價模型,根據市場需求、庫存狀況和競品價格自動調整售價,最大化利潤。

-

評論分析

不只影響銷售,也反映市場需求變化。亞馬遜網頁爬蟲能幫企業大量收集顧客回饋。結合 AI 技術,還能自動摘要評論、做情感分析,深入了解消費者對自家和競品的看法,及時調整產品設計或行銷策略。

成本比較

利用亞馬遜網頁爬蟲,企業可以收集同類商品的價格、運費、促銷等資訊,做全面成本比較。這有助於優化成本結構,避免不必要的支出,提升毛利率。如果你在亞馬遜找供應商,也能比較不同賣家的運費和售價,降低採購成本,確保市場競爭力。

體驗 AI 網頁爬蟲

立即體驗!你可以邊看邊操作,完整流程一目了然。

為什麼用 AI 抓取亞馬遜商品數據

隨著 AI 技術突飛猛進,AI 驅動的亞馬遜網頁爬蟲正帶來數據抓取新革命,讓傳統爬蟲流程更高效、更精準,也大幅降低技術門檻,為電商帶來更多創新可能。

零技術門檻,人人都能用

對沒有技術背景的用戶來說,AI 支援的亞馬遜網頁爬蟲超級友善。傳統爬蟲要寫程式、調 API,AI 工具只要輸入抓取需求、選欄位名稱,AI 就能自動產生合適的抓取方案和建議,完全不用煩惱程式設置。這種易用性讓電商團隊即使沒有工程師,也能高效取得數據,提升團隊生產力,讓非技術人員也能輕鬆用上先進的數據收集工具。

快速又高效

能自動化數據擷取流程,大幅提升抓取速度和效率。它能快速處理複雜網頁結構和動態內容,精準擷取目標數據,減少人工干預,提升整體準確率。而且, 也能有效降低營運成本、優化工作流程,讓企業用更低成本取得高品質數據,為決策提供更精確依據。

智能分析與建議

跟傳統爬蟲比起來, 有智能化自動流程優勢。AI 工具能自動分類、摘要數據並給出洞察。例如,企業可以用 AI 自動將不同商品歸類,或分析大量評論數據,提取關鍵字和情感趨勢,幫助更好理解消費者回饋、優化產品。AI 也能根據抓取數據自動產生客製化報告,快速產出市場分析,協助企業掌握熱門商品特徵和潛在商機。

智慧輸出與多元匯出選項

AI 亞馬遜網頁爬蟲支援更彈性的數據輸出。傳統程式多只能匯出 CSV,AI 工具則同時支援 CSV,還能自動把數據匯出到 Google Sheets、Notion 等協作平台,讓數據分析和團隊共享更方便。像是你可以直接把數據導入 Google Sheets 做即時分析,或整合到團隊協作工具,確保部門間資訊流通順暢。這種智慧匯出方式,讓決策更即時,提升企業反應速度和彈性。

用 抓取:全新

是一款全新推出、功能強大又全面的 ,能滿足各種數據需求。透過 Thunderbit,不論是商品詳情、價格變化還是用戶評論,都能輕鬆抓取並轉化成有價值的商業洞察。以下介紹 Thunderbit 如何幫助電商提升競爭力。

首先,前往 ,把 Thunderbit 加到 Chrome 瀏覽器,然後用 Google 帳號或其他信箱登入。

接下來,你可以選擇 Thunderbit 內建的預設網頁爬蟲,或用 來。操作方式如下:

接下來,你可以選擇 Thunderbit 內建的預設網頁爬蟲,或用 來。操作方式如下:

方式一:使用 Thunderbit 預設網頁爬蟲

根據用戶需求設計並優化了多種預設爬蟲工具,其中包含專為亞馬遜打造的爬蟲模組。這些工具已針對亞馬遜複雜的數據結構設計好模板,並收集大量數據,無需自己設計抓取邏輯,大幅加快抓取流程,提升效率。

打開亞馬遜任一頁面,啟動 Thunderbit 擴充功能的網頁爬蟲,就能看到兩個預設爬蟲,欄位名稱很齊全。只要勾選想要擷取的欄位,剩下的交給 Thunderbit。

-

亞馬遜 SKU 評論擷取

這個工具預設欄位包含商品名稱、商品網址、總體評分、詳細評分分布、評分數、評論標題、作者名稱、評論內容、評論國家和關鍵字等。勾選所需欄位後,點擊抓取,就能快速取得 SKU 評論數據,方便做商品評論分析。

-

亞馬遜 SKU 詳情擷取

這個工具預設欄位包含商品名稱、商品網址、品牌、製造商、原始價格、最終價格、商品描述、評分、分類、配送方式、賣家網址等。勾選所需欄位後,點擊抓取,就能快速取得 SKU 詳細數據。不論是比較供應商、製造商和配送方式,還是做市場調查、評估 SKU 價格競爭力、掌握最新銷售趨勢,這些數據都能幫你深入分析。

方式二:使用 Thunderbit 人工智慧網頁爬蟲

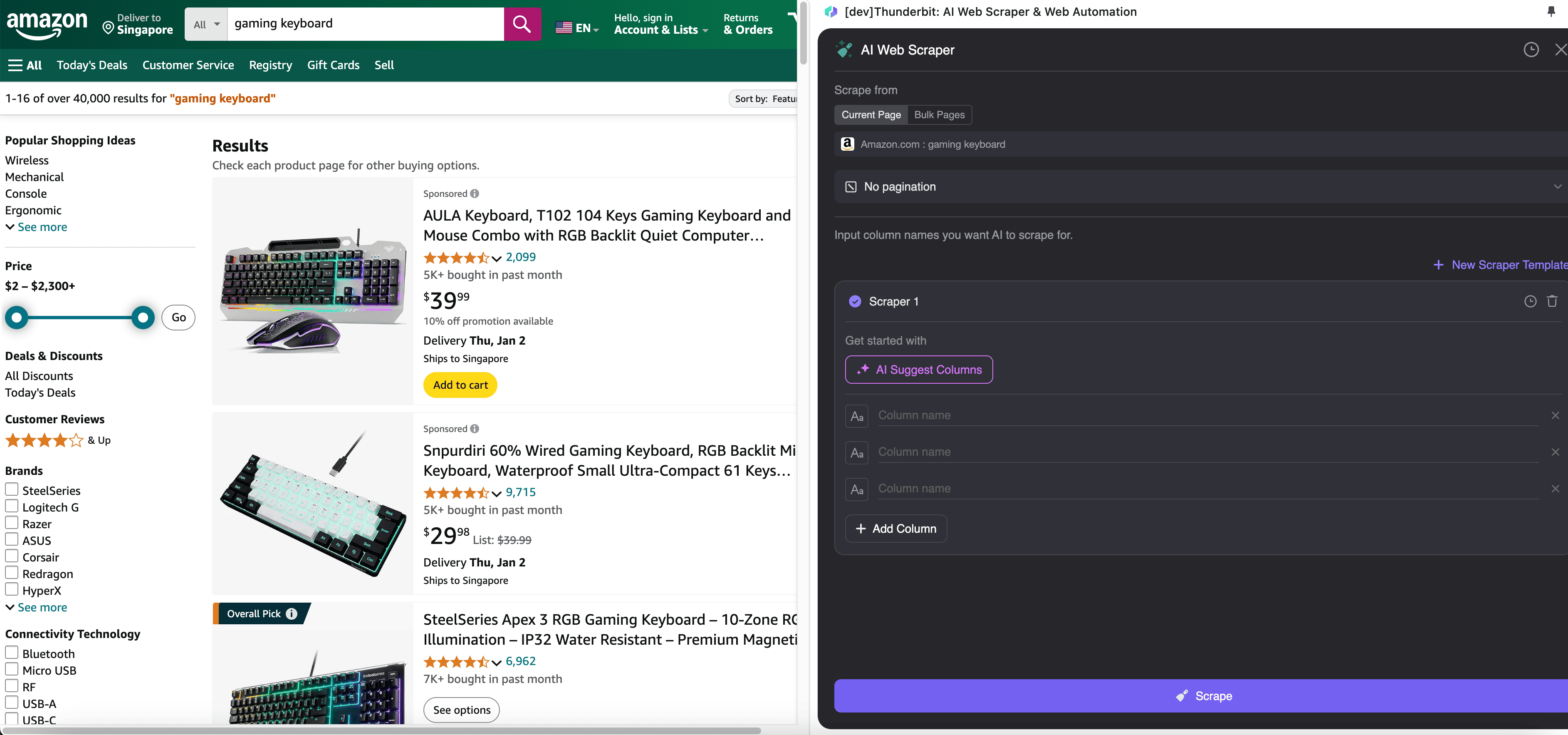

步驟一:打開 ,點選側邊欄的「」

在 Chrome 瀏覽器打開 ,搜尋或瀏覽到想抓取的頁面,點擊右上角 Thunderbit 圖示開啟擴充功能,然後點選「」。

步驟二:自訂要擷取的數據欄位

如果不確定要抓哪些欄位,可以點選 AI 建議欄位,讓 Thunderbit AI 自動產生可靠的欄位名稱。你也能用自然語言描述想要的數據標籤,直接填在欄位名稱欄。還能選不同圖示切換數據型態,像圖片、網址、文字、數字等,對應抓取不同類型資料。

填好初步欄位後,可以選 AI 優化欄位,讓 AI 幫你進一步優化內容。你也能為欄位加上詳細說明,自訂需求。舉例來說,要求商品類型欄自動分類為男、女、童、其他,Thunderbit 會自動把每筆資料歸到你定義的四類。你還能要求 Thunderbit 把價格欄全部轉換成指定幣別,根據即時匯率自動換算,輕鬆取得統一分析所需的數值。

最後,可以自訂抓取數量。針對亞馬遜商品頁,可以選自動翻頁並設定抓取頁數,Thunderbit 會自動翻頁並擷取每頁所有數據。

步驟三:下載或匯出抓取的數據

透過 Thunderbit 擴充功能,你可以。可以選表格輸出,下載 CSV 檔到本地,或直接、Notion、Airtable 等線上協作平台。登入帳號就能直接匯出,方便團隊協作和管理。

傳統網頁爬蟲抓取方式

除了最新 AI 工具,也可以用傳統網頁爬蟲工具,透過簡單程式碼和 API 抓取亞馬遜商品數據。

:API 方式取得 JSON 格式的亞馬遜商品數據

ScraperAPI 提供高效的亞馬遜數據 API,幫你抓取商品詳情、評論、搜尋結果和價格資訊,並以結構化 JSON 格式回傳。操作步驟如下:

步驟一:安裝 Python 環境

請先安裝 Python 3.8 以上版本,並安裝常用分析套件如 Pandas 及爬蟲套件 requests、BeautifulSoup,方便擷取網頁數據。

步驟二:註冊 ScraperAPI 帳號

前往 註冊免費帳號,取得 API 金鑰,就能在程式中調用。

步驟三:撰寫程式碼

在本地建立專屬資料夾,撰寫 Python 腳本進行數據抓取。基本流程如下:

- 取得亞馬遜搜尋網址:在亞馬遜搜尋目標商品,複製搜尋結果頁網址。

- 組建請求:ScraperAPI 會自動循環抓取前五頁搜尋結果,每頁網址只需加上 &page= 和頁碼。

- 發送請求並解析數據:用 get() 方法發送請求,若回應 200,解析頁面內容,擷取所需 ASIN(亞馬遜標準識別碼)。

- 取得商品詳情:調用結構化數據端點,獲取每個 ASIN 的詳細商品資訊,方便後續分析。

步驟四:參考更多教學

詳細操作可參考 。

:防封鎖、大規模抓取

抓取亞馬遜數據時,常遇到 IP 封鎖、驗證碼、動態內容等反爬蟲機制。ScrapFly 提供強大 API,幫你繞過這些限制,順利抓取數據。

ScrapFly 主要功能包括:

- :自動切換 IP,降低被封鎖風險。

- :處理動態內容,抓取 JS 渲染頁面。

- :可自動滾動、輸入、點擊等操作。

- :支援 HTML、JSON、Text、Markdown 等多種格式。

只要幾行程式碼,就能用 ScrapFly 抓取亞馬遜數據。範例如下:

1import scrapfly_sdk

2# 建立客戶端

3client = scrapfly_sdk.ScraperClient(api_key="your_api_key")

4# 發送請求

5response = client.scrape(url="<https://www.amazon.com/s?k=product_name>")

6# 取得回傳數據

7print(response.json())用 ScrapFly,你的爬蟲能有效應對亞馬遜各種反爬蟲機制,提升抓取成功率。不論是簡單商品資訊還是複雜評論分析,ScrapFly 都是實用工具。更多教學可參考 。

用 Python 傳統程式碼抓取

如果你熟悉程式語言,也可以直接用 Python 寫程式抓取亞馬遜商品數據。以下提供簡單範例:

步驟一:安裝必要套件

先建立專屬資料夾:

1mkdir amazonscraper在資料夾內安裝所需套件:

1pip install beautifulsoup4

2pip install requests建立 Python 檔案(如 amazon.py),作為主程式。

步驟二:發送 GET 請求

用 requests 套件對目標頁面發送 GET 請求:

1import requests

2from bs4 import BeautifulSoup

3target_url = "<https://www.amazon.com/s?k=gaming+headsets&_encoding=UTF8>"

4headers = {

5 "accept-language": "en-US,en;q=0.9",

6 "accept-encoding": "gzip, deflate, br",

7 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/111.0.0.0 Safari/537.36",

8 "accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7"

9}

10response = requests.get(target_url, headers=headers)步驟三:抓取商品數據

決定要從擷取哪些資訊:

1# 檢查請求是否成功

2if response.status_code == 200:

3 # 解析頁面內容

4 soup = BeautifulSoup(response.content, 'html.parser')

5 # 找出所有商品區塊

6 products = soup.find_all('div', {'data-component-type': 's-search-result'})

7 # 逐一擷取商品資訊

8 for product in products:

9 # 商品標題

10 title = product.h2.text.strip()

11 # 商品價格

12 price = product.find('span', 'a-price')

13 if price:

14 price = price.find('span', 'a-offscreen').text.strip()

15 else:

16 price = "無價格資訊"

17 # 商品評分

18 rating = product.find('span', 'a-icon-alt')

19 if rating:

20 rating = rating.text.strip()

21 else:

22 rating = "無評分資訊"

23 # 輸出商品資訊

24 print(f"標題: {title}")

25 print(f"價格: {price}")

26 print(f"評分: {rating}")

27 print("-" * 40)

28else:

29 print(f"頁面取得失敗,狀態碼: {response.status_code}")常見問題

1. 抓取 數據是否合法?

是的,抓取亞馬遜公開數據是合法的!亞馬遜和多數網站一樣,將商品資訊和公開內容開放給所有人瀏覽。你可以自由抓取這些公開數據,不會違反亞馬遜服務條款。

2. Thunderbit 可以免費試用嗎?

可以,Thunderbit 提供免費的網頁擷取和數據抓取功能。部分進階功能可能需付費,但基本數據擷取。

3. 可以抓取哪些亞馬遜數據?

你可以抓取商品標題、價格、描述、評論、評分、賣家資訊等多種數據,這些資料對市場調查、價格監控、競爭分析都很有價值。

4. 抓取亞馬遜數據的頻率建議?

頻率取決於你關注的數據類型。若需監控價格或競爭對手動態,建議每日或每週抓取。若是較靜態的商品資訊,每月抓取即可。

延伸閱讀