在網路世界,資料量多到爆炸,根據預測,全球網頁爬蟲市場到 。不管你是商業分析師、行銷人員,還是剛入門的資料控,從網站擷取資料 已經是現代人必備的技能。如果你跟我一樣,受夠了重複又無聊的複製貼上,那你一定會想直接切入重點:拿到有用的洞察、乾淨的表格,甚至自動化整個流程。

這時候 python 就超好用。它就像資料圈的瑞士刀,學起來簡單,卻能搞定從單頁到大規模的各種擷取需求。這篇網頁爬蟲教學會帶你認識 python 網頁爬蟲的基本功,怎麼處理動態網站,還會介紹 ,這款 AI 驅動、完全不用寫程式的人工智慧網頁爬蟲,讓你抓資料就像點外送一樣輕鬆。不管你想學寫程式,還是只想找最快的捷徑,這裡都能滿足你。

什麼是網頁爬蟲?為什麼用 python 擷取網站資料?

網頁爬蟲,就是自動化從網站抓資料,然後把它們變成結構化格式(像是表格、CSV 或資料庫),方便你分析或做生意(參考 )。比起手動複製貼上,爬蟲可以用超快的速度和規模模擬人類操作。

這樣做有什麼好處?因為現在做決策都要靠數據驅動。有 都靠資料(其中很大一部分來自爬蟲)來訂價格、做市場調查、開發名單。想像一下,每天自動監控競爭對手價格、彙整房市資訊、建立潛在客戶清單,這些都能輕鬆搞定。

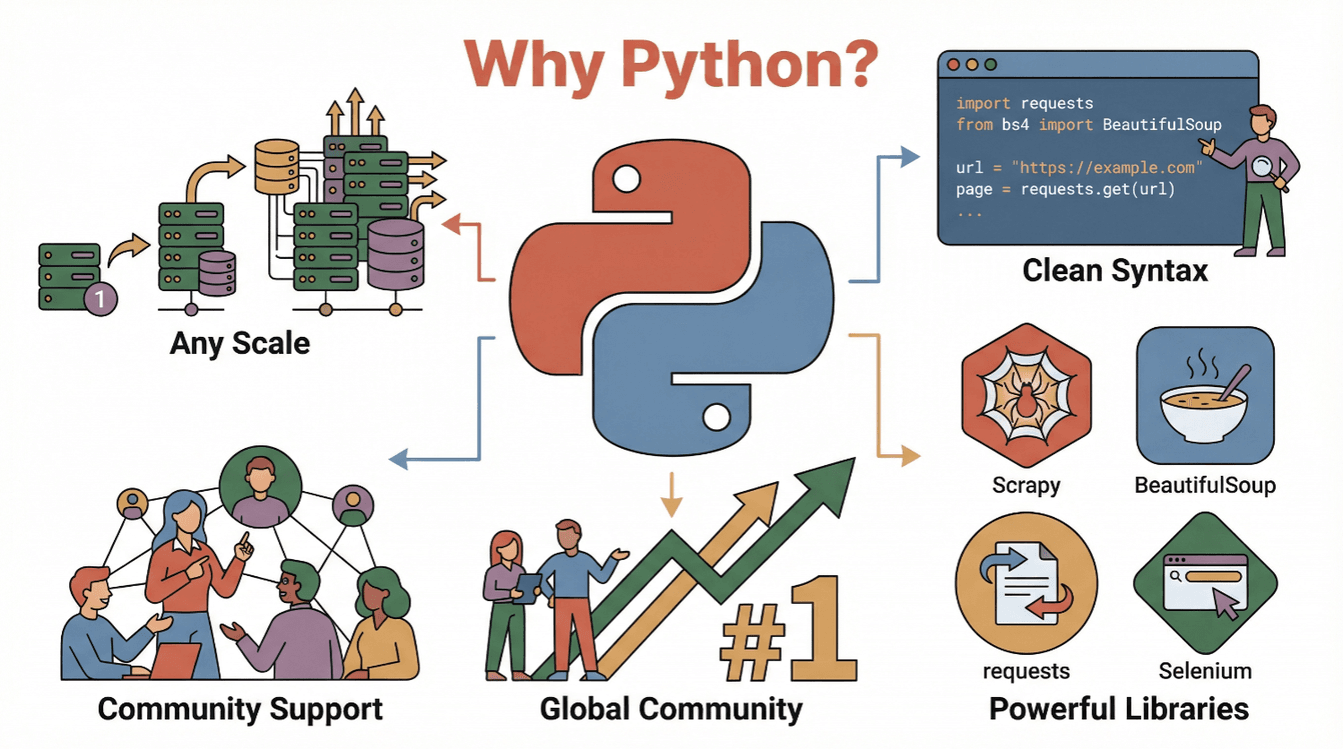

那為什麼大家都愛用 python?原因很簡單:

- 語法超直白: python 的語法很親民,新手也能很快寫出爬蟲腳本(參考 )。

- 生態圈超豐富:

requests、BeautifulSoup、Scrapy、Selenium這些函式庫,讓你抓資料、解析、甚至自動操作瀏覽器都沒問題。 - 社群資源多到爆: python 長年穩坐,教學、論壇、範例一堆。

- 彈性又強大: 從簡單腳本到大型爬蟲專案都能搞定。

總之,不管你是新手還是資深分析師,python 絕對是進入網路資料世界的最佳入場券。

入門指南:python 網頁爬蟲基礎流程

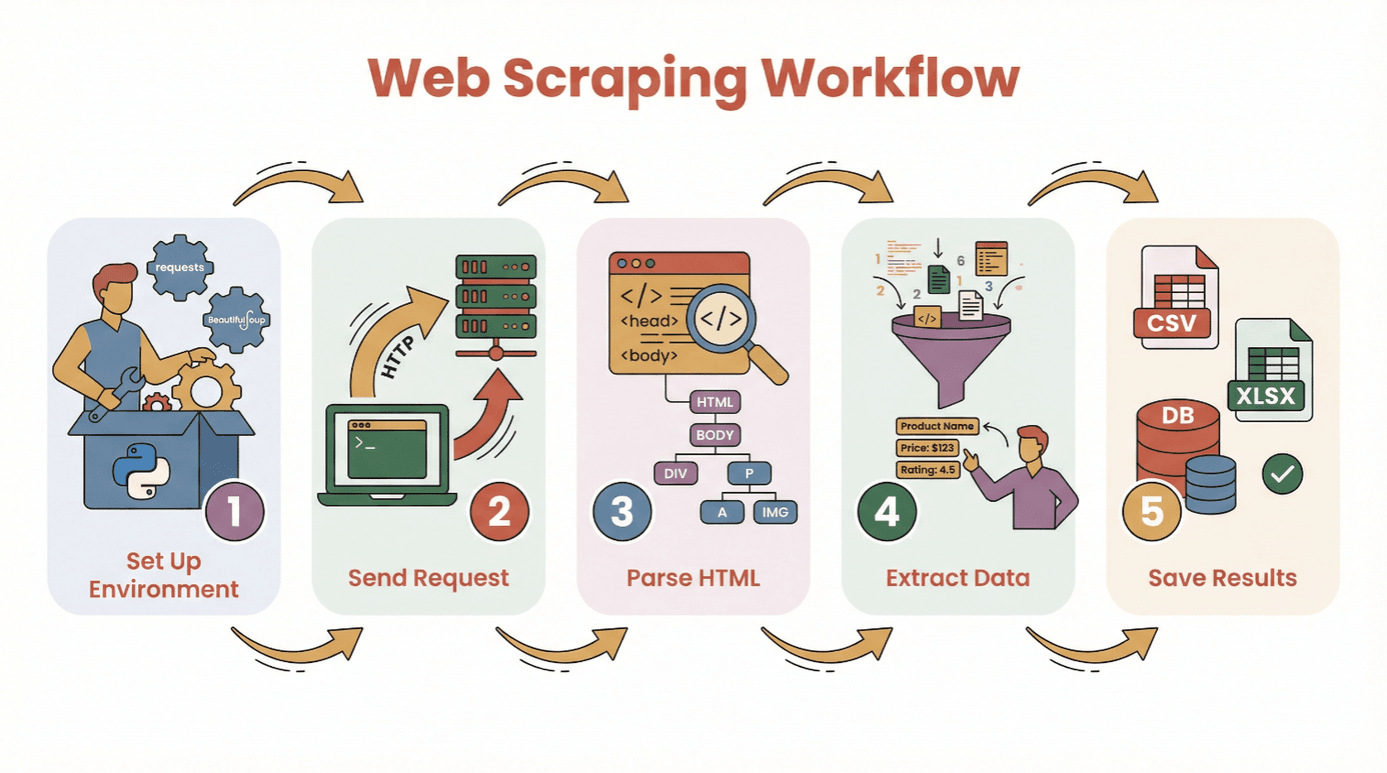

在開始寫程式之前,先搞懂用 python 從網站擷取資料的基本步驟:

- 安裝環境: 裝好 python 跟需要的函式庫(像

requests、BeautifulSoup)。 - 發送請求: 用 python 取得目標網頁的 HTML。

- 解析 HTML: 用解析器看懂網頁結構。

- 擷取資料: 抓出你要的資訊。

- 儲存結果: 把資料存成 CSV、Excel 或資料庫,方便後續分析。

你不用是程式高手才能開始。只要會安裝 python、執行腳本就行。新手可以用 或 Jupyter notebook,任何文字編輯器都 OK。

常用函式庫:

requests— 抓網頁內容BeautifulSoup— 解析 HTMLpandas— 存資料、清理資料(超推薦)

如何選擇 python 網頁爬蟲函式庫:BeautifulSoup、Scrapy、Selenium?

不是每個 python 爬蟲工具都一樣。這裡簡單介紹三大主流選擇:

| 工具 | 適用情境 | 優點 | 缺點 |

|---|---|---|---|

| BeautifulSoup | 靜態頁面、初學者 | 易學易用、設定簡單、文件齊全 | 不適合大規模爬取或動態內容 |

| Scrapy | 大型、多頁面爬取 | 速度快、支援非同步、內建資料處理流程、可自動跟隨連結 | 學習曲線較高、小型專案較繁瑣、不支援 JavaScript |

| Selenium | 動態/JavaScript 網站、自動化操作 | 可渲染 JS、模擬用戶操作、支援登入與點擊 | 速度較慢、資源消耗高、設定較複雜 |

BeautifulSoup:新手最愛的 HTML 解析

BeautifulSoup 超適合新手和小型專案,只要幾行程式就能解析 HTML 抓元素。只要目標網站是靜態頁面(沒什麼 JavaScript),搭配 requests 就能輕鬆搞定。

範例:

1import requests

2from bs4 import BeautifulSoup

3url = "https://example.com"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6titles = [h2.text for h2 in soup.find_all('h2', class_='product-title')]

7print(titles)適合:單次擷取、部落格、商品頁、目錄等。

Scrapy:大規模爬取的專業工具

Scrapy 是完整的爬蟲框架,適合爬整個網站或大量頁面。支援非同步(超快)、內建資料處理流程,還能自動跟連結。

範例:

1import scrapy

2class ProductSpider(scrapy.Spider):

3 name = "products"

4 start_urls = ["https://example.com/products"]

5 def parse(self, response):

6 for item in response.css('div.product'):

7 yield {

8 'name': item.css('h2::text').get(),

9 'price': item.css('span.price::text').get()

10 }適合:大型專案、定時爬取、需要速度和結構化資料時。

Selenium:對付動態和 JavaScript 網站

Selenium 可以操作真實瀏覽器(像 Chrome、Firefox),超適合處理 JavaScript 動態載入、需要登入或互動的網站。

範例:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://example.com/login")

5driver.find_element(By.NAME, "username").send_keys("myuser")

6driver.find_element(By.NAME, "password").send_keys("mypassword")

7driver.find_element(By.XPATH, "//button[@type='submit']").click()

8dashboard = driver.find_element(By.ID, "dashboard").text

9print(dashboard)

10driver.quit()適合:社群網站、股市、無限捲動、原始碼看不到資料的網站。

實作教學:用 python 從網站擷取資料(新手範例)

這裡用 requests 和 BeautifulSoup 實作,抓書籍清單網站的書名、價格。

步驟 1:安裝 python 環境

先裝好需要的函式庫:

1pip install requests beautifulsoup4 pandas然後在腳本裡匯入:

1import requests

2from bs4 import BeautifulSoup

3import pandas as pd步驟 2:發送網站請求

取得 HTML 內容:

1url = "http://books.toscrape.com/catalogue/page-1.html"

2response = requests.get(url)

3if response.status_code == 200:

4 html = response.text

5else:

6 print(f"Failed to retrieve page: {response.status_code}")步驟 3:解析 HTML

建立 BeautifulSoup 物件:

1soup = BeautifulSoup(html, 'html.parser')找到所有書籍區塊:

1books = soup.find_all('article', class_='product_pod')

2print(f"Found {len(books)} books on this page.")步驟 4:擷取所需資料

一個一個抓書籍資訊:

1data = []

2for book in books:

3 title = book.h3.a['title']

4 price = book.find('p', class_='price_color').text

5 data.append({"Title": title, "Price": price})步驟 5:儲存資料

轉成 DataFrame 存檔:

1df = pd.DataFrame(data)

2df.to_csv('books.csv', index=False)這樣你就有一份乾淨的 CSV 檔可以分析啦!

常見問題排解:

- 抓不到資料?檢查是不是 JavaScript 載入(見下節)。

- 用瀏覽器開發者工具看 HTML 結構。

- 用

get_text(strip=True)和條件判斷處理缺漏資料。

應對動態內容:抓取 JavaScript 載入的網站資料

現在很多網站都用 JavaScript 動態載入資料,這時你用爬蟲抓到的 HTML 可能是空的。

解決方法:

- Selenium: 模擬真實瀏覽器,等內容載入,可以點擊或捲動。

- Playwright/Puppeteer: 進階用法,原理差不多(無頭瀏覽器)。

Selenium 快速指南:

- 安裝 Selenium 和瀏覽器驅動(像 ChromeDriver)。

- 用顯式等待讓內容載入。

- 取得渲染後的 HTML,再用 BeautifulSoup 解析。

範例:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.support.ui import WebDriverWait

4from selenium.webdriver.support import expected_conditions as EC

5driver = webdriver.Chrome()

6driver.get("https://example.com/dynamic")

7WebDriverWait(driver, 10).until(

8 EC.presence_of_element_located((By.CLASS_NAME, "dynamic-content"))

9)

10html = driver.page_source

11soup = BeautifulSoup(html, 'html.parser')

12# 如前述方式擷取資料

13driver.quit()什麼時候需要 Selenium?

- 用

requests.get()抓到的 HTML 沒資料,但瀏覽器看得到。 - 網站有無限捲動、彈窗、或需要登入。

AI 讓網頁爬蟲更簡單:用 Thunderbit 快速擷取網站資料

老實說,有時候你只想要資料,根本不想寫程式。這時 就超好用。Thunderbit 是一款 AI 驅動的 Chrome 擴充功能,讓你只要點幾下就能從任何網站擷取資料,完全不用寫 python。

Thunderbit 怎麼用:

- 安裝 。

- 打開你要抓的網站。

- 點 Thunderbit 圖示,選「AI 建議欄位」。 Thunderbit 的 AI 會自動掃描頁面,推薦可以抓的資料(像商品名稱、價格、Email 等)。

- 需要的話可以調整欄位,然後點「開始抓取」。

- 直接匯出資料到 Excel、Google Sheets、Notion 或 Airtable。

Thunderbit 的優勢:

- 完全不用寫程式。 連我媽都會用(她還常問我 Wi-Fi 怎麼連)。

- 支援子頁面和分頁。 要抓多頁商品細節?Thunderbit 會自動點擊合併資料。

- 自然語言指令。 只要輸入「擷取所有商品名稱和價格」,AI 就會自動判斷。

- 熱門網站一鍵範本。 Amazon、Zillow、LinkedIn 等,直接套用。

- 免費匯出資料。 可以下載 CSV、Excel,或直接推到你常用的工具。

Thunderbit 已經有 ,免費方案可以抓 6 頁(試用最多 10 頁)。對商業用戶來說超省時,對技術人員也是快速原型的好幫手。

擷取後:用 pandas 和 NumPy 清理、分析資料

抓到資料只是第一步。原始網頁資料常常亂七八糟——重複、缺漏、格式不一。這時 python 的 pandas 和 NumPy 就超好用。

常見清理任務:

- 移除重複值:

df.drop_duplicates(inplace=True) - 處理缺漏值:

df.fillna('Unknown')或df.dropna() - 轉換資料型態:

df['Price'] = df['Price'].str.replace('$','').astype(float) - 解析日期:

df['Date'] = pd.to_datetime(df['Date']) - 過濾異常值:

df = df[df['Price'] > 0]

基本分析:

- 摘要統計:

df.describe() - 依類別分組:

df.groupby('Category')['Price'].mean() - 快速繪圖:

df['Price'].hist()或df.groupby('Category')['Price'].mean().plot(kind='bar')

進階數值運算可以用 NumPy,但對大多數商業用戶來說,pandas 已經很夠用。

延伸學習: 新手可以參考 。

python 網頁爬蟲實戰技巧與注意事項

網頁爬蟲很強大,但也要守規矩。這裡整理一些專業爬蟲守則:

- 遵守 robots.txt 和網站條款。 先確認網站允不允許爬蟲(參考 )。

- 不要狂發請求。 每次請求間加點延遲(像

time.sleep(2)),模擬人類行為。 - 設定真實瀏覽器標頭。 加 User-Agent。

- 錯誤要處理好。 用 try/except 和重試機制。

- 必要時換代理。 大規模爬取可以用代理池避免 IP 被封。

- 守法守德。 不要未經授權抓個資或登入後內容。

- 記錄流程。 記下抓取來源、時間和內容。

- 有官方 API 優先用 API。 有時比爬 HTML 更穩定。

更多技巧可以參考 。

結語與重點整理

用 python 做網頁爬蟲,能讓你把網路上的雜亂資訊變成有價值的結構化資料。不管你用程式(requests、BeautifulSoup、Scrapy、Selenium),還是像 這種零程式碼工具,都能輕鬆從網站擷取資料,發現新洞察。

重點提醒:

- 從簡單開始,先抓單一頁面再挑戰大型專案。

- 根據需求選對工具(BeautifulSoup 適合基礎,Scrapy 適合規模,Selenium 應對動態,Thunderbit 免寫程式)。

- 用 pandas、NumPy 清理和分析資料。

- 永遠記得合法、合規、負責任地爬取。

準備好自己動手試試看了嗎?從小專案開始——像是抓今日新聞標題或商品清單,體驗一下從原始網頁到乾淨表格的轉換速度。如果想省去寫程式,直接 ,讓 AI 幫你搞定一切。

更多教學、技巧和網頁爬蟲新知,歡迎來 逛逛。

常見問題

1. 什麼是網頁爬蟲?為什麼 python 這麼熱門?

網頁爬蟲就是自動化從網站抓資料的技術。python 之所以超夯,是因為語法簡單、函式庫強大(像 BeautifulSoup、Scrapy、Selenium),而且社群資源超多(參考 )。

2. python 網頁爬蟲該用哪個函式庫?

靜態頁面用 BeautifulSoup,大型或多頁爬取用 Scrapy,動態或 JavaScript 網站用 Selenium。根據需求選最適合的工具(參考 )。

3. 如何處理 JavaScript 載入的網站?

遇到 JavaScript 動態內容,可以用 Selenium(或 Playwright)模擬瀏覽器,等資料載入後再抓。有時也能從網路請求中找到 API 端點。

4. Thunderbit 是什麼?怎麼讓網頁爬蟲更簡單?

是一款 AI 驅動的 Chrome 擴充功能,讓你不用寫程式就能從任何網站擷取資料。AI 會自動建議欄位、支援分頁和子頁,還能直接匯出到 Excel、Google Sheets、Notion 或 Airtable。

5. 如何用 python 清理和分析爬到的資料?

用 pandas 移除重複、處理缺漏、轉換型態並做分析。NumPy 適合數值運算。視覺化可以用 pandas 搭配 Matplotlib 快速畫圖(參考 )。

祝你爬蟲順利,資料永遠乾淨、結構化、超好用!

延伸閱讀