說真的,2025 年的網路就像一個超大、隨時在變動的 Excel 表格——只不過沒人貼心地幫你加個「匯出到 Excel」的按鈕。(要是真的有就太棒了!)身為長期開發 SaaS 和自動化工具的工程師,我超能體會銷售、行銷、營運團隊對即時、精準網路資料的渴望——不管是開發潛在客戶、盯競爭對手價格,還是追蹤房市動態。雖然 java 網頁爬蟲的需求越來越大,但「怎麼做」這件事變化得更快。

Java 一直是大型、嚴謹網頁爬蟲專案的首選。不過說實話,除非你是那種連做夢都在寫大括號的工程師,不然用 Java 寫爬蟲就像在沒說明書、還多三顆螺絲的情況下組裝 IKEA 家具。這也是為什麼我對新一代人工智慧網頁爬蟲(像我們團隊做的 )特別有感——只要點兩下,完全不用寫程式或懂 HTML,誰都能輕鬆抓資料。這篇文章就要帶你看看兩個世界:Java 為什麼還是很重要、自己寫爬蟲要注意什麼,以及 AI 工具怎麼讓資料擷取變得人人都能上手。

2025 年 Java 網頁爬蟲還是很關鍵的原因

即使免寫程式碼網頁爬蟲和 AI 工具大爆發,Java 依然是全球很多大型網頁爬蟲專案的主力。原因很簡單:Java 效能強、穩定性高,還能做到企業級資料擷取需要的細緻控制。

Java 的強項

- 開發潛在客戶名單與銷售:Java 的多執行緒能力,讓你一夜之間從各大名錄或 LinkedIn 抓下數百萬筆資料,銷售名單自動進帳,不用再熬夜加班。

- 競爭對手價格監控:電商團隊靠 Java 爬蟲追蹤成千上萬個商品價格,還能即時調整自家售價。像 Target 用數據驅動定價後,)。

- 房地產資料彙整:房仲和投資人用 Java 整合多個來源的物件、歷史價格和人口統計資料,更容易發現投資機會()。

- 金融市場研究:投資機構信賴 Java 的穩定性,全天候自動抓取股價、新聞、社群情緒——因為在金融圈,幾秒鐘的延遲都可能造成損失。

彈性 vs. 易用性的選擇

Java 給你最大的彈性:每個細節都能自訂,特殊情境也能處理,還能直接整合到後端系統。但現實是——這一切都需要很紮實的程式能力。對非工程師來說,學習曲線超陡,後續維護也很吃力。所以,雖然 Java 仍是大型專案的主力,越來越多商務用戶則轉向人工智慧網頁爬蟲、免寫程式碼網頁爬蟲來應付日常資料抓取需求()。

基礎入門:什麼是 Java 網頁爬蟲?

簡單說,不用怕專有名詞。

用 Java 做網頁爬蟲,就是寫一個像機器人一樣的程式:自動瀏覽網頁、讀取內容,把你要的資料抓下來。就像有個數位小助理幫你複製貼上資料,而且速度超快、永遠不喊累。

基本流程如下:

- 發送請求:Java 程式抓取網頁原始 HTML,就像瀏覽器一樣。

- 解析 HTML:讀取網頁結構(各種

<div>、<span>、<table>標籤)。 - 擷取資料:指定要抓的內容(例如「找出所有

<span class='price'>的價格」)。 - 匯出:把資料存成 CSV、Excel 或資料庫。

靜態網頁這樣做很簡單。遇到動態網頁(內容靠 JavaScript 載入),就需要額外工具模擬真實瀏覽器,後面會再說明。

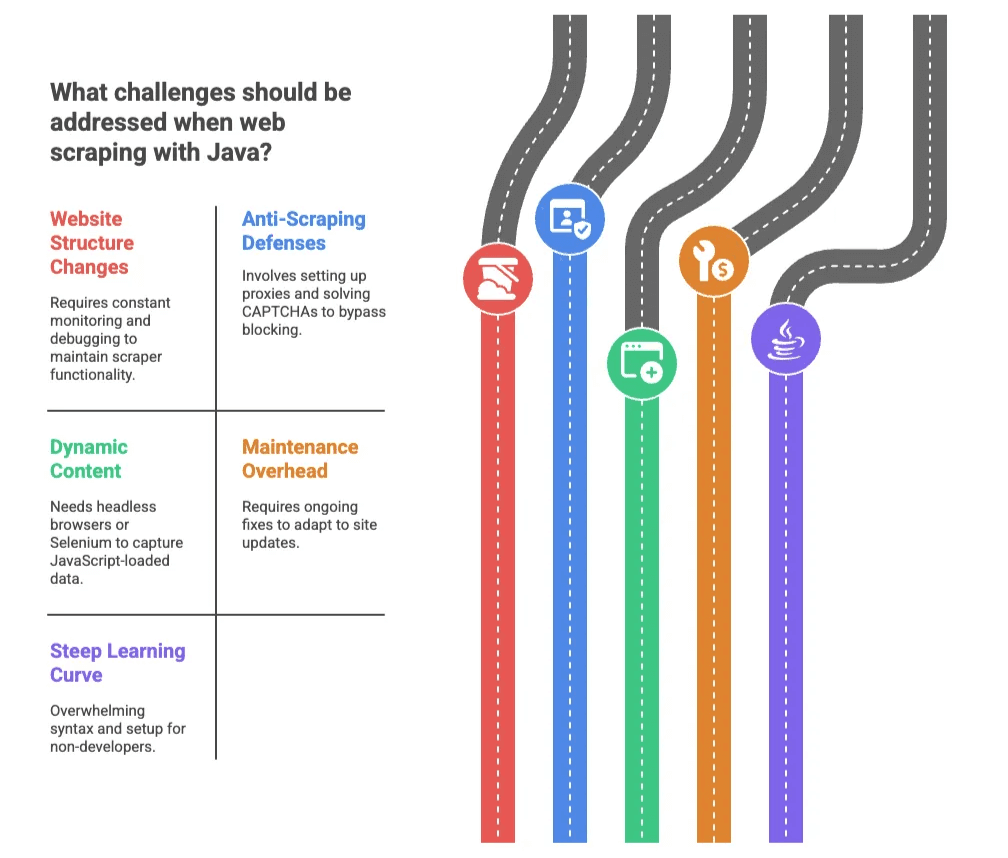

Java 網頁爬蟲的主要挑戰

Java 很強大,但寫起來絕對不輕鬆——除非你覺得公園裡到處都是 CAPTCHA、IP 封鎖和每週都變的 HTML 結構。常見難題如下:

1. 網站結構變動

網站總愛在你爬蟲終於穩定時大改版。只要 CSS class 名稱一改,程式就全掛,半夜還得加班除錯()。

2. 反爬蟲機制

網站會用 CAPTCHA、IP 封鎖、流量限制來防堵爬蟲。最近一份調查顯示, 認為被封鎖是最大痛點。用 Java 處理這些問題,得設置代理、解 CAPTCHA,像在玩永無止盡的打地鼠遊戲。

3. 動態內容

現代網站常用 JavaScript 載入資料,基本 Java 爬蟲看不到這些內容。這時就得用 Selenium 等無頭瀏覽器,難度和複雜度都大幅提升。

4. 維護負擔

爬蟲寫好後,還得不斷維護。網站一更新就可能壞掉,得隨時修補。

5. 學習門檻高

對非工程師來說,Java 的語法和環境設定很難懂。小錯誤就會出現難解的錯誤訊息。就像學開手排車——但車子還在著火、路面全是 HTML。

傳統 Java 網頁爬蟲:流程大公開

如果你還是想自己動手寫爬蟲,通常會經歷以下步驟:

| 步驟 | Java 程式寫法 | AI/免寫程式碼工具 |

|---|---|---|

| 環境安裝 | 安裝 JDK、IDE、加套件(新手可能花數小時) | 裝瀏覽器擴充或註冊帳號(幾分鐘搞定) |

| 資料欄位辨識 | 看 HTML、寫選擇器(需懂 HTML/CSS) | AI 自動偵測欄位,或直接點選 |

| 處理動態內容 | 用 Selenium 或 HtmlUnit(複雜又慢) | 工具自動處理 |

| 除錯修正 | 讀錯誤訊息、改程式、反覆測試 | 工具自動處理大部分問題,偶爾微調欄位選擇 |

| 資料匯出 | 自己寫程式存 CSV/DB,還要整合 | 一鍵匯出到 Excel、Google Sheets、Airtable、Notion |

| 維護 | 監控網站變動、隨時修程式 | AI 自動適應,幾乎不用維護 |

常用 Java 網頁爬蟲函式庫

- Jsoup:適合靜態 HTML,簡單易用,但無法處理 JavaScript 動態內容()。

- HtmlUnit:模擬瀏覽器,可執行 JavaScript,但速度較慢,遇到新技術有時會卡關。

- Selenium:直接操作真實瀏覽器(Chrome、Firefox),動態網頁首選,但對非工程師來說太複雜。

總結:這些函式庫對開發者很棒,但對商務用戶來說,感覺就像為了買披薩卻要自己造火箭。

人工智慧網頁爬蟲:人人都能用的資料擷取利器

這裡才是重點。像 這類人工智慧網頁爬蟲,徹底改變了遊戲規則,讓不會寫程式的人也能輕鬆抓資料。

Thunderbit 怎麼運作?

- AI 智能欄位建議:按一下,AI 會自動分析網頁,推薦可擷取的欄位與資料型態,完全不用看 HTML。

- 兩步驟流程:「AI 建議欄位」→「開始爬蟲」,剩下都交給 AI。

- 子頁面自動爬取:需要更多細節?Thunderbit 可自動點進每個子頁(如商品或個人頁),自動補齊資料。

- 一鍵匯出:資料可直接匯出到 Excel、Google Sheets、Airtable、Notion。

- 雲端或本地爬蟲:雲端模式可同時抓 50 頁,或用瀏覽器模式處理需登入的網站。

真的這麼簡單。我親眼看過完全不懂技術的用戶,從「什麼是 selector?」到「我 10 分鐘內抓了 500 筆競品資料」。

Thunderbit vs. 傳統 Java 爬蟲:快速比較

| 功能 | 傳統 Java | Thunderbit 人工智慧網頁爬蟲 |

|---|---|---|

| 安裝時間 | 幾小時到幾天 | 幾分鐘(安裝 Chrome 擴充) |

| 技能需求 | Java、HTML、CSS、除錯 | 無需技術背景(只要會用網頁) |

| 維護 | 手動、持續修正 | AI 自動適應變動 |

| 資料匯出 | 自己寫程式 | 一鍵匯出到 Excel、Sheets、Airtable、Notion |

| 動態內容 | 複雜(需 Selenium/HtmlUnit) | 自動處理 |

| 子頁面爬取 | 需自寫爬蟲邏輯 | 內建一鍵完成 |

| 擴展性 | 需寫多執行緒、代理 | 雲端爬蟲自動平行處理 |

| 成本 | 工程師時間、基礎設施 | 平價方案,還有免費版 |

對大多數商務用戶來說,Thunderbit 就像從手排車換成自駕車,輕鬆又省力。

Java 網頁爬蟲實作步驟

還是想自己試試 Java?這裡有一份簡明流程:

-

安裝開發環境:下載 Java 開發工具包(JDK)和 IDE(如 IntelliJ 或 Eclipse),加上 Jsoup 等函式庫()。

-

選定目標網站:用瀏覽器檢查 HTML,找出你要的元素(如商品名稱、價格)。

-

撰寫程式碼:用 Jsoup 抓取網頁並選取資料。例如:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

處理分頁:用迴圈換網址或點「下一頁」連結抓多頁資料。

-

資料匯出:把結果寫成 CSV 檔,方便用 Excel 或 Google Sheets 開啟。

-

測試與優化:執行爬蟲、除錯、調整選擇器。

Java 爬蟲維護小技巧

- 定期檢查輸出:常常檢查資料有沒有缺漏。

- 集中管理選擇器:把所有 HTML 選擇器集中管理,方便日後修改。

- 防封鎖:被封鎖時可用代理、切換 User-Agent。

- 寫好註解:程式碼多加註解,記錄每段功能。

- 合法合規:務必遵守網站服務條款與 robots.txt。

如果覺得這一切很繁瑣……沒錯,這也是越來越多團隊轉向人工智慧網頁爬蟲的原因。

什麼時候該選擇 Thunderbit 這類人工智慧網頁爬蟲?

該怎麼選?以下是我的建議:

適合用 Java 的情境:

- 需要高度自訂邏輯、深度整合或大規模爬取。

- 公司有嚴格的資安或合規需求。

- 有工程師資源,能長期維護程式。

適合用 Thunderbit(或其他人工智慧網頁爬蟲)的情境:

- 不會寫程式,或不想寫程式。

- 需要快速取得資料,設定越簡單越好。

- 網站結構常變,或要抓很多不同網站。

- 想直接匯出到 Excel、Google Sheets、Airtable、Notion。

- 重視效率與便利。

Thunderbit 對銷售、電商、房地產團隊特別有幫助,能自動化重複性資料收集,不用再等 IT 支援。臨時專案、快速開發名單、競品監控等需求,也都很適合。

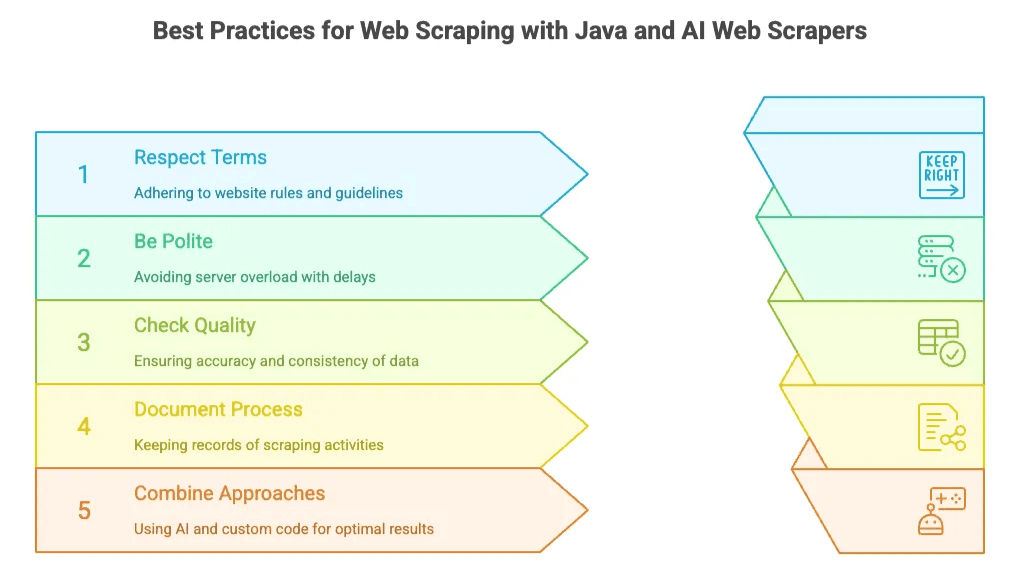

Java 與人工智慧網頁爬蟲的最佳實踐

不論你選哪一種,以下幾個原則都值得遵守:

- 遵守網站規範:務必檢查 robots.txt 與服務條款,勿抓取私人或敏感資料。

- 友善抓取:不要對伺服器造成過大負擔——寫程式時加延遲,或用 AI 工具內建的流量控制。

- 檢查資料品質:定期檢查資料正確性與完整性。Thunderbit 的「欄位 AI 提示」可即時清理與結構化資料。

- 記錄流程:記下你抓了哪些資料、來源與頻率。

- 混合運用:有時先用 AI 工具快速取得資料,再用自訂程式處理進階需求,是最有效率的做法。

結語:2025 年商務用戶的網頁爬蟲新時代

2025 年的網頁爬蟲,選擇比以往更多。Java 依然是企業級、客製化專案的主力。但對大多數商務用戶(銷售、行銷、營運)來說,人工智慧網頁爬蟲如 的崛起,讓你不必是工程師也能輕鬆取得網路資料。

這個市場正快速成長:全球網頁爬蟲軟體市場預計到 2030 年將達 ,而 到 2028 年都會使用自動化分析工具。結論很明確:數據驅動決策已成主流,工具只會越來越強大。

還在猶豫嗎?不妨試試 。免費上手,說不定你只需幾下點擊就能完成過去要花數小時的工作。(如果你是熱愛 Java 的開發者也別擔心——大型、複雜的爬蟲專案還是很需要你的專業!)

想了解更多?歡迎瀏覽 ,有更多深度教學與實戰技巧,包括 和 。

祝你爬蟲順利,資料永遠新鮮、精準、隨手可得。要是人生每件事都這麼簡單就好了!

常見問題

1. 2025 年為什麼還有人用 Java 做網頁爬蟲?

Java 依然是大型、企業級爬蟲的首選,因為速度快、穩定性高、彈性大。特別適合金融數據監控、競價追蹤、大型名單擷取等需要細緻控制或後端整合的情境。

2. 用 Java 寫爬蟲有什麼缺點?

雖然功能強大,但 Java 爬蟲有不少挑戰:學習門檻高、維護成本大、HTML 結構變動常導致程式壞掉、難以處理 JavaScript 網頁,以及需要處理代理、CAPTCHA、分頁等複雜設定。

3. Thunderbit 這類 AI 工具怎麼讓爬蟲變簡單?

Thunderbit 全自動化爬蟲流程:AI 自動偵測欄位、處理動態內容、子頁面導航,並可直接匯出到 Excel 或 Notion。完全不需寫程式或懂 HTML,讓非技術用戶也能輕鬆上手。

4. 什麼時候該用 Thunderbit 而不是 Java?

Thunderbit 適合需要快速、穩定資料、又不想寫程式的商務用戶。特別適合銷售開發、電商監控、臨時研究等,重視速度與便利性大於極致自訂邏輯的情境。

5. 可以混合使用 Java 和 AI 爬蟲工具嗎?

當然可以。許多團隊會先用 Thunderbit 這類 AI 工具快速取得資料,再用 Java 處理進階或大規模需求。這種混合策略能兼顧效率與彈性。

延伸閱讀: