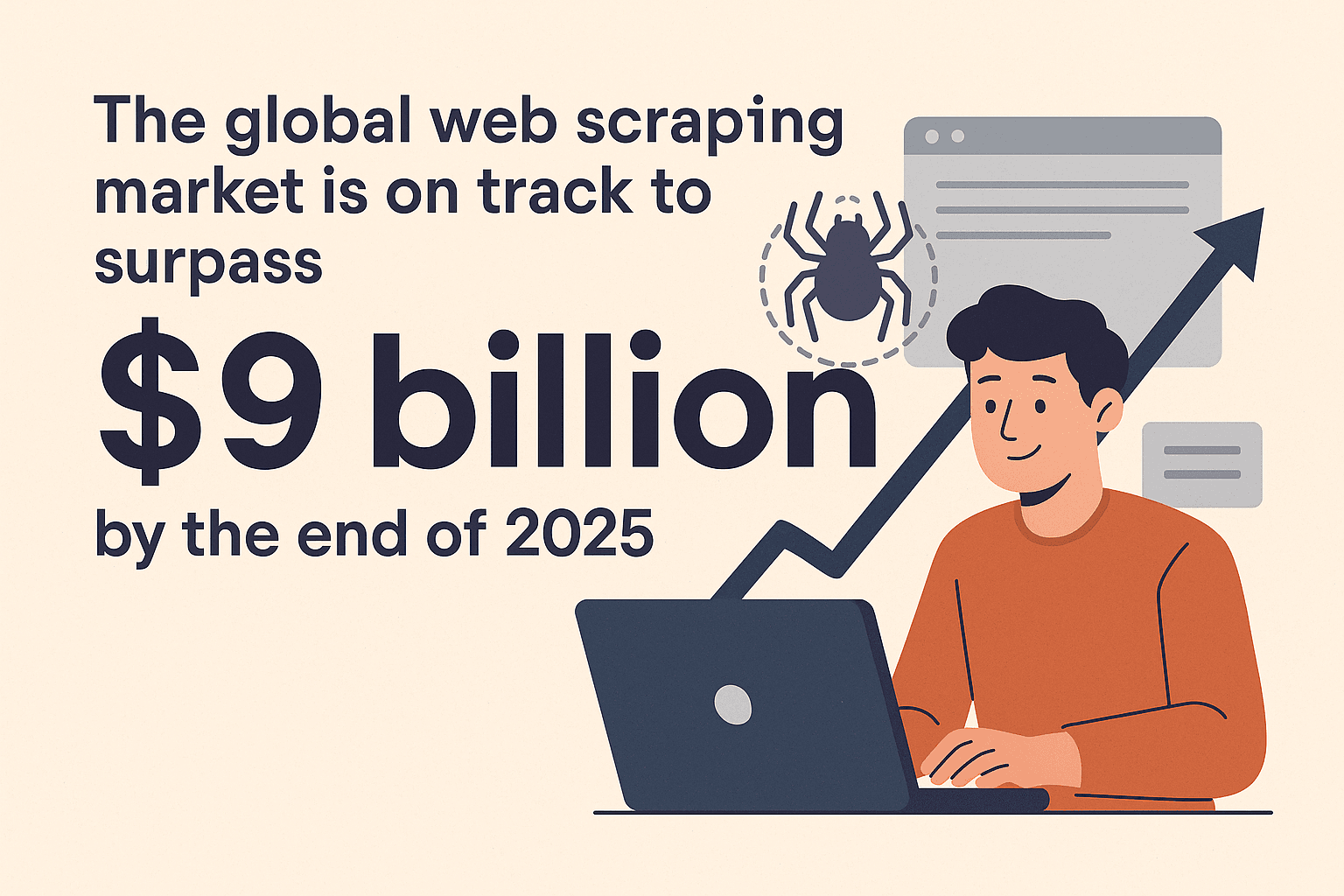

在這個資訊爆炸的時代,誰能把握數據,誰就能在競爭中搶得先機。每天有數十億個網頁被網頁爬蟲抓取,這些數據被廣泛應用在市場分析、比價、開發潛在客戶、研究報告等領域——推動著電商價格戰、AI 創新等多種應用()。全球網頁爬蟲市場預計到 2025 年底將突破90 億美元,如果你還沒開始用高效的網頁爬蟲工具,等於直接錯過龐大商機()。

我在 SaaS 和自動化領域打滾多年,深知選對爬蟲工具對專案成敗有多重要。這幾年 Rust 在這塊的表現真的讓我大開眼界。這篇文章會帶你了解為什麼 Rust 是打造網頁爬蟲的超強選擇、怎麼快速上手,還有怎麼把 Rust 跟 這類 AI 工具結合,讓你兼顧速度、安全、便利,效率直接翻倍。

為什麼用 Rust 開發網頁爬蟲?

直接切重點:為什麼要選 Rust?很多人都用 Python 或 Node.js 來寫爬蟲,但 Rust 有幾個超明顯的優勢:

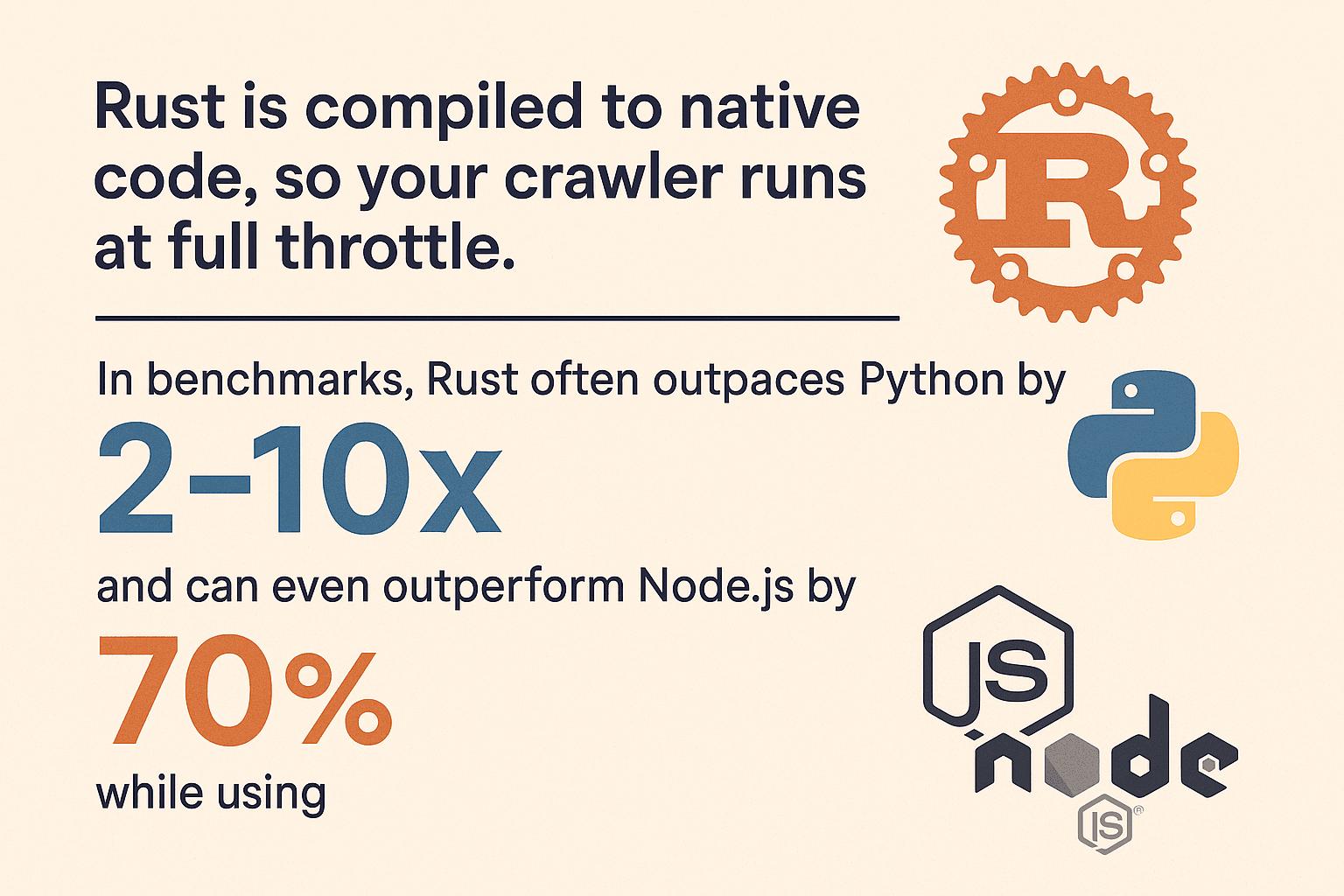

- 效能爆表:Rust 編譯出來是原生程式碼,爬蟲跑起來超快。根據多方測試,Rust 在運算密集型任務上通常比 Python 快2–10 倍,甚至比 Node.js 快70%,而且記憶體用量少90%(, )。

- 記憶體安全:Rust 的所有權機制能在編譯時就抓出潛在 bug,像記憶體洩漏或莫名其妙的當機都能避免。

- 並行無壓力:Rust 天生支援多執行緒,要同時抓 100 個網頁完全沒問題,型別系統還幫你顧好資料安全。

- 高穩定性:Rust 的錯誤處理(

Result和Option)讓你必須考慮失敗情境,爬蟲不會因為一個小錯誤就全掛。 - 安全性高:Rust 能防止緩衝區溢位、空指標等常見漏洞,讓你的爬蟲更不容易被惡意網頁攻擊。

跟 Python(簡單但慢又吃記憶體)或 Node.js(I/O 快但單執行緒、記憶體消耗大)比起來,Rust 在效能和穩定性上都更勝一籌,特別適合大規模爬取需求()。

Rust 網頁爬蟲開發環境怎麼建?

準備好要開工了嗎?這裡有 Rust 網頁爬蟲環境的快速設定教學:

1. 安裝 Rust 和 Cargo

Rust 透過 發佈,這個工具會幫你管理 Rust 版本和 cargo 建構工具。下載對應作業系統的安裝程式照著指示跑就好。Windows 用戶如果有提示,記得要裝 Visual C++ Build Tools。

驗證安裝:

1rustc --version

2cargo --version有看到版本號就代表安裝成功。

2. 建立新專案

打開終端機,輸入:

1cargo new rust_web_crawler

2cd rust_web_crawler這樣就會有一個包含 Cargo.toml 和 src/main.rs 的新專案。

3. 加入常用套件

開發爬蟲常用的套件有:

- (HTTP 請求)

- (HTML 解析和 CSS 選擇器)

- (非同步運行時,適合 async 爬蟲)

- (資料匯出)

安裝方式:

1cargo add reqwest scraper csv tokio --features full或手動編輯 Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. 選擇開發工具

我推薦 VS Code 搭配 擴充,享受自動補全、即時文件和靜態檢查。大型專案可以考慮 JetBrains CLion 或 IntelliJ 加裝 Rust 外掛。

5. 常見安裝問題排解

- 找不到

cargo?確認 Rust 的.cargo/bin已經加到 PATH。 - Windows 用戶請依提示安裝缺少的 C++ 工具。

- 依賴錯誤可以試試

cargo update或檢查Cargo.toml拼寫。

實作教學:打造你的第一個 Rust 網頁爬蟲

下面示範一個簡單的爬蟲,抓取網頁、解析商品資料並匯出成 CSV。你可以依需求再擴充。

Rust 抓取網頁內容

先引入 reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}正式環境建議加上錯誤處理:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};解析與擷取資料

接著用 scraper 解析 HTML,擷取商品資訊:

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}這種寫法參考自 ,適合大多數電商或目錄型網頁。

管理網址與避免重複爬取

實際爬蟲要追蹤已拜訪過的網址,避免重複抓取。常見做法如下:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // 建議用 `url` 套件!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}記得用 套件正規化網址,處理相對路徑、斜線和錨點。

實現並行加速爬取

這就是 Rust 真正發揮威力的地方。逐頁抓太慢,並行才有效率。

選項一:多執行緒

可以開多個執行緒,各自處理待抓清單。用 Arc<Mutex<>> 管理共用狀態,小型爬蟲很適合。

選項二:Tokio 非同步

要極速爬取,建議用 async。結合 tokio 和 async 版 reqwest,可以同時發送數百個請求,記憶體消耗卻很低。

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;非同步 Rust 不只快,還能避免資料競爭和奇怪的 bug,效能和穩定性都很強()。

匯出與儲存爬取資料

資料抓下來後,通常會想匯出。用 套件超方便:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();也可以用 直接序列化結構體,或匯出成 JSON。

善用 Thunderbit 加速與簡化網頁資料擷取

再來聊聊 。雖然自己寫程式很有成就感,但有時候你只想快點拿到資料。Thunderbit 是一款 AI 驅動的 Chrome 擴充,讓你不用寫程式,只要幾下點擊就能抓網頁資料。

Thunderbit 是一款人工智慧網頁爬蟲 Chrome 擴充,幫助商務用戶用 AI 從網站擷取資料。這是提升效率、減少重複性網路作業的神隊友。

Thunderbit 有哪些亮點?

- AI 智能欄位建議:Thunderbit 會自動掃描頁面,推薦可擷取的欄位(像姓名、Email、價格等)()。

- 一鍵爬取:只要點「爬取」,Thunderbit 就能把資料整理成表格。

- 子頁面自動擷取:需要抓詳情頁資訊?Thunderbit 會自動點連結,補齊表格內容()。

- 分頁與無限滾動支援:自動偵測並處理分頁或無限滾動頁面。

- 免費資料匯出:可直接匯出到 Excel、Google Sheets、Notion、Airtable 或 CSV,完全不用多餘操作。

- AI 自動填表:自動填寫表單或登入,輕鬆爬取需要驗證的頁面。

Thunderbit 對商務用戶和開發者都超實用,尤其遇到複雜、動態或大量 JavaScript 的網站時。

什麼時候該用 Thunderbit,什麼時候該用 Rust?

- Thunderbit:適合快速原型、臨時抓取,或讓團隊裡不會寫程式的人也能輕鬆取得資料。

- Rust:適合大規模、客製化或需要高度整合的爬蟲,追求極致效能和彈性。

其實,兩者搭配才是最強組合。

Rust 網頁爬蟲效能與其他技術比較

來點技術分析:Rust 跟主流爬蟲技術比起來表現如何?

| 語言/框架 | 速度 | 記憶體用量 | 並行能力 | 穩定性 | 生態系 |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 低 | 🟢 優異 | 🟢 高 | 中等 |

| Python (Scrapy) | 🚀 | 🔴 高 | 🟡 有限 | 🟡 中等 | 🟢 豐富 |

| Node.js | 🚀🚀 | 🔴 高 | 🟢 良好 | 🟡 中等 | 🟢 豐富 |

| Go | 🚀🚀 | 🟢 低 | 🟢 優異 | 🟢 高 | 中等 |

- Rust 通常比 Python 快2–10 倍,記憶體用量不到 Python 的10%(, )。

- Node.js I/O 效能不錯,但 JS 執行是單執行緒,遇到大量解析時容易卡住。

- Go 也是強勁對手,但 Rust 的記憶體安全和零成本抽象讓它在長時間、高吞吐量爬蟲上更有優勢。

如果你需要大規模爬取或極致效能,Rust 幾乎是無可取代的選擇。

Thunderbit 搭配 Rust,效率直接升級

我最推薦的流程就是:Thunderbit 跟 Rust 一起用。

- 快速原型:先用 Thunderbit 快速了解網站結構、取得樣本資料,省下摸索時間。

- 分工合作:讓 Thunderbit 處理動態、需登入或複雜頁面(AI 自動填表、子頁面爬取),Rust 負責靜態或 API 型頁面的大量抓取。

- 排程爬取:Thunderbit 支援排程自動抓取,Rust 後端再進行資料處理或合併。

- 賦能非開發人員:讓營運、行銷團隊用 Thunderbit 解決臨時資料需求,開發者專注於複雜任務。

- 彈性應對變動:如果 Rust 爬蟲因網頁改版失效,Thunderbit 的 AI 通常能即時適應,無需改程式。

這種混合策略,讓你同時擁有 Thunderbit 的靈活和 Rust 的強大。

Rust 網頁爬蟲常見問題與最佳實踐

打造穩健的爬蟲不只靠寫程式,更要預見網路世界的各種狀況。

常見挑戰

- 反爬蟲機制:使用真實 User-Agent、遵守

robots.txt、適當延遲請求、必要時用代理()。 - 驗證碼與登入:遇到驗證碼或複雜登入頁,可以用 Thunderbit 的 AI 自動填表,或用 headless browser(像 或 )。

- JavaScript 動態頁:資料透過 AJAX 載入時,建議找 API 端點;如果一定要渲染 JS,可以用 Thunderbit 或 headless browser。

- 錯誤處理:一定要妥善處理錯誤(

Result、Option)、設置逾時、記錄錯誤方便除錯。 - 並行陷阱:用 thread-safe 結構(像

Arc<Mutex<>>或DashMap),避免共用狀態成為瓶頸。 - 記憶體管理:大規模爬取時,建議即時寫入硬碟,避免全部資料留在記憶體。

- 合規與道德:遵守網站規範,不要過度請求,注意資料隱私法規。

最佳實踐

- 模組化設計:把抓取、解析、儲存分開,方便維護。

- 參數化設定:用設定檔或 CLI 參數管理網址、並行數、延遲等。

- 日誌紀錄:用

log套件做結構化日誌。 - 單元測試:針對解析邏輯寫測試,提升穩定性。

- 監控:長時間運行時,監控 CPU、記憶體、錯誤等指標。

更多排解技巧可以參考 和 。

結語與重點整理

用 Rust 打造網頁爬蟲,不只是技術挑戰,更是數據時代的競爭優勢。重點如下:

- Rust 是爬蟲神器:速度快、安全性高、並行能力強。

- 每一步都很重要:環境建置、抓取解析、網址管理、並行優化、資料匯出,缺一不可。

- Thunderbit 是你的秘密武器:不用寫程式,快速搞定複雜或動態網頁。

- 兩者結合效率最高:Thunderbit 負責原型和難搞頁面,Rust 處理大規模和客製化需求。

- 務實最重要:有時候,幾個點擊比寫幾百行程式還有效率。

想提升你的爬蟲能力,不妨試試 Rust,也別忘了讓 幫你分擔繁瑣工作。想學更多爬蟲和自動化技巧?歡迎造訪 。

祝你爬蟲順利,數據乾淨又聰明!

常見問答

1. 為什麼用 Rust 開發網頁爬蟲比 Python 或 Node.js 更好?

Rust 在效能、記憶體安全和並行支援上都大幅領先。Python、Node.js 適合快速腳本,但如果追求大規模、長時間或高可靠性的爬蟲,Rust 更勝一籌()。

2. Rust 網頁爬蟲必備套件有哪些?

建議用 reqwest 處理 HTTP 請求、scraper 解析 HTML、tokio 實現非同步、csv 匯出資料,url 套件則有助於網址正規化。

3. 如何處理 JavaScript 動態或需登入的網站?

遇到 JS 動態頁,建議找 API 端點或用 headless browser(像 fantoccini)。需要登入時,可以用 reqwest 管理 cookies,或用 Thunderbit 的 AI 自動填表功能。

4. Thunderbit 與 Rust 結合有什麼好處?

Thunderbit 以 AI 驅動、無需寫程式,適合原型、動態頁或非開發人員。Rust 則適合自訂、高效能爬蟲。兩者搭配,能兼顧速度和彈性。

5. 如何避免爬蟲被封鎖?

遵守 robots.txt、模擬真實瀏覽器 headers、適當延遲、必要時用代理。務必合規、尊重網站規範和資料隱私法()。

想親自體驗 Thunderbit?,馬上開始更聰明的資料擷取。更多網頁自動化深度教學,歡迎造訪 。

延伸閱讀