你有沒有想過,Google 為什麼能夠掌握整個網路的每個角落——甚至連你 2012 年寫的那篇沒人看的部落格都能找到?其實這背後沒有什麼神奇魔法,也不是一群實習生熬夜狂刷網頁。真正的主角是「爬蟲」:這些數位小幫手 24 小時不打烊地掃描、整理、索引全世界的網站。身為一個長期在自動化和人工智慧領域打滾的人(偶爾也會不小心讓網站當掉),我越來越能感受到這些機器人對網路世界的影響。如果你有經營網站,認識爬蟲絕對不是宅宅的專利,而是決定你網站能不能被找到的關鍵。

現在就讓我們一起來揭開爬蟲的神秘面紗,看看它們怎麼「看」你的網站、為什麼它們是 SEO 的基石,以及你該怎麼做才能讓自己的內容不被埋沒在數位沙漠裡。身為自動化控,我也會介紹像 這種 AI 工具,怎麼幫網站經營者和數據團隊帶來全新突破。

爬蟲網站基礎:什麼是爬蟲?它們怎麼運作?

你可以把爬蟲想像成一個數位圖書館員——或者說是一隻拿到組織學博士的蜘蛛——它的任務就是一個連結接一個連結地探索整個網路。技術上來說,爬蟲(又叫 spider 或 bot)是一種自動化軟體,會有系統地瀏覽網站、抓取網頁、追蹤連結,並收集所有看到的資訊。這就是 Google、Bing 等搜尋引擎建立龐大網頁索引的方式。

基本流程大致如下:

- 從一組已知網址開始(像你的首頁或一批「種子」網站)。

- 抓取每個網頁的 HTML 內容。

- 擷取網頁裡的超連結,把新連結加進待訪清單。

- 重複這個流程,不斷從一個連結跳到下一個,持續整理新頁面並更新搜尋引擎的索引。

如果你腦中浮現一個圖書館員在書架間來回穿梭、記錄每本書的標題並交叉比對——只是速度快上千萬倍,那你就抓到重點了。沒有爬蟲,大多數網站內容根本不會被搜尋引擎發現,使用者自然也看不到。

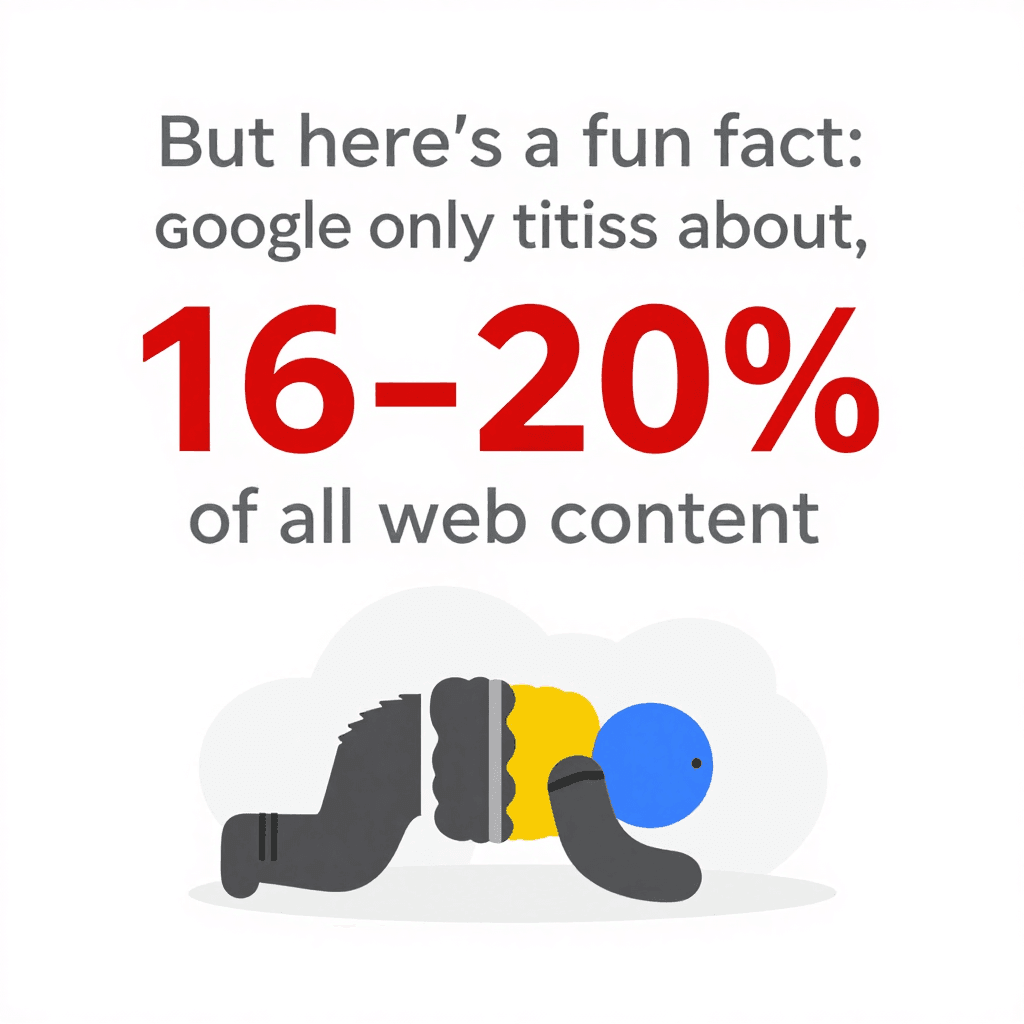

有趣的是:即使爬蟲這麼厲害,Google 其實只索引了。剩下的內容都藏在「深網」裡,連爬蟲都進不去。這也代表你網站的結構、對爬蟲的友善度,會直接影響曝光機會。

有趣的是:即使爬蟲這麼厲害,Google 其實只索引了。剩下的內容都藏在「深網」裡,連爬蟲都進不去。這也代表你網站的結構、對爬蟲的友善度,會直接影響曝光機會。

爬蟲如何「看見」與理解網站內容

爬蟲看網站的方式,跟人類完全不一樣。它們不在乎你的字型多美、圖片多吸睛,或你花多少心思做出炫酷的特效。它們只會讀原始 HTML,掃描文字、標籤和連結。這就像在看建築藍圖,而不是親自走進房間。

對爬蟲來說,最重要的是:

- HTML 結構: 會找標題、段落、清單和連結。

- 內部連結: 這些是指引爬蟲探索網站各區的路線。沒有連結的頁面,對爬蟲來說就像隱形一樣。

- 導覽與網站地圖: 有條理的選單和 sitemap 就像 GPS,幫爬蟲找到最重要的內容。

- 中繼資料與結構化數據: 像

<title>、<meta description>和 Schema.org 標記,能讓爬蟲更快理解頁面主題,就算主文沒寫明也沒關係。

如果你喜歡技術比喻,可以把網站想成一座城市,爬蟲是快遞司機,內部連結和 sitemap 就是路標和地圖,幫助他們送達每個地址。

Sitemap 與 robots.txt:爬蟲行為的關鍵角色

有兩個檔案對爬蟲來說超級重要:

-

XML Sitemap: 這是一份機器可讀的網站重要頁面清單。就像直接把所有書的目錄交給圖書館員。好的 sitemap 能確保爬蟲不會漏掉關鍵內容,就算你的內部連結不夠完善。對大型或複雜網站來說,完整的 sitemap 能。

-

robots.txt: 這是放在網站根目錄的簡單文字檔,用來告訴爬蟲哪些區域可以進、哪些不能。想擋掉機器人進後台或避免重複頁面被索引?就在這裡設定。但要小心:一個小失誤(像

Disallow: /)就可能讓整個網站從搜尋引擎消失——這是 SEO 常見的「翻車現場」。善用 robots.txt,能。

小提醒:記得在 robots.txt 裡標註 sitemap 路徑,等於告訴爬蟲「從這裡開始逛吧!」

為什麼爬蟲對網站這麼重要?SEO 與流量的影響

說穿了:如果爬蟲沒抓到某頁,那這頁就等於不存在。沒被爬取 = 沒被索引 = 沒有搜尋流量。你花心思做的內容、設計和品牌,Googlebot 找不到就全都白費。

為什麼這麼重要?因為,而。如果你網站對爬蟲不友善,就等於錯失最大流量來源。

一個被爬蟲完整抓取的網站,代表:

一個被爬蟲完整抓取的網站,代表:

- 更多頁面被索引: 增加出現在搜尋結果的機會。

- 排名更高: 搜尋引擎能更準確評估內容相關性。

- 內容更新更快: 新內容能及時被收錄與排名。

- 用戶體驗提升: 使用者更容易找到所需資訊,提升信任與流量。

很多網站只要修正爬蟲問題(像斷鏈、誤設 noindex),流量就會大幅成長——這就是「明明在眼前卻被忽略」的經典案例。

爬蟲如何影響搜尋排名

搜尋引擎會根據爬蟲抓到的資料,決定哪些頁面最符合用戶查詢。他們會看:

- 內容品質與關鍵字

- 內部與外部連結

- 頁面新鮮度與更新頻率

- 行動裝置友善度(Google 現在以行動版為主索引)

對大型網站來說,還有「爬取預算」的概念——也就是搜尋引擎在一定時間內願意抓取的頁數。如果你有 10 萬頁,但 Googlebot 一天只抓 5,000 頁,全部索引完可能要好幾週。所以(大多數頁面距首頁只需點幾下)特別重要,能讓爬蟲更有效率地覆蓋全站內容。

傳統爬蟲的限制:現代網站的挑戰

這裡開始變得有點複雜。現代網站充滿 JavaScript、動態內容和登入牆。傳統爬蟲——尤其是基礎型——很容易迷路、卡住,甚至直接放棄。

常見挑戰包括:

- 動態內容與 JavaScript: 很多爬蟲只能看到初始 HTML。如果內容是靠 JavaScript 載入(像無限滾動或「載入更多」按鈕),基礎爬蟲可能什麼都看不到。即使是 Google 的爬蟲能執行 JavaScript,遇到內容載入慢或需互動時,還是常常只抓到一部分(參考 )。

- 登入牆後的內容: 需要登入的頁面,大多數爬蟲進不去。雖然這通常是刻意設計,但有時候重要的公開內容卻被誤鎖在裡面。

- robots.txt 或 meta 標籤設定錯誤: 一個小失誤就可能讓整個區塊無法被爬取。

- 反機器人措施: CAPTCHA、嚴格的流量限制或封鎖未知用戶代理,都會讓爬蟲無法運作。

現在,爬蟲也被迫變得更聰明。但還是有很多內容會因此被忽略。

當傳統爬蟲遇上動態內容與 JavaScript

假設你經營電商網站,商品是隨著用戶滾動才載入。傳統爬蟲可能只看到前 20 項,後面全漏掉。又或者評論區要點選分頁才顯示,這些內容對大多數機器人來說也是隱形的。

結果就是:有價值的內容沒被索引,搜尋流量自然流失。解決方法是提供替代路徑(像分頁連結或伺服器端渲染 HTML),並用 Google Search Console 的網址檢查工具測試爬蟲實際看到什麼。

更聰明的爬蟲工具:Thunderbit 如何處理複雜網頁

這正是我最興奮的地方——因為這也是我們打造 的初衷。Thunderbit 不只是一般的爬蟲,而是結合 AI 的網頁資料擷取代理,能像人類一樣「閱讀」網站、萃取結構化資料,並輕鬆應對現代網頁的各種變化。

Thunderbit 有哪些厲害的地方?

- AI 智能欄位建議: 不用你自己研究 HTML 或寫程式,Thunderbit 的 AI 會自動掃描頁面,推薦最適合擷取的欄位(像「商品名稱」、「價格」、「聯絡信箱」等)。你可以微調,但大部分工作都自動完成。

- 子頁面自動抓取: 需要更多細節?Thunderbit 能自動點進每個子頁(像商品詳情、用戶檔案),補充額外資訊並整合到主資料表。再也不用手動點擊或複製貼上。

- 支援 JavaScript 與登入頁: Thunderbit 以 Chrome 擴充功能(或雲端真實瀏覽器)運作,能執行 JavaScript、等待動態內容載入,甚至抓取你已登入的頁面。

- 自動適應網站變動: 傳統爬蟲遇到版型小改就掛掉,Thunderbit 的 AI 每次都重新理解頁面,小變動不會影響流程。

- 排程自動抓取: 想每天早上自動更新價格或名單?只要用自然語言設定排程(像「每週一上午 9 點」),Thunderbit 就會自動執行。

Thunderbit 專為商業用戶設計——不管你是業務、行銷、電商還是房仲,只要需要資料,不用再煩惱技術門檻。匯出到 Google Sheets、Notion、Airtable 也只要一鍵(而且完全免費)。

Thunderbit 的 AI 功能:優化爬蟲與網站抓取

Thunderbit 的真正魔力在於自然語言處理。它不只是抓取原始文字,而是能理解語境。例如,它能分辨電話、信箱、商品價格,並自動標註、分類,甚至即時翻譯資料。

用戶回饋超好。有位用戶說:「Thunderbit 是我抓取網紅聯絡資料的首選。以前要花錢買資料庫,現在幾分鐘就能自己建立。」這種效率提升,正是我們想帶給大家的。

如果你曾經遇過網站每週都改版(尤其是電商平台),一定會愛上 Thunderbit 的「免維護」設計。AI 會自動適應,你不用再修修補補爬蟲腳本。

如何優化網站給爬蟲:結構、策略與智慧工具

那麼,怎麼讓你的網站成為爬蟲的天堂?以下是實用建議:

- 設計清楚的網站架構: 重要頁面距首頁不超過幾次點擊。(寬導覽、淺層級)能提升爬取效率與索引率。

- 強化內部連結: 用情境連結串聯相關頁面,定期檢查並修復斷鏈。

- 維護最新的 XML sitemap: 把所有重要網址列進去,並提交給 Google Search Console 和 Bing Webmaster Tools。

- 優化 robots.txt: 允許爬蟲存取關鍵內容,只封鎖必要區域,並反覆檢查避免誤封。

- 提升網站速度: 頁面載入快、錯誤少,爬蟲抓取更順利。優化圖片、用 CDN、修正伺服器錯誤。

- 處理重複內容: 用 canonical 標籤,避免爬蟲浪費預算在重複或近似頁面。

- 善用結構化資料與中繼標籤: 為商品、文章、活動等加上 Schema.org 標記,並妥善管理 meta 標籤。

- 監控爬蟲活動: 用 Google Search Console 的索引覆蓋與爬取統計,及早發現問題。

- 用智慧工具測試: 用 Thunderbit 或類似工具,檢查網站在爬蟲眼中的樣貌,並維持資料流程順暢。

網站架構如何配合爬蟲需求

好的網站結構不只對機器人友善,對用戶也一樣重要。定期用 Screaming Frog、Sitebulb 等工具做網站健檢,能及早發現爬蟲問題、斷鏈與孤兒頁,避免影響排名。

別忘了行動版:Google 採用行動優先索引,你的手機版網站必須包含所有重要內容與連結,否則就有頁面被漏掉的風險(參考 )。

Thunderbit 與傳統爬蟲工具比較

簡單對比如下:

| 面向 | Thunderbit(人工智慧網頁爬蟲) | 傳統爬蟲/爬蟲工具 |

|---|---|---|

| 易用性 | 無需寫程式,AI 自動建議欄位,商業用戶兩步即可上手。 | 需技術設定,常常要寫程式或手動選擇器。 |

| 適應力 | AI 自動適應版型變動,幾乎免維護。 | 網站結構一變就掛,需要手動修正。 |

| 動態內容支援 | 預設支援 JavaScript、登入與互動元素。 | 通常只能抓靜態 HTML,遇 JS 或登入頁就無法處理。 |

| 子頁面抓取 | 內建子頁與分頁自動抓取,資料自動整合。 | 需手動設定深度,遞迴抓取需額外設計。 |

| 資料結構化 | AI 產出可直接用的表格,支援多種資料型態(文字、數字、信箱、圖片、PDF 等)。 | 輸出原始資料,需自行定義結構,除非自訂程式,否則僅限 HTML。 |

| 整合性 | 一鍵匯出到 Google Sheets、Notion、Airtable、CSV 等。 | 通常需手動匯出/匯入,少有直接整合。 |

| 反機器人對策 | 自動處理代理、用戶代理、重試,採用瀑布式策略提升成功率。 | 用戶需自行處理 IP 封鎖、CAPTCHA 等,流程複雜且成本高。 |

| 目標用戶 | 非技術商業用戶:業務、行銷、營運、電商、房仲等。 | 開發者、IT、資料工程師。 |

| 價格 | 依用量計費,免費方案可用,按需付費。 | 訂閱制、按席位或伺服器計費,代理與維護常有隱藏成本。 |

總結:Thunderbit 讓先進爬蟲能力人人可用,不再是開發者專利。速度快、準確度高,能靈活應對不斷變化的網路世界。

重點整理:善用爬蟲提升網站價值

- 爬蟲是網站曝光的守門員。 網站不友善爬蟲,就等於放棄搜尋流量和新用戶。

- 結構與策略很重要。 清楚的導覽、內部連結、sitemap 和 robots.txt 是你的好幫手。

- 現代網站需要更聰明的爬蟲。 JavaScript、動態內容、登入牆會讓傳統爬蟲卡關,但 AI 工具如 能輕鬆應對。

- 持續監控不可少。 善用 Search Console、爬蟲健檢與智慧抓取工具,確保網站健康且能見度高。

- 升級你的工具箱。 不管是為 SEO 優化還是建立資料流程,聰明的爬蟲都能幫你省時、省力、提升決策品質。

想知道 Thunderbit 怎麼幫你抓取、索引、擷取最棘手網站的資料? 試試看!更多網頁爬取、SEO 和自動化技巧,歡迎造訪 。

常見問答

1. 什麼是爬蟲?為什麼對我的網站重要?

爬蟲是一種自動化軟體,會系統性地瀏覽並索引網站內容給搜尋引擎。如果網站不友善爬蟲,頁面就可能無法出現在搜尋結果,使用者也難以找到你。

2. sitemap 和 robots.txt 如何影響爬蟲?

sitemap 指引爬蟲找到最重要的頁面,robots.txt 則告訴它們哪些區域可以或不能進入。兩者都是提升爬取與索引效率的關鍵。

3. 傳統爬蟲遇到現代網站會有什麼問題?

傳統爬蟲難以處理大量 JavaScript、動態內容、需登入頁面與反機器人措施,導致重要內容可能被漏抓或只抓到一部分。

4. Thunderbit 如何處理複雜網站?

Thunderbit 利用 AI 像人類一樣「閱讀」頁面,支援 JavaScript 與登入頁,能抓取結構化資料,甚至自動處理子頁與動態內容,完全免寫程式。

5. 如何讓我的網站更友善爬蟲?

維持清楚的網站結構、善用內部連結、定期更新 sitemap 與 robots.txt、優化速度並監控爬蟲活動。用 Thunderbit 等智慧工具測試與優化網站爬取效果。

想深入了解?歡迎閱讀更多 教學,或訂閱我們的 ,掌握最新網頁自動化與 AI 抓取資訊。

延伸閱讀