網路上的數據早就成為現代商業不可或缺的資源,2025 年更是智慧銷售和市場分析的主戰場。我親眼看過無論是電商、房仲還是 SaaS 團隊,大家都在搶著把雜亂的網頁內容變成乾淨、好用的試算表。如果你會點進來這篇文章,肯定也想加入這波數據革命。好消息來了:Python 絕對是你最強的網頁爬蟲神隊友,而且就算你不是工程師,也能很快上手。

這份教學會從 Python 網頁爬蟲的基礎帶你起步,一路進階到用 Scrapy 這類框架做大規模數據擷取。我們還會介紹像 這種 AI 工具,怎麼讓商業用戶更快、更簡單地取得網路資料。不管你是剛入門的新手,還是想提升效率的老鳥,都能在這裡找到實用步驟、程式碼範例和實戰建議,讓你輕鬆晉升爬蟲高手。

什麼是 Python 網頁爬蟲?快速認識

網頁爬蟲就是自動幫你從網站抓資料——就像請電腦幫你高速、批量複製貼上。用 Python 寫個簡單腳本,就能抓網頁、解析 HTML,把你要的重點內容(像商品價格、聯絡方式、評論等)一網打盡。

對商業用戶來說,網頁爬蟲就是數據寶庫。銷售團隊靠它建立潛在客戶名單,電商團隊用來監控競品價格,分析師追蹤市場趨勢——這一切都靠把亂七八糟的網頁內容變成可分析的結構化資料。Python 會這麼受歡迎,就是因為它夠強大又超好上手,無論大專案還是小任務都很適合 ()。

為什麼 Python 是網頁爬蟲首選語言?

那為什麼大家都愛用 Python 來寫網頁爬蟲?三大原因:語法簡單、函式庫超多、社群超熱鬧。

- 語法超直覺: Python 程式碼一看就懂,初學者也能很快上手。

- 函式庫超齊全: BeautifulSoup、Scrapy、Requests 這些工具,讓你抓資料、解析、爬行都超順手。

- 多才多藝: Python 不只適合爬蟲,也是數據分析和自動化的主力語言,從資料抓取到分析一條龍搞定。

- 社群超活躍: 遇到奇怪的 HTML 結構?Stack Overflow 上一定有人已經解過。

來看看 Python 跟其他語言的比較:

| 語言 | 優點 | 缺點 | 最適用情境 |

|---|---|---|---|

| Python | 語法簡單、函式庫豐富、社群活躍 | 執行速度不如 C++/Java | 各種規模的爬蟲任務 |

| JavaScript | 原生支援 JS 動態網站 | HTML 解析較弱、非同步處理較複雜 | 單頁應用、動態網站 |

| R | 擅長數據分析 | 爬蟲框架較少 | 小型、統計分析導向任務 |

| Java/C# | 企業級、效能高 | 語法冗長、開發成本高 | 大型、整合性系統 |

Python 長年穩坐網頁爬蟲語言前三名,2023 年甚至超越 SQL,成為全球第三大熱門語言 ()。

Python 網頁爬蟲必備工具與函式庫

新手必備工具包如下:

- Requests: 最常用的 HTTP 請求函式庫,抓網頁就像開瀏覽器一樣簡單。

- BeautifulSoup: HTML/XML 解析神器,搜尋、過濾、提取資料都靠它。

- Scrapy: 適合大規模自動化爬取的完整框架。

- Selenium: 自動操作瀏覽器,專治 JavaScript 動態網頁。

- 其他:

lxml(高速解析)、pandas(數據處理)、Playwright(現代瀏覽器自動化)。

什麼時候用哪個?

- Requests + BeautifulSoup: 靜態頁面、小型專案首選。

- Scrapy: 需要爬大量頁面、分頁、批量匯出時最合適。

- Selenium/Playwright: 需互動或抓取 JS 動態內容時必備。

開始動手:Python 網頁爬蟲環境快速建置

來快速建立開發環境,就算你是 Python 新手也沒問題。

-

安裝 Python: 到 下載 Python 3.x,記得加到系統 PATH。

-

建立虛擬環境: 管理專案依賴,避免衝突。

1python3 -m venv venv 2# 啟動虛擬環境: 3# Windows: 4venv\Scripts\activate 5# Mac/Linux: 6source venv/bin/activate -

安裝函式庫:

1pip install requests beautifulsoup4 scrapy selenium -

專案結構: 小腳本用一個 .py 檔就好,Scrapy 則用

scrapy startproject myproject建完整專案。 -

測試安裝:

1import requests, bs4, scrapy, selenium 2print("所有函式庫載入成功!") -

設定 User-Agent(建議): 有些網站會擋「Python-requests」,模擬瀏覽器就好:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

恭喜你,環境搞定,準備開抓!

用 BeautifulSoup 解析 HTML:打造你的第一個 Python 網頁爬蟲

我們來寫個簡單爬蟲,抓 上的名言和作者。

步驟一:觀察網站結構

- 用 Chrome 開網站。

- 右鍵點名言,選「檢查」。

- 你會發現每則名言都在

<div class="quote">,文字在<span class="text">,作者在<small class="author">。

步驟二:撰寫並執行爬蟲

基本範例如下:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"請求失敗:{res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")常見陷阱:

- 如果元素不存在,記得先檢查是不是

None再取.get_text()。 - 選擇器一定要在瀏覽器裡反覆確認。

進階應用:用 Scrapy 優化 Python 網頁爬蟲

當你想從「只抓一頁」進階到「整站、所有分頁都要抓」時,就是 Scrapy 上場的時候。

- 架構設計: Scrapy 以「spider」(定義爬取邏輯的類別)、pipeline(數據處理流程)、非同步請求為核心。

- 為什麼選 Scrapy? 它專為大規模爬取設計,能高效抓上千頁、處理錯誤、輕鬆匯出 CSV/JSON。

什麼時候該用 Scrapy 而不是 BeautifulSoup?

- 需要自動爬多頁或自動跟連結時。

- 想要內建重試、限速、數據處理等功能時。

- 準備定期執行或多人協作的爬蟲專案。

Scrapy 實戰範例

這個 spider 會抓所有分頁的名言:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)執行:

1scrapy crawl quotes -O quotes.json你就能直接拿到完整 JSON 檔,完全不用自己寫迴圈。

當你的爬蟲專案規模變大,Scrapy 的架構和效率會讓你省下超多時間。

Thunderbit:AI 工具讓 Python 網頁爬蟲如虎添翼

老實說,就算用 Python,遇到動態網站、分頁、版型變動還是很頭痛。這時候 就超好用。

Thunderbit 是一款 AI 驅動的 Chrome 擴充功能,讓你兩步驟就能抓網站資料:

- AI 智能欄位建議: AI 會自動判斷頁面,推薦最適合提取的欄位(像「商品名稱」、「價格」等)。

- 一鍵爬取: 再點一下,Thunderbit 就能自動抓所有資料,連分頁、子頁面、無限滾動都能搞定。

我推薦 Thunderbit 的原因:

- 完全免寫程式: 商業用戶、分析師都能輕鬆上手。

- 應對複雜網站: 動態內容、子頁面、版型變動,AI 都能自動適應。

- 即時匯出: 資料可直接匯出到 Excel、Google Sheets、Airtable 或 Notion。

- 子頁面爬取: 需要每個商品或個人頁的細節?Thunderbit 會自動拜訪所有子頁並補齊資料。

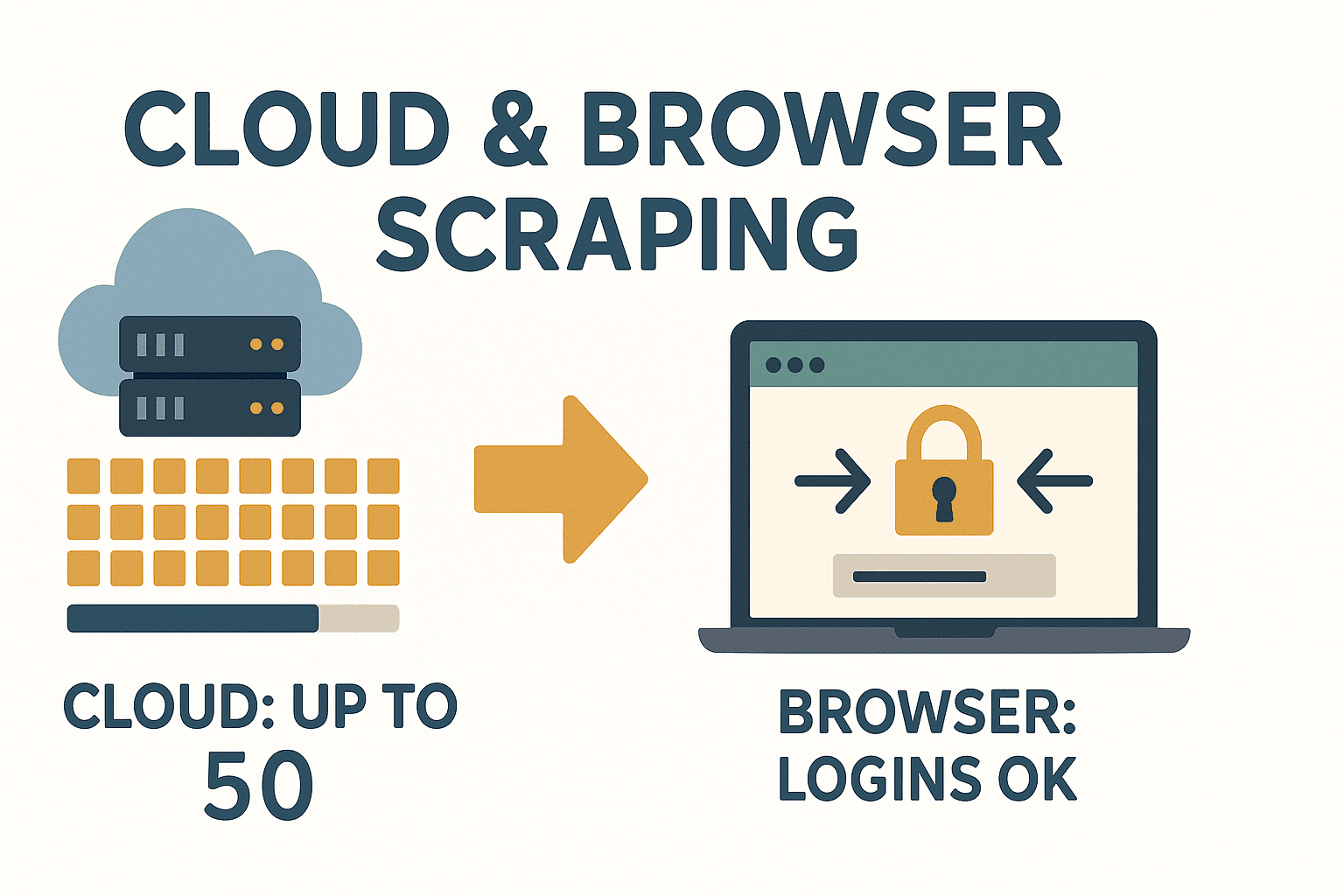

- 雲端/本地雙模式: 雲端可同時抓 50 頁,本地模式適合需登入的網站。

Thunderbit 對於想要快速取得資料、又不想每次網站變動就重寫程式的人來說,真的超級方便。

Thunderbit 對於想要快速取得資料、又不想每次網站變動就重寫程式的人來說,真的超級方便。

什麼時候該用 Thunderbit 這類 AI 工具?

- 你需要「馬上」拿到資料,不想等 IT 或自己寫程式。

- 網站結構複雜、動態內容多、經常變動。

- 想讓非技術同事也能自己收集資料。

- 需要一次完成爬取和資料增強(像翻譯、分類等)。

Thunderbit 很適合跟 Python 流程搭配——用來快速原型、處理難搞網站,或省下維護爬蟲的麻煩。更多比較可以參考 。

處理動態內容與分頁:Python 網頁爬蟲進階技巧

現在的網站很多都用 JavaScript,這對爬蟲來說是大魔王。解法如下:

- 動態內容: 如果資料是 JS 動態載入(HTML 原始碼沒有),就用 Selenium 或 Playwright 自動操作瀏覽器,等內容載入後再抓。

- 分頁處理: 透過「下一頁」連結或遞增 URL 頁碼迴圈抓。Scrapy 內建 request-follow 機制,處理分頁超方便。

BeautifulSoup 處理分頁範例:

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...提取名言...

12 page += 1遇到無限滾動或「載入更多」按鈕: 用 Selenium 自動滾動或點擊,或在瀏覽器網路面板找 API 直接用 Requests 模擬。

數據儲存:讓爬取資料發揮商業價值

資料抓下來後,怎麼存最方便?

- CSV: 通用格式,Excel/Sheets 都能開。

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: 用 pandas 快速匯出。

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - 資料庫: 大型或長期專案可用 SQLite 或 PostgreSQL。

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...建立資料表、寫入資料... 4conn.close()

根據團隊需求選擇格式。要分享給非技術同事,Excel 或 Google Sheets 最直覺。

法律與道德:Python 網頁爬蟲必知守則

爬蟲很強大,但也要守規矩。這裡有幾個合規建議:

- 只抓公開資料: 需要登入或付費牆的內容請三思。

- 檢查服務條款: 有些網站明文禁止爬蟲,違規可能被封鎖甚至觸法 ()。

- 尊重 robots.txt: 雖然不是法律強制,但屬於網路禮儀。

- 避免個資: GDPR、CCPA 等法規下,抓姓名、信箱、電話等個資風險很高。

- 勿過度請求: 加入延遲、限制頻率,盡量在離峰時段執行。

合規快速檢查表:

- 詳讀網站 ToS 和 robots.txt。

- 避免抓個人或敏感資料。

- 標註資料來源。

- 禮貌抓取,別讓伺服器吃不消。

更多法律實務可參考 。

疑難排解與最佳實踐:讓 Python 網頁爬蟲更穩定

爬蟲過程難免遇到狀況,這裡整理常見問題和解法:

- HTTP 錯誤(403、404、429): 設定真實 User-Agent、降低請求頻率、妥善處理錯誤。

- IP 被封鎖: 大規模爬取時可用代理或輪換 IP,但要注意道德界線。

- 遇到驗證碼(CAPTCHA): 遇到就要考慮是否繼續。有第三方服務可解,但屬灰色地帶。

- 網站結構變動: 選擇器要寫得有彈性,提取前先檢查

None,多用 try/except 包裝。 - 編碼問題: 一律用 UTF-8,並在 Excel/Sheets 測試輸出。

最佳實踐:

- 每個步驟都記錄 log,方便追蹤錯誤。

- 失敗請求自動重試並設回退機制。

- 先在少量頁面測試,確認沒問題再擴大規模。

- 持續監控輸出數量,若異常即時調整。

如果你不想每次網站變動就修爬蟲, 的 AI 能自動適應版型變化,省下超多維護工夫。

Thunderbit 的 AI 方案,讓你專心做數據洞察,不用再煩惱維護。

結論與重點整理

用 Python 做網頁爬蟲,能把網路上的雜亂資訊變成有價值的結構化數據。重點如下:

- Python 是爬蟲首選語言, 語法簡單、函式庫強大。

- Requests + BeautifulSoup 適合小型、靜態任務;Scrapy 則適合大規模自動化爬取。

- Thunderbit 結合 AI,讓任何人都能輕鬆抓資料——免寫程式、免維護。

- 動態內容與分頁 可用 Selenium 或 Scrapy 內建功能處理。

- 數據儲存 可選 CSV、Excel 或資料庫,依商業需求彈性調整。

- 合法合規: 只抓公開資料、遵守網站規則、避免個資。

- 打造穩健爬蟲: 記錄 log、自動重試、監控變動,或交給 Thunderbit AI 自動處理。

準備好開始了嗎?不妨試著寫你的第一個 Python 爬蟲,或直接 ,體驗網頁數據擷取的輕鬆與高效。更多技巧和深入教學,歡迎逛逛 。

常見問題

1. 用 Python 做網頁爬蟲是否合法?

只要抓公開資料,並遵守網站服務條款、robots.txt 和隱私法規(像 GDPR),Python 網頁爬蟲是合法的。避免抓個資或敏感資訊,開工前一定要確認規則 ()。

2. BeautifulSoup 和 Scrapy 有什麼不同?

BeautifulSoup 是輕量級 HTML 解析工具,適合小型或單頁抓取。Scrapy 則是完整框架,能自動爬多頁、處理分頁、批量匯出。小專案用 BeautifulSoup,大型專案選 Scrapy ()。

3. 如何用 Python 處理 JavaScript 動態網站?

用 Selenium 或 Playwright 自動操作瀏覽器,等 JS 載入後再抓資料。也可以在瀏覽器網路面板找 API,直接用 Requests 模擬。

4. Thunderbit 跟 Python 傳統爬蟲函式庫有什麼不同?

Thunderbit 利用 AI 自動建議欄位、處理子頁面、適應版型變動,完全免寫程式。很適合需要快速取得資料、又不想維護爬蟲的商業用戶和團隊 ()。

5. 如何儲存和分享爬下來的資料?

可以匯出成 CSV 或 Excel,方便團隊分享;大型專案可用 pandas 存進資料庫。Thunderbit 支援直接匯出到 Google Sheets、Airtable、Notion,或免費下載 CSV/Excel。

祝你爬蟲順利,數據永遠乾淨、結構化、超好用!