網路世界的發展速度真的快到讓人跟不上,如果你在商業、科技圈打滾,或像我一樣是個數據控,你一定會發現:真正的價值其實藏在你能「收集」到的資料裡,而不是表面上看到的那些資訊。現在,越來越多企業投入自動化網頁資料蒐集,全球網頁爬蟲產業預計到 2030 年會衝到 的規模。更有趣的是,現在超過 都已經靠網頁爬蟲或爬蟲工具來強化 AI、數據分析和業務流程。

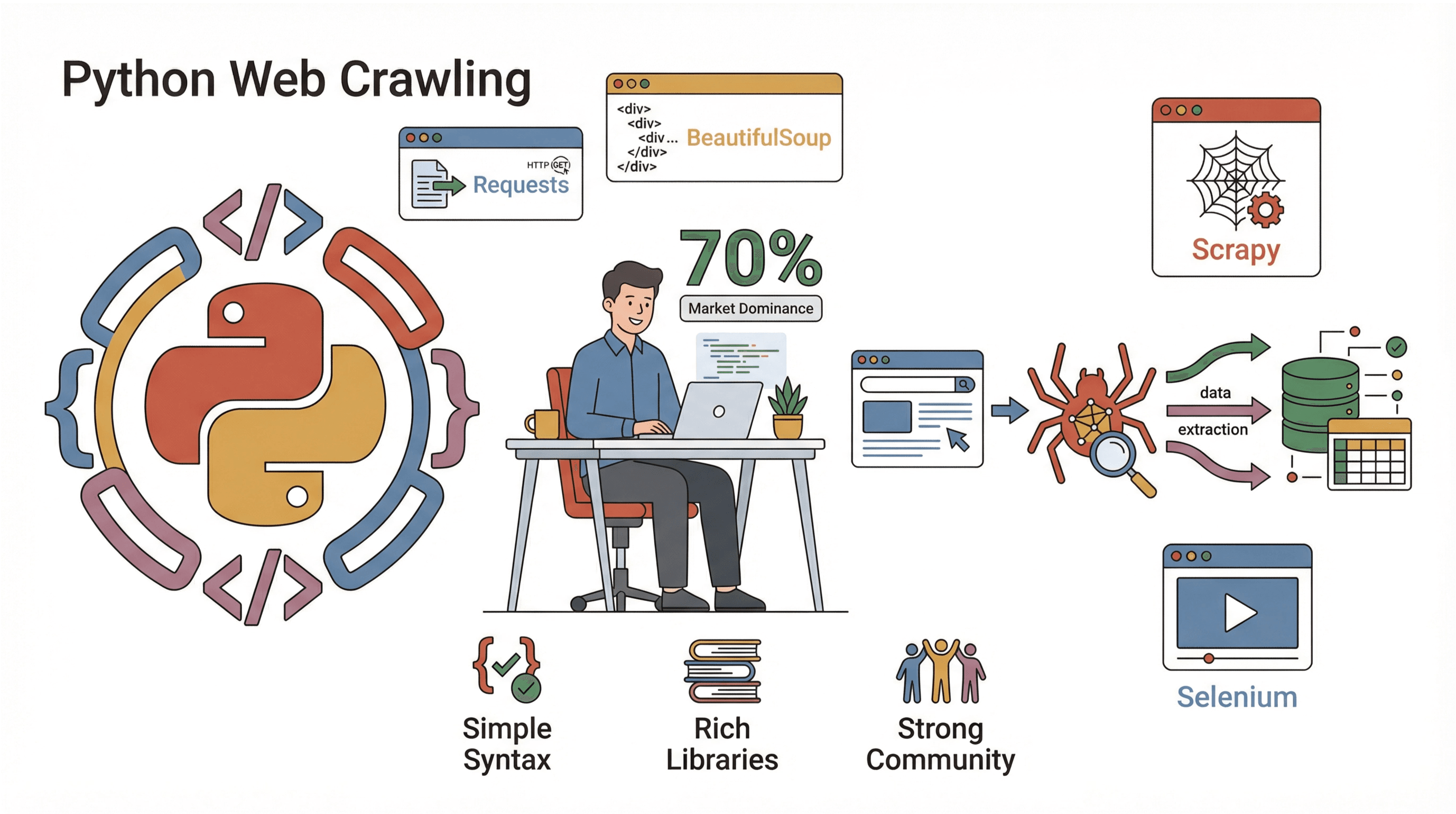

那要怎麼跟上這波潮流?對大多數人來說,Python 絕對是首選。它是打造網站爬蟲的熱門語言,簡單又強大,還有一堆現成的函式庫,讓你抓資料變得超輕鬆。這篇文章會帶你認識什麼是網站爬蟲、為什麼 Python 是最強選擇、怎麼一步步打造自己的爬蟲,以及像 這種工具怎麼讓整個流程變得更簡單(尤其適合只想滑鼠點一點、不想寫程式的人)。不管你是工程師、數據行銷人,還是想自動化重複工作的上班族,都能在這裡找到讓你網路資料蒐集升級的訣竅。

什麼是網站爬蟲?(你為什麼該關心?)

簡單說,網站爬蟲就是一種自動瀏覽網頁的程式,會自動拜訪頁面、追蹤連結,還能(選擇性)沿路收集資料。你可以把它想像成一個永遠不會累、也不會手滑關掉分頁的超級網路衝浪手。爬蟲是搜尋引擎(像 Googlebot)的基礎,但企業也會用它來做價格監控、市場調查等各種應用。

那麼,爬蟲和爬取有什麼差別?爬蟲重點在「發現」和導航頁面(像在畫城市地圖),而爬取則是「擷取」特定資料(像收集全城的餐廳菜單)。實際上,大多數專案都會兩者一起用:先爬蟲找到頁面,再爬取需要的資料(參考 )。

企業常見爬蟲應用場景:

- 名單開發: 自動從目錄或社群網站收集聯絡資訊。

- 價格監控: 追蹤競爭對手數千項商品的價格與庫存。

- 內容監控: 當品牌在新聞、部落格或論壇被提及時即時獲知。

- SEO 檢查: 掃描自家網站找出壞連結或缺漏的中繼資料。

- 市場調查: 匯整房地產、職缺或商品評論等大量資料進行分析。

如果你曾經想過「要是能分身做網路研究就好了」,那爬蟲就是你最強的分身。

為什麼網站爬蟲對企業自動化超重要

實際上,企業為什麼要投資爬蟲和爬取工具?因為回報率真的很高。下面簡單整理不同團隊怎麼用爬蟲,以及帶來的好處:

| 應用場景 | 主要效益 | 使用對象 |

|---|---|---|

| 名單開發 | 自動建立潛在客戶名單,節省大量時間 | 業務、招募 |

| 價格追蹤 | 即時掌握競爭對手動態,靈活調整定價 | 電商、產品團隊 |

| 內容監控 | 保護品牌聲譽,掌握市場趨勢 | 行銷、公關 |

| SEO 網站檢查 | 提升網站健康度與排名 | SEO、網站管理員 |

| 市場調查 | 快速取得大規模、即時的分析資料 | 分析師、研究團隊 |

有研究指出,自動化每週蒐集 5-7 個網站資料的任務,能讓一個員工一年省下超過 50 小時——如果整個團隊都用上,你就知道為什麼 。

Python:打造網站爬蟲的首選語言

那為什麼 Python 能在網頁爬蟲界稱王?主要有三大原因:

那為什麼 Python 能在網頁爬蟲界稱王?主要有三大原因:

- 語法簡單: Python 超好讀、超好學,幾行程式就能寫出實用爬蟲。

- 函式庫超多: 從抓網頁、解析 HTML 到處理 JavaScript,Python 都有現成工具包。

- 社群超大: 幾乎 都用 Python,資源、教學一堆,遇到問題很快就能找到解法。

Python 網頁爬蟲常用函式庫:

- Requests: 最簡單的 HTTP 請求工具,抓網頁超方便。

- BeautifulSoup: 解析 HTML、搜尋元素的首選。

- Scrapy: 適合大型專案的全方位爬蟲框架。

- Selenium: 自動操作瀏覽器,專門對付 JavaScript 動態網頁。

跟 Java、C# 這些語言比起來,Python 讓你從想法到成品的開發時間大幅縮短。對數據分析師來說,還能直接把爬蟲結果丟進 Pandas 處理,省去一堆轉檔麻煩。

解析方法比較:Regex、BeautifulSoup、Scrapy

要從網頁「擷取」資料,有幾種常見方法。下面幫你比較一下各自的特色:

| 方法 | 運作方式 | 優點 🟢 | 缺點 🔴 | 適用情境 |

|---|---|---|---|---|

| Regex | 直接用模式比對原始 HTML | 快速、適合簡單且格式固定的資料 | HTML 結構一變就失效,維護困難 | 快速抓網址、簡單資料 |

| BeautifulSoup | 將 HTML 解析成樹狀結構,標籤搜尋 | 易用、彈性高,能處理雜亂 HTML | 大型頁面較慢,需自行設計爬蟲邏輯 | 多數中小型爬蟲腳本 |

| Scrapy | 完整爬蟲框架,支援 CSS/XPath 解析 | 快速、可擴展,爬取與解析一條龍 | 上手門檻較高,設定較多 | 大型、商業級爬蟲 |

- Regex 就像用金屬探測器在沙灘上找東西——快,但沙子一動就找不到。

- BeautifulSoup 像拿著地圖和鏟子——你能挖任何地方,但得自己走遍全場。

- Scrapy 則像帶著一整隊人馬和卡車——對小沙坑太大材小用,但大規模任務無敵。

新手建議從 Requests + BeautifulSoup 開始,學會基礎後再升級到 Scrapy。

實作教學:用 Python 打造簡易網站爬蟲

準備動手了嗎?我們來寫一個基本爬蟲,能自動拜訪頁面、追蹤連結並擷取資料。每一步都有範例程式碼,直接照抄就能用。

步驟 1:建立 Python 開發環境

先確認你已經安裝 Python 3.10 以上版本(用 python --version 檢查)。建議為專案建立虛擬環境:

1python -m venv venv

2source venv/bin/activate # Windows 用 venv\Scripts\activate接著安裝需要的函式庫:

1pip install requests beautifulsoup4就這麼簡單!打開你最愛的編輯器,準備寫爬蟲吧。

步驟 2:撰寫第一個網站爬蟲腳本

先從抓取單一網頁開始。以下是簡單範例:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # 非 200 OK 會報錯

5 print(response.text[:500]) # 預覽前 500 字元

6crawl_page("https://www.scrapingcourse.com/ecommerce/")你應該會在終端機看到一段 HTML,代表已經連線成功。

步驟 3:自動追蹤連結,擴大爬取範圍

接下來讓爬蟲自動追蹤連結,拜訪多個頁面。我們會維護一個待訪問網址清單,以及已拜訪網址集合(避免重複):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # 安全上限

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Failed to retrieve {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawled: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)這段程式會自動爬取最多 20 頁,並顯示每次拜訪的網址。

步驟 4:從頁面擷取資料

假設你想抓取每頁的商品名稱和價格,可以這樣做:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ...(同上)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ...(其餘爬蟲邏輯)

18# 儲存為 CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Scraped {len(product_data)} products.")這樣你就能得到一份包含所有商品資料的 CSV 檔,後續分析或匯入都超方便。

步驟 5:除錯與優化爬蟲

寫好爬蟲是一回事,讓它穩定運作又是另一回事。以下是我的實戰建議:

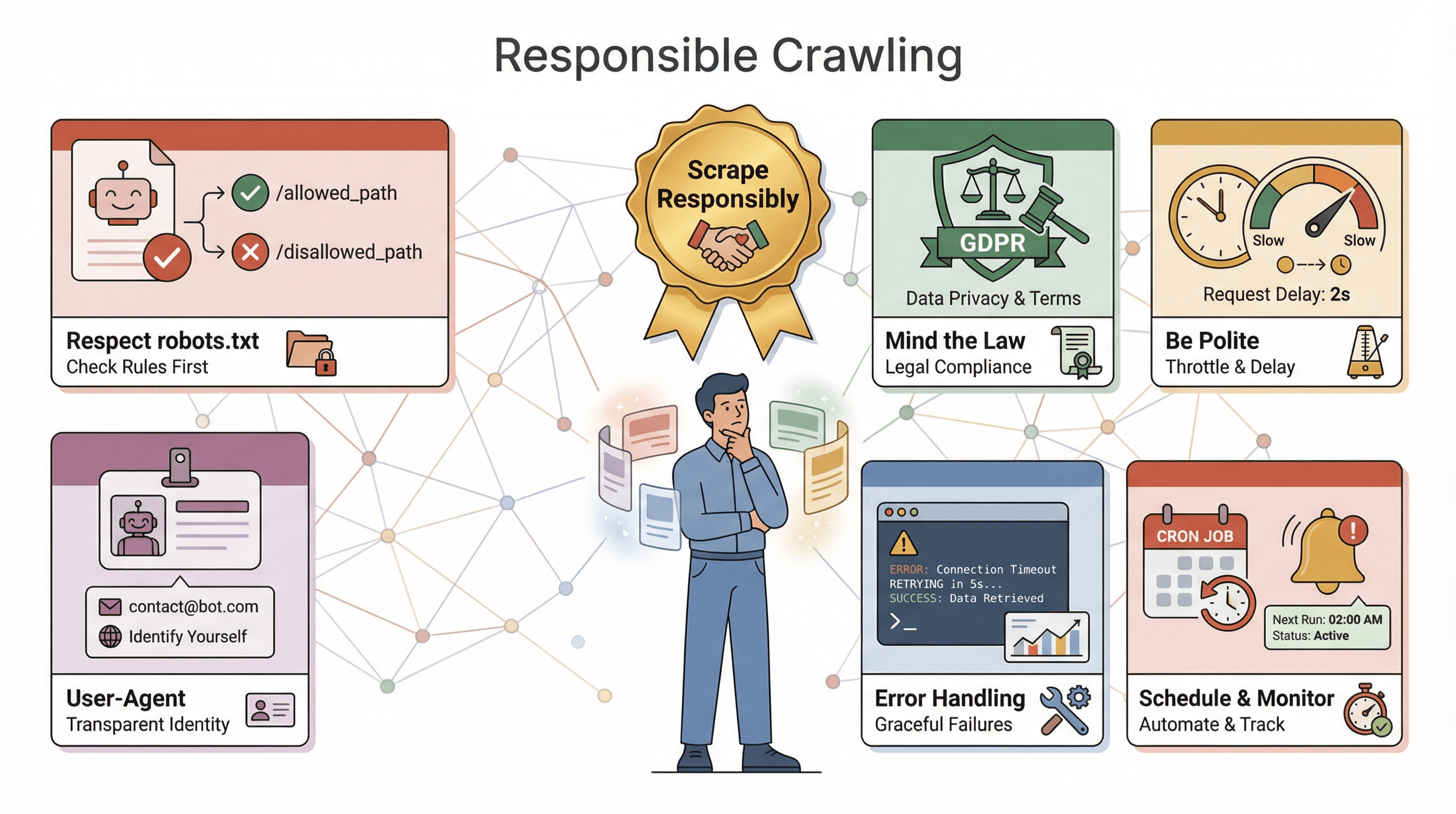

- 設定 User-Agent 標頭: 有些網站會擋掉「Python-requests」,偽裝成瀏覽器就好:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - 錯誤處理要完善: 用 try/except 跳過無法存取的頁面。

- 避免無限循環: 務必記錄已拜訪網址,並設置最大頁數限制。

- 適當延遲請求: 每次請求間加上

time.sleep(1),降低被封鎖風險。 - 遵守 robots.txt: 一定要尊重網站的爬蟲規則()。

- 記錄進度: 每爬一頁就列印或記錄網址,方便除錯。

如果遇到被封鎖、內容怪怪或資料缺漏,檢查 headers、降低速度,並確認沒有違反反爬蟲規則。

Thunderbit:用 AI 讓網站爬蟲變得超簡單

接下來介紹一鍵搞定網頁爬蟲的神器:。雖然我很愛寫 Python,但有時候你只想要資料,不想花時間設定、除錯或維護。Thunderbit 是一款 AI 驅動的網頁爬蟲 Chrome 擴充功能,讓你只要滑鼠點幾下就能從任何網站抓資料。

Thunderbit 有哪些亮點?

- AI 智能欄位建議: Thunderbit 會自動分析頁面,推薦可擷取的資料欄位,完全不用研究 HTML 或寫選擇器。

- 無需寫程式、直接在瀏覽器操作: 支援登入網站、JavaScript 動態頁面。

- 子頁面自動爬取: 需要更多細節?Thunderbit 可自動拜訪每個子頁(像商品詳情),讓你的資料表更完整。

- 一鍵匯出: 資料可直接匯出到 Excel、Google Sheets、Airtable 或 Notion,完全不用自己轉檔。

- 雲端或本地爬取: 公開網站可用雲端模式,登入或複雜網站可用本地瀏覽器模式。

- 自動排程: 可設定定時自動爬取,完全不用自己架設伺服器。

對商業用戶來說,Thunderbit 真的徹底改變了資料蒐集流程,從「我需要這些資料」到「這是我的試算表」只要幾分鐘。如果你是開發者,也能把 Thunderbit 當作輔助工具,快速處理臨時需求或備用方案。

想親自體驗? 試著抓你最常用的網站。免費方案可爬少量頁面,付費方案每月只要 $15 美元起,含 500 點數。

用 Python 寫網站爬蟲時必須注意的重點

在讓你的爬蟲大顯身手前,這裡有幾個重要提醒:

在讓你的爬蟲大顯身手前,這裡有幾個重要提醒:

- 遵守 robots.txt: 大多數網站會有

robots.txt,規定哪些頁面可被爬取。忽略這些規則可能被封鎖,甚至觸法。一定要查閱並遵守()。 - 注意法律規範: 有些網站服務條款禁止爬取,若涉及個資,還需遵守 GDPR、CCPA 等隱私法規(參考 )。不確定時,建議只抓公開、非敏感資料。

- 禮貌爬取: 不要對網站發送過多請求,適當延遲、隨機間隔,避開尖峰時段。

- 標明身份: 使用自訂 User-Agent,若大規模爬取可加上聯絡資訊。

- 錯誤處理與日誌: 預期網站會變動、頁面會壞、資料會亂,務必加強錯誤處理、日誌與監控,方便快速修復。

- 排程與監控: 定期爬取時,善用排程工具(如 cron 或 Thunderbit 內建排程),並設置異常警示。

黃金守則:負責任地爬取。網路是大家的資源,千萬別成為「那個」讓大家討厭的機器人。

進階技巧:讓 Python 網站爬蟲更強大

學會基礎後,你可能想讓爬蟲更進階。這裡有一些進階招式:

- 處理 JavaScript 動態資料: 用 Selenium 或 Playwright 抓取動態載入的內容。

- 大規模擴展: 專案變大時,改用 Scrapy 或 async 函式庫(像

aiohttp)實現多線程爬取。 - 使用代理伺服器: 輪換 IP,避免高頻率爬取被封鎖。

- 自動化資料流程: 直接寫入資料庫,或串接雲端儲存處理大量資料。

- 監控與警示: 長時間運作時,設置日誌、健康檢查與異常通知。

如果你的爬蟲已經變成關鍵任務,建議考慮用託管服務或 API 來分擔重擔。要爬多種版型網站,也可以把解析邏輯模組化,日後維護更輕鬆。

結語與重點整理

用 Python 打造網站爬蟲,是現代數據時代最實用的技能之一。本文重點回顧:

- 網站爬蟲 能自動拜訪並擷取網頁資料,是企業自動化、研究、競爭情報的必備工具。

- Python 因語法簡單、函式庫強大、社群龐大,成為爬蟲首選語言。

- 解析方法 有別:簡單任務用 regex,常規腳本用 BeautifulSoup,大型專案用 Scrapy。

- 循序漸進,你能從抓一頁到爬整站、儲存結構化資料,無需高深學歷。

- Thunderbit 讓資料爬取更進化,AI 智能、免寫程式、即時匯出,特別適合商業用戶或追求效率的人。

- 負責任爬取 是關鍵:遵守網站規則、妥善處理錯誤、重視道德。

- 進階擴展 靠對的工具——JavaScript 用 Selenium,並發用 Scrapy,無程式就用 Thunderbit。

最好的學習方式就是動手做——寫個小腳本、試用 Thunderbit,看看你能挖出哪些資料。網路就是你的資料寶庫(或說自助餐,對我這種數據控來說)。

想深入了解?推薦這些資源:

- 更多技巧、教學與進階應用。

祝你爬蟲順利,資料乾淨,咖啡永遠不會見底!

常見問題

1. 網站爬蟲和網頁爬蟲有什麼不同?

網站爬蟲會系統性地拜訪、發現網頁(像畫網站地圖),而網頁爬蟲則是從這些頁面擷取特定資料。多數實務專案會兩者一起用:先爬蟲找頁面,再爬取資料。

2. 為什麼 Python 這麼適合寫網站爬蟲?

Python 易學、函式庫強大(如 Requests、BeautifulSoup、Scrapy、Selenium),社群龐大。近 70% 的網頁爬取專案都用 Python,已經是業界標配。

3. 什麼時候該用 regex、BeautifulSoup 或 Scrapy?

格式簡單可用 regex,常規腳本建議用 BeautifulSoup,需速度、並發與穩定性的商業級爬蟲則選 Scrapy。

4. Thunderbit 和用 Python 寫爬蟲有什麼差別?

Thunderbit 讓你用 AI、免寫程式就能抓資料——只要點選欄位、匯出即可,適合商業用戶或臨時需求。Python 則更彈性、可自訂,但需要寫程式和維護。

5. 寫爬蟲時有哪些法律或道德風險?

一定要查閱並遵守 robots.txt、網站服務條款,避免未經同意蒐集敏感或個資,請求頻率要適當。負責任的爬取才能讓網路生態永續。

想親自試試? 或打開你最愛的 Python 編輯器開始爬蟲之旅。資料就在那裡,等你來挖掘!

延伸閱讀