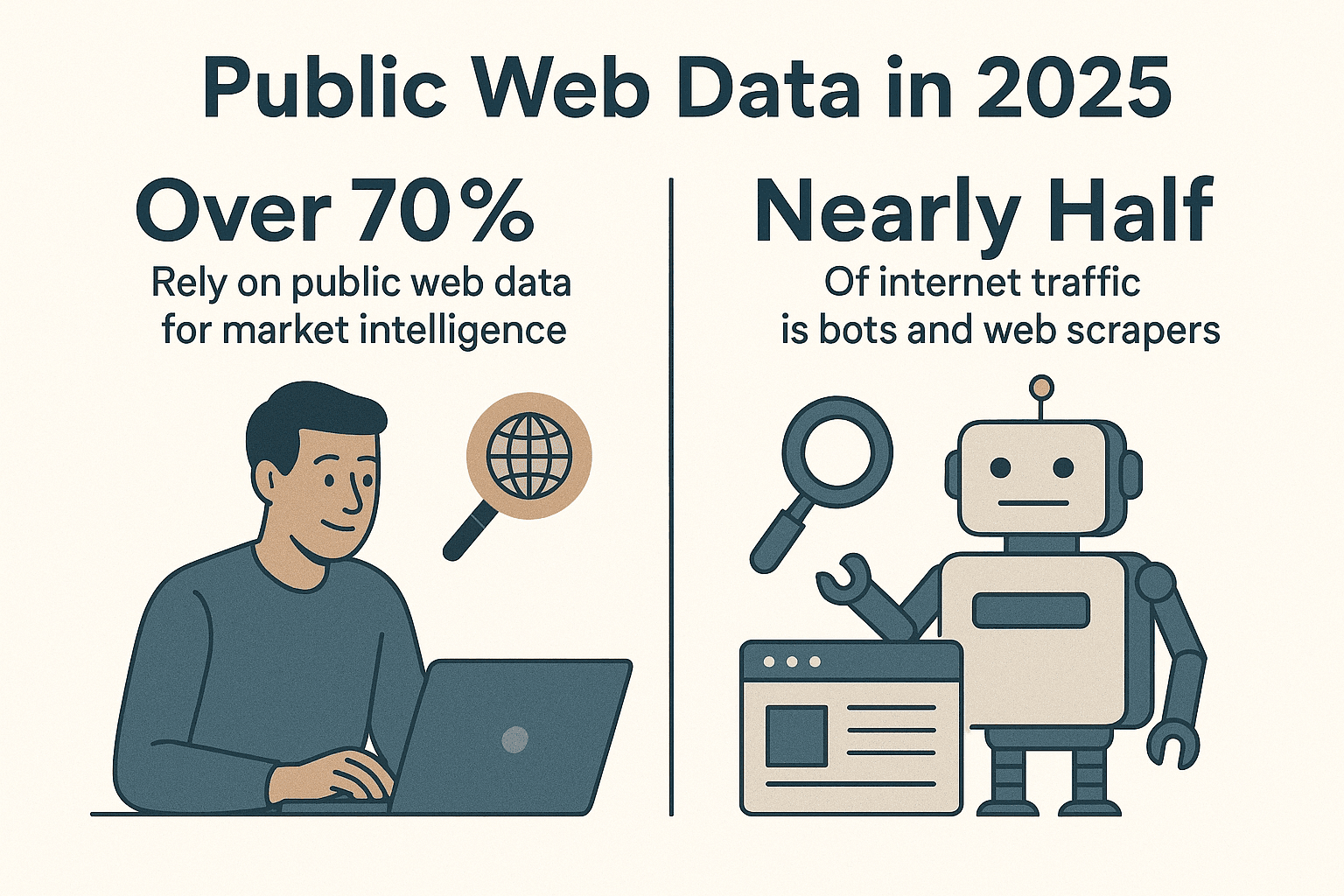

在網路這個資訊爆炸的時代,數據就是金礦,大家都搶著把這些雜亂的網頁內容變成有用的商業洞察。你知道嗎?現在有超過,而且現今網路流量裡,幾乎一半都是自動化機器人和網頁爬蟲在跑,不是人類在瀏覽 ()。身為一個長年開發自動化工具的工程師(寫過的爬蟲比我去過的網站還多),我可以很直接告訴你:如果你還沒用 Python 網頁爬蟲來自動化數據收集,真的等於錯過了大幅提升效率的機會。

Python 會成為網頁爬蟲的首選語言,絕對不是偶然。不管你是做銷售、行銷、營運還是學術研究,只要善用 Python 網頁爬蟲,真的可以省下超多時間,還能挖到一般方法拿不到的資訊。這篇文章會帶你從零開始打造高效 Python 網頁爬蟲,分享我最愛用的函式庫和實戰技巧,還有像 這種工具,怎麼幫你輕鬆搞定連資深工程師都頭痛的動態網站。

為什麼大家都用 Python 寫網頁爬蟲?

直接說重點:Python 在網頁爬蟲界幾乎是無敵的。根據最新產業數據,將近,遠遠甩開 JavaScript 和其他語言。2024 年,Python 更是在 GitHub 上超車 JavaScript,成為最受歡迎的語言 (),這很大一部分就是因為它在數據科學和自動化領域的強勢地位。

為什麼 Python 這麼適合做爬蟲?

- 語法超直白: Python 的語法很親民,新手很快就能上手,老手也能快速開發。

- 函式庫超多: 、、、 等等,從發送網頁請求、解析 HTML 到自動操作瀏覽器,通通有。

- 社群超熱絡: 卡關時網路上教學、範例一堆,幾乎所有爬蟲問題都找得到解法。

- 彈性超高: 不管是一次性小腳本還是大規模爬蟲系統,Python 都能輕鬆搞定。

跟其他語言比起來,Python 真的又強又親切。JavaScript(Node.js)雖然處理動態內容很強,但異步寫法對新手來說有點難。Java、C# 雖然穩定,但開發流程比較繁瑣。Python 讓你可以專心在數據本身,開發效率直接拉滿。

Python 網頁爬蟲開發環境怎麼建?

開始寫爬蟲前,先把開發環境準備好。這是我每次新專案的標配流程:

1. 安裝 Python 3

去 下載最新版 Python 3.x,或用作業系統的套件管理器安裝。記得終端機要能跑 python 或 python3。

2. 建立虛擬環境

用虛擬環境把專案依賴隔開:

1python3 -m venv .venv

2# Unix/Mac

3source .venv/bin/activate

4# Windows

5.venv\Scripts\activate這樣安裝套件才不會亂掉,管理起來也乾淨。

3. 安裝必備函式庫

啟動虛擬環境後,直接裝主流函式庫:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemy各函式庫的用途:

- Requests: 發送 HTTP 請求抓網頁。

- BeautifulSoup: 解析、操作 HTML。

- lxml: 超快的 HTML/XML 解析(可跟 BeautifulSoup 搭配)。

- Scrapy: 強大爬蟲框架,適合大規模爬取。

- Selenium: 自動化瀏覽器,搞定 JavaScript 動態網頁。

- pandas: 數據清理、處理。

- SQLAlchemy: 數據庫儲存。

到這裡,從簡單腳本到大型爬蟲系統你都能輕鬆開發。

Python 網頁爬蟲函式庫怎麼選?

Python 有超多爬蟲工具,該怎麼挑?這是我的選擇邏輯:

| 函式庫/工具 | 易用性 | 速度與規模 | 最適用情境 |

|---|---|---|---|

| Requests + BeautifulSoup | 非常簡單 | 中等(單頁處理) | 新手、靜態頁面、快速任務 |

| Scrapy | 學習曲線較高 | 非常快(異步、併發) | 大規模爬取、全站抓取 |

| Selenium/Playwright | 中等 | 較慢(需啟動瀏覽器) | JS 動態頁、需登入頁面 |

| aiohttp + asyncio | 中等(異步) | 非常快(多網址同時處理) | 高頻靜態頁面爬取 |

| Thunderbit(無程式碼) | 最簡單(AI 驅動) | 快(雲端/本地) | 不會寫程式、動態網站、快速取得結果 |

我的經驗法則:

- 少量靜態頁面:Requests + BeautifulSoup 最方便。

- 幾百到幾千頁、需要自動跟連結:選 Scrapy。

- 需要模擬瀏覽器(像無限滾動、登入):用 Selenium 或 Playwright。

- 「我現在就要數據,不想寫程式」:直接用 。

Python 網頁爬蟲實戰:從零開始

來寫個簡單爬蟲,抓 Hacker News 的文章標題。這是我最常用的「爬蟲 Hello World」。

1. 抓網頁內容

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. 解析 HTML

1soup = BeautifulSoup(html_content, "html.parser")3. 擷取資料

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. 處理分頁

Hacker News 頁面底部有「More」連結,這樣可以自動翻頁:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (同上擷取文章)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # 禮貌等待!

11 else:

12 page_url = None5. 錯誤處理與爬蟲禮儀

- 隨時檢查

response.status_code。 - 用

time.sleep()降低請求頻率。 - 設定自訂 User-Agent:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)這個基礎爬蟲可以套用到大多數靜態網站。遇到更複雜的需求,就該用 Scrapy 進階升級。

Scrapy 讓你的爬蟲更強大

當需求超越簡單腳本時,Scrapy 絕對是進階首選。快速上手方式如下:

1. 建立 Scrapy 專案

1scrapy startproject myspider2. 撰寫爬蟲

在 myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. 執行爬蟲

1scrapy crawl quotes -o quotes.jsonScrapy 會自動處理分頁、併發、跟連結,還能把資料輸出成 JSON(也能選 CSV、XML 等格式),程式碼量超少。

我愛用 Scrapy 的原因:

- 內建併發、速率限制、爬蟲禮儀

- 自動遵守 robots.txt

- 資料匯出、清理、儲存都很彈性

- 從小型到大型專案都能輕鬆擴展

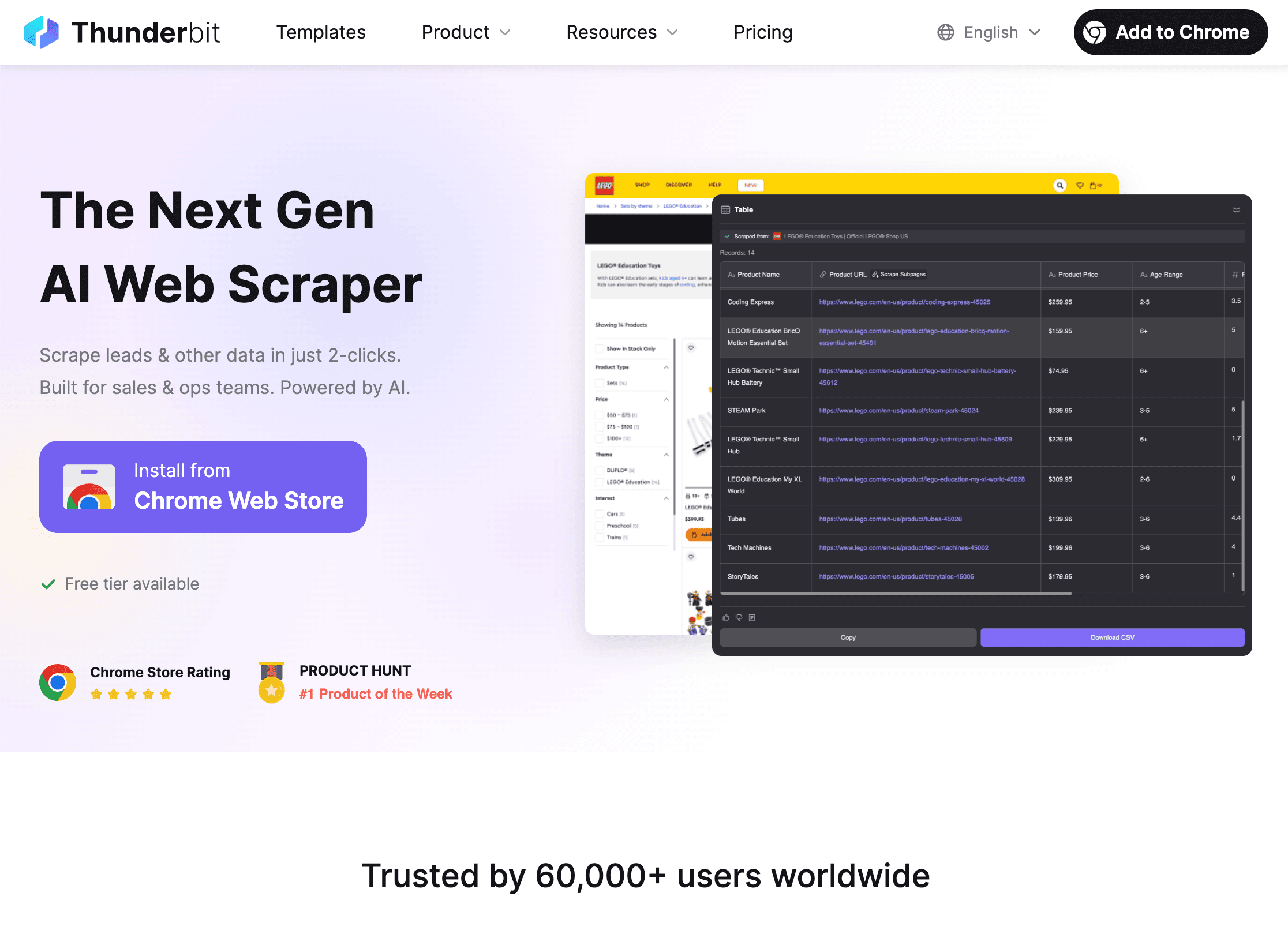

Thunderbit 讓 Python 網頁爬蟲如虎添翼

再來聊聊爬蟲界的「大魔王」:動態網站。雖然我很愛 Python,但遇到滿滿 JavaScript、反爬蟲機制或頁面常常變動,真的會讓人崩潰。這時候, 就是救星。

Thunderbit 有什麼厲害的地方?

- AI 智能欄位建議: 開啟 ,點「AI Suggest Fields」,AI 會自動推薦可擷取的資料欄位,完全不用自己查 HTML 或寫選擇器。

- 子頁面抓取: Thunderbit 能自動點連結,抓詳細頁(像商品、個人頁),資料自動合併到主表格。

- 完美處理動態內容: Thunderbit 在真實瀏覽器裡運作,能抓 JavaScript 動態頁、無限滾動,甚至用 AI 自動填表。

- 無程式碼、自然語言操作: 只要用中文或英文描述需求(像「擷取本頁所有職缺標題與地點」),Thunderbit 就能自動完成。

- 即時資料匯出: 支援 CSV、Excel、Google Sheets、Airtable、Notion 等多種格式,免費又沒限制。

- 排程爬蟲: 可以設定定時任務(像「每天早上 9 點」),自動取得最新資料。

Thunderbit 怎麼跟 Python 配合?

我最常用的流程:

- 用 Thunderbit 處理難搞或動態網站,尤其是要快速拿資料或不想維護脆弱程式時。

- 把資料匯出 成 CSV 或 Excel。

- 用 Python(pandas) 做資料清理、分析或自動化後續流程。

這樣就能結合兩邊的優勢:Thunderbit 負責資料擷取,Python 負責資料處理。

什麼時候該用 Thunderbit,什麼時候用 Python?

- Thunderbit: 適合不會寫程式、動態網站、臨時需求,或讓業務部門自己抓資料。

- Python: 適合高度自訂邏輯、大規模或定時爬取,或要跟其他系統整合。

- 兩者合用: Thunderbit 擷取,Python 處理和自動化。我都叫這組合「花生醬配果醬」——單用也行,合用更強。

想了解混合流程,推薦參考 。

合法合規,尊重網站規則

網頁爬蟲很強大,但「能力越大,責任越大」(有時還會收到系統管理員的警告信)。怎麼合法合規、避免踩雷?

1. 尊重 robots.txt

大多數網站會有 robots.txt,規定哪些區域能被爬。Python 也能自動檢查:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("robots.txt 禁止爬取")Scrapy 預設會遵守 robots.txt(ROBOTSTXT_OBEY=True)。

2. 保持禮貌

- 加入延遲(

time.sleep()或 Scrapy 的DOWNLOAD_DELAY),不要讓伺服器太累。 - 設定明確的 User-Agent 並附上聯絡方式。

- 避免抓個資或受保護內容。

- 如果網站封鎖或要求停止,請配合。

3. 處理速率限制與驗證碼

- 遇到 429(Too Many Requests)錯誤,請降低頻率或用代理。

- 不要硬破解驗證碼,遇到就先暫停。

更多合規與道德細節,請參考 。

Python 整理與儲存數據怎麼做?

數據抓下來後,通常還要清理、轉換、儲存,才能進行分析。我平常的做法如下:

1. 用 pandas 清理與轉換

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. 匯出成 CSV 或 Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. 用 SQLAlchemy 存入資料庫

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)這樣就能輕鬆串接完整數據流程,從爬蟲到儀表板。

自動化數據流程

定期任務可以完全自動化:

- Cron 任務: 定時執行 Python 腳本。

- Apache Airflow: 複雜流程可用 Airflow 編排爬取、清理、報表等步驟。

- Thunderbit 排程: 讓 Thunderbit 定時抓取,再觸發 Python 處理新數據。

更多細節可參考 。

Python 網頁爬蟲常見問題與優化

再強的爬蟲也會遇到問題,這是我的排查清單:

- 被封鎖(403/429): 換 User-Agent、降低頻率、用代理,並檢查 robots.txt。

- 資料抓不到: 檢查選擇器,或是 HTML 結構已經變了。

- 動態內容: JS 動態頁可以用 Selenium 或 Thunderbit。

- 效能問題: 用 aiohttp(異步)或 Scrapy 併發加速,資料分批寫入避免記憶體爆掉。

- 除錯: 多印 log、用瀏覽器開發者工具,隨時檢查輸出結果。

更多排錯技巧,請參考 。

結語與重點整理

打造高效 Python 網頁爬蟲,真的很值得投入,能幫你省下大把時間、提升數據價值。重點整理如下:

- Python 是網頁爬蟲首選,語法簡單、函式庫齊全、社群超活躍。

- 環境建置:用 virtualenv 隔離,安裝 Requests、BeautifulSoup、Scrapy、Selenium、pandas、SQLAlchemy。

- 工具選擇:小型任務用簡單腳本,大型或全站用 Scrapy,動態頁用 Selenium,無程式碼/AI 就選 Thunderbit。

- 寫出合規、禮貌的爬蟲,遵守 robots.txt 和網站規範。

- 用 pandas、SQLAlchemy 處理與儲存數據,並自動化流程。

- 結合 Python 與 Thunderbit,AI 負責資料擷取,Python 負責分析與自動化。

想讓你的爬蟲能力再升級,,體驗輕鬆抓取各種網站的威力。更多教學、技巧與實戰案例,歡迎逛逛 。

祝你爬蟲順利,數據滿載(也別被 CAPTCHA 卡住)!

常見問答

1. 為什麼 Python 是開發網頁爬蟲的最佳語言?

Python 語法簡單、函式庫(像 Requests、BeautifulSoup、Scrapy)超多,社群又活躍,讓你能輕鬆開發、擴展和維護爬蟲。新手友善,專業專案也沒問題。

2. 什麼情況下該用 Thunderbit,而不是自己寫 Python 爬蟲?

Thunderbit 適合不會寫程式、動態或 JS 網站,或需要快速拿資料又不想維護程式時。要高度自訂、大規模或深度整合,Python 還是首選。很多團隊會兩者一起用:Thunderbit 擷取,Python 分析。

3. 如何確保我的爬蟲合法且合乎道德?

一定要檢查並遵守網站 robots.txt,保持禮貌(延遲、User-Agent),避免抓個資或受保護內容。如果網站要求停止,請配合。更多細節見 。

4. 抓下來的數據怎麼儲存與處理最方便?

用 pandas 清理、轉換數據,匯出 CSV/Excel 分享,或用 SQLAlchemy 存進資料庫(像 SQLite、PostgreSQL)方便長期或定期管理。

5. 如何自動化我的爬蟲流程?

用 cron 或 Apache Airflow 定時執行 Python 腳本。Thunderbit 也支援排程爬蟲,可以跟 Python 結合打造全自動數據流程。

想看更多實戰技巧?參考 ,也可以訂閱 看教學影片。