2026 年的網頁爬蟲圈,真的就像清晨七點鐘的傳統市場——大家都想搶第一手新鮮貨,誰手上有最強的工具,誰就能在一片混亂中輕鬆搶先一步。現在企業越來越仰賴爬蟲抓來的資料來開發新客戶、掌握市場脈動,選對 Python 網頁爬蟲函式庫,已經不只是技術選擇,更是攸關競爭力的關鍵。說真的,現在市面上的選擇多到爆(還有一堆「終極指南」),挑個工具都快像在準備考研究所。

我自己在 SaaS 和自動化領域混了好幾年,深知選對 Python 網頁爬蟲工具,真的能讓原本要搞一個禮拜的工作,變成一個早上就搞定。不管你是要打造大型數據管線的工程師,還是只想把乾淨資料丟進試算表的商務夥伴,這份清單幫你精選 2026 年最值得信賴的 12 款 Python 網頁爬蟲函式庫——還有一款顛覆傳統、連完全不會寫程式的人都能用的 AI 解決方案。

為什麼選對 Python 網頁爬蟲函式庫這麼重要?

網頁爬蟲不是單純「抓資料」——而是要抓到對的資料、速度要夠快,還要讓你用起來不會卡關。2026 年,美國有超過 都靠自動化網頁爬蟲推動銷售、市場調查和營運,每天被爬的網頁數量更是 。選錯工具,可能直接錯失商機、腳本掛掉,還得花一堆時間 debug。

選 Python 網頁爬蟲工具時,你要考慮:

- 效能: 能不能處理大規模任務不卡?

- 易用性: 是要寫一堆 code,還是能快速產出結果?

- 瀏覽器與 JavaScript 支援: 能不能搞定現代動態網站?

- 可擴展性: 需求變大時撐得住嗎?

- 整合性: 能不能跟你的數據流程或商業系統無縫串接?

常見的商業應用像是:名單開發、價格監控、競品追蹤,還有自動化那些「拜託不要再來一次」的資料輸入。選對函式庫,讓你的銷售團隊永遠走在前面,不會被困在無止盡的 Excel 地獄。

我們怎麼挑出這 12 款 Python 網頁爬蟲函式庫

這份清單的評選標準有:

- 效能與可擴展性: 能不能搞定大型任務和複雜網站?

- 易用性: 新手友善嗎?還是要很會 Python 才能上手?

- 瀏覽器與 JavaScript 處理力: 能不能搞定動態內容和現代網頁?

- 安全性與維護度: 有沒有在持續更新、用起來安不安全?

- 社群與支援: 文件、教學、社群資源夠不夠?

- 整合潛力: 能不能跟其他工具(像 Thunderbit 這種 AI 解決方案)搭配,發揮更大效益?

同時也會考慮實際商業需求——畢竟,程式再強,最終還是要看能不能產出有價值的數據。

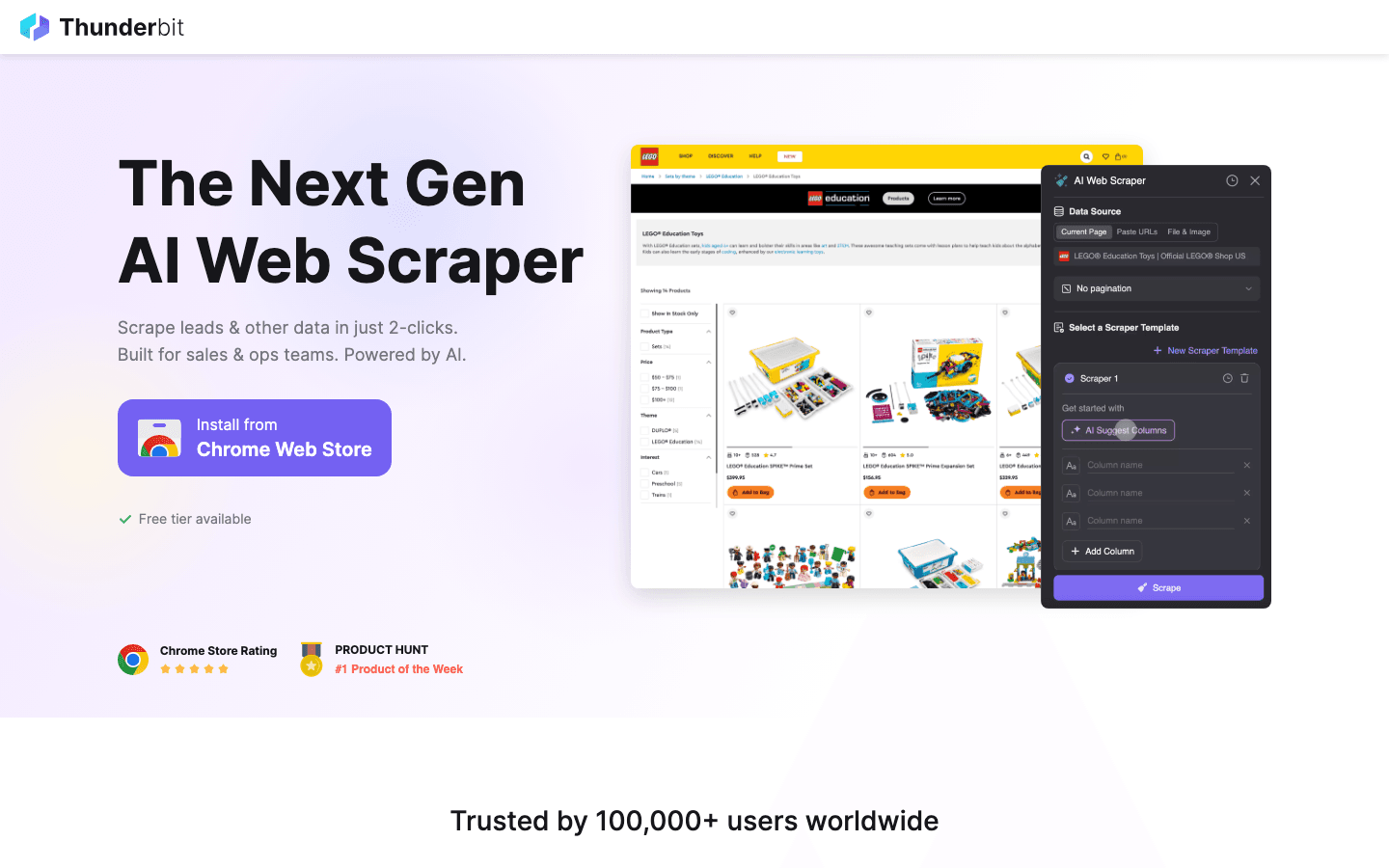

1. Thunderbit

不是傳統的 Python 函式庫,而是一款 ,徹底顛覆 2026 年商務用戶和開發者的網頁爬蟲體驗。它入選的理由很簡單:

不是傳統的 Python 函式庫,而是一款 ,徹底顛覆 2026 年商務用戶和開發者的網頁爬蟲體驗。它入選的理由很簡單:

主要特色:

- AI 智能欄位建議: 只要描述需求,Thunderbit AI 會自動判斷欄位和資料型態。

- 子頁面自動爬取: 能自動拜訪並擷取子頁(像商品詳情、LinkedIn 個人頁)。

- 即時範本: 一鍵爬取熱門網站(Amazon、Zillow、Shopify 等)。

- 免費資料匯出: 支援匯出到 Excel、Google Sheets、Airtable、Notion、CSV、JSON,完全不用加錢。

- 零程式碼流程: 不會寫程式也能輕鬆上手,也能跟 Python 工具整合,打造進階自動化。

最佳應用場景: 銷售名單開發、電商價格監控、不動產資訊、營運管理,還有任何需要快速結構化資料的情境。

優點:

- 完全免寫程式,點選+描述就能搞定

- AI 會自動適應網站版型變動

- 輕鬆處理雜亂、長尾型網頁資料

- 可跟 Python 函式庫(像 Scrapy、Beautiful Soup)混搭,打造混合式流程

缺點:

- 不是純 Python 函式庫(但能跟 Python 流程無縫整合)

- 更適合商務用戶,或當作程式化爬蟲的輔助工具

專家建議: Thunderbit 很適合快速原型設計或處理一次性、複雜的爬蟲任務。大規模自動化時,可以先用 Thunderbit 把資料結構化匯出,再交給 Python 腳本進一步處理。

2. Beautiful Soup

是解析和操作 HTML/XML 的經典 Python 函式庫。只要你有處理過亂七八糟的網頁,就知道為什麼新手和老手都愛用它。

是解析和操作 HTML/XML 的經典 Python 函式庫。只要你有處理過亂七八糟的網頁,就知道為什麼新手和老手都愛用它。

主要特色:

- 直覺語法,方便搜尋、瀏覽和修改 HTML/XML

- 能優雅處理格式錯誤或破損的標記

- 跟 無縫整合,輕鬆抓網頁

最佳應用場景: 快速爬取、資料清理、中小型網頁解析。

優點:

- 超級容易上手

- 特別適合清理亂 HTML

- 彈性高、容錯力強

缺點:

- 處理大型文件時速度不如

- 不支援 JavaScript

專家建議: 如果追求速度,可以搭配 lxml 當解析器。遇到動態網站,建議跟 Selenium 或 Pyppeteer 一起用。

3. Selenium

是自動化瀏覽器的重量級選手,能控制 Chrome、Firefox、Edge 等主流瀏覽器,特別適合處理動態、JavaScript 很重的網站。

是自動化瀏覽器的重量級選手,能控制 Chrome、Firefox、Edge 等主流瀏覽器,特別適合處理動態、JavaScript 很重的網站。

主要特色:

- 可自動操作真實瀏覽器(Chrome、Firefox 等)

- 支援無頭模式,加快執行速度

- 能模擬表單、按鈕等用戶互動

最佳應用場景: 需要登入、點擊或大量 JavaScript 渲染的網站。

優點:

- 幾乎能搞定所有動態網站

- 支援多種瀏覽器和平台

- 測試和爬蟲一體化

缺點:

- 執行速度比較慢

- 資源消耗高

- 網站版型變動時腳本容易壞

專家建議: 當其他工具搞不定時,Selenium 是最後防線。如果追求速度和規模,建議考慮 Scrapy 或 Pyppeteer。

4. Requests

是 Python 最基礎的 HTTP 函式庫,很多爬蟲流程都靠它打底,讓你輕鬆發送 GET/POST 請求和處理回應。

是 Python 最基礎的 HTTP 函式庫,很多爬蟲流程都靠它打底,讓你輕鬆發送 GET/POST 請求和處理回應。

主要特色:

- 乾淨、Python 風格的 API

- 支援 cookies、session 和認證

- 跟 Beautiful Soup、LXML 等解析器完美搭配

最佳應用場景: 抓靜態網頁、API,或自訂爬蟲的基礎元件。

優點:

- 超級容易上手

- 穩定可靠、維護良好

- 適合快速腳本和原型設計

缺點:

- 沒有內建 HTML 解析功能

- 無法處理 JavaScript 渲染內容

專家建議: 跟 Beautiful Soup 或 LXML 搭配,打造經典輕量級爬蟲組合。

5. LXML

是 Python 處理 HTML/XML 的效能怪獸。要處理大型文件或複雜 XPath 查詢,LXML 絕對是你的好夥伴。

是 Python 處理 HTML/XML 的效能怪獸。要處理大型文件或複雜 XPath 查詢,LXML 絕對是你的好夥伴。

主要特色:

- 以 C 為基礎,解析速度超快

- 完整支援 XPath 和 CSS 選擇器

- 同時支援 HTML 和 XML

最佳應用場景: 大型文件解析、複雜結構、對速度有要求的專案。

優點:

- 處理大規模任務時遠勝 Beautiful Soup

- 強大的選擇器支援

- 錯誤處理能力佳

缺點:

- 對格式錯誤的 HTML 容忍度較低

- 學習曲線略高

專家建議: 把 LXML 當作 Beautiful Soup 的解析器,兼顧易用性和效能。

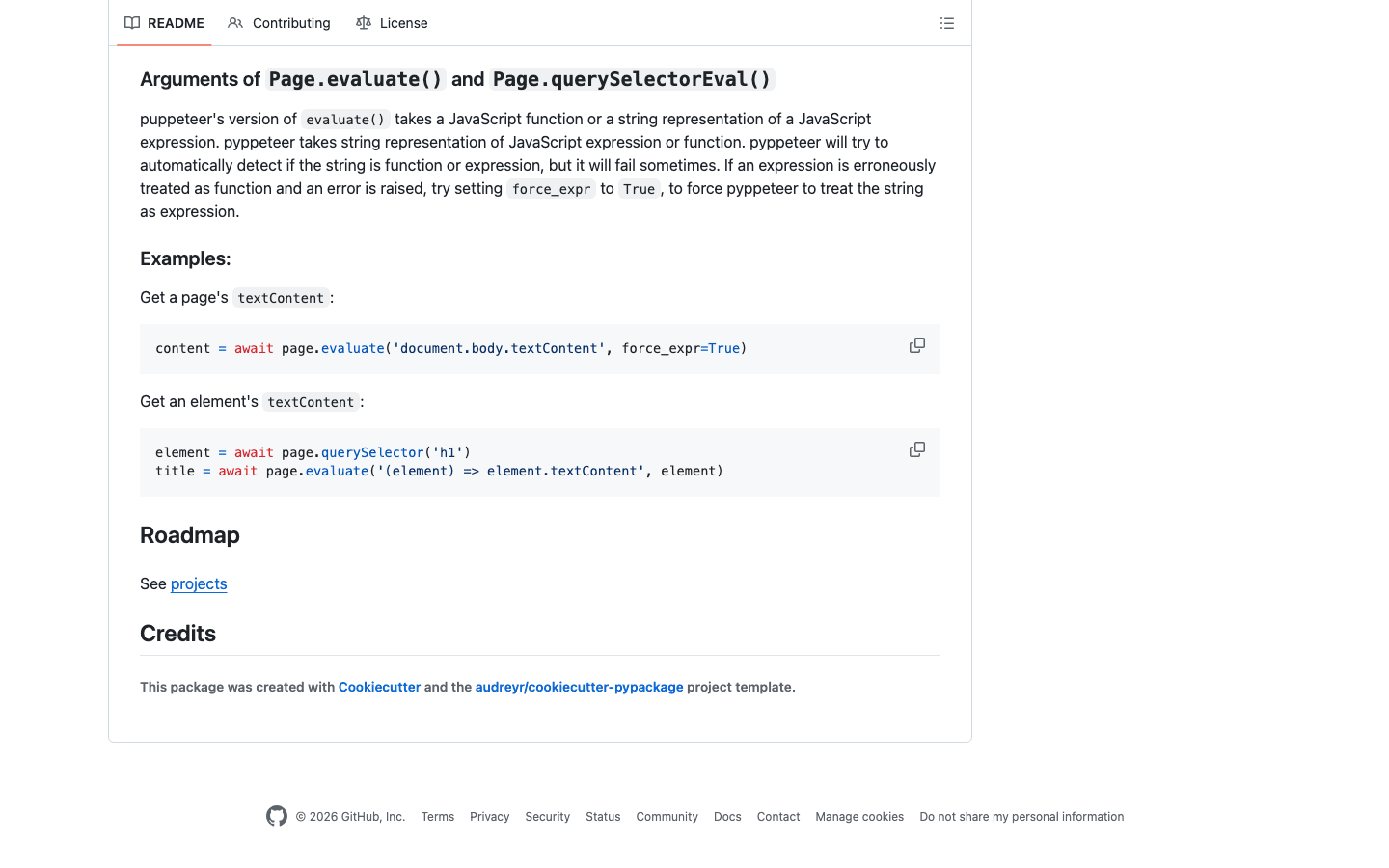

6. Pyppeteer

是 Puppeteer 的 Python 版本,讓你能控制無頭 Chrome,專門為現代 JavaScript 網站而生。

是 Puppeteer 的 Python 版本,讓你能控制無頭 Chrome,專門為現代 JavaScript 網站而生。

主要特色:

- 完整控制無頭 Chrome(或 Chromium)

- 超強的 JavaScript 渲染和用戶模擬能力

- 支援複雜導航、截圖、PDF 產生

最佳應用場景: 現代 JS 網站、用戶流程自動化、繞過反爬蟲機制。

優點:

- 頂級 JavaScript 支援

- 能模擬真人操作,搞定複雜網站

- 適合單頁應用(SPA)

缺點:

- 比 Requests 或 Scrapy 更重、更慢

- 維護狀態要注意,建議確認最新版本

- 設定比較繁瑣

專家建議: 如果 Selenium 搞不定,Pyppeteer 常常能解決難題。商業流程可以先用 Thunderbit AI 定義欄位,再交給 Pyppeteer 處理導航。

7. Splash

是專為大規模 JavaScript 渲染設計的輕量級瀏覽器引擎,常跟 Scrapy 搭配,處理動態網站。

是專為大規模 JavaScript 渲染設計的輕量級瀏覽器引擎,常跟 Scrapy 搭配,處理動態網站。

主要特色:

- 無頭瀏覽器,提供 HTTP API

- 能渲染 JavaScript 並回傳 HTML、截圖或 HAR 檔

- 透過中介軟體和 Scrapy 整合

最佳應用場景: 批次處理 JS 網頁、可擴展的爬蟲流程、伺服器端渲染。

優點:

- 大規模渲染效率高

- API 介面,易於整合

- 資源消耗低於全功能瀏覽器自動化

缺點:

- 互動性不如 Selenium 或 Pyppeteer

- 設定和腳本有學習門檻

專家建議: 大規模動態網站爬取,Scrapy + Splash 是超強組合。

8. MechanicalSoup

是輕量級 Python 函式庫,專為自動化表單和簡單網頁導航設計,基於 Requests 和 Beautiful Soup。

是輕量級 Python 函式庫,專為自動化表單和簡單網頁導航設計,基於 Requests 和 Beautiful Soup。

主要特色:

- 自動化表單填寫和網頁導航

- 維持 session 狀態和 cookies

- API 簡單,適合新手

最佳應用場景: 登入網站、填寫表單、靜態或輕度動態頁面爬取。

優點:

- 設定簡單,適合快速自動化

- 內建 cookies 和 session 處理

- 適合簡單登入或搜尋表單

缺點:

- 不支援 JavaScript

- 不適合大規模或高度動態爬蟲

專家建議: 用來搞定登入流程,後續再交給 Requests + Beautiful Soup 處理。

9. Twisted

是 Python 的事件驅動網路引擎,雖然不是專門爬蟲工具,卻是打造高吞吐量自訂爬蟲系統的基石。

是 Python 的事件驅動網路引擎,雖然不是專門爬蟲工具,卻是打造高吞吐量自訂爬蟲系統的基石。

主要特色:

- 支援 HTTP、TCP 等非同步網路通訊

- 可同時處理數千連線

- 適合自訂、分散式爬蟲架構

最佳應用場景: 建立高流量自訂爬蟲、跟其他非同步框架整合。

優點:

- 可擴展性超高

- 支援多種協議

- 適合進階用戶

缺點:

- 學習曲線很陡

- 一般爬蟲任務可能太複雜

專家建議: 如果要大規模(百萬頁等級)爬取,Twisted 值得深入研究。

10. Scrapy

是 Python 網頁爬蟲框架中的瑞士刀,專為大規模、商業級專案設計,非同步架構讓你輕鬆爬成千上萬頁面。

是 Python 網頁爬蟲框架中的瑞士刀,專為大規模、商業級專案設計,非同步架構讓你輕鬆爬成千上萬頁面。

主要特色:

- 非同步、事件驅動引擎,效率超高

- 內建資料管道、中介軟體、資料匯出(JSON、CSV、XML)

- 一站式處理爬取、解析、資料清理

- 可擴充插件(代理、用戶代理等)

最佳應用場景: 企業級爬蟲、結構化資料擷取、需要速度和穩定性的專案。

優點:

- 大型任務效率驚人

- 高度可自訂和擴充

- 社群活躍、文件齊全

缺點:

- 新手學習曲線較高

- 原生不支援動態 JS 網站(可搭配 Splash)

專家建議: Scrapy 可以跟 搭配處理 JavaScript,或跟 結合 AI 欄位偵測和資料結構化。

11. PyQuery

把 jQuery 風格選擇器帶進 Python,喜歡 jQuery 語法的開發者會超快上手。

把 jQuery 風格選擇器帶進 Python,喜歡 jQuery 語法的開發者會超快上手。

主要特色:

- jQuery 式 API,方便選取和操作 HTML

- 基於 lxml,速度快

- 支援 CSS 選擇器和 DOM 操作

最佳應用場景: 熟悉 jQuery 的開發者、快速原型設計、需要彈性選擇器的專案。

優點:

- 速度快、效率高

- jQuery 用戶直覺好上手

- 適合解析和修改 HTML

缺點:

- 社群規模小於 Beautiful Soup、LXML

- 對格式錯誤 HTML 支援有限

專家建議: 偏好 CSS 選擇器而不是 XPath 時,PyQuery 是 lxml 的好搭檔。

12. Parsel

是強大的 HTML/XML 資料擷取函式庫,支援 XPath 和 CSS 選擇器,也是 Scrapy 解析引擎的核心。

是強大的 HTML/XML 資料擷取函式庫,支援 XPath 和 CSS 選擇器,也是 Scrapy 解析引擎的核心。

主要特色:

- 進階 XPath 和 CSS 選擇器支援

- 乾淨 API,方便資料擷取和清理

- 可獨立使用或整合於 Scrapy

最佳應用場景: 複雜資料擷取、需要強大選擇器邏輯的專案、跟 Scrapy 整合。

優點:

- 彈性高、功能強大

- 能處理複雜頁面結構

- 文件完善、持續維護

缺點:

- 需具備選擇器基礎

- 不是完整爬蟲框架,適合當解析元件

專家建議: 用來寫自訂 Scrapy spider 或獨立解析腳本的重度資料擷取。

Python 網頁爬蟲工具一覽比較表

| Library | Main Features | Performance | Ease of Use | JavaScript Support | Best For | Integration Options |

|---|---|---|---|---|---|---|

| Thunderbit | AI-powered, no-code, subpages | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Yes (browser-based) | Business users, hybrid workflows | Excel, Sheets, Notion, Python |

| Beautiful Soup | HTML/XML parsing, forgiving | ⭐⭐ | ⭐⭐⭐⭐⭐ | No | Data cleaning, small jobs | Requests, LXML, Thunderbit |

| Selenium | Browser automation, dynamic content | ⭐⭐ | ⭐⭐ | Yes | Dynamic sites, user interaction | Beautiful Soup, PyQuery |

| Requests | HTTP requests, sessions | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | No | Fetching static pages, APIs | Beautiful Soup, LXML |

| LXML | Fast parsing, XPath, CSS selectors | ⭐⭐⭐⭐ | ⭐⭐⭐ | No | Large docs, complex parsing | Beautiful Soup, PyQuery |

| Pyppeteer | Headless Chrome, JS rendering | ⭐⭐ | ⭐⭐ | Yes | Modern JS sites, SPAs | Thunderbit, Pandas |

| Splash | JS rendering, API-based | ⭐⭐⭐ | ⭐⭐ | Yes | Batch JS scraping, pipelines | Scrapy, Thunderbit |

| MechanicalSoup | Form handling, navigation | ⭐⭐ | ⭐⭐⭐⭐ | No | Simple forms, logins | Requests, Beautiful Soup |

| Twisted | Async networking, custom pipelines | ⭐⭐⭐⭐⭐ | ⭐ | No | High-volume, custom scrapers | Scrapy, custom frameworks |

| Scrapy | High-performance, async, pipelines | ⭐⭐⭐⭐⭐ | ⭐⭐ | Limited (via Splash) | Enterprise-scale, structured data | Splash, Parsel, Thunderbit |

| PyQuery | jQuery-style selectors, fast | ⭐⭐⭐ | ⭐⭐⭐⭐ | No | jQuery fans, fast prototyping | LXML, Requests |

| Parsel | XPath/CSS selectors, flexible parsing | ⭐⭐⭐⭐ | ⭐⭐⭐ | No | Complex extraction, Scrapy users | Scrapy, Standalone |

怎麼選最適合你的 Python 網頁爬蟲函式庫

快速決策流程:

-

只要處理靜態頁或 API?

用 Requests + Beautiful Soup 或 LXML。 -

需要高速、大量爬取?

Scrapy 是首選。要非同步網路,考慮 Twisted。 -

要爬動態、JavaScript 網站?

試試 Selenium、Pyppeteer 或 Scrapy + Splash。 -

偏好 jQuery 選擇器語法?

PyQuery 很適合。 -

要自動化表單或登入?

MechanicalSoup 簡單又有效。 -

不會寫程式,或想省下設定時間?

Thunderbit 讓你用自然語言描述需求,直接匯出結構化資料。 -

想混搭?

先用 Thunderbit 快速原型和結構化資料,再交給 Python 腳本進一步處理。

選擇工具檢查清單:

- 網站屬性(靜態還是動態?)

- 需要爬多少資料?

- 要不要互動(表單、登入)?

- 你對 Python 和選擇器的熟悉度?

- 要不要匯出到 Excel、Sheets、Notion 等商業工具?

- 長期維護重不重要?

結語:2026 年 Python 網頁爬蟲的無限可能

Python 網頁爬蟲的威力和易用性已經來到新高度。不管你是用 Scrapy 擴大規模、用 Beautiful Soup 清理資料、用 Selenium 或 Pyppeteer 處理動態內容,還是想免寫程式直接把資料丟進試算表,都能找到適合你的工具。

真正的訣竅?就是勇於混搭。每款 Python 網頁爬蟲函式庫都有自己的強項,靈活組合(或加上像 這種 AI 解決方案),能大幅省時、省力,還能挖掘更多商業洞察。

2026 年,贏家不再只是寫程式最快的人,而是懂得選對工具、自動化重複工作,把精力放在最有價值的事——讓網頁數據真正變成商業成果。

常見問題

1. 新手最推薦哪個 Python 網頁爬蟲函式庫?

Beautiful Soup 因為語法簡單、容錯力高,非常適合初學者。如果完全不會寫程式,Thunderbit 提供 AI 驅動、零程式碼的替代方案。

2. 哪些 Python 工具適合動態或 JavaScript 網站?

Selenium、Pyppeteer 和 Splash 都很適合處理動態內容,Pyppeteer 對現代 JS 應用尤其強。

3. Thunderbit 能跟 Scrapy 或 Beautiful Soup 等 Python 函式庫結合嗎?

當然可以!Thunderbit 能快速結構化並匯出資料,之後可以用你熟悉的 Python 函式庫進一步處理。

4. 哪個 Python 函式庫解析大型 HTML 文件最快?

LXML 通常是大規模解析的速度王,特別適合用 XPath 或 CSS 選擇器。

5. Scrapy 和 Selenium 怎麼選?

Scrapy 適合大規模、結構化的靜態網站爬取;如果需要互動、登入或處理大量 JavaScript,建議用 Selenium。

想體驗 Thunderbit 怎麼讓你的網頁爬蟲流程升級?,或到 看更多教學。祝你爬蟲順利!

延伸閱讀