想像一下:你正盯著一個有上千件商品的網站,老闆(或你內心的數據狂)要你把所有價格、名稱和評論通通整理進 Excel——還要馬上交差。你可以選擇花好幾個小時慢慢複製貼上,或者……直接交給 Python 幫你自動搞定這些瑣碎事。這就是網頁爬蟲的厲害之處,而且現在早就不是只有工程師或駭客才會用的技能。其實,網頁爬蟲已經成為銷售、房仲、行銷、研究等各行各業的必備工具。全球網頁爬蟲軟體市場規模已經超過 ,預計到 2032 年還會再翻一倍。背後蘊藏的數據和商機,真的不容小覷。

身為 的共同創辦人,這幾年我幫過無數企業自動化資料蒐集流程。在 AI 網頁爬蟲(像 )讓抓資料變得超簡單之前,我也是靠經典 Python 工具組——BeautifulSoup、requests,加上一點土法煉鋼,慢慢累積經驗。這篇文章會帶你認識什麼是 BeautifulSoup、怎麼安裝和使用它,以及為什麼它到現在還是很多人的首選。最後,我也會介紹 AI 工具如 Thunderbit 如何徹底顛覆網頁爬蟲的玩法,讓每個人都能輕鬆上手。不管你是 Python 新手、商務用戶,還是單純對爬蟲有興趣,都歡迎一起深入了解。

什麼是 BeautifulSoup?Python 網頁爬蟲的超強助手

先從基礎開始。(大家都叫它 BS4)是一個專門用來解析 HTML 和 XML 的 Python 函式庫。你可以把它想像成你的 HTML 偵探:只要給它一段亂七八糟的網頁原始碼,它就能幫你整理成一棵結構清楚、超好操作的樹狀結構。這樣一來,抓商品名稱、價格或評論,只要根據標籤或 class 名稱就能輕鬆搞定。

BeautifulSoup 本身不負責抓網頁(這通常交給 requests 這類函式庫),但只要你有 HTML 原始碼,它就能讓你快速搜尋、過濾並提取你要的資料。難怪在最近的調查中, 都選擇 BeautifulSoup 當作他們的網頁爬蟲工具,遠遠超過其他函式庫。

BeautifulSoup 被廣泛應用在學術研究、電商分析、名單蒐集等各種場景。我看過行銷團隊用它建立網紅名單、獵頭自動抓職缺、甚至記者用來輔助調查。它彈性高、容錯率強,只要你會一點 Python,很快就能上手。

為什麼大家都愛用 BeautifulSoup?商業價值與實戰應用

那為什麼這麼多企業和數據控都愛用 BeautifulSoup?這裡有幾個它成為主流網頁爬蟲工具的關鍵原因:

- 自動化重複工作: 不用再傻傻手動複製貼上,寫個腳本就能幾分鐘抓到成千上萬筆資料,團隊可以把時間花在更有價值的事上。

- 即時監控: 可以定時追蹤競爭對手價格、庫存或新聞標題。對手一降價,你馬上就知道。

- 自訂資料擷取: 想抓前 10 名熱銷商品、評分、評論?BeautifulSoup 讓你精準控制要抓什麼、怎麼處理。

- 能處理亂七八糟的 HTML: 就算網站原始碼很亂,BeautifulSoup 通常也能解析出你要的資料。

來看幾個常見的實戰應用:

| 應用場景 | 說明 | 實際成果 |

|---|---|---|

| 潛在客戶開發 | 從商業名錄或 LinkedIn 擷取郵件、電話 | 建立精準的銷售名單 |

| 價格監控 | 追蹤電商網站競品價格 | 即時調整自家定價策略 |

| 市場調查 | 收集商品評論、評分、詳細資訊 | 掌握市場趨勢、優化產品策略 |

| 房地產數據 | 匯整 Zillow 或 Realtor.com 等房源資訊 | 分析價格走勢、投資機會 |

| 內容彙整 | 抓取新聞、部落格、社群貼文 | 製作電子報、情緒分析 |

這些數據帶來的效益也很明顯:英國某零售商靠網頁爬蟲監控競爭對手,。ASOS 也因為根據爬取的在地價格調整行銷策略,讓國際銷售翻倍。簡單說,數據真的能驅動商業決策。

開始動手:Python 安裝 BeautifulSoup 教學

準備好要實作了嗎?以下是安裝 BeautifulSoup 的步驟:

步驟 1:安裝 BeautifulSoup(記得選對版本)

一定要安裝最新版——BeautifulSoup 4(bs4)。不要被舊的套件名稱搞混!

1pip install beautifulsoup4如果你用的是 macOS 或 Linux,可能要加上 pip3 或 sudo:

1sudo pip3 install beautifulsoup4小提醒: 如果你不小心打成 pip install beautifulsoup(少了「4」),會裝到舊版且不相容的套件。這個坑我也踩過。

步驟 2:安裝解析器(建議)

BeautifulSoup 可以用 Python 內建的 HTML 解析器,但為了速度和穩定性,建議加裝 lxml 和 html5lib:

1pip install lxml html5lib步驟 3:安裝 Requests(用來抓網頁)

BeautifulSoup 負責解析 HTML,但你還需要先把網頁抓下來。推薦用 套件:

1pip install requests步驟 4:檢查 Python 環境

請確認你用的是 Python 3。如果你在 IDE(像 PyCharm、VS Code)裡操作,記得檢查解譯器。如果遇到 import 錯誤,可能是安裝到錯的環境。在 Windows 上可以用 py -m pip install beautifulsoup4 指定版本。

步驟 5:測試安裝是否成功

快速測試一下:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)如果你看到 <title> 標籤被印出來,就代表安裝成功。

BeautifulSoup 基礎:核心概念與語法

來認識一下 BeautifulSoup 的主要物件和概念:

- BeautifulSoup 物件: 解析後的 HTML 樹狀結構根節點。用

BeautifulSoup(html, parser)建立。 - Tag: 代表一個 HTML 或 XML 標籤(像

<div>、<p>、<span>),可以存取屬性、子元素、文字等。 - NavigableString: 標籤內的純文字內容。

解析樹的概念

可以把 HTML 想像成家族樹:<html> 是祖先,<head> 和 <body> 是子節點,依此類推。BeautifulSoup 讓你用 Python 很直覺地操作這棵樹。

範例:

1html = """

2<html>

3 <head><title>My Test Page</title></head>

4 <body>

5 <p class="story">Once upon a time <b>there were three little sisters</b>...</p>

6 </body>

7</html>

8"""

9soup = BeautifulSoup(html, "html.parser")

10# 取得 title 標籤

11print(soup.title) # <title>My Test Page</title>

12print(soup.title.string) # My Test Page

13# 取得第一個 <p> 標籤及其 class 屬性

14p_tag = soup.find('p', class_='story')

15print(p_tag['class']) # ['story']

16# 取得 <p> 標籤內所有文字

17print(p_tag.get_text()) # Once upon a time there were three little sisters...導覽與搜尋

- 元素存取:

soup.head、soup.body、tag.parent、tag.children - find() / find_all(): 依標籤名稱或屬性搜尋元素。

- select(): 支援 CSS 選擇器,適合複雜查詢。

範例:

1# 找出所有連結

2for link in soup.find_all('a'):

3 print(link.get('href'))

4# CSS 選擇器範例

5for item in soup.select('div.product > span.price'):

6 print(item.get_text())實作練習:用 BeautifulSoup 打造你的第一個網頁爬蟲

來點實戰吧。假設你想從電商搜尋頁(以 Etsy 為例)抓商品名稱和價格,可以這樣做:

步驟 1:抓網頁內容

1import requests

2from bs4 import BeautifulSoup

3url = "https://www.etsy.com/search?q=clothes"

4headers = {"User-Agent": "Mozilla/5.0"} # 有些網站需要 user-agent

5resp = requests.get(url, headers=headers)

6soup = BeautifulSoup(resp.text, 'html.parser')步驟 2:解析並擷取資料

假設每個商品都在 <li class="wt-list-unstyled">,名稱在 <h3 class="v2-listing-card__title">,價格在 <span class="currency-value">。

1items = []

2for item in soup.find_all('li', class_='wt-list-unstyled'):

3 title_tag = item.find('h3', class_='v2-listing-card__title')

4 price_tag = item.find('span', class_='currency-value')

5 if title_tag and price_tag:

6 title = title_tag.get_text(strip=True)

7 price = price_tag.get_text(strip=True)

8 items.append((title, price))步驟 3:存成 CSV 或 Excel

用 Python 內建的 csv 模組:

1import csv

2with open("etsy_products.csv", "w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Product Title", "Price"])

5 writer.writerows(items)或用 :

1import pandas as pd

2df = pd.DataFrame(items, columns=["Product Title", "Price"])

3df.to_csv("etsy_products.csv", index=False)這樣你就有一份可以分析、做報表、或分享的商品清單了。

BeautifulSoup 的挑戰:維護、反爬蟲與限制

老實說,雖然我很愛 BeautifulSoup,但它也有一些現實挑戰,尤其是你要長期或大規模抓資料時。

1. 容易受網站變動影響

網站常常會改版、調整 class 名稱或元素順序。你的 BeautifulSoup 腳本只要選擇器寫錯或網站一改版就可能失效,有時還不會報錯,讓你以為一切正常。如果你同時抓很多網站,維護這些腳本真的會讓人崩潰。

2. 反爬蟲機制

現在的網站會用各種手段防止爬蟲:像是 CAPTCHA、IP 封鎖、流量限制、JavaScript 動態載入等。BeautifulSoup 本身沒辦法處理這些,你得另外加代理、無頭瀏覽器,甚至外部解碼服務。這就像和網站管理員玩打地鼠。

3. 擴展性與效能

BeautifulSoup 很適合一次性或中小型資料抓取。但如果你要抓數百萬頁、或需要多線程並行,就得自己寫額外的錯誤處理、併發、基礎設施等。雖然做得到,但工程量不小。

4. 技術門檻

說真的,如果你對 Python、HTML 不熟,BeautifulSoup 會讓人有點卻步。即使是有經驗的開發者,寫爬蟲也常常是「檢查、寫程式、執行、修正」的無限循環。

5. 法律與道德風險

爬蟲有時會踩到法律灰色地帶,特別是忽略 robots.txt 或違反網站服務條款時。寫程式的人必須自律,控制抓取頻率、遵守規則、妥善處理資料。

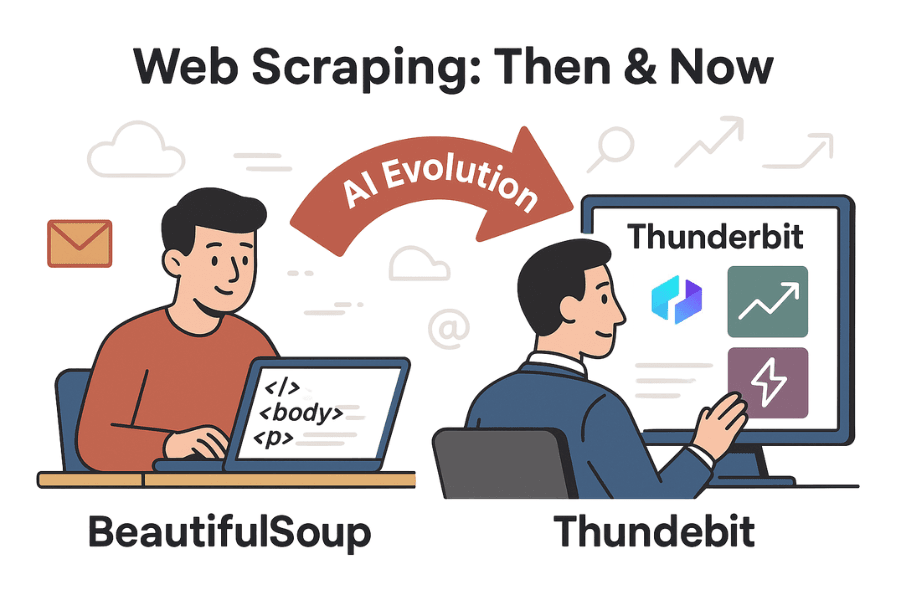

超越 BeautifulSoup:AI 工具 Thunderbit 讓網頁爬蟲變超簡單

重點來了。隨著 AI 崛起,像 這類工具,讓網頁爬蟲不再只是工程師的專利。

Thunderbit 是一款人工智慧網頁爬蟲 Chrome 擴充功能,讓你只要點兩下就能抓任何網站資料。完全不用寫 Python、設定選擇器,也不用擔心維護。只要打開網頁,點「AI 建議欄位」,Thunderbit 的 AI 就會自動判斷你可能需要的資料(像商品名稱、價格、評論、郵件、電話等)。再點「開始抓取」,資料馬上到手。

Thunderbit vs. BeautifulSoup:功能大比拼

| 功能 | BeautifulSoup(寫程式) | Thunderbit(無程式碼 AI) |

|---|---|---|

| 安裝難度 | 需會 Python、HTML、除錯 | 不用寫程式,AI 自動辨識欄位,介面超直覺 |

| 取得資料速度 | 需花數小時寫程式、測試 | 幾分鐘內搞定(2–3 下點擊) |

| 應對網站變動 | 網站改版要手動修正選擇器 | AI 能自動適應多數變動,熱門網站有現成模板 |

| 分頁/子頁面 | 需手動寫迴圈處理每一頁 | 內建分頁、子頁面抓取,開關一按就好 |

| 反爬蟲處理 | 需自己加代理、解 CAPTCHA、模擬瀏覽器 | 多數反爬蟲問題內建處理,瀏覽器環境降低被封鎖風險 |

| 資料處理 | 完全自訂,但要自己寫程式 | 內建 AI 支援摘要、分類、翻譯、清理資料 |

| 匯出選項 | 需寫程式輸出 CSV、Excel、資料庫等 | 一鍵匯出到 CSV、Excel、Google Sheets、Airtable、Notion |

| 擴展性 | 無限大,但要自己處理錯誤、重試、擴充 | 高,雲端/擴充功能自動處理併發、排程、大型任務(依方案/點數限制) |

| 成本 | 免費(開源),但要花時間維護 | 免費小量,進階需付費,但省下大量時間與維護成本 |

| 彈性 | 最高,程式碼可做任何事 | 覆蓋大多數常見需求,特殊情境還是能寫程式 |

想更深入了解,歡迎參考 和 。

實戰對比:Thunderbit 與 BeautifulSoup 抓資料流程

我們來比一比,從電商網站抓商品資料的流程:

用 BeautifulSoup

- 用瀏覽器開發者工具檢查網站 HTML 結構。

- 寫 Python 程式碼抓網頁(requests)、解析(BeautifulSoup)、擷取欄位。

- 不斷調整選擇器(class 名稱、標籤路徑)直到抓到正確資料。

- 處理分頁要另外寫迴圈跟「下一頁」。

- 匯出資料到 CSV 或 Excel 也要再寫程式。

- 網站改版時,重來一次。

所需時間: 新網站約 1–2 小時(遇到反爬蟲會更久)。

用 Thunderbit

- 在 Chrome 開啟目標網站。

- 點 Thunderbit 擴充功能。

- 點「AI 建議欄位」——AI 自動推薦欄位(如商品名稱、價格等)。

- 有需要可調整欄位,然後點「開始抓取」。

- 若要分頁或子頁面抓取,只要開啟對應開關。

- 預覽資料表格,然後匯出成你要的格式。

所需時間: 2–5 分鐘。完全不用寫程式、除錯、維護。

額外加分: Thunderbit 還能自動抓郵件、電話、圖片,甚至自動填表單。就像請了一個永遠不喊累的超快助理。

結語與重點整理

網頁爬蟲早就從小眾技術變成主流商業工具,推動名單開發、市場調查等各種應用。 依然是入門 Python 網頁爬蟲的絕佳選擇,彈性高、可自訂,適合想深入學習的人。但隨著網站越來越複雜、商務用戶追求更快更簡單的解決方案,AI 工具如 正在改變這個領域。

如果你喜歡寫程式、想打造完全客製化的爬蟲,BeautifulSoup 依然是首選。但如果你想省去寫程式、維護的麻煩,快速拿到結果,Thunderbit 絕對是未來趨勢。與其花好幾個小時寫程式,不如用 AI 幾分鐘解決問題。

想親自體驗嗎? 立刻下載 ,或到 看更多教學。如果你還想精進 Python,繼續用 BeautifulSoup 練功吧——只是記得偶爾讓手腕休息一下。

祝你爬蟲愉快!

延伸閱讀:

有任何問題、經驗或想分享爬蟲趣事,歡迎留言或聯絡我們。我踩過的坑,真的比大多數人寫過的爬蟲還多!