Скажу по-честному: я и подумать не мог, что «веб-скрейпинг» однажды станет темой разговоров у кулера — причём не у разработчиков, а в сейлз-отделах и операционных командах. Но вот мы в 2025-м, и внезапно все — от риелторов до e-commerce менеджеров — обсуждают стратегии извлечения данных так, будто делятся рецептом самгёпсаля на выходные. Я много лет делаю и использую SaaS-инструменты для автоматизации, и этот сдвиг невозможно не заметить: веб-данные больше не «только для айтишников». Сегодня это буквально 혈액 (кровь) современного бизнеса: они питают всё — от лидогенерации до мониторинга цен. И если ты до сих пор не используешь Web Scraper или, ещё лучше, AI Web Scraper, то, скорее всего, всё ещё живёшь в эпохе бесконечного копипаста.

Но из-за взрыва количества решений выбор подходящего Web Scraper иногда ощущается как поход в корейский супермаркет за хлопьями: полки бесконечные, глаза разбегаются, а если возьмёшь не то — будешь жалеть ещё долго. Поэтому давай разложим по полочкам лучшие инструменты для веб-скрейпинга в 2025 году: от no-code AI-решений до «тяжёлой артиллерии» для разработчиков. Неважно, ты в продажах, в e-commerce, в ops или просто хочешь автоматизировать рутину — здесь найдётся вариант под твой стиль работы.

Зачем бизнесу нужен Web Scraper в 2025 году

Начнём с базового — «зачем вообще». Почему все вдруг так подсели на веб-скрейпинг и извлечение данных? Цифры говорят сами за себя: . Это не разовый хайп — это большая волна. Причём растут не только техкомпании. Команды продаж, маркетинга и операций активно подключаются благодаря новому поколению low-code и no-code скрейперов: они сделали извлечение данных доступным даже тем, кто не пишет код ().

Бизнес-сценарии использования

- Лидогенерация: сейлз-команды собирают данные из публичных каталогов, соцсетей и сайтов компаний, чтобы собирать максимально точные списки потенциальных клиентов — без покупки устаревших баз и «холодных» звонков наугад.

- Маркетинговые исследования и мониторинг цен: e-commerce и ритейл используют скрейперы, чтобы отслеживать цены конкурентов, наличие на складе и сравнивать ассортимент. Например, John Lewis связывает веб-скрейпинг с благодаря более умному ценообразованию.

- Автоматизация процессов: операционные команды автоматизируют повторяющийся сбор данных и возвращают себе часы, которые раньше улетали в бесконечный ручной копипаст.

- Аналитика в недвижимости: агенты и инвесторы агрегируют объявления, вытаскивают контакты владельцев и отслеживают тренды рынка — за один проход.

И вот ключевой момент: , а данные по вакансиям для рыночной аналитики выросли на 50%. В мире, где скорость и точность решают всё, Web Scraper стал тем самым «секретным оружием» команд, которые хотят обгонять конкурентов.

Переход к AI Web Scraper

Скрейперы «старой школы» были мощными, но часто требовали почти докторской степени по «настройке селекторов» — и, честно, немало 인내심 (терпения). Сегодня AI Web Scraper, такие как , меняют правила игры: структурированные данные можно получать буквально в пару кликов. Итог? Команды становятся самостоятельнее, узкие места исчезают, а данные превращаются в реальное конкурентное преимущество.

Как выбрать подходящий Web Scraper или AI Web Scraper

Как подобрать инструмент под свою команду? Вот чек-лист, которым я сам пользуюсь, когда оцениваю инструменты для веб-скрейпинга (и поверь: я видел всё — от «настолько просто, что справится 할머니» до «настолько сложно, что нужен второй монитор только под документацию»).

Ключевые критерии

- Простота использования: сможет ли нетехнический пользователь стартовать без недели обучения?

- Точность извлечения данных: стабильно ли инструмент вытягивает нужные поля, даже если сайт меняется?

- Поддерживаемые платформы: это расширение браузера, облачный сервис или библиотека для кода?

- Интеграции: можно ли выгружать данные напрямую в Google Sheets, Excel, Airtable, Notion или CRM?

- Цена: есть ли бесплатный тариф? Оплата за строки, за запуск или по подписке?

- Автоматизация и расписание: можно ли «настроить и забыть» или придётся контролировать каждый запуск?

- AI-возможности: помогает ли AI упростить настройку, предложить поля или справиться со сложными сайтами?

Ниже — быстрая таблица сравнения для старта (подробно разберём каждый инструмент дальше):

| Инструмент | Нужен код | AI-функции | Расписание | Экспорт | Сильные стороны |

|---|---|---|---|---|---|

| Thunderbit | Нет | Да | Да | Sheets, Excel, Airtable, Notion | Самая простая настройка, AI-определение полей |

| Web Scraper | Нет | Нет | Ограниченно | CSV, JSON, Sheets (облако) | Визуальная настройка, гибкость |

| BeautifulSoup | Да | Нет | Нет | На выбор (CSV, JSON, БД) | Простота, отличен для парсинга |

| Scrapy | Да | Нет | Да | CSV, JSON, XML, API | Масштабируемость, надёжный краулинг |

| Playwright | Да | Нет | Нет | На выбор | Хорошо для сайтов с тяжёлым JS |

| Apify | Нет/Да | Частично | Да | CSV, JSON, Sheets, API | Облачный масштаб, готовые акторы |

Thunderbit: самый простой AI Web Scraper для бизнес-пользователей

— это расширение Chrome, которое делает AI-веб-скрейпинг доступным каждому. Особенно тем, кто в продажах, e-commerce и недвижимости: когда данные нужны «ещё вчера», а ждать помощи от IT — это уже не вариант.

Что выделяет Thunderbit

![]()

- AI Suggest Fields: нажми «AI Suggest Fields», и Thunderbit сам проанализирует страницу, предложит колонки для извлечения и даже сформулирует кастомные подсказки (prompts) для каждого поля. Больше не нужно гадать, что именно выбирать.

- Сбор данных с подстраниц: нужно больше, чем просто список? Thunderbit может автоматически заходить на каждую подстраницу и обогащать таблицу.

- Мгновенные шаблоны Instant Data Scraper: для популярных сайтов (Amazon, Zillow, Instagram, Shopify и др.) достаточно выбрать шаблон и запустить. AI-кредиты не требуются.

- Scheduled Scraper: опиши расписание обычными словами («каждый понедельник в 9:00»), и Thunderbit будет запускать сбор автоматически.

- Извлечение email, телефонов и изображений + AI Autofill: инструменты в один клик для получения контактов или картинок с любой страницы, а AI может заполнять формы и автоматизировать веб-рутины.

- Облачный сбор vs. сбор в браузере: выбирай облако (быстрее, до 50 страниц параллельно) или браузер (для сайтов, где нужен твой логин).

Да, есть и : можно собрать данные с 6 страниц, или с 10 в рамках пробного периода. Для большинства бизнес-пользователей этого хватает, чтобы почувствовать разницу (окей, не 마법 — но очень близко).

Хочешь посмотреть Thunderbit в деле — загляни на наш или почитай подробные гайды про , или .

Web Scraper: гибкое извлечение данных прямо в браузере

Web Scraper (от ) — классическое расширение Chrome, которое живёт на рынке уже много лет. Его любят «гражданские аналитики данных» (citizen data analysts): код писать не хочется, но чуть-чуть покопаться — 괜찮아. Инструмент работает через создание «sitemap» — визуальных схем, которые объясняют скрейперу, как ходить по сайту и что именно вытаскивать.

- Интерфейс point-and-click: без кода, но придётся освоить выбор элементов и построение маршрутов навигации.

- Подстраницы и пагинация: отлично подходит для многоуровневых сайтов, но каждый шаг нужно настраивать руками.

- Экспорт: по умолчанию CSV и JSON; в облачной версии можно отправлять данные в Google Sheets или Dropbox.

- Расписание: доступно только в платном облачном тарифе.

- Поддержка сообщества: много документации и форумов, но оперативной помощи немного.

Главный плюс — гибкость. Главный минус — порог входа. Как отметил один из пользователей, «разобраться смогут только те, кто уверенно чувствует себя в технике» (). Если ты терпелив и готов экспериментировать, можно собрать данные почти с любого сайта. Но если не любишь метод проб и ошибок — лучше взять что-то попроще.

Подробное сравнение — в нашем обзоре .

BeautifulSoup: библиотека Python для кастомного извлечения данных

Теперь — территория разработчиков. — популярная Python-библиотека для парсинга HTML и XML. Если ты знаешь Python, можно написать скрипт, который вытащит ровно то, что нужно — и именно так, как нужно тебе.

- Без интерфейса: только код.

- Гибкая и лёгкая: отлично для небольших и средних задач или как часть более крупного Python-процесса.

- Пагинация — частично: циклы и логику переходов по страницам придётся писать самостоятельно.

- Нет встроенного расписания: для автоматизации используй cron или планировщики задач.

- Вывод на ваш выбор: CSV, JSON, база данных — куда угодно.

BeautifulSoup хорош для быстрых точечных задач или как компонент в большом пайплайне данных. Для масштабного краулинга на тысячи страниц он не заточен (это уже зона Scrapy), но как старт для Python-разработчиков — прям 국룰 (классика).

Scrapy: мощный фреймворк для извлечения данных в больших объёмах

Если BeautifulSoup — это швейцарский нож, то — уже полноценный электроинструмент. Scrapy — Python-фреймворк, созданный для краулинга и извлечения данных в масштабе.

- Для разработчиков: настройка через командную строку, Python-классы и структурированный проект.

- Глубокий краулинг: автоматически следует по ссылкам, обрабатывает пагинацию и учитывает robots.txt.

- Высокая производительность: асинхронные запросы, авто-троттлинг, кэширование и повторные попытки.

- Гибкие пайплайны: вывод в CSV, JSON, XML или отправка в API и базы данных.

- Расписание: через Scrapy Cloud или интеграцию с cron.

- Расширяемость: middleware для прокси-ротации, подмены user-agent и даже интеграции headless-браузера (для сайтов с тяжёлым JavaScript).

Компромисс — сложность. Порог входа у Scrapy высокий, но если нужно надёжно собирать данные с тысяч (или миллионов) страниц, конкурентов у него реально немного.

Playwright: современная автоматизация для веб-скрейпинга

Некоторые сайты будто специально не хотят, чтобы их скрейпили: данные спрятаны за JavaScript, нужен логин или приходится проходить лабиринт кнопок. Тут выручает (см. ) — современная библиотека автоматизации браузера (есть Python, JavaScript и другие языки), которая позволяет управлять настоящим браузером — почти как человек.

- Динамический контент: идеально для React, Angular и других JS-насыщенных сайтов.

- Имитация действий пользователя: клики, заполнение форм, скролл, ожидание загрузки элементов.

- Нет встроенного расписания: запуск вручную или через внешние планировщики.

- Вывод на ваш выбор: куда сохранять данные — решаешь ты.

- Требовательность к ресурсам: каждый экземпляр браузера ест много памяти — лучше для задач среднего масштаба.

Playwright — это такой «взломщик замков» в мире веб-скрейпинга. Если сайт закрывает доступ хитрыми механиками, он поможет. Но для нетехнических пользователей это не вариант, и по скорости он уступает сетевым скрейперам вроде Scrapy.

Apify: облачный Web Scraper для масштабируемого извлечения данных

— платформа «швейцарский нож» для веб-скрейпинга. Она поддерживает и no-code, и кодовые сценарии, поэтому хорошо заходит командам, которые хотят масштабироваться без управления собственной инфраструктурой.

- Готовые “Actors”: тысячи готовых скрейперов для Google Maps, LinkedIn, Zillow и многих других. Просто задай параметры и запускай.

- Кастомные скрейперы: разработчики могут создавать и деплоить собственные акторы на JavaScript или Python.

- Облачное расписание и масштабирование: параллельные запуски, планирование задач — Apify берёт на себя самую тяжёлую часть.

- Интеграции: экспорт в CSV, JSON, Excel, Google Sheets или доступ через API. Поддерживаются webhooks и инструменты автоматизации вроде n8n или Make.

- AI-интеграции: некоторые акторы используют AI для более умного извлечения и классификации данных.

- Порог входа: интерфейс и концепции (Actors, datasets, proxies) могут пугать новичков, но документация сильная.

Apify отлично подходит организациям со смешанным уровнем технических навыков или тем, кто хочет запускать крупные сборы данных без забот о серверах и прокси. Но имей в виду: вместе с мощью приходит и немного сложности (и тарификация по использованию).

Сравнение: какой Web Scraper или AI Web Scraper подойдёт именно вам?

Вот более подробная таблица, чтобы быстрее сузить выбор:

| Инструмент | Удобен без кода | Подстраницы/пагинация | Расписание | Масштабируемость | Лучше всего для |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | Авто (AI) | Встроено | Средняя | Продажи, ops, недвижимость |

| Web Scraper | ⭐⭐ | Ручная настройка | Только облако | Средняя | Аналитики данных, терпеливые пользователи |

| BeautifulSoup | ⭐ | Вручную (код) | Нет | Низкая | Python-разработчики, небольшие проекты |

| Scrapy | ⭐ | Авто (код) | Да | Высокая | Разработчики, крупный краулинг |

| Playwright | ⭐ | Вручную (код) | Нет | Средняя | Разработчики, динамические JS-сайты |

| Apify | ⭐⭐⭐ | Зависит от актора | Встроено | Высокая | Команды, масштабируемые проекты |

- Thunderbit: лучший выбор для нетехнических пользователей, которым нужны данные быстро, с минимальной настройкой и AI-автоматизацией.

- Web Scraper: подойдёт тем, кто готов разбираться в нюансах; гибкий, но не совсем «включил и работает».

- BeautifulSoup/Scrapy/Playwright: для разработчиков, которым важен полный контроль и комфортно работать с кодом.

- Apify: отличный вариант для команд, которым нужен облачный масштаб, готовые решения и не страшна небольшая сложность.

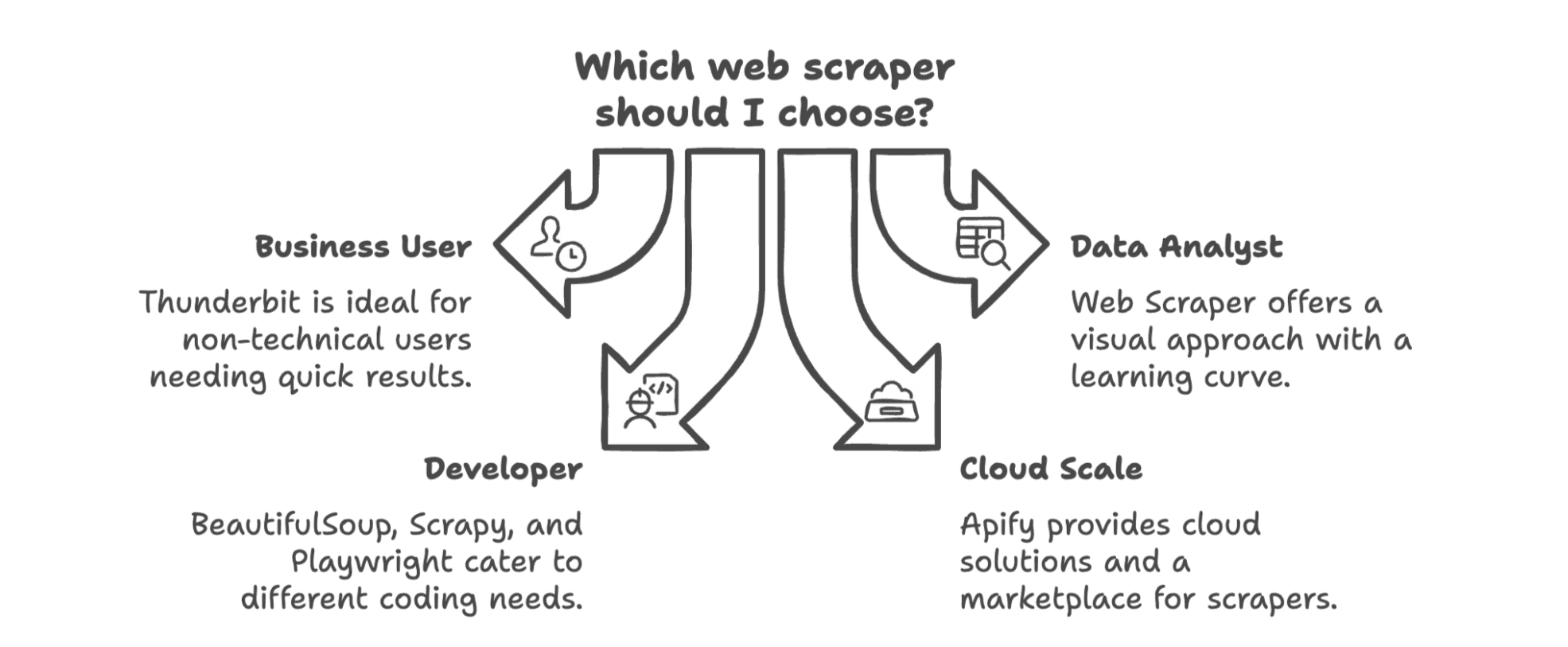

Как выбрать лучший Web Scraper для вашего бизнеса в 2025 году

Итак, что по итогу? Лучший Web Scraper зависит от твоей команды, технической подготовки и того, какие данные тебе реально нужны.

- Если ты бизнес-пользователь (продажи, маркетинг, ops) и хочешь без кода — твой лучший вариант . Он сделан для тебя, а не для инженеров, и позволит начать собирать данные за минуты, а не часы.

- Если ты аналитик данных или тебя не пугает обучение, визуальный подход Web Scraper может быть очень мощным — но готовься к экспериментам.

- Если ты разработчик, BeautifulSoup и Scrapy — проверенная классика: BS4 для быстрых скриптов, Scrapy для больших обходов, Playwright для динамических сайтов.

- Если тебе нужен облачный масштаб или маркетплейс готовых скрейперов, Apify — сильный выбор, особенно для команд с разным уровнем навыков.

И не забывай: тренд уверенно идёт в сторону AI-решений без кода, которые встраиваются прямо в рабочий процесс. Эпоха «собрал → скачал → импортировал → почистил → повторил» быстро уходит. Теперь можно перейти от сайта к таблице (или CRM, или Notion) буквально за пару кликов.

Если хочешь увидеть, насколько простым может быть веб-скрейпинг, попробуй . А если хочется углубиться — загляни в : там есть разборы, инструкции и иногда — не самые удачные шутки от автора.

Пусть 2025 станет годом, когда ты наконец перестанешь копировать и вставлять — и начнёшь поручать тяжёлую работу AI.

FAQ

Q1: Нужны ли навыки программирования, чтобы пользоваться Web Scraper в 2025 году? A: Уже нет. AI-инструменты вроде Thunderbit позволяют нетехническим пользователям извлекать данные в несколько кликов — без кода и сложной настройки. Разработчики по-прежнему выбирают Scrapy или Playwright, когда нужна кастомная логика.

Q2: Какие типы данных умеют извлекать AI Web Scraper? A: Текст, числа, ссылки, email, номера телефонов, изображения — и даже структурированные данные из PDF или динамических сайтов. Некоторые инструменты также позволяют на лету планировать сбор, переводить или категоризировать данные.

Q3: Законен ли веб-скрейпинг для бизнеса? A: Да — если ты собираешь публично доступные данные для легитимных бизнес-задач (например, исследования или лидогенерация), обычно это допустимо. Главное — не скрейпить закрытый доступом или защищённый авторским правом контент без разрешения.

Q4: В чём главный плюс использования AI для веб-скрейпинга? A: Скорость и доступность. AI берёт на себя определение полей, пагинацию и даже автоматизацию процессов — ты тратишь меньше времени на настройку и больше на использование данных.

Читайте также