«Можно иметь данные без информации, но нельзя иметь информацию без данных». —

По самым свежим подсчётам, в интернете уже больше сайтов, и каждый день появляется примерно 2 миллиона новых материалов. В этом настоящем 데이터 바다 спрятано море инсайтов для решений, но есть один момент: около информации — неструктурированная. То есть её нужно «причесать» и разложить по полочкам, чтобы она реально работала на вас. Вот тут и вступают в игру инструменты для веб-скрейпинга — без них сложно представить работу тех, кто хочет быстро и эффективно вытаскивать пользу из данных в сети.

Если вы только стартуете, слова вроде и могут звучать как что-то из мира 개발자. Но в эпоху ИИ вход стал заметно проще. Современные инструменты для веб-скрейпинга с поддержкой ai web scraper помогают начать без глубоких техзнаний: собирать и обрабатывать данные можно быстро, удобно и без программирования.

Лучшие инструменты и программы для веб-скрейпинга

- — простой AI Web Scraper с отличным качеством результата

- — мониторинг в реальном времени и массовая выгрузка данных

- — no-code автоматизация с большим числом интеграций

- — более «профессиональный» визуальный скрейпинг

- — мощный no-code скрейпинг с обходом блокировок и антибот-защит

- — продвинутый API для извлечения данных на базе ИИ и knowledge graph

Попробуйте веб-скрейпинг с помощью ИИ

Попробуйте! Можно кликать, изучать и запускать сценарий прямо во время просмотра.

Как работает веб-скрейпинг?

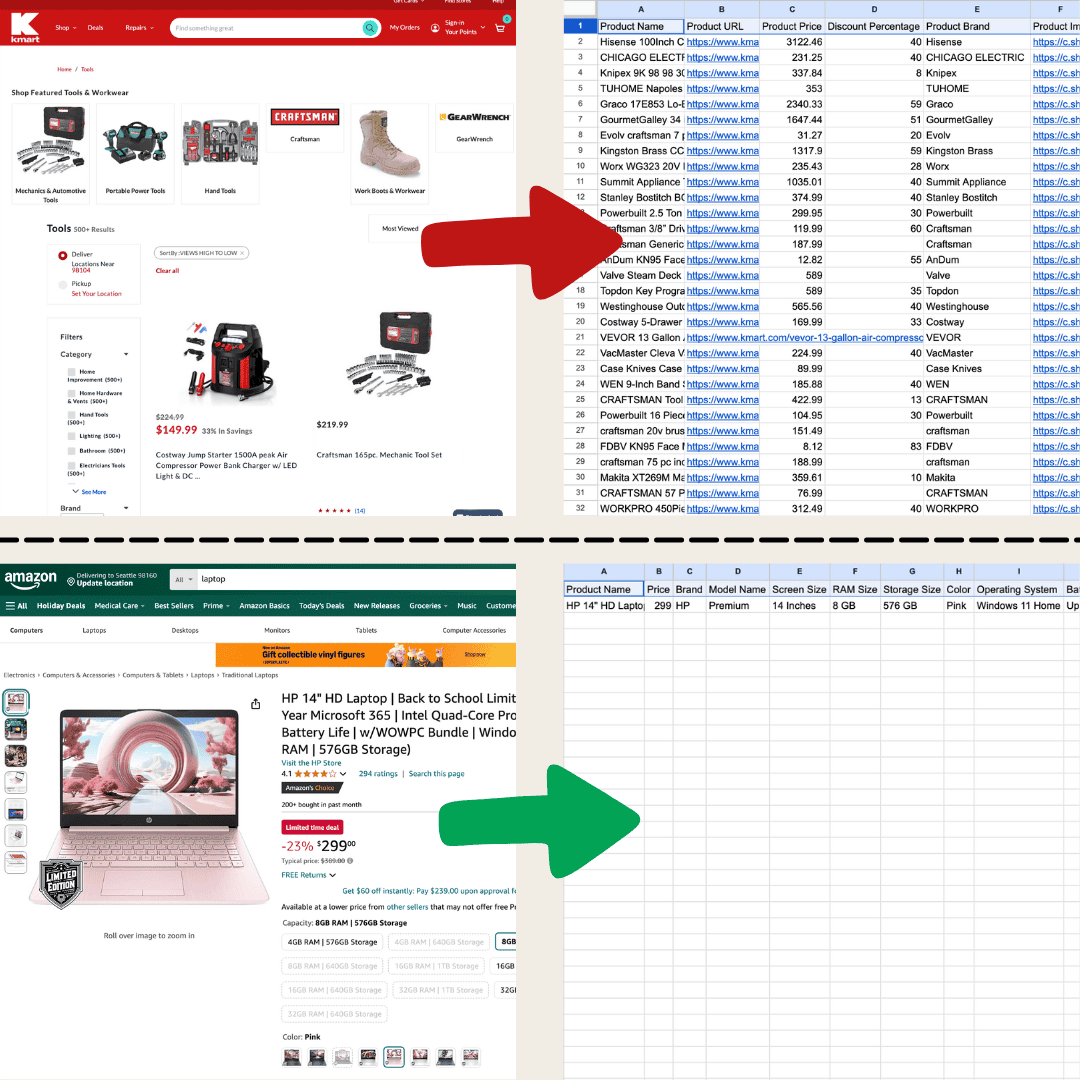

Веб-скрейпинг — это процесс извлечения данных с сайтов. Вы задаёте инструменту понятные инструкции, а он собирает текст, изображения или другие нужные элементы со страницы и аккуратно складывает всё в таблицу. Это выручает в самых разных задачах: от отслеживания цен в интернет-магазинах до сбора данных для исследований или просто чтобы собрать красивую табличку в Excel или Google Sheets.

Я сделал это в Thunderbit с помощью AI Web Scraper.

Я сделал это в Thunderbit с помощью AI Web Scraper.

Подходов несколько. Самый базовый — копировать и вставлять вручную, но на больших объёмах это быстро превращается в бесконечную рутину. Поэтому обычно выбирают один из трёх вариантов: классические веб-скрейперы, AI Web Scraper или собственный код.

Классические веб-скрейперы работают по чётким правилам: вы указываете, какие элементы страницы забирать, опираясь на структуру сайта. Например, можно настроить сбор названий товаров или цен из конкретных HTML-тегов. Лучше всего это заходит на сайтах, где верстка почти не меняется: стоит макету обновиться — и скрейпер придётся заново настраивать.

Освоение классического скрейпера обычно занимает время, а настройка нередко требует десятков кликов.

Освоение классического скрейпера обычно занимает время, а настройка нередко требует десятков кликов.

AI Web Scraper — это когда условно «ChatGPT читает сайт целиком» и достаёт нужное по вашему запросу. Он может параллельно вытаскивать данные, переводить и делать короткие 요약. За счёт обработки естественного языка такие решения лучше «понимают» структуру страницы и спокойнее переживают изменения на сайте. Если, например, блоки на странице чуть переставили местами, AI Web Scraper часто подстроится без необходимости переписывать настройки. Поэтому он особенно удобен для «капризных» сайтов и сложных структур.

С AI Web Scraper легко начать: несколько кликов — и у вас уже детализированные данные.

С AI Web Scraper легко начать: несколько кликов — и у вас уже детализированные данные.

Что выбрать? Всё упирается в задачу. Если вы уверенно чувствуете себя в настройках/коде или вам нужно собирать огромные объёмы данных с популярного ресурса, классические скрейперы могут быть очень эффективны. Но если вы новичок или хотите инструмент, который проще адаптируется к обновлениям сайтов, чаще выигрывает AI Web Scraper. В таблице ниже — примеры, когда что лучше подходит.

| Сценарий | Лучший выбор |

|---|---|

| Небольшой скрейпинг страниц вроде каталогов, интернет-магазинов или любых страниц со списками | AI Web Scraper |

| На странице меньше 200 строк данных, а настройка классического скрейпера занимает слишком много времени | AI Web Scraper |

| Данные нужно выгрузить в конкретном формате для загрузки в другой сервис. Например, собрать контакты для импорта в HubSpot. | AI Web Scraper |

| Масштабный сбор с популярных сайтов: десятки тысяч карточек товаров Amazon или объявлений Zillow. | Traditional Web Scraper |

Лучшие инструменты для веб-скрейпинга — краткое сравнение

| Инструмент | Цена | Ключевые возможности | Плюсы | Минусы |

|---|---|---|---|---|

| Thunderbit | От $9/мес, есть бесплатный тариф | AI Web Scraper, автоопределение и форматирование данных, поддержка разных форматов, экспорт в один клик, удобный интерфейс. | Без кода, поддержка ИИ, интеграции с Google Sheets и др. | На больших объёмах может работать медленнее, продвинутые функции могут стоить дороже |

| Browse AI | От $48.75/мес, есть бесплатный тариф | No-code интерфейс, мониторинг в реальном времени, массовая выгрузка, интеграция в процессы. | Удобен, интеграции с Google Sheets и Zapier | Для сложных страниц нужна доп. настройка, массовый сбор иногда приводит к таймаутам |

| Bardeen AI | От $60/мес, есть бесплатный тариф | No-code автоматизация, интеграции с 130+ приложениями, MagicBox превращает задачи в сценарии. | Очень много интеграций, подходит бизнесу | Новичкам сложнее освоить, настройка может занять время |

| Web Scraper | Бесплатно локально, $50/мес за облако | Визуальная настройка, поддержка динамических сайтов (AJAX/JavaScript), облачный скрейпинг. | Хорошо работает с динамическими сайтами | Для лучшего результата нужны тех. знания |

| Octoparse | От $119/мес, есть бесплатный тариф | No-code скрейпинг, автоопределение элементов, облако и расписание, библиотека шаблонов. | Мощный для динамических сайтов, умеет обходить ограничения | Сложные сайты требуют времени на обучение |

| Diffbot | От $299/мес | API для извлечения данных, no-rule API, NLP для неструктурированного текста, большой knowledge graph. | Сильное AI-извлечение, широкие возможности API, масштабируемость | Нужна подготовка для нетехнических пользователей, настройка занимает время |

Лучший веб-скрейпер в эпоху ИИ

Thunderbit — мощный, но при этом максимально понятный инструмент AI-автоматизации прямо в браузере: он помогает извлекать и упорядочивать данные без навыков программирования. Благодаря и встроенному сбор данных становится реально проще: можно быстро получать информацию со страниц без ручного «выделения» элементов и без создания отдельных скрейперов под каждую верстку.

Ключевые возможности

- Гибкость на базе ИИ: AI Web Scraper в Thunderbit сам определяет и форматирует данные, без CSS-селекторов.

- Максимально простой процесс: нажмите “AI suggest column”, затем “Scrape” на нужной странице — и готово.

- Поддержка разных форматов данных: Thunderbit умеет собирать URL, изображения и показывать результат в разных форматах.

- Автоматическая обработка данных: ИИ может «на лету» переформатировать данные — делать краткие итоги, категоризировать, переводить и приводить к нужному виду.

- Удобный экспорт: выгрузка в Google Sheets, Airtable или Notion в один клик.

- Понятный интерфейс: подойдёт пользователям с любым уровнем подготовки.

Цена

У Thunderbit есть тарифы с разным объёмом кредитов: от $9 в месяц за 5 000 кредитов до $199 за 240 000 кредитов. В годовом плане все кредиты начисляются сразу.

Плюсы:

- Сильная поддержка ИИ упрощает извлечение и обработку данных.

- Не нужен код — подходит пользователям любого уровня.

- Отлично для «лёгкого» скрейпинга: каталоги, магазины и т. п.

- Удобные интеграции для экспорта в популярные приложения.

Минусы:

- При больших объёмах сбор может занять больше времени, чтобы сохранить точность.

- Некоторые продвинутые функции доступны только по подписке.

Хотите узнать больше? Начните с или посмотрите, с Thunderbit.

Лучший веб-скрейпер для мониторинга данных и массовой выгрузки

Browse AI

Browse AI — надёжный no-code инструмент для извлечения и мониторинга данных без написания кода. В нём есть некоторые AI-функции, но до полноценного ai web scraper он всё-таки не дотягивает. Тем не менее, стартовать с ним действительно проще — особенно если нужен мониторинг.

Ключевые возможности

- No-code интерфейс: позволяет собирать сценарии простыми кликами.

- Мониторинг в реальном времени: боты отслеживают изменения на страницах и присылают обновления.

- Массовое извлечение данных: до 50 000 записей за один запуск.

- Интеграция в процессы: можно связывать несколько ботов для более сложной обработки.

Цена

От $48.75 в месяц, включая 2 000 кредитов. Есть бесплатный тариф: 50 кредитов в месяц, чтобы протестировать базовые возможности.

Плюсы:

- Интеграции с Google Sheets и Zapier.

- Готовые боты упрощают типовые задачи.

Минусы:

- Для сложных страниц может потребоваться дополнительная настройка.

- Скорость массового сбора нестабильна — иногда случаются таймауты.

Лучший веб-скрейпер для интеграции в рабочие процессы

Bardeen AI

Bardeen AI — no-code инструмент автоматизации, который помогает выстраивать процессы, соединяя разные приложения. Он использует ИИ для создания кастомной автоматизации, но по адаптивности уступает полноценному AI-скрейперу.

Ключевые возможности

- No-code автоматизация: настройка сценариев кликами.

- MagicBox: вы описываете задачу обычным языком, а Bardeen AI превращает её в workflow.

- Широкие интеграции: более 130 приложений, включая Google Sheets, Slack и LinkedIn.

Цена

От $60 в месяц, включая 1 500 кредитов (примерно 1 500 строк данных). Бесплатный тариф даёт 100 кредитов в месяц для теста базовых функций.

Плюсы:

- Большой выбор интеграций под разные бизнес-задачи.

- Гибкий и масштабируемый для компаний любого размера.

Минусы:

- Новичкам нужно время, чтобы освоить платформу.

- Первичная настройка может быть довольно долгой.

Лучший визуальный веб-скрейпер для опытных пользователей

Web Scraper

Да, вы всё правильно поняли: инструмент действительно называется «Web Scraper». Это популярное расширение для Chrome и Firefox, которое позволяет извлекать данные без кода и настраивать сбор визуально. Но чтобы уверенно им пользоваться, скорее всего, придётся потратить несколько дней на обучение по урокам выше. Если хочется, чтобы скрейпинг был максимально «원클릭» и без лишней возни, выбирайте AI Web Scraper.

Ключевые возможности

- Визуальная настройка: задачи создаются кликами по элементам страницы.

- Поддержка динамических сайтов: работает с AJAX и JavaScript.

- Облачный скрейпинг: можно запускать по расписанию через Web Scraper Cloud.

Цена

Бесплатно для локального использования; платные планы для облачных функций — от $50/мес.

Плюсы:

- Хорошо подходит для динамических сайтов.

- Бесплатен при локальном использовании.

Минусы:

- Для оптимальной настройки нужны технические знания.

- При изменениях на сайте требуется сложное тестирование.

Лучший веб-скрейпер, который помогает избегать блокировок IP и антибот-защит

Octoparse

Octoparse — универсальная программа для более технически подготовленных пользователей: помогает собирать и мониторить конкретные веб-данные без кода и подходит для больших объёмов. Octoparse работает не через браузер пользователя — он использует облачные серверы. Благодаря этому доступны разные способы обхода IP-блокировок и некоторых антибот-механизмов.

Ключевые возможности

- No-code подход: задачи можно создавать без программирования — подходит пользователям с разным уровнем технической подготовки.

- Умное автоопределение: автоматически находит данные на странице и элементы, которые можно извлечь, ускоряя настройку.

- Облачный скрейпинг: поддерживает круглосуточный сбор в облаке и запуск по расписанию.

- Большая библиотека шаблонов: сотни готовых шаблонов для популярных сайтов — можно быстро начать без сложной настройки.

Цена

Тарифы Octoparse начинаются от $119 в месяц и включают 100 задач. Есть бесплатный план с 10 задачами в месяц для тестирования.

Плюсы:

- Мощные функции для динамических сайтов и высокая адаптивность.

- Есть решения для ограничений, динамического контента и защит.

Минусы:

- Сложные структуры сайтов требуют больше времени на настройку.

- Новичкам нужно время, чтобы освоить приёмы работы.

Лучший веб-скрейпер для продвинутого API-извлечения данных на базе ИИ

Diffbot

Diffbot — продвинутый инструмент извлечения веб-данных, который с помощью ИИ превращает неструктурированный контент в структурированные данные. Благодаря мощным API и knowledge graph Diffbot помогает извлекать, анализировать и управлять информацией из интернета — подходит для разных отраслей и сценариев.

Ключевые возможности

- API для извлечения данных: у Diffbot есть no-rule API — достаточно передать URL, и данные извлекутся автоматически без ручных правил под каждый сайт.

- API обработки естественного языка (NLP): извлекает сущности, связи и тональность из неструктурированного текста — полезно для построения собственных knowledge graph.

- Knowledge Graph: один из крупнейших графов знаний, связывающий данные о сущностях, включая людей и организации.

Цена

Тарифы Diffbot начинаются от $299 в месяц и включают 250 000 кредитов (примерно 250 000 извлечений страниц через API).

Плюсы:

- Сильные no-rule возможности с высокой адаптивностью.

- Широкие варианты интеграции через API — удобно встраивать в существующие системы.

- Поддерживает масштабный сбор данных, подходит для enterprise-задач.

Минусы:

- Нетехническим пользователям может понадобиться время на освоение.

- Чтобы пользоваться API, нужно написать программу для вызова запросов.

Для чего вообще используют скрейперы?

Если вы только знакомитесь с веб-скрейпингом, вот несколько самых популярных сценариев. Часто скрейперы используют, чтобы собирать карточки товаров на Amazon, выгружать данные о недвижимости с Zillow или получать сведения о компаниях из Google Maps. Но это только разогрев — с помощью от Thunderbit можно собирать данные почти с любого сайта, ускоряя рутинные задачи и экономя время в ежедневной работе. Исследования, мониторинг цен, построение баз данных — веб-скрейпинг открывает массу способов превратить интернет-данные в практическую пользу.

FAQ

-

Законен ли веб-скрейпинг?

Веб-скрейпинг обычно законен, но важно учитывать условия использования сайта и характер данных, к которым вы обращаетесь. Всегда проверяйте правила и соблюдайте юридические требования.

-

Нужны ли навыки программирования для работы с инструментами веб-скрейпинга?

Большинство инструментов из этого списка не требуют программирования. Однако в Octoparse и Web Scraper базовое понимание структуры веб-страниц и «технический» подход могут заметно улучшить результат.

-

Есть ли бесплатные инструменты для веб-скрейпинга?

Да. Существуют бесплатные инструменты вроде BeautifulSoup, Scrapy и Web Scraper, а многие сервисы также предлагают бесплатные тарифы с ограничениями.

-

С какими сложностями чаще всего сталкиваются при веб-скрейпинге?

Обычно это динамический контент, CAPTCHA, блокировки по IP и сложная HTML-структура. Продвинутые инструменты и техники помогают эффективно решать эти проблемы.

Узнать больше:

-

Используйте ИИ и работайте без лишних усилий.