Скажу по-честному: в цифровой жизни мало что даёт такое странное, почти «кайфовое» чувство, как аккуратный и полный список всех страниц сайта — примерно как когда после стирки внезапно находятся все носки, и ни один не пропал. Но если ты хоть раз пытался получить страницы сайта для контент-аудита, миграции или просто чтобы понять, что там спрятано в «цифровом подвале», то знаешь: в реальности это почти никогда не бывает так просто. Я видел, как команды часами (а иногда и днями) склеивали списки из sitemap, выдачи Google и выгрузок из CMS — и всё равно в конце выяснялось, что они пропустили скрытые или динамические страницы. И не напоминай мне про случай, когда я помогал другу выгрузить все URL из WordPress: скажем так, кофе было много, а экзистенциальной тревоги — чуть больше, чем хотелось бы.

Хорошая новость: тебе не нужно дальше играть со своим сайтом в цифровые прятки. В этом гайде я разберу все основные способы, как найти URL сайта — от классики до более современных подходов — и покажу, как инструменты на базе ИИ вроде могут сделать процесс заметно быстрее, полнее и (осмелюсь сказать) даже приятнее. Неважно, ты маркетолог, разработчик или тот самый «счастливчик», которому поручили «собрать все ссылки» — здесь ты найдёшь практические шаги, примеры из жизни и честные сравнения, чтобы выбрать лучший подход для вашей команды.

Зачем может понадобиться список страниц сайта: реальные сценарии

Прежде чем перейти к «как», давай разберёмся с «зачем». Почему вообще так многим командам нужно находить URL сайта? Оказывается, это далеко не только про SEO — такая задача регулярно всплывает у маркетинга, продаж, IT и операционных команд. Вот самые частые кейсы:

- SEO-аудит и контент-стратегия: Контент-аудиты стали рутиной: . Полный список URL — база для оценки эффективности, обновления старых материалов и роста позиций. Более того, .

- Редизайн и миграции сайта: ), а любая миграция требует сопоставить текущие URL, чтобы избежать битых ссылок и потери SEO.

- Соответствие требованиям и поддержка: Операционные команды выискивают «сиротские» или устаревшие страницы — иногда это старые промо-микросайты, которые всё ещё живы и просто ждут момента, чтобы кого-то подставить.

- Анализ конкурентов: Маркетинг и продажи собирают страницы конкурентов (продукты, цены, блог), чтобы увидеть пробелы и возможности.

- Лидогенерация и аутрич: Отделы продаж часто составляют списки страниц магазинов, дилерских каталогов или страниц участников для контакта.

- Инвентаризация контента: Контент-маркетологи ведут перечень всех постов, лендингов, PDF и т. п., чтобы не дублировать материалы и выжимать максимум ценности.

Вот короткая таблица, которая суммирует эти сценарии:

| Сценарий | Кому нужно | Почему важен полный список страниц |

|---|---|---|

| SEO-аудит / контент-аудит | SEO-специалисты, контент-маркетологи | Оценить каждый материал; пропущенные страницы = неполный анализ и упущенные возможности оптимизации |

| Миграция/редизайн сайта | Веб-разработчики, SEO, IT, маркетинг | Сопоставить старые и новые URL, настроить редиректы, избежать битых ссылок и потерь SEO |

| Анализ конкурентов | Маркетинг, продажи | Увидеть все страницы конкурента; скрытые страницы могут подсказать новые возможности |

| Лидогенерация | Отделы продаж | Собрать страницы контактов/ресурсов для аутрича; чтобы не упустить потенциальные лиды |

| Инвентаризация контента | Контент-маркетинг | Поддерживать актуальный реестр, находить пробелы, избегать дублей и пересматривать старые страницы |

А последствия пропущенных или скрытых страниц вполне ощутимы. Представь: вы планируете редизайн и забываете про скрытый лендинг, который всё ещё приносит конверсии. Или проводите аудит и не видите 5% страниц, потому что они не проиндексированы. Это и потерянная выручка, и просадки в SEO, и иногда PR-проблемы, которые прилетают неожиданно.

Как обычно находят URL сайта: разбор классических методов

Переходим к практике: как люди в реальности получают страницы сайта? Есть несколько проверенных способов — одни быстрые и «на коленке», другие более тщательные (и иногда довольно болезненные). Вот как это обычно выглядит.

Поиск в Google и поисковые операторы

Как работает:

Открой Google и введи site:yourwebsite.com. Google покажет страницы, которые он проиндексировал для домена. Можно уточнять запрос ключевыми словами или разделами (например, site:yourwebsite.com/blog).

Что ты получишь:

Список проиндексированных страниц — то есть то, что Google «видит» и «помнит» про ваш сайт.

Ограничения:

- Показывает только проиндексированное, а не всё, что реально существует

- Обычно выдача обрывается после нескольких сотен результатов, даже если сайт большой

- Пропускает новые, скрытые или намеренно не индексируемые страницы

Когда использовать:

Подходит для быстрого «среза» или небольших сайтов, но не для полноценного аудита.

robots.txt и Sitemap.xml

Как работает:

Зайди на yourwebsite.com/robots.txt и найди строки “Sitemap:”. Открой карту сайта (часто это yourwebsite.com/sitemap.xml или /sitemap_index.xml). В sitemap перечислены URL, которые владелец сайта хочет индексировать.

Что ты получишь:

Список ключевых страниц — часто все посты блога, карточки товаров и т. п. .

Ограничения:

- В sitemap обычно попадают только страницы, которые владелец хочет индексировать — скрытые и «сиротские» часто не попадают

- Карта сайта может быть устаревшей, если её не обновляют

- У сайта может быть несколько sitemap — иногда их ещё нужно отыскать

Когда использовать:

Отлично, если это ваш сайт или ты хочешь быстро посмотреть основные страницы конкурента. Но помни: ты видишь то, что владелец сайта решил показать.

SEO-«пауки» и краулеры

Как работает:

Инструменты вроде Screaming Frog, Sitebulb или DeepCrawl имитируют поискового робота. Ты вводишь URL сайта, и инструмент проходит по внутренним ссылкам, собирая список найденных страниц.

Что ты получишь:

Потенциально все страницы, на которые есть ссылки внутри сайта, плюс данные вроде кодов ответа и метатегов.

Ограничения:

- «Сиротские» страницы (на которые нигде нет ссылок) не найдутся, если не подать их вручную

- Динамические страницы или контент, генерируемый JavaScript, могут быть пропущены, если нет поддержки headless-браузера

- Обход больших сайтов может занять много времени и «съесть» память компьютера

- Нужны настройка и технические навыки

Когда использовать:

Идеально для SEO-специалистов и разработчиков при глубоком аудите. Для нетехнических пользователей — вариант не самый дружелюбный.

Google Search Console и Analytics

Как работает:

Если у тебя есть доступ к сайту, Google Search Console (GSC) и Analytics позволяют выгружать списки URL.

- GSC: отчёты по индексации и эффективности показывают проиндексированные и исключённые URL (до 1 000 строк в экспорте, больше — через API).

- Analytics: показывает страницы, которые получали трафик за выбранный период (GA4 позволяет экспортировать до 100 000 строк).

Ограничения:

- GSC и Analytics показывают только страницы, о которых знает Google, или те, что получали трафик

- Лимиты экспорта (1 000 строк для GSC, 100k для GA4)

- Нужна верификация/владение сайтом; для анализа конкурентов не подходит

- Страницы без трафика или не в индексе не попадут в отчёты

Когда использовать:

Отлично для собственного сайта, особенно перед миграцией или аудитом. Для конкурентов — мимо.

Панели CMS

Как работает:

Если сайт на WordPress, Shopify или другой CMS, часто можно экспортировать список страниц и записей прямо из админки (иногда через плагин).

Что ты получишь:

Список всех сущностей контента — страницы, посты, товары и т. д.

Ограничения:

- Нужен админ-доступ

- Может не включать неконтентные или динамические страницы

- Если сайт собран из нескольких систем (блог, магазин, документация), придётся объединять выгрузки

Когда использовать:

Лучше всего для владельцев сайта при инвентаризации контента или бэкапе. Для конкурентов — бесполезно.

Почему классические способы часто не дают полного списка страниц

Если говорить прямо: идеального «традиционного» метода нет. Вот основные слабые места:

- Техническая сложность: многие подходы требуют навыков или специализированных инструментов. Для нетехнических коллег это реальный стоп-фактор. Ручной контент-аудит на большом сайте может занять .

- Неполное покрытие: каждый метод что-то упускает — индекс Google не видит неиндексируемые/новые страницы, sitemap не включает «сирот», краулеры не находят не связанные ссылками или динамические страницы, экспорт из CMS не охватывает всё, что вне системы.

- Много ручной работы и времени: часто приходится собирать данные из нескольких источников, удалять дубли и чистить список — скучно и легко ошибиться. Люди даже делятся «лайфхаками» вроде копипаста из sitemap в Excel или скриптов в командной строке.

- Актуальность: списки быстро устаревают. Традиционные методы нужно повторять каждый раз при изменениях на сайте.

- Доступы и права: часть способов требует админ-доступа или владения сайтом — для конкурентов не подходит.

- Перегруз данными: SEO-краулеры могут завалить техническими метриками, когда тебе нужен просто список URL.

В итоге классический процесс напоминает «попытку испечь торт, когда рецепт постоянно меняется, а духовка периодически не пускает тебя внутрь». (Да, это реальная метафора от контент-стратега — и она пугающе точная.)

Знакомьтесь: Thunderbit — способ находить URL сайта с помощью ИИ

А теперь — самое вкусное. Что если можно просто попросить помощника: «пройди по этому сайту и составь список всех страниц», и он реально это сделает — без кода и без головной боли? Именно под это и заточен .

Thunderbit — это AI Web Scraper в формате расширения Chrome, рассчитанный на нетехнических пользователей (но при этом достаточно мощный и для профи). Он использует ИИ, чтобы «понимать» страницы, структурировать данные и получить страницы сайта — включая скрытые, динамические и контент на подстраницах. Никакого кода и сложных настроек: открываешь сайт, жмёшь “AI Suggest Fields”, и Thunderbit берёт работу на себя.

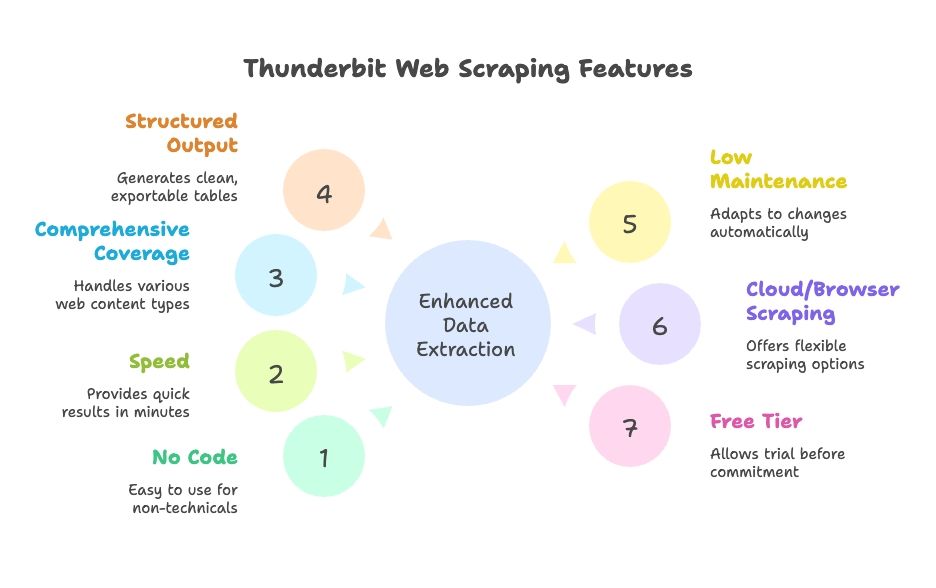

Чем Thunderbit выделяется:

- Без кода и подготовки: интерфейс на естественном языке, подсказки от ИИ — разберётся любой в команде.

- Скорость: результат за минуты, а не за часы.

- Широкое покрытие: динамика, пагинация, бесконечная прокрутка, подстраницы.

- Структурированный вывод: аккуратные таблицы с экспортом в Google Sheets, Excel, Airtable, Notion, CSV или JSON.

- Меньше поддержки: ИИ подстраивается под изменения сайта — меньше ручной «подкрутки».

- Скрапинг в облаке или в браузере: выбирай, что удобнее.

- Есть бесплатный тариф: можно попробовать перед покупкой.

Как Thunderbit упрощает сбор страниц сайта

Разберём, как это выглядит в реальности. Покажу, как перейти от «нужен список всех страниц» к «вот таблица, босс» буквально за несколько кликов.

Шаг 1: Установите и запустите Thunderbit

Скачай и закрепи его в браузере. Открой сайт, который хочешь собрать (например, главную страницу), и нажми на иконку Thunderbit, чтобы открыть интерфейс.

Совет: Thunderbit даёт бесплатные кредиты новым пользователям — можно протестировать без карты.

Шаг 2: Выберите источник данных

По умолчанию Thunderbit собирает текущую страницу, но ты также можешь загрузить список URL (например, из sitemap или страниц категорий), если хочешь стартовать с конкретного раздела.

- Для большинства сайтов логично начать с главной или страницы sitemap.

- Для e-commerce обычно удобнее стартовать с категории или листинга товаров.

Шаг 3: Используйте “AI Suggest Fields”, чтобы распознать URL

Вот тут и начинается «магия». Нажми “AI Suggest Fields” (или “AI Suggest Columns”). ИИ Thunderbit просканирует страницу, распознает паттерны и предложит колонки вроде “Page Title” и “Page URL” для всех найденных ссылок. Если нужно — отредактируй набор колонок.

- На главной обычно подтягиваются ссылки из меню, футера и блоков.

- На sitemap получится максимально чистый список URL.

- Можно добавлять/удалять колонки и уточнять, что именно извлекать.

ИИ делает всю сложную часть — не нужно писать XPath или CSS-селекторы. Это как стажёр-робот, который реально понимает задачу.

Шаг 4: Включите сбор подстраниц

На главной редко есть все страницы. Тут выручает Subpage Scraping в Thunderbit. Отметь колонку URL как ссылку для перехода (follow), и Thunderbit будет открывать каждую найденную ссылку и собирать дополнительные URL с этих страниц. Можно настроить вложенные шаблоны для многоуровневого сбора.

- Для пагинации или кнопок “load more” включи Pagination & Scrolling, чтобы Thunderbit продолжал, пока не соберёт всё.

- Для сайтов с поддоменами или отдельными разделами (например, блог на ) Thunderbit тоже может переходить по ссылкам, если ты это задашь.

Шаг 5: Запустите сбор

Нажми “Scrape” и просто наблюдай, как Thunderbit работает. Таблица будет заполняться URL (и другими выбранными полями) в реальном времени. Для больших сайтов можно оставить процесс в фоне и вернуться позже.

Шаг 6: Проверьте и экспортируйте

После завершения проверь результат: Thunderbit позволяет сортировать, фильтровать и удалять дубли прямо в приложении. Затем экспортируй данные в один клик в Google Sheets, Excel, CSV, Airtable, Notion или JSON. Никакого копипаста и «кривого» форматирования.

Сколько это занимает? Для небольшого или среднего сайта — от нуля до полного списка URL обычно меньше 10 минут. Для крупных сайтов всё равно получается на порядок быстрее (и спокойнее), чем собирать данные из разных источников вручную.

Как Thunderbit находит скрытые и динамические страницы

Одна из моих любимых фишек Thunderbit — как он вытаскивает то, что традиционные инструменты часто не видят:

- Контент, отрисованный JavaScript: поскольку Thunderbit работает в реальном браузере, он видит динамическую загрузку (например, бесконечную прокрутку на вакансиях или листингах товаров).

- «Сиротские» или не связанные ссылками страницы: если есть зацепка (sitemap или поиск по сайту), Thunderbit может использовать её, чтобы найти страницы, на которые нигде не ссылаются.

- Поддомены и разделы: при необходимости Thunderbit может переходить по ссылкам между поддоменами, давая более полную картину.

- Взаимодействие как у пользователя: нужно ввести запрос в поиск или нажать фильтр, чтобы открыть скрытые страницы? AI Autofill в Thunderbit справится и с этим.

Пример из практики: маркетинговой команде нужно было найти все старые лендинги — многие нигде не были связаны ссылками, но продолжали существовать. Они собрали выдачу Google через Thunderbit и добавили известные паттерны URL — так нашли десятки забытых страниц и избавили компанию от путаницы (и пары головных болей).

Thunderbit против классических методов: скорость, простота и полнота

Сравним Thunderbit с традиционными подходами:

| Критерий | Поиск Google “site:” | XML Sitemap | SEO-краулер (Screaming Frog) | Google Search Console | Экспорт из CMS | Thunderbit AI Scraper |

|---|---|---|---|---|---|---|

| Скорость | Очень быстро, но ограниченно | Мгновенно, если доступно | По-разному (от минут до часов) | Быстро для небольших сайтов | Мгновенно для небольших сайтов | Быстро: настройка за минуты, сбор автоматический |

| Простота | Очень просто | Просто | Средне (нужна настройка) | Средне | Просто (если есть админ-доступ) | Очень просто, без кода |

| Покрытие | Низкое (только индекс) | Высокое для «задуманных» страниц | Высокое для связанных ссылками страниц | Высокое для индекса, но ограничено экспортом | Среднее (только контент) | Очень высокое: динамика и подстраницы |

| Вывод и интеграции | Ручной копипаст | XML (нужно парсить) | CSV с большим количеством лишних данных | CSV/Excel, до 1 000 строк | CSV/XML, часто нужна чистка | Чистая таблица, экспорт в Sheets/Excel и др. в 1 клик |

| Поддержка/актуальность | Ручной повтор | Нужно обновлять | Перезапускать при изменениях | Периодические выгрузки | Выгрузка после изменений | Низкая: ИИ адаптируется, можно настроить расписание |

Thunderbit выигрывает по простоте, полноте и удобству интеграций. У традиционных методов есть сильные стороны, но обычно требуется больше усилий, чтобы объединить результаты и поддерживать их актуальными. ИИ Thunderbit подстраивается под изменения сайта, поэтому ты не тратишь время на постоянную «подкрутку» настроек.

Как выбрать подход: кому какой метод подходит

Так что же выбрать? Вот мой взгляд, основанный на годах помощи командам в «укрощении» данных сайта:

- SEO-специалисты / разработчики: если нужны глубокие технические данные (метатеги, битые ссылки и т. п.) или вы аудируете огромный корпоративный сайт, краулер или кастомный скрипт всё ещё могут быть оправданы. Но даже тогда Thunderbit поможет быстро получить список URL для загрузки в другие инструменты.

- Маркетологи, контент-стратеги, проджект-менеджеры: Thunderbit — спасение. Не нужно ждать IT, чтобы запустить скрипт или склеить выгрузки. Для инвентаризации контента, анализа конкурентов или быстрого аудита можно сделать всё самостоятельно.

- Продажи / лидогенерация: Thunderbit позволяет быстро собрать списки страниц локаций, мероприятий или каталогов участников с любого сайта — без кода.

- Небольшие сайты / разовые задачи: для совсем маленьких сайтов может хватить ручной проверки или sitemap. Но настройка Thunderbit настолько быстрая, что часто проще использовать его и не рисковать пропусками.

- Бюджет: традиционные методы почти бесплатны (если не считать твоё время). У Thunderbit есть бесплатный тариф, а платные планы обычно доступны бизнесу. Помни: время тоже стоит денег.

- Очень специфичные требования к данным: если нужна сложная логика или нестандартные поля, возможно, придётся писать свой скрейпер. Но большинство задач Thunderbit закрывает с минимальной настройкой.

Подсказки для решения:

- Если ты владелец сайта и страниц меньше 1 000 — попробуй экспорт из Google Search Console, но проверь полноту.

- Если доступа к сайту нет или нужны данные конкурента — выбирай Thunderbit или краулер.

- Если ты ценишь время и хочешь решение, которое масштабируется — Thunderbit сложно превзойти.

- Для командной работы большой плюс — прямой экспорт Thunderbit в Google Sheets.

Во многих компаниях работает гибридный подход: Thunderbit — для быстрых задач и самостоятельности нетехнических коллег, традиционные инструменты — для глубоких технических аудитов.

Главное: как собирать страницы сайта под разные бизнес-задачи

Подведём итог:

- Полный список страниц сайта критически важен для SEO, контент-стратегии, миграций и исследований для продаж. Он помогает избежать сюрпризов, битых ссылок и упущенных возможностей. Большинство маркетологов сегодня проводят контент-аудиты минимум раз в год ().

- Классические методы существуют, но у каждого есть пробелы. Ни один подход не гарантирует полностью актуальный и исчерпывающий список. Часто нужны технические навыки и объединение нескольких выгрузок.

- Скрапинг с ИИ (Thunderbit) — современная альтернатива. Thunderbit берёт на себя «умную» часть: клики, переходы и структурирование данных, делая веб-скрейпинг доступным всем. Он справляется с динамическим контентом, подстраницами и экспортирует данные в готовом виде — экономит время и снижает риск ошибок. В прямых сравнениях Thunderbit часто делает за минуты то, на что раньше уходили часы, и почти без порога входа ().

- Подбирайте метод под задачу и команду. Для гигантских сайтов пригодится весь набор инструментов, но для большинства бизнес-пользователей одного Thunderbit обычно достаточно.

- Поддерживайте список актуальным. Регулярные аудиты помогают раньше замечать проблемы и держать сайт «стройным». Планирование по расписанию в Thunderbit делает это реальным, тогда как ручные процессы часто откладывают из-за трудозатрат.

Финальная мысль: больше никаких оправданий, почему ты не знаешь, что находится на твоём сайте (или на сайте конкурента). С правильным подходом ты получишь страницы сайта в виде полного списка и сможешь использовать его для улучшения SEO, пользовательского опыта и бизнес-стратегии. Работай умнее, а не больше: пусть ИИ делает тяжёлую работу — и ни одна страница не останется за бортом.

Что делать дальше

Если ты хочешь перестать бояться задачи «собери мне все URL», и протестируй его на своём сайте или на сайте конкурента. Ты удивишься, сколько времени (и нервов) это экономит. А если хочешь глубже разобраться в веб-скрейпинге, загляни в другие материалы на , например или .

FAQ

1. Зачем нужен список всех страниц сайта?

Командам в SEO, маркетинге, продажах и IT часто требуется полный список URL для контент-аудитов, миграций, лидогенерации и анализа конкурентов. Полный и точный перечень помогает избежать битых ссылок, не допустить дублирования или «забытых» материалов и находить скрытые возможности.

2. Какие есть традиционные способы найти все URL сайта?

Обычно используют поиск Google с оператором site:, проверяют sitemap.xml и robots.txt, обходят сайт SEO-инструментами вроде Screaming Frog, выгружают данные из CMS (например, WordPress), а также берут списки проиндексированных/трафиковых страниц из Google Search Console и Analytics. Но у каждого метода есть ограничения по полноте и удобству.

3. В чём ограничения традиционных методов?

Классические подходы часто пропускают динамические, «сиротские» или неиндексируемые страницы. Нередко нужны технические знания, а на объединение и очистку данных уходят часы. Для больших сайтов и повторяющихся аудитов такие методы масштабируются плохо. Плюс иногда требуется владение сайтом или админ-доступ, что не всегда возможно.

4. Как Thunderbit упрощает поиск всех страниц сайта?

Thunderbit — AI Web Scraper, который «просматривает» сайт как человек: переходит по подстраницам, корректно обрабатывает JavaScript и автоматически структурирует данные. Код не нужен: это расширение Chrome, которое за несколько минут выгружает аккуратный список URL в Google Sheets, Excel, CSV и другие форматы.

5. Кому лучше использовать Thunderbit, а кому — традиционные инструменты?

Thunderbit отлично подходит маркетологам, контент-стратегам, отделам продаж и всем нетехническим пользователям, которым нужен быстрый и полный список URL без лишней возни. Традиционные инструменты полезнее для технических аудитов, где требуется глубокая мета-информация или кастомные скрипты. Многие команды используют оба подхода: Thunderbit — для скорости и простоты, классические инструменты — для детального анализа.