Инструменты для веб-скрейпинга стремительно превращаются в одно из самых недооценённых «оружий продуктивности» 2025 года — 진짜로. От лидогенерации и отслеживания рынка до мониторинга конкурентов и анализа тональности — такие решения дают нетехническим специалистам возможности, которые раньше требовали целой команды инженеров. Автоматизированный веб-скрейпинг больше не «закрытый 동아리» для разработчиков и дата-энтузиастов. Сегодня sales-менеджеры, маркетологи и даже самые «не технарские» ops-сотрудники собирают пайплайны данных за считанные минуты — иногда хватает пары кликов и простого описания на обычном языке того, что нужно получить.

Если ты читаешь это, ты, скорее всего, уже понимаешь: веб-скрейпинг — это секретный ингредиент умного поиска клиентов, быстрой аналитики рынка и прокачки эффективности процессов. Но когда вокруг десятки инструмент Web Scraper — и каждый обещает сэкономить время и нервы — как выбрать подходящий? За годы работы над SaaS и инструментами автоматизации (и да, соосновывая ) я не раз видел, как правильный инструмент превращает утомительный марафон «копировать-вставить» в победу за две минуты. Давайте разберём топ-10 инструменты автоматизированного веб-скрейпинга на 2025 год, сравним их сильные стороны и поможем вам начать работать умнее.

Почему автоматизированные инструменты веб-скрейпинга важны для бизнеса

Давайте по-честному: эпоха ручного копирования данных с сайтов закончилась (если, конечно, тебе не по кайфу монотонность, боль в запястьях и лёгкая экзистенциальная тоска). Автоматизированные инструменты веб-скрейпинга стали критически важными для компаний любого масштаба. Более того, , и веб-скрейпинг — один из ключевых элементов этой стратегии.

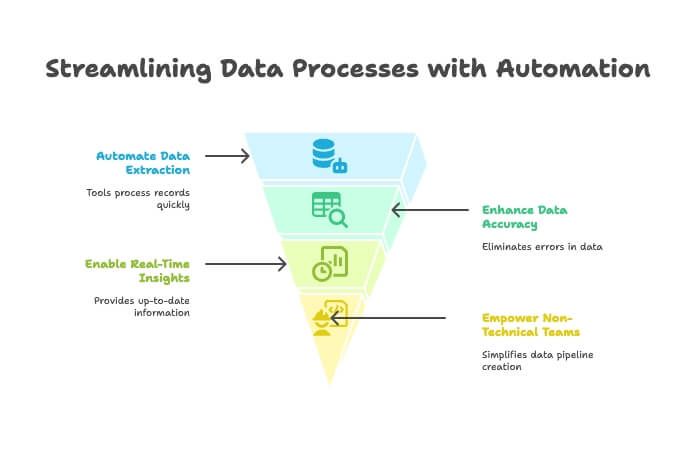

Вот почему такие инструменты настолько ценны:

- Экономия времени и меньше ручной рутины: автоматические скрейперы обрабатывают тысячи записей за минуты, освобождая команду для задач с большей отдачей. Один из пользователей сообщил, что сэкономил «сотни часов», автоматизировав сбор данных ().

- Выше точность данных: никаких опечаток и пропущенных строк. Автоматическое извлечение даёт более чистые и надёжные данные.

- Быстрее принятие решений: с потоками данных в реальном времени ты можешь следить за конкурентами, мониторить цены или собирать списки лидов без ожидания «ежемесячного отчёта от стажёра».

- Доступно нетехническим командам: благодаря no-code и AI-инструментам даже те, кто думает, что «XPath» — это поза из 요가, теперь могут собирать веб-пайплайны данных ().

Неудивительно, что , а почти 80% говорят, что без них их организация не смогла бы эффективно работать. В 2025 году, если ты не автоматизируешь сбор данных, ты, скорее всего, оставляешь на столе и деньги, и инсайты.

Как мы выбирали лучшие инструменты автоматизированного веб-скрейпинга

Рынок ПО для веб-скрейпинга, по прогнозам, , поэтому выбор подходящего решения иногда ощущается как шопинг обуви в магазине с 10 000 моделей. Вот по каким критериям я отобрал инструменты:

- Простота использования: сможет ли не-разработчик быстро стартовать? Насколько крутая кривая обучения?

- AI-возможности: использует ли инструмент AI для автоопределения полей, работы с динамическими сайтами или позволяет описывать задачу обычным языком?

- Экспорт и интеграции: насколько легко выгрузить данные в Excel, Google Sheets, Airtable, Notion или CRM?

- Цена: есть ли бесплатный пробный период? Доступны ли платные тарифы для одиночных пользователей и небольших команд или это только enterprise?

- Масштабируемость: справится ли инструмент и с разовой задачей, и с крупными регулярными выгрузками?

- Целевая аудитория: решение для бизнес-пользователей, разработчиков или для обоих?

- Уникальные преимущества: чем инструмент выделяется среди остальных?

Я включил варианты для любого уровня — от «мне просто нужна таблица» до «хочу обойти весь интернет». Переходим к списку.

1. Thunderbit: AI Web Scraper для всех

Начну с инструмента, который знаю лучше всего — потому что мы с командой создавали его, чтобы закрыть именно те боли, с которыми годами сталкиваются бизнес-пользователи. — это не типичный скрейпер «перетащи-и-брось» и не «напиши свои селекторы». Это AI-ассистент по данным: ты описываешь, что хочешь получить, а дальше он делает всю тяжёлую работу — без кода, без возни с XPath и без слёз.

Почему Thunderbit — в топе

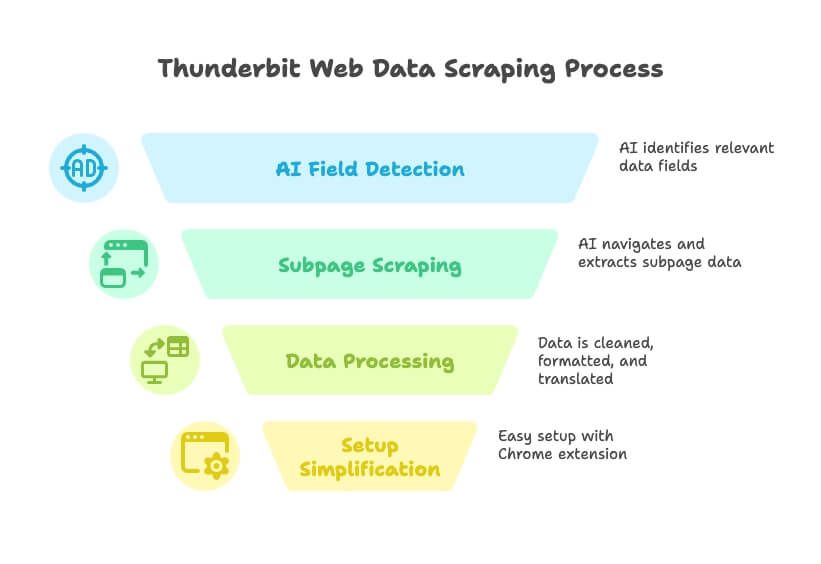

Thunderbit — это, пожалуй, самое близкое к идее «превратить любой сайт в базу данных», что я видел. Как это работает:

- Управление через обычный язык: просто скажи Thunderbit, какие данные нужны («хочу все названия компаний, email и телефоны из этого каталога»), и AI сам определит релевантные поля.

- AI Suggest Fields: одним кликом Thunderbit анализирует страницу и предлагает оптимальные колонки для извлечения — без гаданий и бесконечных попыток.

- Сбор с подстраниц и многоуровневый скрейпинг: нужны детали с подстраницы каждой карточки? Thunderbit зайдёт внутрь, заберёт дополнительные поля и добавит их в таблицу.

- Очистка, перевод и классификация данных: Thunderbit не просто вытаскивает «сырое» — он может чистить, форматировать, переводить и даже категоризировать поля прямо в процессе.

- Без головной боли на старте: установи , нажми «AI Suggest Fields» — и начнёшь собирать данные меньше чем за минуту.

- Бесплатный тест и низкая цена: щедрый бесплатный уровень (до 6 страниц бесплатно), платные тарифы — от $9/мес. Это меньше, чем я трачу на 커피 за неделю.

Thunderbit создан для команд продаж, маркетинга и операций, которым нужны данные — быстро. Никакого кода, плагинов и обучения. Это как стажёр по данным, который реально слушает и никогда не ноет.

Чем Thunderbit особенно выделяется

- AI-скрейпинг: AI понимает структуру страницы, подстраивается под изменения верстки и автоматически справляется с пагинацией и подстраницами ().

- Мгновенный экспорт: отправляй результат прямо в Excel, Google Sheets, Airtable, Notion или скачивай CSV/JSON.

- Запуск в облаке или локально: выполняй сбор в облаке для скорости и масштаба или в браузере, если нужно использовать твой логин/сессию.

- Scheduled Scraper: настраивай регулярные задания, чтобы данные всегда были актуальными — идеально для мониторинга цен или обновления лидов.

- Без обслуживания: AI Thunderbit адаптируется к изменениям сайтов, поэтому ты тратишь меньше времени на починку «сломанных» скрейперов ().

Для кого это? Для всех, кто хочет пройти путь от «мне нужны эти данные» до «вот ваша таблица» за минуты — особенно для нетехнических пользователей. С и рейтингом 4,9★ Thunderbit быстро становится выбором бизнес-команд, которым важен результат, а не головная боль.

Хочешь посмотреть вживую? Загляни на или изучи другие .

2. Clay: автоматическое обогащение данных + веб-скрейпинг

Clay — это «швейцарский нож» для growth-команд. Это не просто Web Scraper: скорее, это таблица-автоматизатор, которая подключается к 50+ живым источникам данных (например, Apollo, LinkedIn, Crunchbase) и использует встроенный AI, чтобы обогащать лиды, писать письма для аутрича и оценивать перспективность контактов.

- Автоматизация процессов: каждая строка — лид, каждый столбец может подтягивать данные или запускать действие. Хочешь собрать список компаний, обогатить профилями LinkedIn и отправить персонализированное письмо? Clay справится.

- Интеграция AI: использует GPT-4 для «айсбрейкеров», кратких резюме биографий и т. д.

- Интеграции: нативные подключения к HubSpot, Salesforce, Gmail, Slack и другим.

- Цена: примерно от $99/мес за профессиональный план, есть бесплатный пробный период для лёгких сценариев.

Лучше всего подходит для: outbound-продаж, growth-специалистов и маркетологов, которые хотят собрать кастомный лид-пайплайн, объединяя скрейпинг, обогащение и аутрич в одном месте. Инструмент мощный, но новичкам в автоматизации может быть непросто на старте ().

3. Bardeen: Web Scraper в браузере для автоматизации рабочих процессов

Bardeen — это как «робот в браузере», который умеет собирать данные и автоматизировать повторяющиеся веб-задачи — прямо из расширения Chrome.

- No-code автоматизация: более 500 «Playbooks» для скрейпинга, автозаполнения форм, переноса данных между приложениями и многого другого.

- AI Command Builder: опиши задачу обычными словами — Bardeen соберёт workflow.

- Интеграции: работает с Notion, Trello, Slack, Salesforce и 100+ другими приложениями.

- Цена: бесплатно для лёгкого использования (100 кредитов автоматизации/мес), платные планы — от $99/мес для команд.

Лучше всего подходит для: продвинутых пользователей и go-to-market команд, которым нужно автоматизировать и сбор данных, и последующие действия в разных приложениях. Гибкости много, но порог входа для новичков может быть выше ().

4. Bright Data: enterprise-уровень автоматизированного веб-скрейпинга

Bright Data (ранее Luminati) — это «тяжёлая техника» в мире веб-скрейпинга: глобальные прокси-сети, продвинутые API и возможность обходить тысячи страниц в день.

- Масштаб enterprise: более 100 млн IP, Web Scraper IDE, Web Unlocker для обхода антибот-защит.

- Гибкая настройка: можно строить сложные, крупномасштабные выгрузки с высокой надёжностью.

- Цена: от $499/мес за Web Scraper IDE, есть более компактные «micro» пакеты.

Лучше всего подходит для: крупных компаний, агрегаторов данных и опытных пользователей, которым нужны надёжные и масштабируемые решения. Если ты ежедневно обходишь тысячи страниц и важно избегать блокировок по IP, Bright Data создан для этого ().

5. Octoparse: визуальный Web Scraper для пользователей среднего уровня

Octoparse — популярный no-code инструмент с визуальным интерфейсом «укажи и кликни» — отличный вариант для тех, кому нужна мощность без программирования.

- Drag-and-drop интерфейс: кликай по элементам, задавай, что извлекать, работай с логинами, пагинацией и т. д.

- Шаблоны: 500+ готовых шаблонов для популярных сайтов (Amazon, Twitter и др.).

- Облачный скрейпинг: запуск задач на серверах Octoparse, расписание, ротация IP.

- Цена: есть бесплатный план с ограничениями; платные — от $119/мес.

Лучше всего подходит для: нетехнических пользователей и аналитиков, которым нужен функциональный скрейпер без кода. Хорош для мониторинга цен, карточек товаров и исследовательских задач ().

6. : платформа для сбора данных для бизнеса

— один из «старожилов» веб-скрейпинга, который со временем вырос в полноценную платформу извлечения данных.

- Извлечение point-and-click: поддерживает логины, выпадающие списки и интерактивные элементы.

- Облачная архитектура: параллельная обработка тысяч URL, расписание, доступ через API.

- Фокус на enterprise: используется для мониторинга цен, исследований рынка и подготовки датасетов для машинного обучения.

- Цена: Starter — $199/мес, Standard — $599/мес, Advanced — $1 099/мес.

Лучше всего подходит для: средних и крупных компаний и data-команд, которым нужны надёжные, поддерживаемые решения для больших объёмов. Для хобби-проектов может быть избыточно, но для бизнес-масштаба — очень мощно ().

7. Parsehub: гибкий Web Scraper с визуальным редактором

Parsehub — десктопное приложение (Windows, Mac, Linux), в котором ты «собираешь» скрейпер, кликая по интерфейсу сайта.

- Визуальный сценарий: выбирай элементы, задавай правила извлечения, работай с логинами, выпадающими списками и бесконечной прокруткой.

- Облачные функции: запуск в облаке, расписание, доступ через API.

- Цена: есть бесплатный уровень для небольших задач; платные планы — от $149/мес.

Лучше всего подходит для: исследователей, малого бизнеса и индивидуальных пользователей, которым нужно больше контроля, чем у расширений, но без написания собственного скрейпера ().

8. Common Crawl: открытые веб-данные для AI и исследований

Common Crawl — это не инструмент в привычном смысле, а огромный открытый датасет веб-краулинга, который обновляется ежемесячно.

- Масштаб: около 400 ТБ данных, миллиарды веб-страниц.

- Бесплатно и открыто: не нужно запускать собственный краулер.

- Нужны технические навыки: потребуются инструменты big data и инженерная подготовка, чтобы фильтровать и парсить данные.

Лучше всего подходит для: data scientists и инженеров, которые строят AI-модели или проводят исследования на больших объёмах. Если тебе нужен общий веб-текст или архивы за длительный период — это настоящая кладовая ().

9. Crawly: лёгкий инструмент автоматизированного веб-скрейпинга для стартапов

Crawly (от Diffbot) — облачный AI-краулер, который может собирать данные с миллионов сайтов и возвращать структурированный результат — без ручных правил парсинга.

- AI-извлечение: использует computer vision и NLP для распознавания и извлечения контента.

- Доступ через API: можно запрашивать собранные данные и интегрировать с аналитикой или базами данных.

- Цена: enterprise-уровень; стоимость по запросу.

Лучше всего подходит для: стартапов и команд с технической базой, которым нужно масштабное «умное» извлечение веб-данных без разработки собственных скрейперов ().

10. Apify: Web Scraper для разработчиков с маркетплейсом

Apify — облачная платформа, где можно создавать собственные скрейперы («Actors») или использовать библиотеку готовых решений от сообщества.

- Гибкость для разработчиков: поддержка JavaScript/Python, headless Chrome, управление прокси и расписание.

- Маркетплейс: большая библиотека готовых скрейперов для популярных сайтов.

- Цена: бесплатный уровень с кредитами на $5/мес; платные планы — от $49/мес.

Лучше всего подходит для: разработчиков и технически подкованных аналитиков, которым нужен полный контроль и масштабирование. При этом и нетехнические пользователи могут запускать готовые Actors для типовых задач ().

Сравнительная таблица инструментов автоматизированного веб-скрейпинга

| Инструмент | Простота использования | AI-функции | Цена (от) | Для кого | Уникальные преимущества |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | Обычный язык, AI Suggest Fields, сбор с подстраниц | $9/мес | Нетехнические бизнес-пользователи | Настройка в 2 клика, без кода, мгновенный экспорт, бесплатный тест |

| Clay | ★★★★☆ | AI-обогащение, GPT-4 | $99/мес | Growth/продажи ops | Таблица-автоматизатор, enrichment, аутрич |

| Bardeen | ★★★★☆ | Конструктор команд на AI | $99/мес | Power users, GTM-команды | Браузерная RPA, 500+ playbooks, глубокие интеграции |

| Bright Data | ★★☆☆☆ | Ротация прокси, антибот AI | $499/мес | Enterprise, разработчики | Масштаб, надёжность, глобальные прокси |

| Octoparse | ★★★★☆ | Визуальное AI-распознавание | $119/мес | Аналитики, нетехнические | Drag-and-drop, шаблоны, облачный скрейпинг |

| Import.io | ★★★☆☆ | Интерактивные экстракторы | $199/мес | Enterprise, data-команды | Параллельность, расписание, API, поддержка |

| Parsehub | ★★★★☆ | Визуальные сценарии | $149/мес | Исследователи, SMB | Десктоп-приложение, работа с динамическими сайтами |

| Common Crawl | ★☆☆☆☆ | N/A (только датасет) | Бесплатно | Data scientists, инженеры | Огромный открытый датасет, архивы веб-масштаба |

| Crawly | ★★☆☆☆ | AI-извлечение | Индивидуально/Enterprise | Стартапы, техкоманды | AI-краулер, без правил парсинга, доступ через API |

| Apify | ★★★★☆ | Маркетплейс Actors | $49/мес | Разработчики, теханалитики | Сборка/маркетплейс, облачная автоматизация, гибкость |

Как выбрать Web Scraper под ваши задачи

Выбор лучшего инструмента автоматизированного веб-скрейпинга зависит от размера команды, технических навыков и бизнес-целей. Вот короткий ориентир:

- Для нетехнических пользователей (продажи, маркетинг, ops): Выбирай . Он сделан именно для тебя — без кода, без настройки, только результат. Отлично подходит для лидогенерации, мониторинга цен и быстрых задач по данным.

- Для команд, которые живут автоматизацией: Clay и Bardeen особенно хороши, если ты хочешь объединить скрейпинг с обогащением, аутричем или автоматизацией процессов.

- Для enterprise и разработчиков: Bright Data, и Apify — лучшие варианты для масштабных и максимально настраиваемых проектов.

- Для исследователей и аналитиков: Octoparse и Parsehub дают визуальный интерфейс и мощные функции без необходимости писать код.

- Для AI и data science проектов: Common Crawl и Crawly предоставляют огромные датасеты и AI-извлечение для тех, кто хочет строить или обучать модели.

Спроси себя: тебе нужно начать за минуты или ты строишь кастомное enterprise-решение? Если сомневаешься — начни с бесплатного теста: он есть у большинства инструментов.

Уникальная ценность Thunderbit: AI-ассистент для бизнес-данных

Среди всех решений Thunderbit выделяется тем, что действительно работает как «AI-ассистент» для веб-скрейпинга и преобразования данных. Речь не только о том, чтобы «вытащить данные», — а о том, чтобы превратить хаотичные сайты в чистые, структурированные инсайты без технических барьеров.

- Интерфейс на обычном языке: опиши задачу простыми словами — Thunderbit сделает остальное.

- Автоматизация полного цикла: от извлечения до очистки, перевода и экспорта — весь процесс закрыт.

- Идеально для быстрых проверок гипотез: нужно оценить новый рынок, собрать список лидов или следить за конкурентами? Thunderbit — самый быстрый и недорогой старт.

Это как аналитик данных, встроенный в твой браузер — только он не просит повышения и не уходит в отпуск.

Итоги: выбирайте правильный инструмент автоматизированного веб-скрейпинга и начинайте умнее

Мир веб-скрейпинга в 2025 году стал больше, умнее и доступнее, чем когда-либо. Будь ты соло-фаундером, небольшой «боевой» командой продаж или data scientist в крупной компании — в этом списке найдётся инструмент под твои задачи. Главное — сопоставить ваш процесс и уровень навыков с подходящей платформой, чтобы перестать бороться с кодом и начать извлекать инсайты.

Если ты готов отказаться от ручного «копировать-вставить» и начать работать умнее, и убедись, насколько простым может быть веб-скрейпинг. Или выбери альтернативу выше — в зависимости от твоих целей. В любом случае будущее data-driven бизнеса за теми, кто автоматизирует.

Хочешь узнать больше? Загляни в — там есть подробные разборы, туториалы и советы, как выжать максимум из веб-данных. Удачного скрейпинга — и пусть твои данные всегда будут чистыми, а скрейперы не ломаются (а если и ломаются — пусть AI разрулит).

FAQs

1. Почему автоматизированные инструменты веб-скрейпинга важны для бизнес-пользователей в 2025 году?

Автоматизированные инструменты веб-скрейпинга упрощают сбор данных, экономят время и сокращают ручную работу. Они повышают точность данных, помогают принимать решения на основе актуальной информации и позволяют нетехническим командам извлекать и использовать веб-данные без написания кода. Сегодня такие инструменты критически важны для продаж, маркетинга и операционных функций.

2. Чем Thunderbit отличается от других инструментов веб-скрейпинга?

Thunderbit использует AI, чтобы пользователь мог описать нужные данные обычным языком. Он автоматически определяет поля, работает с подстраницами и пагинацией и мгновенно экспортирует результат в Excel и Airtable. Инструмент ориентирован на нетехнических пользователей и включает мощные функции — например, очистку данных и Scheduled Scraper — при доступной цене.

3. Какой инструмент лучше всего подходит для enterprise-проектов со скрейпингом в большом масштабе?

Bright Data и отлично подходят для enterprise. Они предлагают ротацию прокси, антибот-механизмы, параллельную обработку больших объёмов и доступ через API — то, что нужно организациям, которым важно надёжно обрабатывать тысячи страниц в масштабе.

4. Есть ли инструменты, которые совмещают скрейпинг с автоматизацией и аутричем?

Да. Clay и Bardeen не только собирают веб-данные, но и встраивают их в рабочие процессы. Clay обогащает лиды и автоматизирует аутрич, а Bardeen позволяет автоматизировать браузерные задачи и workflow с помощью AI-управляемых playbooks.

5. Какой вариант лучше всего для пользователей без технического бэкграунда?

Thunderbit — лучший выбор для нетехнических пользователей благодаря интерфейсу на обычном языке, AI-настройке и простоте использования. Он не требует кода и сложной подготовки и идеально подходит бизнес-пользователям, которым нужны быстрые и надёжные данные без технической сложности.