A internet virou um verdadeiro oceano de dados e, se você está tocando um negócio em 2025, já percebeu que quem consegue coletar as melhores informações, mais rápido, sai na frente da concorrência. Seja para vendas, e-commerce, operações ou pesquisa de mercado, a habilidade de puxar dados de sites — em grande escala e sob demanda — virou aquele trunfo silencioso que faz toda a diferença. O Python acabou se firmando como a linguagem queridinha dessa tarefa, com quase escolhendo ele por causa do ecossistema gigante de bibliotecas e pela fama de ser poderoso e fácil de usar.

Mas olha só: apesar do Python ser uma baita caixa de ferramentas para puxar dados de sites, ele não é a única alternativa. Ferramentas sem código como o estão democratizando o acesso à raspagem de dados, permitindo que qualquer pessoa — mesmo quem nunca programou — consiga raspar, limpar e organizar informações online em poucos cliques. Neste guia, vou te mostrar os dois caminhos: o método tradicional com Python (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) e como o Thunderbit pode turbinar sua produtividade. Vou trazer exemplos práticos, cenários de negócios e algumas lições que aprendi na prática. Bora lá!

O que significa "Python pull data from website"?

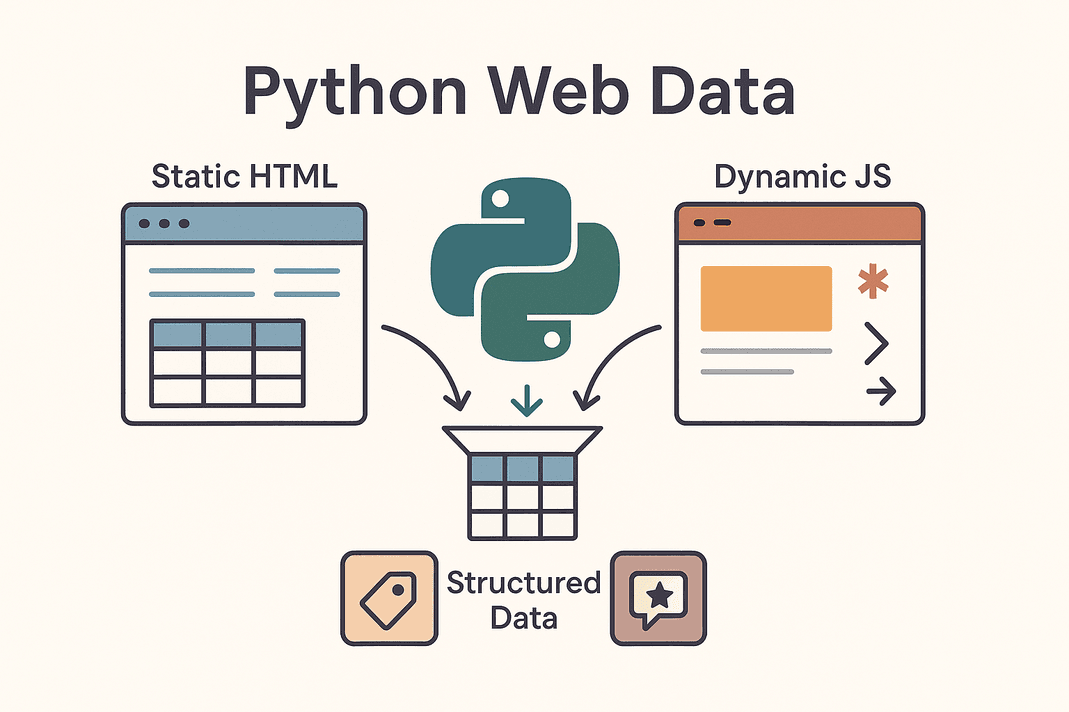

No fundo, "python pull data from website" quer dizer usar scripts em Python para buscar e extrair automaticamente informações de páginas web — transformando aquele HTML bagunçado em dados organizados, prontos para uso. Isso é o famoso web scraping. Em vez de ficar copiando e colando preços, contatos ou avaliações na mão, você deixa o Python fazer esse trabalho pesado.

No fundo, "python pull data from website" quer dizer usar scripts em Python para buscar e extrair automaticamente informações de páginas web — transformando aquele HTML bagunçado em dados organizados, prontos para uso. Isso é o famoso web scraping. Em vez de ficar copiando e colando preços, contatos ou avaliações na mão, você deixa o Python fazer esse trabalho pesado.

Você vai topar com dois tipos principais de sites:

- Sites estáticos: Todo o conteúdo já está no HTML inicial. O que aparece no "Ver código-fonte" é exatamente o que você vai extrair. Raspar esses sites é moleza: só buscar o HTML e analisar.

- Sites dinâmicos: Usam JavaScript para carregar dados depois que a página abre. Exemplos: rolagem infinita, preços mudando em tempo real ou conteúdo que só aparece depois de clicar em algo. Nesses casos, é preciso simular um navegador com ferramentas como Selenium ou achar as APIs escondidas que alimentam o site ().

Os alvos mais comuns de raspagem são tabelas de produtos, listas de leads, preços, avaliações, imagens e por aí vai. Seja para montar uma lista de clientes em potencial, monitorar preços da concorrência ou analisar opiniões do mercado, o Python transforma a web em um verdadeiro lago de dados para o seu negócio.

Por que empresas usam Python para extrair dados de sites?

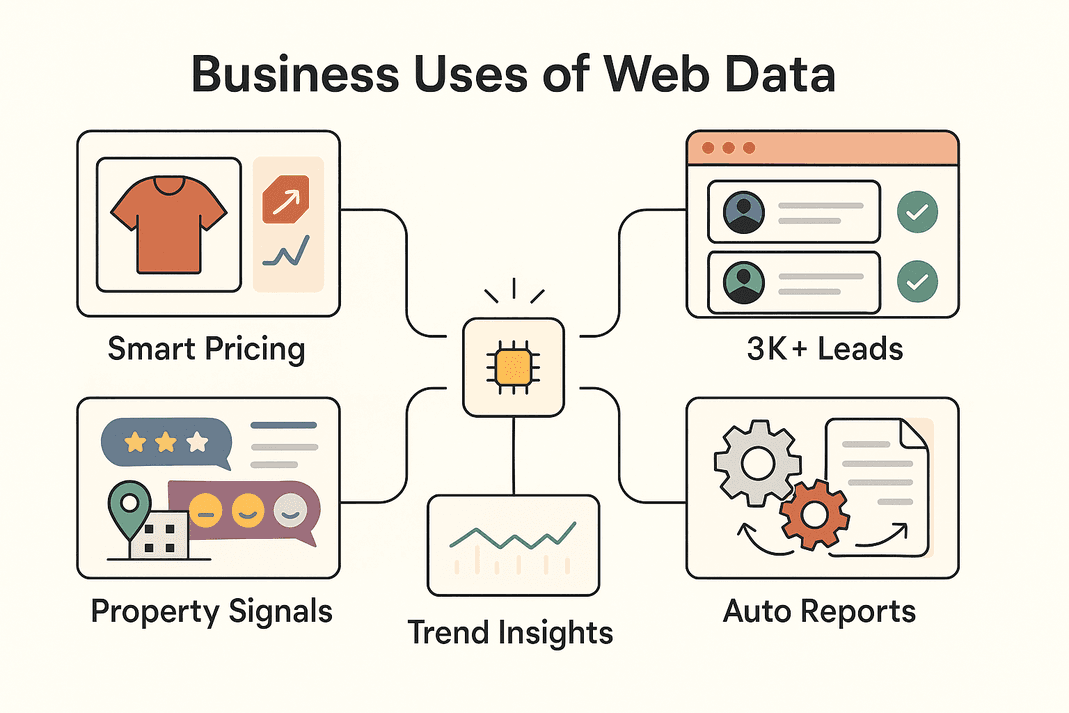

Vamos ao que interessa: por que tanta empresa está de olho em extrair dados da web? Olha só alguns dos principais usos e os benefícios que vêm junto:

| Cenário de Negócio | Dados Extraídos | ROI / Benefício |

|---|---|---|

| Geração de Leads (Vendas) | Contatos de diretórios, redes sociais | 3.000+ leads/mês, ~8 horas/semana economizadas por representante (Thunderbit)) |

| Monitoramento de Preços (E-commerce) | Preços de produtos, estoque | ~4% de aumento nas vendas, 30% menos tempo de análise (blog.apify.com) |

| Pesquisa de Mercado | Avaliações, posts em redes, comentários | Segmentação aprimorada; 26% dos scrapers focam em dados sociais (Thunderbit) |

| Imóveis | Dados de propriedades, comparativos, localização | Descoberta de oportunidades mais rápida, comps sempre atualizados |

| Automação Operacional | Inventário, relatórios, dados repetitivos | 10–50% de economia de tempo em tarefas manuais |

Resumindo: puxar dados da web com Python (ou Thunderbit) acelera processos, melhora decisões e automatiza tarefas repetitivas que antes tomavam horas. Não é à toa que o — e só cresce.

Ferramentas essenciais de Python para extração de dados de sites

O sucesso do Python na raspagem de dados vem do seu ecossistema. Dá uma olhada nas principais ferramentas e quando usar cada uma:

| Ferramenta | Melhor Para | Vantagens | Desvantagens |

|---|---|---|---|

| Requests | Buscar HTML estático ou APIs | Simples, rápido, ótimo para iniciantes | Não lida com JavaScript |

| Beautiful Soup | Analisar HTML/XML em dados estruturados | Fácil de usar, flexível | Precisa do HTML em mãos, não serve para sites JS |

| Selenium | Sites dinâmicos/pesados em JS, logins, cliques | Faz tudo que um navegador faz | Mais lento, exige mais configuração |

| Scrapy | Crawls em larga escala, múltiplas páginas | Rápido, assíncrono, robusto, escalável | Curva de aprendizado maior, não lida com JS por padrão |

| Thunderbit | Sem código/baixo código, usuários de negócios | IA integrada, lida com JS, exportação fácil | Menos customizável para lógicas avançadas |

Na prática, muita gente mistura ferramentas: Requests + Beautiful Soup para tarefas simples, Selenium para sites dinâmicos, Scrapy para grandes volumes e Thunderbit para agilidade e facilidade.

Passo 1: Usando Python Requests para buscar dados de sites

Começando pelo básico: Requests é o coringa para buscar páginas web em Python. Olha como é fácil usar:

-

Instale o Requests:

1pip install requests -

Busque uma página:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Falha ao obter dados: {response.status_code}")()

-

Dicas para resolver problemas:

- Adicione headers para simular um navegador:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Trate erros com

response.raise_for_status() - Para APIs que retornam JSON:

data = response.json()

- Adicione headers para simular um navegador:

Requests é perfeito para páginas estáticas ou APIs. Se você buscar uma página e os dados não aparecerem, provavelmente são carregados via JavaScript — aí é hora de usar o Selenium.

Passo 2: Extraindo conteúdo web com Beautiful Soup

Depois de pegar o HTML, o Beautiful Soup facilita a vida na hora de extrair os dados que interessam. Veja como funciona:

-

Instale o Beautiful Soup:

1pip install beautifulsoup4 -

Analise o HTML:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Extraia os dados:

- Encontre todos os cards de produtos:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Para tabelas:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Extraia os dados das células conforme necessário

- Encontre todos os cards de produtos:

Dicas:

- Use as ferramentas de desenvolvedor do navegador para achar os seletores certos.

- Use

.get_text()ou.textpara puxar textos. - Trate dados ausentes com verificações (

if price_elem else "N/A").

Requests + Beautiful Soup é a dupla clássica do web scraping — simples, confiável e ótima para sites estáticos.

Passo 3: Lidando com conteúdo dinâmico usando Selenium

Quando um site carrega dados via JavaScript, você precisa de uma ferramenta que simule um usuário de verdade. É aí que entra o Selenium.

-

Instale o Selenium:

1pip install seleniumBaixe o driver do navegador correspondente (ex: ChromeDriver) e coloque no PATH.

-

Automatize o navegador:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Faça login e clique em botões:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("meuusuario") 3driver.find_element_by_name("password").send_keys("minhasenha") 4driver.find_element_by_id("login-button").click() -

Espere pelo conteúdo dinâmico:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Modo headless (sem abrir janela):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

O Selenium é superpoderoso, mas mais pesado — ideal para sites que realmente exigem automação de navegador.

Passo 4: Escalando com Scrapy para grandes volumes de dados

Se você precisa raspar centenas ou milhares de páginas, o Scrapy é o parceiro certo.

-

Instale o Scrapy:

1pip install scrapy 2scrapy startproject myproject -

Crie um spider:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Execute o spider:

1scrapy crawl products -o products.csv

O Scrapy é assíncrono, rápido e feito para escala. Perfeito para varrer sites inteiros ou lidar com paginação complicada.

Passo 5: Potencializando a extração de dados com Thunderbit

Agora, vamos falar do — o raspador web IA sem código que está mudando o jogo para equipes de negócios.

- Sugestão de campos por IA: O Thunderbit lê a página e já sugere as melhores colunas para extrair — sem precisar fuçar no HTML.

- Lida com páginas dinâmicas: Ele enxerga a página como você, então JavaScript, rolagem infinita e logins não são problema.

- Raspagem de subpáginas: O Thunderbit pode clicar em cada item e enriquecer seu conjunto de dados automaticamente.

- Modelos prontos: Para sites populares como Amazon, Zillow ou Shopify, use templates prontos — sem dor de cabeça.

- Extratores com um clique: Precisa de todos os e-mails ou telefones de uma página? O Thunderbit faz isso na hora.

- Agendamento e raspagem na nuvem: Programe coletas recorrentes em linguagem natural ("toda segunda às 9h") e deixe a nuvem do Thunderbit cuidar de até 50 páginas por vez.

- Exportação para qualquer lugar: Jogue seus dados para Excel, Google Sheets, Airtable, Notion ou baixe como CSV/JSON — grátis e sem limites.

O Thunderbit é perfeito para equipes que precisam de dados para ontem, sem programação. Você pode até usar o Thunderbit para coletar dados e depois analisar no Python — o melhor dos dois mundos.

Passo 6: Limpando e analisando os dados extraídos com Pandas

Depois de coletar os dados (seja com Python ou Thunderbit), é hora de limpar e analisar usando o Pandas.

-

Carregue seus dados:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Limpe os dados:

- Remova duplicatas:

1df = df.drop_duplicates() - Trate valores ausentes:

1df = df.fillna("N/A") - Padronize formatos (ex: preços):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Remova duplicatas:

-

Analise:

- Veja estatísticas:

1print(df.describe()) - Agrupe por categoria:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Veja estatísticas:

O Pandas é a ferramenta ideal para transformar dados brutos da web em insights valiosos para o negócio.

Passo 7: Organizando e armazenando os dados extraídos para uso empresarial

Com os dados limpos, é hora de deixá-los prontos para o time usar.

- CSV/Excel: Use

df.to_csv("out.csv", index=False)oudf.to_excel("out.xlsx")para compartilhar rapidinho. - Google Sheets: Use a exportação do ou a biblioteca

gspreaddo Python. - Bancos de dados: Para grandes volumes, use

df.to_sql()para jogar em bancos SQL. - Automação: Programe scripts ou agendamentos no Thunderbit para manter os dados sempre atualizados.

- Boas práticas: Sempre registre a data dos dados, documente as colunas e controle o acesso se tiver informações sensíveis.

O segredo é adaptar o armazenamento ao jeito de trabalhar do seu time — planilhas para agilidade, bancos de dados para escala.

Thunderbit vs. Programação em Python: qual abordagem é melhor para sua equipe?

Vamos comparar:

| Fator | Thunderbit (IA sem código) | Bibliotecas Python (Código) |

|---|---|---|

| Conhecimento necessário | Nenhum (interface no navegador) | Precisa saber programar em Python |

| Tempo de configuração | Minutos (sugestões por IA, raspagem instantânea) | Horas ou dias (código, depuração, setup) |

| Lida com JS/Interatividade | Sim, nativo (modos navegador/nuvem) | Sim, mas exige Selenium/Playwright |

| Manutenção | Baixa — IA se adapta a muitas mudanças nos sites | Manual — precisa atualizar o código quando o site muda |

| Escalabilidade | Moderada (rápido para dezenas ou centenas de páginas via nuvem) | Alta (Scrapy escala para milhares+) |

| Customização | Via opções na interface e prompts de IA | Ilimitada (qualquer lógica, qualquer integração) |

| Anti-bot/Proxies | Gerenciado internamente | Precisa implementar manualmente |

| Exportação de dados | 1 clique para Sheets, Excel, Notion, Airtable | Precisa de código personalizado |

| Melhor para | Usuários não técnicos, resultados rápidos, pouca manutenção | Desenvolvedores, projetos complexos ou de grande porte |

Dica de quem já ralou muito: Use o Thunderbit para resultados rápidos e empodere sua equipe de negócios. Use Python quando precisar de personalização avançada ou grande escala. Muita gente faz o combo — Thunderbit para validar e puxar dados rápido, Python para automatizar ou escalar depois.

Aplicações reais de extração de dados de sites para negócios

Veja como as equipes estão usando essas ferramentas na vida real:

Veja como as equipes estão usando essas ferramentas na vida real:

- E-commerce: A John Lewis monitorando preços da concorrência e ajustando os próprios em tempo real.

- Vendas: Times coletam mais de 3.000 leads/mês, economizando 8 horas/semana por representante ()) — chega de pesquisa manual.

- Pesquisa de Mercado: Profissionais de marketing coletam milhares de avaliações ou posts para análise de sentimento, pegando tendências antes dos relatórios.

- Imóveis: Corretores raspam anúncios para achar imóveis abaixo do preço ou novas oportunidades — mais rápido que esperar atualização do MLS.

- Automação de Processos: Equipes de operações automatizam checagem de estoque, geração de relatórios ou até FAQs de suporte raspando sites parceiros ou internos.

Muitas vezes, o fluxo é misto: Thunderbit para coletar os dados, Python para limpar e analisar, e depois exportar para Sheets ou banco de dados para o time.

Conclusão & principais aprendizados

Extrair dados de sites com Python (e Thunderbit) é uma habilidade essencial para equipes modernas. Resumindo:

- Requests + Beautiful Soup: Ótimos para sites estáticos, rápidos e simples.

- Selenium: Para sites dinâmicos, pesados em JS ou que exigem login.

- Scrapy: Para grandes volumes e crawls em múltiplas páginas.

- Thunderbit: Para raspagem sem código, com IA — rápido, fácil e perfeito para negócios.

- Pandas: Para limpar, analisar e transformar dados em insights.

- Exporte com inteligência: Use CSV, Sheets ou bancos de dados — o que encaixar melhor no seu fluxo.

O melhor caminho? Comece com a ferramenta que combina com seu perfil técnico e as necessidades do negócio. Misture e evolua conforme crescer. E se quiser ver como a raspagem web pode ser simples, ou confira o para mais dicas.

Boas raspagens — e que seus dados estejam sempre limpos, organizados e prontos para ação.

Perguntas Frequentes

1. Qual a forma mais fácil de extrair dados de um site usando Python?

Para sites estáticos, use a biblioteca Requests para buscar o HTML e o Beautiful Soup para analisar e extrair os dados desejados. Para sites dinâmicos, provavelmente será necessário o Selenium.

2. Quando devo usar Thunderbit em vez de código Python?

O Thunderbit é ideal quando você precisa de dados rápido, não quer programar ou precisa lidar com páginas dinâmicas, subpáginas ou exportação instantânea para Sheets/Excel. Perfeito para usuários de negócios ou projetos com prazos apertados.

3. Como lidar com sites que carregam dados via JavaScript?

Use Selenium (ou Playwright) para automatizar um navegador, ou experimente o modo navegador/nuvem do Thunderbit, que lida com JS automaticamente.

4. Qual a melhor forma de limpar e analisar dados raspados?

Importe seus dados no Pandas, remova duplicatas, trate valores ausentes, padronize formatos e use groupby ou describe para obter insights rápidos.

5. Raspagem web é legal e segura para empresas?

No geral, raspar dados públicos é permitido, mas sempre confira os termos de uso do site e o robots.txt. Evite coletar dados pessoais sem consentimento e respeite os recursos do site. Tanto Thunderbit quanto Python apoiam práticas éticas de raspagem.

Pronto para dar um salto nos seus dados? ou coloque a mão na massa com Python — de qualquer jeito, você vai ter acesso a dados valiosos rapidinho.

Saiba mais