Vou ser bem direto: quando criei meu primeiro raspador web, parecia que tinha desbloqueado um superpoder escondido. De repente, todas aquelas horas copiando e colando dados de sites para listas de vendas ou pesquisas de preços ficaram no passado. Escrever seu próprio raspador web em Python é quase um rito de passagem para quem quer automatizar tarefas repetitivas online. E, se você trabalha com negócios, pode ser a diferença entre passar a sexta-feira brigando com planilhas ou curtindo o happy hour.

Neste tutorial, vou te mostrar como criar um raspador web com Python, trazendo exemplos de código práticos. Depois, explico por que, para a maioria das equipes de negócios, existe um caminho muito mais fácil: usar um que resolve tudo em dois cliques, sem precisar programar nada. Seja você fã de Python ou só queira os dados sem dor de cabeça, aqui tem a solução certa.

O que é Web Scraping com Python? Um Resumão

Vamos começar do começo. Web scraping nada mais é do que coletar informações automaticamente de sites. Imagina um estagiário robô fazendo todo o trabalho de copiar e colar pra você — só que ele nunca reclama nem pede aumento.

Um raspador web é um script ou programa que:

- Acessa uma página da web (igualzinho ao seu navegador)

- Puxa dados específicos (nomes de produtos, preços, contatos, etc.)

- Salva tudo de forma organizada (em planilhas ou arquivos JSON, por exemplo)

Python é a linguagem queridinha pra isso porque é fácil de entender, tem ótimas bibliotecas e é super versátil. Na real, .

O passo a passo básico é:

- Buscar a página (pegar o HTML)

- Analisar o HTML pra encontrar os dados que você quer

- Salvar os resultados em algum lugar útil

É tipo fazer um bolo: pega os ingredientes (HTML), separa o que interessa (dados) e serve (exporta).

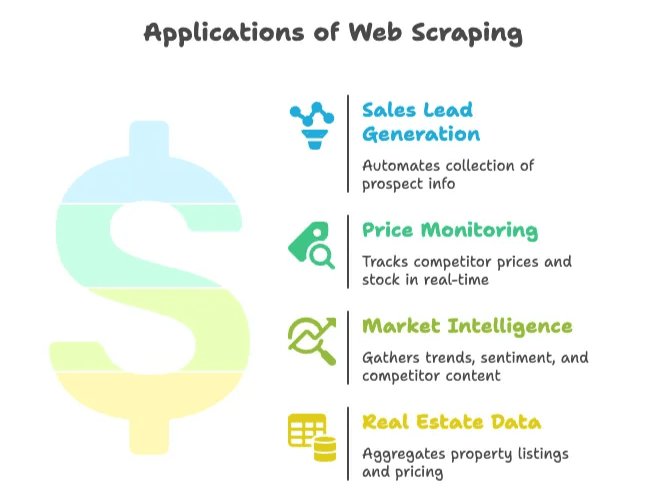

Por Que Web Scraping é Importante para Empresas

Web scraping não é só pra programador ou analista de dados. Hoje, é essencial pra vendas, marketing, e-commerce, imobiliárias e qualquer área que precise de dados atualizados pra tomar decisões. O e cresce 28% ao ano. É dado demais — e muita oportunidade.

Olha só alguns exemplos reais de uso nos negócios:

| Caso de Uso | Benefício | Resultado Exemplo |

|---|---|---|

| Geração de Leads de Vendas | Automatiza a coleta de contatos em diretórios ou redes sociais | Economia de ~8 horas/semana por vendedor; 3.000 leads/mês extraídos, crescimento de 10× nas vendas em 3 meses |

| Monitoramento de Preços | Acompanha preços e estoques de concorrentes em tempo real | Redução de 30% no tempo de coleta; aumento de 4% nas vendas com preços mais inteligentes |

| Inteligência de Mercado | Coleta tendências, sentimentos e conteúdos de concorrentes para análise | Mais de 70% das empresas usam dados extraídos da web para inteligência de mercado |

| Dados Imobiliários | Agrega anúncios e preços de imóveis de vários sites | Empresas extraem dados do Zillow/Trulia para acompanhar mudanças no mercado local |

Resumindo: web scraping economiza tempo, corta trabalho manual e te dá vantagem competitiva. Se você ainda tá no copiar e colar, seus concorrentes provavelmente já estão um passo à frente.

Preparando o Terreno: Ferramentas e Conhecimentos Necessários

Antes de partir pro código, confere o que você precisa ter em mãos.

O Básico

- Python Instalado: Baixe a versão mais recente () e garanta que consegue rodar

pythonno terminal. - Editor de Código: VS Code, PyCharm ou até o Notepad++ servem. Eu curto o VS Code pelo suporte ao Python.

- Ambiente Virtual: Não é obrigatório, mas ajuda a manter as dependências organizadas. Crie um com

python -m venv venv.

Principais Bibliotecas Python

- Requests: Pra buscar páginas web ().

- BeautifulSoup: Pra analisar HTML e encontrar elementos ().

- Selenium: Pra sites que carregam conteúdo via JavaScript ().

Instale tudo com:

1pip install requests beautifulsoup4 lxml seleniumEntendendo HTML

Você não precisa ser dev web, mas é importante saber inspecionar o HTML de uma página. Clique com o botão direito, escolha “Inspecionar” e veja a árvore DOM. É ali que estão as tags e classes que seu raspador vai buscar ().

Passo a Passo: Como Criar um Raspador Web com Python

Vamos botar a mão na massa e montar um raspador simples do zero. Vou usar um exemplo real — extraindo títulos de notícias ou produtos. Adapte pro seu caso.

Configurando o Ambiente Python

Primeiro, crie uma pasta pro projeto e um ambiente virtual:

1mkdir meu-raspador

2cd meu-raspador

3python -m venv venv

4# Ative o venv:

5# No Windows:

6venv\Scripts\activate

7# No macOS/Linux:

8source venv/bin/activateInstale as bibliotecas:

1pip install requests beautifulsoup4 lxmlCrie um arquivo chamado scraper.py e abra no editor.

Buscando e Analisando Páginas Web

Vamos buscar o HTML de um site. Neste exemplo, vou usar o (um clássico pra demonstração).

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Agora, analise o HTML com BeautifulSoup:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Deve exibir "Hacker News"Extraindo os Dados Desejados

Suponha que você queira pegar todos os títulos das notícias e seus links. Inspecionando a página, verá que cada título está em uma tag <a class="storylink">.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Se for extrair produtos, procure algo como <div class="product-item"> e extraia os campos internos. Exemplo genérico:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Salvando os Dados em CSV ou JSON

Agora, vamos salvar os dados pra usar de verdade.

Para CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])Para JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Abra o CSV no Excel ou o JSON em qualquer editor de texto — e pronto, você automatizou horas de trabalho manual.

Avançando: Lidando com Paginação e Conteúdo Dinâmico

A maioria dos sites reais não cabe em uma página só. Veja como lidar com situações mais complexas.

Paginação

Se o site usa paginação por URL (ex: ?page=2), basta fazer um loop pelos números de página:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Extraia os dados como antes()

Se o site usa botão “Próxima”, encontre o link e siga:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Extraia os dados

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneConteúdo Dinâmico (Carregado por JavaScript)

Se os dados não estão no HTML (ex: carregados via JavaScript), use Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Agora extraia os dados como antes()

O Selenium também pode clicar em botões “Carregar mais” ou rolar a página. Mas fica ligado: é mais lento e consome mais recursos que o Requests.

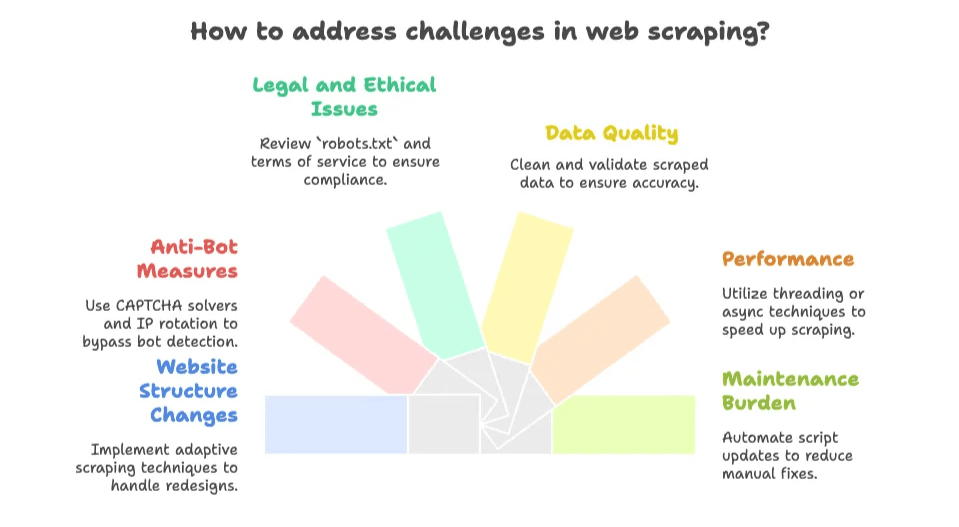

Principais Desafios ao Criar Seu Próprio Raspador Web

Aqui começa o jogo de verdade. Criar um raspador web é divertido — até o site mudar e seu script quebrar de madrugada antes de um prazo importante. Veja os problemas mais comuns:

- Mudanças na Estrutura do Site: Se o site muda o layout ou as classes, seu raspador pode parar de funcionar. Manutenção é constante ().

- Proteções Anti-bot: CAPTCHAs, limites de acesso e bloqueios de IP são comuns. .

- Questões Legais e Éticas: Sempre confira o

robots.txte os termos de uso do site. Dados públicos geralmente podem ser extraídos, mas evite conteúdos privados ou protegidos por direitos autorais (). - Qualidade dos Dados: Dados extraídos podem vir bagunçados. Às vezes é preciso limpar tags HTML, espaços ou textos quebrados.

- Performance: Extrair muitas páginas pode ser lento sem técnicas de threading ou async.

- Manutenção: Cada novo site ou mudança exige ajustes nos scripts. É um ciclo sem fim.

Se você curte desafios técnicos, isso faz parte da diversão. Mas se só quer os dados, pode virar dor de cabeça rapidinho.

A Alternativa Inteligente: Ferramentas de Raspador Web IA como o Thunderbit

Agora é hora de colocar o boné do Thunderbit (que, na minha cabeça, tem um raio estiloso). A maioria dos profissionais de negócios não quer programar nem ficar cuidando de script — só quer os dados, e rápido.

Por isso criamos o , uma que permite extrair dados de qualquer site, PDF ou imagem em dois cliques. Sem código, sem configuração, sem precisar entender de HTML.

O que Torna o Thunderbit Diferente?

- Configuração em 2 cliques: Abra a página, clique em “IA Sugerir Campos” e depois em “Raspar”. Pronto.

- Sugestão de Campos por IA: A IA do Thunderbit lê a página e sugere as melhores colunas (nome do produto, preço, avaliação, etc.).

- Raspagem de Subpáginas e Paginação: Segue automaticamente links “Próxima” ou entra em páginas de detalhes pra enriquecer seus dados.

- Exportação Instantânea: Exporte pra Excel, Google Sheets, Airtable, Notion, CSV ou JSON — grátis, sem complicação.

- Tipos de Dados Avançados: Extraia e-mails, telefones, imagens e até texto de PDFs ou imagens (graças ao OCR integrado).

- Raspagem na Nuvem ou no Navegador: Extraia até 50 páginas de uma vez na nuvem, ou use o navegador pra sites que exigem login.

- Sem Dor de Cabeça com Manutenção: A IA se adapta automaticamente a mudanças no layout, sem precisar mexer em script.

Comparativo Lado a Lado: Python vs. Thunderbit

| Aspecto | Raspador Python | Thunderbit (Raspador Web IA) |

|---|---|---|

| Tempo de Configuração | Horas para programar e depurar | Minutos — instale a extensão, clique e pronto |

| Habilidade Técnica | Alta (Python, HTML, CSS, depuração) | Baixa (apontar e clicar, sem código) |

| Manutenção | Você precisa ajustar sempre que o site muda | A IA do Thunderbit se adapta automaticamente |

| Paginação/Subpáginas | Precisa programar loops e lógica | Integrado, basta ativar a opção |

| Tipos de Dados | Básico por padrão; precisa programar para imagens, PDFs, e-mails, etc. | Extração em um clique para texto, imagens, e-mails, telefones, PDFs e mais |

| Escala & Velocidade | Limitado pelo seu código e recursos | Raspagem em nuvem de até 50 páginas; modo navegador para sites com login |

| Custo | Python é grátis, mas seu tempo não; infraestrutura e proxies podem custar caro | Plano gratuito disponível; planos pagos a partir de ~$16,5/mês para 30.000 créditos/ano (preços) |

| Flexibilidade & Controle | Máximo controle para lógica personalizada | Máxima praticidade para casos de uso padrão |

Pra maioria dos profissionais, o Thunderbit é o atalho pra conseguir dados estruturados sem complicação.

Quando Criar Seu Próprio Raspador Web ou Usar um Raspador Web IA?

Qual caminho é melhor pra você? Aqui vai minha opinião sincera:

Crie Seu Próprio Raspador Quando:

- Precisa de lógica muito personalizada (ex: login com 2FA, fluxos multi-etapas, integração profunda com seu sistema).

- Tem habilidade em programação e gosta de experimentar.

- O site é estável e você não se importa em manter scripts.

- Precisa integrar a raspagem em um sistema maior.

- Vai extrair dados protegidos por login ou não suportados por ferramentas IA.

Use um Raspador Web IA (Thunderbit) Quando:

- Não quer programar nem manter scripts.

- Precisa dos dados rápido (pra tarefas pontuais ou recorrentes).

- O site muda com frequência ou tem proteções anti-bot (Thunderbit cuida disso).

- Quer recursos prontos como OCR, extração de e-mail/telefone ou exportação direta pra suas ferramentas favoritas.

- Valoriza seu tempo e prefere focar na análise, não em depuração.

Checklist rápido:

- Os dados são públicos e não exigem login complicado? → Thunderbit é provavelmente a melhor escolha.

- É uma necessidade pontual ou ad-hoc? → Thunderbit.

- Precisa de personalização profunda ou integração? → Script Python.

- Tem um dev disponível e gosta de programar? → Script Python.

- Quer evitar dor de cabeça com manutenção? → Thunderbit.

Lembre: você pode começar com o Thunderbit pra resultados rápidos e, se precisar de algo mais avançado, investir em scripts personalizados depois.

Pra saber mais sobre como funcionam os raspadores web IA e quando usar, confira nosso .

Resumindo: Como o Web Scraping Pode Impulsionar Seu Negócio

Pra fechar:

- Web scraping com Python é poderoso e flexível, mas exige aprendizado e manutenção constante.

- Raspadores web IA como o Thunderbit tornam a extração de dados acessível pra todo mundo — sem código, sem configuração, só resultado.

- Pra maioria dos negócios, o caminho mais rápido é usar uma ferramenta IA, a não ser que precise de algo muito específico.

- A web é uma mina de ouro de dados, e a abordagem certa pode economizar horas (ou dias) de trabalho manual.

Perguntas Frequentes

1. O que é web scraping e por que Python é tão usado?

Web scraping é o processo automatizado de coletar dados de sites. Python é popular porque é fácil de ler, tem bibliotecas como requests, BeautifulSoup e Selenium, e facilita o trabalho com HTML.

2. Quais os principais usos de web scraping em negócios?

Empresas usam web scraping pra geração de leads, monitoramento de preços, inteligência de mercado e agregação de dados imobiliários. Isso automatiza tarefas repetitivas e traz insights atualizados pra decisões estratégicas.

3. Quais os maiores desafios ao criar seu próprio raspador web?

Os principais desafios são lidar com mudanças nos sites, proteções anti-bot como CAPTCHAs, questões legais e éticas, qualidade dos dados e a manutenção constante dos scripts.

4. Como o Raspador Web IA do Thunderbit se diferencia dos scripts Python tradicionais?

O Thunderbit oferece uma solução sem código, com sugestões de campos por IA, paginação automática e várias opções de exportação. Requer configuração mínima, se adapta automaticamente a mudanças nos sites e pode ser usado por quem não é dev — diferente dos scripts Python, que exigem programação e manutenção manual.

5. Quando usar um raspador IA como o Thunderbit em vez de programar o seu?

Use o Thunderbit se precisa de extração rápida e confiável sem programar, especialmente pra dados públicos ou tarefas pontuais. Opte por um script Python se precisa de controle total, integração profunda ou vai extrair dados complexos e protegidos por login.

Leituras Recomendadas:

Se quiser se aprofundar em web scraping, confira outros guias nossos:

E se quiser experimentar a forma mais fácil de extrair dados da web, e veja na prática. Suas noites de sexta (e seus dados) vão agradecer.