Se você já se viu diante de uma enxurrada de dados na internet e pensou em como transformar tudo isso em uma planilha (sem enlouquecer ou abrir mão do seu fim de semana), pode acreditar: não está sozinho nessa. Eu já passei por isso — café do lado, um monte de abas abertas no navegador e aquela certeza de que copiar e colar não vai dar conta do recado. Em 2025, a raspagem web virou item obrigatório para times de inteligência de negócios, vendas e operações — não é mais um “extra”, é essencial para decisões baseadas em dados. Só que, com tanta opção de ferramenta (de Raspador Web IA a biblioteca clássica em Python), escolher a certa pode ser tão complicado quanto decidir o sabor do sorvete numa sorveteria com 100 opções.

Vamos facilitar as coisas. Eu sou Shuai Guan, cofundador e CEO da , e já rodei bastante pelo universo SaaS, automação e IA — criando ferramentas, testando limites e, às vezes, quase derrubando a internet (no bom sentido). Este guia é meu resumo prático e sincero das 20 melhores ferramentas de raspagem web para 2025. Seja você alguém de negócios que quer dados em dois cliques, um dev que gosta de personalizar tudo, ou está no meio do caminho, vou te ajudar a achar a solução ideal — com dicas reais, um toque de humor e uma tabela comparativa fácil de entender.

Tabela Comparativa Rápida: As Melhores Ferramentas de Raspagem Web em 2025

Antes de entrar nos detalhes, dá uma olhada nesse panorama das 20 principais ferramentas de raspagem web, separadas por categoria. Use a tabela para comparar rapidinho recursos, preços, cenários ideais e avaliações dos usuários. (Spoiler: Se você quer o raspador web IA mais fácil, Thunderbit está no topo.)

Como usar a tabela:

- Ferramentas de Raspador Web IA são perfeitas para quem não manja de programação e quer automação e flexibilidade.

- Ferramentas No/Low Code têm interface visual para quem quer mais controle sem precisar programar.

- Ferramentas API são para equipes técnicas que precisam integrar a raspagem nos fluxos de trabalho.

- Bibliotecas Python são para devs que querem liberdade total e personalização.

| Nome da Ferramenta | Categoria | Principais Recursos | Preço (2025) | Indicado Para | Prós | Contras | Avaliações de Usuários (G2, Capterra, Trustpilot, Chrome Store) |

|---|---|---|---|---|---|---|---|

| Thunderbit | Raspador Web IA | Sugestão de campos por IA, raspagem de subpáginas, templates prontos, exportação gratuita, agendamento, navegador/nuvem | Gratuito (6 páginas), Pago a partir de $15/mês | Vendas, operações, não programadores | Configuração em 2 cliques, sem código, preciso, exportação grátis | Limite no plano gratuito, novo no G2/Capterra | Chrome Store ★4.9, Thunderbit Blog |

| Browse AI | Raspador Web IA | Gravador visual, robôs prontos, detecção de padrões por IA | Gratuito, Pago a partir de $19/mês | Não programadores, tarefas rápidas | Fácil de usar, assistido por IA, integrações | Personalização limitada, lento em grandes volumes | G2 ★4.8, Capterra ★4.5, Chrome Store ★4.7 |

| Bardeen AI | Raspador Web IA | Fluxos de automação, extensão de navegador, integrações | Gratuito, Pago a partir de $10/mês | Automação de fluxos | Automatiza tarefas repetitivas, integra com apps | Limitado para raspagens complexas | G2 ★4.7, Chrome Store ★4.8 |

| Diffbot | Raspador Web IA | Extração por visão computacional, knowledge graph, APIs | A partir de $299/mês | Empresas, big data | Sem código, robusto a mudanças, suporta JS | Alto custo, cobrança por uso | G2 ★4.9, Capterra ★4.5 |

| Zyte (IA) | Raspador Web IA | Extração com IA, anti-bot, proxy inteligente | Gratuito, Pago a partir de $29/mês | Desenvolvedores, empresas de dados | Confiável, proxy inteligente, ecossistema rico | Foco em devs, custos aumentam em escala | G2 ★4.3 |

| Octoparse | No/Low Code | Construtor visual, nuvem, suporte a login/paginação | Gratuito (10 tarefas), Pago a partir de $119/mês | Usuários não técnicos, grandes volumes | Fácil de usar, lida com sites complexos | Recursos avançados exigem aprendizado | G2 ★4.8, Capterra ★4.7, Trustpilot ★2.7 |

| Parsehub | No/Low Code | Editor visual, desktop/nuvem, agendamento | Gratuito (200 páginas/execução), Pago a partir de $189/mês | Analistas, jornalistas | Flexível, rotação de IP, multiplataforma | Execução local, suporte comercial | G2 ★4.3, Capterra ★4.5 |

| Webscraper.io | No/Low Code | Extensão Chrome, planos em nuvem, configuração de sitemap | Gratuito (extensão), Pago a partir de $50/mês | Hobbistas, pequenos volumes | Gratuito localmente, nuvem acessível | Só Chrome, limitado para tarefas avançadas | G2 ★4.7, Capterra ★4.4, Trustpilot ★4.4 |

| Data Miner | No/Low Code | Extensão de navegador, templates prontos | Gratuito, Pago a partir de $19/mês | Raspagens pequenas, tarefas rápidas | Templates, exportação fácil | Limitado para tarefas complexas | Chrome Store ★4.4 |

| Apify | API | Marketplace de atores, scripts customizados, agendamento | Gratuito, Pago a partir de $49/mês | Devs e não devs (via atores) | Flexível, escalável, muitas integrações | Precisa de código para customizar, UI complexa | G2 ★4.5, Capterra ★4.7 |

| ScrapingBee | API | API de navegador headless, renderização JS, rotação de proxy | Teste grátis, Pago a partir de $49/mês | Devs raspando sites JS | API simples, renderização confiável | Foco em devs, custos sobem em escala | G2 ★4.6 |

| ScraperAPI | API | Gerenciamento de proxy, resolução de CAPTCHA, API assíncrona | Gratuito (5k req), Pago a partir de $49/mês | Devs, escala, anti-bloqueio | Completo, alta taxa de sucesso, custo-benefício | Exige conhecimento técnico | G2 ★4.3, Capterra ★4.6, Trustpilot ★4.7 |

| Bright Data | API | IDE de raspagem, rede de proxies, datasets | Teste grátis, Pago a partir de ~$500/mês | Empresas, alto volume | Potente, compliance, suporte | Caro, curva de aprendizado | G2 ★4.5, Trustpilot ★4.3 |

| Oxylabs | API | Rede de proxies, entrega de dados, APIs | Pago a partir de $99/mês | Empresas, compliance | Alta taxa de sucesso, suporte, geolocalização | Caro, exige configuração técnica | G2 ★4.6 |

| Zyte (API) | API | Scrapy Cloud, proxy inteligente, extração automática | Gratuito, Pago a partir de $29/mês | Devs, empresas de dados | Confiável, integração Scrapy | Precisa de código, custos em escala | G2 ★4.3 |

| Selenium | Biblioteca Python | Automação de navegador, raspagem dinâmica | Gratuito | QA, devs, sites dinâmicos | Lida com qualquer site, comunidade grande | Lento, pesado, configuração trabalhosa | G2 ★4.5 (ferramenta de testes) |

| BeautifulSoup4 | Biblioteca Python | Parsing HTML/XML, API simples | Gratuito | Iniciantes, parsing rápido | Simples, robusto, flexível | Não suporta JS, não é crawler | G2 ★4.4 |

| Scrapy | Biblioteca Python | Crawling assíncrono, extensível, pipelines | Gratuito | Devs que precisam de crawlers customizados | Alta performance, personalizável | Curva de aprendizado íngreme | GitHub ★55k |

| Puppeteer | Biblioteca Python | Automação Chrome headless, raspagem JS | Gratuito | Devs, conteúdo dinâmico | Potente, moderno, screenshots | Foco em Node.js, uso de recursos | GitHub ★85k |

| Playwright | Biblioteca Python | Automação multi-navegador, API moderna | Gratuito | Devs, sites JS complexos | Rápido, multiplataforma, auto-wait | Exige código, uso de recursos | Comunidade dev ★4.8 |

Obs: As avaliações dos usuários são aproximadas e podem mudar. Para dados atualizados, consulte G2, Capterra, Trustpilot ou a Chrome Web Store.

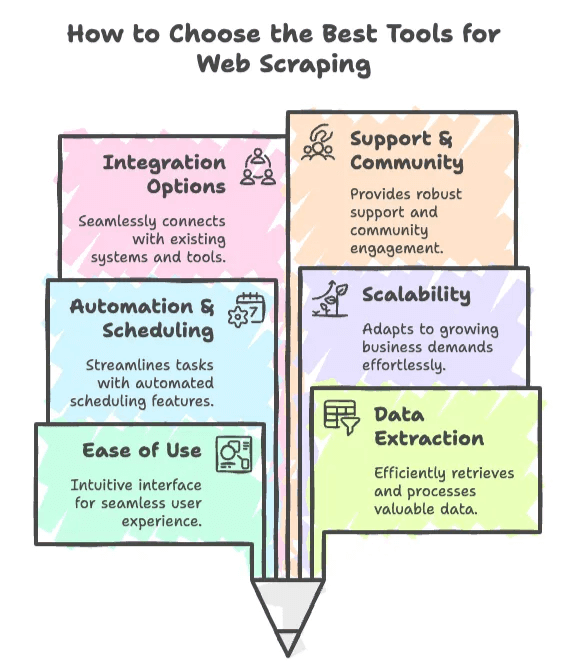

Como Escolher a Melhor Ferramenta de Raspagem Web

Vamos falar a real: escolher uma ferramenta de raspagem web é quase como procurar o par perfeito em app de namoro. Você quer algo confiável, fácil de lidar e — de preferência — que não te deixe na mão quando mais precisa. Veja os principais critérios que eu uso (e recomendo) para acertar na escolha:

1. Facilidade de Uso

- Raspadores Web IA (tipo Thunderbit ou Browse AI) são feitos para quem não programa. Se você quer sair do “preciso desses dados” para “tá aqui minha planilha” em menos de cinco minutos, começa por aqui.

- Ferramentas No/Low Code dão mais controle, mas pedem um pouco de aprendizado. Ótimas para quem quer mexer sem programar.

2. Capacidade de Extração de Dados

- Precisa raspar sites dinâmicos, cheios de JavaScript? Procure ferramentas com automação de navegador (Selenium, Playwright, ScrapingBee).

- Quer extrair listas, tabelas ou subpáginas? Ferramentas IA e visuais geralmente mandam bem nisso.

3. Automação e Agendamento

- Precisa de dados atualizados todo dia ou toda semana? Escolha uma ferramenta com agendamento integrado (Thunderbit, Octoparse, Apify).

- Para tarefas pontuais, uma extensão de navegador ou script simples já resolve.

4. Escalabilidade

- Vai raspar centenas de páginas? A maioria das ferramentas dá conta.

- Vai raspar milhões? Prefira APIs ou frameworks Python escaláveis (ScraperAPI, Bright Data, Scrapy).

5. Integrações

- Precisa mandar dados direto pro Google Sheets, Airtable ou banco de dados? Procure integrações nativas (Thunderbit, Simplescraper, Apify).

- Devs podem preferir APIs ou bibliotecas para fluxos customizados.

6. Suporte e Comunidade

- É novo em raspagem? Ferramentas com bom suporte e comunidade ativa (Octoparse, Apify, Thunderbit) ajudam muito.

- Para problemas mais avançados, bibliotecas open source como Scrapy e Selenium têm comunidades gigantes.

Dica de quem já apanhou:

Se seu foco é geração de leads, monitoramento de preços ou análise de concorrentes, comece com uma ferramenta IA ou no-code. Se você é dev ou tem equipe técnica, APIs e bibliotecas Python dão mais poder e flexibilidade.

Ferramentas de Raspador Web IA: O Futuro da Extração de Dados

Vamos falar das novidades: os raspadores web com IA. Essas ferramentas estão mudando o jogo para quem precisa de dados — chega de brigar com seletor CSS ou torcer pro scraper não quebrar quando o site muda. Raspadores IA usam machine learning e visão computacional para “enxergar” páginas como a gente, extraindo dados estruturados com quase nenhuma configuração.

Por que isso importa? Porque em 2025, mais de 65% das organizações usam raspagem web para alimentar modelos de IA/ML e inteligência de negócios (). Ferramentas IA são especialmente valiosas para equipes não técnicas — são rápidas, adaptáveis e quase não dão trabalho de manutenção.

1. Thunderbit: O Raspador Web IA Mais Simples para Negócios

Começando pelo meu xodó (sim, sou suspeito, mas com razão): .

Por que o Thunderbit é diferente?

- Sugestão de Campos por IA: Clique em “AI Suggest Fields” e o Thunderbit lê o site, sugerindo as melhores colunas e tipos de dados.

- Raspagem de Subpáginas: Quer mais detalhes? O IA do Thunderbit visita cada subpágina (tipo detalhes de produtos) e já preenche sua tabela.

- Templates Prontos: Para sites populares (Amazon, Zillow, Instagram, Shopify, etc.), use templates prontos — sem precisar configurar nada.

- Exportação Grátis: Exporte para Excel, Google Sheets, Airtable, Notion, CSV ou JSON — sem pegadinha.

- Raspagem Agendada: Descreva o agendamento em português; o IA faz o resto. Perfeito pra monitorar preços ou estoques.

- Navegador/Nuvem: Raspe com seu navegador (para sites logados) ou use a nuvem para mais velocidade (até 50 páginas de uma vez).

- Preenchimento Automático IA: Use IA para preencher formulários e automatizar fluxos — totalmente grátis.

- Extrator de E-mail, Telefone e Imagens: Extraia contatos ou imagens de qualquer site em um clique.

Pra quem é o Thunderbit?

- Equipes de vendas extraindo leads (e-mails, telefones, nomes)

- E-commerces monitorando preços e SKUs de concorrentes

- Corretores de imóveis acompanhando anúncios e valores

- Qualquer pessoa que quer dados web em 2 cliques, não 200

Preços

- Plano gratuito: raspe 6 páginas (linhas ilimitadas por página)

- Starter: $15/mês (500 créditos)

- Pro: $38–$249/mês (3.000–20.000 créditos)

O que o pessoal diz

- Chrome Store: ★4.9 (e subindo)

- Usuários elogiam a “configuração em 2 cliques” e “zero código”.

- Veja exemplos reais no .

Por que eu curto tanto

Sinceramente, criei o Thunderbit pra quem, como eu, quer analisar dados sem perder tempo com ferramenta. O agente IA se adapta quando o site muda, então você não precisa ficar ajustando o raspador. E a raspagem de subpáginas? É meu truque pra pegar dados ricos e organizados sem dor de cabeça.

2. Browse AI

O Browse AI é outro raspador web IA, sem código, que caiu no gosto de muita gente de negócios. Ele usa um “gravador de robô” visual: só clicar nos dados que você quer e o IA agrupa itens parecidos (tipo nomes de produtos ou preços), além de lidar com paginação e agendamento na nuvem.

Principais recursos

- Treinamento visual por apontar e clicar

- Robôs prontos para tarefas comuns

- Detecção de padrões IA para listas e tabelas

- Integrações com Google Sheets, Zapier, Slack e mais

Preços

- Plano gratuito disponível

- Planos pagos a partir de $19/mês

Indicado para

- Quem não é técnico e quer dados rápido

- Profissionais de marketing, vendas, pequenos negócios

Vantagens

- Muito fácil de usar

- Não exige código ou configuração

- Automação e integrações nativas

Desvantagens

- Personalização limitada para fluxos complexos

- Pode ser lento em grandes volumes

- Não é ideal para sites com bloqueio anti-bot

Avaliações

- G2: ★4.8

- Capterra: ★4.5

- Chrome Store: ★4.7

O Browse AI é ótimo pra quem quer transformar “preciso desses dados” em “tá aqui minha planilha” em minutos.

3. Bardeen AI

O Bardeen AI vai além da raspagem, integrando automação de fluxos de trabalho. É uma extensão de navegador que automatiza tarefas repetitivas, raspa dados e já manda direto pra apps como Google Sheets, Notion ou Airtable.

Principais recursos

- Fluxos de automação para raspagem e além

- Integra com dezenas de apps de negócios

- Pode acionar ações com base nos dados raspados

Preços

- Plano gratuito disponível

- Planos pagos a partir de $10/mês

Indicado para

- Equipes que querem automatizar tarefas web e extração de dados

Vantagens

- Potente para automação de fluxos multi-etapas

- Integrações profundas com ferramentas de negócios

Desvantagens

- Limitado para raspagens muito complexas

- Exige aprendizado para configurar fluxos

Avaliações

- G2: ★4.7

- Chrome Store: ★4.8

Se você quer que a raspagem seja só parte de uma automação maior, o Bardeen AI vale a pena.

4. Diffbot

O Diffbot é referência em raspagem web IA para empresas. Usa visão computacional e machine learning para extrair dados estruturados de praticamente qualquer página, alimentando um knowledge graph usado por grandes corporações.

Principais recursos

- Extração por visão computacional (lê como um humano)

- APIs para artigos, produtos, imagens e mais

- Suporta sites dinâmicos e com JavaScript

- Knowledge graph para vinculação de entidades

Preços

- A partir de $299/mês (250.000 créditos)

- Teste gratuito disponível

Indicado para

- Empresas, projetos de grande escala, times de machine learning

Vantagens

- Sem código, robusto a mudanças de layout

- Lida com conteúdo dinâmico e JS

- Escalável e confiável

Desvantagens

- Alto custo (não indicado para projetos pequenos)

- IA de caixa preta (pouca customização manual)

Avaliações

- G2: ★4.9

- Capterra: ★4.5

Se você precisa de um pipeline de dados crítico e de alto volume, o Diffbot é referência.

5. Instant Data Scraper

O Instant Data Scraper é uma ferramenta simples, baseada em navegador, criada pela WebRobots.io pra quem quer extrair dados rapidinho usando uma extensão Chrome. Ideal pra tarefas rápidas como raspar tabelas, listas e diretórios.

Principais recursos

- Sem código, detecta tabelas automaticamente

- Extensão Chrome para raspagem por clique

- Exportação instantânea para CSV/Excel

Preços

- Totalmente gratuito

Indicado para

- Quem não é técnico, raspagens rápidas, listas ou tabelas

Vantagens

- Configuração rápida, muito fácil de usar

- Não exige login ou cadastro

- Ótimo para páginas estruturadas

Desvantagens

- Sem automação ou nuvem

- Limitado para páginas complexas ou com JS

Avaliações

- Chrome Web Store: ★4.8 (10.000+ avaliações)

Ideal pra quem precisa extrair tabelas rapidinho e seguir em frente.

Ferramentas No/Low Code: Extração de Dados Sem Programação

Nem todo mundo quer (ou pode) programar. Ferramentas no/low code são perfeitas pra quem quer mais controle que as IA, mas sem precisar codar. Essas plataformas têm interface visual, agendamento e opções em nuvem.

6. Octoparse

O Octoparse é um dos raspadores visuais mais populares, conhecido pela interface intuitiva e capacidade de lidar com sites complexos (logins, paginação, scroll infinito).

Principais recursos

- Construtor visual com modos assistido e avançado

- Raspagem e agendamento em nuvem

- Suporta logins, formulários e conteúdo dinâmico

Preços

- Plano gratuito (10 tarefas)

- Pago a partir de $119/mês

Indicado para

- Quem não é técnico, grandes volumes, e-commerce, imóveis

Vantagens

- Muito fácil de usar

- Lida com cenários complexos

- Plano gratuito pra aprender

Desvantagens

- Recursos avançados exigem aprendizado

- Avaliação baixa no Trustpilot (suporte)

Avaliações

- G2: ★4.8

- Capterra: ★4.7

- Trustpilot: ★2.7

Se você quer uma experiência visual e guiada, o Octoparse é excelente.

7. Parsehub

O Parsehub é um raspador flexível, low-code, com app desktop e execução em nuvem. Muito usado por analistas e jornalistas pela flexibilidade.

Principais recursos

- Editor visual com lógica de script

- Opções desktop e nuvem

- Rotação de IP, paginação, navegação aninhada

Preços

- Plano gratuito (200 páginas/execução)

- Pago a partir de $189/mês

Indicado para

- Analistas, jornalistas, usuários avançados

Vantagens

- Potente e flexível

- App desktop multiplataforma

- Plano gratuito pra projetos pequenos

Desvantagens

- Execução local exige seu computador

- Suporte pode ser mais comercial

Avaliações

- G2: ★4.3

- Capterra: ★4.5

Ótimo pra quem quer mais controle sem programar tudo.

8. Webscraper.io

O Webscraper.io começou como uma extensão Chrome gratuita e agora oferece raspagem em nuvem. É queridinho de iniciantes e hobbistas.

Principais recursos

- Extensão Chrome para raspagem local

- Planos em nuvem para agendamento e escala

- Navegação baseada em sitemap

Preços

- Extensão gratuita

- Nuvem a partir de $50/mês

Indicado para

- Hobbistas, pesquisadores, pequenos negócios

Vantagens

- Gratuito pra raspagem local

- Planos em nuvem acessíveis

Desvantagens

- Só funciona no Chrome

- Limitado pra tarefas avançadas

Avaliações

- G2: ★4.7

- Capterra: ★4.4

- Trustpilot: ★4.4

Perfeito pra raspagens rápidas ou pra aprender.

9. Data Miner

O Data Miner é uma extensão de navegador baseada em templates, ideal pra raspagens pequenas e rápidas.

Principais recursos

- Extensão Chrome

- Templates prontos pra sites comuns

- Exportação fácil pra CSV, Excel

Preços

- Plano gratuito

- Pago a partir de $19/mês

Indicado para

- Raspagens rápidas e pequenas, quem não é técnico

Vantagens

- Templates agilizam a configuração

- Exportação fácil

Desvantagens

- Limitado pra tarefas grandes ou complexas

Avaliações

- Chrome Store: ★4.4

Ótimo pra raspagens pequenas e baseadas em templates.

Ferramentas API: Extração de Dados Escalável e Automatizada

Ferramentas baseadas em API são essenciais pra equipes técnicas que querem automatizar e escalar a extração de dados. Esses serviços cuidam de proxies, renderização e anti-bloqueio nos bastidores.

10. Apify

O Apify é uma plataforma completa de automação, com marketplace de “atores” (scrapers prontos) e APIs pra scripts customizados.

Principais recursos

- Marketplace de atores (scrapers prontos)

- Scripts customizados em Node.js/Python

- Agendamento, armazenamento, acesso via API

Preços

- Plano gratuito

- Pago a partir de $49/mês

Indicado para

- Devs e não devs (via atores), automação de fluxos

Vantagens

- Muito flexível e escalável

- Atores da comunidade economizam tempo

Desvantagens

- Precisa de código pra tarefas customizadas

- UI pode ser complexa em grandes projetos

Avaliações

- G2: ★4.5

- Capterra: ★4.7

Se busca flexibilidade e soluções da comunidade, o Apify é uma ótima escolha.

11. ScrapingBee

O ScrapingBee é uma API amigável pra devs, focada em sites dinâmicos com JavaScript usando Chrome headless.

Principais recursos

- API de navegador headless (Chromium)

- Renderização JS, rotação de proxy

- API de screenshots

Preços

- Teste gratuito

- Pago a partir de $49/mês

Indicado para

- Devs raspando sites dinâmicos e JS

Vantagens

- API simples, renderização confiável

- Boa documentação e suporte

Desvantagens

- Foco em devs, não pra quem não é técnico

- Custos aumentam em escala

Avaliações

- G2: ★4.6

Ótimo pra equipes técnicas que precisam raspar web apps modernos.

12. ScraperAPI

O ScraperAPI é uma API completa que gerencia proxies, renderização e anti-bloqueio.

Principais recursos

- Gerenciamento de proxy, resolução de CAPTCHA

- API assíncrona pra grandes volumes

- Endpoints estruturados pra sites comuns

Preços

- Gratuito (5k requisições)

- Pago a partir de $49/mês

Indicado para

- Devs, raspagem em larga escala, anti-bloqueio

Vantagens

- Alta taxa de sucesso, custo-benefício em escala

- Solução completa

Desvantagens

- Exige conhecimento técnico

- Parsing ainda necessário pra sites customizados

Avaliações

- G2: ★4.3

- Capterra: ★4.6

- Trustpilot: ★4.7

Ideal pra devs que querem focar nos dados, não na infraestrutura.

13. Bright Data Web Scraper API

O Bright Data é referência em proxies e agora oferece uma plataforma completa de raspagem com IDE e APIs prontas.

Principais recursos

- IDE de raspagem (visual/código)

- Maior rede de proxies (72M+ IPs)

- APIs de coleta de dados prontas

Preços

- Teste gratuito

- Pago a partir de ~$500/mês

Indicado para

- Empresas, alto volume, compliance

Vantagens

- Potente, escalável, recursos de compliance

- Suporte dedicado

Desvantagens

- Caro, curva de aprendizado pra IDE

Avaliações

- G2: ★4.5

- Trustpilot: ★4.3

Se você gerencia pipelines de dados corporativos, o Bright Data é referência.

14. Oxylabs

O Oxylabs oferece redes de proxies e APIs de raspagem pra empresas, com foco em confiabilidade e compliance.

Principais recursos

- Rede de proxies, APIs de entrega de dados

- Geolocalização, suporte a compliance

Preços

- Pago a partir de $99/mês

Indicado para

- Empresas, compliance, raspagem geolocalizada

Vantagens

- Alta taxa de sucesso, suporte, opções de geo

Desvantagens

- Caro, exige configuração técnica

Avaliações

- G2: ★4.6

Ótimo pra projetos grandes e com exigências de compliance.

15. Zyte (API)

As APIs do Zyte incluem Scrapy Cloud, proxy inteligente e extração automática pra conteúdos comuns.

Principais recursos

- Scrapy Cloud pra execução de spiders

- Proxy inteligente (Crawlera)

- APIs de extração automática

Preços

- Plano gratuito

- Pago a partir de $29/mês

Indicado para

- Devs, projetos customizados

Vantagens

- Confiável, integração com Scrapy

Desvantagens

- Exige código, custos em escala

Avaliações

- G2: ★4.3

Ideal pra equipes técnicas construindo crawlers em escala ().

Bibliotecas Python: Ferramentas para Desenvolvedores

Se você curte colocar a mão no código, as bibliotecas Python dão máxima flexibilidade e controle. São gratuitas, open source e têm comunidades enormes.

16. Selenium

O Selenium é o clássico da automação de navegador. Permite controlar Chrome, Firefox e outros pra raspar sites dinâmicos e com JavaScript.

Principais recursos

- Automação total do navegador (clique, scroll, formulários)

- Suporta JS, logins, scroll infinito

- Screenshots, suporte multi-navegador

Indicado para

- Times de QA, raspagem de sites dinâmicos, fluxos complexos

Vantagens

- Lida com quase qualquer site

- Comunidade grande, muitos tutoriais

Desvantagens

- Mais lento, pesado

- Configuração trabalhosa pra grandes volumes

Avaliações

- G2: ★4.5 (como ferramenta de testes)

Se precisa simular o comportamento real do usuário, o Selenium é ideal.

17. BeautifulSoup4

O BeautifulSoup4 é a biblioteca Python mais usada pra parsing de HTML e XML. Simples, tolerante e perfeita pra raspagens pequenas e médias.

Principais recursos

- API fácil pra parsing de HTML/XML

- Lida bem com HTML desorganizado

- Integra com requests, lxml

Indicado para

- Iniciantes, parsing rápido, limpeza de dados

Vantagens

- Simples, intuitivo, robusto

- Flexível com outras bibliotecas

Desvantagens

- Não suporta JS, não é crawler

Avaliações

- G2: ★4.4

Ótimo pra scripts rápidos e aprendizado.

18. Scrapy

O Scrapy é um framework Python de alta performance pra crawlers e raspadores escaláveis.

Principais recursos

- Crawling assíncrono (rápido e escalável)

- Extensível com pipelines e middlewares

- Comunidade e plugins robustos

Indicado para

- Devs criando crawlers customizados, grandes projetos

Vantagens

- Alta performance, personalizável

- Gratuito e open source

Desvantagens

- Curva de aprendizado íngreme

- Não renderiza JS nativamente (precisa Selenium ou Splash)

Avaliações

- GitHub: ★55k (scraper mais estrelado)

Se quer construir pipelines robustos e escaláveis, o Scrapy é o caminho.

19. Puppeteer

O Puppeteer é uma biblioteca Node.js (com wrappers Python) pra controlar o Chrome headless. Potente pra raspar conteúdo dinâmico e tirar screenshots.

Principais recursos

- Automação Chrome headless

- Screenshots, geração de PDF

- Interceptação de rede

Indicado para

- Devs raspando sites dinâmicos e JS

Vantagens

- Moderno, potente, flexível

Desvantagens

- Foco em Node.js, uso de recursos

Avaliações

- GitHub: ★85k

Perfeito pra raspagem avançada e automação de navegador.

20. Playwright

O Playwright é uma biblioteca moderna da Microsoft pra automação de navegadores, suportando múltiplos browsers e linguagens (incluindo Python).

Principais recursos

- Suporte multi-navegador (Chromium, Firefox, WebKit)

- Auto-wait, API assíncrona

- Screenshots, interceptação de rede

Indicado para

- Devs raspando sites JS complexos

Vantagens

- Rápido, confiável, multiplataforma

- API moderna, ótimo pra concorrência

Desvantagens

- Exige código, uso de recursos

Avaliações

- Comunidade dev: ★4.8

Se quer o que há de mais moderno em automação de navegador, o Playwright é destaque.

Qual Ferramenta de Raspagem Web é Melhor para Seu Negócio?

Veja um resumo pra combinar sua necessidade com a ferramenta ideal:

- Geração de Leads, Contatos: Thunderbit, Browse AI, Bardeen AI, Data Miner

- Monitoramento de Preços, E-commerce: Thunderbit, Octoparse, Parsehub, ScraperAPI, Bright Data

- Acompanhamento de Concorrentes, Pesquisa de Mercado: Thunderbit, Diffbot, Apify, Scrapy

- Imóveis: Thunderbit, Octoparse, Webscraper.io

- Automação de Fluxos: Bardeen AI, Apify, Thunderbit (Preenchimento Automático IA)

- Projetos Grandes e Customizados: Scrapy, Selenium, Playwright, APIs (ScraperAPI, Zyte, Bright Data)

Dica:

Teste os planos gratuitos ou demos antes de decidir. A maioria das ferramentas deixa você experimentar o fluxo e ver se atende suas necessidades.

Considerações Finais: Ferramentas de Raspagem Web em 2025

A raspagem web deixou de ser coisa de nicho pra dev e virou essencial pra qualquer negócio. Em 2025, 96% das empresas dizem que dados são centrais pra decisão (), e dados web são parte fundamental disso. O mercado de ferramentas de raspagem cresce a dois dígitos, impulsionado pela explosão da IA e pela busca por insights em tempo real ().

Raspadores IA como o Thunderbit estão facilitando a vida de quem não é técnico — tornando a extração de dados tão simples quanto clicar em um botão. Mas tem opção pra todo perfil, do no-code ao API e frameworks Python avançados.

O cenário muda rápido. Meu conselho? Fique de olho nas novidades, teste diferentes ferramentas e não tenha medo de misturar soluções. A melhor ferramenta de raspagem não é só sobre pegar dados — é sobre dar poder pro seu time decidir mais rápido, com mais inteligência e segurança.

Quer ver mais tutoriais, análises e dicas? Dá uma olhada no . E se quiser raspar dados de um jeito mais inteligente, experimenta o . Seu eu do futuro (e seu bolso do café) vão agradecer.

Perguntas Frequentes

1. Quais são as melhores ferramentas de raspagem web para quem não é técnico em 2025?

Pra quem não programa, raspadores IA como Thunderbit, Browse AI e Bardeen AI são as melhores opções. Não exigem código, têm interface visual e automatizam tarefas como paginação, navegação em subpáginas e exportação pra planilhas.

2. Quais ferramentas são mais indicadas para raspagem web em larga escala ou nível corporativo?

Pra projetos corporativos, Diffbot, Bright Data, Oxylabs e Scrapy se destacam. Suportam grandes volumes, automação avançada e lidam com sites dinâmicos e anti-bloqueio.

3. Como ferramentas no-code e low-code se comparam aos raspadores IA?

Ferramentas no/low-code como Octoparse, Parsehub e Webscraper.io oferecem mais customização que as IA, mas exigem algum aprendizado. Raspadores IA como Thunderbit focam em velocidade e simplicidade, usando machine learning pra automatizar seleção de campos e subpáginas.

4. Quais são as principais bibliotecas Python para desenvolvedores que querem controle total?

Pra quem prefere programar, Scrapy, Selenium, BeautifulSoup4, Puppeteer e Playwright são as melhores escolhas. Oferecem flexibilidade, performance e suporte da comunidade pra soluções customizadas.

5. Como empresas devem escolher a ferramenta de raspagem web ideal?

Depende do nível técnico, volume de dados e complexidade do projeto. Comece com IA pra velocidade e facilidade, use plataformas no-code pra média complexidade e opte por APIs ou Python pra escala e personalização. Testar planos gratuitos ou demos é sempre uma boa.

Saiba mais: