Powiem tak: niewiele rzeczy w cyfrowym świecie daje taką nieoczekiwaną satysfakcję jak schludna, kompletna lista każdej jednej podstrony w serwisie — trochę jak wtedy, gdy po praniu nagle znajdujesz wszystkie skarpety do pary. Ale jeśli kiedykolwiek robiłeś(-aś) pobieranie listy podstron do audytu treści, migracji albo po prostu po to, żeby sprawdzić, co siedzi w tej „cyfrowej piwnicy”, to wiesz, że rzadko bywa to tak proste, jak brzmi. Widziałem zespoły, które spędzały godziny (a czasem i dni) na sklejaniu list z map witryny, wyników Google i eksportów z CMS-a, żeby na końcu odkryć, że i tak brakuje im ukrytych albo dynamicznych stron. A gdy próbowałem pomóc znajomemu wyciągnąć wszystkie adresy URL z WordPressa… powiedzmy tylko, że było dużo kawy i odrobina egzystencjalnego niepokoju.

Dobra wiadomość? Nie musisz dalej bawić się w cyfrowe „chowanego” z własną stroną. W tym poradniku przeprowadzę Cię przez najważniejsze sposoby na wyszukiwanie adresów URL w witrynie — zarówno klasyczne, jak i nowoczesne — oraz pokażę, jak narzędzia oparte na AI, takie jak , potrafią zrobić to znacznie szybciej, dokładniej i (tak, serio) przyjemniej. Niezależnie od tego, czy jesteś marketerem, developerem, czy po prostu osobą, na którą spadło zadanie „zebrać wszystkie URL-e”, znajdziesz tu konkretne kroki, przykłady z życia i uczciwe porównania, które pomogą wybrać najlepszą metodę dla Twojego zespołu.

Dlaczego możesz potrzebować listy podstron: praktyczne zastosowania

Zanim przejdziemy do „jak”, pogadajmy o „po co”. Dlaczego tyle zespołów w ogóle musi robić wyszukiwanie adresów URL w witrynie? Okazuje się, że to nie tylko temat SEO — to powracająca potrzeba w marketingu, sprzedaży, IT i operacjach. Oto najczęstsze scenariusze:

- Audyty treści i strategia SEO: Audyty treści stały się standardem — . Pełna lista URL-i to fundament oceny wyników, aktualizacji starszych materiałów i poprawy pozycji. Co więcej, .

- Redesign i migracje serwisu: ), a każda migracja wymaga mapowania obecnych URL-i, by uniknąć błędów 404 i strat w SEO.

- Zgodność i utrzymanie: Zespoły operacyjne muszą namierzać osierocone lub przestarzałe strony — czasem dawne mikrowitryny kampanii, które nadal działają i tylko czekają, by kogoś skompromitować.

- Analiza konkurencji: Marketing i sprzedaż zbierają dane z witryn konkurentów, tworząc listy stron produktowych, cenników czy wpisów blogowych, by znaleźć luki lub leady.

- Generowanie leadów i outreach: Sprzedaż często potrzebuje list lokalizacji, katalogów dealerów czy stron członkowskich do działań prospectingowych.

- Inwentaryzacja treści: Content marketerzy prowadzą bieżącą listę wpisów, landingów, PDF-ów i innych zasobów, by unikać duplikacji i maksymalizować wartość.

Poniżej szybka tabela podsumowująca te przypadki:

| Scenariusz | Kto tego potrzebuje | Dlaczego kompletna lista stron ma znaczenie |

|---|---|---|

| Audyt SEO / audyt treści | Specjaliści SEO, content marketerzy | Ocena każdej treści; brakujące strony = niepełna analiza i utracone możliwości optymalizacji |

| Migracja / redesign strony | Web developerzy, SEO, IT, Marketing | Mapowanie starych i nowych URL-i, przekierowania, brak błędów i strat w SEO |

| Analiza konkurencji | Marketing, Sprzedaż | Wgląd we wszystkie podstrony konkurencji; ukryte strony mogą ujawnić szanse |

| Generowanie leadów | Zespoły sprzedaży | Zbieranie stron kontaktowych/zasobów do outreachu; żadna potencjalna szansa nie umyka |

| Inwentaryzacja treści | Content marketing | Aktualne repozytorium, identyfikacja luk, unikanie duplikacji i przegląd starych stron |

A konsekwencje pominięcia ukrytych stron? Jak najbardziej realne. Wyobraź sobie redesign, w którym zapominasz o ukrytym landingu, który nadal konwertuje, albo audyt, w którym brakuje 5% stron, bo nie są zindeksowane. To może oznaczać utracone przychody, problemy z SEO, a czasem kryzys wizerunkowy, którego nikt nie przewidział.

Najpopularniejsze sposoby na znalezienie URL-i: tradycyjne metody w praktyce

Przejdźmy do konkretów: jak w ogóle robi się pobieranie listy podstron? Jest kilka sprawdzonych metod — część jest szybka i „na skróty”, inne bardziej dokładne (i czasem bardziej bolesne). Oto jak to wygląda:

Wyszukiwanie w Google i operatory

Jak to działa:

Otwórz Google i wpisz site:twojadomena.pl. Google pokaże strony, które ma zindeksowane dla tej domeny. Możesz zawęzić wyniki słowami kluczowymi lub katalogami (np. site:twojadomena.pl/blog).

Co dostajesz:

Listę zindeksowanych stron — czyli to, co Google „wie” o Twojej witrynie.

Ograniczenia:

- Pokazuje tylko to, co jest w indeksie, a nie wszystko, co istnieje

- Zwykle kończy się po kilkuset wynikach, nawet dla dużych serwisów

- Pomija nowe, ukryte lub celowo niezindeksowane strony

Kiedy używać:

Świetne do szybkiego podglądu lub małych stron, ale nie do pełnego audytu.

robots.txt i sitemap.xml

Jak to działa:

Wejdź na twojadomena.pl/robots.txt i poszukaj linii „Sitemap:”. Otwórz mapę witryny (często twojadomena.pl/sitemap.xml lub /sitemap_index.xml). Sitemap zawiera URL-e, które właściciel chce indeksować.

Co dostajesz:

Listę kluczowych stron — często wszystkie wpisy blogowe, strony produktowe itd. .

Ograniczenia:

- Sitemap obejmuje tylko strony, które właściciel chce pokazać wyszukiwarkom — ukryte/osierocone często wypadają

- Może być nieaktualna, jeśli nie jest regularnie generowana

- Czasem istnieje wiele sitemap; trzeba je odnaleźć

Kiedy używać:

Idealne, gdy masz dostęp do własnej strony lub chcesz szybko podejrzeć główne sekcje konkurencji. Pamiętaj jednak: widzisz to, co właściciel chce ujawnić.

Narzędzia typu SEO Spider i crawlery

Jak to działa:

Narzędzia takie jak Screaming Frog, Sitebulb czy DeepCrawl działają jak robot wyszukiwarki. Podajesz URL, a narzędzie podąża za linkami wewnętrznymi i buduje listę znalezionych stron.

Co dostajesz:

Potencjalnie wszystkie strony, do których prowadzą linki w serwisie, plus dane typu kody statusu czy meta tagi.

Ograniczenia:

- Strony osierocone (bez linków) nie zostaną znalezione, jeśli nie dodasz ich ręcznie

- Strony generowane dynamicznie lub przez JavaScript mogą zostać pominięte, jeśli narzędzie nie wspiera renderowania

- Crawl dużych serwisów bywa długi i potrafi „zjeść” pamięć komputera

- Wymaga konfiguracji i technicznej wiedzy

Kiedy używać:

Dobre dla specjalistów SEO i developerów przy głębokich audytach. Mniej przyjazne dla osób nietechnicznych.

Google Search Console i Analytics

Jak to działa:

Jeśli masz dostęp do witryny, Google Search Console (GSC) i Analytics pozwalają eksportować listy URL-i.

- GSC: Raporty Index Coverage i Performance pokazują URL-e zindeksowane i wykluczone (do 1 000 na eksport, więcej przez API).

- Analytics: Pokazuje strony, które miały ruch w wybranym okresie (GA4 pozwala wyeksportować do 100 000 wierszy).

Ograniczenia:

- GSC i Analytics pokazują tylko strony znane Google lub takie, które miały ruch

- Limity eksportu (1 000 wierszy w GSC, 100k w GA4)

- Wymaga weryfikacji/własności; nie nadaje się do analizy konkurencji

- Strony bez ruchu lub niezindeksowane nie pojawią się

Kiedy używać:

Świetne dla własnej strony, zwłaszcza przed migracją lub audytem. Nie do researchu konkurencji.

Panele CMS

Jak to działa:

Jeśli strona działa na WordPressie, Shopify lub innym CMS, często da się wyeksportować listę stron i wpisów z panelu administracyjnego (czasem przez wtyczkę).

Co dostajesz:

Listę wszystkich wpisów treści: stron, postów, produktów itd.

Ograniczenia:

- Wymaga dostępu administratora

- Może nie obejmować stron nietreściowych lub dynamicznych

- Jeśli używasz kilku systemów (blog, sklep, dokumentacja), trzeba łączyć eksporty

Kiedy używać:

Najlepsze dla właścicieli strony przy inwentaryzacji treści lub backupie. Nie pomaga w analizie konkurencji.

Ograniczenia tradycyjnych metod zbierania listy podstron

Bądźmy szczerzy: żadna z tych metod nie jest idealna. Oto najczęstsze luki:

- Złożoność techniczna: Wiele podejść wymaga umiejętności technicznych lub specjalistycznych narzędzi. Dla osób nietechnicznych to realna bariera. Ręczny audyt treści może zająć .

- Niepełne pokrycie: Każda metoda może coś pominąć — indeks Google nie obejmuje wszystkiego, sitemap nie pokazuje osieroconych, crawlery nie widzą niepodlinkowanych lub dynamicznych, eksport z CMS nie obejmuje elementów poza systemem.

- Czas i ręczna robota: Często trzeba łączyć dane z wielu źródeł, usuwać duplikaty i czyścić listy — to żmudne i podatne na błędy. Ludzie wymyślają nawet „patenty” typu kopiuj-wklej z sitemap do Excela albo skrypty w terminalu.

- Aktualność: Listy szybko się dezaktualizują. Tradycyjne metody trzeba powtarzać przy każdej zmianie w serwisie.

- Dostęp i uprawnienia: Część metod wymaga uprawnień admina lub własności witryny — odpada przy analizie konkurencji.

- Nadmiar danych: Crawlery SEO potrafią zasypać technicznymi metrykami, gdy Tobie potrzebna jest po prostu lista URL-i.

W skrócie: tradycyjny proces przypomina „pieczenie ciasta, gdy przepis ciągle się zmienia, a piekarnik co jakiś czas blokuje dostęp”. (Tak, to prawdziwa analogia od stratega treści — i niestety bardzo trafna.)

Poznaj Thunderbit: sposób na URL-e napędzany AI

A teraz ciekawsza część. Co, jeśli mógłbyś(-abyś) po prostu poprosić asystenta: „przejdź po tej stronie i wypisz mi wszystkie podstrony”, a on faktycznie by to zrobił — bez kodu i bez kombinowania? Na tym polega .

Thunderbit to AI Web Scraper w formie rozszerzenia Chrome, zaprojektowany z myślą o osobach nietechnicznych (ale wystarczająco mocny dla profesjonalistów). Wykorzystuje AI do „czytania” stron, porządkowania danych i eksportu wszystkich URL-i — także tych ukrytych, dynamicznych i z podstron. Nie musisz pisać kodu ani grzebać w skomplikowanych ustawieniach. Wystarczy otworzyć stronę, kliknąć „AI Suggest Fields” i pozwolić Thunderbit zrobić resztę.

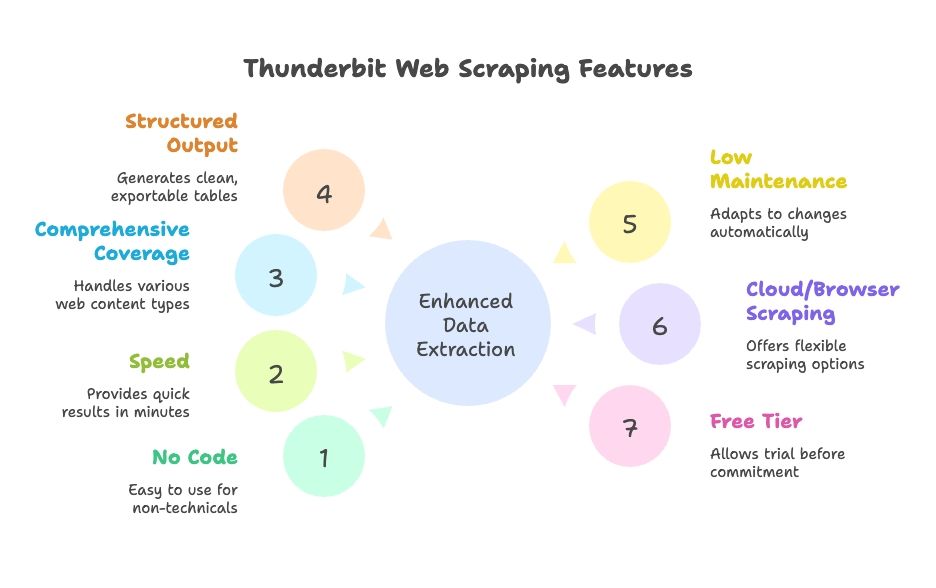

Co wyróżnia Thunderbit:

- Bez kodowania i konfiguracji: Interfejs w naturalnym języku, wspierany przez AI — każdy w zespole da radę.

- Szybkość: Wyniki w minuty, nie w godziny.

- Szerokie pokrycie: Obsługuje treści dynamiczne, paginację, infinite scroll i podstrony.

- Uporządkowany wynik: Czyste tabele gotowe do eksportu do Google Sheets, Excel, Airtable, Notion, CSV lub JSON.

- Mniej utrzymania: AI lepiej radzi sobie ze zmianami w serwisie; mniej ręcznego „dostrajania”.

- Scraping w chmurze lub w przeglądarce: Wybierasz, co pasuje do Twojego procesu.

- Dostępny plan darmowy: Możesz przetestować przed zakupem.

Jak Thunderbit upraszcza zbieranie listy podstron

Zobaczmy, jak to wygląda w praktyce. Pokażę Ci, jak przejść od „potrzebuję listy wszystkich podstron” do „oto arkusz, szefie” w kilka kliknięć.

Krok 1: Instalacja i uruchomienie Thunderbit

Pobierz i przypnij do paska przeglądarki. Wejdź na stronę, którą chcesz zebrać (np. stronę główną), a następnie kliknij ikonę Thunderbit, aby otworzyć panel.

Wskazówka: Thunderbit daje darmowe kredyty na start, więc możesz przetestować narzędzie bez sięgania po kartę.

Krok 2: Wybierz źródło danych

Domyślnie Thunderbit zbiera dane z bieżącej strony, ale możesz też wkleić listę URL-i (np. z mapy witryny lub stron kategorii), jeśli chcesz zacząć od konkretnej sekcji.

- Dla większości serwisów zacznij od strony głównej lub strony z sitemapą.

- Dla e-commerce sensowny start to kategoria lub lista produktów.

Krok 3: Użyj „AI Suggest Fields”, aby wykryć URL-e

Tu dzieje się magia. Kliknij „AI Suggest Fields” (lub „AI Suggest Columns”). AI Thunderbit skanuje stronę, rozpoznaje wzorce i proponuje kolumny typu „Page Title” i „Page URL” dla znalezionych linków. W razie potrzeby możesz je dopasować.

- Na stronie głównej zobaczysz linki z nawigacji, stopki i sekcji wyróżnionych.

- Na stronie z sitemapą dostaniesz czystą listę URL-i.

- Możesz dodawać/usuwać kolumny i doprecyzować, co ma zostać wyciągnięte.

AI wykonuje najtrudniejszą część — bez XPathów i selektorów CSS. To jak stażysta-robot, który naprawdę rozumie, o co prosisz.

Krok 4: Włącz zbieranie z podstron (Subpage Scraping)

Większość serwisów nie pokazuje wszystkich podstron na homepage. Dlatego przydaje się funkcja Subpage Scraping. Oznacz kolumnę z URL jako link „follow”, a Thunderbit będzie przechodzić po każdym linku i zbierać kolejne URL-e z tych stron. Możesz też ustawić zagnieżdżone szablony do wielopoziomowego zbierania.

- Dla list stronicowanych lub przycisków „load more” włącz Pagination & Scrolling, aby Thunderbit kontynuował aż do zebrania całości.

- Dla serwisów z subdomenami lub sekcjami (np. blog na ) Thunderbit też może za nimi podążać, jeśli go do tego skierujesz.

Krok 5: Uruchom scraping

Kliknij „Scrape” i obserwuj, jak Thunderbit działa. Tabela będzie wypełniać się URL-ami (i innymi wybranymi polami) w czasie rzeczywistym. Przy większych serwisach możesz zostawić proces w tle i wrócić później.

Krok 6: Sprawdź i wyeksportuj

Po zakończeniu przejrzyj wyniki — Thunderbit pozwala sortować, filtrować i usuwać duplikaty bezpośrednio w aplikacji. Następnie wyeksportuj dane jednym kliknięciem do Google Sheets, Excel, CSV, Airtable, Notion lub JSON. Koniec z kopiowaniem i bałaganem w formatowaniu.

Ile to trwa? Dla małej lub średniej strony: od zera do pełnej listy URL-i w mniej niż 10 minut. Dla dużych serwisów nadal jest to nieporównywalnie szybciej (i spokojniej) niż składanie listy z kilku źródeł.

Wykrywanie ukrytych i dynamicznych stron z Thunderbit

Jedna z moich ulubionych rzeczy w Thunderbit to to, jak radzi sobie z elementami, które tradycyjne narzędzia często pomijają:

- Treści renderowane przez JavaScript: Ponieważ Thunderbit działa w prawdziwej przeglądarce, potrafi przechwycić strony ładowane dynamicznie (np. tablice ofert pracy z infinite scroll czy listy produktów).

- Strony osierocone / bez linków: Jeśli masz trop (np. sitemapę lub wyszukiwarkę na stronie), Thunderbit może pomóc znaleźć strony, które nigdzie nie są podlinkowane.

- Subdomeny i sekcje: W razie potrzeby Thunderbit może podążać za linkami między subdomenami, dając pełny obraz serwisu.

- Interakcje jak użytkownik: Trzeba wpisać coś w wyszukiwarkę albo kliknąć filtr, by odsłonić ukryte strony? Z tym też poradzi sobie AI Autofill.

Przykład z życia: Zespół marketingu musiał znaleźć wszystkie stare landing page’e — wiele z nich nie było nigdzie podlinkowanych, ale nadal istniały. Dzięki zebraniu wyników wyszukiwania Google w Thunderbit i wykorzystaniu znanych wzorców URL odkryli dziesiątki zapomnianych stron, oszczędzając firmie zamieszania (i kilku bólów głowy).

Thunderbit vs. tradycyjne metody: szybkość, prostota i pokrycie

Zestawmy Thunderbit z klasycznymi podejściami:

| Aspekt | Wyszukiwanie Google „site:” | Mapa witryny XML | Crawler SEO (Screaming Frog) | Google Search Console | Eksport z CMS | Thunderbit AI Scraper |

|---|---|---|---|---|---|---|

| Szybkość | Bardzo szybko, ale ograniczone | Natychmiast, jeśli dostępne | Różnie (minuty do godzin) | Szybko dla małych stron | Natychmiast dla małych stron | Szybko: konfiguracja w minuty, scraping automatyczny |

| Łatwość użycia | Bardzo proste | Proste | Średnie (wymaga ustawień) | Średnie | Proste (jeśli masz admina) | Bardzo proste, bez kodu |

| Pokrycie | Niskie (tylko indeks) | Wysokie dla „zamierzonych” stron | Wysokie dla podlinkowanych | Wysokie dla zindeksowanych, ale limity eksportu | Średnie (tylko treści) | Bardzo wysokie: dynamiczne treści i podstrony |

| Wynik i integracje | Ręczne kopiowanie | XML (trzeba parsować) | CSV z dużą ilością danych pobocznych | CSV/Excel, do 1 000 wierszy | CSV/XML, często wymaga czyszczenia | Czysta tabela, eksport 1 klik do Sheets, Excel itd. |

| Utrzymanie | Ręczne powtarzanie | Wymaga aktualizacji | Ponowny crawl po zmianach | Okresowy eksport | Eksport po zmianach | Niskie: AI się adaptuje, można planować scraping |

Thunderbit wygrywa prostotą, kompletnością i integracjami. Tradycyjne metody mają swoje mocne strony, ale zwykle wymagają więcej pracy, by połączyć wyniki i utrzymać je aktualne. AI w Thunderbit lepiej znosi zmiany w serwisie, więc nie musisz ciągle poprawiać ustawień ani robić ręcznych eksportów.

Jak wybrać właściwe podejście: kto powinien używać czego?

Która metoda będzie najlepsza? Oto moja perspektywa po latach pomagania zespołom ogarniać dane ze stron:

- Specjaliści SEO / developerzy: Jeśli potrzebujesz głębokich danych technicznych (meta tagi, błędy linków itd.) albo audytujesz ogromny serwis enterprise, crawler lub własny skrypt nadal mogą mieć sens. Ale nawet wtedy Thunderbit świetnie sprawdza się jako szybkie źródło listy URL-i do dalszych narzędzi.

- Marketerzy, stratedzy treści, PM-owie: Thunderbit to wybawienie. Koniec z czekaniem, aż IT uruchomi skrypt lub poskleja eksporty. Do inwentaryzacji treści, analizy konkurencji czy szybkiego audytu — możesz działać samodzielnie.

- Sprzedaż / lead gen: Thunderbit ułatwia wyciąganie list lokalizacji, stron wydarzeń czy katalogów członków z dowolnej witryny — bez kodowania.

- Małe strony / szybkie zadania: Dla małych serwisów ręczne sprawdzenie lub sitemap może wystarczyć. Ale konfiguracja Thunderbit jest tak szybka, że często i tak warto, by niczego nie pominąć.

- Budżet: Tradycyjne metody są tanie (poza Twoim czasem). Thunderbit ma darmowy plan, a płatne są zwykle osiągalne dla firm. Pamiętaj: czas też kosztuje.

- Bardzo niestandardowe potrzeby: Jeśli potrzebujesz specyficznych danych lub złożonej logiki, własny scraper może być konieczny. Jednak AI Thunderbit ogarnia większość przypadków przy minimalnej konfiguracji.

Wskazówki decyzyjne:

- Jeśli masz dostęp do witryny i mniej niż 1 000 stron, spróbuj eksportu z Google Search Console — ale sprawdź kompletność.

- Jeśli nie masz dostępu do strony lub potrzebujesz danych o konkurencji, Thunderbit albo crawler będą najlepsze.

- Jeśli cenisz czas i chcesz rozwiązania, które skaluje się bez bólu, Thunderbit trudno przebić.

- Do pracy zespołowej duży plus to bezpośredni eksport do Google Sheets.

Wiele organizacji działa hybrydowo: Thunderbit do szybkich zadań i dla osób nietechnicznych, a tradycyjne narzędzia do głębokich audytów.

Najważniejsze wnioski: lista podstron dla każdej potrzeby biznesowej

Podsumujmy:

- Kompletna lista podstron jest kluczowa dla SEO, strategii treści, migracji i researchu sprzedażowego. Chroni przed niespodziankami, błędami linków i utraconymi szansami. Większość marketerów robi audyty treści co najmniej raz w roku ().

- Tradycyjne metody istnieją, ale każda ma braki. Żadne pojedyncze podejście nie gwarantuje pełnej, aktualnej listy. Często wymagają też umiejętności technicznych i łączenia wyników.

- web scraping oparty na AI (Thunderbit) to nowoczesna alternatywa. Thunderbit wykorzystuje AI do „myślenia” i klikania za Ciebie, dzięki czemu web scraping staje się dostępny dla każdego. Obsługuje treści dynamiczne, podstrony i eksportuje dane w formacie gotowym do użycia — oszczędza czas i zmniejsza liczbę błędów. W porównaniach 1:1 Thunderbit często robi w kilka minut to, co wcześniej zajmowało godziny, i to bez stromej krzywej nauki ().

- Dobierz metodę do potrzeb i zespołu. Przy ogromnych serwisach warto używać całego zestawu narzędzi, ale dla większości użytkowników biznesowych Thunderbit sam w sobie będzie najlepszym wyborem.

- Dbaj o aktualność. Regularne audyty pozwalają wcześnie wyłapać problemy i utrzymać stronę „szczupłą” oraz skuteczną. Harmonogram w Thunderbit ułatwia to w praktyce, podczas gdy ręczne procesy często są odkładane przez nakład pracy.

Na koniec: Koniec z wymówkami, że nie wiesz, co jest na Twojej stronie (albo na stronie konkurencji). Przy właściwym podejściu zbudujesz pełną listę podstron i wykorzystasz ją do poprawy SEO, UX i strategii biznesowej. Pracuj mądrzej, nie ciężej — niech AI zrobi najtrudniejszą część, a żadna strona nie zostanie pominięta.

Co dalej

Jeśli chcesz przestać odkładać zadanie „zbierz mi wszystkie URL-e”, i przetestuj na swojej stronie albo u konkurencji. Zdziwisz się, ile czasu (i nerwów) oszczędzisz. A jeśli chcesz wejść głębiej w web scraping, zajrzyj do innych poradników na , np. lub .

FAQ

1. Po co w ogóle potrzebna jest lista wszystkich podstron w witrynie?

Zespoły SEO, marketingu, sprzedaży i IT regularnie potrzebują pełnej listy URL-i do audytów treści, migracji, generowania leadów czy analizy konkurencji. Kompletna i poprawna lista pomaga uniknąć błędów linków, zapobiega duplikacji lub „zapomnieniu” treści oraz ujawnia ukryte możliwości.

2. Jakie są tradycyjne sposoby na znalezienie wszystkich URL-i w witrynie?

Najczęściej używa się wyszukiwania site: w Google, sprawdza pliki sitemap.xml i robots.txt, wykonuje crawl narzędziami SEO typu Screaming Frog, eksportuje dane z CMS-ów (np. WordPress) oraz pobiera listy stron zindeksowanych lub z ruchem z Google Search Console i Analytics. Każda z tych metod ma jednak ograniczenia w zakresie pokrycia i wygody.

3. Jakie są ograniczenia tradycyjnych metod wyszukiwania URL-i?

Klasyczne podejścia często pomijają strony dynamiczne, osierocone lub niezindeksowane. Wymagają wiedzy technicznej, a łączenie i czyszczenie danych potrafi zająć godziny. Zwykle słabo skalują się dla dużych serwisów i cyklicznych audytów. Często potrzebujesz też własności witryny lub dostępu admina, co nie zawsze jest możliwe.

4. Jak Thunderbit upraszcza znajdowanie wszystkich podstron?

Thunderbit to narzędzie do web scrapingu oparte na AI, które „ogląda” strony jak człowiek — przechodzi po podstronach, radzi sobie z JavaScriptem i automatycznie porządkuje dane. Nie wymaga kodowania, działa jako rozszerzenie Chrome i w kilka minut eksportuje czyste listy URL-i do Google Sheets, Excel, CSV i innych formatów.

5. Kto powinien wybrać Thunderbit, a kto tradycyjne narzędzia?

Thunderbit najlepiej sprawdza się u marketerów, strategów treści, zespołów sprzedaży i osób nietechnicznych, które chcą szybko i bezproblemowo uzyskać kompletną listę URL-i. Tradycyjne narzędzia są lepsze do audytów stricte technicznych, gdzie potrzebujesz głębokich metadanych lub własnych skryptów. Wiele zespołów łączy oba podejścia: Thunderbit dla szybkości i wygody, a klasyczne narzędzia do analizy „w głąb”.