Internet jest dosłownie napakowany wartościowymi danymi — problem w tym, że większość stron wcale nie powstała po to, żeby dało się je łatwo „zassać”. W 2025 roku web scraping to już nie ciekawostka dla geeków, tylko obowiązkowe narzędzie dla zespołów, które śledzą ceny, oferty pracy, rynek nieruchomości czy ruchy konkurencji. Tylko że… GitHub aż kipi od repozytoriów. Jedne są dopieszczone, inne doprowadzają do szału, a sporo nie widziało aktualizacji od lat. Jak więc wybrać coś sensownego — zwłaszcza jeśli nie jesteś 개발자?

W tym poradniku przeprowadzę Cię przez 15 najlepszych projektów do web scrapingu na GitHubie na 2025 rok. To nie będzie sucha lista linków — porównam je pod kątem łatwości startu, dopasowania do zastosowań, radzenia sobie z dynamicznymi stronami, kondycji projektu, opcji eksportu danych oraz tego, dla kogo realnie są. A jeśli masz już dość walki z kodem, pokażę też, czemu narzędzia no-code oparte o AI, takie jak , robią prawdziwy game changer dla zespołów biznesowych i osób nietechnicznych.

Jak wybraliśmy TOP 15 projektów do web scrapingu na GitHubie

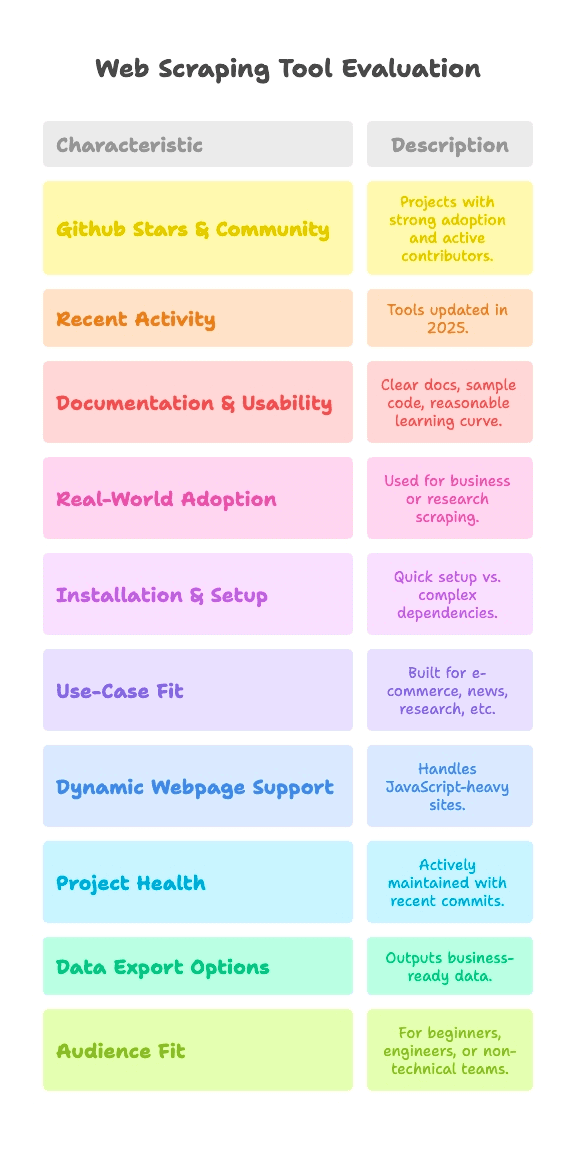

Bądźmy szczerzy: nie każdy projekt na GitHubie to złoto. Część to narzędzia sprawdzone w boju przez tysiące użytkowników, a część to weekendowe „garażówki”, które nigdy nie wyszły poza etap testów. Do zestawienia wybrałem projekty, które spełniają te kryteria:

- Gwiazdy na GitHubie i społeczność: narzędzia z wyraźną adopcją (od kilku tysięcy do 90k+ gwiazdek) i aktywnymi współtwórcami.

- Świeża aktywność: projekty, które wciąż żyją i rozwijają się w 2025 roku — a nie cyfrowe skamieliny.

- Dokumentacja i użyteczność: jasne instrukcje, przykłady kodu i sensowna krzywa uczenia.

- Zastosowanie w praktyce: używane w realnych projektach biznesowych lub badawczych, a nie tylko w demach typu „hello world”.

Ponieważ web scraping nie jest rozwiązaniem „one size fits all”, każdy projekt porównuję też pod kątem:

- Instalacji i złożoności konfiguracji: start w kilka minut czy walka ze sterownikami i zależnościami?

- Dopasowania do zastosowań: e-commerce, newsy, badania, a może coś zupełnie innego?

- Obsługi dynamicznych stron: czy ogarnie nowoczesne serwisy oparte o JavaScript?

- Kondycji projektu: czy jest aktywnie utrzymywany, czy ostatni commit ma już „prawa wyborcze”?

- Eksportu danych: czy dostaniesz dane gotowe do pracy, czy tylko surowy HTML?

- Dopasowania do odbiorcy: dla początkujących w Pythonie, inżynierów danych czy zespołów nietechnicznych?

Każdy projekt dostaje szybkie tagi dla tych kryteriów, żebyś od razu wyłapał to, co pasuje do Twoich potrzeb — niezależnie od tego, czy jesteś kodowym 고수, czy po prostu chcesz mieć dane w Google Sheets.

Instalacja i konfiguracja: jak szybko zaczniesz scrapować?

Nie ma co udawać: dla większości osób największą barierą jest samo odpalenie scrapera. Tak dzielę poziom trudności konfiguracji:

- Plug & Play (zero konfiguracji): instalujesz i działa. Minimum ustawień, super na start.

- Średni poziom (linia poleceń, trochę kodu): wymaga odrobiny kodowania lub pracy w CLI, ale da się to ogarnąć, jeśli pisałeś już skrypty.

- Zaawansowany (sterowniki, anty-bot, dużo kodu): potrzebujesz konfiguracji środowiska, driverów przeglądarki albo solidnych umiejętności w Python/JS.

Tak wypadają najpopularniejsze projekty:

- Plug & Play: MechanicalSoup (Python), Nokogiri (Ruby), Maxun (dla użytkowników końcowych po wdrożeniu)

- Średni poziom: Scrapy, Crawlee, Node Crawler, Selenium, Playwright, Colly, Puppeteer, Katana, Scrapling, WebMagic

- Zaawansowany: Heritrix, Apache Nutch (oba wymagają Javy, plików konfiguracyjnych lub „cięższych” stosów big data)

Jeśli nie jesteś programistą, „Plug & Play” albo narzędzia no-code będą Twoimi sprzymierzeńcami. Dla reszty „Średni poziom” oznacza, że trzeba będzie coś napisać, ale bez dramatu — chyba że masz alergię na klamry.

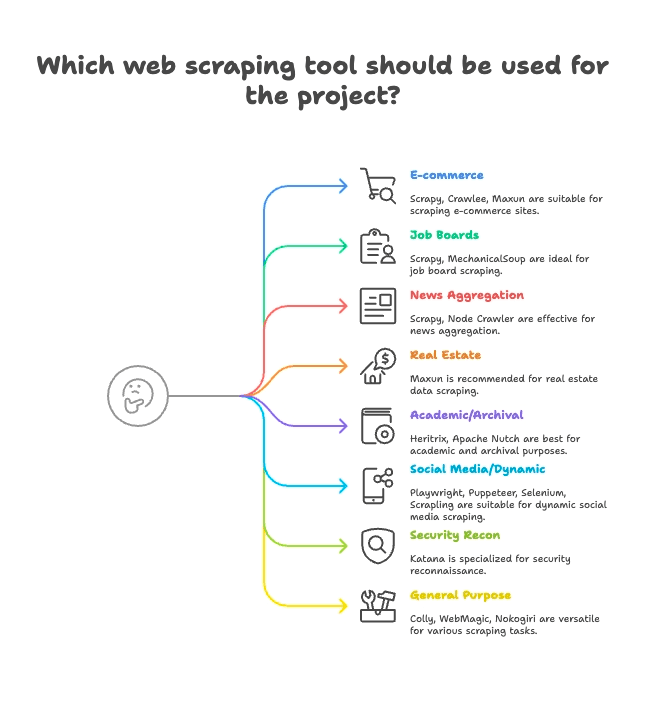

Podział według zastosowań: dobierz scraper do branży

Nie każdy scraper python (i nie tylko) jest stworzony do tego samego zadania. Oto jak grupuję TOP 15 według najlepszego dopasowania:

E-commerce i monitoring cen

- Scrapy: duża skala, wielostronicowe scrapowanie produktów

- Crawlee: uniwersalne, działa na stronach statycznych i dynamicznych

- Maxun: no-code, świetne do szybkiego wyciągania list produktów

Portale pracy i rekrutacja

- Scrapy: dobrze ogarnia paginację i ustrukturyzowane listy

- MechanicalSoup: przydatne przy portalach wymagających logowania

Newsy i agregacja treści

- Scrapy: zaprojektowane do crawl’owania serwisów informacyjnych na dużą skalę

- Node Crawler: szybkie przy statycznej agregacji newsów

Nieruchomości

- Thunderbit: scrapowanie podstron oparte o AI (listingi + strony szczegółów)

- Maxun: wizualny wybór pól dla danych o nieruchomościach

Badania akademickie i archiwizacja WWW

- Heritrix: archiwizacja całych serwisów (pliki WARC)

- Apache Nutch: rozproszony crawling do zbiorów badawczych

Social media i treści dynamiczne

- Playwright, Puppeteer, Selenium: scrapowanie dynamicznych feedów, symulacja logowania

- Scrapling: „stealth scraping” dla stron z zabezpieczeniami anty-bot

Bezpieczeństwo i rekonesans

- Katana: szybkie odkrywanie URL-i, crawling pod kątem security

Ogólne / wielozadaniowe

- Colly: bardzo wydajny scraping w Go dla dowolnych stron

- WebMagic: Java, elastyczne zastosowania w wielu domenach

- Nokogiri: parsowanie w Ruby do własnych skryptów

Obsługa dynamicznych stron: czy te projekty z GitHuba poradzą sobie z nowoczesnym webem?

Współczesne strony kochają JavaScript. React, Vue, infinite scroll, AJAX — jeśli kiedykolwiek próbowałeś scrapować stronę i dostałeś wielkie „nic”, to wiesz, o co chodzi.

Tak poszczególne projekty radzą sobie z dynamiczną treścią:

- Pełna obsługa JS (przeglądarka headless):

- Selenium: steruje prawdziwymi przeglądarkami, wykonuje cały JS

- Playwright: wiele przeglądarek i języków, solidne wsparcie JS

- Puppeteer: headless Chrome/Firefox, pełne renderowanie JS

- Crawlee: przełącza się między HTTP a trybem przeglądarki (Puppeteer/Playwright)

- Katana: opcjonalny tryb headless do parsowania JS

- Scrapling: integruje Playwright do „cichego” scrapingu JS

- Maxun: pod spodem używa przeglądarki, więc ogarnia dynamiczne treści

- Brak natywnej obsługi JS (tylko statyczny HTML):

- Scrapy: do JS potrzebuje wtyczki Selenium/Playwright

- MechanicalSoup, Node Crawler, Colly, WebMagic, Nokogiri, Heritrix, Apache Nutch: pobierają tylko HTML, bez JS „z pudełka”

Na tym tle wyróżnia się AI w Thunderbit: automatycznie wykrywa i wyciąga dane z treści dynamicznych — bez ręcznej konfiguracji, bez wtyczek i bez bólu z selektorami. Wystarczy kliknąć „AI Suggest Fields”, a resztę zrobi za Ciebie, nawet na stronach mocno opartych o React. Jeśli chcesz zrozumieć, jak to działa, zajrzyj do .

Kondycja projektu i niezawodność: czy ten scraper zadziała też za rok?

Nie ma nic gorszego niż zbudować proces na narzędziu, które potem zostaje porzucone. Tak wypadają topowe projekty:

- Aktywnie utrzymywane (częste aktualizacje):

- Scrapy:

- Crawlee:

- Playwright:

- Puppeteer:

- Katana:

- Colly:

- Maxun:

- Scrapling:

- Stabilne, ale aktualizowane wolniej:

- MechanicalSoup:

- Node Crawler:

- WebMagic:

- Nokogiri:

- Tryb utrzymaniowy (specjalistyczne, wolniejsze):

- Heritrix:

- Apache Nutch:

Thunderbit to usługa zarządzana, więc nie musisz się martwić, że repo nagle umrze. Nasz zespół dba o aktualność AI, szablonów i integracji — a do tego masz onboarding, tutoriale i wsparcie, gdy utkniesz.

Dane i eksport: od surowego HTML do danych gotowych dla biznesu

Samo pobranie danych to dopiero połowa roboty. Potrzebujesz ich w formacie, z którego skorzysta zespół — CSV, Excel, Google Sheets, Airtable, Notion albo nawet API.

- Wbudowany eksport ustrukturyzowany:

- Scrapy: eksport do CSV, JSON, XML

- Crawlee: elastyczne datasety i storage

- Maxun: CSV, Excel, Google Sheets, JSON API

- Thunderbit:

- Ręczna obsługa danych (po stronie użytkownika):

- MechanicalSoup, Node Crawler, Selenium, Playwright, Puppeteer, Colly, WebMagic, Nokogiri, Scrapling: sam piszesz kod do zapisu/eksportu

- Eksport specjalistyczny:

- Heritrix: WARC (pliki archiwum WWW)

- Apache Nutch: surowa treść do storage/indexu

Ustrukturyzowany eksport i integracje Thunderbit to ogromna oszczędność czasu dla zespołów biznesowych. Koniec z ręcznym „męczeniem” CSV i dopisywaniem glue code — klikasz i masz dane gotowe do użycia.

Dla kogo jest które narzędzie? Dopasowanie do odbiorcy

Nie każde narzędzie jest dla każdego. Oto moje rekomendacje:

- Początkujący w Pythonie: MechanicalSoup, Scrapling (jeśli lubisz wyzwania)

- Inżynierowie danych: Scrapy, Crawlee, Colly, WebMagic, Node Crawler

- QA i automatyzacja: Selenium, Playwright, Puppeteer

- Badacze bezpieczeństwa: Katana

- Rubyści: Nokogiri

- Programiści Java: WebMagic, Heritrix, Apache Nutch

- Użytkownicy nietechniczni / zespoły biznesowe: Maxun, Thunderbit

- Growth hackerzy, analitycy: Maxun, Thunderbit

Jeśli nie czujesz się pewnie w kodzie albo po prostu chcesz szybko dostać wynik, Thunderbit i Maxun będą najlepszym wyborem. W pozostałych przypadkach dobierz narzędzie do języka i scenariusza.

TOP 15 projektów do web scrapingu na GitHubie: szczegółowe porównanie

Przejdźmy do konkretów — każdy projekt w grupie zastosowań, z tagami i najważniejszymi cechami.

E-commerce, monitoring cen i crawling ogólny

— 57.1k gwiazdek, aktualizacja czerwiec 2025

- Podsumowanie: wysokopoziomowy, asynchroniczny framework w Pythonie do scrapingu i crawl’owania na dużą skalę.

- Konfiguracja: średni poziom (kod w Pythonie, asynchroniczność)

- Zastosowanie: e-commerce, newsy, badania, wielostronicowe „spidery”

- Obsługa JS: nie (wymaga wtyczki Selenium/Playwright)

- Kondycja projektu: aktywnie utrzymywany

- Eksport danych: wbudowane CSV, JSON, XML

- Dla kogo: programiści, inżynierowie danych

- Wyróżniki: skalowalny, solidny, masa wtyczek. Dla początkujących krzywa uczenia jest stroma.

— 17.9k gwiazdek, 2025

- Podsumowanie: rozbudowana biblioteka Node.js do scrapingu stron statycznych i dynamicznych.

- Konfiguracja: średni poziom (kod w Node/TS)

- Zastosowanie: e-commerce, social media, automatyzacja

- Obsługa JS: tak (integracja z Puppeteer/Playwright)

- Kondycja projektu: bardzo aktywny

- Eksport danych: elastyczny (datasety, storage)

- Dla kogo: zespoły developerskie w JS/TS

- Wyróżniki: narzędzia antyblokujące, łatwe przełączanie trybu HTTP/przeglądarka.

— 13k gwiazdek, czerwiec 2025

- Podsumowanie: open-source’owa platforma no-code do ekstrakcji danych z WWW z wizualnym interfejsem.

- Konfiguracja: średni poziom (wdrożenie serwera), łatwa (dla użytkowników końcowych)

- Zastosowanie: ogólne, e-commerce, scraping biznesowy

- Obsługa JS: tak (działa na silniku przeglądarki)

- Kondycja projektu: aktywny i rosnący

- Eksport danych: CSV, Excel, Google Sheets, JSON API

- Dla kogo: osoby nietechniczne, analitycy, zespoły

- Wyróżniki: scraping „wskaż i kliknij”, nawigacja wielopoziomowa, możliwość self-hostingu.

Portale pracy, rekrutacja i proste interakcje

— 4.8k gwiazdek, 2024

- Podsumowanie: biblioteka Pythona do automatyzacji formularzy i prostej nawigacji.

- Konfiguracja: Plug & Play (Python, minimum kodu)

- Zastosowanie: portale pracy z logowaniem, strony statyczne

- Obsługa JS: nie

- Kondycja projektu: dojrzały, lekko utrzymywany

- Eksport danych: brak wbudowanego (ręcznie)

- Dla kogo: początkujący w Pythonie, szybkie skrypty

- Wyróżniki: symuluje sesję przeglądarki w kilku linijkach. Nie nadaje się do stron dynamicznych.

Agregacja newsów i treści statyczne

— 6.8k gwiazdek, 2024

- Podsumowanie: szybki, współbieżny crawler po stronie serwera z parsowaniem przez Cheerio.

- Konfiguracja: średni poziom (callbacki/async w Node)

- Zastosowanie: newsy, szybki scraping stron statycznych

- Obsługa JS: nie (tylko HTML)

- Kondycja projektu: umiarkowana aktywność (v2 beta)

- Eksport danych: brak wbudowanego (po stronie użytkownika)

- Dla kogo: programiści Node.js, potrzeby wysokiej współbieżności

- Wyróżniki: asynchroniczny crawling, limity zapytań, API podobne do jQuery.

Nieruchomości, listingi i scraping podstron

- Podsumowanie: no-code Web Scraper oparty o AI, stworzony dla użytkowników biznesowych.

- Konfiguracja: Plug & Play (rozszerzenie Chrome, konfiguracja w 2 kliknięcia)

- Zastosowanie: nieruchomości, e-commerce, sprzedaż, marketing — dowolna strona

- Obsługa JS: tak (AI automatycznie wykrywa treści dynamiczne)

- Kondycja projektu: stale aktualizowany, usługa zarządzana

- Eksport danych: jednym kliknięciem do Sheets, Airtable, Notion, CSV, JSON

- Dla kogo: osoby nietechniczne, zespoły biznesowe, sprzedaż, marketing

- Wyróżniki: AI „Suggest Fields”, scraping podstron, natychmiastowy eksport, onboarding, szablony, .

Badania akademickie i archiwizacja WWW

— 3k gwiazdek, 2023

- Podsumowanie: crawler do archiwizacji na skalę WWW od Internet Archive.

- Konfiguracja: zaawansowana (aplikacja Java, pliki konfiguracyjne)

- Zastosowanie: archiwizacja WWW, crawl całych domen

- Obsługa JS: nie (tylko pobieranie)

- Kondycja projektu: utrzymywany (wolniej, ale konsekwentnie)

- Eksport danych: WARC (pliki archiwum WWW)

- Dla kogo: archiwa, biblioteki, instytucje

- Wyróżniki: skalowalny, solidny, zgodny ze standardami. Nie jest narzędziem do precyzyjnego scrapingu.

— 3k gwiazdek, 2024

- Podsumowanie: open-source’owy crawler do big data i wyszukiwarek.

- Konfiguracja: zaawansowana (Java + Hadoop dla skali)

- Zastosowanie: crawling pod wyszukiwarki, big data

- Obsługa JS: nie (tylko HTTP)

- Kondycja projektu: aktywny (Apache)

- Eksport danych: surowa treść do storage/indexu

- Dla kogo: firmy, big data, badania akademickie

- Wyróżniki: architektura wtyczek, crawling rozproszony.

Social media, treści dynamiczne i automatyzacja

— ~30k gwiazdek, 2025

- Podsumowanie: automatyzacja przeglądarki do scrapingu i testów, obsługuje wszystkie główne przeglądarki.

- Konfiguracja: średni poziom (drivery, wiele języków)

- Zastosowanie: strony z dużą ilością JS, testy przepływów, social media

- Obsługa JS: tak (pełna automatyzacja przeglądarki)

- Kondycja projektu: aktywny, dojrzały

- Eksport danych: brak (ręcznie)

- Dla kogo: inżynierowie QA, programiści

- Wyróżniki: wiele języków, symulacja zachowania prawdziwego użytkownika.

— 73.5k gwiazdek, 2025

- Podsumowanie: nowoczesna automatyzacja przeglądarki do scrapingu i testów E2E.

- Konfiguracja: średni poziom (skrypty w różnych językach)

- Zastosowanie: nowoczesne aplikacje webowe, social media, automatyzacja

- Obsługa JS: tak (headless lub prawdziwa przeglądarka)

- Kondycja projektu: bardzo aktywny

- Eksport danych: brak (po stronie użytkownika)

- Dla kogo: programiści potrzebujący solidnej kontroli przeglądarki

- Wyróżniki: cross-browser, auto-wait, przechwytywanie sieci.

— 90.9k gwiazdek, 2025

- Podsumowanie: wysokopoziomowe API do automatyzacji Chrome/Firefox.

- Konfiguracja: średni poziom (skrypty w Node)

- Zastosowanie: scraping headless Chrome, treści dynamiczne

- Obsługa JS: tak (Chrome/Firefox)

- Kondycja projektu: aktywny (zespół Chrome)

- Eksport danych: brak (własny kod)

- Dla kogo: programiści Node.js, front-end

- Wyróżniki: bogata kontrola przeglądarki, zrzuty ekranu, PDF, przechwytywanie sieci.

— 5.4k gwiazdek, czerwiec 2025

- Podsumowanie: szybki „stealth scraping” z funkcjami anty-bot.

- Konfiguracja: średni poziom (kod w Pythonie)

- Zastosowanie: scraping z ukrywaniem, anty-bot, strony dynamiczne

- Obsługa JS: tak (integracja z Playwright)

- Kondycja projektu: aktywny, bardzo „na czasie”

- Eksport danych: brak wbudowanego (ręcznie)

- Dla kogo: programiści Python, „hackerzy”, inżynierowie danych

- Wyróżniki: stealth, proxy, antyblokowanie, async.

Rekonesans bezpieczeństwa

— 13.8k gwiazdek, 2025

- Podsumowanie: szybki crawler do security, automatyzacji i odkrywania linków.

- Konfiguracja: średni poziom (narzędzie CLI lub biblioteka Go)

- Zastosowanie: crawling pod bezpieczeństwo, wykrywanie endpointów

- Obsługa JS: tak (opcjonalny tryb headless)

- Kondycja projektu: aktywny (ProjectDiscovery)

- Eksport danych: wyjście tekstowe (listy URL)

- Dla kogo: badacze bezpieczeństwa, programiści Go

- Wyróżniki: szybkość, współbieżność, parsowanie JS w trybie headless.

Ogólne / wielozadaniowe scrapowanie

— 24.3k gwiazdek, 2025

- Podsumowanie: szybki i elegancki framework do scrapingu w Go.

- Konfiguracja: średni poziom (kod w Go)

- Zastosowanie: wydajny scraping ogólnego przeznaczenia

- Obsługa JS: nie (tylko HTML)

- Kondycja projektu: aktywny, świeże commity

- Eksport danych: brak wbudowanego (po stronie użytkownika)

- Dla kogo: programiści Go, osoby stawiające na wydajność

- Wyróżniki: async, limity zapytań, scraping rozproszony.

— 11.6k gwiazdek, 2023

- Podsumowanie: elastyczny framework crawlera w Javie, w stylu Scrapy.

- Konfiguracja: średni poziom (Java, proste API)

- Zastosowanie: web scraping w Javie

- Obsługa JS: nie (można rozszerzyć przez Selenium)

- Kondycja projektu: aktywna społeczność

- Eksport danych: pipeline’y wtyczkowe

- Dla kogo: programiści Java

- Wyróżniki: pule wątków, schedulery, antyblokowanie.

— 6.2k gwiazdek, 2025

- Podsumowanie: szybki, natywny parser HTML/XML dla Ruby.

- Konfiguracja: Plug & Play (gem Ruby)

- Zastosowanie: parsowanie HTML/XML w aplikacjach Ruby

- Obsługa JS: nie (tylko parsowanie)

- Kondycja projektu: aktywny, nadąża za Ruby

- Eksport danych: brak (formatowanie po stronie Ruby)

- Dla kogo: Rubyści, programiści Rails

- Wyróżniki: szybkość, zgodność, bezpieczeństwo domyślnie.

Szybki przegląd: tabela porównawcza funkcji

Poniżej szybka tabela — z Thunderbit dla porównania:

| Projekt | Złożoność konfiguracji | Zastosowanie | Obsługa JS | Utrzymanie | Eksport danych | Dla kogo | Gwiazdy na GitHubie |

|---|---|---|---|---|---|---|---|

| Scrapy | Średnia | E-commerce, newsy | Nie | Aktywny | CSV, JSON, XML | Dev, inż. danych | 57.1k |

| Crawlee | Średnia | Uniwersalne, automatyzacja | Tak | Bardzo aktywny | Elastyczne datasety | Zespoły JS/TS | 17.9k |

| MechanicalSoup | Plug & Play | Statyczne, formularze | Nie | Dojrzały | Brak (ręcznie) | Początkujący Python | 4.8k |

| Node Crawler | Średnia | Newsy, statyczne | Nie | Umiarkowane | Brak (ręcznie) | Dev Node.js | 6.8k |

| Selenium | Średnia | Dużo JS, testy | Tak | Aktywny | Brak (ręcznie) | QA, dev | ~30k |

| Heritrix | Zaawansowana | Archiwizacja, badania | Nie | Utrzymywany | WARC | Archiwa, instytucje | 3k |

| Apache Nutch | Zaawansowana | Big data, wyszukiwanie | Nie | Aktywny | Surowa treść | Firmy, badania | 3k |

| WebMagic | Średnia | Java, ogólne | Nie | Aktywna społeczność | Pipeline’y wtyczkowe | Dev Java | 11.6k |

| Nokogiri | Plug & Play | Parsowanie Ruby | Nie | Aktywny | Brak (ręcznie) | Rubyści | 6.2k |

| Playwright | Średnia | Dynamiczne, automatyzacja | Tak | Bardzo aktywny | Brak (ręcznie) | Dev, QA | 73.5k |

| Katana | Średnia | Security, odkrywanie | Tak | Aktywny | Wyjście tekstowe | Security, dev Go | 13.8k |

| Colly | Średnia | Wysoka wydajność, ogólne | Nie | Aktywny | Brak (ręcznie) | Dev Go | 24.3k |

| Puppeteer | Średnia | Dynamiczne, automatyzacja | Tak | Aktywny | Brak (ręcznie) | Dev Node.js | 90.9k |

| Maxun | Łatwa (użytk.) | No-code, biznes | Tak | Aktywny | CSV, Excel, Sheets, API | Nietech., analitycy | 13k |

| Scrapling | Średnia | Stealth, anty-bot | Tak | Aktywny | Brak (ręcznie) | Dev Python, „hackerzy” | 5.4k |

| Thunderbit | Plug & Play | No-code, biznes | Tak | Usługa zarządzana | Sheets, Airtable, Notion | Nietech., biznes | N/A |

Dlaczego Thunderbit to najlepszy wybór dla osób nietechnicznych i zespołów biznesowych

Większość open-source’owych projektów z GitHuba powstaje „od programistów dla programistów”. Czyli: konfiguracja, utrzymanie i rozwiązywanie problemów są w pakiecie. Jeśli jesteś po stronie biznesu — marketing, sales ops albo po prostu chcesz efektów zamiast bólu z regexami — Thunderbit jest zrobiony właśnie pod Ciebie.

Co wyróżnia Thunderbit:

- Prostota no-code wspierana przez AI: zainstaluj , kliknij „AI Suggest Fields” i gotowe. Bez Pythona, bez selektorów, bez dramatu „pip install”.

- Obsługa stron dynamicznych: AI Thunderbit potrafi czytać i wyciągać dane z nowoczesnych stron opartych o JavaScript (React, Vue, AJAX) bez ręcznej konfiguracji.

- Scraping podstron: chcesz zebrać szczegóły z każdej oferty lub produktu? AI Thunderbit przejdzie po podstronach i scali dane w jedną tabelę — bez pisania kodu.

- Eksport gotowy do pracy: jednym kliknięciem do Google Sheets, Airtable, Notion, CSV lub JSON. Idealne do leadów, monitoringu cen czy agregacji treści.

- Ciągłe aktualizacje i wsparcie: Thunderbit to usługa zarządzana — bez ryzyka „abandonware”. Dostajesz onboarding, tutoriale i rosnącą bibliotekę szablonów.

- Dopasowanie do odbiorcy: Thunderbit jest dla osób nietechnicznych, zespołów biznesowych i wszystkich, którzy cenią szybkość oraz niezawodność bardziej niż dłubanie w kodzie.

To nie są puste słowa — Thunderbit zaufało już ponad 30 000 użytkowników na całym świecie, w tym zespoły z Accenture, Grammarly i Puma. I tak, byliśmy też #1 Produktem Tygodnia na Product Hunt.

Jeśli chcesz zobaczyć, jak proste może być web scraping, .

Podsumowanie: jak wybrać właściwe rozwiązanie do web scrapingu w 2025 roku

Sedno jest takie: GitHub to kopalnia potężnych narzędzi do scrapingu, ale większość z nich jest projektowana z myślą o programistach. Jeśli lubisz kodować, frameworki takie jak Scrapy, Crawlee, Playwright czy Colly dadzą Ci maksymalną kontrolę. Jeśli działasz w akademii lub security, Heritrix, Nutch i Katana będą naturalnym wyborem.

Jeśli jednak jesteś po stronie biznesu, analityki albo po prostu chcesz danych — szybko, w strukturze i gotowych do użycia — Thunderbit będzie najprostszą drogą. Bez konfiguracji, bez utrzymania, bez kodu. Po prostu wynik.

Co dalej? Jeśli chcesz, przetestuj projekty github dopasowane do Twoich umiejętności i zastosowania. A jeśli wolisz ominąć krzywą uczenia i zobaczyć realne efekty w kilka minut, i zacznij scrapować już dziś.

Jeśli chcesz wejść głębiej w temat, sprawdź kolejne poradniki na , np. albo .

Powodzenia w scrapowaniu — oby Twoje dane zawsze były ustrukturyzowane, czyste i gotowe do działania. A gdy utkniesz, pamiętaj: prawdopodobnie istnieje repo na GitHubie, które to rozwiązuje… albo możesz po prostu pozwolić, żeby AI Thunderbit zrobiło to za Ciebie.