Internet to już nie tylko miejsce do zabijania czasu – to prawdziwa kopalnia danych, z której korzystają zarówno handlowcy, jak i analitycy rynku. Ale ręczne zbieranie danych z sieci? To jak próba złożenia mebli z IKEA bez instrukcji, a na końcu i tak zostają Ci śrubki. W czasach, gdy firmy coraz mocniej opierają się na świeżych informacjach rynkowych, analizie konkurencji czy generowaniu leadów, sprawne i niezawodne narzędzia do pozyskiwania danych są na wagę złota. Szacuje się, że już prawie , a globalny rynek web scrapingu ma się .

Masz już dość kopiowania i wklejania, gubisz potencjalnych klientów albo po prostu chcesz zobaczyć, jak automatyzacja może odciążyć Twój zespół? Trafiłeś idealnie. Od lat testuję narzędzia do ekstrakcji danych (i prowadzę zespół w ), więc wiem, jak odpowiednie rozwiązanie potrafi zamienić godziny żmudnej pracy w szybki, dwuklikowy proces. Niezależnie, czy nie programujesz i chcesz natychmiastowych efektów, czy jesteś deweloperem szukającym pełnej kontroli – poniżej znajdziesz 10 najlepszych narzędzi do pozyskiwania danych, które pomogą Ci wybrać to idealne.

Dlaczego wybór dobrego narzędzia do pozyskiwania danych jest ważny

Różnica między dobrym a przeciętnym narzędziem do scrapowania to nie tylko wygoda – to realny wpływ na rozwój firmy. Automatyzując pozyskiwanie danych, nie tylko oszczędzasz czas (jeden z użytkowników G2 przyznał, że ), ale też minimalizujesz błędy, odkrywasz nowe możliwości i masz pewność, że Twój zespół pracuje na najświeższych i najdokładniejszych danych. Ręczne zbieranie informacji jest powolne, podatne na pomyłki i często nieaktualne już w momencie zakończenia pracy. Z odpowiednim narzędziem możesz monitorować konkurencję, śledzić ceny czy budować listy leadów w kilka minut – a nie dni.

Przykład z życia: sieć sklepów kosmetycznych wykorzystała web scraping do monitorowania stanów magazynowych i cen konkurencji, . Takich efektów nie osiągniesz, polegając wyłącznie na arkuszach kalkulacyjnych i ręcznej pracy.

Jak ocenialiśmy najlepsze narzędzia do pozyskiwania danych

Wybór narzędzia do scrapowania przypomina trochę szybkie randki na konferencji IT. Oto, na co zwracałem uwagę:

- Łatwość obsługi: Czy można zacząć bez znajomości Pythona? Czy jest interfejs wizualny lub wsparcie AI dla osób nietechnicznych?

- Możliwości automatyzacji: Czy narzędzie radzi sobie z paginacją, podstronami, dynamiczną treścią i harmonogramowaniem? Czy obsługuje pracę w chmurze przy dużych projektach?

- Cena i skalowalność: Czy jest darmowa wersja lub przystępny plan startowy? Jak rosną koszty wraz ze wzrostem potrzeb?

- Funkcje i integracje: Czy można eksportować dane do Excela, Google Sheets lub przez API? Czy są szablony, harmonogramy lub wbudowane czyszczenie danych?

- Dla kogo: Dla jakiego użytkownika narzędzie jest stworzone – biznes, deweloperzy, zespoły korporacyjne?

Na końcu znajdziesz tabelę porównawczą, która ułatwi wybór.

Czas na przegląd 10 najlepszych narzędzi do efektywnego pozyskiwania danych z sieci w 2025 roku.

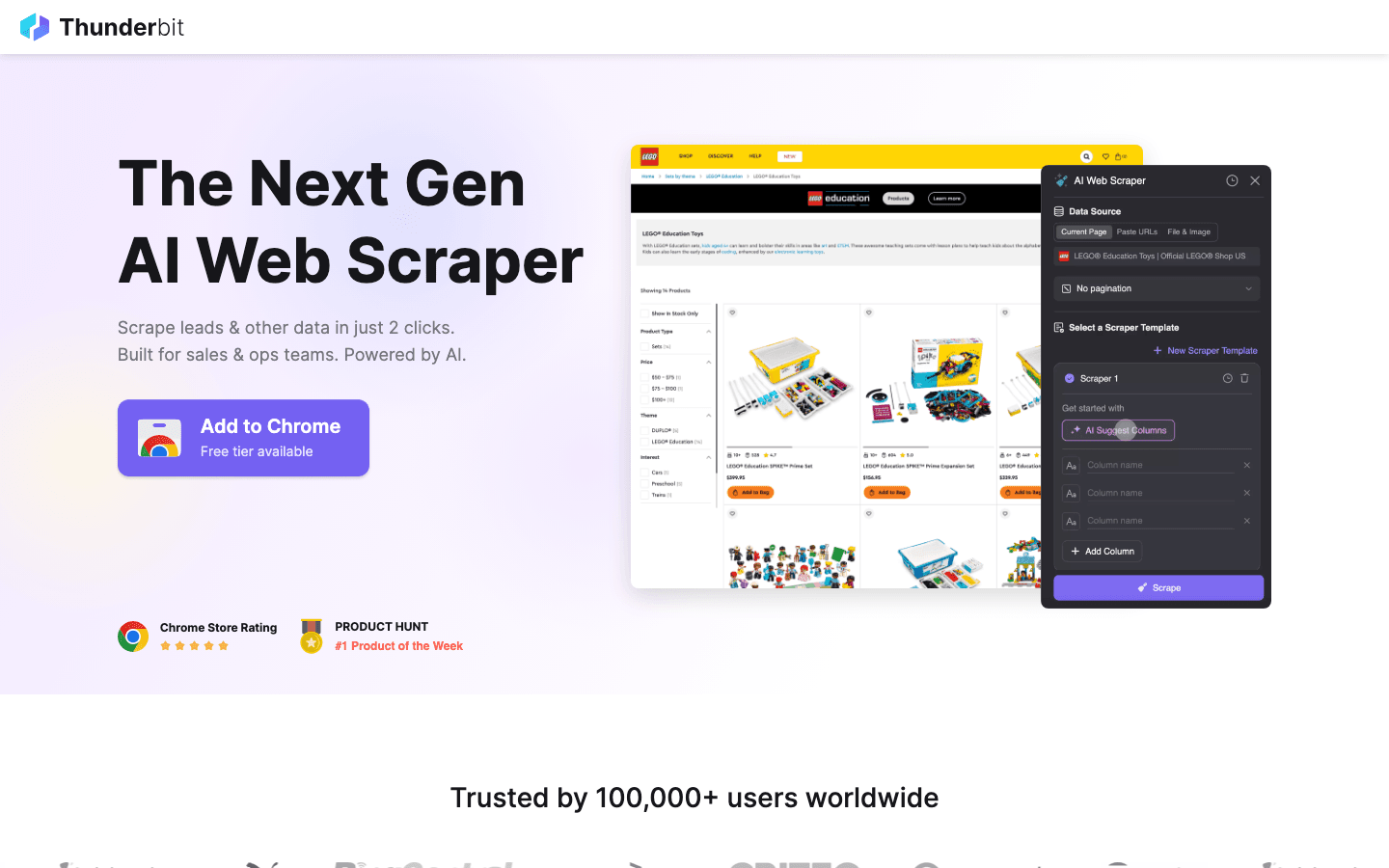

1. Thunderbit

to moja pierwsza propozycja dla każdego, kto chce, by scrapowanie danych było tak proste, jak zamawianie jedzenia przez internet. Jako rozszerzenie Chrome zasilane AI, Thunderbit pozwala pozyskiwać dane w 2 kliknięciach: wystarczy wybrać „AI Suggest Fields”, by sztuczna inteligencja rozpoznała dane na stronie, a potem kliknąć „Scrape”, by je pobrać. Bez kodowania, bez ustawiania selektorów – natychmiastowe efekty.

to moja pierwsza propozycja dla każdego, kto chce, by scrapowanie danych było tak proste, jak zamawianie jedzenia przez internet. Jako rozszerzenie Chrome zasilane AI, Thunderbit pozwala pozyskiwać dane w 2 kliknięciach: wystarczy wybrać „AI Suggest Fields”, by sztuczna inteligencja rozpoznała dane na stronie, a potem kliknąć „Scrape”, by je pobrać. Bez kodowania, bez ustawiania selektorów – natychmiastowe efekty.

Dlaczego Thunderbit jest tak popularny wśród zespołów sprzedaży, marketingu i e-commerce? Bo odpowiada na realne potrzeby biznesu:

- AI Suggest Fields: Sztuczna inteligencja analizuje stronę i proponuje najlepsze kolumny do wyciągnięcia – imiona, ceny, e-maile i inne.

- Scrapowanie podstron: Potrzebujesz więcej szczegółów? Thunderbit automatycznie odwiedzi każdą podstronę (np. szczegóły produktu czy profile LinkedIn) i wzbogaci Twoją tabelę.

- Natychmiastowy eksport: Przesyłaj dane bezpośrednio do Excela, Google Sheets, Airtable lub Notion. Wszystkie eksporty są darmowe.

- Szablony na jeden klik: Dla popularnych stron (Amazon, Zillow, Instagram) dostępne są gotowe szablony, które przyspieszają pracę.

- Darmowy eksport danych: Brak opłat za pobieranie własnych danych.

- Harmonogramowanie scrapowania: Ustawiaj cykliczne zadania w prostym języku („każdy poniedziałek o 9:00”) – idealne do monitorowania cen czy cotygodniowej aktualizacji leadów.

Thunderbit działa w systemie kredytowym (1 kredyt = 1 wiersz), a pozwala na scrapowanie do 6 stron (lub 10 z bonusem na start). Płatne plany zaczynają się od 15 USD/miesiąc za 500 kredytów, co czyni go przystępnym dla firm każdej wielkości.

Chcesz zobaczyć Thunderbit w akcji? Sprawdź nasz lub . To narzędzie, którego sam kiedyś bardzo mi brakowało, gdy tonąłem w ręcznym wprowadzaniu danych.

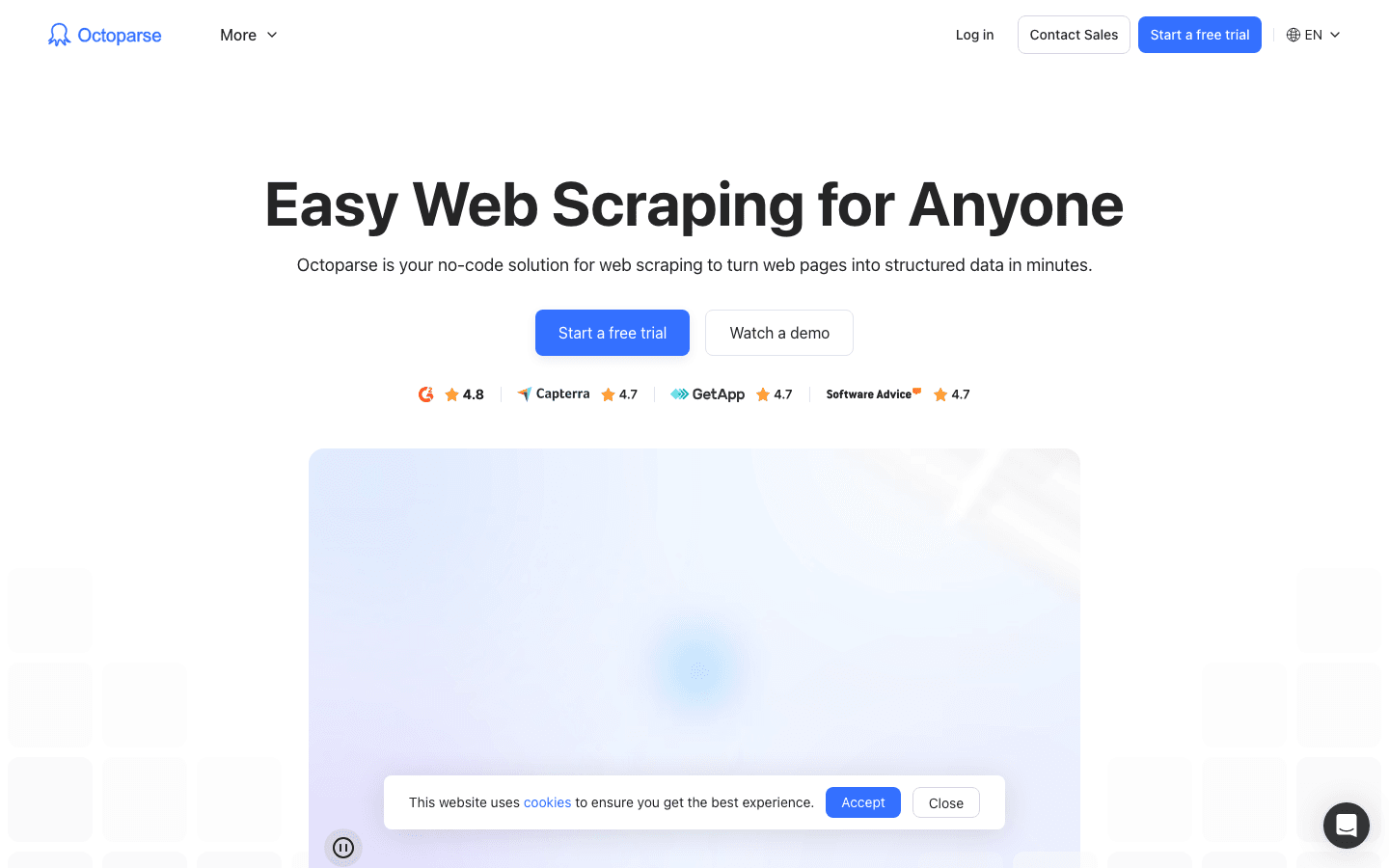

2. Octoparse

to prawdziwy gigant w świecie scrapowania danych, szczególnie dla firm potrzebujących dużej mocy. Oferuje wizualny interfejs na Windows i Mac, gdzie możesz budować procesy ekstrakcji metodą „wskaż i kliknij” – bez kodowania. Pod przyjaznym interfejsem kryje się obsługa logowania, nieskończonego scrollowania, rotacji proxy, a nawet rozwiązywania CAPTCHA.

to prawdziwy gigant w świecie scrapowania danych, szczególnie dla firm potrzebujących dużej mocy. Oferuje wizualny interfejs na Windows i Mac, gdzie możesz budować procesy ekstrakcji metodą „wskaż i kliknij” – bez kodowania. Pod przyjaznym interfejsem kryje się obsługa logowania, nieskończonego scrollowania, rotacji proxy, a nawet rozwiązywania CAPTCHA.

- Ponad 500 gotowych szablonów: Szybki start z szablonami dla Amazon, Twittera, LinkedIn i innych.

- Scrapowanie w chmurze: Uruchamiaj zadania na serwerach Octoparse, planuj harmonogramy i skaluj projekty.

- Dostęp przez API: Integruj dane bezpośrednio z aplikacjami lub bazami danych.

- Zaawansowana automatyzacja: Obsługuje dynamiczną treść, paginację i wieloetapowe procesy.

Jest na 10 zadań, ale większość firm wybierze Standard (~83 USD/mies.) lub Professional (~299 USD/mies.). Krzywa nauki jest nieco wyższa niż w Thunderbit, ale jeśli musisz regularnie scrapować tysiące stron, Octoparse to świetny wybór.

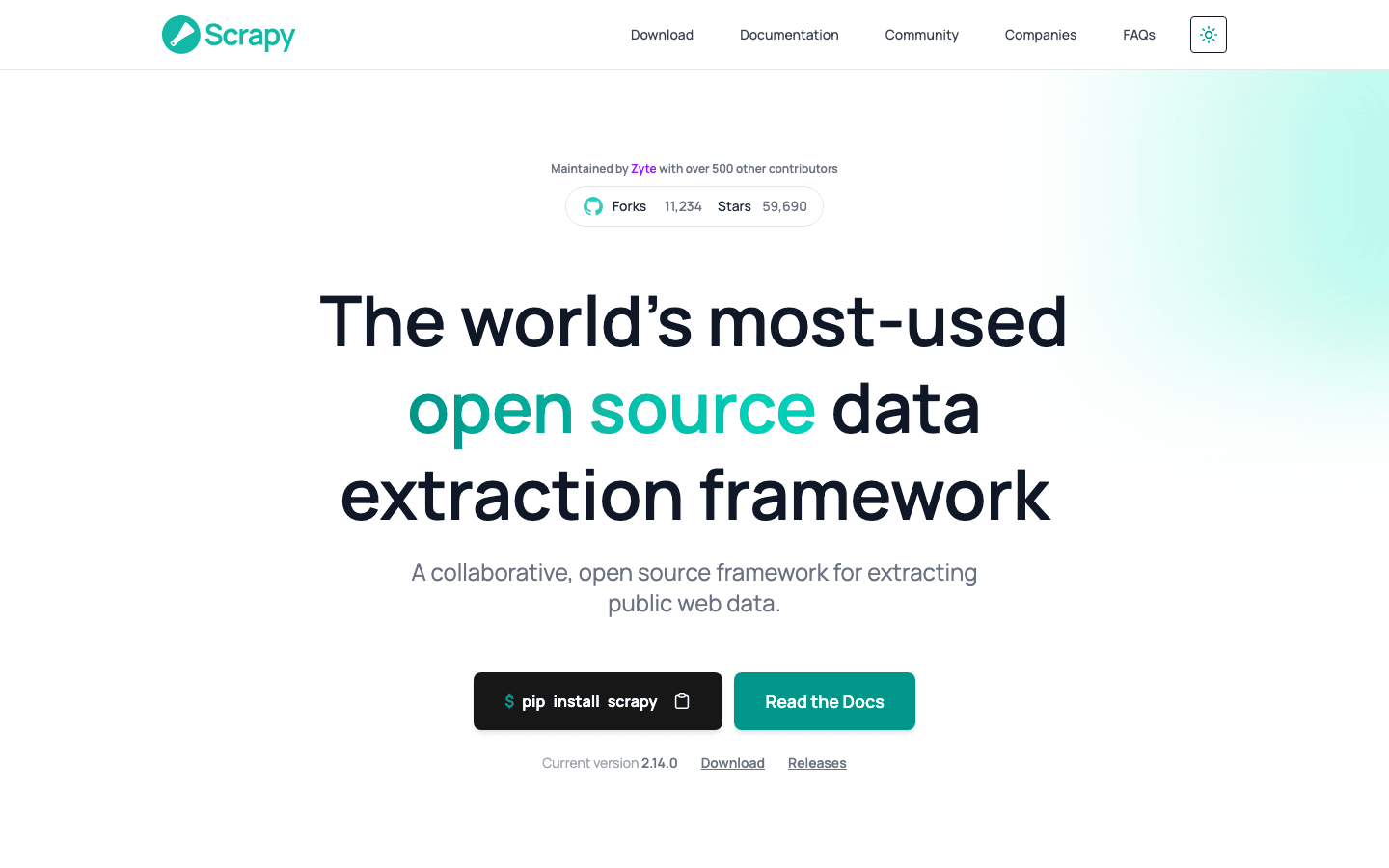

3. Scrapy

to złoty standard dla programistów, którzy chcą pełnej kontroli nad projektami scrapowania. To otwartoźródłowy framework w Pythonie, pozwalający pisać własne „pająki” (crawlers) na dowolną stronę. Jeśli potrafisz to sobie wyobrazić, możesz to zbudować w Scrapy.

to złoty standard dla programistów, którzy chcą pełnej kontroli nad projektami scrapowania. To otwartoźródłowy framework w Pythonie, pozwalający pisać własne „pająki” (crawlers) na dowolną stronę. Jeśli potrafisz to sobie wyobrazić, możesz to zbudować w Scrapy.

- Pełna programowalność: Piszesz kod w Pythonie, by dokładnie określić sposób pobierania i przetwarzania danych.

- Asynchroniczność i szybkość: Obsługuje tysiące stron równocześnie, idealny do dużych projektów.

- Rozszerzalność: Dodawaj middleware do obsługi proxy, przeglądarek headless czy własnej logiki.

- Silna społeczność: Mnóstwo tutoriali, wtyczek i wsparcia dla nietypowych przypadków.

Scrapy jest darmowy i otwartoźródłowy, ale wymaga umiejętności programowania. Jeśli masz zespół techniczny lub chcesz zbudować własny pipeline, trudno o lepsze narzędzie. Dla nietechnicznych użytkowników to jednak spore wyzwanie.

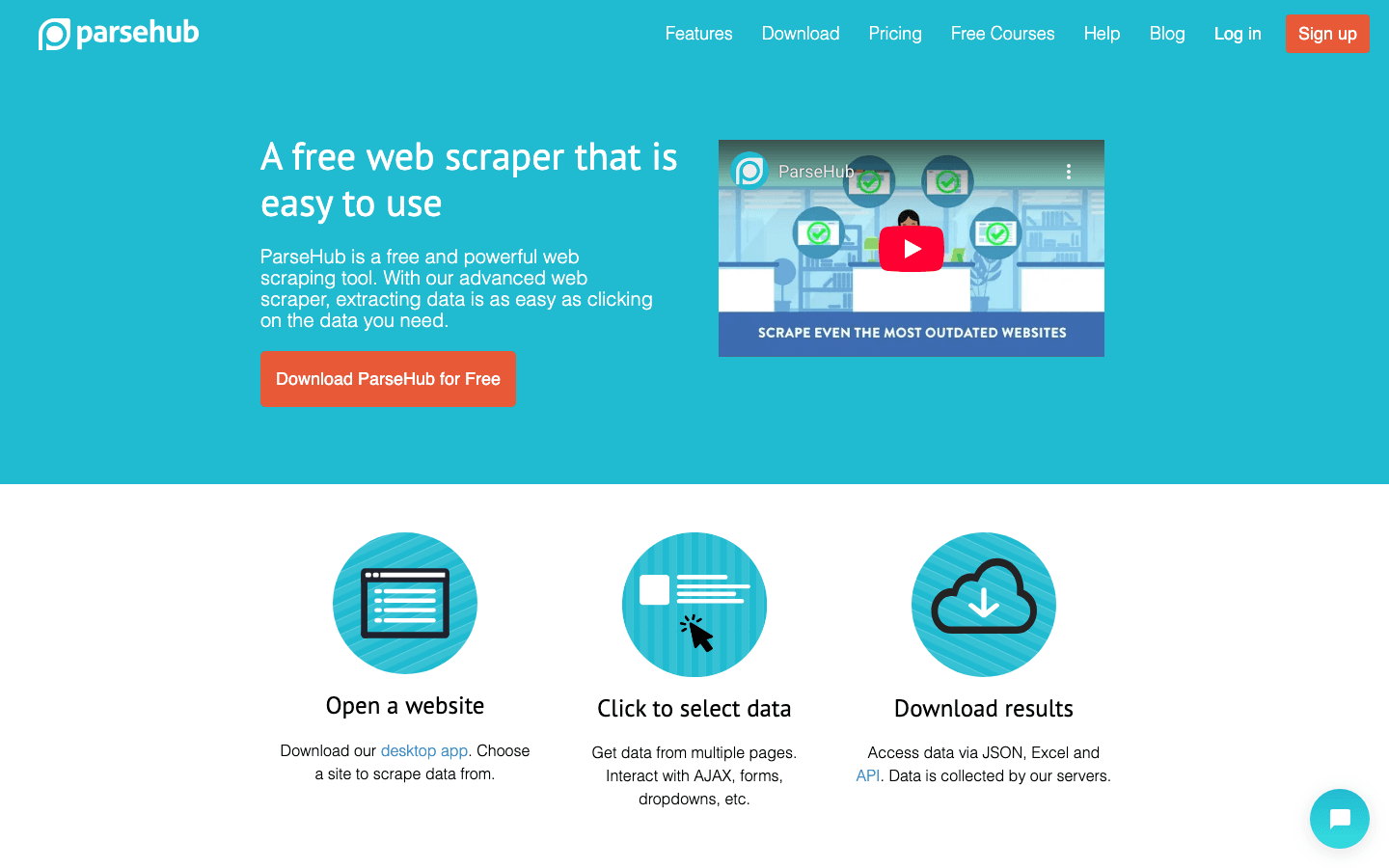

4. ParseHub

to wizualne, bezkodowe narzędzie do scrapowania, idealne dla osób nietechnicznych, które muszą radzić sobie ze złożonymi stronami. Interfejs „wskaż i kliknij” pozwala wybierać elementy, definiować akcje i budować procesy scrapowania – nawet na stronach z dynamiczną treścią czy skomplikowaną nawigacją.

to wizualne, bezkodowe narzędzie do scrapowania, idealne dla osób nietechnicznych, które muszą radzić sobie ze złożonymi stronami. Interfejs „wskaż i kliknij” pozwala wybierać elementy, definiować akcje i budować procesy scrapowania – nawet na stronach z dynamiczną treścią czy skomplikowaną nawigacją.

- Wizualny kreator procesów: Klikasz, by wybrać dane, ustalasz paginację, obsługujesz pop-upy i rozwijane listy.

- Obsługa dynamicznej treści: Działa na stronach z dużą ilością JavaScript i interaktywnych elementów.

- Scrapowanie w chmurze i harmonogramy: Uruchamiaj zadania w chmurze i planuj cykliczne pobieranie danych.

- Eksport do CSV, Excela lub przez API: Łatwa integracja z ulubionymi narzędziami.

ParseHub oferuje darmowy plan (5 projektów), a płatne zaczynają się od . Jest droższy niż niektóre konkurencyjne rozwiązania, ale wizualny interfejs sprawia, że jest przystępny dla analityków, marketerów i badaczy potrzebujących czegoś więcej niż proste rozszerzenie Chrome.

5. Apify

to zarówno platforma, jak i marketplace do scrapowania. Oferuje ogromną bibliotekę gotowych „aktorów” (czyli scraperów) na popularne strony oraz możliwość budowania własnych crawlerów w chmurze.

to zarówno platforma, jak i marketplace do scrapowania. Oferuje ogromną bibliotekę gotowych „aktorów” (czyli scraperów) na popularne strony oraz możliwość budowania własnych crawlerów w chmurze.

- Ponad 5000 gotowych aktorów: Natychmiastowe scrapowanie Google Maps, Amazona, Twittera i innych.

- Własne skrypty: Programiści mogą używać JavaScript lub Pythona do tworzenia zaawansowanych crawlerów.

- Skalowanie w chmurze: Równoległe zadania, harmonogramy i zarządzanie danymi w chmurze.

- API i integracje: Wyniki można podłączyć do aplikacji, workflowów czy pipeline’ów danych.

Apify ma elastyczny , a płatne plany zaczynają się od 29 USD/mies. (rozliczane za czas obliczeniowy). Krzywa nauki jest umiarkowana, ale jeśli chcesz połączyć gotowe rozwiązania z pełną personalizacją, Apify to bardzo mocny wybór.

6. Data Miner

to rozszerzenie Chrome stworzone do szybkiego, szablonowego scrapowania danych. Idealne dla biznesu, który chce pobrać dane z tabel czy list bez żadnej konfiguracji.

to rozszerzenie Chrome stworzone do szybkiego, szablonowego scrapowania danych. Idealne dla biznesu, który chce pobrać dane z tabel czy list bez żadnej konfiguracji.

- Ogromna biblioteka szablonów: Ponad tysiąc gotowych przepisów na popularne strony (LinkedIn, Yelp itd.).

- Ekstrakcja na klik: Wybierasz szablon, podglądasz dane i eksportujesz w kilka sekund.

- Działa w przeglądarce: Korzysta z aktualnej sesji – świetne do scrapowania za logowaniem.

- Eksport do CSV lub Excela: Dane w arkuszu w kilka chwil.

obejmuje 500 stron miesięcznie, płatne od 20 USD/mies. Najlepszy do szybkich, jednorazowych zadań lub gdy potrzebujesz danych „na już” – nie oczekuj jednak obsługi dużych projektów czy zaawansowanej automatyzacji.

7. Import.io

to platforma klasy enterprise dla firm, które potrzebują ciągłej, niezawodnej integracji danych z sieci. To nie tylko crawler – to zarządzana usługa, która dostarcza czyste, uporządkowane dane bezpośrednio do Twoich systemów biznesowych.

to platforma klasy enterprise dla firm, które potrzebują ciągłej, niezawodnej integracji danych z sieci. To nie tylko crawler – to zarządzana usługa, która dostarcza czyste, uporządkowane dane bezpośrednio do Twoich systemów biznesowych.

- Bez kodowania: Wizualna konfiguracja, co i jak pobierać.

- Dane w czasie rzeczywistym: Strumieniowanie danych do dashboardów, narzędzi analitycznych czy baz danych.

- Zgodność i niezawodność: Obsługa rotacji IP, zabezpieczeń antybotowych i zgodności prawnej.

- Usługi zarządzane: Zespół Import.io może skonfigurować i utrzymywać Twoje scrapery.

Ceny są , a SaaS można testować przez 14 dni za darmo. Jeśli Twój biznes wymaga zawsze aktualnych danych z sieci (np. retail, finanse, badania rynku), Import.io to propozycja warta rozważenia.

8. WebHarvy

to narzędzie desktopowe dla użytkowników Windows, którzy chcą rozwiązania „wskaż i kliknij” bez abonamentu. Szczególnie popularne wśród małych firm i osób prywatnych, które wolą jednorazowy zakup.

to narzędzie desktopowe dla użytkowników Windows, którzy chcą rozwiązania „wskaż i kliknij” bez abonamentu. Szczególnie popularne wśród małych firm i osób prywatnych, które wolą jednorazowy zakup.

- Wizualne wykrywanie wzorców: Klikasz na dane, a WebHarvy sam rozpoznaje powtarzające się elementy.

- Obsługa tekstu, obrazów i innych: Pobiera wszystkie typy danych, w tym e-maile i adresy URL.

- Paginacja i harmonogramy: Przechodzi przez wielostronicowe serwisy i pozwala planować scrapowanie.

- Eksport do Excela, CSV, XML, JSON lub SQL: Elastyczne formaty wyjściowe.

Licencja dla jednego użytkownika to , co czyni to rozwiązanie opłacalnym przy regularnym użyciu – pamiętaj jednak, że działa tylko na Windows.

9. Mozenda

to platforma do scrapowania w chmurze, stworzona z myślą o operacjach biznesowych i stałych potrzebach danych. Łączy desktopowy kreator (Windows) z potężną automatyzacją i przetwarzaniem w chmurze.

to platforma do scrapowania w chmurze, stworzona z myślą o operacjach biznesowych i stałych potrzebach danych. Łączy desktopowy kreator (Windows) z potężną automatyzacją i przetwarzaniem w chmurze.

- Wizualny kreator agentów: Budujesz procesy ekstrakcji metodą „wskaż i kliknij”.

- Skalowanie w chmurze: Równoległe uruchamianie wielu agentów, harmonogramy i centralne zarządzanie danymi.

- Konsola zarządzania danymi: Łączenie, filtrowanie i czyszczenie danych po ekstrakcji.

- Wsparcie dla firm: Dedykowani opiekunowie i usługi zarządzane dla dużych zespołów.

Plany zaczynają się od , wyższe pakiety dla większych zespołów i mocy obliczeniowej. Mozenda to idealne rozwiązanie dla firm, które potrzebują niezawodnych, powtarzalnych danych z sieci na co dzień.

10. BeautifulSoup

to klasyczna biblioteka Pythona do parsowania HTML i XML. Nie jest pełnym crawlerem, ale deweloperzy cenią ją za prostotę przy mniejszych, niestandardowych projektach scrapowania.

to klasyczna biblioteka Pythona do parsowania HTML i XML. Nie jest pełnym crawlerem, ale deweloperzy cenią ją za prostotę przy mniejszych, niestandardowych projektach scrapowania.

- Proste parsowanie HTML: Łatwe wyciąganie danych ze statycznych stron.

- Współpraca z Python Requests: Możesz łączyć z innymi bibliotekami do pobierania i scrapowania.

- Elastyczność i lekkość: Idealna do szybkich skryptów lub nauki.

- Ogromna społeczność: Mnóstwo tutoriali i odpowiedzi na Stack Overflow.

BeautifulSoup jest , ale musisz samodzielnie napisać kod i obsłużyć logikę scrapowania. Najlepszy dla programistów lub osób uczących się podstaw web scrapingu.

Tabela porównawcza: Narzędzia do pozyskiwania danych w skrócie

| Narzędzie | Łatwość obsługi | Poziom automatyzacji | Cena | Opcje eksportu | Dla kogo |

|---|---|---|---|---|---|

| Thunderbit | Bardzo łatwe, bez kodu | Wysoki (AI, podstrony) | Darmowy trial, od 15 USD/mies. | Excel, Sheets, Airtable, Notion, CSV | Sprzedaż, marketing, e-commerce, nietechniczni |

| Octoparse | Średnie, wizualny UI | Bardzo wysoki, chmura | Darmowy, 83–299 USD/mies. | CSV, Excel, JSON, API | Firmy, zespoły danych, dynamiczne strony |

| Scrapy | Niskie (wymaga Pythona) | Wysoki (personalizacja) | Darmowy, open-source | Dowolny (przez kod) | Programiści, duże projekty customowe |

| ParseHub | Wysokie, wizualne | Wysoki (dynamiczne strony) | Darmowy, od 189 USD/mies. | CSV, Excel, JSON, API | Nietechniczni, złożone struktury stron |

| Apify | Średnie, elastyczne | Bardzo wysoki, chmura | Darmowy, 29–999 USD/mies. | CSV, JSON, API, chmura | Programiści, firmy, gotowe lub własne aktory |

| Data Miner | Bardzo łatwe, przeglądarka | Niski (manualny) | Darmowy, 20–99 USD/mies. | CSV, Excel | Szybkie, jednorazowe pobieranie, małe zbiory |

| Import.io | Średnie, zarządzane | Bardzo wysoki, enterprise | Indywidualna, zależna od wolumenu | CSV, JSON, API, integracja bezpośrednia | Firmy, ciągła integracja danych |

| WebHarvy | Wysokie, desktop | Średni (harmonogramy) | 129 USD jednorazowo | Excel, CSV, XML, JSON, SQL | Małe firmy, użytkownicy Windows, regularne scrapowanie |

| Mozenda | Średnie, wizualne | Bardzo wysoki, chmura | 250–450+ USD/mies. | CSV, Excel, JSON, chmura, DB | Stałe, duże operacje biznesowe |

| BeautifulSoup | Niskie (wymaga Pythona) | Niski (manualne kodowanie) | Darmowy, open-source | Dowolny (przez kod) | Programiści, uczący się, małe skrypty customowe |

Jak wybrać odpowiednie narzędzie do pozyskiwania danych dla Twojego zespołu

Najlepsze narzędzie do scrapowania to nie to „najpotężniejsze”, ale to, które najlepiej pasuje do umiejętności, potrzeb i budżetu Twojego zespołu. Moje szybkie rady:

- Nietechniczni lub biznes: Zacznij od Thunderbit, ParseHub lub Data Miner – szybkie efekty i łatwa konfiguracja.

- Firmy i duże projekty: Sprawdź Octoparse, Mozenda lub Import.io – automatyzacja, harmonogramy i wsparcie.

- Programiści lub customowe projekty: Scrapy, Apify lub BeautifulSoup dają pełną kontrolę i elastyczność.

- Oszczędni lub jednorazowe zadania: WebHarvy (Windows) lub Data Miner (przeglądarka) są tanie i proste.

Zawsze testuj wybrane narzędzia na prawdziwych stronach – to, co działa na jednej, może nie działać na innej. Pamiętaj też o integracji: jeśli potrzebujesz danych w Sheets, Notion czy bazie danych, sprawdź, czy narzędzie to obsługuje.

Podsumowanie: Wydobądź wartość biznesową dzięki najlepszym narzędziom do scrapowania

Dane z internetu to nowe „paliwo”, ale tylko wtedy, gdy masz odpowiednie narzędzia do ich pozyskiwania i przetwarzania. Nowoczesne narzędzia do scrapowania pozwalają zamienić godziny ręcznego researchu w minuty automatycznej analizy – napędzając skuteczniejszą sprzedaż, lepszy marketing i sprawniejsze operacje. Niezależnie, czy budujesz listy leadów, śledzisz konkurencję, czy po prostu masz dość kopiowania i wklejania – w tym zestawieniu znajdziesz narzędzie, które ułatwi Ci życie.

Przeanalizuj potrzeby swojego zespołu, przetestuj kilka rozwiązań i przekonaj się, ile więcej możesz osiągnąć, gdy automatyzacja przejmie żmudne zadania. A jeśli chcesz zobaczyć, jak wygląda scrapowanie z AI w 2 kliknięciach, . Powodzenia w scrapowaniu – niech Twoje dane zawsze będą świeże, uporządkowane i gotowe do działania.

Najczęściej zadawane pytania

1. Czym jest narzędzie do pozyskiwania danych i po co mi ono?

To narzędzie, które automatycznie pobiera informacje ze stron internetowych. Oszczędza czas, minimalizuje błędy i pozwala zespołom szybko gromadzić aktualne dane do sprzedaży, marketingu, badań czy operacji – znacznie wydajniej niż ręczne kopiowanie.

2. Które narzędzie do scrapowania jest najlepsze dla nietechnicznych użytkowników?

Thunderbit, ParseHub i Data Miner to najlepsze opcje dla osób bez umiejętności programowania. Thunderbit wyróżnia się workflowem AI w 2 kliknięciach, a ParseHub oferuje wizualne podejście do bardziej złożonych stron.

3. Jak różnią się modele cenowe narzędzi do scrapowania?

Ceny są bardzo zróżnicowane: niektóre narzędzia (np. Thunderbit, Data Miner) mają darmowe pakiety i przystępne abonamenty, a platformy enterprise (Import.io, Mozenda) rozliczają się indywidualnie lub według wolumenu. Zawsze sprawdź, czy koszt odpowiada Twoim potrzebom.

4. Czy te narzędzia obsługują cykliczne, zaplanowane pobieranie danych?

Tak – Thunderbit, Octoparse, Apify, Mozenda i Import.io umożliwiają harmonogramowanie scrapowania, co sprawdza się przy monitorowaniu cen, generowaniu leadów czy badaniach rynku.

5. Na co zwrócić uwagę przed wyborem narzędzia do scrapowania?

Weź pod uwagę umiejętności zespołu, złożoność stron, wolumen danych, potrzeby integracji i budżet. Przetestuj kilka narzędzi na realnych zadaniach przed wyborem płatnego planu.

Więcej praktycznych porad znajdziesz na .

Dowiedz się więcej