Narzędzia do web scrapingu w 2025 roku błyskawicznie wyrastają na jedną z najbardziej niedocenianych broni produktywności.

Od generowania leadów i śledzenia rynku, przez monitoring konkurencji, aż po analizę nastrojów — te rozwiązania pozwalają osobom nietechnicznym robić to, co jeszcze niedawno wymagało całego zespołu inżynierów. zautomatyzowane narzędzia do web scrapingu przestały być wyłącznym placem zabaw programistów i „data nerdów”. Dziś handlowcy, marketerzy, a nawet osoby z operacji, które zwykle trzymają się z dala od technologii, potrafią odpalić przepływ danych w kilka minut — czasem wystarczą dosłownie parę kliknięć i proste, „po ludzku” opisanie, co ma zostać zebrane.

Jeśli to czytasz, pewnie już wiesz, że web scraping to taki cichy game-changer dla skuteczniejszego prospectingu, badań rynku w czasie rzeczywistym i sprawniejszych procesów operacyjnych. Tylko jak wybrać właściwe narzędzie, skoro na rynku jest ich masa — a każde obiecuje oszczędność czasu i mniej frustracji? Jako osoba, która od lat buduje narzędzia SaaS i automatyzacje (i tak, współtworzy ), widziałem na własne oczy, jak dobre rozwiązanie potrafi zamienić męczący maraton kopiuj-wklej w dwuminutowy sukces. Zobaczmy więc top 10 zautomatyzowanych narzędzi do web scrapingu na 2025 rok, porównajmy ich mocne strony i wybierzmy mądrzej.

Dlaczego zautomatyzowane narzędzia do web scrapingu są ważne dla biznesu

Umówmy się: era ręcznego kopiowania danych ze stron internetowych minęła (chyba że naprawdę kręci cię monotonia, ból nadgarstków i lekki egzystencjalny niepokój). zautomatyzowane narzędzia do web scrapingu stały się krytyczne dla firm każdej wielkości. Co więcej, , a web scraping jest ważnym elementem tej strategii.

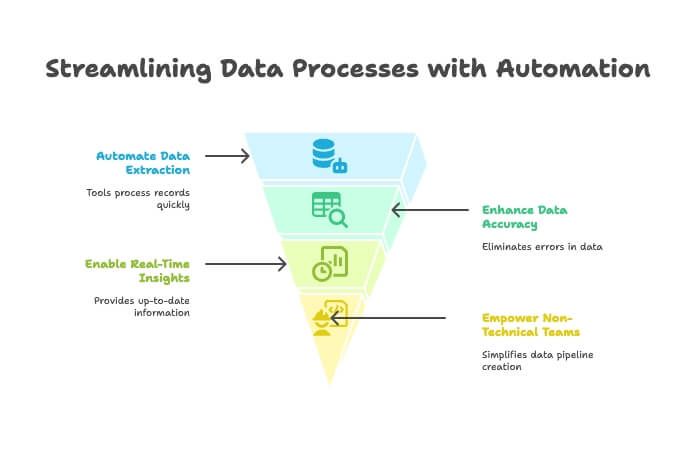

Dlaczego te narzędzia są tak wartościowe?

- Oszczędność czasu i mniej ręcznej pracy: Automatyczne scrapery potrafią przerobić tysiące rekordów w kilka minut, uwalniając zespół do zadań o większej wartości. Jeden z użytkowników opisał, że automatyzacja zbierania danych pozwoliła mu zaoszczędzić „setki godzin” ().

- Wyższa jakość danych: Koniec z literówkami i pominiętymi wpisami. Automatyczna ekstrakcja oznacza czystsze, bardziej wiarygodne dane.

- Szybsze decyzje: Dzięki danym w czasie rzeczywistym możesz monitorować konkurencję, śledzić ceny czy budować listy leadów bez czekania na comiesięczny raport od stażysty.

- Dostępność dla zespołów nietechnicznych: Dzięki narzędziom no-code i rozwiązaniom opartym o AI nawet osoby, dla których „XPath” brzmi jak pozycja z jogi, mogą budować pipeline’y danych z internetu ().

Nic dziwnego, że , a niemal 80% twierdzi, że bez nich organizacja nie działałaby efektywnie. W 2025 roku, jeśli nie automatyzujesz pozyskiwania danych, prawdopodobnie zostawiasz na stole pieniądze — i insighty.

Jak wybraliśmy najlepsze zautomatyzowane narzędzia do web scrapingu

Skoro rynek oprogramowania do web scrapingu ma się , wybór odpowiedniego narzędzia może przypominać kupowanie butów w sklepie z 10 000 modeli. Oto kryteria, które zastosowałem:

- Łatwość użycia: Czy osoba nietechniczna ruszy szybko? Czy próg wejścia jest wysoki?

- Możliwości AI: Czy narzędzie wykorzystuje AI do automatycznego wykrywania pól, obsługi dynamicznych stron lub pozwala opisać potrzeby zwykłym językiem?

- Eksport i integracje: Jak łatwo przenieść dane do Excel, Google Sheets, Airtable, Notion albo CRM?

- Cena: Czy jest darmowy okres próbny? Czy płatne plany są dostępne dla osób i małych zespołów, czy tylko dla enterprise?

- Skalowalność: Czy narzędzie ogarnie zarówno małe jednorazowe zadania, jak i duże, cykliczne ekstrakcje?

- Docelowy użytkownik: Czy jest stworzone dla biznesu, developerów, czy dla obu grup?

- Unikalne atuty: Co wyróżnia je na tle konkurencji?

Uwzględniłem rozwiązania dla każdego poziomu — od „chcę po prostu arkusz” po „chcę przeczesać cały internet”. Przejdźmy do listy.

1. Thunderbit: Web Scraper oparty o AI dla każdego

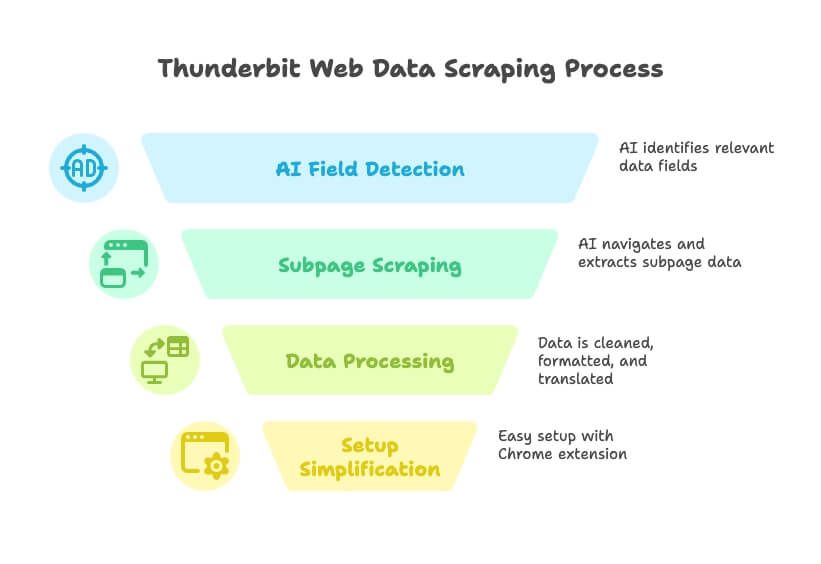

Zacznę od narzędzia, które znam najlepiej — bo mój zespół i ja zbudowaliśmy je dokładnie po to, żeby rozwiązać problemy, z którymi od lat zmagają się użytkownicy biznesowi. nie jest typowym scraperem „przeciągnij i upuść” ani „napisz własne selektory”. To asystent danych oparty o AI: mówisz, czego potrzebujesz, a on robi resztę — bez kodu, bez dłubania w XPath, bez frustracji.

Dlaczego Thunderbit jest na szczycie listy

Thunderbit to najbliższe, co widziałem do „zamiany dowolnej strony w bazę danych”. Działa to tak:

- Sterowanie językiem naturalnym: Powiedz Thunderbit, jakie dane chcesz („potrzebuję nazw firm, e-maili i numerów telefonów z tego katalogu”), a AI sama wykryje właściwe pola.

- AI Suggest Fields: Jednym kliknięciem Thunderbit analizuje stronę i proponuje najlepsze kolumny do wyciągnięcia — bez zgadywania i metody prób i błędów.

- Scraping podstron i wielu poziomów: Potrzebujesz szczegółów z podstron ofert? Thunderbit potrafi przejść dalej, pobrać dodatkowe informacje i dopisać je do tabeli.

- Czyszczenie danych, tłumaczenie i klasyfikacja: Thunderbit nie tylko pobiera surowe dane — potrafi je oczyścić, sformatować, przetłumaczyć, a nawet skategoryzować w trakcie scrapowania.

- Bez bólu konfiguracji: Zainstaluj , kliknij „AI Suggest Fields” i zacznij w mniej niż minutę.

- Darmowy start i niska cena: Hojny darmowy plan (do 6 stron za darmo), a płatne pakiety od 9 USD/mies. To mniej niż tygodniowy budżet na kawę.

Thunderbit jest zbudowany dla zespołów sprzedaży, marketingu i operacji, które potrzebują danych — szybko. Bez kodowania, bez wtyczek, bez szkoleń. Jak stażysta od danych, który naprawdę słucha i nigdy nie narzeka.

Funkcje, które wyróżniają Thunderbit

- Scraping napędzany AI: AI rozumie strukturę strony, dostosowuje się do zmian układu i automatycznie ogarnia paginację oraz podstrony ().

- Natychmiastowy eksport danych: Wyślij wyniki prosto do Excel, Google Sheets, Airtable, Notion albo pobierz jako CSV/JSON.

- Uruchomienia w chmurze lub lokalnie: Odpal scraping w chmurze dla szybkości i skali albo w przeglądarce, jeśli potrzebujesz logowania/sesji.

- Scheduled Scraper: Ustaw cykliczne zadania, by dane były zawsze aktualne — idealne do monitoringu cen lub regularnych aktualizacji leadów.

- Bezobsługowość: AI Thunderbit dopasowuje się do zmian na stronach, więc mniej czasu tracisz na naprawianie „zepsutych” scraperów ().

Dla kogo? Dla każdego, kto chce przejść od „potrzebuję tych danych” do „oto arkusz” w kilka minut — szczególnie dla osób nietechnicznych. Z i oceną 4,9★ Thunderbit szybko staje się wyborem numer jeden dla zespołów biznesowych, które chcą efektów, a nie problemów.

Chcesz zobaczyć, jak to działa? Zajrzyj na albo przejrzyj kolejne poradniki na .

2. Clay: automatyczne wzbogacanie danych + web scraping

Clay to coś w rodzaju scyzoryka szwajcarskiego dla zespołów growth. To nie tylko web scraper — to „arkusz automatyzacji”, który łączy się z ponad 50 źródłami danych na żywo (np. Apollo, LinkedIn, Crunchbase) i wykorzystuje wbudowane AI do wzbogacania leadów, pisania wiadomości outreach i scoringu prospektów.

- Automatyzacja workflow: Każdy wiersz to lead, a każda kolumna może pobierać dane lub uruchamiać akcję. Chcesz zeskrobać listę firm, wzbogacić ją o profile z LinkedIn i wysłać spersonalizowany e-mail? Clay to ogarnie.

- Integracja z AI: Wykorzystuje GPT-4 do pisania „icebreakerów”, streszczania bio i nie tylko.

- Integracje: Natywnie łączy się z HubSpot, Salesforce, Gmail, Slack i innymi.

- Cennik: Od ok. 99 USD/mies. za plan Pro, z darmowym trialem do lekkiego użycia.

Najlepsze dla: outbound sales, growth hackerów i marketerów, którzy chcą budować własne pipeline’y leadów, łącząc scraping, enrichment i outreach w jednym miejscu. Narzędzie jest potężne, ale dla nowych w automatyzacjach może mieć wyraźny próg wejścia ().

3. Bardeen: Web Scraper w przeglądarce do automatyzacji pracy

Bardeen działa jak „robot w przeglądarce”, który potrafi scrapować dane i automatyzować powtarzalne zadania webowe — wszystko z poziomu rozszerzenia Chrome.

- Automatyzacja no-code: Ponad 500 „Playbooks” do scrapowania, wypełniania formularzy, przenoszenia danych między aplikacjami i nie tylko.

- AI Command Builder: Opisz zadanie zwykłym językiem, a Bardeen zbuduje workflow.

- Integracje: Działa z Notion, Trello, Slack, Salesforce i ponad 100 innymi aplikacjami.

- Cennik: Darmowy plan do lekkiego użycia (100 kredytów automatyzacji/mies.), płatne plany od 99 USD/mies. dla zespołów.

Najlepsze dla: power userów i zespołów go-to-market, które chcą automatyzować scraping i działania następcze w wielu aplikacjach. Elastyczność jest duża, ale początkujący mogą odczuć stromą krzywą nauki ().

4. Bright Data: zautomatyzowane narzędzia do web scrapingu klasy enterprise

Bright Data (dawniej Luminati) to ciężki sprzęt w świecie web scrapingu — globalne sieci proxy, zaawansowane API i możliwość crawlowania tysięcy stron dziennie.

- Skala enterprise: Ponad 100 mln IP, Web Scraper IDE, Web Unlocker do omijania zabezpieczeń anty-bot.

- Duża konfigurowalność: Buduj złożone ekstrakcje na dużą skalę z wysoką niezawodnością.

- Cennik: Od 499 USD/mies. za Web Scraper IDE, dostępne też mniejsze pakiety „micro”.

Najlepsze dla: dużych firm, agregatorów danych i zaawansowanych użytkowników, którzy potrzebują solidnych, skalowalnych rozwiązań. Jeśli codziennie przetwarzasz tysiące stron i musisz unikać blokad IP, Bright Data jest dla Ciebie ().

5. Octoparse: wizualny Web Scraper dla użytkowników średniozaawansowanych

Octoparse to popularne narzędzie no-code z wizualnym interfejsem „wskaż i kliknij” — idealne, gdy chcesz mocy bez programowania.

- Interfejs drag-and-drop: Klikasz elementy, by zdefiniować ekstrakcję; obsługuje logowanie, paginację i więcej.

- Szablony: Ponad 500 gotowych template’ów dla popularnych serwisów (Amazon, Twitter itd.).

- Scraping w chmurze: Uruchamiaj zadania na serwerach Octoparse, planuj ekstrakcje i korzystaj z rotacji IP.

- Cennik: Darmowy plan z limitami; płatne od 119 USD/mies.

Najlepsze dla: osób nietechnicznych i analityków danych, którzy chcą solidnego scrapera bez pisania kodu. Świetne do monitoringu cen, list produktów i projektów badawczych ().

6. : platforma do scrapowania danych dla firm

to jeden z pionierów web scrapingu, dziś rozwinięty do pełnoprawnej platformy ekstrakcji danych.

- Ekstrakcja point-and-click: Obsługuje logowania, listy rozwijane i elementy interaktywne.

- Chmura: Przetwarzaj tysiące URL-i równolegle, planuj ekstrakcje i korzystaj z API.

- Nastawienie na enterprise: Wykorzystywane do monitoringu cen, badań rynku i budowy datasetów do ML.

- Cennik: Starter 199 USD/mies., Standard 599 USD/mies., Advanced 1 099 USD/mies.

Najlepsze dla: średnich i dużych firm oraz zespołów danych, które potrzebują stabilnych, utrzymywanych rozwiązań do dużych zadań. Dla hobbystów może być przesadą, ale w skali biznesowej to prawdziwa „maszyna” ().

7. Parsehub: elastyczny Web Scraper z edytorem wizualnym

Parsehub to aplikacja desktopowa (Windows, Mac, Linux), która pozwala budować scrapery poprzez „przeklikiwanie” interfejsu strony.

- Wizualny workflow: Wybierasz elementy, ustawiasz reguły ekstrakcji, obsługujesz logowania, dropdowny i infinite scroll.

- Funkcje chmurowe: Uruchamianie w chmurze, harmonogramy, dostęp do API.

- Cennik: Darmowy plan do małych zadań; płatne od 149 USD/mies.

Najlepsze dla: badaczy, małych firm i osób, które chcą większej kontroli niż w rozszerzeniu przeglądarki, ale nie są gotowe pisać własnego scrapera ().

8. Common Crawl: otwarte dane webowe dla AI i badań

Common Crawl nie jest narzędziem w klasycznym sensie — to ogromny, otwarty zbiór danych z crawlowania internetu, aktualizowany co miesiąc.

- Skala: Około 400 TB danych, obejmujących miliardy stron.

- Darmowe i otwarte: Nie musisz uruchamiać własnego crawlera.

- Wymaga kompetencji technicznych: Potrzebujesz narzędzi big data i umiejętności inżynierskich, by filtrować i parsować dane.

Najlepsze dla: data scientistów i inżynierów budujących modele AI lub prowadzących badania na dużą skalę. Jeśli potrzebujesz ogólnego tekstu z sieci lub archiwów długoterminowych, to kopalnia złota ().

9. Crawly: lekkie zautomatyzowane narzędzie do web scrapingu dla startupów

Crawly (od Diffbot) to chmurowy crawler oparty o AI, który potrafi zbierać dane z milionów stron i zwracać ustrukturyzowane wyniki — bez pisania reguł parsowania.

- Ekstrakcja AI: Wykorzystuje machine vision i NLP do rozpoznawania oraz wyciągania treści.

- Dostęp przez API: Odpytuj zebrane dane i integruj je z analityką lub bazami.

- Cennik: Poziom enterprise; wycena indywidualna.

Najlepsze dla: startupów i zespołów z pewnym zapleczem technicznym, które potrzebują inteligentnej ekstrakcji danych na dużą skalę bez budowania własnych scraperów ().

10. Apify: Web Scraper przyjazny developerom z marketplace

Apify to platforma chmurowa, na której możesz budować własne scrapery („Actors”) albo korzystać z biblioteki gotowych scraperów tworzonych przez społeczność.

- Elastyczność dla developerów: Wsparcie dla scrapowania w JavaScript/Python, headless Chrome, zarządzanie proxy i harmonogramy.

- Marketplace: Duża biblioteka gotowych scraperów dla popularnych serwisów.

- Cennik: Darmowy plan z kredytami 5 USD/mies.; płatne od 49 USD/mies.

Najlepsze dla: programistów i technicznych analityków, którzy chcą pełnej kontroli i skalowalności. Nawet osoby nietechniczne mogą używać gotowych Actorów do typowych zadań ().

Tabela porównawcza zautomatyzowanych narzędzi do web scrapingu

| Narzędzie | Łatwość użycia | Funkcje AI | Cena (od) | Dla kogo | Największe atuty |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | Język naturalny, AI Suggest Fields, scraping podstron | 9 USD/mies. | Nietechniczni użytkownicy biznesowi | Konfiguracja w 2 kliknięcia, bez kodu, natychmiastowy eksport, darmowy trial |

| Clay | ★★★★☆ | Wzbogacanie AI, GPT-4 | 99 USD/mies. | Growth/sales ops | Arkusz automatyzacji, enrichment, outreach |

| Bardeen | ★★★★☆ | Kreator komend AI | 99 USD/mies. | Power userzy, zespoły GTM | RPA w przeglądarce, 500+ playbooków, głębokie integracje |

| Bright Data | ★★☆☆☆ | Rotacja proxy, AI anty-bot | 499 USD/mies. | Enterprise, developerzy | Skala, niezawodność, globalne proxy |

| Octoparse | ★★★★☆ | Wizualne wykrywanie AI | 119 USD/mies. | Analitycy, osoby nietechniczne | Drag-and-drop, szablony, scraping w chmurze |

| Import.io | ★★★☆☆ | Ekstraktory interaktywne | 199 USD/mies. | Enterprise, zespoły danych | Równoległość, harmonogramy, API, wsparcie |

| Parsehub | ★★★★☆ | Wizualne workflow | 149 USD/mies. | Badacze, MŚP | Aplikacja desktopowa, obsługa dynamicznych stron |

| Common Crawl | ★☆☆☆☆ | N/D (tylko dataset) | Darmowe | Data scientist, inżynierowie | Ogromny otwarty zbiór danych, archiwa w skali internetu |

| Crawly | ★★☆☆☆ | Ekstrakcja AI | Wycena/Enterprise | Startupy, zespoły techniczne | AI, bez reguł parsowania, dostęp przez API |

| Apify | ★★★★☆ | Marketplace Actorów | 49 USD/mies. | Developerzy, analitycy techniczni | Budowa/marketplace, automatyzacja w chmurze, elastyczność |

Jak wybrać odpowiednie narzędzie Web Scraper do swoich potrzeb

Wybór najlepszego zautomatyzowanego narzędzia do web scrapingu zależy od wielkości zespołu, kompetencji technicznych i celów biznesowych. Oto szybka ściąga:

- Dla osób nietechnicznych (sprzedaż, marketing, ops):

Wybierz . Jest stworzony pod ciebie — bez kodu, bez konfiguracji, po prostu wynik. Idealny do generowania leadów, monitoringu cen i szybkich projektów danych. - Dla zespołów, które kochają automatyzację:

Clay i Bardeen świetnie się sprawdzą, jeśli chcesz połączyć scraping z enrichment, outreach lub automatyzacją workflow. - Dla enterprise i developerów:

Bright Data, i Apify to najlepsze opcje do projektów na dużą skalę i z wysoką konfigurowalnością. - Dla badaczy i analityków:

Octoparse i Parsehub oferują wizualne interfejsy i mocne funkcje bez konieczności kodowania. - Dla projektów AI i data science:

Common Crawl i Crawly dostarczają ogromne zbiory danych oraz ekstrakcję opartą o AI dla tych, którzy chcą budować lub trenować modele.

Zadaj sobie pytanie: chcesz wystartować w kilka minut czy budujesz niestandardowe rozwiązanie klasy enterprise? Jeśli nie masz pewności, zacznij od darmowego triala — większość narzędzi go oferuje.

Unikalna wartość Thunderbit: asystent AI do danych biznesowych

Na tle wszystkich tych narzędzi Thunderbit wyróżnia się tym, że jako jedyny naprawdę działa jak „asystent AI” do web scrapingu i transformacji danych. Nie chodzi tylko o pobranie danych — chodzi o zamianę chaotycznych stron w czyste, ustrukturyzowane insighty bez barier technicznych.

- Interfejs w języku naturalnym: Opisz potrzeby zwykłym językiem, a Thunderbit zajmie się resztą.

- Automatyzacja end-to-end: Od ekstrakcji, przez czyszczenie, tłumaczenie, aż po eksport — Thunderbit obejmuje cały proces.

- Idealne do szybkich testów: Walidujesz nowy rynek, budujesz listę leadów albo monitorujesz konkurencję? Thunderbit to najszybszy i najtańszy punkt startu.

To jak analityk danych wbudowany w przeglądarkę — taki, który nie prosi o podwyżkę i nie bierze urlopu.

Podsumowanie: wybierz mądrzej właściwe zautomatyzowane narzędzie do web scrapingu

Świat web scrapingu w 2025 roku jest większy, sprytniejszy i bardziej dostępny niż kiedykolwiek. Niezależnie od tego, czy jesteś solo founderem, zwinny zespół sprzedaży, czy data scientistą w enterprise — na tej liście znajdziesz narzędzie dopasowane do potrzeb. Klucz to dobrać platformę do workflow i umiejętności, żeby przestać walczyć z kodem i zacząć wyciągać wnioski.

Jeśli chcesz pożegnać ręczne kopiuj-wklej i działać mądrzej, i zobacz, jak proste może być scrapowanie. Albo wybierz inne opcje powyżej zgodnie z celami. Tak czy inaczej, przyszłość biznesu opartego na danych należy do tych, którzy automatyzują.

Chcesz dowiedzieć się więcej? Zajrzyj na — znajdziesz tam analizy, tutoriale i wskazówki, jak wycisnąć maksimum z danych z sieci. Powodzenia w scrapowaniu — i oby twoje dane zawsze były czyste, a scrapery nigdy się nie psuły (a jeśli się zepsują, niech AI to ogarnie).

FAQ

1. Dlaczego zautomatyzowane narzędzia do web scrapingu są ważne dla użytkowników biznesowych w 2025 roku?

zautomatyzowane narzędzia do web scrapingu usprawniają zbieranie danych, oszczędzając czas i ograniczając pracę ręczną. Poprawiają dokładność danych, wspierają podejmowanie decyzji w czasie rzeczywistym i umożliwiają zespołom nietechnicznym pozyskiwanie oraz wykorzystywanie danych z internetu bez pisania kodu. Dziś są kluczowe dla sprzedaży, marketingu i operacji.

2. Co wyróżnia Thunderbit na tle innych narzędzi do web scrapingu?

Thunderbit wykorzystuje AI, dzięki czemu użytkownik może opisać, jakie dane chce pozyskać, zwykłym językiem. Narzędzie automatycznie wykrywa pola danych, obsługuje podstrony i paginację oraz natychmiast eksportuje wyniki do narzędzi takich jak Excel czy Airtable. Jest zaprojektowane dla osób nietechnicznych i oferuje mocne funkcje, m.in. czyszczenie danych oraz Scheduled Scraper, w przystępnej cenie.

3. Które narzędzie najlepiej sprawdzi się w dużych projektach scrapingu klasy enterprise?

Bright Data oraz to świetne wybory dla enterprise. Oferują m.in. rotację proxy, mechanizmy anty-bot, dużą równoległość przetwarzania i dostęp przez API, dzięki czemu nadają się do niezawodnego przetwarzania tysięcy stron na dużą skalę.

4. Czy są narzędzia, które łączą scraping z automatyzacją i outreach?

Tak. Clay i Bardeen nie tylko zbierają dane z sieci, ale też wpinają je w procesy. Clay wzbogaca leady i automatyzuje outreach, a Bardeen pozwala automatyzować zadania w przeglądarce i workflow dzięki playbookom wspieranym przez AI.

5. Jaka jest najlepsza opcja dla osób bez zaplecza technicznego?

Thunderbit jest najlepszym wyborem dla osób nietechnicznych dzięki interfejsowi w języku naturalnym, konfiguracji opartej o AI i bardzo prostej obsłudze. Nie wymaga kodowania ani skomplikowanego setupu i świetnie sprawdza się, gdy potrzebujesz szybkich, wiarygodnych danych bez technicznej złożoności.