Heb je ooit voor een gigantische stapel webpagina’s gestaan en gedacht: “Was er maar een manier om al die info in één keer netjes in een spreadsheet te krijgen”? Je bent zeker niet de enige. In de huidige zakenwereld is de honger naar webdata groter dan ooit. Of je nu concurrentieprijzen wilt volgen, prospectlijsten samenstelt of vastgoedtrends analyseert: bedrijven willen het internet omtoveren tot bruikbare inzichten. Het geheime wapen in deze digitale goudkoorts? De Python-webscraper—een tool die onmisbaar is geworden voor iedereen die serieus met geautomatiseerde dataverzameling aan de slag wil.

Toch blijft de Python-webscraper voor veel zakelijke gebruikers een mysterieus, technisch hulpmiddel. Bij zien we dit dagelijks: onze missie is om webdata net zo makkelijk te maken als eten bestellen. Tijd om het mysterie te ontrafelen. Wat is een Python-webscraper precies? Waarom is het dé oplossing voor webdata-extractie? En hoe maken nieuwe AI-tools deze technologie toegankelijk voor iedereen—zelfs als je nog nooit een regel code hebt aangeraakt?

Python-webscraper: Wat is het en waarom is het zo handig?

Laten we bij het begin beginnen. Een Python-webscraper (ook wel 'scraper' genoemd) is een programma in Python dat automatisch informatie van websites verzamelt. Zie het als je digitale assistent: je geeft een lijst met websites op, en de scraper bezoekt ze allemaal, leest de inhoud en haalt precies de gegevens op die jij nodig hebt—namen, prijzen, e-mails, noem maar op—en zet ze overzichtelijk in bijvoorbeeld een spreadsheet.

Waarom is dit zo waardevol voor bedrijven? Omdat handmatig data verzamelen ontzettend veel tijd kost. Informatie kopiëren en plakken van honderden of duizenden webpagina’s is niet alleen traag, maar ook foutgevoelig en frustrerend. Python-webscrapers nemen dit werk uit handen, zodat je in minuten enorme hoeveelheden data kunt verzamelen in plaats van dagen. Zoals een gids het mooi samenvat: een webscraper “haalt automatisch informatie van websites en zet het om in gestructureerde data (zoals een spreadsheet)”—nooit meer eindeloos copy-pasten, geen gemiste kansen ().

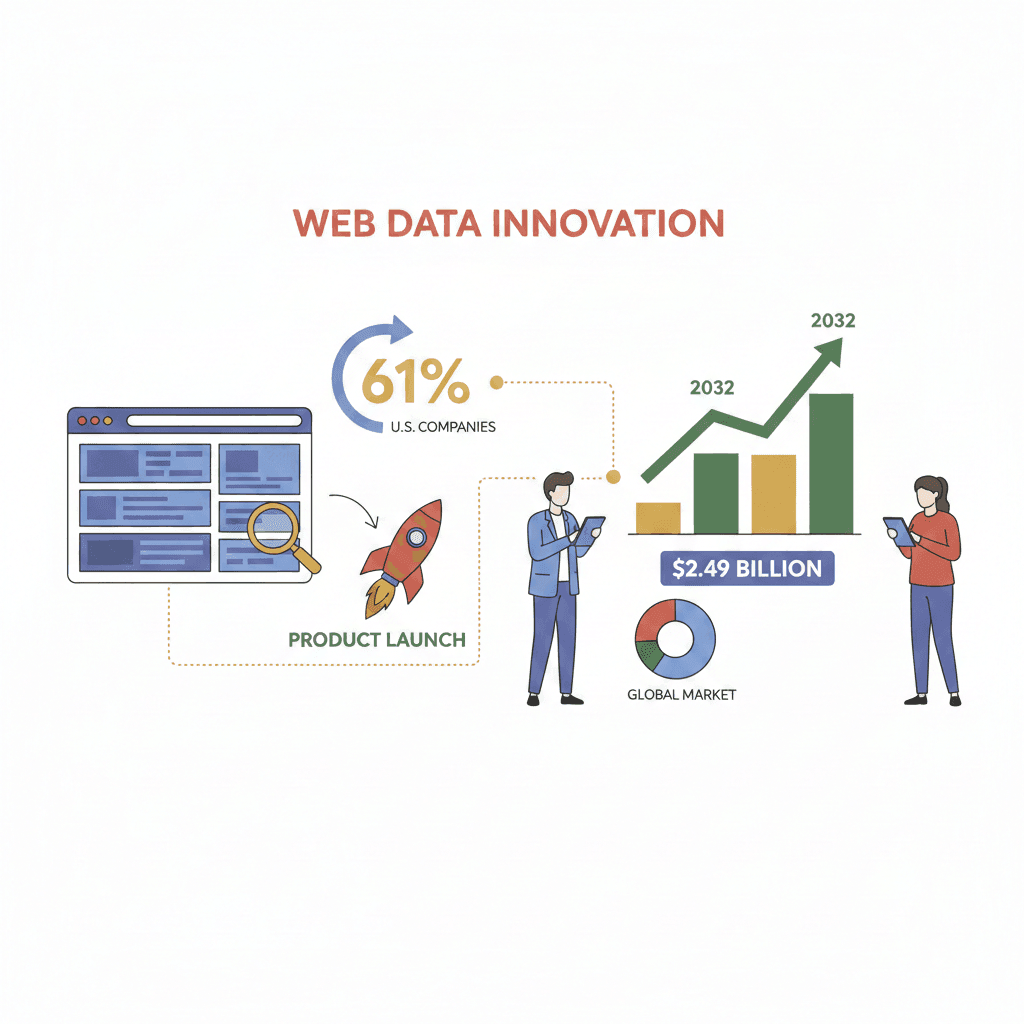

En de vraag blijft groeien. Bijna gebruikt externe webdata om nieuwe producten of functies te lanceren, en de wereldwijde markt voor webscraping-software groeit naar verwachting tot . Als jij deze data niet benut, doet je concurrent het wel.

Wat kan een Python-webscraper allemaal?

Wat kan een Python-webscraper nu eigenlijk allemaal? Heel veel! Dit zijn de belangrijkste functies die het tot een krachtig dataverzamelinstrument maken:

- Alle soorten data verzamelen: Of het nu gaat om producttabellen, e-maillijsten, telefoonnummers, afbeeldingen of zelfs verborgen metadata—een Python-webscraper kan vrijwel alles ophalen wat zichtbaar (of onzichtbaar) is op een webpagina. Contactgegevens voor leadgeneratie? Geen probleem. Productinformatie, prijzen of reviews? Zo geregeld.

- Grote, repetitieve taken automatiseren: Een scraper verwerkt moeiteloos honderden of duizenden pagina’s in een geautomatiseerde cyclus. Hij volgt “Volgende”-knoppen, scrolt door eindeloze pagina’s en raakt nooit moe of afgeleid.

- Links volgen en subpagina’s scrapen: Meer details nodig? Scrapers kunnen van een overzichtspagina doorklikken naar elke product- of profielpagina, daar extra data ophalen en alles samenvoegen tot één dataset.

- Omgaan met paginering en dynamische content: Veel moderne sites laden data via JavaScript of verspreiden informatie over meerdere pagina’s. Met de juiste Python-bibliotheken kan een scraper beide aan, door pagina’s te doorlopen of te wachten tot content geladen is—net als een echte gebruiker.

- Exporteren naar zakelijke formaten: Na het verzamelen wordt de data geëxporteerd naar CSV, Excel, JSON of direct naar een database—klaar voor analyse, rapportage of import in je CRM.

Populaire Python-bibliotheken zoals , Scrapy en Selenium maken dit allemaal mogelijk, maar vereisen wel enige technische kennis.

Waarom is een Python-webscraper zo krachtig voor dataverzameling?

Laten we eerlijk zijn: het verschil tussen handmatig data verzamelen en een Python-webscraper gebruiken is als graven met een lepel versus een boormachine. Waarom?

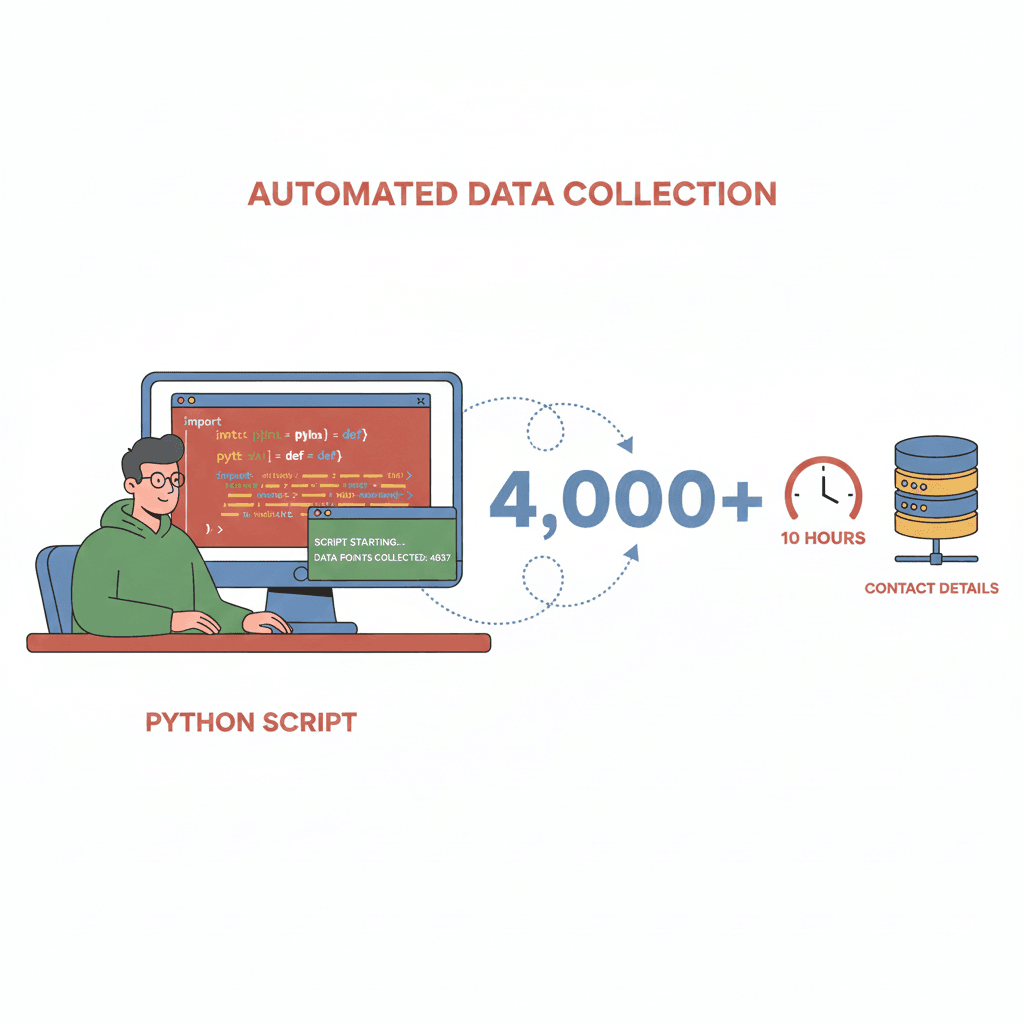

- Snelheid & efficiëntie: Wat een mens dagen kost, doet een scraper in minuten. Eén ontwikkelaar verzamelde met een Python-script —iets wat handmatig weken zou duren.

- Schaalbaarheid: Wil je alle producten van een concurrent monitoren of duizenden reviews verzamelen? Scrapers verwerken enorme hoeveelheden data zonder moeite.

- Nauwkeurigheid & consistentie: Scrapers volgen instructies altijd exact op. Geen typefouten, geen overgeslagen rijen, geen “ik maak het morgen wel af”. Met AI-ondersteuning kan de nauwkeurigheid zelfs oplopen tot , zelfs op lastige, dynamische websites.

- Kostenbesparing: Door automatisering zijn er minder handjes nodig en kun je .

Hier een overzicht van veelvoorkomende zakelijke toepassingen en het rendement:

| Toepassing | Data die wordt verzameld | Zakelijk effect (ROI) |

|---|---|---|

| Leadgeneratie | Namen, e-mails, telefoonnummers uit directories | Snel prospectlijsten opbouwen; 4.000+ leads in enkele uren (Medium) |

| Prijsmonitoring (e-commerce) | Prijzen van concurrenten, voorraadniveaus | Dynamische prijsstelling; John Lewis zag +4% omzet (Browsercat) |

| Markt- & concurrentieanalyse | Productlijsten, reviews, sentiment | 73% van de bedrijven scrapen voor marktinzichten (Browsercat) |

| Vastgoedanalyse | Woningen, prijzen, kenmerken | Altijd actuele marktinformatie voor makelaars/beleggers |

| Nieuws & onderzoeksaggregatie | Headlines, artikelen, onderzoeksdata | Real-time nieuwsfeeds voor analisten; geen handmatig zoeken meer |

Python-webscraper in de praktijk: Toepassingen per sector

Hoe worden Python-webscrapers in de praktijk ingezet?

E-commerce & Retail

Winkels gebruiken webscrapers om prijzen, beschikbaarheid en klantbeoordelingen van concurrenten te volgen. Ongeveer gebruikt scraping voor dynamische prijsstelling. Het resultaat? Snellere prijsaanpassingen en soms een duidelijke omzetstijging.

Sales & Leadgeneratie

Sales-teams scrapen openbare directories, branchewebsites of zelfs Google Maps om lijsten met potentiële klanten samen te stellen. Waarom betalen voor verouderde leads als je er zelf duizenden kunt verzamelen in één dag?

Vastgoed

Makelaars en investeerders scrapen sites als Zillow of Realtor.com om woningaanbod, prijzen en trends te volgen. Zo blijven ze altijd op de hoogte in een snel veranderende markt.

Marktonderzoek & Nieuws

Analisten scrapen nieuwssites, fora en sociale media om trends, sentiment en concurrentie te monitoren. Alles handmatig lezen is simpelweg niet haalbaar op grote schaal.

Veelvoorkomende uitdagingen

Natuurlijk zijn er ook obstakels. Webscrapers krijgen te maken met:

- Dynamische content: Sites die data laden via JavaScript.

- Anti-scrapingmaatregelen: CAPTCHAs, IP-blokkades en inlogvereisten.

- Wijzigingen in websitestructuur: Een redesign kan je script in één klap onbruikbaar maken.

Gelukkig maken nieuwe AI-tools deze uitdagingen steeds makkelijker te overwinnen.

De techniek: Hoe werkt een Python-webscraper (zonder technisch gedoe)?

Hoe werkt een Python-webscraper nu eigenlijk? In gewone taal:

- Verzoek versturen: De scraper “vraagt” de website om de inhoud van de pagina (zoals je browser dat doet).

- Inhoud ophalen: De HTML-code wordt opgehaald (en eventueel dynamische content geladen met tools als Selenium).

- Data uitlezen: Met bibliotheken als BeautifulSoup wordt de HTML doorzocht om precies de juiste info te vinden—productnamen, prijzen, e-mails, enzovoort.

- Opschonen & structureren: De data wordt netjes gemaakt—overbodige spaties verwijderd, formaten gestandaardiseerd, telefoonnummers gevalideerd.

- Exporteren: De uiteindelijke dataset wordt opgeslagen als CSV, Excel of een ander gewenst formaat.

Zie het web als een gigantische bibliotheek, en een Python-webscraper als een robot-bibliothecaris die je precies vertelt: “Zoek alle boeken over sneakers, noteer de prijs en auteur, en zet het in mijn spreadsheet.” De robot raakt nooit moe, slaat niets over en werkt razendsnel.

De leercurve: Wat moet je kunnen voor een Python-webscraper?

Er zit wel een addertje onder het gras: traditionele Python-webscrapers zijn krachtig, maar vragen om technische kennis.

- Programmeervaardigheden: Je moet Python kennen, bibliotheken kunnen installeren en code kunnen debuggen.

- Kennis van HTML/CSS: Scrapen vereist dat je webpagina’s inspecteert om de juiste elementen te vinden—denk aan “zoek de

<h2>-tag met class ‘product-title’.” - Omgaan met webspecifieke uitdagingen: Veel sites gebruiken JavaScript, vereisen inloggen of proberen bots te blokkeren. Je moet scripts kunnen aanpassen aan deze obstakels.

- Onderhoud: Websites veranderen. Je script kan ineens niet meer werken en moet dan worden aangepast—vaak op het minst handige moment.

Voor niet-technische gebruikers is dit een flinke drempel. Zelfs voor ontwikkelaars kan het schrijven en onderhouden van webscrapers veel tijd kosten. Geen wonder dat veel mensen terugvallen op handmatig kopiëren en plakken.

Thunderbit: Python-webscraperkracht voor iedereen

Hier word ik enthousiast van—want precies dit probleem lossen we op met . Thunderbit is een die je alle kracht van een Python-webscraper geeft, maar dan zonder ook maar één regel code te hoeven schrijven.

Zo maakt Thunderbit het verschil:

- AI-veldherkenning: Met één klik scant Thunderbit de pagina, stelt de beste velden voor om te extraheren (zoals “Productnaam”, “Prijs”, “E-mail”) en geeft ze direct een naam.

- Scrapen in 2 klikken: Controleer de voorgestelde kolommen, klik op “Scrapen” en Thunderbit doet de rest—paginering, subpagina’s en dynamische content worden automatisch afgehandeld.

- Overal exporteren: Exporteer je data direct naar Excel, Google Sheets, Notion, Airtable, CSV of JSON—zonder extra kosten of gedoe.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch elke subpagina (zoals productdetails of LinkedIn-profielen) en verrijkt je tabel.

- Geen installatie of onderhoud: Installeer de extensie en je kunt direct aan de slag. Wijzigt een website? Klik opnieuw op “AI-veldherkenning” en Thunderbit past zich direct aan.

Het is alsof je een Python-webscraper als dienst hebt, maar dan voor iedereen—niet alleen voor de “Python-wizards”.

Hoe Thunderbit technische drempels wegneemt

Vergelijk het traditionele Python-webscraperproces eens met de aanpak van Thunderbit:

| Stap | Traditionele Python-scraper | Thunderbit AI-webscraper |

|---|---|---|

| Vereiste kennis | Python, HTML/CSS, probleemoplossing | Geen—alleen basis webgebruik |

| Installatietijd | Uren tot dagen (installeren, coderen, debuggen) | Minuten (extensie installeren, klikken en starten) |

| Paginering afhandelen | Lussen schrijven, debuggen bij sitewijzigingen | AI detecteert en klikt automatisch door pagina’s |

| Subpagina’s scrapen | Maatwerkcode per site | Eén klik—AI regelt navigatie en samenvoegen |

| Dynamische content | Selenium/Playwright, browsers beheren | Scrapen in de browser—je ziet wat je krijgt |

| Export naar Excel/Sheets | Exportcode schrijven, bestandsformaten beheren | Eén klik export naar Excel, Sheets, Notion, Airtable |

| Onderhoud | Code aanpassen bij sitewijzigingen | Klik opnieuw op “AI-veldherkenning”—AI past zich aan |

Kortom: Thunderbit haalt alle technische rompslomp weg. Als je een browser kunt gebruiken, kun je met Thunderbit aan de slag.

AI + Python-webscraper: Meer nauwkeurigheid en waarde uit je data

Hier wordt het pas echt interessant. Thunderbit doet meer dan alleen data kopiëren—het gebruikt AI om je data slimmer te maken:

- Slimmere extractie: AI herkent patronen, zelfs op rommelige of dynamische pagina’s, en verhoogt de nauwkeurigheid tot .

- Ruisonderdrukking: Thunderbit filtert automatisch irrelevante content (zoals advertenties, footers, navigatie) en focust alleen op de data die jij nodig hebt.

- Data normaliseren: Wil je alle telefoonnummers in E.164-formaat? Adressen gestandaardiseerd? Productcategorieën gelabeld? Voeg een instructie toe en Thunderbit’s AI regelt het tijdens het scrapen.

- Direct verrijken: Tekst vertalen, beschrijvingen samenvatten of producten categoriseren? Met Field AI Prompts doe je dit direct tijdens het verzamelen.

Het resultaat? Schonere, direct bruikbare datasets—zonder uren nabewerking.

Veelvoorkomende scraping-uitdagingen? Zo lost Thunderbit ze op

Webscraping kent uitdagingen, maar moderne tools maken ze een stuk minder lastig:

- Anti-scrapingmaatregelen: Thunderbit werkt in de browser en gedraagt zich als een echte gebruiker, waardoor blokkades of CAPTCHAs zelden voorkomen. Voor lastigere sites is er een cloudmodus met roterende IP’s en anti-bot technieken.

- Dynamische content: Als je het in je browser ziet, kan Thunderbit het scrapen—geen gedoe meer met JavaScript of verborgen data.

- Wijzigingen in websitestructuur: Wijzigt een site? Klik opnieuw op “AI-veldherkenning” en Thunderbit past zich direct aan.

- Datakwaliteit: Ingebouwde deduplicatie, foutafhandeling en AI-schoonmaak zorgen altijd voor hoogwaardige data.

- Compliance: Thunderbit stimuleert verantwoord scrapen—met limieten, respect voor robots.txt en standaard geen gevoelige data.

Kortom: de technische obstakels die scraping vroeger tot een ontwikkelaarsklus maakten, worden nu automatisch opgelost.

Conclusie: Kies de juiste data-extractieoplossing voor jouw bedrijf

Wat hebben we geleerd? Een Python-webscraper is een krachtig hulpmiddel om het ongestructureerde web om te zetten in bruikbare, gestructureerde bedrijfsdata. Het is de ruggengraat van moderne sales, e-commerce, marktonderzoek en meer. Maar tot voor kort was het alleen bereikbaar voor wie kon programmeren.

Met AI-tools als is die drempel verdwenen. Of je nu salesmanager, marketeer of makelaar bent—je haalt de data die je nodig hebt in minuten binnen, zonder code, installatie of onderhoud. Gewoon resultaat.

Wanneer kies je voor een traditionele Python-webscraper? Als je een eigen developmentteam hebt, extreem maatwerk nodig hebt of diep wilt integreren met interne systemen, kan zelf coderen zinvol zijn. Maar voor 99% van de bedrijven zijn AI-tools als Thunderbit sneller, eenvoudiger en betrouwbaarder.

Zelf ervaren? en probeer vandaag nog je eerste website te scrapen. Je zult je afvragen hoe je ooit zonder hebt gekund.

Meer weten over webscraping, AI-data-extractie of automatisering? Bekijk de voor meer tips, handleidingen en praktijkvoorbeelden.

Veelgestelde vragen

1. Wat is een Python-webscraper en hoe verschilt het van handmatig data verzamelen?

Een Python-webscraper is een programma dat automatisch data van websites haalt en omzet in gestructureerde formaten zoals spreadsheets. In tegenstelling tot handmatig kopiëren werkt het op grote schaal, veel sneller en met minder fouten.

2. Welke soorten data kan een Python-webscraper verzamelen?

Python-webscrapers kunnen tabellen, lijsten, afbeeldingen, e-mails, telefoonnummers, prijzen, productdetails, reviews en meer ophalen—eigenlijk alles wat zichtbaar (of verborgen) is op een webpagina.

3. Moet ik kunnen programmeren om een Python-webscraper te gebruiken?

Traditionele Python-webscrapers vereisen programmeerkennis. Maar met AI-tools zoals kan iedereen data scrapen met slechts een paar klikken—zonder code.

4. Hoe maakt Thunderbit webscraping makkelijker voor niet-technische gebruikers?

Thunderbit gebruikt AI om automatisch datavelden te herkennen, paginering en subpagina’s af te handelen en resultaten te exporteren naar Excel, Google Sheets, Notion of Airtable. Jij beschrijft wat je wilt, Thunderbit doet de rest.

5. Is webscraping legaal en veilig voor zakelijk gebruik?

Webscraping is legaal als je het verantwoord doet—alleen openbare data scrapen, de voorwaarden van websites respecteren en geen gevoelige of persoonlijke informatie verzamelen. Thunderbit stimuleert ethisch scrapen en helpt je compliant te blijven.

Benieuwd hoe eenvoudig webdata-extractie kan zijn? en maak van het web jouw zakelijke voordeel.

Meer weten