Heb je je ooit afgevraagd hoe Google altijd precies weet wat er op elke website gebeurt, of hoe prijsvergelijkers altijd de nieuwste deals tonen? Achter de schermen zijn er digitale ‘spinnen’ die dag en nacht het web afstruinen. Zij brengen het internet in kaart, zodat jij razendsnel vindt wat je zoekt. Tegenwoordig komt bijna de helft van al het internetverkeer van bots—waarvan de meeste crawlers zijn—die stilletjes informatie verzamelen, indexeren en ordenen voor zoekmachines, AI-modellen en bedrijven ().

Als iemand die jarenlang automatisering en AI-tools heeft gebouwd bij Thunderbit, weet ik uit de praktijk dat snappen wat crawlers doen elk bedrijf een voorsprong geeft. Of je nu in sales, e-commerce of operations werkt: begrijpen wat crawlers zijn—en hoe moderne AI-oplossingen zoals werken—helpt je om nieuwe data te vinden, onderzoek te automatiseren en de concurrentie voor te blijven. Laten we samen ontdekken waarom deze digitale werkpaarden belangrijker zijn dan ooit.

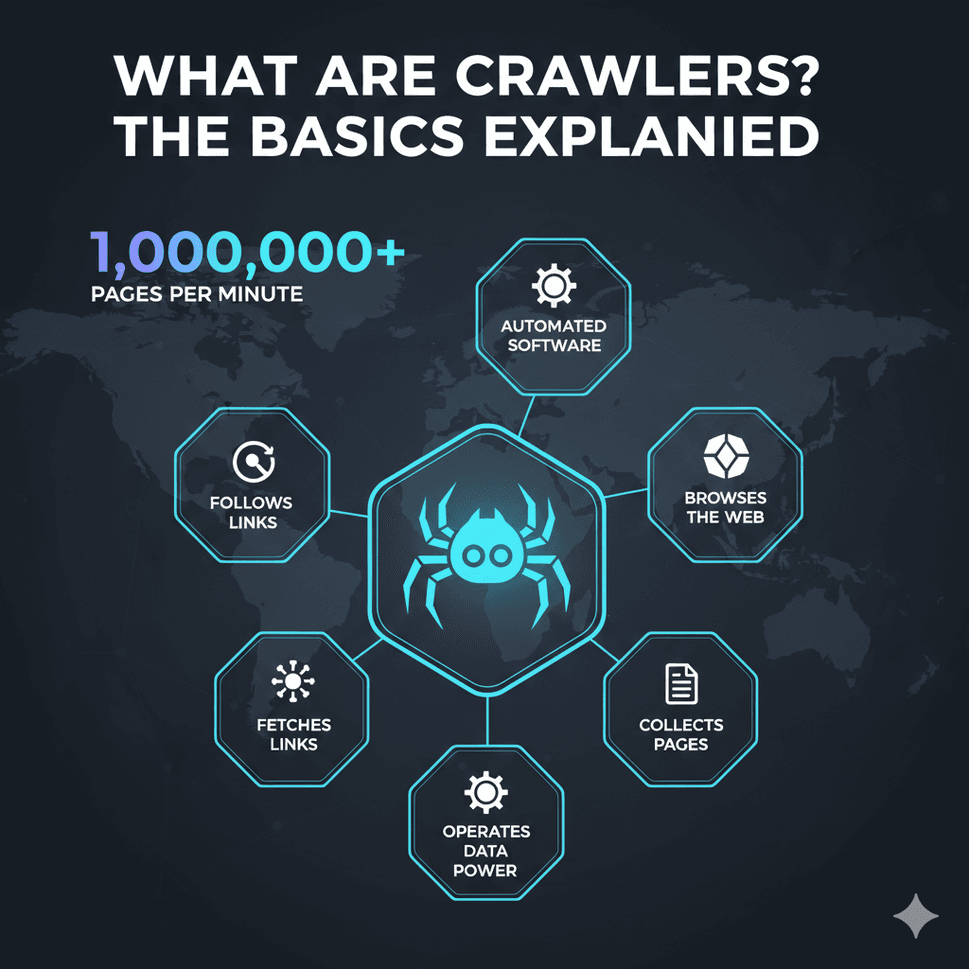

Wat zijn crawlers? De basis uitgelegd

Wat zijn crawlers nou eigenlijk? Kort gezegd is een crawler (ook wel spider of bot genoemd) een stukje software dat automatisch websites bezoekt, pagina’s ophaalt, links volgt en onderweg informatie verzamelt. Zie crawlers als onvermoeibare bibliothecarissen van het internet: ze bezoeken websites, lezen de inhoud en catalogiseren alles zodat het later makkelijk terug te vinden is (, ).

Stel je het web voor als een gigantische stad, en crawlers als koeriers die bij één adres beginnen, noteren wat er te vinden is, en vervolgens elk verkeersbord (hyperlink) volgen naar de volgende plek. Zo bouwen ze een enorme, doorzoekbare kaart van het internet.

Bekende voorbeelden van crawlers zijn Googlebot (voor Google Search), Bingbot (voor Bing), en nieuwe AI-crawlers zoals GPTBot (voor OpenAI’s modellen). Deze bots zijn verantwoordelijk voor het indexeren van honderden miljarden webpagina’s—alleen al de index van Google beslaat meer dan 100 miljoen gigabyte aan opslag (). Zonder crawlers zouden zoekmachines, AI-assistenten en talloze zakelijke tools simpelweg niet werken.

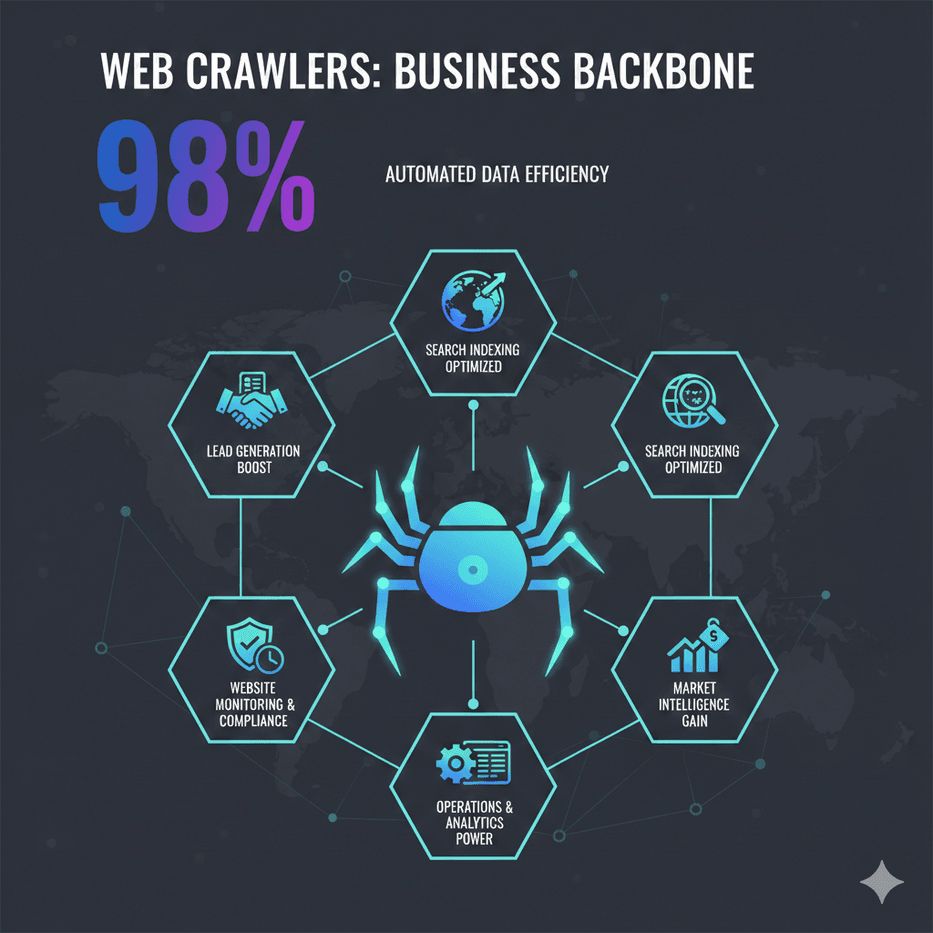

Waarom crawlers belangrijk zijn: functies en zakelijke toepassingen

Crawlers zijn niet alleen voor zoekmachines; ze zijn de stille kracht achter veel moderne bedrijfsprocessen. Dit zijn hun belangrijkste toepassingen:

- Zoekmachine-indexering: Crawlers scannen het web zodat zoekmachines direct relevante resultaten kunnen tonen. Wordt je site niet gecrawld, dan verschijnt hij niet in Google of Bing ().

- Data-extractie & marktanalyse: Bedrijven gebruiken crawlers (en webscrapers) om concurrentieprijzen, productinformatie, reviews en meer te verzamelen. Zo verhoogde de Britse retailer John Lewis zijn omzet met 4% door prijsdata van concurrenten te crawlen, en verdubbelde ASOS de internationale verkoop door regio-specifieke webdata te benutten ().

- Website monitoring & compliance: Crawlers kunnen je eigen of concurrerende websites monitoren op veranderingen—denk aan nieuwe producten, prijsupdates of nalevingscontroles.

- Leadgeneratie: Sales-teams gebruiken crawlers om contactgegevens te verzamelen uit bedrijvengidsen, waardoor handmatig zoekwerk verleden tijd is.

- Operations & analytics: Van voorraadbeheer tot het verzamelen van vastgoedaanbod: crawlers voeden dashboards en analysetools met actuele data voor betere beslissingen.

Hieronder een handig overzicht van crawler-toepassingen per team:

| Team/Functie | Crawler-toepassing | Voordeel |

|---|---|---|

| Sales & Leadgeneratie | Contactgegevens verzamelen van websites of bedrijvengidsen | Automatisch leadlijsten bouwen; groei van de sales pipeline zonder handmatig werk |

| Marketing/Onderzoek | Concurrenten en online reviews monitoren | Directe marktinzichten; betere strategie |

| E-commerce & Retail | Prijzen en producten monitoren bij concurrenten | Dynamische prijsstelling; hogere marges en omzet |

| Operations/Product | Websitewijzigingen detecteren voor compliance of updates | Kwaliteitscontrole; snel reageren op externe veranderingen |

| Data-analyse & AI | Grootschalige dataverzameling voor analyse of AI-training | Data-gedreven inzichten; trainingsmateriaal voor machine learning |

()

Hoe werken crawlers? Stap-voor-stap uitgelegd

Ondanks hun slimme imago is de basisworkflow van een crawler vrij rechttoe rechtaan ():

- Seed-URL’s: Crawlers starten met een lijst van beginadressen (de 'seeds'). Dit kan een homepage, sitemap of een door jou opgegeven lijst zijn.

- Ophalen: De crawler bezoekt elk adres en downloadt de HTML van de pagina (net als je browser).

- Parsen & extractie: De crawler leest de pagina, haalt relevante informatie (zoals tekst, metadata en links) eruit en noteert alle hyperlinks.

- Opslaan & indexeren: De verzamelde data wordt opgeslagen in een database of index, klaar voor zoekopdrachten of analyse.

- Links volgen: Alle nieuwe links worden aan de wachtrij toegevoegd, waarna de crawler het proces herhaalt en zo het web blijft verkennen.

Moderne crawlers houden zich netjes aan de regels: ze checken het robots.txt-bestand van een site om te zien wat ze mogen bezoeken, en beperken hun verzoeken om servers niet te overbelasten (). Zoekmachines hanteren zelfs een 'crawl budget' om te bepalen hoe vaak ze een site opnieuw bezoeken, waarbij belangrijke of vaak geüpdatete pagina’s voorrang krijgen.

Crawlers vs. scrapers: wat is het verschil?

De termen 'crawlen' en 'scrapen' worden vaak door elkaar gebruikt, maar er is een belangrijk verschil ():

- Crawlen draait om ontdekken en indexeren van zoveel mogelijk pagina’s (het web in kaart brengen).

- Scrapen is gericht op het uithalen van specifieke data uit geselecteerde pagina’s (zoals prijzen van een productpagina).

In de praktijk werken ze vaak samen: je crawlt een site om alle productpagina’s te vinden, en scraped vervolgens elke pagina voor details zoals prijs en voorraad. Voor bedrijven is het belangrijk om dit verschil te kennen en zo het juiste gereedschap te kiezen.

Soorten crawlers: van zoekmachines tot AI-gestuurde bots

Niet elke crawler is hetzelfde. Dit zijn de belangrijkste soorten die je tegenkomt ():

- Zoekmachine-crawlers: De grote namen zoals Googlebot, Bingbot, Baidu Spider en Yandex Bot. Hun doel: het hele web indexeren zodat jij kunt zoeken.

- Gerichte crawlers: Gespecialiseerd in het vinden van pagina’s over een bepaald onderwerp (bijvoorbeeld alleen vacaturesites of nieuws over 'klimaatverandering').

- Incrementele crawlers: Gericht op het detecteren en ophalen van alleen nieuwe of gewijzigde content, wat tijd en bandbreedte bespaart.

- Deep web crawlers: Ontworpen om content te bereiken die achter zoekformulieren, logins of verborgen pagina’s zit.

- Site-audit crawlers: Tools zoals Screaming Frog of SEMrush’s Site Audit, die je eigen site crawlen voor SEO of kwaliteitscontroles.

- Vergelijkings-/monitoringcrawlers: Gebruikt door bedrijven om prijzen, productwijzigingen of compliance bij concurrenten te volgen.

- AI-gestuurde crawlers: De nieuwste generatie—zoals OpenAI’s GPTBot of Common Crawl’s CCBot—die data verzamelen voor AI-training of met AI bepalen wat en hoe er gecrawld wordt ().

AI-crawlers veranderen het speelveld razendsnel. In 2025 bestaat al zo’n 30% van het webverkeer uit AI-gerelateerde bots—en dat aandeel groeit snel ().

Uitdagingen van traditionele crawlers en moderne oplossingen

Nu het web steeds complexer wordt, lopen traditionele crawlers tegen flinke obstakels aan:

- Anti-crawlingmaatregelen: CAPTCHAs, IP-blokkades, snelheidslimieten en browser fingerprinting kunnen klassieke bots eenvoudig tegenhouden. Meer dan 95% van de mislukte scrapingpogingen komt door anti-botmaatregelen ().

- Dynamische content: Veel sites laden data via JavaScript of oneindig scrollen, wat basis-crawlers niet aankunnen. Headless browsers en AI-analyse zijn nu onmisbaar ().

- Regelmatige site-updates: Als een site zijn lay-out aanpast, werken traditionele scrapers vaak niet meer en zijn handmatige aanpassingen nodig. Onderhoud is een doorlopende uitdaging.

- Schaal en snelheid: Miljoenen pagina’s snel crawlen vereist gedistribueerde systemen en cloudinfrastructuur—veel meer dan een enkele laptop aankan.

- Juridische en ethische kwesties: Het respecteren van

robots.txt, privacywetgeving en gebruiksvoorwaarden is belangrijker dan ooit.

Moderne oplossingen—waaronder AI-gestuurde tools—spelen hierop in. Ze gebruiken machine learning om zich aan te passen aan veranderende lay-outs, bootsen echte browsers na en kunnen pagina’s zelfs interpreteren zoals een mens dat zou doen. Zo kunnen AI-webscrapers nu data halen uit PDF’s, afbeeldingen of niet-standaard webpagina’s, waardoor ze veel flexibeler en robuuster zijn.

Thunderbit: crawlers geoptimaliseerd voor het web van nu

Hier komt Thunderbit om de hoek kijken. Bij hebben we een AI-webscraper en crawler ontwikkeld die is gemaakt voor het chaotische, steeds veranderende web van 2025. Ons doel? Webdata toegankelijk maken voor iedereen, niet alleen voor ontwikkelaars.

Wat maakt Thunderbit uniek?

- AI-gestuurde eenvoud: Klik op “AI Suggest Fields” en Thunderbit’s AI scant de pagina, stelt de beste datakolommen voor (zoals “Productnaam”, “Prijs”, “Beoordeling”) en zet de extractie voor je klaar. Geen code, geen HTML-gedoe—gewoon klikken en starten ().

- Kan overweg met complexe & nichepagina’s: Thunderbit’s AI past zich aan aan ongewone lay-outs, dynamische content en zelfs niet-standaard pagina’s. Ideaal voor data van nichewebsites of pagina’s waar traditionele scrapers vastlopen.

- Subpagina’s & paginering crawlen: Details nodig van elke productpagina in een categorie? Thunderbit volgt automatisch links, crawlt subpagina’s en voegt alles samen in één tabel—zonder handmatige instellingen ().

- Cloud- & browsermodus: Kies voor snelle cloud scraping bij openbare sites, of browsermodus voor sites met login of extra beveiliging.

- Gratis data-export: Exporteer je data direct naar Excel, Google Sheets, Airtable of Notion—zonder verborgen kosten ().

- No-code, klaar voor zakelijk gebruik: Thunderbit is gemaakt voor zakelijke gebruikers—sales, marketing, e-commerce en operations—die gewoon resultaat willen, zonder technische kennis van webscraping.

Thunderbit vs. traditionele crawlers: vergelijking van functies

Zo verhoudt Thunderbit zich tot klassieke tools:

| Functie | Thunderbit (AI-gestuurd) | Traditionele crawlers/scrapers |

|---|---|---|

| Installatietijd | 2 klikken met AI | Handmatige configuratie, steile leercurve |

| Aanpassingsvermogen | AI past zich aan sitewijzigingen aan | Werkt niet meer bij lay-outwijzigingen |

| Kan dynamische content aan | Ja (AI & headless browser) | Beperkt of handmatig instellen nodig |

| Subpagina’s/paginering crawlen | Ingebouwd, automatisch | Handmatig scripten vereist |

| Data-export | Gratis naar Excel, Sheets, Notion | Vaak beperkt of betaald |

| Benodigde gebruikersvaardigheid | Geen (no-code) | Programmeer- of technische kennis nodig |

| Onderhoud | Minimaal (AI leert bij) | Regelmatig handmatig aanpassen |

| Templates voor populaire sites | 1 klik, altijd actueel | Community/shared, mogelijk verouderd |

| Prijs | Gratis instap, betaalbare abonnementen | Vaak duur voor volledige functies |

()

Thunderbit van binnenuit: slimme functies die crawlen eenvoudig maken

Wat maakt Thunderbit zo krachtig?

- AI Suggest Fields: Mijn persoonlijke favoriet. Eén klik en Thunderbit’s AI leest de pagina, stelt de meest relevante kolommen voor en maakt zelfs extractieprompts aan. Nooit meer gokken welke selector je moet gebruiken.

- Subpagina’s crawlen: Na het scrapen van een lijstpagina klik je op “Scrape Subpages” en Thunderbit bezoekt automatisch elke gelinkte pagina (zoals productdetails) en verrijkt je tabel.

- Directe templates: Voor populaire sites (Amazon, Zillow, Instagram, Shopify) biedt Thunderbit 1-klik-templates—geen gedoe, direct resultaat.

- Gratis e-mail-, telefoon- en afbeelding-extractors: Alle e-mails of afbeeldingen van een pagina halen? Thunderbit doet het met één klik, gratis.

- Geplande scraping: Stel terugkerende scrapes in (dagelijks, wekelijks, etc.) in gewoon Nederlands. Ideaal voor prijsmonitoring of marktanalyse.

- Cloud vs. browser scraping: Kies de modus die bij je past—cloud voor snelheid, browser voor lastige sites.

Thunderbit wordt wereldwijd vertrouwd door meer dan 30.000 gebruikers, van solo-ondernemers tot grote bedrijven (). En ja, er is een zodat je het zonder risico kunt proberen.

Crawler-toegang beheren: best practices voor bedrijven

Of je nu een website beheert of crawlers gebruikt, goed toegangsbeheer is essentieel:

Voor website-eigenaren:

- Gebruik

robots.txtom regels op te stellen—blokkeer gevoelige delen, sta zoekbots toe, houd ongewenste crawlers buiten (). - Voeg meta-tags toe (

noindex,nofollow) om te bepalen wat geïndexeerd mag worden. - Monitor botverkeer en pas crawl rates aan indien nodig.

- Vind de balans tussen SEO (vindbaarheid) en contentbescherming—blokkeer niet de bots die je juist wilt (zoals Googlebot).

Voor bedrijven die crawlers inzetten:

- Respecteer altijd

robots.txten de gebruiksvoorwaarden van sites—ethisch crawlen is cruciaal. - Identificeer je bot met een duidelijke user-agent.

- Beperk het aantal verzoeken om servers niet te belasten.

- Gebruik waar mogelijk API’s en scrape alleen openbare data.

- Houd het effect van je crawler in de gaten en stuur bij waar nodig.

Conclusie: de veranderende rol van crawlers in zakelijke datastrategie

Crawlers zijn uitgegroeid van simpele 'spinnen' tot de ruggengraat van zoekmachines, AI en business intelligence. In een wereld die steeds meer draait om data, kan inzicht in crawlers—en het gebruik van moderne, AI-gestuurde tools zoals Thunderbit—nieuwe kansen openen voor elk team. Of je nu je SEO wilt verbeteren, onderzoek wilt automatiseren of slimmere salesprocessen wilt bouwen: crawlers zijn je stille kracht.

En naarmate het web blijft groeien en veranderen, zijn het de bedrijven die deze tools slim en verantwoord inzetten die het verschil maken. Benieuwd wat AI-crawling voor jouw organisatie kan betekenen? en ontdek het zelf. Meer praktische tips en verdiepende artikelen vind je op de .

Veelgestelde vragen

1. Wat is een webcrawler, simpel uitgelegd?

Een webcrawler is een softwareprogramma dat automatisch het internet afstruint, websites bezoekt, links volgt en informatie verzamelt. Zie het als een digitale bibliothecaris die webpagina’s catalogiseert zodat zoekmachines ze kunnen vinden of bedrijven ze kunnen gebruiken.

2. Hoe verschillen crawlers van scrapers?

Crawlers zijn gericht op het ontdekken en indexeren van zoveel mogelijk pagina’s (het web in kaart brengen), terwijl scrapers specifieke data uit geselecteerde pagina’s halen. In de praktijk werken ze vaak samen: crawlen om pagina’s te vinden, scrapen om de details te verzamelen.

3. Waarom gebruiken bedrijven crawlers?

Bedrijven zetten crawlers in voor uiteenlopende doelen: van SEO (zorgen dat hun site wordt geïndexeerd) tot concurrentieanalyse (prijzen of productwijzigingen volgen), leadgeneratie, marktonderzoek en het automatiseren van dataverzameling voor analytics of AI.

4. Tegen welke uitdagingen lopen traditionele crawlers aan?

Traditionele crawlers hebben moeite met anti-botmaatregelen (CAPTCHAs, IP-blokkades), dynamische content (JavaScript, infinite scroll), frequente sitewijzigingen en juridische/ethische beperkingen. Moderne AI-tools zoals Thunderbit zijn ontwikkeld om deze obstakels te overwinnen.

5. Hoe maakt Thunderbit crawlen makkelijker voor zakelijke gebruikers?

Thunderbit gebruikt AI om automatisch de structuur van webpagina’s te herkennen, stelt datavelden voor en regelt complexe taken zoals subpagina’s crawlen en dynamische content. Het is no-code, snel op te zetten en exporteert data direct naar je favoriete tools—zo wordt webdata toegankelijk voor iedereen, niet alleen voor ontwikkelaars.

Wil je crawlers inzetten voor jouw bedrijf? en ontdek hoe eenvoudig webdata kan zijn.

Meer weten?