Het web barst van de waardevolle data—of je nu in sales, e-commerce of marktonderzoek zit, webscraping is dé geheime kracht voor het verzamelen van leads, prijsvergelijkingen en concurrentie-inzicht. Maar er zit een addertje onder het gras: nu steeds meer bedrijven aan de slag gaan met scrapen, worden websites steeds slimmer in het weren van bots. Meer dan , en zijn inmiddels standaard. Heb je ooit meegemaakt dat je Python-script twintig minuten perfect draait, om vervolgens alleen nog maar 403-fouten te krijgen? Dan weet je hoe frustrerend het kan zijn.

Na jaren in SaaS en automatisering heb ik gezien hoe een scrapingproject in een mum van tijd kan omslaan van “dit is een eitje” naar “waarom word ik overal geblokkeerd?”. Tijd voor praktische tips: ik laat je zien hoe je in Python webscraping aanpakt zonder geblokkeerd te worden, deel de beste technieken en codevoorbeelden, en vertel wanneer het slim is om AI-gedreven alternatieven zoals te overwegen. Of je nu een Python-pro bent of net begint, na deze gids heb je een toolkit voor betrouwbare, blokkadevrije data-extractie.

Wat is webscraping zonder blokkades in Python?

Heel simpel gezegd betekent webscraping zonder blokkades dat je data van websites haalt zonder dat je wordt opgemerkt door hun anti-botsystemen. In Python komt er dus meer bij kijken dan alleen een simpele requests.get()-loop—je moet je gedragen als een echte bezoeker en de detectiesystemen steeds een stap voor zijn.

Waarom Python? —dankzij de makkelijke syntax, het enorme ecosysteem (requests, BeautifulSoup, Scrapy, Selenium) en de flexibiliteit voor alles van snelle scripts tot grote crawlers. Maar die populariteit heeft ook een keerzijde: veel anti-botsystemen zijn inmiddels getraind om Python-scraping te herkennen.

Wil je dus betrouwbaar scrapen, dan moet je verder gaan dan de basis. Dat betekent: snappen hoe sites bots detecteren, en weten hoe je daar slim omheen werkt—zonder ethische of juridische grenzen te overschrijden.

Waarom blokkades voorkomen belangrijk is bij Python webscraping

Geblokkeerd worden is niet zomaar een technisch probleem—het kan je hele bedrijfsproces in de war schoppen. Even op een rijtje:

| Toepassing | Gevolg van blokkade |

|---|---|

| Leadgeneratie | Onvolledige of verouderde prospectlijsten, misgelopen omzet |

| Prijsmonitoring | Gemiste prijswijzigingen bij concurrenten, verkeerde prijsbeslissingen |

| Contentaggregatie | Hiaten in nieuws, reviews of onderzoeksdata |

| Marktinformatie | Onvolledig zicht op concurrenten of sector |

| Vastgoedaanbod | Onjuiste of verouderde woningdata, gemiste kansen |

Als je webscraper wordt geblokkeerd, mis je niet alleen data—je verspilt ook tijd, loopt risico op complianceproblemen en neemt mogelijk verkeerde beslissingen op basis van onvolledige informatie. In een wereld waarin , is betrouwbaarheid alles.

Hoe websites Python webscrapers detecteren en blokkeren

Websites zijn steeds slimmer geworden in het herkennen van bots. Dit zijn de meest voorkomende anti-scrapingmaatregelen (, ):

- IP-adres blokkeren: Te veel verzoeken vanaf één IP? Je ligt eruit.

- User-Agent en header checks: Verzoeken met standaard of ontbrekende headers (zoals Python’s

python-requests/2.25.1) vallen direct op. - Rate limiting: Te veel verzoeken in korte tijd? Dan volgt throttling of een ban.

- CAPTCHAs: “Bewijs dat je mens bent”-puzzels waar bots moeite mee hebben.

- Gedragsanalyse: Sites letten op robotachtig gedrag, zoals steeds op hetzelfde moment klikken.

- Honeypots: Verborgen links of velden die alleen bots invullen.

- Browser fingerprinting: Details over je browser en apparaat verzamelen om automatisering te herkennen.

- Cookie- en sessietracking: Bots die cookies of sessies niet goed afhandelen, vallen door de mand.

Zie het als luchthavenbeveiliging: als je je normaal gedraagt, loop je zo door. Val je op, dan word je extra gecontroleerd.

Essentiële Python-technieken voor webscraping zonder blokkades

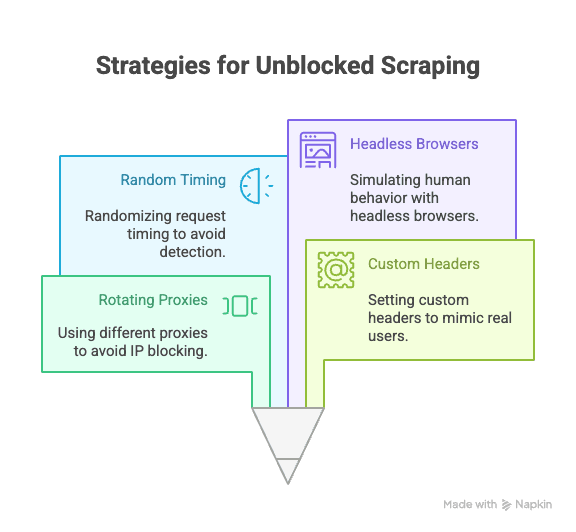

Tijd voor de praktijk: hoe voorkom je blokkades bij scrapen met Python? Dit zijn de belangrijkste strategieën:

Proxies en IP-adressen roteren

Waarom belangrijk: Als al je verzoeken van hetzelfde IP komen, ben je een makkelijk doelwit. Met roterende proxies verspreid je je verzoeken over meerdere IP’s, waardoor blokkades veel lastiger worden.

Zo doe je het in Python:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...meer proxies

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # verwerk responseVoor meer betrouwbaarheid kun je betaalde proxyservices gebruiken (zoals residentiële of roterende proxies) ().

User-Agent en headers instellen

Waarom belangrijk: Standaardheaders van Python verraden je direct als bot. Doe je voor als een echte browser door user-agent en andere headers aan te passen.

Voorbeeldcode:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Wissel regelmatig van user-agent voor extra camouflage ().

Verzoektiming en patronen randomiseren

Waarom belangrijk: Bots zijn snel en voorspelbaar; mensen zijn traag en willekeurig. Voeg vertragingen toe en varieer je klik- en navigeergedrag.

Python-tip:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # Wacht 2–7 secondenGebruik je Selenium, randomiseer dan ook klikpaden en scrollgedrag.

Cookies en sessies beheren

Waarom belangrijk: Veel sites vereisen cookies of sessietokens voor toegang. Bots die dit negeren, worden snel geblokkeerd.

Zo regel je het in Python:

1import requests

2session = requests.Session()

3response = session.get(url)

4# session regelt cookies automatischVoor complexere flows kun je met Selenium cookies ophalen en hergebruiken.

Menselijk gedrag simuleren met headless browsers

Waarom belangrijk: Sommige sites letten op JavaScript, muisbewegingen of scrollen als teken van echte gebruikers. Headless browsers zoals Selenium of Playwright kunnen dit nabootsen.

Voorbeeld met Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))Hiermee omzeil je gedragsanalyse en dynamische content ().

Geavanceerde strategieën: CAPTCHAs en honeypots omzeilen in Python

CAPTCHAs zijn bedoeld om bots te stoppen. Sommige Python-libraries kunnen simpele CAPTCHAs oplossen, maar voor serieuze scrapingprojecten gebruik je vaak externe diensten (zoals 2Captcha of Anti-Captcha) die dit tegen betaling voor je doen ().

Voorbeeldintegratie:

1# Pseudocode voor 2Captcha API

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Wacht op oplossing, voeg toe aan je verzoekHoneypots zijn verborgen velden of links die alleen bots invullen. Klik of verstuur nooit iets dat je niet in een echte browser ziet ().

Slimme request headers ontwerpen met Python-libraries

Naast user-agent kun je ook andere headers (zoals Referer, Accept, Origin, etc.) roteren en randomiseren om minder op te vallen.

Met Scrapy:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # Meer headers

7 }

8 }Met Selenium: Gebruik browserprofielen of extensies om headers te zetten, of injecteer ze via JavaScript.

Houd je headerlijst actueel—kopieer echte browserverzoeken via DevTools voor inspiratie.

Wanneer traditionele Python-scraping niet meer volstaat: de opkomst van anti-bottechnologie

De realiteit: hoe populairder scraping wordt, hoe geavanceerder de anti-botmaatregelen. . AI-gedreven detectie, dynamische limieten en browser fingerprinting maken het steeds lastiger om onopgemerkt te blijven, zelfs met slimme Python-scripts ().

Soms loop je, hoe slim je code ook is, toch tegen een muur. Dan is het tijd voor een andere aanpak.

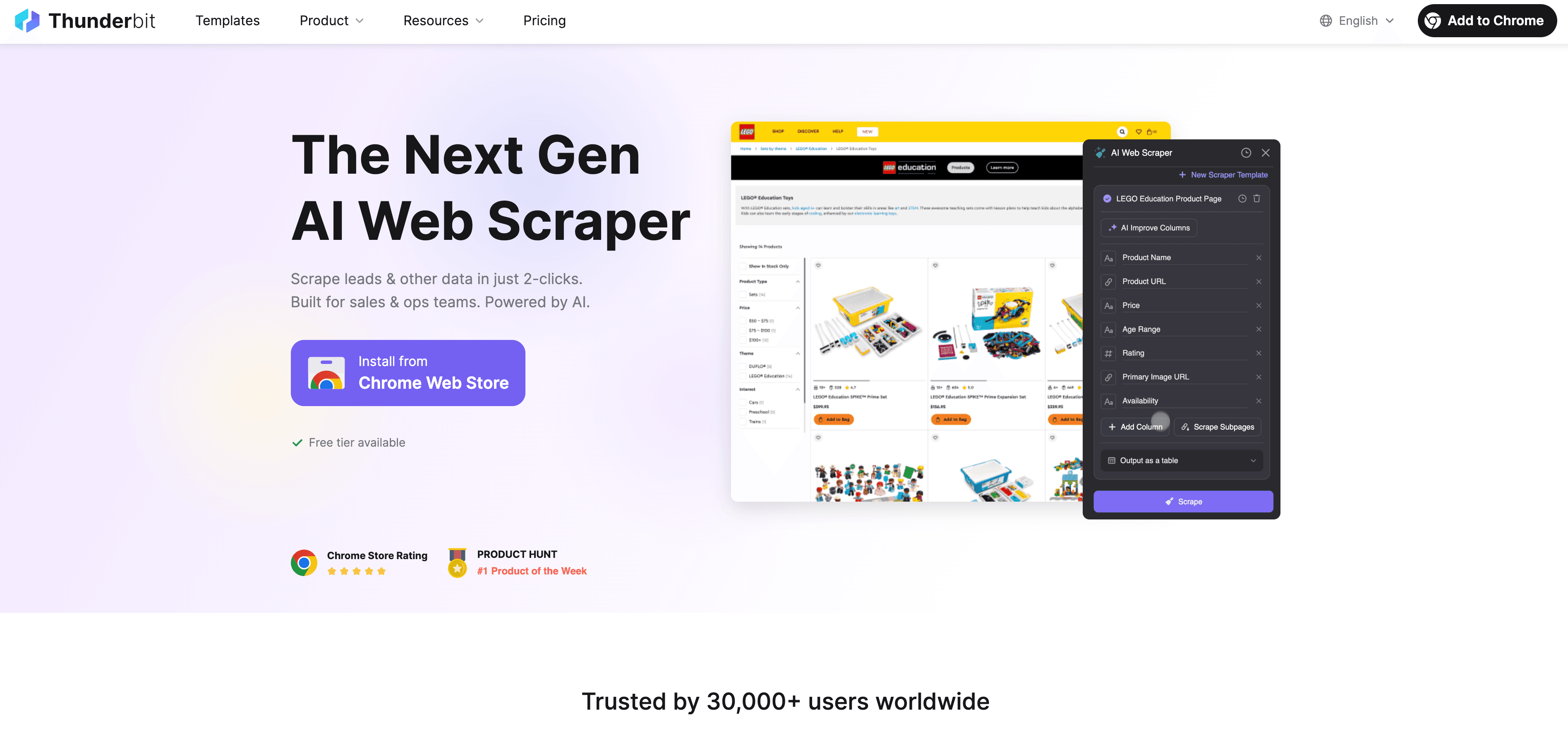

Thunderbit: een AI-webscraper als alternatief voor Python-scraping

Als Python zijn grenzen bereikt, biedt uitkomst: een no-code, AI-gedreven webscraper speciaal voor zakelijke gebruikers. Geen gedoe meer met proxies, headers of CAPTCHAs—de AI-agent van Thunderbit leest de website, stelt de beste velden voor en regelt alles van subpagina’s tot data-export.

Wat maakt Thunderbit uniek?

- AI-veldherkenning: Klik op “AI Suggest Fields” en Thunderbit scant de pagina, doet kolomvoorstellen en genereert extractie-instructies.

- Subpagina’s scrapen: Thunderbit bezoekt automatisch subpagina’s (zoals productdetails of LinkedIn-profielen) en vult je tabel aan.

- Cloud- of browserscraping: Kies de snelste optie—cloud voor openbare sites, browser voor pagina’s achter een login.

- Geplande scraping: Stel een schema in en je data blijft altijd up-to-date.

- Directe sjablonen: Voor populaire sites (Amazon, Zillow, Shopify, enz.) zijn er 1-klik sjablonen—geen configuratie nodig.

- Gratis data-export: Exporteer naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

Thunderbit wordt vertrouwd door meer dan , en je hoeft geen regel code te schrijven.

Hoe Thunderbit blokkades voorkomt en data-extractie automatiseert

De AI van Thunderbit doet meer dan menselijk gedrag nadoen—het past zich in realtime aan elke site aan, waardoor de kans op blokkades flink afneemt. Zo werkt het:

- AI past zich aan bij lay-outwijzigingen: Geen kapotte scripts meer als een site het design aanpast.

- Subpagina’s en paginering: Thunderbit volgt automatisch links en doorzoekt paginaties, net als een echte gebruiker.

- Cloudscraping op schaal: Scrape tot 50 pagina’s tegelijk, razendsnel.

- Geen code, geen onderhoud: Besteed je tijd aan analyse, niet aan debuggen.

Meer weten? Lees .

Python-scraping versus Thunderbit: wat kies je?

Een vergelijking op een rij:

| Functie | Python-scraping | Thunderbit |

|---|---|---|

| Installatietijd | Gemiddeld–hoog (scripts, proxies, etc.) | Laag (2 klikken, AI doet de rest) |

| Technische kennis | Programmeren vereist | Geen code nodig |

| Betrouwbaarheid | Variabel (breekt snel) | Hoog (AI past zich aan) |

| Kans op blokkades | Gemiddeld–hoog | Laag (AI imiteert gebruiker, past zich aan) |

| Schaalbaarheid | Eigen code/cloud nodig | Ingebouwde cloud/batchscraping |

| Onderhoud | Regelmatig (sitewijzigingen, blokkades) | Minimaal (AI past zich automatisch aan) |

| Exportopties | Handmatig (CSV, DB) | Direct naar Sheets, Notion, Airtable, CSV |

| Kosten | Gratis (maar tijdrovend) | Gratis tier, betaalde plannen voor schaal |

Wanneer kies je voor Python:

- Je wilt volledige controle, eigen logica of integratie met andere Python-workflows.

- Je scrape’t sites met weinig anti-botmaatregelen.

Wanneer kies je voor Thunderbit:

- Je wilt snelheid, betrouwbaarheid en geen gedoe met instellen.

- Je scrape’t complexe of vaak veranderende sites.

- Je wilt niet bezig zijn met proxies, CAPTCHAs of code.

Stappenplan: webscraping zonder blokkades in Python

Een praktisch voorbeeld: productdata scrapen van een voorbeeldsite, mét anti-blokkade best practices.

1. Installeer de benodigde libraries

1pip install requests beautifulsoup4 fake-useragent2. Schrijf je script

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Vervang door je eigen URLs

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Data extractie hier

16 print(soup.title.text)

17 else:

18 print(f"Geblokkeerd of fout bij {url}: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Willekeurige vertraging3. Voeg proxyrotatie toe (optioneel)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Meer proxies

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...rest van de code4. Cookies en sessies afhandelen

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...rest van de code5. Tips bij problemen

- Zie je veel 403/429-fouten? Vertraag je verzoeken of probeer andere proxies.

- Krijg je CAPTCHAs? Gebruik Selenium of een CAPTCHA-oplossingsdienst.

- Controleer altijd het

robots.txt-bestand en de gebruiksvoorwaarden van de site.

Conclusie & belangrijkste inzichten

Webscraping met Python is krachtig—maar blokkades liggen altijd op de loer door steeds slimmere anti-bottechnologie. De beste aanpak? Combineer technische best practices (proxies roteren, slimme headers, willekeurige vertragingen, sessiebeheer en headless browsers) met respect voor de regels en ethiek van de site.

Maar soms zijn zelfs de beste Python-trucs niet genoeg. Dan bieden AI-tools zoals uitkomst: geen code, bestand tegen blokkades en ideaal voor zakelijk gebruik.

Zelf ervaren hoe makkelijk scrapen kan zijn? en probeer het zelf—of check onze voor meer scraping-tips en tutorials.

Veelgestelde vragen

1. Waarom blokkeren websites Python-webscrapers?

Websites blokkeren scrapers om hun data te beschermen, overbelasting te voorkomen en misbruik van hun diensten tegen te gaan. Python-scripts zijn makkelijk te herkennen als ze standaardheaders gebruiken, geen cookies verwerken of te snel verzoeken sturen.

2. Wat zijn de beste manieren om blokkades te voorkomen bij scrapen met Python?

Gebruik roterende proxies, stel realistische user-agent en headers in, randomiseer je verzoeken, beheer cookies/sessies en simuleer menselijk gedrag met tools als Selenium of Playwright.

3. Hoe helpt Thunderbit blokkades te voorkomen in vergelijking met Python-scripts?

Thunderbit gebruikt AI om zich aan te passen aan site-layouts, menselijk surfgedrag na te bootsen en automatisch subpagina’s en paginering te verwerken. Zo wordt de kans op blokkades kleiner—zonder code of proxies.

4. Wanneer kies ik voor Python-scraping en wanneer voor een AI-tool als Thunderbit?

Gebruik Python als je maatwerk nodig hebt, wilt integreren met andere Python-code of simpele sites scrape’t. Kies Thunderbit voor snelle, betrouwbare en schaalbare scraping—vooral bij complexe, veranderlijke of streng beveiligde sites.

5. Is webscraping legaal?

Webscraping is toegestaan voor publiek toegankelijke data, maar je moet altijd de gebruiksvoorwaarden, privacyregels en wetgeving respecteren. Scrape nooit gevoelige of privégegevens en gebruik scraping altijd op een verantwoorde manier.

Slimmer scrapen, niet harder? Probeer Thunderbit en laat blokkades achter je.

Meer weten:

- Google News scrapen met Python: een stapsgewijze handleiding

- Een prijsmonitor bouwen voor Best Buy met Python

- 14 manieren om te scrapen zonder geblokkeerd te worden

- 10 beste tips om blokkades bij webscraping te voorkomen