Webscraping is tegenwoordig hét geheime wapen voor teams die een stapje voor willen zijn—of je nu in sales, operations, e-commerce of vastgoed werkt. Het internet staat bomvol waardevolle data, maar die informatie eruit halen—vooral bij dynamische en interactieve websites—is vaak een flinke klus. Naar verwachting zal webscraping in 2025 wereldwijd bijna waard zijn, en gebruikt data-analyse om beslissingen te nemen. Maar er zit een addertje onder het gras: naarmate websites steeds slimmer worden—denk aan eindeloos scrollen, pop-ups en content die via JavaScript wordt geladen—lopen traditionele scrapingtools vaak vast.

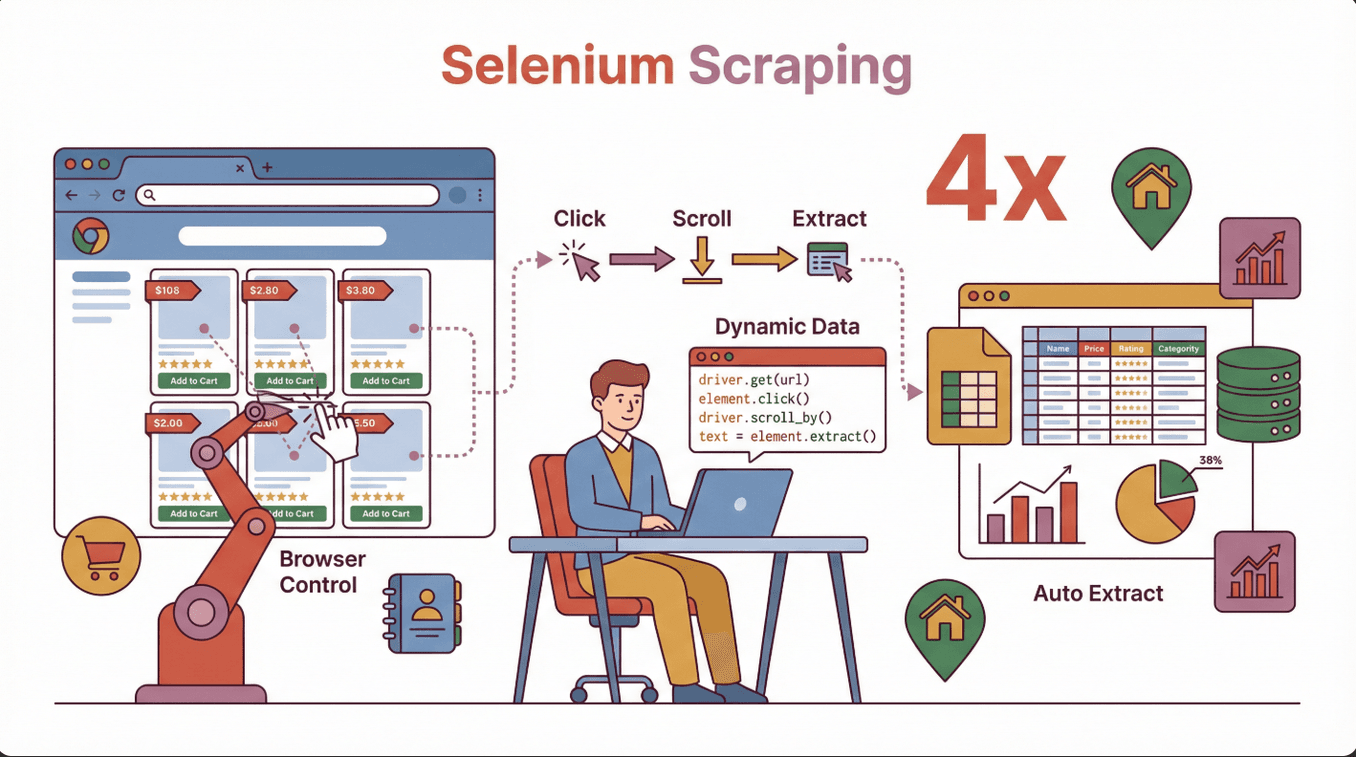

En daar komt Selenium om de hoek kijken. Selenium is eigenlijk het Zwitserse zakmes onder de webscrapingtools: je automatiseert echte browseracties en kunt zelfs de lastigste, dynamische websites uitlezen. Heb je ooit gewenst dat je gewoon als een echte gebruiker door een site kon klikken en de data kon pakken? Dan is Selenium jouw nieuwe beste maatje. In deze gids leer je stap voor stap hoe je webscraping met Selenium onder de knie krijgt—en je hoeft er echt geen IT-nerd voor te zijn.

Wat is webscraping met Selenium? Een toegankelijke introductie

Heel simpel gezegd: webscraping met Selenium betekent dat je met de Selenium-bibliotheek een echte webbrowser (zoals Chrome of Firefox) bestuurt via code, en zo menselijke handelingen nadoet—knoppen aanklikken, formulieren invullen, scrollen, noem maar op. In tegenstelling tot traditionele scrapers die alleen statische HTML lezen, kan Selenium websites benaderen zoals jij dat doet. Ideaal dus voor het verzamelen van data van pagina’s die hun inhoud dynamisch laden via JavaScript.

Heel simpel gezegd: webscraping met Selenium betekent dat je met de Selenium-bibliotheek een echte webbrowser (zoals Chrome of Firefox) bestuurt via code, en zo menselijke handelingen nadoet—knoppen aanklikken, formulieren invullen, scrollen, noem maar op. In tegenstelling tot traditionele scrapers die alleen statische HTML lezen, kan Selenium websites benaderen zoals jij dat doet. Ideaal dus voor het verzamelen van data van pagina’s die hun inhoud dynamisch laden via JavaScript.

Zakelijke toepassingen waar Selenium uitblinkt:

- E-commerce: Productinformatie, prijzen en reviews verzamelen van sites die data pas tonen als je scrolt.

- Sales & leadgeneratie: Contactgegevens halen uit directories waarvoor je moet inloggen of meerdere stappen moet doorlopen.

- Vastgoed: Woningen en panden verzamelen van interactieve kaarten of lijsten achter pop-ups.

- Marktonderzoek: Concurrentiedata verzamelen van moderne, app-achtige websites.

Heb je ooit geprobeerd een site te scrapen en miste je de helft van de info? Grote kans dat de data pas na het laden van de pagina verscheen—Selenium lost dit op door te wachten, klikken en interacteren als een echte gebruiker ().

Waarom Selenium kiezen voor webscraping? Je opties vergeleken

Er zijn veel webscrapingtools—BeautifulSoup, Scrapy, , en meer. Waarom zou je dan Selenium kiezen? Hier de belangrijkste verschillen:

| Tool | Ideaal voor | Kan JavaScript aan? | Interactiviteit | Snelheid | Gebruiksgemak |

|---|---|---|---|---|---|

| Selenium | Dynamische, interactieve sites | Ja | Volledig | Langzamer | Gemiddeld |

| BeautifulSoup | Simpele, statische HTML-pagina’s | Nee | Geen | Snel | Makkelijk |

| Scrapy | Grootschalige, statische of semi-dynamische sites | Beperkt (met plugins) | Beperkt | Zeer snel | Gemiddeld |

| Thunderbit | Snel, no-code extractie voor bedrijven | Ja (AI-ondersteund) | Beperkt | Snel | Zeer makkelijk |

Sterke punten van Selenium:

- Perfect voor sites met veel JavaScript, eindeloos scrollen en pop-ups.

- Kan inloggen, knoppen aanklikken en formulieren invullen—net als een mens.

- Ideaal voor data die pas zichtbaar wordt na interactie.

Wanneer Selenium gebruiken:

- De data verschijnt pas na het laden van de pagina (bijvoorbeeld via JavaScript).

- Je moet interacteren met de site (inloggen, klikken, scrollen).

- De site gebruikt complexe layouts of is een Single Page Application (SPA).

Wanneer iets anders kiezen:

- De site is statisch en eenvoudig—BeautifulSoup of Scrapy zijn dan sneller.

- Je wilt een no-code, gebruiksvriendelijke tool—Thunderbit is ideaal voor snelle klussen ().

Selenium installeren en instellen: zo geregeld

Aan de slag gaan met Selenium lijkt misschien ingewikkeld, maar het valt reuze mee. Zo zet je alles snel op:

1. Installeer Python (als je dat nog niet hebt)

De meeste Selenium-tutorials gebruiken Python, maar het werkt ook met Java, C# en andere talen. Download Python via .

2. Installeer Selenium via pip

Open je terminal of opdrachtprompt en voer uit:

1pip install selenium()

3. Download de browserdriver

Selenium heeft een “driver” nodig om je browser te besturen. Voor Chrome is dat ChromeDriver, voor Firefox GeckoDriver.

- Check je browserversie: Open Chrome en ga naar

chrome://settings/help. - Download de juiste driver: Haal .

- Pak de driver uit en plaats hem: Zet de driver in een map en voeg het pad toe aan je systeemvariabelen (PATH).

Tip: De driver moet exact overeenkomen met je browserversie. Anders krijg je foutmeldingen zoals chromedriver executable needs to be available in the path ().

4. Test je installatie

Probeer dit in Python:

1from selenium import webdriver

2driver = webdriver.Chrome() # Of Firefox()

3driver.get("https://www.google.com")

4print(driver.title)

5driver.quit()Als de browser opent en de titel print, werkt alles!

Veelvoorkomende valkuilen:

- PATH niet goed ingesteld—controleer je omgevingsvariabelen.

- Driver/browserversie komt niet overeen—update beide tegelijk.

- Rechten—op Mac/Linux moet je soms

chmod +x chromedriveruitvoeren.

Je eerste Selenium-webscraping script: stap voor stap

We gaan een simpel script schrijven om productnamen te scrapen van een voorbeeld e-commercepagina. Zo pak je het aan:

1. Importeer Selenium en stel de driver in

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()2. Open de gewenste pagina

1driver.get("https://example-ecommerce.com/products")3. Wacht tot de content geladen is (indien nodig)

Voor dynamische content gebruik je een expliciete wacht:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3wait = WebDriverWait(driver, 10)

4wait.until(EC.presence_of_element_located((By.CLASS_NAME, "product-title")))4. Data ophalen

1products = driver.find_elements(By.CLASS_NAME, "product-title")

2for product in products:

3 print(product.text)5. Afronden

1driver.quit()Wat gebeurt er hier? Selenium opent de browser, wacht tot de producten geladen zijn, zoekt alle elementen met de class product-title en print hun tekst.

Praktische tips voor dynamische content scrapen met Selenium

Dynamische websites zijn tegenwoordig de standaard—denk aan eindeloos scrollen, pop-ups en content die pas na een klik verschijnt. Zo pak je dat slim aan:

1. Wachten op elementen

Websites laden niet altijd direct. Gebruik expliciete waits tot de data zichtbaar is:

1wait.until(EC.presence_of_element_located((By.ID, "dynamic-content")))2. Scrollen om meer te laden

Voor pagina’s met eindeloos scrollen:

1driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")Herhaal dit om meer data te laden.

3. Pop-ups afhandelen

Zoek en sluit pop-ups:

1try:

2 close_button = driver.find_element(By.CLASS_NAME, "close-popup")

3 close_button.click()

4except:

5 pass # Geen pop-up gevonden4. Formulieren en knoppen bedienen

Vul zoekvelden in of klik op “volgende” knoppen:

1search_box = driver.find_element(By.NAME, "search")

2search_box.send_keys("laptop")

3search_box.submit()Praktijkvoorbeeld: Vastgoedaanbod scrapen dat pas zichtbaar wordt als je scrolt, of productreviews ophalen die pas na een klik verschijnen.

Veelvoorkomende problemen voorkomen: Selenium troubleshooting

Zelfs ervaren webscrapers lopen soms tegen problemen aan. Dit zijn de meest voorkomende issues—en zo los je ze op:

| Probleem | Oplossing |

|---|---|

| Element niet gevonden | Gebruik waits, check selectors, probeer andere zoekmethodes |

| Timeout-fouten | Verhoog de wachttijd, controleer op trage content |

| CAPTCHA of botdetectie | Vertraag je acties, randomiseer gedrag, gebruik eventueel proxies |

| Driver/browser mismatch | Update beide naar de nieuwste compatibele versies |

| Website-indeling verandert | Update je selectors en test je scripts regelmatig |

| Trage prestaties | Minimaliseer browseracties, gebruik indien mogelijk headless mode |

Tip: Selenium is wat trager dan andere tools omdat het echte gebruikersacties nadoet (). Voor grote projecten kun je beter alternatieven overwegen of je werk verdelen.

Je gescrapete data exporteren en gebruiken

Als je de data eenmaal binnen hebt, wil je die natuurlijk makkelijk kunnen gebruiken. Zo doe je dat:

1. Data opslaan in een lijst of DataFrame

1import pandas as pd

2data = []

3for product in products:

4 data.append({"name": product.text})

5df = pd.DataFrame(data)2. Exporteren naar CSV of Excel

1df.to_csv("products.csv", index=False)

2# Of

3df.to_excel("products.xlsx", index=False)()

3. Integreren met zakelijke tools

- Importeer je CSV in Google Sheets of Airtable.

- Gebruik Zapier of API’s om je datastromen te automatiseren.

Tip: Maak je data schoon voordat je importeert—verwijder onregelmatigheden en vul ontbrekende waarden aan ().

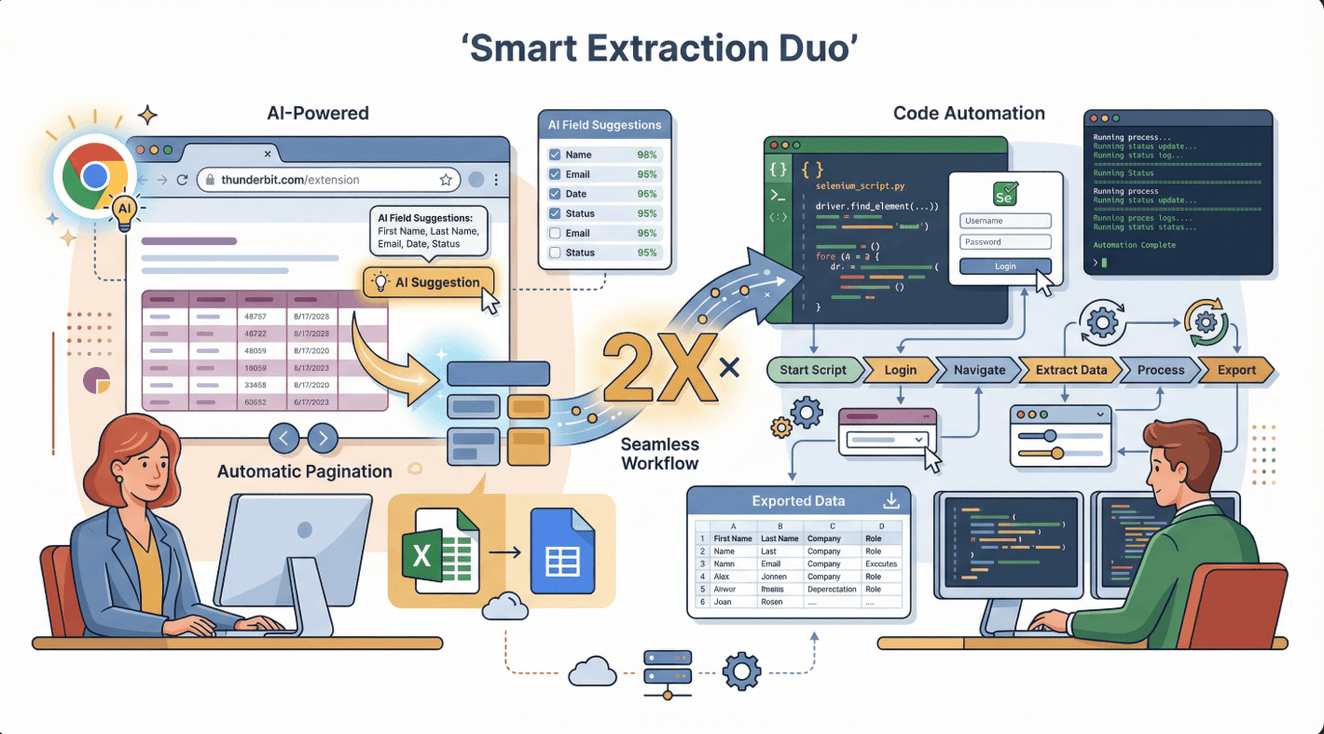

Selenium en Thunderbit: de ideale combinatie voor complexe data-extractie

Laten we eerlijk zijn—Selenium is krachtig, maar niet altijd de snelste of makkelijkste oplossing. Hier komt in beeld. Thunderbit is een AI-webscraper Chrome-extensie waarmee je in een paar klikken data van de meeste websites haalt—zonder code, zonder gedoe.

Laten we eerlijk zijn—Selenium is krachtig, maar niet altijd de snelste of makkelijkste oplossing. Hier komt in beeld. Thunderbit is een AI-webscraper Chrome-extensie waarmee je in een paar klikken data van de meeste websites haalt—zonder code, zonder gedoe.

Hoe werken ze samen?

- Gebruik Thunderbit voor snelle, gestructureerde extractie van tabellen, lijsten of eenvoudige pagina’s. Ideaal voor sales, e-commerce of onderzoeksteams die snel resultaat willen.

- Gebruik Selenium als je complexe interacties moet automatiseren—zoals inloggen, door meerdere stappen klikken of data ophalen die pas na interactie verschijnt.

Pro workflow: Begin met Thunderbit voor het makkelijke werk. Loop je vast (bijvoorbeeld bij een login of interactieve content), schakel dan over op Selenium. Je kunt zelfs data uit Thunderbit exporteren en verder verwerken met Selenium-scripts.

Sterke punten van Thunderbit:

- AI-veldherkenning—klik op “AI Suggest Fields” en de tool doet het werk voor je.

- Kan paginering, subpagina’s en exporteert direct naar Excel, Google Sheets, Notion of Airtable.

- Geen onderhoud nodig—de AI past zich automatisch aan websitewijzigingen aan ().

Blijf binnen de regels: legaal en ethisch webscrapen met Selenium

Webscraping is krachtig, maar brengt ook verantwoordelijkheden met zich mee. Zo blijf je netjes binnen de lijntjes:

1. Check de gebruiksvoorwaarden van de website

Lees altijd de voorwaarden van een site voordat je gaat scrapen. Sommige sites verbieden scraping expliciet, andere staan het toe voor persoonlijk gebruik ().

2. Respecteer robots.txt

Het robots.txt-bestand geeft aan wat je wel en niet mag crawlen of scrapen. Je vindt het op https://website.com/robots.txt ().

3. Vermijd gevoelige of persoonlijke data

Scrape geen gezondheids-, financiële of privé-informatie—dit kan juridische problemen opleveren ().

4. Wees beleefd: beperk je verzoeken en identificeer je scraper

Overbelast servers niet—bouw pauzes in tussen je verzoeken en vermeld waar mogelijk wie je bent.

5. Gebruik officiële API’s als die er zijn

Biedt een site een publieke API? Gebruik die dan—dat is altijd de veiligste en meest betrouwbare optie.

Checklist voor verantwoord scrapen:

- [ ] Lees en volg de voorwaarden en robots.txt van de site.

- [ ] Scrape alleen openbare, niet-gevoelige data.

- [ ] Beperk het aantal verzoeken en verstoor de site niet.

- [ ] Vermeld de bron als dat gevraagd wordt.

- [ ] Blijf op de hoogte van lokale wet- en regelgeving ().

Schalen: wanneer overstappen op andere tools dan Selenium

Selenium is ideaal voor kleine tot middelgrote projecten, maar kent zijn grenzen:

Beperkingen:

- Trager dan andere tools (omdat het een echte browser draait).

- Vraagt veel van je computer—meerdere browsers tegelijk kunnen je systeem vertragen.

- Niet geschikt om razendsnel duizenden pagina’s te scrapen.

Wanneer upgraden:

- Je wilt op grote schaal scrapen (duizenden of miljoenen pagina’s).

- Je wilt scraping automatiseren in de cloud of op vaste tijden.

- Je hebt geavanceerde functies nodig zoals proxyrotatie, retries of gedistribueerd scrapen.

Alternatieven:

- Thunderbit: Voor zakelijke gebruikers die snel, no-code scraping met AI willen ().

- Scrapy: Voor ontwikkelaars die grootschalige, flexibele webscrapers bouwen ().

- Managed APIs: Diensten als ScraperAPI of Apify voor schaalbare, onderhoudsvrije scraping ().

| Tool | Ideaal voor | Voordelen | Nadelen |

|---|---|---|---|

| Selenium | Complexe, interactieve | Kan elke site aan, volledige controle | Traag, zwaar voor je systeem |

| Thunderbit | Snel, zakelijke gebruikers | Geen code, AI, makkelijk exporteren | Minder controle voor gevorderden |

| Scrapy | Grootschalig, dev teams | Snel, schaalbaar, aanpasbaar | Programmeren vereist, minder interactief |

| Managed APIs | Enterprise, automatisering | Schaalbaar, geen onderhoud | Kosten, minder flexibel |

Samenvatting & belangrijkste punten

Webscraping met Selenium is een superkracht voor iedereen die data wil halen van dynamische, interactieve websites. Het is dé tool als je echte gebruikersacties moet nabootsen—klikken, scrollen, inloggen, enzovoort. Onthoud het volgende:

- Selenium is ideaal voor: Dynamische sites, JavaScript-content en interactieve flows.

- Installatietips: Zorg dat je browser- en driverversies overeenkomen, stel PATH goed in en gebruik waits voor dynamische content.

- Combineer met Thunderbit: Gebruik Thunderbit voor snelle, no-code scraping; schakel over op Selenium voor complexe processen.

- Blijf compliant: Check altijd de voorwaarden, robots.txt en vermijd gevoelige data.

- Slim opschalen: Voor grote projecten zijn managed APIs of cloudtools een betere keuze.

Begin je net? Probeer een simpel Selenium-script om productnamen of prijzen te scrapen. Test daarna Thunderbit voor je volgende zakelijke dataproject—het is gratis te proberen en bespaart je uren handmatig werk ().

Meer leren? Bekijk de voor meer webscrapinggidsen, of abonneer je op ons voor stap-voor-stap video’s.

Veelgestelde vragen

1. Wat maakt Selenium anders dan andere webscrapingtools?

Selenium bestuurt een echte browser, waardoor het kan omgaan met dynamische, JavaScript-rijke sites—iets wat traditionele scrapers zoals BeautifulSoup niet kunnen. Ideaal voor sites waar je moet klikken of inloggen.

2. Wat zijn de meest voorkomende fouten bij het instellen van Selenium?

De grootste valkuilen zijn niet-overeenkomende browser- en driverversies, het niet toevoegen van de driver aan je PATH, en geen waits gebruiken voor dynamische content. Controleer altijd de versies en gebruik expliciete waits.

3. Kan ik Selenium en Thunderbit samen gebruiken?

Zeker. Thunderbit is perfect voor snelle, no-code scraping, terwijl Selenium complexe, interactieve flows aankan. Veel teams gebruiken Thunderbit voor eenvoudige data en Selenium voor geavanceerde taken.

4. Is webscraping met Selenium legaal?

Webscraping is toegestaan zolang je de voorwaarden van de site volgt, robots.txt respecteert, geen gevoelige data verzamelt en servers niet overbelast. Check altijd de lokale wetgeving en scrape verantwoord.

5. Wanneer moet ik verder kijken dan Selenium voor webscraping?

Als je razendsnel duizenden pagina’s wilt scrapen of scraping wilt automatiseren in de cloud, kies dan voor tools als Thunderbit, Scrapy of managed APIs. Selenium is het beste voor kleine tot middelgrote, interactieve projecten.

Klaar om webscraping te beheersen? Probeer Selenium voor je volgende project—en ontdek hoe snel je met zakelijke data van het web haalt.

Meer weten