Webscraping is stiekem het geheime wapen geworden van veel moderne teams. Of je nu in sales werkt, operationeel bezig bent of gewoon je concurrenten wilt volgen: data van websites halen is tegenwoordig een must-have skill. Wat is er de laatste jaren veranderd? De online wereld is veel interactiever geworden—denk aan dashboards die live bijwerken, oneindig scrollen en info die pas zichtbaar wordt na een klik. JavaScript is de motor achter al die vernieuwing; bijna alles wat je online ziet (en niet ziet) draait erop.

Als iemand die al jaren in SaaS en automatisering werkt, heb ik JavaScript en Node.js zien veranderen van een handige extra naar dé basis voor data extractie. De cijfers liegen er niet om: , en de wereldwijde webscraping-markt groeit tot minstens 2030 met dubbele cijfers (). In deze blog leg ik uit wat webscraping met JavaScript en Node.js precies inhoudt, waarom het zo belangrijk is, en—misschien wel het belangrijkste—hoe zelfs niet-techneuten deze kracht kunnen inzetten met tools als . Of je nu technisch bent of niet, er is nog nooit een beter moment geweest om de chaos van het web om te zetten in waardevolle bedrijfsdata.

Wat is Webscraping met JavaScript? De Basis

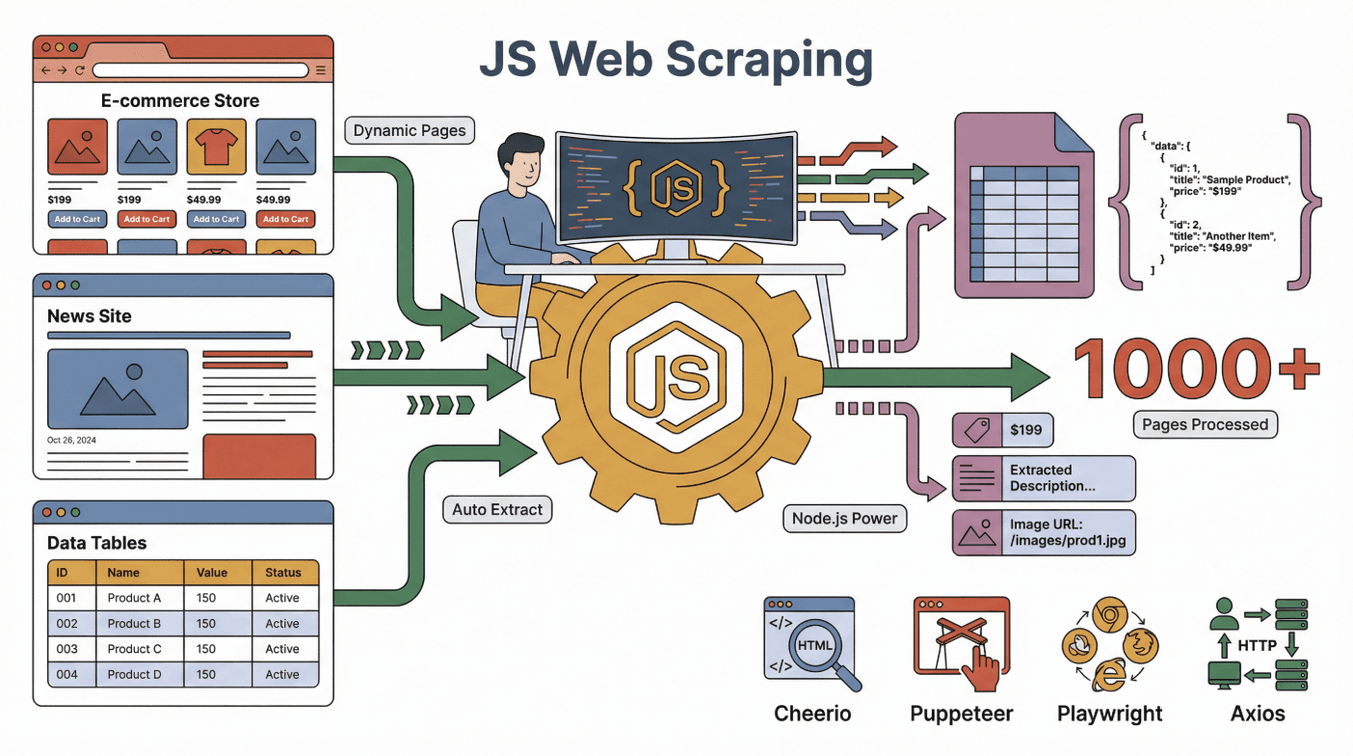

Laten we bij het begin beginnen. Webscraping met JavaScript betekent dat je met JavaScript (vaak samen met Node.js) automatisch data van websites haalt. Zie het als een digitale assistent die een website bezoekt, de pagina leest en de info die jij zoekt in een spreadsheet zet—maar dan eentje die duizenden pagina’s aankan, nooit moe wordt en zelfs knoppen en formulieren kan bedienen.

Laten we bij het begin beginnen. Webscraping met JavaScript betekent dat je met JavaScript (vaak samen met Node.js) automatisch data van websites haalt. Zie het als een digitale assistent die een website bezoekt, de pagina leest en de info die jij zoekt in een spreadsheet zet—maar dan eentje die duizenden pagina’s aankan, nooit moe wordt en zelfs knoppen en formulieren kan bedienen.

JavaScript is hier superkrachtig omdat het de taal is waarmee browsers webpagina’s bouwen en bijwerken. Met Node.js kun je JavaScript buiten de browser draaien, zodat je onder andere het volgende kunt automatiseren:

- Een webpagina laden (ook als deze dynamisch of interactief is)

- Knoppen aanklikken, scrollen of wachten tot content verschijnt

- Tekst, afbeeldingen, prijzen, e-mails of andere gegevens van de pagina halen

Populaire tools voor webscraping met JavaScript zijn onder andere:

- : Ideaal voor het uitlezen van statische HTML-pagina’s (vergelijkbaar met jQuery, maar dan voor de server).

- : Automatiseert een echte Chrome-browser, perfect voor dynamische sites die interactie vereisen.

- : Vergelijkbaar met Puppeteer, maar krachtiger voor automatisering in meerdere browsers.

- : Maakt HTTP-verzoeken om webpagina’s of API’s op te halen.

De echte kracht zit in de combinatie van deze tools: Axios of Puppeteer haalt de pagina op, Cheerio leest de HTML uit, en Node.js zorgt dat alles samenwerkt.

Statische vs. Dynamische Pagina’s: Waarom JavaScript Onmisbaar Is

- Statische pagina’s: De inhoud staat vast en laadt direct mee. Makkelijk te scrapen met simpele tools.

- Dynamische pagina’s: Content verschijnt pas na het laden, vaak via JavaScript. Hiervoor heb je browserautomatisering nodig (zoals Puppeteer) om de data te kunnen zien en verzamelen ().

Omdat zoveel websites dynamisch zijn (denk aan Amazon, LinkedIn, Zillow), is scrapen met JavaScript tegenwoordig de standaard om de juiste data te krijgen.

Waarom JavaScript Kiezen voor Webscraping? De Belangrijkste Pluspunten

Op ontwikkelaarsfora wordt er eindeloos gediscussieerd: JavaScript vs. Python vs. Ruby vs. Go voor webscraping. Mijn ervaring na jaren in het veld:

De Superkrachten van JavaScript

- Dynamische Content Aanpakken: JavaScript is de taal van de browser en kan daardoor moeiteloos omgaan met moderne, JavaScript-rijke sites ().

- Browserautomatisering: Met tools als Puppeteer en Playwright kun je klikken, scrollen en formulieren invullen—net als een mens.

- Bekendheid bij Front-End Teams: Als je team al met JavaScript werkt voor webontwikkeling, kun je die kennis direct inzetten voor scraping ().

- Snelheid en Schaalbaarheid: Node.js kan veel taken tegelijk uitvoeren, ideaal voor het snel scrapen van grote aantallen pagina’s ().

- Enorme Community: Duizenden libraries, tutorials en veel support.

Hoe Vergelijkt JavaScript met Python, Ruby en Go?

| Taal | Dynamische Content | Browserautomatisering | Community | Snelheid | Ideaal Voor |

|---|---|---|---|---|---|

| JavaScript | Uitstekend | Uitstekend | Groot | Snel | Interactieve sites, front-end teams |

| Python | Goed (met Selenium/Playwright) | Goed | Groot | Snel | API’s, statische sites, data science |

| Ruby | Redelijk | Beperkt | Klein | Gemiddeld | Simpele statische scraping |

| Go | Beperkt | Beperkt | Groeit | Zeer snel | Grootschalige, backend scraping |

Voor het scrapen van moderne, interactieve websites is JavaScript (met Node.js) vaak je geheime troef (). Python is een goede tweede, maar als je te maken hebt met zware JavaScript op de pagina, is er niets beter dan JavaScript zelf ().

De Belangrijkste Tools voor Webscraping met JavaScript en Node.js

Hier zijn de belangrijkste onderdelen van de JavaScript scraping-toolkit:

- Node.js: De motor die JavaScript buiten de browser draait. Zie het als je commandocentrum.

- Cheerio: Leest HTML uit en selecteert elementen (zoals “geef me alle productnamen op deze pagina”).

- Puppeteer/Playwright: Automatiseert een echte browser voor dynamische content, logins en complexe interacties.

- Axios/Fetch: Haalt webpagina’s of API’s direct op.

- Overige Helpers: Libraries voor exporteren (CSV, Excel), proxies of het plannen van scrapes.

Hoe werken ze samen? Zie Puppeteer als je robotbrowser, Cheerio als je datadetective, en Node.js als de projectmanager die alles aanstuurt.

Hoe Werkt Webscraping met JavaScript? Stap-voor-Stap

Zo ziet een typische workflow voor webscraping met JavaScript eruit:

- Verzoek Versturen: Gebruik Axios of Puppeteer om de webpagina te laden.

- Wachten op Content: Als de pagina dynamisch is, wacht tot JavaScript alles heeft geladen (Puppeteer kan de uiteindelijke pagina “zien”).

- Data Uitlezen: Gebruik Cheerio of browser-API’s om de gewenste data te selecteren en kopiëren.

- Paginering/Subpagina’s: Klik op “Volgende” of volg links om meer data te verzamelen.

- Data Exporteren: Sla de resultaten op in CSV, Excel, Google Sheets of een database.

Vergelijking: Het is alsof je een super-intern op pad stuurt die elke pagina bezoekt, aantekeningen maakt en alles netjes in een spreadsheet zet.

Statische vs. Dynamische Content: Wat is het Verschil?

- Voorbeeld Statische Site: Een blog waar alle artikelen direct in de HTML staan. Cheerio + Axios werkt perfect.

- Voorbeeld Dynamische Site: Een webshop waar prijzen pas na scrollen verschijnen. Puppeteer of Playwright is nodig om de uiteindelijke prijzen te zien ().

Tip: Zie je een lege pagina bij het scrapen? Dan is de site waarschijnlijk dynamisch—gebruik dan Puppeteer.

Thunderbit: No-Code Webscraping met de Kracht van JavaScript

Hier wordt het pas echt interessant—vooral als je geen programmeur bent. Bij maken we webscraping op JavaScript-niveau toegankelijk voor iedereen, niet alleen voor techneuten.

Onze visie: Je webscraper moet “taken begrijpen als een stagiair”—jij beschrijft wat je wilt, en de AI regelt de rest.

Hoe Thunderbit JavaScript Scraping voor Iedereen Beschikbaar Maakt

- AI Veldsuggesties: Eén klik en Thunderbit’s AI scant de pagina, stelt voor welke data je kunt halen en zet de scraper voor je klaar.

- Subpagina’s Scrapen: Meer details nodig? Thunderbit bezoekt automatisch elke subpagina (zoals product- of profielpagina’s) en vult je tabel aan.

- Directe Templates: Voor populaire sites (Amazon, Zillow, Shopify) kies je gewoon een sjabloon—geen gedoe met instellingen.

- Gratis Data Exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

Praktijkvoorbeeld: Ik heb sales-teams met Thunderbit honderden leads uit een dynamische bedrijvengids zien halen, inclusief e-mails en telefoonnummers, met slechts een paar klikken—zonder code, zonder gedoe. Het is alsof je een JavaScript-ontwikkelaar in je team hebt, maar dan zonder sollicitatieproces.

Populaire Toepassingen: Webscraping met JavaScript voor Sales en Operations

Webscraping met JavaScript is niet alleen voor techneuten. Zo gebruiken echte teams het dagelijks:

| Team | Toepassing | Resultaat |

|---|---|---|

| Sales | Leads verzamelen uit directories | 10x meer leads, direct klaar voor CRM |

| E-commerce | Prijzen van concurrenten monitoren | Dynamische prijsstelling, sneller reageren |

| Operations | Voorraadgegevens samenvoegen | Overzicht van alle SKU’s bij leveranciers |

| Vastgoed | Woningenaanbod verzamelen | Altijd actuele marktdata in één spreadsheet |

| Marketing | Reviews en sentiment analyseren | Sneller inzicht, betere campagne-targeting |

Voorbeeld: Een e-commerce team vertelde ons dat ze wekelijks meer dan 20 uur besparen door met Thunderbit concurrentieprijzen te scrapen, zodat ze hun eigen prijzen bijna realtime kunnen aanpassen ().

Ethische en Juridische Overwegingen bij Webscraping met JavaScript

Laten we het onvermijdelijke bespreken: Is webscraping legaal? Kort gezegd: meestal wel, zolang je openbare data scrapt en de regels van de site respecteert (). Maar let op:

- Respecteer robots.txt: Als een site aangeeft niet te willen dat je scrapt, doe het dan niet.

- Volg de Gebruiksvoorwaarden: Sommige sites verbieden scraping expliciet.

- Bescherm Privacy: Verzamel of misbruik geen persoonlijke gegevens.

- Overbelast Servers Niet: Scrape met mate.

Recente rechtspraak is meestal gunstig voor het scrapen van openbare data, maar auteursrecht en privacywetgeving blijven gelden (). Twijfel je? Raadpleeg een jurist.

Best practice: Verzamel alleen data die je ook zelf openbaar zou delen, en vermeld altijd je bronnen.

De Toekomst van Webscraping met JavaScript: AI en Automatisering

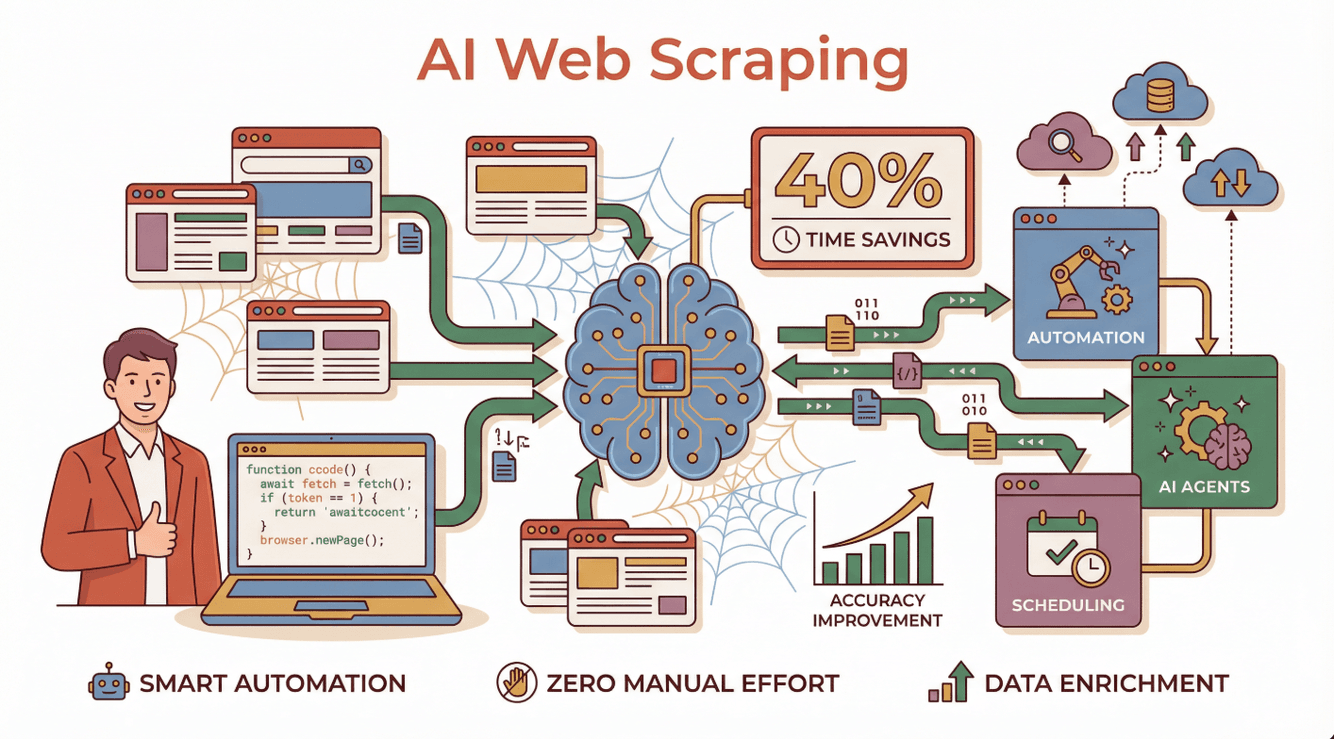

Nu wordt het pas echt interessant. AI verandert webscraping van een handmatig, code-intensief proces in een slimme, geautomatiseerde workflow. Bedrijven die AI-gedreven scrapers inzetten, rapporteren , hogere nauwkeurigheid en de mogelijkheid om zelfs de lastigste dynamische sites aan te pakken ().

Nu wordt het pas echt interessant. AI verandert webscraping van een handmatig, code-intensief proces in een slimme, geautomatiseerde workflow. Bedrijven die AI-gedreven scrapers inzetten, rapporteren , hogere nauwkeurigheid en de mogelijkheid om zelfs de lastigste dynamische sites aan te pakken ().

Hoe ziet dat er in de praktijk uit?

- AI-agenten kunnen instructies in gewone taal lezen, zich aanpassen aan websitewijzigingen en fouten zelf oplossen ().

- Automatische planning zorgt ervoor dat je dagelijks verse data krijgt, zonder handmatig werk.

- Data verrijken: AI kan data direct categoriseren, samenvatten of zelfs vertalen.

Thunderbit loopt hierin voorop en maakt het mogelijk voor iedereen om AI-gestuurde webscrapers te bouwen en te draaien—zonder code, zonder onderhoud.

Meer weten over de toekomst van AI-webscraping? Lees onze uitgebreide gids over .

Aan de Slag: Praktische Tips voor Zakelijke Gebruikers

Wil je zelf aan de slag met webscraping via JavaScript (of de no-code aanpak van Thunderbit)? Zo begin je:

- Bepaal je Doel: Welke data heb je nodig, en waarom?

- Kies je Tool: Ben je technisch? Probeer Node.js met Puppeteer of Cheerio. Liever zonder code? en laat de AI het werk doen.

- Begin Klein: Test eerst op een paar pagina’s voordat je opschaalt.

- Exporteer en Analyseer: Zet je data in Google Sheets, Excel of Notion voor verdere analyse.

- Blijf Ethisch: Respecteer altijd privacy, gebruiksvoorwaarden en datalimieten.

Meer leren? Bekijk de toegankelijke tutorials op , of sluit je aan bij online communities zoals Stack Overflow of Reddit’s r/webscraping voor hulp.

Conclusie: Meerwaarde voor je Bedrijf met Webscraping en JavaScript

Kort samengevat: JavaScript en Node.js zijn de ruggengraat van moderne webscraping, vooral voor dynamische, interactieve websites. Of je nu ontwikkelaar bent of zakelijke gebruiker, dankzij browserautomatisering, een enorme community en nu ook AI-tools kun je sneller en nauwkeuriger dan ooit de data verzamelen die je nodig hebt.

En met no-code oplossingen zoals hoef je geen regel code te schrijven om te profiteren van JavaScript-gedreven scraping. Beschrijf simpelweg wat je wilt, klik, en zie je data verschijnen—klaar voor analyse, leadgeneratie of wat je bedrijf ook nodig heeft.

Wil je de chaos van het web omzetten in gestructureerde, bruikbare inzichten? Dit is hét moment om te beginnen. Veel succes met scrapen—en moge je data altijd schoon, legaal en een stap voor zijn op de concurrentie.

Veelgestelde Vragen

1. Wat is webscraping met JavaScript en Node.js?

Webscraping met JavaScript en Node.js betekent dat je met JavaScript-code (vaak draaiend op Node.js) automatisch data van websites haalt. Deze aanpak is vooral krachtig voor dynamische sites die hun content met JavaScript laden.

2. Waarom is JavaScript beter dan Python of Ruby voor het scrapen van dynamische websites?

JavaScript is de taal waarmee browsers webpagina’s opbouwen en bijwerken, waardoor het natuurlijker met dynamische content kan omgaan. Met tools als Puppeteer en Playwright kun je echte browsers automatiseren, wat het scrapen van JavaScript-gedreven sites eenvoudiger maakt.

3. Kunnen niet-technische gebruikers webscraping met JavaScript doen?

Zeker. No-code tools zoals maken de kracht van JavaScript-scraping voor iedereen toegankelijk. Gebruik gewoon instructies in gewone taal en laat de AI de technische details regelen.

4. Is webscraping legaal?

In het algemeen is het scrapen van openbare data toegestaan, mits je de gebruiksvoorwaarden, robots.txt en privacywetgeving respecteert. Vermijd het verzamelen van persoonlijke of auteursrechtelijk beschermde data zonder toestemming.

5. Hoe verandert AI webscraping met JavaScript?

AI maakt webscraping slimmer en toegankelijker. Het kan zich aanpassen aan websitewijzigingen, fouten afhandelen en zelfs data direct verwerken en verrijken—wat tijd bespaart en de nauwkeurigheid verhoogt. Thunderbit is een toonaangevend voorbeeld van deze nieuwe generatie AI-webscraping.

Voor meer tips en handleidingen, bekijk de of abonneer je op ons .

Meer weten