Als je ooit met de terminal hebt gewerkt, is de kans groot dat je cURL al eens bent tegengekomen. Het is echt het Zwitsers zakmes van het internet: stilletjes aanwezig op miljarden apparaten, altijd paraat om data op te halen, te versturen of te debuggen via een URL. De maker van cURL schat zelfs dat er wereldwijd zijn. Geen typefout: twintig miljard.

Waarom kiezen ontwikkelaars (en eerlijk is eerlijk, ook veel zakelijke gebruikers) in 2025 nog steeds voor cURL, terwijl er zoveel moderne, AI-gedreven scrapingtools zijn? Soms wil je gewoon snel resultaat, zonder poespas, volledig scriptbaar en zonder extra ballast. In deze gids ontdek je waarom webscraping met curl nog steeds relevant is, wanneer het de beste keuze is, hoe je het slim inzet én hoe je je workflow kunt versnellen met , onze AI-webscraper die scraping naar een hoger niveau tilt.

Waarom cURL Webscraping in 2025 Nog Steeds Onmisbaar Is

Eerlijk is eerlijk: ik ben fan van cURL. Het is heerlijk om met één commando direct ruwe data binnen te halen. En ik ben niet de enige. Uit de blijkt dat het aantal respondenten vorig jaar met 28% steeg, en op Stack Overflow vind je over cURL. Ontwikkelaars noemen het "beproefd", "fantastisch" en "de standaardtaal voor webverzoeken". Ondanks alle nieuwe tools blijft cURL zich ontwikkelen, met ondersteuning voor o.a. HTTP/3.

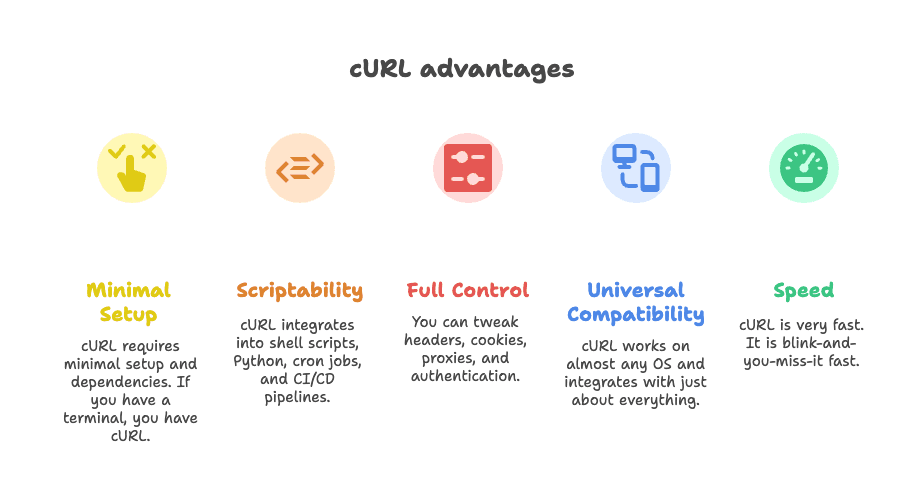

Maar waarom blijft cURL zo populair voor webscraping?

- Direct te gebruiken: Geen gedoe met extra installaties. Als je een terminal hebt, heb je cURL.

- Makkelijk te automatiseren: Perfect te integreren in shellscripts, Python, cronjobs en CI/CD pipelines.

- Volledige controle: Pas headers, cookies, proxies en authenticatie helemaal naar wens aan.

- Universeel inzetbaar: Werkt op praktisch elk besturingssysteem en met bijna alle tools.

- Supersnel: Razendsnelle data-opvragingen.

Zoals een ontwikkelaar het mooi zei: “Alles wat je wilt doen, kan cURL.” ()

Wanneer Kies Je Voor cURL Webscraping? De Beste Toepassingen

Laten we eerlijk zijn: cURL is niet altijd de beste oplossing. Maar in sommige situaties is het onovertroffen. Hier blinkt cURL uit:

1. API’s Scrapen voor JSON Data

Veel moderne websites laden content via API-calls op de achtergrond. Als je het juiste endpoint vindt (tip: kijk in het Netwerk-tabblad van je browser), kun je met cURL in één commando JSON-data ophalen. Ideaal voor snelle dataverzameling, API-tests of automatisering.

2. Data Halen uit Statische of Eenvoudige Pagina’s

Staat de informatie direct in de HTML (zoals nieuwsartikelen, bedrijvengidsen of productoverzichten)? Dan haalt cURL het razendsnel binnen. Combineer met tools als grep, sed of jq voor eenvoudige parsing.

3. Debuggen en Nadoen van HTTP-verzoeken

Wil je een login simuleren, een webhook testen of een complexe API-call debuggen? Met cURL heb je volledige controle over headers, cookies en payloads. Onmisbaar voor ontwikkelaars die precies willen weten wat er gebeurt.

4. Snel Data Integreren in Scripts

cURL is favoriet om te verwerken in shellscripts, Python of zelfs Zapier-webhooks. Het is de lijm die veel automatisering mogelijk maakt.

Hier een overzichtstabel van waar cURL uitblinkt – en waar niet:

| Toepassing | Waarom cURL Geschikt Is | Beperkingen | Alternatieven |

|---|---|---|---|

| JSON API’s scrapen | Snel, scriptbaar, ondersteunt headers/tokens | Geen ingebouwde JSON-parsing, complexe authenticatie handmatig | Python Requests, Postman, Thunderbit |

| Statische HTML-pagina’s | Lichtgewicht, makkelijk te combineren met CLI-tools | Geen HTML-parsing, geen JavaScript-ondersteuning | Scrapy, BeautifulSoup, Thunderbit |

| Scraping met sessie-authenticatie | Kan cookies, headers, basic auth aan | Lastig bij meerstapslogins, geen JS-ondersteuning | Requests sessions, Selenium, Thunderbit |

| Integratie in Shell/Python | Universeel, werkt in elk script | Parsing en foutafhandeling handmatig | Native HTTP-libraries, Thunderbit |

Wil je dieper in deze scenario’s duiken? Lees dan .

Onmisbare cURL Webscraping Technieken voor 2025

Tijd om praktisch te worden. Zo haal je in 2025 het maximale uit cURL, inclusief een paar handige tips.

Headers en User-Agents Instellen

Websites blokkeren vaak standaard cURL-verzoeken. Gebruik een realistische User-Agent en de juiste headers om niet op te vallen:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/dataOf met meerdere headers:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataHet aanpassen van headers maakt vaak het verschil tussen toegang krijgen of geblokkeerd worden. Meer weten? Bekijk .

Cookies en Sessies Beheren

Moet je inloggen of een sessie behouden? Gebruik de cookie jar van cURL:

1# Inloggen en cookies opslaan

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# Cookies gebruiken voor volgende verzoeken

4curl -b cookies.txt https://example.com/dashboardCookies direct meesturen kan ook:

1curl -b "SESSIONID=abcd1234" https://example.com/pageVolg je redirects (zoals na inloggen)? Voeg dan -L toe om cookies te behouden.

Proxies Gebruiken om Blokkades te Omzeilen

Word je IP geblokkeerd? Stuur je verzoeken via een proxy:

1curl --proxy 198.199.86.11:8080 https://target.comVoor roterende proxies kun je cURL laten werken met een lijst en deze afwisselen. Let op: gratis proxies zijn vaak onbetrouwbaar – als je een “connection refused” krijgt, ligt dat meestal niet aan cURL.

Antwoorden Opslaan en Parssen

cURL levert ruwe data. Gebruik command-line tools om deze te verwerken:

-

Voor JSON: Gebruik

jqom te filteren of mooi weer te geven.1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

Voor HTML: Gebruik

grepofsedvoor eenvoudige patronen.1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

Voor complexere parsing: Tools als

htmlq(voor CSS-selectors) of Python met BeautifulSoup zijn dan handig.

Meer weten over cURL en jq samen? Lees .

Authenticatie en Rate Limits met cURL

Authenticatie:

-

Basic Auth:

1curl -u username:password https://api.example.com/data -

Bearer Tokens:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Sessiecookies: Gebruik de

-cen-bopties zoals hierboven.

Voor complexere flows (zoals OAuth) moet je het handshake-proces zelf scripten – cURL kan het, maar het is niet eenvoudig.

Rate Limits en Retries:

-

Vertraging toevoegen:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # willekeurige pauze tussen 2-4 seconden 4done -

Opnieuw proberen:

1curl --retry 3 --retry-delay 5 https://example.com/data

Wees netjes: overbelast servers niet en let op 429 Too Many Requests meldingen.

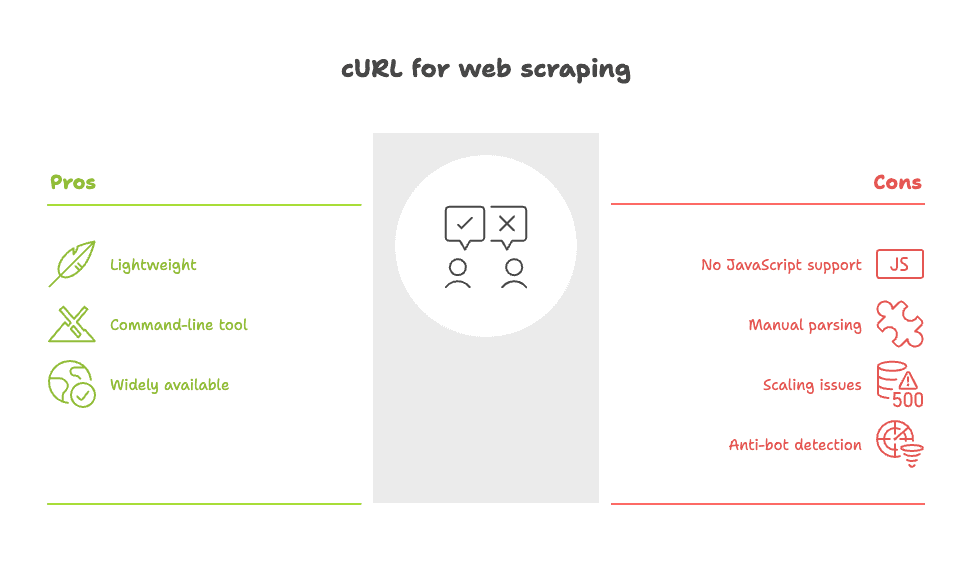

Beperkingen van cURL voor Webscraping: Hier Moet Je Op Letten

Tijd voor wat realisme. Hoe handig cURL ook is, het is niet altijd de beste keuze. Hier schiet het tekort:

- Geen JavaScript-ondersteuning: cURL voert geen scripts uit en ziet geen dynamische content. Wordt data pas na het laden van de pagina zichtbaar? Dan moet je het onderliggende API-endpoint vinden of overstappen op een browser-based tool.

- Handmatig parsen: Je krijgt ruwe HTML of JSON. Het structureren van die data moet je zelf doen – vaak met

grep,sedof eigen scripts. - Schaalbaarheid: Bij honderden of duizenden pagina’s wordt foutafhandeling, retries en datacleaning snel complex.

- Makkelijk te detecteren door anti-bot systemen: Veel sites herkennen cURL en blokkeren het direct, zelfs als je headers aanpast.

Zoals een Reddit-gebruiker zei: “Curl of wget is prima voor simpele scraping, maar voor complexe sites wordt het een uitdaging.” ()

Meer weten over de valkuilen van cURL? Lees .

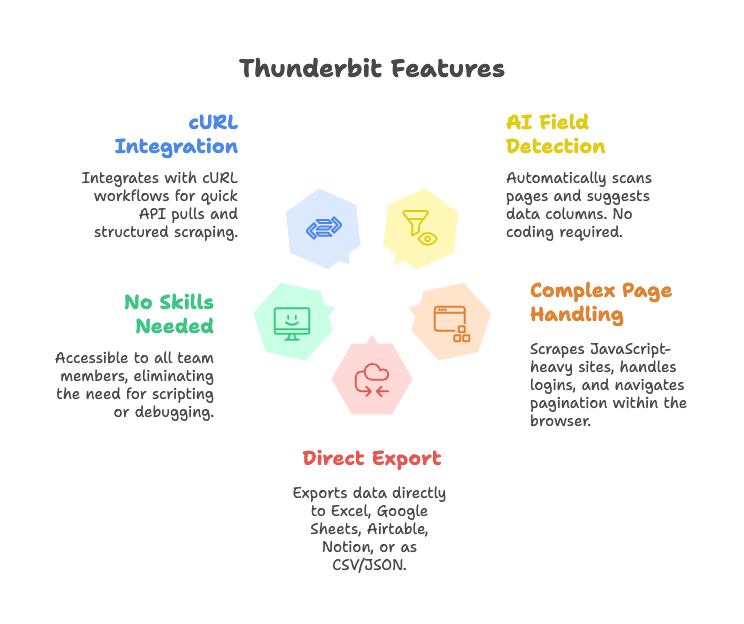

Maak cURL Webscraping Slimmer met Thunderbit

Wil je de snelheid en controle van cURL, maar zonder het handwerk? Dan is jouw oplossing.

Thunderbit is een AI-webscraper Chrome-extensie die data-extractie moeiteloos maakt. Zo vult het cURL perfect aan:

- AI-veldherkenning: Klik op “AI Suggest Fields” en Thunderbit scant de pagina, stelt kolommen voor en structureert je data – geen selectors, geen code.

- Geschikt voor complexe pagina’s: Thunderbit werkt in je browser, dus ook JavaScript-rijke sites, logins en subpagina’s zijn geen probleem.

- Direct exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable, Notion of download als CSV/JSON.

- Geen technische kennis nodig: Iedereen in je team kan ermee aan de slag – geen scripts of HTTP-debugging vereist.

- Integreert met cURL-workflows: Ontwikkelaars kunnen cURL blijven gebruiken voor snelle API-tests, en daarna Thunderbit inzetten voor gestructureerde, herhaalbare scraping.

Wil je Thunderbit in actie zien? Bekijk onze of lees meer op onze .

Thunderbit + cURL: Praktische Workflows voor Zakelijke Teams

Hoe combineren teams cURL en Thunderbit voor maximale impact? Een paar voorbeelden:

1. Snel Marktonderzoek

- Gebruik cURL om te testen of een concurrent een publieke API of statische HTML heeft.

- Script een snelle datadump voor een momentopname.

- Voor diepere analyses (zoals het scrapen van productlijsten over meerdere pagina’s), schakel je over naar Thunderbit – AI detecteert velden, regelt paginering en exporteert direct naar Sheets.

2. Leadgeneratie

- Gebruik cURL om contactgegevens uit een eenvoudige directory-API te halen.

- Voor complexere sites (zoals LinkedIn-achtige profielen of vastgoedoverzichten) gebruik je Thunderbit om namen, e-mails, telefoonnummers en zelfs afbeeldingen te verzamelen – zonder handmatig parsen.

3. Productlijsten of Prijzen Monitoren

- Plan cURL-scripts in om prijswijzigingen via een REST API te volgen.

- Heeft een site geen API? Laat Thunderbit de scraping doen, structureer de data en stuur updates naar Airtable of Notion voor je operationele team.

Een workflow-overzicht (denk aan poppetjes en pijlen):

1[Browser/Terminal] --(testen met cURL)--> [Snelle Datapull]

2 |

3 v

4[Thunderbit Chrome-extensie] --(AI-extractie)--> [Gestructureerde Data] --> [Sheets/Airtable/Notion]Thunderbit versus Handgeschreven cURL-scripts: De Voordelen

Een vergelijking op een rij:

| Functie | Thunderbit (AI-webscraper) | cURL (CLI-tool) |

|---|---|---|

| Installatie | Klikken, AI detecteert velden automatisch | Handmatig scripten, HTML-kennis vereist |

| Gebruiksgemak | Iedereen kan het, visuele feedback | Alleen CLI, steile leercurve |

| Gestructureerde output | Ja – tabellen, kolommen, export naar Sheets/CRM | Ruwe HTML/JSON, handmatig parsen |

| Dynamische pagina’s | Ja – werkt in browser, ondersteunt JS, subpagina’s, paginering | Nee – alleen statische HTML |

| Onderhoud | Laag – AI past zich aan sitewijzigingen aan | Hoog – scripts breken bij sitewijzigingen |

| Integratie | Exporteert direct naar zakelijke tools | Maatwerkcode nodig |

| Meertaligheid/vertaling | Ja – AI kan velden vertalen en normaliseren | Nee – alleen handmatig |

| Schaalbaarheid | Ideaal voor middelgrote jobs | Goed voor grote jobs als je alles zelf bouwt |

| Kosten | Gratis tier, betaalde plannen vanaf ~$9/maand | Gratis, maar kost ontwikkeltijd |

Meer weten? Lees onze .

Dankzij de AI-aanpak van Thunderbit besteed je minder tijd aan scripten en meer aan resultaat. Of je nu ontwikkelaar bent of zakelijke gebruiker, het is de snelste manier om webdata om te zetten in waarde.

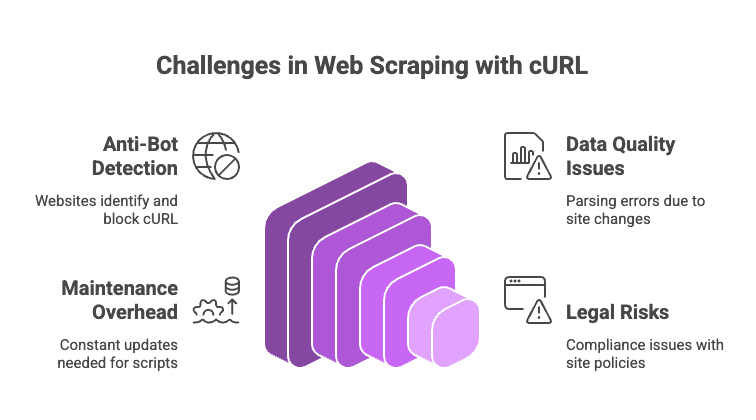

Mogelijke Uitdagingen en Valkuilen bij cURL Webscraping

Webscraping in 2025 is niet altijd eenvoudig. Hier moet je op letten (en zo voorkom je problemen):

- Anti-botmaatregelen: Tools als Cloudflare, Akamai en DataDome herkennen cURL vaak direct. Zelfs met aangepaste headers controleren ze op JavaScript, TLS-kenmerken en meer. Kom je een CAPTCHA tegen? cURL kan die niet oplossen.

- Datakwaliteit en consistentie: Ruwe HTML parsen met regex of grep is kwetsbaar. Elke wijziging in de site kan je script breken.

- Onderhoud: Elke site-update betekent weer sleutelen aan je code of selectors.

- Juridische en compliance-risico’s: Controleer altijd de gebruiksvoorwaarden en privacyregels van een site. Dat je kunt scrapen, betekent niet dat het mag.

Tips:

- Wissel user agents en IP’s af als je geblokkeerd wordt.

- Voeg willekeurige pauzes toe tussen verzoeken.

- Gebruik tools als

jqvoor JSON enhtmlqvoor HTML-parsing. - Voor dynamische of beschermde sites: stap over op een browser-based tool zoals Thunderbit of een scraping API.

Meer valkuilen (en oplossingen) vind je in .

Conclusie: Kies de Juiste Webscraping-aanpak in 2025

Mijn advies: cURL blijft onovertroffen voor snelle, gerichte scraping – vooral voor API’s, statische pagina’s of debugging. Het is de snelste manier om te testen wat mogelijk is.

Maar zodra je gestructureerde data, dynamische content of een workflow voor teams nodig hebt, is het tijd voor zwaarder geschut. bespaart je handwerk, verwerkt complexe sites en levert data direct waar je het nodig hebt.

Kortom: kies het juiste gereedschap voor de klus. Voor kleine, scriptbare taken is cURL ideaal. Voor grotere, dynamische of teamgerichte projecten laat je Thunderbit het zware werk doen.

Veelgestelde Vragen: Webscraping met cURL in 2025

1. Kan cURL omgaan met JavaScript-gegenereerde content?

Nee. cURL haalt alleen de initiële HTML op. Wordt data via JavaScript geladen, dan moet je het onderliggende API-endpoint vinden of een browser-based tool zoals Thunderbit gebruiken.

2. Hoe voorkom ik blokkades bij scrapen met cURL?

Gebruik realistische headers (User-Agent, Accept), roteer IP’s en user agents, voeg pauzes toe tussen verzoeken en hergebruik cookies. Voor zware anti-botsystemen (zoals Cloudflare) kun je proberen of overstappen op een headless browser of scraping API.

3. Wat is de beste manier om cURL-output te structureren?

Voor JSON: stuur de output naar jq. Voor HTML: gebruik grep, sed of command-line HTML-parsers zoals htmlq. Voor complexere parsing kun je overstappen op Python met BeautifulSoup of Thunderbit gebruiken voor AI-gestuurde extractie.

4. Is cURL geschikt voor grootschalige scrapingprojecten?

Het kan, maar je moet veel zelf bouwen: retries, foutafhandeling, proxies en datacleaning. Voor grote projecten zijn frameworks als Scrapy of browser-based tools vaak efficiënter.

5. Hoe verbetert Thunderbit traditioneel cURL-scrapen?

Thunderbit automatiseert veldherkenning, verwerkt dynamische pagina’s, beheert sessies en subpagina’s en exporteert gestructureerde data direct naar zakelijke tools. Geen scripting, geen selectors, geen onderhoudszorgen.

Wil je scraping makkelijker maken? Probeer of installeer onze en ontdek hoe AI je workflow versnelt.

Werk je liever in de terminal? Geen zorgen, cURL blijft bestaan. Maar wees lief voor de servers – en trakteer je favoriete sysadmin eens op een kop koffie.

Meer tips over webscraping, automatisering en AI-productiviteit? Bekijk de voor de nieuwste inzichten en handleidingen.