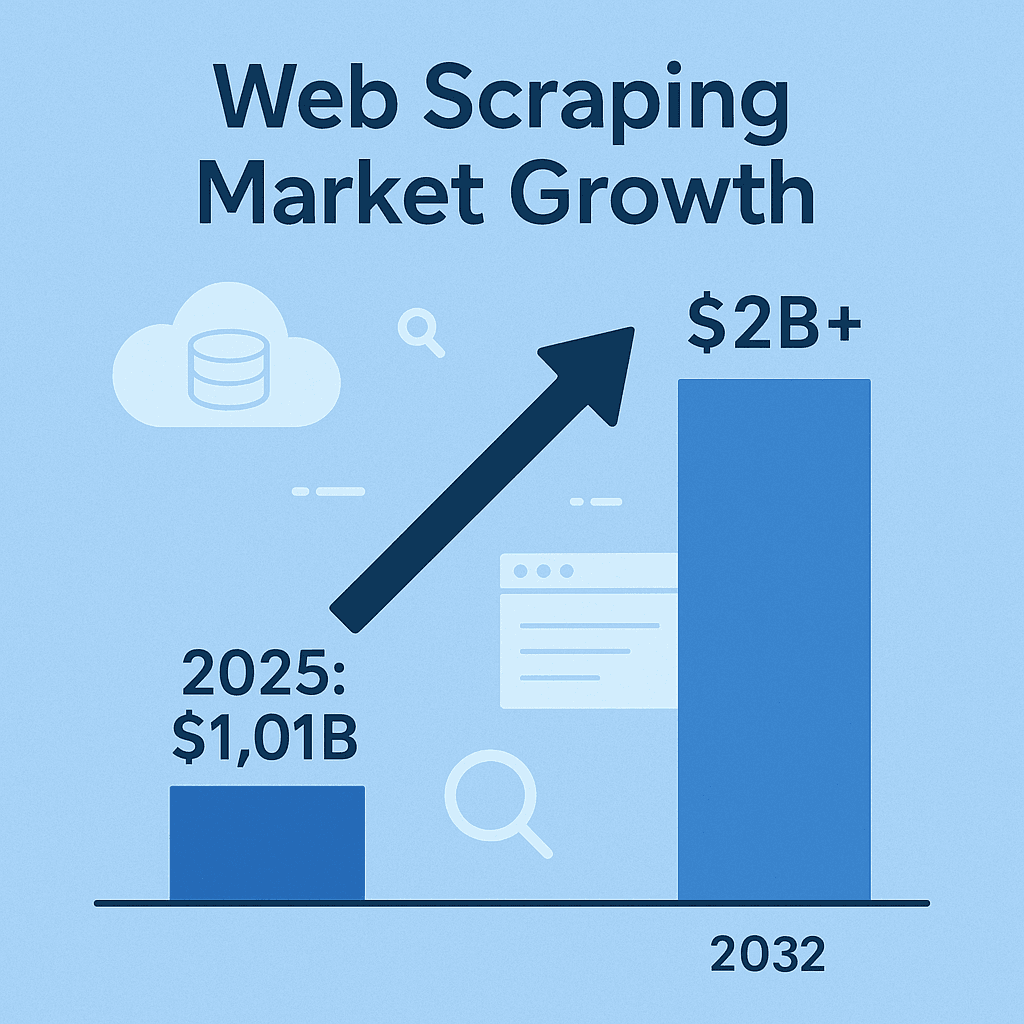

Webscraping is in stilte uitgegroeid tot een onmisbare troef voor moderne bedrijven, sales en marktonderzoek. Tegenwoordig geldt: als je geen webdata verzamelt—denk aan concurrentieprijzen, productoverzichten, markttrends of leads—dan mis je waarschijnlijk inzichten waar je concurrenten al lang op inspelen. De markt voor webscraping-software tikte zelfs aan en zal naar verwachting meer dan verdubbelen tegen 2032. Dit is geen hype, maar een structurele verschuiving. En hoewel Python vaak in de spotlights staat, blijft Java dé keuze voor teams die betrouwbaarheid, snelheid en sterke integratie eisen.

Na jarenlange ervaring in SaaS en automatisering kan ik bevestigen: webscraping met Java is springlevend—vooral bij grote organisaties waar stabiliteit, multithreading en koppeling met big data-systemen essentieel zijn. Maar let op: scrapen draait niet alleen om data binnenhalen. Het gaat om efficiënt, netjes en (als je geen juridische problemen wilt) volgens de regels werken. Dus, laten we samen de beste aanpakken voor webscraping in Java verkennen—of je nu zelf webscrapers bouwt of je workflow wilt versnellen met AI-tools zoals .

Webscraping in Java uitgelegd: de basis

In de kern is webscraping het proces waarbij je met code automatisch informatie van websites haalt. De standaard workflow is simpel: je code stuurt een HTTP-verzoek naar een webpagina, ontvangt de HTML, haalt daaruit de gewenste data (zoals prijzen, productnamen of reviews), en exporteert die naar een bruikbaar formaat—zoals CSV, JSON of direct naar een database ().

Waarom Java? Waar Python populair is voor snelle scripts, is Java de krachtpatser voor grootschalige, langdurige en bedrijfsbrede scraping-taken. Java is statisch getypt, robuust en heeft een uitgebreid aanbod aan libraries voor netwerken, HTML-parsing en gelijktijdigheid. En als je data-pijplijn of analytics-stack al op Java draait, sluit alles naadloos aan—zonder gedoe met verschillende programmeertalen ().

Kortom: Java-webscrapers kunnen dagenlang draaien, enorme hoeveelheden data verwerken en integreren moeiteloos met je bestaande systemen. Maar je moet wel weten welke tools je wanneer inzet.

Populaire Java webscraping-tools en libraries

Tijd voor de praktijk. Dit zijn de meest gebruikte Java webscraping-libraries, elk met hun eigen plus- en minpunten:

| Tool | Ideaal voor | Sterke punten | Beperkingen |

|---|---|---|---|

| Jsoup | Statische HTML-pagina's, snelle extractie | Lichtgewicht, eenvoudige API, snel, ideaal voor simpele taken | Kan geen JavaScript of dynamische content verwerken |

| Selenium | Dynamische, interactieve sites | Automatiseert echte browsers, ondersteunt JS, gebruikersacties, grote community | Vraagt veel resources, trager, kwetsbaar bij UI-wijzigingen, vereist browserdrivers |

| HtmlUnit | Headless browsen, matige JS-ondersteuning | Pure Java, kan wat JS uitvoeren, geen externe browser nodig | Trager dan Jsoup, beperkte support voor moderne JS-frameworks, geen ingebouwde anti-blokkering |

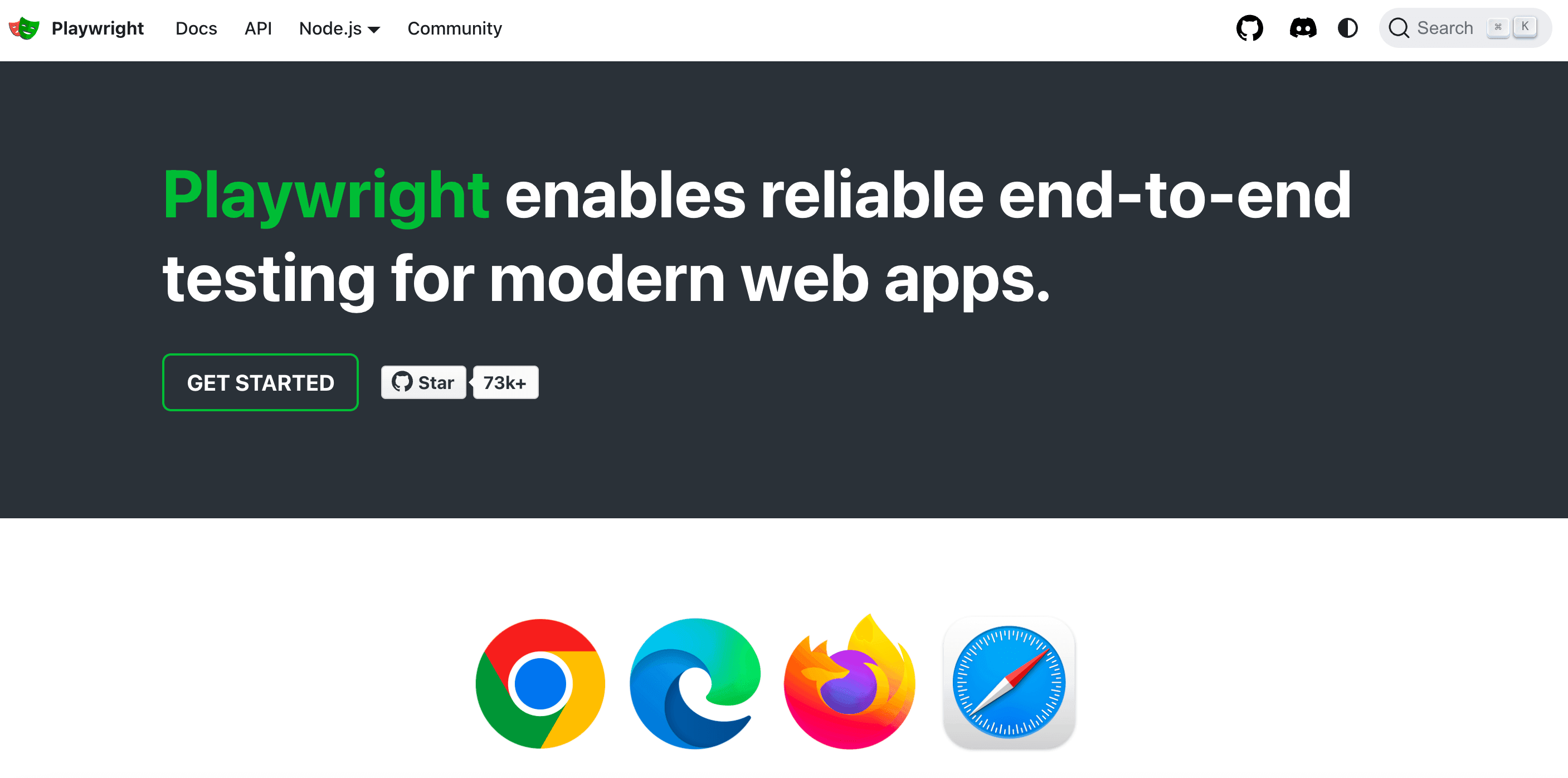

| Playwright | Moderne JS-rijke sites, automatisering | Snel, efficiënt, ondersteunt meerdere browsers, kan pop-ups en multi-page flows aan, auto-waiting | Nieuwe library, vereist nog steeds browserresources, minder native voor Java dan Selenium |

(, )

Jsoup: Dé keuze voor statische HTML

is de standaardtool voor Java-webscraping als je werkt met statische webpagina’s. Het werkt als jQuery voor Java: haal een pagina op met Jsoup.connect(URL).get(), en selecteer met CSS-selectors de data die je nodig hebt. Alle <h1>-titels ophalen? Zo gepiept. Alle productnamen in <div class="product-name">? Met één regel geregeld.

Voorbeeld: Productnamen uit een webshop halen

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup is snel, eenvoudig en ideaal voor het scrapen van blogs, productoverzichten of nieuwsartikelen—maar let op: het voert geen JavaScript uit. Staat de data niet in de HTML-bron, dan vindt Jsoup het niet.

Selenium en HtmlUnit: Voor dynamische content

Soms wordt de data die je zoekt pas zichtbaar na een JavaScript-actie of gebruikersinteractie (zoals op “Meer laden” klikken). Dan is de oplossing. Selenium laat je Java-code een echte browser starten (Chrome, Firefox, enz.), waarmee je de pagina net als een gebruiker kunt bedienen en de gewenste content kunt ophalen.

HtmlUnit is een lichtere, volledig Java-gebaseerde optie die wat JavaScript aankan, maar niet geschikt is voor moderne, zwaar op JS leunende sites. Voor simpele dynamische content werkt het prima, maar voor React of Angular-sites kun je beter Selenium of Playwright gebruiken.

Wanneer een headless browser gebruiken: Moet je inloggen, knoppen aanklikken of content scrapen die pas na scripts zichtbaar wordt? Dan is browserautomatisering de juiste keuze. Houd wel rekening met lagere snelheid en meer onderhoud—websites veranderen hun structuur regelmatig.

Playwright: De moderne automatiseringskrachtpatser

is relatief nieuw, ontwikkeld door Microsoft en gericht op snelheid en betrouwbaarheid. Het is tot 40–50% sneller dan Selenium, ondersteunt meerdere browsers en kan complexe situaties aan zoals pop-ups, infinite scroll en multi-page flows met minder code. Werk je met moderne, client-side gerenderde sites? Dan is Playwright zeker het proberen waard.

De juiste Java webscraping-tool kiezen voor jouw project

Niet elk project vraagt om een alleskunner. Zo maak ik de keuze:

- Website-complexiteit: Statische HTML? Gebruik Jsoup. Dynamische JS? Kies Selenium of Playwright. Een beetje JS, maar niet te gek? HtmlUnit kan volstaan.

- Datavolume & frequentie: Eenmalige scrape? Houd het simpel. Grote, terugkerende jobs? Kies tools die multithreading en foutafhandeling ondersteunen.

- Gebruiksgemak vs. flexibiliteit: Jsoup is snel te leren. Selenium/Playwright bieden meer mogelijkheden, maar vragen meer opzet en onderhoud.

- Projecteisen & budget: Open-source libraries zijn gratis, maar je bouwt en onderhoudt alles zelf. Betaalde API’s of cloud scraping-diensten besparen tijd, maar kosten geld.

Keuzematrix:

| Criteria | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| Statische HTML | ✔️ | ✔️ | ||

| Dynamische JS | ✔️ | (beetje) | ✔️ | |

| Snelheid | ✔️ | ✔️ | ||

| Gebruiksgemak | ✔️ | |||

| Kan inloggen/klikken | ✔️ | (basis) | ✔️ | |

| Grootschalig/Parallel | ✔️ | (moeilijker) | (oké) | ✔️ |

| Budgetvriendelijk | ✔️ | ✔️ | ✔️ | ✔️ |

Begin eenvoudig, schakel pas op als het nodig is. En mix gerust verschillende tools—soms is een hybride aanpak het meest effectief.

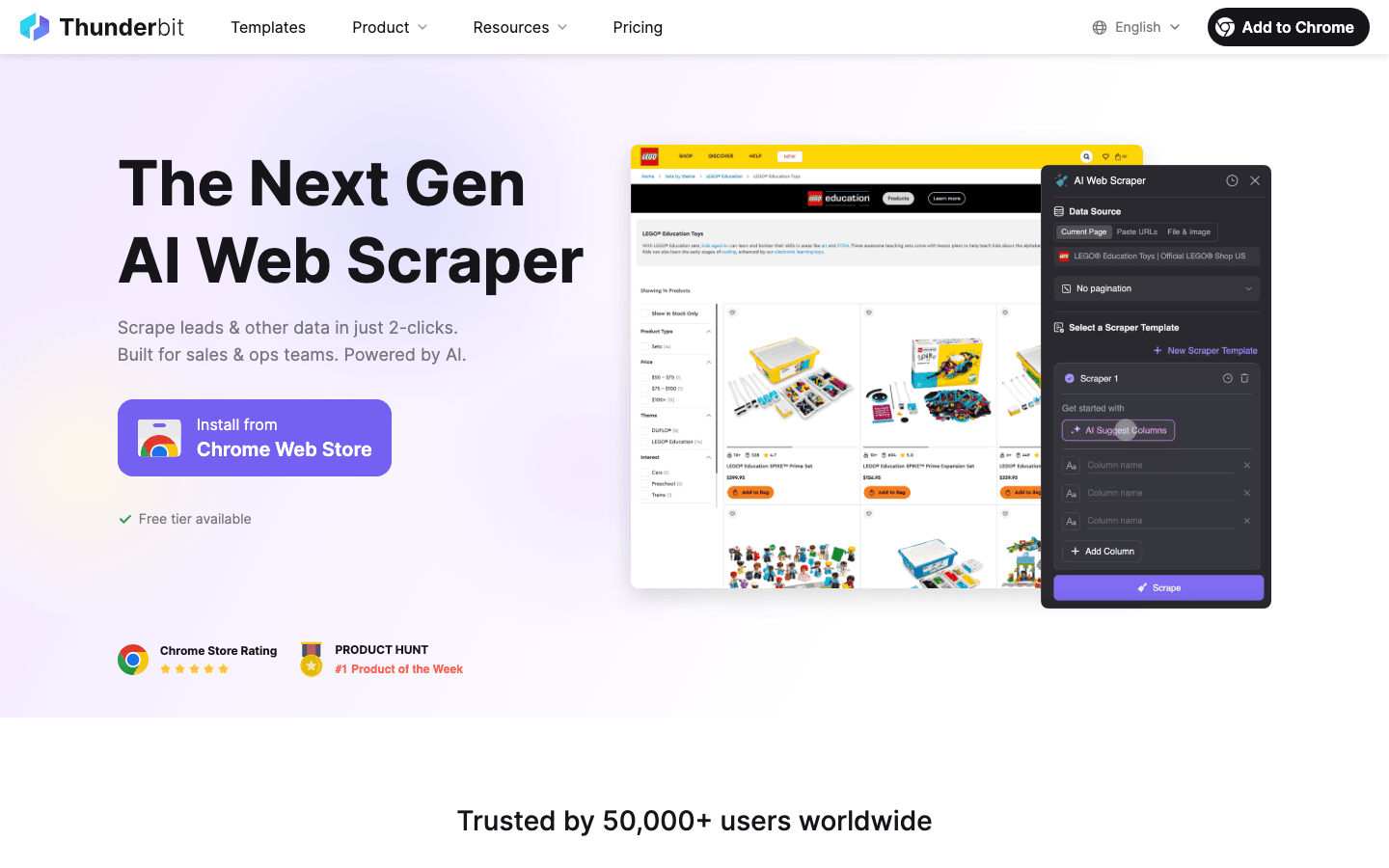

Thunderbit: Webscraping vereenvoudigd voor Java-ontwikkelaars

Wat voor veel teams een gamechanger is: . Thunderbit is een AI-webscraper Chrome-extensie waarmee je gestructureerde data van elke website haalt—zonder code, zonder sjablonen, zonder gedoe.

Hoe Thunderbit Java-ontwikkelaars en zakelijke gebruikers helpt:

- AI-voorgestelde velden: Thunderbit’s AI leest de pagina en stelt automatisch de beste kolommen voor. Geen gedoe meer met CSS-selectors of kwetsbare parsing-code.

- Subpagina-navigatie: Details nodig van gelinkte pagina’s? Thunderbit klikt automatisch door en verrijkt je dataset—denk aan productoverzichten met detailpagina’s.

- Paginering & infinite scroll: Thunderbit scrolt, klikt op “Volgende” en verzamelt alle data.

- Gestructureerde export: Exporteer direct naar Excel, Google Sheets, Airtable of Notion. Of download als CSV/JSON en gebruik het in je Java-app.

- Cloud- of browserscraping: Draai scrapes in de cloud (tot 50 pagina’s tegelijk—supersnel!) of in je browser voor sites waar je moet inloggen.

- Inplannen: Stel scrapes in om dagelijks, wekelijks of op maat te draaien. Thunderbit’s AI begrijpt zelfs natuurlijke taal (“elke maandag om 9 uur”).

Voor Java-ontwikkelaars is Thunderbit een enorme tijdsbesparing voor prototypes, snelle dataverzameling of zelfs productie—vooral als je niet-technische collega’s zelf data wilt laten verzamelen.

Hoe Thunderbit het verschil maakt voor sales- en operationele teams

Thunderbit is niet alleen voor ontwikkelaars. Sales, marketing, e-commerce en vastgoedteams gebruiken het dagelijks om:

- Leads te genereren: Contactgegevens scrapen uit bedrijvengidsen, LinkedIn of deelnemerslijsten—zonder code.

- Concurrenten te monitoren: Prijzen, productaanbod of marketingacties van concurrenten volgen met geplande scrapes.

- Overzichten samen te voegen: Product-, vastgoed- of vacaturelijsten van verschillende sites in één gestructureerde tabel verzamelen.

Ik heb teams in minder dan 10 minuten zien schakelen van “hadden we die data maar” naar “hier is het spreadsheet”. Dankzij subpagina-scraping en AI-veldherkenning zijn zelfs rommelige, ongestructureerde sites geen probleem meer.

Data-kwaliteit waarborgen bij Java webscraping

Data verzamelen is pas het begin. Als je data onvolledig, rommelig of verouderd is, loop je risico’s. Zo houd ik mijn webscrapers (en mezelf) scherp:

- Valideren en opschonen: Controleer op juistheid, volledigheid en consistentie. Gebruik Java’s sterke typing om vreemde waarden te vangen (zoals een prijs “N/B” in plaats van een getal). Normaliseer formaten—datums, valuta, telefoonnummers—zodat je data direct bruikbaar is ().

- Dubbele data verwijderen: Gescrapete data bevat vaak duplicaten. Gebruik unieke sleutels (zoals URL’s of ID’s) en Java’s

Set-collecties om herhalingen te voorkomen. - Automatische kwaliteitscontroles: Controleer na elke scrape of je het verwachte aantal items hebt, of velden plots leeg zijn. Log afwijkingen en stel meldingen in als er iets misgaat.

- Data slim opslaan: Voor grote jobs: sla data op in een database (Postgres, MongoDB, enz.) in plaats van alles in het geheugen te houden. Databases helpen bij het afdwingen van structuur en het verwijderen van dubbelen ().

Foutafhandeling en robuustheid: sterke webscrapers bouwen

Webscraping is soms een contactsport. Sites gaan offline, HTML verandert, anti-botmaatregelen treden in werking. Zo voorkom je dat je webscraper crasht:

- Netjes omgaan met fouten: Vang HTTP-fouten (404, 500), timeouts en parsing-excepties op. Probeer mislukte verzoeken opnieuw met een backoff—blijf niet eindeloos herhalen ().

- Weerbaar tegen veranderingen: Gebruik robuuste selectors, null-checks en fallback-logica. Als de structuur verandert, log de ruwe HTML voor analyse.

- Logging en meldingen: Log elke fetch, succes en fout. Stel meldingen in voor kritieke issues—zoals nul resultaten als je er honderd verwachtte.

- Checkpoints: Sla bij lange jobs tussentijds je voortgang op. Gaat de webscraper onderuit, dan kun je verder waar je gebleven was.

- Verzoekjes doseren: Wees netjes—wacht tussen verzoeken, beperk het aantal gelijktijdige requests en roteer User-Agent strings om detectie te voorkomen.

Voorbeeld van retry-logica in Java:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Poging " + attempt + " mislukt: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Exponentiële backoff

9 }

10}()

Blijf binnen de regels: juridische en ethische aspecten van webscraping

Webscraping is geen vrijstaat. Er zijn regels—negeer ze en je loopt risico op blokkades of juridische problemen.

- Respecteer data-eigendom: Publieke, niet-gevoelige data scrapen is meestal toegestaan, maar persoonsgegevens (namen, e-mails) vallen onder privacywetgeving zoals AVG en CCPA. Scrape geen persoonsgegevens zonder geldige reden ().

- Volg de voorwaarden en robots.txt: Staat er “geen scraping” in de voorwaarden? Respecteer dat, of wees je bewust van het risico. Houd je altijd aan robots.txt en rate limits.

- Overbelast servers niet: Doseer je verzoeken, beperk gelijktijdigheid en scrape nooit zo agressief dat je de site hindert ().

- Vermijd auteursrechtelijk beschermd of afgeschermde content: Scrape en publiceer geen beschermde content, en haal geen data achter logins zonder toestemming.

- Beveilig en anonimiseer data: Verzamel je gevoelige info, sla die dan veilig op en respecteer verwijderverzoeken.

Praktische tips voor ethisch webscrapen

- Check altijd de voorwaarden en robots.txt van een site.

- Gebruik een duidelijke User-Agent (niet alleen “Java/1.8.0_201”).

- Beperk het aantal verzoeken en gelijktijdige verbindingen.

- Gebruik waar mogelijk API’s of openbare datasets.

- Houd bij wat je scrapt en waarom.

- Blijf op de hoogte van wetgeving en best practices ().

Prestaties optimaliseren: je Java-webscraper opschalen

Als je scraping-behoefte groeit, wordt performance belangrijk. Zo schaal je zonder kopzorgen:

- Parallelle verzoeken: Gebruik Java’s

ExecutorServiceof threadpools om meerdere pagina’s tegelijk te scrapen. Houd de gelijktijdigheid in de hand om sites niet te overbelasten (). - Stream data: Schrijf resultaten direct weg naar een database of bestand—hou niet alles in het geheugen.

- Efficiënt parsen: Gebruik Jsoup-selectors gericht. Voor grote jobs kun je streaming of lichtere parsers overwegen.

- Cloud inzetten: Draai webscrapers op cloudservers voor meer bandbreedte en betrouwbaarheid. Of gebruik cloud scraping-platforms (zoals Thunderbit’s cloudmodus) voor grote volumes.

- Netwerkgebruik optimaliseren: Gebruik compressie, draai webscrapers dicht bij je doelwit en cache waar mogelijk responses.

Voorbeeld van multithreaded scraping in Java:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

Samenvatting: Succesvol webscrapen in Java

De belangrijkste punten voor webscraping in Java op een rij:

- Kies de juiste tool: Jsoup voor statische pagina’s, Selenium/Playwright voor dynamische sites, HtmlUnit voor headless Java-webscraping.

- Maak gebruik van automatisering en AI: Tools als versnellen veldherkenning, subpagina-scraping en data-export—ideaal voor business users of snelle prototypes.

- Zorg voor datakwaliteit: Valideer, maak schoon, verwijder dubbelen en sla data slim op.

- Blijf compliant: Respecteer juridische en ethische grenzen—scrape alleen publieke data, volg de regels van de site en verzamel geen persoonsgegevens zonder geldige reden.

- Schaal slim op: Gebruik Java’s multithreading, efficiënte opslag en cloudresources voor grote projecten.

Webscraping is meer dan techniek—het is een strategisch voordeel. Of je nu als ontwikkelaar robuuste Java-webscrapers bouwt of als sales/operations professional met Thunderbit je dataverzameling automatiseert, met deze best practices ben je klaar voor succes.

Wil je AI-gestuurd scrapen proberen? en ontdek hoe eenvoudig je elke website omzet in een gestructureerde dataset. Meer weten? Bekijk de voor extra tutorials, vergelijkingen en praktijkvoorbeelden.

Veelgestelde vragen

1. Waarom is Java nog steeds een sterke keuze voor webscraping?

Java biedt betrouwbaarheid, krachtige multithreading en naadloze integratie met bedrijfsomgevingen. Ideaal voor grootschalige, langdurige of prestatiegevoelige scraping-taken—vooral als je data-pijplijn al op Java draait ().

2. Wat is het verschil tussen Jsoup, Selenium, HtmlUnit en Playwright?

Jsoup is perfect voor statische HTML; Selenium en Playwright zijn geschikt voor dynamische, JS-rijke sites; HtmlUnit is een pure Java, headless browser voor matige JS. Kies op basis van de complexiteit van de site en je projectbehoeften ().

3. Hoe helpt Thunderbit Java-ontwikkelaars en zakelijke gebruikers?

Thunderbit gebruikt AI om veldherkenning, subpagina-navigatie en datastructurering te automatiseren—zonder code. Ideaal voor business users of ontwikkelaars die snel willen prototypen of niet-technische collega’s zelf data willen laten verzamelen ().

4. Wat zijn de best practices voor datakwaliteit bij webscraping?

Valideer en maak data schoon, verwijder dubbelen, automatiseer kwaliteitscontroles en sla resultaten op in databases bij grote jobs. Zie gescrapete data altijd als ruwe grondstof die bewerking nodig heeft ().

5. Hoe blijf ik compliant en ethisch bij het scrapen van webdata?

Scrape alleen publieke, niet-gevoelige data; respecteer robots.txt en sitevoorwaarden; overbelast servers niet; en verzamel geen persoonsgegevens zonder geldige reden. Blijf op de hoogte van wetgeving zoals AVG en CCPA ().

Klaar om je webscraping-skills te verbeteren? Probeer Thunderbit gratis, of bouw je eigen Java-webscraper met deze best practices in gedachten. Veel succes—en onthoud: codeer verantwoord, scrape ethisch en controleer altijd je data voordat je grote beslissingen neemt.

Meer weten