Heb je ooit op een website gezeten en gedacht: “Kon ik deze hele site maar in één keer in een spreadsheet zetten”? Je bent zeker niet de enige. Zelf heb ik ook vaak eindeloos zitten klikken, kopiëren en plakken, hopend op een slimmere manier om orde te brengen in de online wirwar. Gelukkig is die oplossing er – en het is allang niet meer alleen weggelegd voor techneuten of datawizards.

Websites zijn tegenwoordig veel meer dan alleen een digitaal visitekaartje; ze zijn een goudmijn aan waardevolle info. Salesafdelingen, e-commerce ondernemers, onderzoekers en freelancers zijn allemaal op zoek naar manieren om snel en efficiënt data van het web te halen. De cijfers liegen er niet om: , en . Als je nog steeds handmatig kopieert en plakt, mis je de efficiëntie die moderne site rip tools bieden.

Laten we samen de wereld van site rip induiken: wat het precies is, wie het gebruikt, en de beste tools (inclusief slimme AI-oplossingen) om bestanden van online URL’s te downloaden, je processen te automatiseren en websites om te zetten in bruikbare databronnen.

Wat is Site Rip? Websites omzetten naar bruikbare data

Laten we bij het begin beginnen: wat betekent “site rip” eigenlijk? Kort gezegd: het downloaden van (een deel van) een website voor offline gebruik, back-up of – mijn favoriet – data-extractie. Zie het als het maken van een snapshot van een website, of je nu alles wilt bewaren of alleen de interessante stukken.

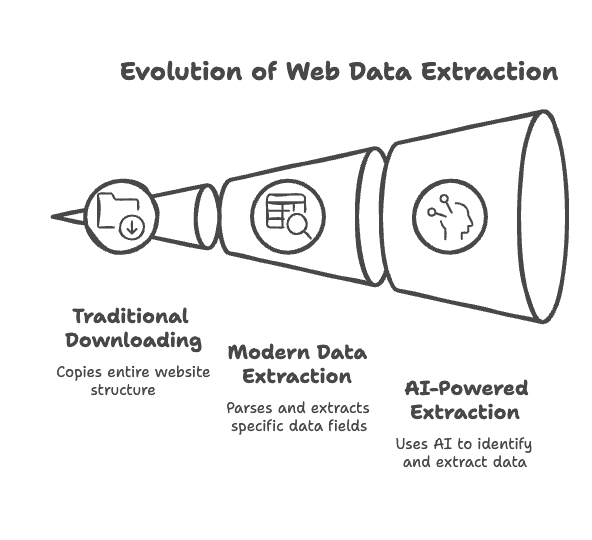

Ouderwetse site rippers (ook wel genoemd), zoals HTTrack of Wget, zijn gemaakt om websites te “spiegelen”: ze halen HTML-pagina’s, afbeeldingen, PDF’s en andere bestanden op, en houden de originele linkstructuur intact zodat je offline kunt bladeren alsof je online bent. Ideaal voor back-ups, migraties of als je de code van een site wilt bekijken.

Maar het wordt pas echt interessant met de moderne site rip tools. Het draait niet meer alleen om het kopiëren van bestanden, maar om . In plaats van een map vol losse bestanden krijg je tabellen, CSV’s of spreadsheets met netjes geordende data. Bijvoorbeeld: in plaats van alleen een productpagina op te slaan, krijg je direct een overzichtelijke lijst met productnamen, prijzen en reviews.

En met AI-webscrapers wordt het nog slimmer. Deze tools snappen de inhoud van een pagina, passen zich aan bij veranderingen en kunnen zelfs de output bewerken – zoals het samenvatten van tekst of het automatisch categoriseren van info. Kortom, .

Wie gebruikt Site Rip? Waarde creëren voor sales, operations en meer

Misschien denk je dat site ripping alleen iets is voor hackers of developers, maar dat is allang verleden tijd. Tegenwoordig gebruiken mensen uit allerlei sectoren deze tools om waarde uit webdata te halen. Hier een overzicht van wie site rip gebruikt en waarom:

| Gebruikersgroep | Voorbeeldtoepassing | Voordeel / ROI |

|---|---|---|

| Sales Teams | Bedrijvengidsen of LinkedIn-profielen scrapen voor leads en contacten | Sneller leads genereren: prospectlijsten in minuten, meer tijd voor verkoop |

| Marketing Teams | Concurrenten monitoren en klantreviews verzamelen | Beter marktoverzicht: actuele inzichten voor effectievere campagnes |

| E-commerce Ops | Prijzen en voorraad van concurrenten volgen | Directe beslissingen: automatische prijsmonitoring voor dynamisch prijsbeleid |

| Onderzoekers/Analisten | Grote datasets verzamelen van nieuwssites, fora of openbare databases | Data op schaal en nauwkeurigheid: volledige datasets met minder fouten, diepere inzichten |

| Makelaars | Woningen en contactgegevens van vastgoedwebsites halen | Concurrentievoordeel: compleet en actueel aanbod voor betere klantadviezen |

| Contentbeheerders | Website-inhoud en media back-uppen of migreren naar een nieuw platform | Contentbehoud: altijd een recente offline kopie, eenvoudig migreren en herstellen |

In al deze gevallen draait het om . Bedrijven die dataverzameling automatiseren, rapporteren en in 2023 gebruikte .

Hoe werkt Site Rip? Van downloaden tot data-extractie

Het proces van site ripping is vrij rechttoe rechtaan, maar de juiste tool maakt het verschil.

Traditionele Website Downloaders:

Je voert een website-URL in, stelt wat opties in (zoals welke bestandstypen je wilt meenemen), en de tool doorzoekt de site en downloadt pagina’s en bestanden. Tools als HTTrack of Cyotek WebCopy zijn hier goed in – ze behouden de structuur zodat je offline kunt bladeren. Maar ze kopiëren alles, zonder onderscheid te maken in welke data je echt nodig hebt.

Moderne Data Extractie Tools:

Deze gaan een stap verder. In plaats van alleen bestanden te downloaden, . Je klikt bijvoorbeeld op een productnaam of prijs, en de tool maakt een workflow om die elementen van alle vergelijkbare pagina’s te verzamelen. Het resultaat? Gestructureerde data in Excel, CSV, JSON of direct in Google Sheets.

De rol van AI:

Hier wordt het pas echt interessant. AI-tools zoals laten je in gewone taal beschrijven wat je wilt (“productnaam, prijs en afbeelding-URL”), en de AI regelt de rest. Geen gedoe meer met HTML of CSS-selectors. AI helpt ook met het opschonen en structureren van data, en past zich aan als de website verandert. Kortom, .

De 8 beste Site Rip Tools voor snelle en eenvoudige data-extractie

Tijd voor de tools! Ik heb de beste opties getest, onderzocht en vergeleken – van klassieke downloaders tot slimme AI-webscrapers. Hier mijn top acht, met de unieke kenmerken van elke tool.

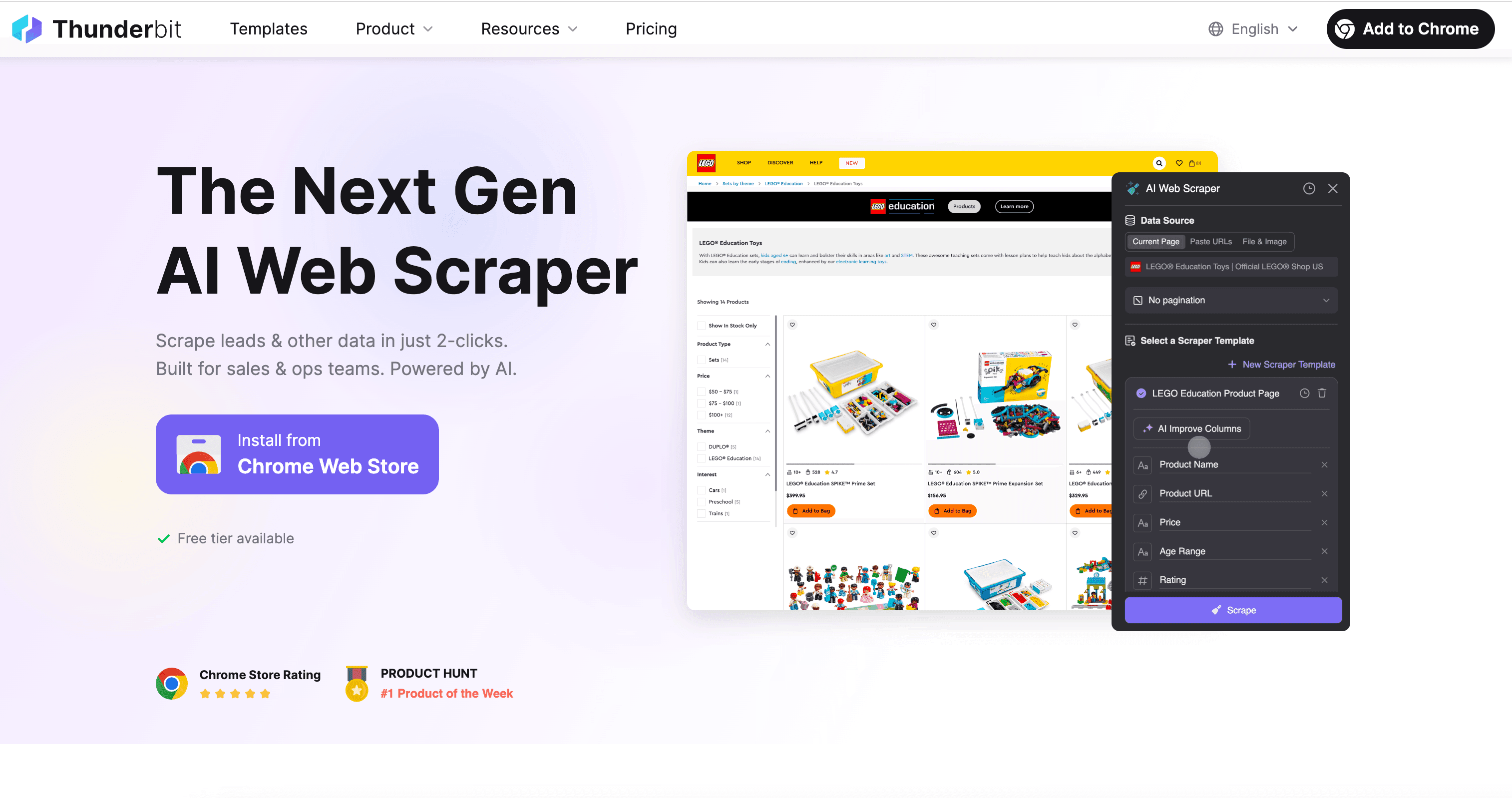

1. Thunderbit: AI-gedreven Site Rip voor iedereen

Eerlijk is eerlijk: Thunderbit is mijn eigen project, ontwikkeld om precies de problemen op te lossen die ik hierboven beschrijf. Onze filosofie: “Websites zijn niet alleen om te lezen – ze zijn gestructureerde databronnen die je kunt benutten.” Oftewel, het web is een goudmijn aan ongestructureerde informatie, en site rip tools zijn de sleutel. AI zorgt ervoor dat je die informatie direct bruikbaar maakt.

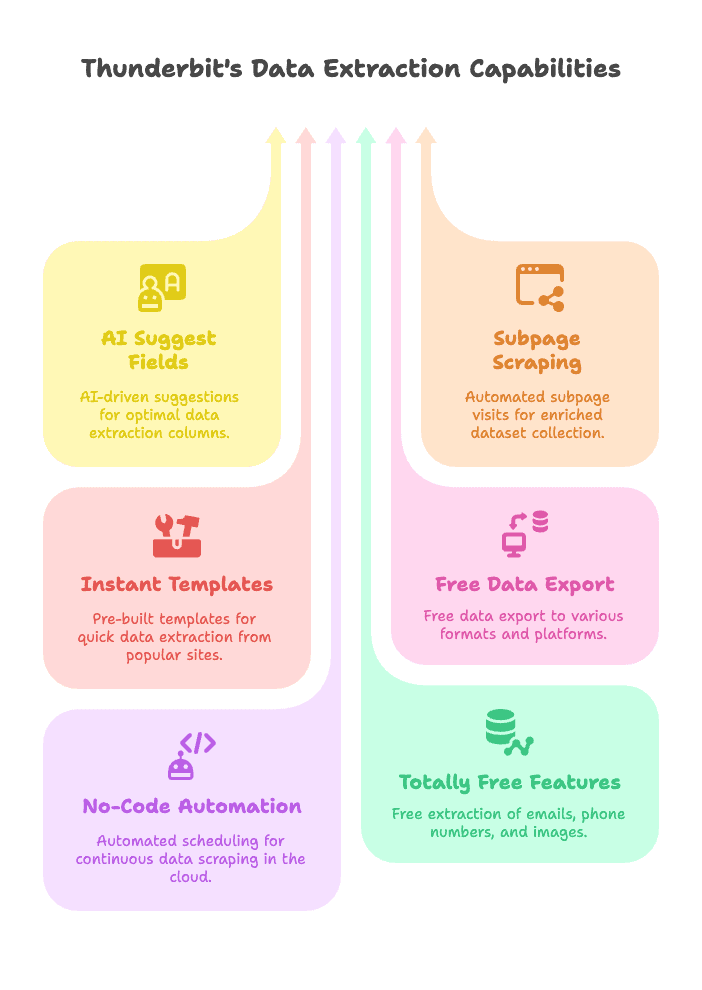

Waarom Thunderbit uniek is

- AI Veldsuggesties: Met één klik leest Thunderbit’s AI de pagina, stelt de beste kolommen voor en zet de webscraper voor je klaar. Geen giswerk of code nodig.

- Subpagina’s Scrapen: Meer nodig dan alleen de lijstpagina? Thunderbit bezoekt automatisch elke subpagina (zoals productdetails) en verrijkt je dataset in één workflow.

- Directe Templates: Voor populaire sites (Amazon, Zillow, Instagram, Shopify en meer) zijn er kant-en-klare sjablonen voor één-klik data-extractie – geen instellingen nodig.

- Gratis Data Export: Exporteer je data naar Excel, Google Sheets, Airtable, Notion of download als CSV/JSON. Geen extra kosten, zelfs niet met het gratis abonnement.

- No-Code Automatisering: Plan scrapes automatisch in (bijvoorbeeld dagelijkse prijschecks) en laat Thunderbit het werk doen in de cloud.

- Volledig Gratis Functies: Haal e-mails, telefoonnummers en afbeeldingen van elke website met één klik – helemaal gratis.

- Ondersteunt 34 Talen: De Chrome-extensie is wereldwijd toegankelijk.

Thunderbit is gemaakt voor niet-technische gebruikers – geen code, geen IT-team nodig. Gewoon aanwijzen, klikken en data ophalen. Onze gebruikers zijn onder andere sales teams die leads verzamelen, e-commerce managers die prijzen monitoren en makelaars die woningaanbod verzamelen. Het mooiste? .

Wil je Thunderbit in actie zien? Bekijk ons of ontdek meer toepassingen op de .

Thunderbit is de makkelijkste manier om gestructureerde data van elke website te halen, of je nu in sales, e-commerce of onderzoek werkt. Dankzij AI-veldherkenning en subpagina-scraping automatiseer je je dataverzameling in een paar klikken.

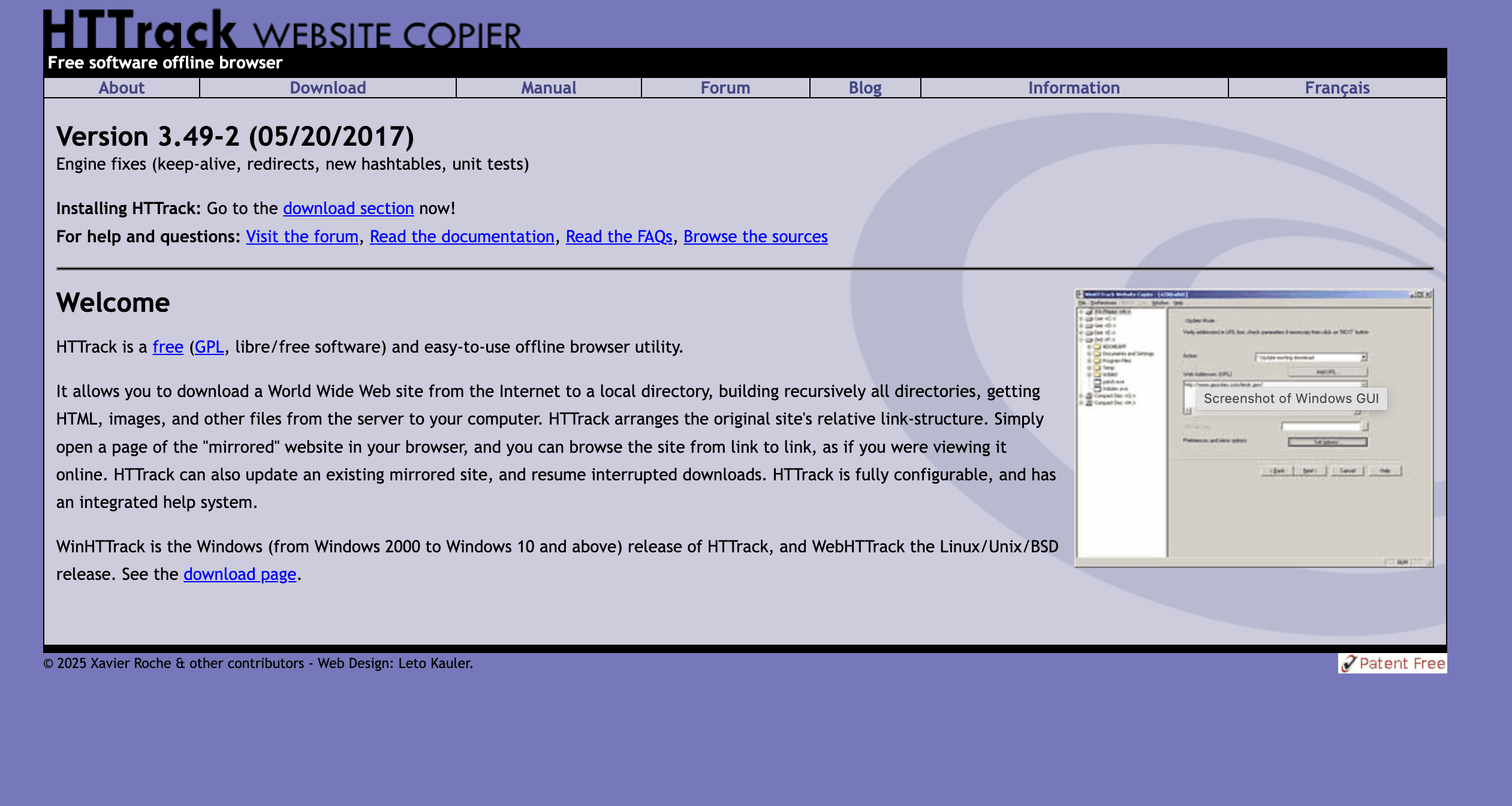

2. HTTrack: Klassieke Website Downloader voor offline browsen

HTTrack is de klassieker onder de site rippers. Al sinds de jaren 90 populair bij archivarissen, onderzoekers en iedereen die een volledige offline kopie van een website wil.

Wat kan het?

- Offline Browsen: Download complete sites (HTML, afbeeldingen, stylesheets, enz.) en behoud de linkstructuur.

- Cross-Platform: Beschikbaar voor Windows, Linux en Android.

- Instelbaar: Stel filters in, bepaal crawl-diepte en hervat onderbroken downloads.

Beperkingen

- Geen Dynamische Content: Heeft moeite met sites die veel JavaScript gebruiken.

- Niet voor Gestructureerde Data: Geeft bestanden en mappen, geen tabellen.

- Kan Overkill zijn: Downloadt alles tenzij je filters instelt.

HTTrack is ideaal voor het back-uppen van statische sites, archiveren of offline browsen. Het is gratis en open-source, maar niet geschikt als je alleen een nette spreadsheet wilt.

3. Octoparse: Visuele Site Rip en Cloud-gebaseerde Data Extractie

Octoparse is een zwaargewicht in de webscraping-wereld, vooral voor zakelijke gebruikers die visuele workflows willen. Het is een Windows-app (met cloudplatform) waarmee je scraping-taken bouwt door simpelweg te klikken – geen code nodig, maar je moet wel snappen hoe websites zijn opgebouwd.

Belangrijkste functies

- Visuele Workflow: Selecteer data met point-and-click, regel paginering, logins of scrollen.

- Cloud Scraping: Draai taken op Octoparse-servers, plan jobs en exporteer data in verschillende formaten.

- Kant-en-klare Templates: Sjablonen voor Amazon, Twitter, Yelp en meer.

- Geavanceerde Opties: IP-rotatie, anti-blokkering, API-toegang en teamwerk.

Plus- en minpunten

- Plus: Kan complexe, dynamische sites aan; krachtig voor grootschalige data-extractie; geen code nodig.

- Min: Steile leercurve voor beginners; betaalde abonnementen kunnen prijzig zijn; vooral gericht op Windows (cloud is cross-platform).

Ben je data-analist of e-commerce manager die regelmatig duizenden records moet scrapen? Dan is Octoparse een goede keuze. Houd wel rekening met de leercurve. Voor een uitgebreide vergelijking, zie .

4. Cyotek WebCopy: Gratis en Flexibele Site Rip voor Windows

Cyotek WebCopy is een gratis Windows-tool waarmee je hele of gedeeltelijke websites kunt downloaden voor offline gebruik. Het is moderner dan HTTrack en biedt meer controle over wat je downloadt.

Highlights

- Aangepaste Regels: Bepaal welke URL’s of bestandstypen je wilt meenemen met wildcards of regex.

- Link Remapping: Past links aan voor soepel offline browsen.

- Rapportages: Maakt crawlapporten om ontbrekende of kapotte links te tonen.

Nadelen

- Alleen voor Windows: Geen Mac- of Linux-versie.

- Geen JavaScript: Kan geen dynamische content aan.

- Leercurve: Veel instellingen voor complexe taken.

Ben je Windows-gebruiker en wil je meer controle over je offline back-ups? Dan is Cyotek WebCopy een flexibele (en gratis) optie.

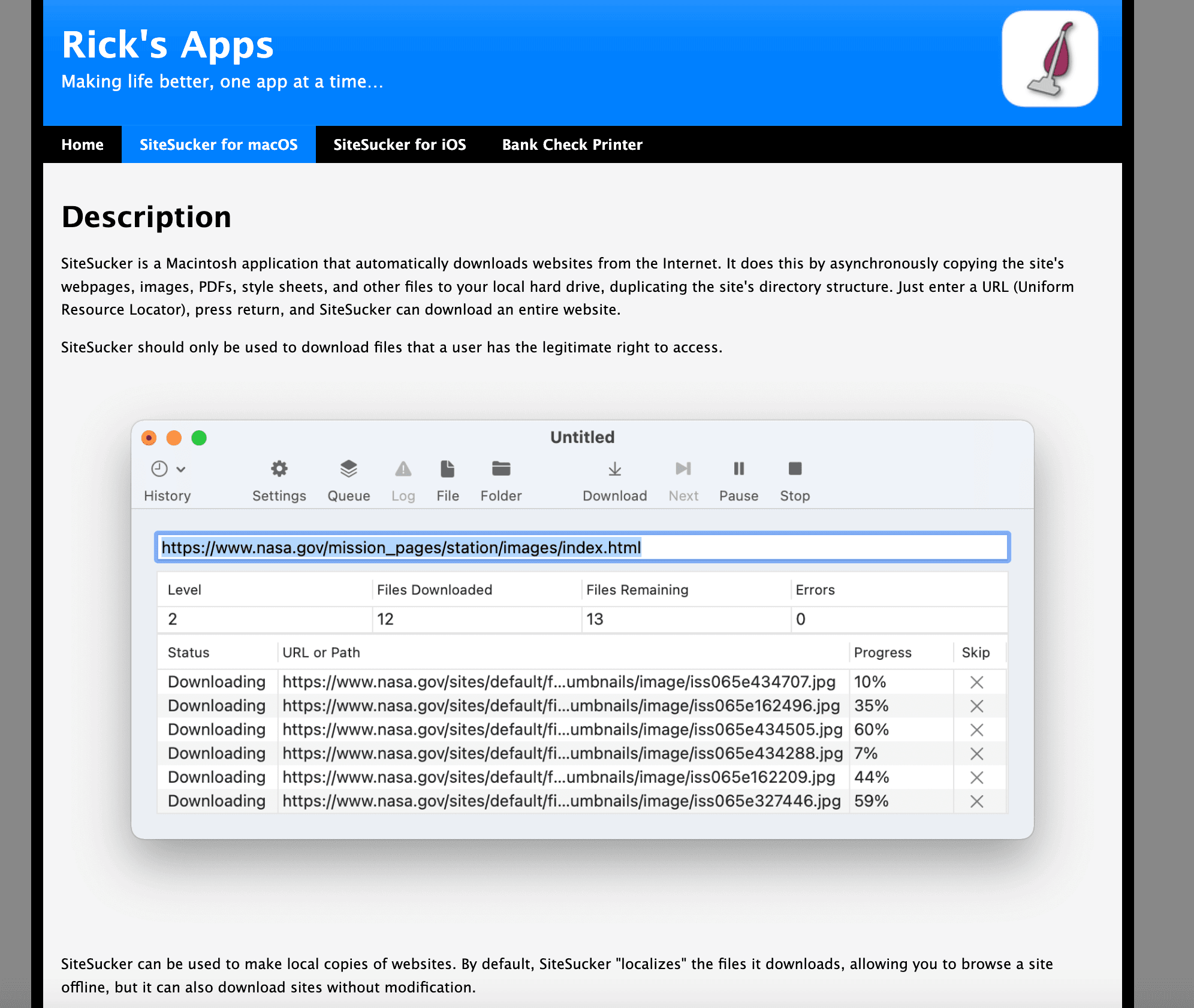

5. SiteSucker: Website Downloader voor Mac

SiteSucker is dé favoriet voor Mac-gebruikers die websites offline willen opslaan. Je vindt het in de Mac App Store en het werkt super eenvoudig.

Functies

- One-Click Download: Voer een URL in, kies een map en klaar.

- Pauzeren/Hervatten: Handig bij grote sites of instabiele verbindingen.

- Meertalige Ondersteuning: Beschikbaar in meerdere talen.

Beperkingen

- Alleen voor Mac: Geen Windows of Linux.

- Alleen Statische Content: Kan geen dynamische of interactieve sites aan.

- Betaalde App: Kost ongeveer €5, maar veel gebruikers vinden het de moeite waard.

SiteSucker is ideaal voor het archiveren van blogs, documentatie of sites die je offline wilt lezen. Voor gestructureerde data-extractie kun je beter een andere tool kiezen.

6. Getleft: Open Source, Meertalige Website Downloader

Getleft is een minder bekende, open-source site ripper met een eenvoudige interface en ondersteuning voor 14 talen. Lichtgewicht en gratis, populair bij studenten en hobbyisten.

Pluspunten

- Bestandstype Selectie: Kies welke bestanden je wilt downloaden (HTML, afbeeldingen, PDF’s, enz.).

- Linkbewerking: Past links aan voor offline gebruik.

- Downloads Hervatten: Kan onderbrekingen goed opvangen.

Minpunten

- Verouderd: Kan niet overweg met moderne, JavaScript-rijke sites.

- Geen Gestructureerde Data: Alleen voor statische HTML-content.

- Ouderwetse UI: Ziet er wat gedateerd uit.

Zoek je een simpele, open-source oplossing voor basis site copying? Dan is Getleft prima.

7. Website : Bestanden van URL Online Downloaden in één klik

Soms wil je gewoon snel iets downloaden zonder installatie. Website is een online tool: voer een URL in en je krijgt een ZIP-bestand met de HTML, CSS, afbeeldingen en andere assets van de site.

Voordelen

- Geen Installatie: Werkt in elke browser.

- Snel Resultaat: Ideaal voor eenmalige downloads of op een computer zonder installatierechten.

- Statische Bestanden: Haalt HTML, afbeeldingen, PDF’s en meer op.

Beperkingen

- Bestandslimiet: Gratis versie tot ongeveer 200 bestanden.

- Geen Gestructureerde Data: Je krijgt ruwe bestanden, geen tabellen.

- Beperkte Instellingen: Geen filters of login-mogelijkheden.

Wil je of de broncode van een site binnenhalen? Dan is Website handig.

8. Eervolle vermeldingen

Naast de zeven bovenstaande tools zijn er nog enkele niche-opties:

- Wget: Command-line tool voor gevorderden, vooral op Linux.

- Wayback Machine Downloader: Voor het archiveren van historische versies van websites.

- Andere Chrome-extensies: Er zijn er veel, maar weinig bieden de AI-functies van Thunderbit.

Snel Vergelijkingsoverzicht: Welke Site Rip Tool past bij jou?

| Tool | Platform | Prijs | Belangrijkste functies | Beste voor | Beperkingen |

|---|---|---|---|---|---|

| Thunderbit | Chrome-extensie + Cloud | Gratis/Betaald | AI-veldherkenning, subpagina scraping, sjablonen, planning, export | Gestructureerde data, no-code gebruikers | Kredietlimieten, Chrome vereist |

| HTTrack | Windows/Linux/Android | Gratis (Open Source) | Volledige site-mirroring, instelbaar, hervatten, cross-platform | Offline browsen, back-up | Geen JS, geen datatabellen |

| Cyotek WebCopy | Windows | Gratis | Aangepaste regels, link remapping, rapporten | Aangepaste offline kopieën | Alleen Windows, geen JS, leercurve |

| Octoparse | Windows + Cloud | Gratis/Betaald | Visuele workflow, cloud scraping, sjablonen, API | Data-analisten, e-commerce, grote datasets | Leercurve, prijs, Windows-focus |

| SiteSucker | macOS | Betaald (~€5) | One-click download, pauzeren/hervatten, meertalig | Mac-gebruikers, offline lezen | Alleen Mac, statische content, geen datatabellen |

| Getleft | Windows/Linux | Gratis (Open Source) | Bestandstype selectie, meertalig, hervatten | Open-source fans, simpele sites | Verouderd, geen JS, geen gestructureerde data |

| Website Downloader.io | Web (elk OS) | Gratis/Betaald | Browser-based, snelle ZIP-download, statische assets | Snel downloaden, geen installatie | Bestandslimiet, geen filters, alleen statisch |

Meer details? Bekijk de .

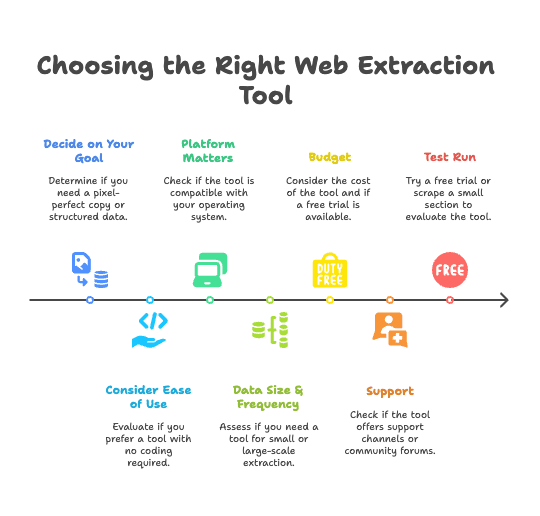

Hoe kies je de juiste Site Rip Tool voor jouw workflow?

Met zoveel opties, hoe maak je de juiste keuze? Hier mijn praktische tips, gebaseerd op jaren ervaring met het automatiseren van webdata-processen:

- Bepaal je doel:

- Wil je een exacte offline kopie? Kies een traditionele downloader (HTTrack, WebCopy, SiteSucker).

- Wil je gestructureerde data (zoals product- of contactlijsten)? Gebruik een data-extractietool (Thunderbit, Octoparse).

- Let op gebruiksgemak:

- Snel resultaat zonder code? is ideaal.

- Wil je meer controle en ben je bereid te leren? Probeer Octoparse of Cyotek WebCopy.

- Platform:

- Mac? Kies Thunderbit (Chrome) of SiteSucker.

- Windows? Alle opties zijn mogelijk.

- Linux? HTTrack, Getleft of Thunderbit (via Chrome).

- Dataomvang & frequentie:

- Eenmalig, klein project? Website of een gratis tool volstaat.

- Regelmatig, grootschalig? Investeer in automatisering met Thunderbit of Octoparse.

- Budget:

- Gratis/open-source tools zijn prima, maar betaalde oplossingen besparen vaak meer tijd (en frustratie) op de lange termijn.

- Veel betaalde tools bieden gratis proefperiodes – maak daar gebruik van.

- Ondersteuning:

- Hulp nodig? Thunderbit en Octoparse bieden support. Open-source tools zijn afhankelijk van community-forums.

- Test het uit:

- Probeer een gratis proefversie of scrape een klein deel om te zien of de tool voldoet.

Voorbeeldscenario’s:

Voorbeeldscenario’s:

- Sales Ops: Wekelijks leads verzamelen? Thunderbit’s AI en planning besparen je uren.

- Archiveren: Back-up van je bedrijfswebsite nodig? Gebruik HTTrack of WebCopy.

- Onderzoek: Concurrentiegegevens nodig? Thunderbit of Octoparse levert gestructureerde tabellen.

- Offline lezen: Interessante tutorials gevonden? SiteSucker (Mac) of HTTrack (Windows) is perfect.

Twijfel je nog? is een laagdrempelige start – werkt het niet voor jou, probeer dan een andere tool.

Conclusie: De toekomst van Site Rip – van handmatig kopiëren naar AI-gedreven data-extractie

We zijn ver gekomen sinds de tijd van handmatig webpagina’s in Excel plakken. Site rip tools zijn geëvolueerd van simpele website downloaders tot AI-platforms voor data-extractie. De toekomst? Websites worden gezien als databronnen, niet alleen als leesmateriaal.

De visie van Thunderbit is duidelijk: “Websites zijn er niet alleen om te lezen – ze zijn er om te gebruiken.” De slimste teams kopiëren en plakken niet meer, maar laten AI het zware werk doen. Met de juiste tool kan iedereen de informatie op het web omzetten in bruikbare inzichten, back-ups of producten.

Stop dus met handmatig werk en kies voor automatisering. Of je nu sales, marketing, onderzoek doet of gewoon nieuwsgierig bent: er is altijd een site rip tool die bij je past. Het tijdperk van AI-gedreven site ripping is aangebroken en maakt webdata toegankelijk voor iedereen.

Klaar om je workflow te upgraden? en sluit je aan bij de mensen die handmatig kopiëren voorgoed achter zich laten.

Verder lezen:

Veel succes met data-extractie!

Veelgestelde vragen

1. Wat is Site Rip en hoe werkt het?

Site rip betekent het downloaden van (een deel van) een website voor offline gebruik, back-up of data-extractie. Traditionele tools zoals HTTrack maken een offline kopie, terwijl moderne tools met AI gestructureerde data zoals tabellen, productlijsten of contactgegevens exporteren naar bijvoorbeeld CSV of Excel.

2. Wie heeft baat bij Site Rip tools?

Site rip tools zijn waardevol voor uiteenlopende gebruikers: sales teams die leads verzamelen, marketingteams die concurrenten volgen, e-commerce managers die prijzen monitoren, onderzoekers die datasets verzamelen, makelaars die woningaanbod scrapen en contentbeheerders die websites back-uppen.

3. Hoe verschillen AI-gedreven Site Rip tools van traditionele downloaders?

AI-tools zoals Thunderbit begrijpen de inhoud van webpagina’s, herkennen automatisch relevante data, passen zich aan bij veranderingen en exporteren schone, gestructureerde data. Traditionele tools kopiëren vooral ruwe websitebestanden zonder de inhoud te analyseren.

4. Wat zijn de beste Site Rip tools van dit moment?

Toptools zijn onder andere Thunderbit voor AI-gedreven data-extractie, HTTrack en Cyotek WebCopy voor volledige site downloads, Octoparse voor visuele scraping workflows, SiteSucker voor Mac-gebruikers en Downloader.io voor snelle browsergebaseerde downloads. Elke tool past bij een ander platform, doel en gebruikersniveau.

5. Hoe kies ik de juiste Site Rip tool voor mijn situatie?

Bepaal eerst je doel – offline toegang of gestructureerde data-extractie. Kijk dan naar je platform (Windows, Mac, enz.), gebruiksgemak, budget en hoe vaak/groot je data wilt scrapen. Thunderbit is ideaal voor no-code gebruikers die gestructureerde data willen, HTTrack is perfect voor statische site-back-ups.