Stel je het volgende scenario voor: het is 8:30 uur, je hebt net een verse bak koffie gezet en je leidinggevende (of misschien zelfs diens baas) vraagt je om een spreadsheet met alle productprijzen van de concurrent, klantreviews én – waarom ook niet – de favoriete pizzatopping van hun CEO. Je kunt urenlang copy-pasten, of je laat Python het zware werk doen. Maar wat als je niet kunt programmeren, of geen zin hebt om je ochtend te verprutsen aan het debuggen van HTML? Dan is deze gids precies wat je zoekt.

Ik ben Shuai Guan, medeoprichter en CEO van , en ik heb jarenlange ervaring in SaaS, automatisering en AI. Ik help teams om de chaos van webdata om te zetten in bruikbare inzichten. In deze blog neem ik je mee langs de top 10 Python webscraping bibliotheken voor 2025—wat ze doen, hoe ze werken, hun plus- en minpunten en wanneer je ze het beste inzet. En als je denkt: “Klinkt goed, maar ik kan nog steeds geen Python schrijven,” geen paniek. Ik laat je ook zien hoe je met Thunderbit’s no-code AI-webscraper in twee klikken hetzelfde voor elkaar krijgt—zonder code, zonder gedoe, en zonder een overdosis cafeïne.

Waarom Python webscraping bibliotheken onmisbaar zijn voor zakelijke teams

- Leadgeneratie & Sales: Verzamel moeiteloos gegevens uit bedrijvengidsen, sociale netwerken of fora om gerichte prospectlijsten te bouwen—namen, e-mails, social media-profielen, noem maar op. Sales-teams kunnen zo handmatig werk automatiseren dat normaal uren kost ().

- Prijsmonitoring & concurrentieanalyse: E-commerce teams houden realtime prijzen, voorraad en acties van concurrenten bij en kunnen hun eigen strategie direct aanpassen ().

- Marktonderzoek & trendanalyse: Door reviews, social media of nieuwssites te scrapen, ontdekken marketing- en productteams trends en klantgevoelens voordat ze mainstream worden ().

- Vastgoed & woningdata: Makelaars en analisten verzamelen eenvoudig woningaanbod, prijzen en details van verschillende platforms, waardoor marktanalyses een fluitje van een cent worden.

- E-commerce processen: Van leveranciersdata tot cataloguscontroles—scraping zorgt voor nauwkeurigheid en bespaart teams eindeloos handmatig werk.

Kortom: . Maar er zit een addertje onder het gras: de meeste Python webscraping bibliotheken gaan ervan uit dat je kunt programmeren. Voor niet-technische gebruikers is dat een flinke hobbel. Daarom winnen no-code, AI-gedreven tools zoals razendsnel terrein—daarover straks meer.

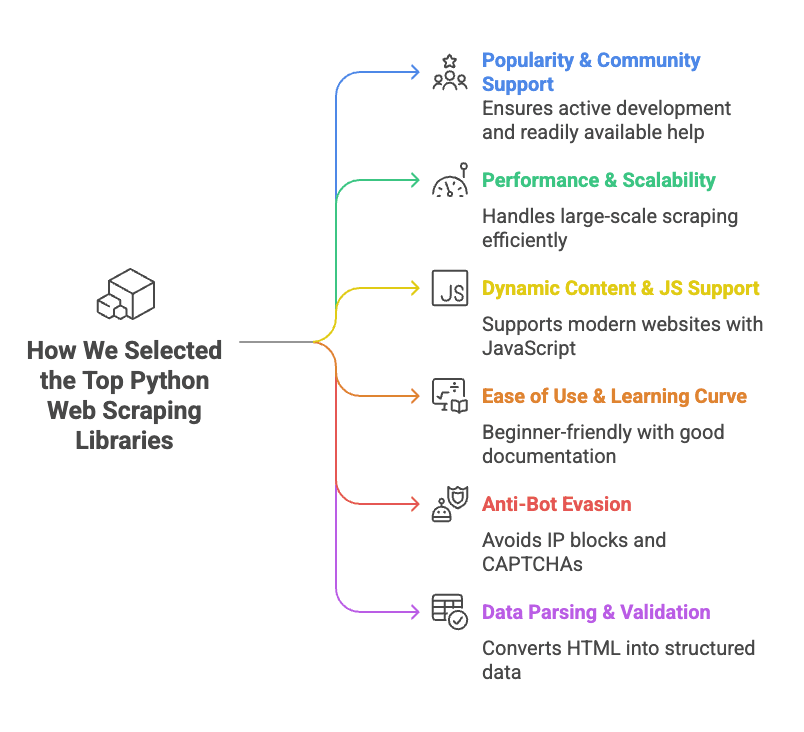

Hoe we de beste Python webscraping bibliotheken hebben gekozen

- Populariteit & community support: Bibliotheken met veel GitHub-sterren, actieve ontwikkeling en veel tutorials. Als je vastloopt, wil je snel een antwoord op Stack Overflow.

- Prestaties & schaalbaarheid: Kan de tool duizenden pagina’s aan? Ondersteunt het gelijktijdige of asynchrone verzoeken? Is het snel, of kun je net zo goed een stagiair inhuren?

- Dynamische content & JS-ondersteuning: Veel moderne sites laden data via JavaScript. Bibliotheken die hiermee overweg kunnen (via browserautomatisering of API-integratie) scoren hoger.

- Gebruiksgemak & leercurve: Sommige tools zijn plug-and-play, andere vereisen een master in “waarom werkt dit niet?” We geven de voorkeur aan tools die toegankelijk zijn voor beginners of goed gedocumenteerd.

- Anti-bot omzeiling: Kan de tool omgaan met IP-blokkades, CAPTCHAs of strenge limieten? Zo niet, dan kun je na vijf minuten scrapen zomaar vijf dagen geblokkeerd zijn.

- Dataparseren & validatie: Het gaat niet alleen om HTML ophalen—je wilt schone, gestructureerde data. Bibliotheken die helpen met parseren of valideren krijgen extra punten.

Bij elke bibliotheek bespreken we wat het is, hoe je het gebruikt, de voor- en nadelen en wanneer het uitblinkt.

Snel overzicht: Python webscraping bibliotheken in één oogopslag

Hier vind je een vergelijking van de top 10 bibliotheken, zodat je snel de juiste tool voor jouw situatie kiest (en je je leidinggevende kunt imponeren met je nieuwe webscraping-kennis):

| Bibliotheek | Gebruiksgemak | JS-ondersteuning | HTTP-verzoeken | HTML-parsing | Anti-bot functies | Datavalidatie | Ideaal voor |

|---|---|---|---|---|---|---|---|

| ZenRows | Zeer eenvoudig (API) | ✅ (browser) | ✅ (API) | ✅ | ✅ (proxies, CAPTCHA-omzeiling) | ❌ | Grootschalig scrapen van beschermde sites |

| Selenium | Gemiddeld | ✅ (browser) | ✅ (browser) | Gedeeltelijk | ❌ | ❌ | Dynamische, interactieve sites |

| Requests | Zeer eenvoudig | ❌ | ✅ | ❌ | ❌ | ❌ | Statische pagina’s, API’s |

| Beautiful Soup | Eenvoudig | ❌ | ❌ | ✅ | ❌ | ❌ | HTML-parsing van statische pagina’s |

| Playwright | Gemiddeld | ✅ (browser) | ✅ (browser) | DOM-toegang | ❌ | ❌ | Moderne webapps, multi-browser support |

| Scrapy | Gemiddeld/moeilijk | Gedeeltelijk (add-ons) | ✅ (async) | ✅ | ❌ | Beperkt | Grootschalige, gestructureerde crawls |

| urllib3 | Eenvoudig (laag-niveau) | ❌ | ✅ | ❌ | ❌ | ❌ | Custom HTTP, hoge gelijktijdigheid |

| HTTPX | Eenvoudig/gemiddeld | ❌ (async IO) | ✅ (async) | ❌ | ❌ | ❌ | High-performance, async scraping |

| lxml | Gemiddeld | ❌ | ❌ | ✅ (snel) | ❌ | ❌ | Snel parsen, complexe HTML/XML |

| Pydantic | Gemiddeld | N.v.t. | N.v.t. | N.v.t. | N.v.t. | ✅ | Datavalidatie na scraping |

Let op: “JS-ondersteuning” betekent dat de tool JavaScript-rendered content aankan. “Anti-bot functies” verwijst naar ingebouwde maatregelen, niet wat je zelf kunt toevoegen.

ZenRows: Alles-in-één Python webscraping oplossing

Wat is het?

is een webscraping-API die het zware werk uit handen neemt—zoals roterende proxies, CAPTCHA-omzeiling, browser-fingerprinting en JavaScript-rendering. Je doet een API-aanroep en ZenRows regelt de rest.

Hoe gebruik je het:

Registreer voor een API-sleutel en gebruik vervolgens Python’s requests-bibliotheek om ZenRows aan te roepen:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Voordelen:

- Omzeilt de meeste anti-botmaatregelen (proxies, CAPTCHAs, enz.)

- Geschikt voor sites met veel JavaScript

- Eenvoudige API—geen gedoe met browsers of proxies

- Schaalbaar voor grote projecten

Nadelen:

- Betaalde dienst (gratis proefperiode, daarna kosten)

- Je bent afhankelijk van een externe API

Ideaal voor:

Grote hoeveelheden data scrapen, vooral op sites die bots actief blokkeren of JavaScript vereisen. Als je vaak geblokkeerd wordt of CAPTCHAs moet oplossen, is ZenRows het proberen waard ().

Selenium: Browsers automatiseren voor dynamische webscraping

Wat is het?

is de klassieker op het gebied van browserautomatisering. Je kunt Chrome, Firefox of andere browsers aansturen vanuit Python en zo klikken, formulieren invullen, scrollen en meer simuleren. Alles wat een mens in de browser kan doen, kan Selenium ook.

Hoe gebruik je het:

Installeer Selenium en een browserdriver (zoals ChromeDriver), en dan:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Voordelen:

- Kan alles aan wat een echte browser kan (dynamische content, logins, pop-ups)

- Simuleert gebruikersacties (klikken, typen, enz.)

- Ondersteunt meerdere browsers

Nadelen:

- Vraagt veel van je computer (elke browserinstantie gebruikt RAM en CPU)

- Langzamer dan HTTP-gebaseerde scraping

- Steilere leercurve (vooral bij gelijktijdigheid)

- Kan worden gedetecteerd door geavanceerde anti-botsystemen

Ideaal voor:

Scrapen van dynamische, JavaScript-rijke sites die interactie vereisen—denk aan LinkedIn, dashboards of alles achter een login ().

Requests: De standaard Python HTTP-client

Wat is het?

is de “HTTP voor mensen”-bibliotheek. Het is dé manier om webpagina’s of API’s op te halen in Python—eenvoudig, betrouwbaar en overal te vinden.

Hoe gebruik je het:

Een statische pagina ophalen:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Voordelen:

- Zeer eenvoudige API

- Snel en lichtgewicht

- Ondersteunt cookies, redirects en de meeste HTTP-behoeften

- Grote community, veel tutorials

Nadelen:

- Kan geen JavaScript uitvoeren of dynamische content ophalen

- Geen ingebouwde HTML-parsing (combineer met Beautiful Soup of lxml)

- Geen anti-bot functies (je moet zelf headers, proxies, enz. regelen)

Ideaal voor:

Statische pagina’s, API’s of sites waar de data direct in de HTML staat. Voor beginners is Requests + Beautiful Soup een klassieker ().

Beautiful Soup: Eenvoudig HTML parsen voor Python webscraping

Wat is het?

(BS4) is een Python-bibliotheek voor het parsen van HTML en XML. Het haalt zelf geen pagina’s op—je combineert het met Requests of Selenium—maar het maakt het vinden en extraheren van data uit HTML heel eenvoudig.

Hoe gebruik je het:

Productnamen van een pagina halen:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Voordelen:

- Zeer toegankelijk, vergeeft rommelige HTML

- Flexibel zoeken (op tag, klasse, CSS-selector, regex)

- Lichtgewicht en snel voor de meeste toepassingen

- Veel documentatie en voorbeelden

Nadelen:

- Haalt zelf geen pagina’s op en kan geen JavaScript aan

- Langzamer dan lxml bij grote documenten

- Minder krachtig voor complexe queries (gebruik lxml voor geavanceerde XPath)

Ideaal voor:

Ruwe HTML omzetten naar gestructureerde data—productlijsten, tabellen of links. Als je de HTML hebt, helpt Beautiful Soup je om er structuur in te brengen ().

Playwright: Moderne browserautomatisering voor Python webscraping

Wat is het?

is de nieuwe speler op het gebied van browserautomatisering, ontwikkeld door Microsoft. Net als Selenium stuurt het browsers aan, maar het is sneller, ondersteunt meerdere engines (Chromium, Firefox, WebKit) en heeft een modernere API.

Hoe gebruik je het:

De inhoud van een pagina ophalen:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Voordelen:

- Geschikt voor dynamische, JavaScript-rijke sites

- Ondersteunt meerdere browsers (Chromium, Firefox, WebKit)

- Wacht automatisch op elementen (minder foutgevoelig dan Selenium)

- Ondersteunt async en parallel scraping

Nadelen:

- Nog steeds zwaar qua resources (browserautomatisering)

- Leercurve, vooral bij async code

- Niet ongevoelig voor anti-botdetectie

Ideaal voor:

Moderne webapps, sites die zich anders gedragen in verschillende browsers, of als je netwerkverzoeken wilt onderscheppen ().

Scrapy: Schaalbaar Python webscraping framework

Wat is het?

is een compleet webscraping-framework. Het is gemaakt voor grootschalig crawlen, met ingebouwde gelijktijdigheid, pipelines en exportmogelijkheden. Als je duizenden pagina’s wilt scrapen, is Scrapy je beste vriend.

Hoe gebruik je het:

Definieer een spider:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Run met scrapy crawl quotes binnen een Scrapy-project.

Voordelen:

- Hoge prestaties, ingebouwde gelijktijdigheid

- Gestructureerde projectopzet (spiders, pipelines, middlewares)

- Eenvoudig exporteren naar CSV, JSON, databases

- Grote community, veel plugins

Nadelen:

- Steile leercurve voor beginners

- Vereist projectstructuur (minder geschikt voor snelle eenmalige taken)

- Beperkte JavaScript-ondersteuning standaard (add-ons nodig)

Ideaal voor:

Grote, herhaalbare crawls—zoals het verzamelen van woningaanbod van meerdere sites of het crawlen van complete productcatalogi ().

Urllib3: Betrouwbare HTTP voor Python webscraping

Wat is het?

is een laag-niveau HTTP-client die onder andere Requests aandrijft. Heb je veel controle nodig over connecties, retries of pooling, dan is urllib3 jouw tool.

Hoe gebruik je het:

Een pagina ophalen:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Voordelen:

- Snel, efficiënt connection pooling

- Thread-safe, ideaal voor gelijktijdig scrapen

- Veel controle over HTTP-gedrag

Nadelen:

- Meer handmatig werk dan Requests

- Geen HTML-parsing of JS-ondersteuning

- Minder documentatie voor beginners

Ideaal voor:

Maatwerk HTTP-scenario’s, scraping met hoge gelijktijdigheid of als je maximale prestaties wilt ().

HTTPX: Moderne, async-ready Python webscraping bibliotheek

Wat is het?

is de nieuwe generatie HTTP-client voor Python. Het lijkt op Requests, maar ondersteunt standaard async en HTTP/2. Wil je duizenden pagina’s tegelijk scrapen, dan is HTTPX jouw vriend.

Hoe gebruik je het:

Synchronous:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Async:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Voordelen:

- Async-ondersteuning voor supersnel scrapen

- HTTP/2-ondersteuning (sneller voor veel sites)

- Requests-achtige API (makkelijk overstappen)

- Betere foutafhandeling

Nadelen:

- Relatief nieuw, dus minder tutorials dan Requests

- Async vereist kennis van event loops

- Geen ingebouwde HTML-parsing

Ideaal voor:

Snel, grootschalig scrapen, API’s of als je veel pagina’s tegelijk wilt verwerken ().

lxml: Supersnel en krachtig HTML/XML parsen voor Python webscraping

Wat is het?

is een high-performance bibliotheek voor het parsen van HTML en XML, met ondersteuning voor XPath en CSS-selectors. Het is de motor achter veel andere tools (zoals de selectors van Scrapy).

Hoe gebruik je het:

Quotes en auteurs extraheren:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Voordelen:

- Razendsnel, zelfs bij grote documenten

- Krachtige XPath-ondersteuning voor complexe queries

- Geheugenefficiënt

Nadelen:

- Leercurve voor XPath-syntax

- Minder toegankelijke documentatie dan BS4

- Installatie kan lastig zijn op sommige systemen

Ideaal voor:

Grote of complexe HTML/XML-bestanden parsen, of als je geavanceerde zoekopdrachten nodig hebt ().

Pydantic: Datavalidatie voor schone Python webscraping resultaten

Wat is het?

is geen scraper, maar een bibliotheek voor datavalidatie en -modellering. Na het scrapen zorgt Pydantic ervoor dat je data schoon, getypeerd en klaar voor zakelijk gebruik is.

Hoe gebruik je het:

Geparste data valideren:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Voordelen:

- Strikte validatie (fouten worden vroeg opgemerkt)

- Automatische typeconversie (strings naar getallen, datums, enz.)

- Declaratieve datamodellen (duidelijke, onderhoudbare code)

- Geschikt voor complexe, geneste data

Nadelen:

- Leercurve voor modelsyntax

- Voegt wat overhead toe aan je pipeline

Ideaal voor:

Zorgen dat je gescrapete data schoon, consistent en klaar voor analyse of import is ().

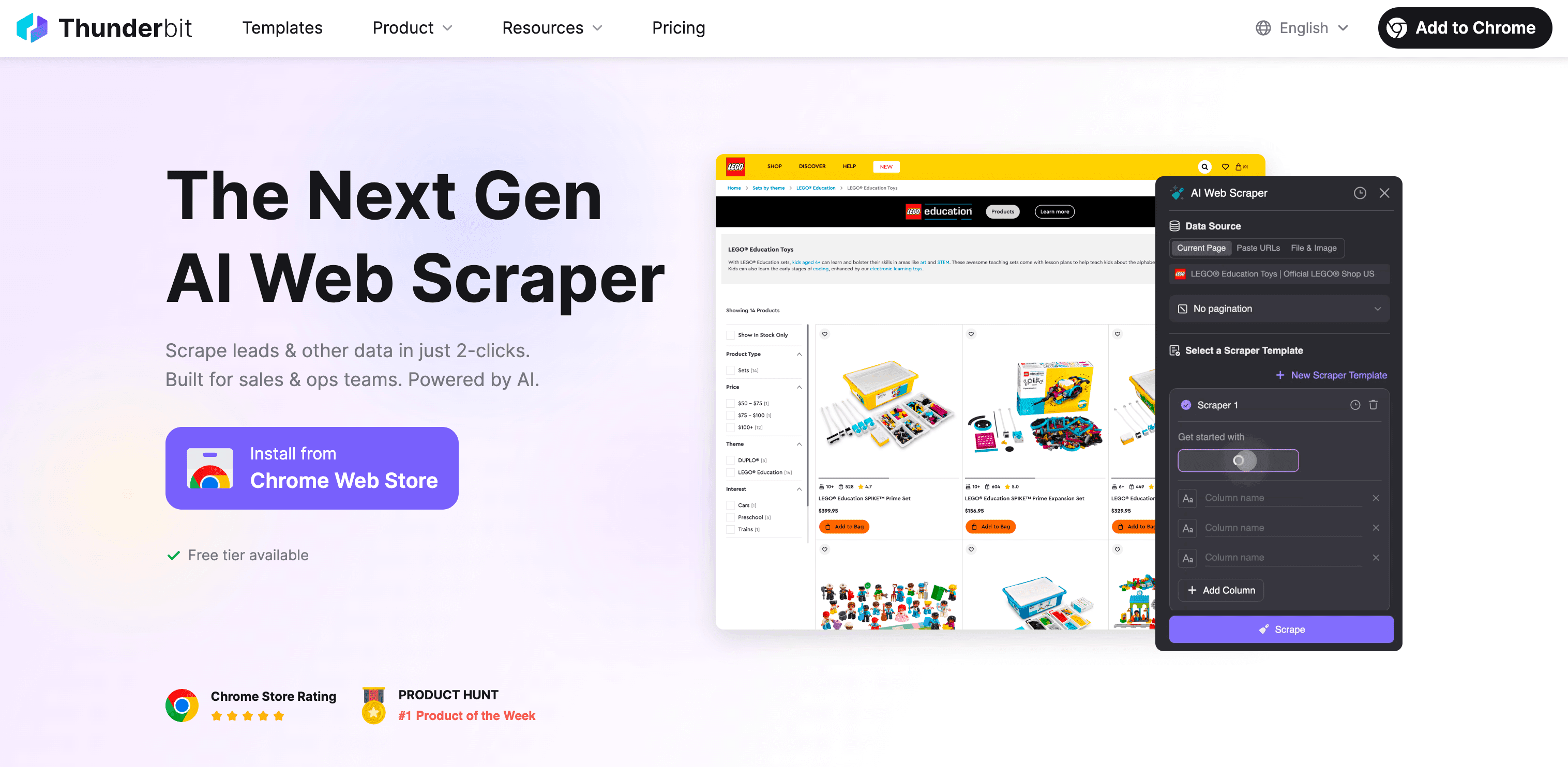

No-code alternatief: Thunderbit AI-webscraper voor zakelijke gebruikers

Laten we eerlijk zijn. Als je tot hier hebt gelezen en denkt: “Python is krachtig, maar ik wil mijn weekend niet besteden aan het leren van XPath,” dan ben je niet de enige. Precies daarom hebben we ontwikkeld.

Wat is Thunderbit?

Thunderbit is een AI-gedreven, no-code webscraper Chrome-extensie. Speciaal ontworpen voor zakelijke gebruikers—sales, e-commerce, marketing, makelaars—die webdata nodig hebben, maar geen zin hebben in code, proxies of anti-bot gedoe.

Waarom Thunderbit beter is dan Python-bibliotheken voor niet-programmeurs:

- Geen code nodig: Klik op “AI Velden voorstellen”, laat Thunderbit’s AI de pagina lezen en druk op “Scrapen”. Dat is alles. Je kunt elke website, PDF of afbeelding in twee klikken scrapen.

- Geschikt voor dynamische content: Omdat Thunderbit in je browser (of via de cloud) werkt, kan het data ophalen van JavaScript-rijke sites, infinite scrolls of zelfs achter logins.

- Subpagina’s scrapen: Details van elke product- of profielpagina nodig? Thunderbit bezoekt automatisch elke subpagina en vult je tabel aan.

- AI-gestuurde datastructurering: Thunderbit stelt veldnamen, datatypes en zelfs aangepaste prompts voor elk veld voor. Je kunt data direct labelen, formatteren, vertalen en ordenen.

- Anti-bot bestendig: Geen proxies of blokkades regelen—Thunderbit gebruikt echte browsersessies en AI om de meeste anti-scrapingmaatregelen te omzeilen.

- Overal exporteren: Download je data naar Excel, Google Sheets, Airtable, Notion, CSV of JSON—gratis en onbeperkt.

- Kant-en-klare templates: Voor populaire sites (Amazon, Zillow, Instagram, Shopify, enz.) kies je gewoon een template. Geen gedoe, direct aan de slag.

- Gratis functies: E-mail-, telefoon- en afbeeldings-extractors zijn helemaal gratis. Ook AI-autofill voor online formulieren.

Hoe verhoudt het zich tot Python-bibliotheken?

| Functie | Python-bibliotheken | Thunderbit |

|---|---|---|

| Code vereist | Ja | Nee |

| Dynamische content | Soms (browsertools) | Ja (browser/cloud) |

| Anti-bot aanpak | Handmatig (proxies, headers) | Ingebouwd (browsersessie, AI) |

| Datastructurering | Handmatig (code, parsing) | AI-gestuurd, automatisch |

| Subpagina’s scrapen | Eigen code | 1 klik |

| Exportopties | CSV/JSON (code) | Excel, Google Sheets, Airtable, Notion, enz. |

| Templates | Zelf maken of community | Ingebouwd voor populaire sites |

| Onderhoud | Jij (scripts updaten) | Thunderbit-team regelt updates |

Voor wie is Thunderbit bedoeld?

Werk je in sales, e-commerce, marketing of vastgoed en heb je webdata nodig—leads, prijzen, productinformatie, woningaanbod—maar geen technische achtergrond? Dan is Thunderbit voor jou gemaakt. Het is de snelste manier van “ik heb deze data nodig” naar “hier is je spreadsheet”, zonder Python.

Wil je het zelf proberen? en gebruik het gratis. Of lees meer tips op de .

Conclusie: De juiste Python webscraping bibliotheek (of no-code tool) kiezen

Kort samengevat: Python webscraping bibliotheken zijn krachtig, flexibel en kunnen bijna elk scenario aan—mits je kunt programmeren en er tijd in wilt steken. Een kort overzicht:

- ZenRows: Ideaal voor grootschalig scrapen van beschermde sites, met ingebouwde anti-bot functies.

- Selenium & Playwright: Perfect voor dynamische, interactieve sites, maar zwaarder en complexer.

- Requests & HTTPX: Geweldig voor statische pagina’s en API’s; HTTPX blinkt uit in async, supersnel scrapen.

- Beautiful Soup & lxml: Dé tools voor HTML-parsing—BS4 voor beginners, lxml voor snelheid en kracht.

- Scrapy: Het framework voor grote, gestructureerde crawls.

- urllib3: Voor maatwerk en hoge gelijktijdigheid.

- Pydantic: Zorgt dat je gescrapete data schoon en bruikbaar is.

Maar als je geen programmeur bent—of je wilt gewoon snel resultaat— is je shortcut. Geen code, geen onderhoud, gewoon direct resultaat.

Mijn advies:

- Ben je gek op Python en wil je volledige controle? Kies de bibliotheek die past bij jouw situatie en kennisniveau.

- Wil je gewoon snel data (en misschien wat extra nachtrust)? Laat Thunderbit’s AI het werk doen.

Hoe dan ook, het web staat vol data die wacht om omgezet te worden in inzichten. Of je nu een Python-expert bent of een zakelijke gebruiker die liever geen code aanraakt, in 2025 is er altijd een geschikte tool. En mocht je ooit willen sparren over scraping, automatisering of de beste pizzatoppings voor CEO’s—je weet me te vinden.

Veel succes met scrapen!

Veelgestelde vragen

1. Wat zijn de populairste Python-bibliotheken voor webscraping?

Bekende Python-bibliotheken voor webscraping zijn onder andere Requests voor statische pagina’s, Selenium voor dynamische sites met JavaScript en Scrapy voor grootschalige crawls. De keuze hangt vaak af van de complexiteit van de data, de behoefte aan gelijktijdigheid en hoe dynamisch de content is.

2. Hoe ga ik om met websites die veel JavaScript gebruiken tijdens het scrapen?

Voor sites die zwaar leunen op JavaScript zijn Selenium en Playwright uitstekende opties. Hiermee kun je browseracties simuleren en dynamische content laden zoals een echte gebruiker. ZenRows is ook een optie, met een eenvoudige API die JavaScript aankan en anti-botmaatregelen omzeilt zonder extra instellingen.

3. Hoe helpt Thunderbit mijn bedrijf met webscraping?

Thunderbit is een no-code AI-webscraper waarmee zakelijke gebruikers webdata kunnen verzamelen zonder te programmeren. Of je nu concurrentieprijzen, leads of productdata nodig hebt, Thunderbit maakt scrapen eenvoudig met AI-automatisering, ondersteuning voor dynamische content, anti-bot functies en exportopties in slechts twee klikken.

Meer weten: