Toen ik voor het eerst begon met webscraping, dacht ik: “Hoe lastig kan het zijn? Gewoon wat HTML binnenhalen en klaar!” Inmiddels weet ik wel beter: webscraping is uitgegroeid tot een onmisbare skill voor iedereen die zich bezighoudt met sales, e-commerce of marktonderzoek. Het internet staat bomvol data—meer dan en het worden er elke dag meer—en bedrijven zijn continu op zoek naar waardevolle inzichten. Maar er is een uitdaging: het grootste deel van die data zit verstopt achter dynamische pagina’s, JavaScript en interactieve elementen waar simpele tools niet bij kunnen.

Daar komen Python webscraper-tools zoals Selenium om de hoek kijken. Met Selenium Python kun je een echte browser aansturen, waardoor je zelfs de meest dynamische websites kunt scrapen. Maar, zoals je in deze praktische beginnersgids zult merken, is het niet altijd zo simpel als het lijkt. We gaan samen een praktijkvoorbeeld doorlopen—productdata scrapen van —zodat je precies ziet hoe Selenium werkt. En omdat ik het graag makkelijk maak, laat ik je ook zien hoe nieuwe AI-tools zoals hetzelfde klusje in een fractie van de tijd klaren (en met veel minder code).

Waarom Webscraping Onmisbaar Is (en Waarom Dynamische Sites Zo’n Gedoe Zijn)

Webscraping is allang niet meer alleen voor nerds. Het is een must geworden voor sales-, marketing-, e-commerce- en operationele teams. Wil je concurrentieprijzen in de gaten houden? Leads verzamelen? Klantreviews analyseren? Webscraping is dé manier. Sterker nog, geeft aan dat prijsdata hun belangrijkste doel is, en 80–90% van alle online data is ongestructureerd—je kunt het dus niet zomaar kopiëren en in Excel plakken.

Maar hier zit het probleem: moderne websites zijn dynamisch. Ze laden content via JavaScript, verstoppen data achter knoppen of vereisen eindeloos scrollen. Simpele scrapers zoals requests of BeautifulSoup zien alleen de statische HTML—alsof je een krant leest die nooit wordt bijgewerkt. Staat de info die je zoekt pas na klikken, scrollen of inloggen op de pagina? Dan heb je een tool nodig die zich als een echte gebruiker gedraagt.

Wat is Selenium Python en Waarom Gebruik Je Het voor Webscraping?

Wat is Selenium Python nu eigenlijk? Kort gezegd: Selenium is een tool waarmee je browsers kunt automatiseren. Je schrijft Python-scripts die een echte browser besturen—knoppen aanklikken, formulieren invullen, pagina’s scrollen en natuurlijk data scrapen die pas na interactie zichtbaar wordt.

Hoe Selenium Python Verschilt van Simpele Scrapers

- Selenium Python: Stuurt een echte browser aan (zoals Chrome), voert JavaScript uit, werkt met dynamische elementen en wacht tot content geladen is—net als een mens.

- Requests/BeautifulSoup: Haalt alleen statische HTML op. Snel en lichtgewicht, maar kan geen JavaScript of interactieve content verwerken.

Zie Selenium als je digitale stagiair: hij kan alles wat jij in de browser doet, maar heeft duidelijke instructies (en wat geduld) nodig.

Wanneer Gebruik Je Selenium?

- Oneindig scrollende feeds (denk aan social media of productoverzichten)

- Interactieve filters of dropdowns (zoals schoenmaten kiezen op )

- Content achter logins of pop-ups

- Single Page Applications (zoals React, Vue, enz.)

Wil je alleen statische tekst van een simpele pagina halen? Dan is BeautifulSoup voldoende. Maar voor alles wat dynamisch is, is Selenium je beste maatje.

Je Selenium Python-omgeving Klaarzetten

Voordat we aan de slag gaan, moeten we de juiste tools installeren. Ik neem je stap voor stap mee—ervaring is niet nodig.

1. Python en Selenium Installeren

Zorg eerst dat je Python 3 op je computer hebt staan. Download het via de . Check je versie met:

1python --versionInstalleer daarna Selenium met pip:

1pip install seleniumZo heb je de nieuwste Selenium-versie voor Python binnen. Makkelijk toch?

2. ChromeDriver Downloaden en Instellen

Selenium heeft een “driver” nodig om je browser te besturen. Voor Chrome is dat .

- Check je Chrome-versie: Open Chrome, ga naar Menu → Help → Over Google Chrome.

- Download de juiste ChromeDriver: Kies de versie die bij jouw browser past.

- Pak het bestand uit en plaats de driver: Zet

chromedriver.exe(of het Mac/Linux-equivalent) in je systeem-PATH of in je projectmap.

Tip: Er zijn Python-pakketten zoals webdriver_manager die drivers automatisch downloaden, maar handmatig werkt prima als je net begint.

3. Je Installatie Testen

Laten we checken of alles werkt. Maak een Python-bestand aan, bijvoorbeeld test_selenium.py:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://www.example.com")

4print(driver.title)

5driver.quit()Voer het script uit. Je ziet Chrome openen, bezoeken, de titel printen en weer sluiten. Zie je de melding “Chrome wordt bestuurd door geautomatiseerde testsoftware”? Dan ben je klaar om te starten!

Je Eerste Selenium Python-script: Scrapen van

Tijd om Selenium in actie te zien. Onze opdracht: productnamen en prijzen scrapen van .

Stap 1: Browser Starten en Navigeren

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://www.allbirds.com/collections/mens")Stap 2: Wachten tot Dynamische Content is Geladen

Dynamische sites laden niet altijd direct. Gebruik Selenium’s wachtfuncties:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.CSS_SELECTOR, "div.product-card"))

5)(Check altijd even de juiste CSS-selectors via de inspectietool. In dit voorbeeld gaan we uit van div.product-card.)

Stap 3: Elementen Vinden en Data Uitlezen

1products = driver.find_elements(By.CSS_SELECTOR, "div.product-card")

2print(f"Found {len(products)} products")

3data = []

4for prod in products:

5 name = prod.find_element(By.CSS_SELECTOR, ".product-name").text

6 price = prod.find_element(By.CSS_SELECTOR, ".price").text

7 data.append((name, price))

8 print(name, "-", price)Je krijgt dan bijvoorbeeld:

1Found 24 products

2Wool Runner - $110

3Tree Dasher 2 - $135

4...Stap 4: Data Opslaan in een CSV-bestand

Sla de resultaten op in een CSV:

1import csv

2with open("allbirds_products.csv", "w", newline="") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Product Name", "Price"])

5 writer.writerows(data)En vergeet niet de browser te sluiten:

1driver.quit()Open je CSV-bestand en voilà—productnamen en prijzen, klaar voor analyse.

Veelvoorkomende Webscraping-uitdagingen met Selenium Python

In de praktijk gaat scrapen zelden vlekkeloos. Zo pak je de meest voorkomende problemen aan:

Wachten tot Elementen Geladen Zijn

Dynamische sites kunnen traag zijn. Gebruik expliciete waits:

1WebDriverWait(driver, 10).until(

2 EC.visibility_of_element_located((By.CSS_SELECTOR, ".product-card"))

3)Zo voorkom je dat je script te vroeg probeert data te pakken.

Omgaan met Paginering

Wil je meer dan alleen de eerste pagina? Loop door de pagina’s:

1while True:

2 try:

3 next_btn = driver.find_element(By.LINK_TEXT, "Next")

4 next_btn.click()

5 WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CSS_SELECTOR, ".product-card")))

6 except Exception:

7 break # Geen volgende pagina meerOf, bij oneindig scrollen:

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightPop-ups en Logins Afhandelen

Blokkeert een pop-up je script? Sluit hem:

1driver.find_element(By.CSS_SELECTOR, ".modal-close").click()Automatisch inloggen? Vul de velden in en klik op inloggen:

1driver.find_element(By.ID, "email").send_keys("user@example.com")

2driver.find_element(By.NAME, "login").click()Let op: CAPTCHAs en tweestapsverificatie zijn lastig te automatiseren.

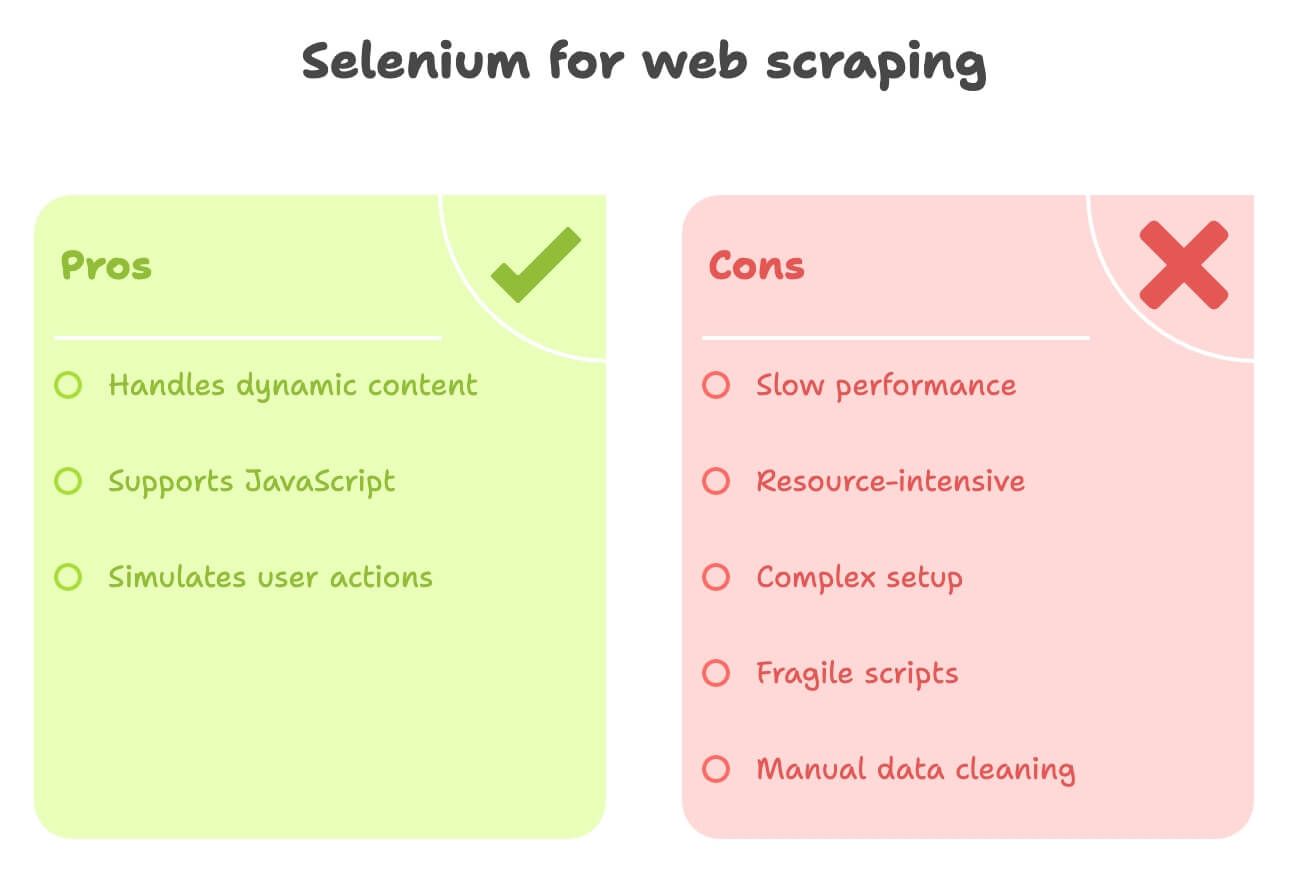

Nadelen van Selenium Python voor Webscraping

Eerlijk is eerlijk—Selenium is krachtig, maar niet altijd ideaal:

- Traag: Elke pagina laadt een volledige browser, inclusief afbeeldingen en scripts. Wil je 1.000 pagina’s scrapen? Neem je tijd.

- Vraagt veel van je computer: Gebruikt veel CPU en geheugen. Meerdere browsers tegelijk? Dan heb je een stevige laptop of pc nodig.

- Complexe installatie: ChromeDriver moet bij je browser passen, updates bijhouden, voor elke site aparte code schrijven—het onderhoud kan flink oplopen.

- Kwetsbaar: Als de website zijn indeling aanpast, kan je script zomaar stukgaan.

- Handmatige dataverwerking: Wil je beschrijvingen vertalen of sentiment analyseren? Dan heb je extra libraries of API’s nodig.

Voor niet-technische gebruikers, of wie snel gestructureerde data wil, voelt Selenium soms als een kanon op een mug.

Maak kennis met Thunderbit: Het AI-alternatief voor Selenium Python

Tijd om een tool te bespreken die het leven van zakelijke gebruikers een stuk makkelijker maakt: . Thunderbit is een AI-webscraper Chrome-extensie waarmee je data van elke website kunt halen—zonder code, zonder gedoe, gewoon met een paar klikken.

Waarom Thunderbit Anders Is

- AI-veldherkenning: Klik op “AI Suggest Fields” en Thunderbit’s AI bepaalt automatisch welke velden je moet scrapen—productnamen, prijzen, afbeeldingen, noem maar op.

- Subpagina’s Scrapen: Heb je details van productpagina’s nodig? Thunderbit klikt automatisch door en haalt extra info op.

- Data verrijken: Vertaal beschrijvingen, vat teksten samen of analyseer sentiment—direct tijdens het scrapen.

- Exporteren met één klik: Stuur je data direct naar Excel, Google Sheets, Notion of Airtable. Geen code, geen gedoe.

- No-code interface: Ontworpen voor niet-programmeurs. Als je een browser kunt gebruiken, kun je met Thunderbit aan de slag.

Misschien ben ik een beetje bevooroordeeld (ik heb meegewerkt aan Thunderbit!), maar ik geloof echt dat dit de snelste manier is voor zakelijke teams om gestructureerde webdata te verzamelen—vooral voor sales, e-commerce en onderzoek.

Thunderbit vs. Selenium Python: Een Vergelijking

Hier de verschillen op een rijtje:

| Criteria | Selenium Python | Thunderbit (AI, No-Code) |

|---|---|---|

| Installatietijd | Gemiddeld tot complex—Python, Selenium, ChromeDriver installeren, code schrijven | Supersnel—Chrome-extensie installeren, direct aan de slag |

| Vereiste kennis | Hoog—je moet kunnen programmeren en HTML begrijpen | Laag—wijzen en klikken, AI doet het zware werk |

| Dynamische content | Uitstekend—kan JS, klikken, scrollen aan | Uitstekend—werkt in de browser, ondersteunt AJAX, infinite scroll, subpagina’s |

| Snelheid | Traag—browser-overhead | Snel voor kleine/middelgrote taken—AI herkent velden direct, directe DOM-toegang |

| Schaalbaarheid | Moeilijk—veel resources nodig | Prima voor honderden/duizenden items; niet voor massale bulk-scraping |

| Dataverwerking | Handmatig—je moet zelf data opschonen, vertalen, sentiment bepalen | Geautomatiseerd—AI kan direct vertalen, samenvatten, categoriseren, verrijken |

| Exportmogelijkheden | Eigen code nodig voor CSV, Sheets, enz. | Eén klik export naar Excel, Google Sheets, Notion, Airtable |

| Onderhoud | Hoog—kwetsbaar bij sitewijzigingen | Laag—AI past zich aan veel layout-wijzigingen aan, weinig onderhoud nodig |

| Unieke features | Volledige browserautomatisering, maatwerk workflows | AI-inzichten, kant-en-klare templates, data verrijking, gratis extractors |

Voor de meeste zakelijke gebruikers is Thunderbit een verademing—geen gedoe meer met code of drivers.

Praktijkvoorbeeld: scrapen met Thunderbit

Zo werkt Thunderbit voor dezelfde opdracht:

- Installeer de

- Ga naar

- Klik op het Thunderbit-icoon en kies “AI Suggest Fields”

- Thunderbit’s AI herkent automatisch kolommen als “Productnaam”, “Prijs”, “Product URL”, enz.

- (Optioneel) Voeg een kolom toe voor “Beschrijving (Japans)” of “Sentiment”

- Thunderbit vertaalt of analyseert direct tijdens het scrapen.

- Klik op “Scrape”

- Thunderbit verzamelt alle productdata in een tabel.

- Exporteer met één klik naar Google Sheets, Notion of Excel

Geen code, geen wachten op browsers, geen gedoe met CSV’s. Gewoon direct bruikbare data.

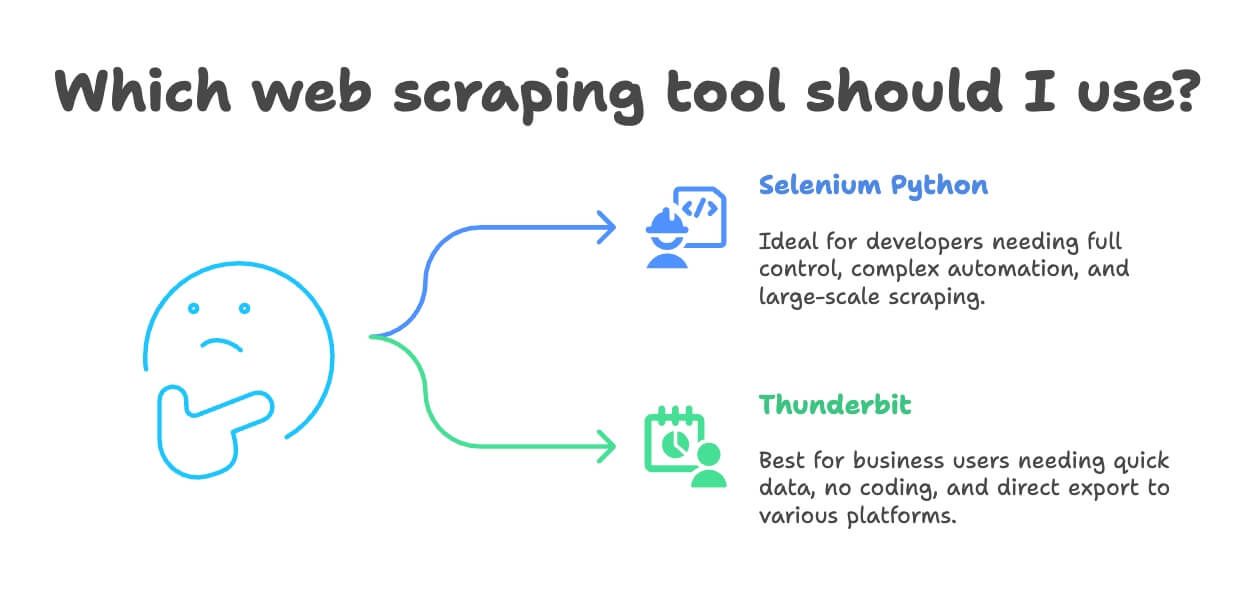

Wanneer Kies Je voor Selenium Python of Thunderbit bij Webscraping?

Welke tool past het beste bij jouw situatie? Mijn advies:

- Gebruik Selenium Python als:

- Je een ontwikkelaar bent of volledige controle wilt over browserautomatisering

- De scraping-taak heel specifiek of onderdeel van een groter softwareproject is

- Je complexe workflows moet automatiseren (logins, downloads, meerstapsformulieren)

- Je op grote schaal wilt scrapen (met de juiste infrastructuur)

- Gebruik Thunderbit als:

- Je een zakelijke gebruiker, analist of marketeer bent die snel data nodig heeft

- Je geen zin hebt in code of installatiegedoe

- Je tijdens het scrapen wilt vertalen, sentiment analyseren of data verrijken

- Je project klein tot middelgroot is (honderden tot enkele duizenden records)

- Je direct wilt exporteren naar Excel, Google Sheets, Notion of Airtable

Eerlijk: ik heb teams dagenlang Selenium-scripts zien bouwen voor taken die Thunderbit in 10 minuten oplost. Tenzij je echt maatwerk of enorme schaal nodig hebt, is Thunderbit meestal de snellere en gebruiksvriendelijkere keuze.

Bonus: Tips voor Verantwoord en Effectief Webscrapen

Voordat je losgaat met data verzamelen, een paar belangrijke tips:

- Respecteer robots.txt en de gebruiksvoorwaarden: Check altijd wat mag. Staat er “geen scraping”? Neem geen risico.

- Beperk je verzoeken: Overbelast servers niet—bouw pauzes in of gebruik ingebouwde limieten.

- Wissel user agents/IP’s indien nodig: Helpt tegen simpele blokkades, maar ga niet tegen het beleid van de site in.

- Vermijd het scrapen van persoonlijke of gevoelige data: Blijf bij openbare info en houd rekening met privacywetgeving zoals de AVG.

- Gebruik een API als die beschikbaar is: Dat is veiliger en stabieler.

- Scrape niet achter logins of betaalmuren zonder toestemming: Dat is juridisch en ethisch niet oké.

- Log je activiteiten en vang fouten netjes op: Word je geblokkeerd? Pas je aanpak aan.

Meer weten over de ethiek en legaliteit van webscraping? Lees .

Conclusie: Kies de Juiste Tool voor Jouw Webscraping

Webscraping is flink geëvolueerd—van handmatig knutselen tot slimme AI-tools zonder code. Zoals je hebt gezien, is Selenium Python een krachtige optie voor ontwikkelaars die complexe, dynamische sites willen aanpakken, maar het vraagt wel om technische kennis en onderhoud. Voor de meeste zakelijke gebruikers biedt Thunderbit een snellere en eenvoudigere route naar gestructureerde webdata—met vertaling, sentimentanalyse en export met één klik.

Mijn tip? Probeer beide methodes. Ben je developer, bouw dan eens een Selenium-script voor een site als en ervaar het zelf. Wil je snel resultaat (of gewoon geen gedoe)? Test dan uit. Er is een gratis versie, dus je kunt vandaag nog aan de slag op je favoriete site.

En onthoud: scrape verantwoord, gebruik je data slim en zorg dat je IP niet geblokkeerd wordt.

Meer leren? Check deze bronnen: