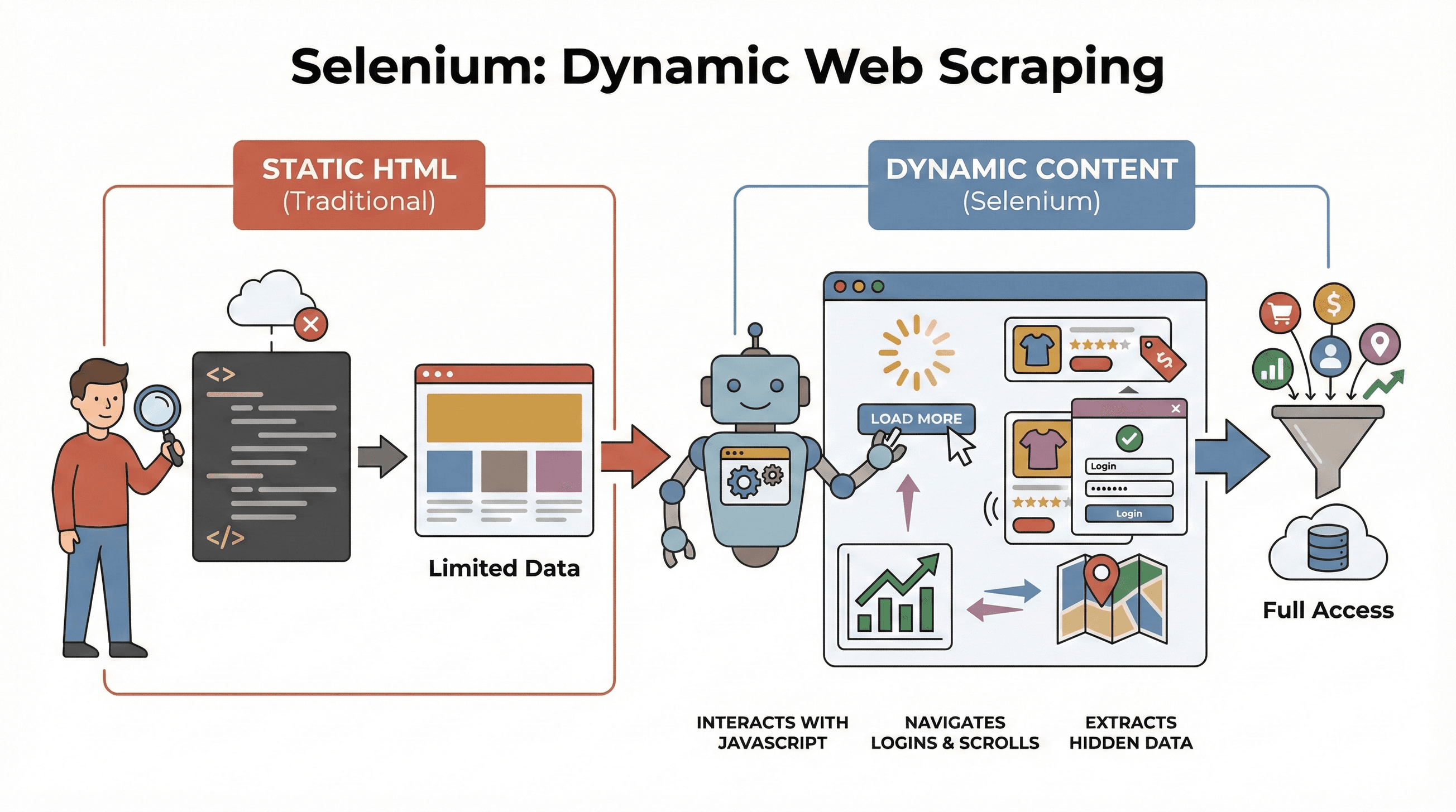

Het internet is tegenwoordig totaal anders dan vroeger. Vrijwel elke site draait op JavaScript en laat pas content zien als je ergens op klikt, scrolt of een pop-up wegdrukt. Je kent het wel: oneindig scrollen, dashboards die pas na een klik data tonen, of webshops waar prijzen pas na interactie verschijnen. Geloof het of niet, maar . Met ouderwetse scrapingtools die alleen statische HTML lezen, mis je dus een hoop waardevolle info. Heb je ooit geprobeerd prijzen van een moderne webshop te scrapen of huizenaanbod van een interactieve kaart te halen? Dan weet je hoe frustrerend het is als de data die je zoekt nergens in de broncode te vinden is.

Hier komt scrapen met Selenium om de hoek kijken. Als iemand die al jaren automatiseringstools bouwt (en meer dan genoeg sites heeft gescrapet), kan ik je vertellen: als je Selenium onder de knie hebt, heb je echt een streepje voor als je actuele, dynamische data wilt. In deze praktische selenium webscraping tutorial neem ik je stap voor stap mee—van installatie tot automatisering—en laat ik je zien hoe je Selenium slim combineert met voor gestructureerde, direct exporteerbare data. Of je nu business-analist, salesmedewerker of gewoon een nieuwsgierige Python-gebruiker bent, je loopt straks weg met concrete skills én een glimlach (want eerlijk is eerlijk: XPath-debuggen is soms een karaktertest).

Wat is Selenium en waarom gebruiken voor webscraping?

Laten we bij het begin beginnen. is een open-source framework waarmee je een echte browser—zoals Chrome of Firefox—met code kunt besturen. Zie het als een robot die websites opent, op knoppen klikt, formulieren invult, scrollt en zelfs JavaScript uitvoert, net als een echte gebruiker. Dat is belangrijk, want de meeste moderne sites laten hun data pas zien na interactie of dynamisch laden.

Laten we bij het begin beginnen. is een open-source framework waarmee je een echte browser—zoals Chrome of Firefox—met code kunt besturen. Zie het als een robot die websites opent, op knoppen klikt, formulieren invult, scrollt en zelfs JavaScript uitvoert, net als een echte gebruiker. Dat is belangrijk, want de meeste moderne sites laten hun data pas zien na interactie of dynamisch laden.

Waarom is dit belangrijk voor scraping? Tools als BeautifulSoup of Scrapy zijn top voor statische HTML, maar zien niks van wat na het laden door JavaScript verschijnt. Selenium kan daarentegen live met de pagina interacteren, waardoor het perfect is voor:

- Productlijsten die pas na ‘Meer laden’ verschijnen

- Prijzen of reviews die dynamisch worden bijgewerkt

- Navigeren door login-formulieren, pop-ups of eindeloos scrollen

- Data uit dashboards, kaarten of andere interactieve onderdelen halen

Kortom: Selenium is dé tool als je data wilt scrapen die pas zichtbaar wordt na het laden of na een gebruikersactie.

Belangrijke stappen voor python selenium website scrapen

Scrapen met Selenium bestaat uit drie hoofdfases:

| Stap | Wat doe je | Waarom is het belangrijk |

|---|---|---|

| 1. Omgeving instellen | Selenium, WebDriver en Python-libraries installeren | Je tools klaarzetten en installatieproblemen voorkomen |

| 2. Elementen vinden | De gewenste data lokaliseren via ID’s, klassen, XPath, etc. | Gericht de juiste info pakken, ook als die door JavaScript verborgen is |

| 3. Data extraheren & opslaan | Tekst, links of tabellen ophalen en bewaren als CSV/Excel | Ruwe webdata omzetten naar bruikbare informatie |

We gaan elke stap behandelen met praktische voorbeelden en code die je direct kunt gebruiken of aanpassen.

Stap 1: Je Python Selenium-omgeving opzetten

Eerst even de basis: je moet Selenium en een browserdriver (zoals ChromeDriver voor Chrome) installeren. Gelukkig is dat tegenwoordig zo geregeld.

Selenium installeren

Open je terminal en voer uit:

1pip install seleniumWebDriver downloaden

- Chrome: Download (let op: versie moet overeenkomen met je browser).

- Firefox: Download .

Tip: Vanaf Selenium 4.6+ kun je Selenium Manager gebruiken om drivers automatisch te downloaden, dus je hoeft vaak niet meer met PATH-variabelen te stoeien ().

Je eerste Selenium-script

Hier een snelle “hello world” met Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome() # Of webdriver.Firefox()

3driver.get("https://example.com")

4print(driver.title)

5driver.quit()Probleemoplossing:

- Krijg je een “driver not found”-melding? Check je PATH of gebruik Selenium Manager.

- Zorg dat je browser- en driverversies overeenkomen.

- Draai je op een server zonder GUI? Zie de tips voor headless mode hieronder.

Stap 2: Webelementen lokaliseren voor data-extractie

Nu het leuke deel: Selenium vertellen welke data je wilt hebben. Websites bestaan uit allerlei elementen—divs, spans, tabellen, enzovoort—en Selenium biedt verschillende manieren om ze te vinden.

Veelgebruikte locator-strategieën

By.ID: Vind een element met een unieke IDBy.CLASS_NAME: Vind elementen op basis van CSS-klasseBy.XPATH: Gebruik XPath-expressies (zeer flexibel, soms kwetsbaar)By.CSS_SELECTOR: Gebruik CSS-selectors (handig voor complexe queries)

Zo gebruik je ze:

1from selenium.webdriver.common.by import By

2# Vind op ID

3prijs = driver.find_element(By.ID, "price").text

4# Vind op XPath

5titel = driver.find_element(By.XPATH, "//h1").text

6# Vind alle productafbeeldingen via CSS-selector

7images = driver.find_elements(By.CSS_SELECTOR, ".product img")

8for img in images:

9 print(img.get_attribute("src"))Tip: Gebruik altijd de eenvoudigste en meest stabiele locator (ID > class > CSS > XPath). En als je een pagina scrapt die data vertraagd laadt, gebruik dan expliciete waits:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3wait = WebDriverWait(driver, 10)

4prijs_elem = wait.until(EC.presence_of_element_located((By.CSS_SELECTOR, ".price")))Zo voorkom je dat je script crasht als de data even op zich laat wachten.

Stap 3: Data extraheren en opslaan

Heb je de juiste elementen gevonden? Dan kun je de data ophalen en opslaan waar je wilt.

Tekst, links en tabellen extraheren

Stel, je wilt een tabel met producten scrapen:

1data = []

2rows = driver.find_elements(By.XPATH, "//table/tbody/tr")

3for row in rows:

4 cells = row.find_elements(By.TAG_NAME, "td")

5 data.append([cell.text for cell in cells])Opslaan als CSV met Pandas

1import pandas as pd

2df = pd.DataFrame(data, columns=["Naam", "Prijs", "Voorraad"])

3df.to_csv("producten.csv", index=False)Je kunt ook naar Excel opslaan (df.to_excel("producten.xlsx")) of zelfs naar Google Sheets pushen via hun API.

Volledig voorbeeld: Producttitels en prijzen scrapen

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3import pandas as pd

4driver = webdriver.Chrome()

5driver.get("https://example.com/products")

6data = []

7products = driver.find_elements(By.CLASS_NAME, "product-card")

8for p in products:

9 title = p.find_element(By.CLASS_NAME, "title").text

10 price = p.find_element(By.CLASS_NAME, "price").text

11 data.append([title, price])

12driver.quit()

13df = pd.DataFrame(data, columns=["Titel", "Prijs"])

14df.to_csv("producten.csv", index=False)Selenium vs. BeautifulSoup en Scrapy: Wat maakt Selenium uniek?

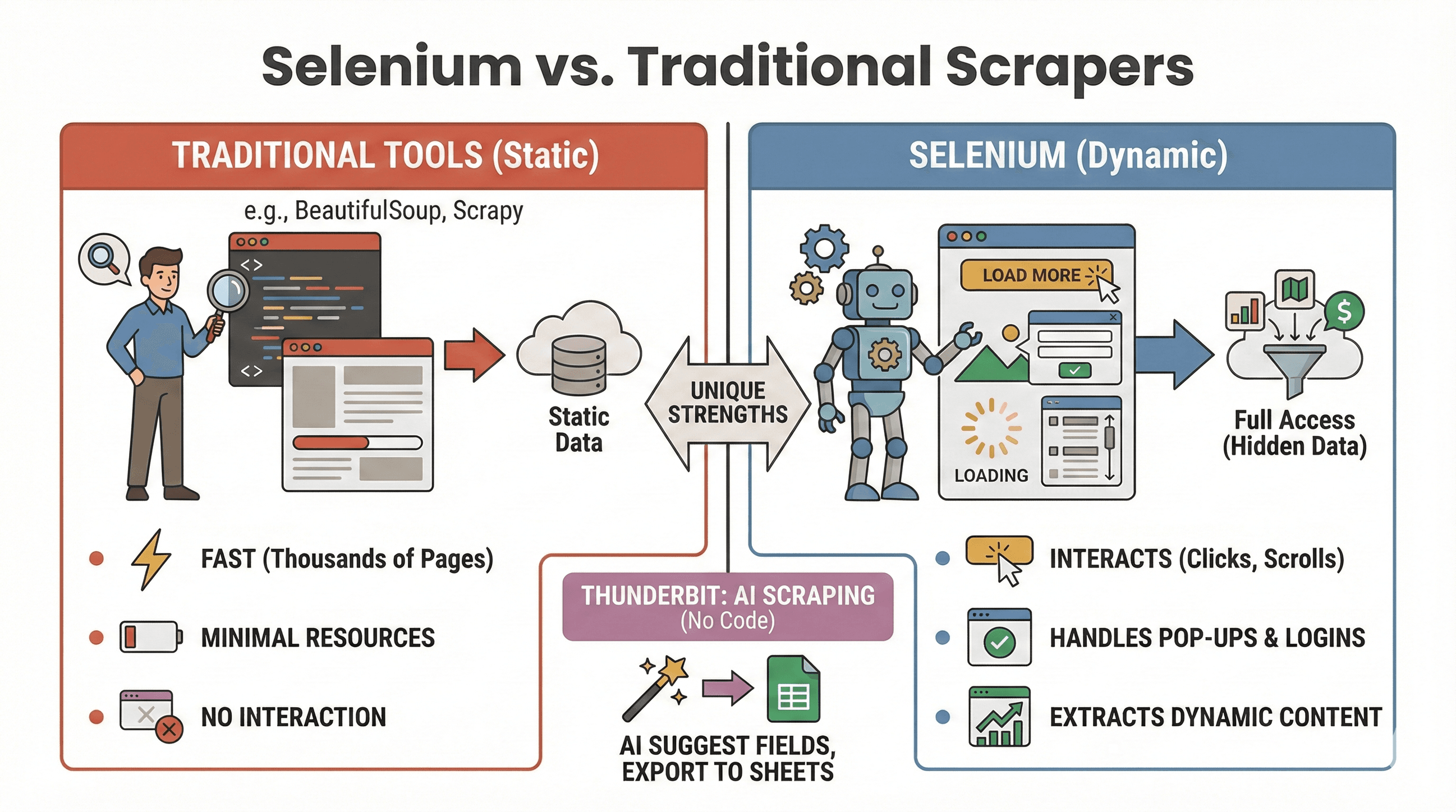

Wanneer kies je voor Selenium, en wanneer zijn BeautifulSoup of Scrapy beter? Hier een kort overzicht:

Wanneer kies je voor Selenium, en wanneer zijn BeautifulSoup of Scrapy beter? Hier een kort overzicht:

| Tool | Beste voor | Kan JavaScript aan? | Snelheid & resources |

|---|---|---|---|

| Selenium | Dynamische/interactieve sites | Ja | Langzamer, meer geheugen |

| BeautifulSoup | Simpele statische HTML-scraping | Nee | Zeer snel, lichtgewicht |

| Scrapy | Grote hoeveelheden statische sites | Beperkt* | Supersnel, async, weinig RAM |

| Thunderbit | No-code, zakelijke scraping | Ja (AI) | Snel voor kleine/middelgrote jobs |

*Scrapy kan met plugins wat dynamische content aan, maar dat is niet zijn kracht ().

Wanneer Selenium gebruiken:

- Data verschijnt pas na klikken, scrollen of inloggen

- Je moet omgaan met pop-ups, infinite scroll of dynamische dashboards

- Statische scrapers zijn niet voldoende

Wanneer BeautifulSoup/Scrapy gebruiken:

- Data staat direct in de HTML

- Je wilt duizenden pagina’s snel scrapen

- Je wilt minimale resourcebelasting

Wil je helemaal niet coderen? Met kun je dynamische sites scrapen met AI—klik op “AI Suggest Fields” en exporteer direct naar Sheets, Notion of Airtable. (Meer daarover verderop.)

Webscraping automatiseren met Selenium en Python

Laten we eerlijk zijn: niemand heeft zin om ’s nachts scripts handmatig te draaien. Gelukkig kun je Selenium-taken automatiseren met Python’s scheduling libraries of de scheduler van je besturingssysteem (zoals cron op Linux/Mac of Taakplanner op Windows).

Met de schedule-library

1import schedule

2import time

3def job():

4 # Je scraping-code hier

5 print("Scrapen...")

6schedule.every().day.at("09:00").do(job)

7while True:

8 schedule.run_pending()

9 time.sleep(1)Of met Cron (Linux/Mac)

Voeg dit toe aan je crontab om elk uur te draaien:

10 * * * * python /pad/naar/jouw_script.pyAutomatiseringstips:

- Draai Selenium in headless mode (zie hieronder) om pop-ups te vermijden.

- Log fouten en stuur jezelf meldingen als er iets misgaat.

- Sluit altijd de browser af met

driver.quit()om resources vrij te geven.

Efficiënter scrapen: tips voor snellere en stabielere Selenium-scripts

Selenium is krachtig, maar kan traag en zwaar zijn als je niet oplet. Zo maak je je scripts sneller en betrouwbaarder:

1. Gebruik headless mode

Je hoeft niet te zien hoe Chrome honderd keer opent en sluit. Headless mode draait de browser op de achtergrond:

1from selenium.webdriver.chrome.options import Options

2opts = Options()

3opts.headless = True

4driver = webdriver.Chrome(options=opts)2. Blokkeer afbeeldingen en onnodige content

Waarom afbeeldingen laden als je alleen tekst nodig hebt? Blokkeer ze voor snellere laadtijden:

1prefs = {"profile.managed_default_content_settings.images": 2}

2opts.add_experimental_option("prefs", prefs)3. Gebruik efficiënte locators

- Geef de voorkeur aan ID’s of simpele CSS-selectors boven complexe XPaths.

- Vermijd

time.sleep()—gebruik expliciete waits (WebDriverWait).

4. Varieer wachttijden

Voeg willekeurige pauzes toe om menselijk gedrag na te bootsen en blokkades te voorkomen:

1import random, time

2time.sleep(random.uniform(1, 3))5. Wissel user agents en IP’s (indien nodig)

Scrape je veel? Wissel dan je user agent en overweeg proxies om blokkades te vermijden.

6. Beheer sessies en fouten

- Gebruik try/except om ontbrekende elementen netjes af te handelen.

- Log fouten en maak screenshots voor debugging.

Meer optimalisatietips? Bekijk .

Geavanceerd: Selenium combineren met Thunderbit voor gestructureerde data-export

Hier wordt het pas echt interessant—vooral als je tijd wilt besparen op data opschonen en exporteren.

Nadat je ruwe data met Selenium hebt gescrapet, kun je inzetten om:

- Velden automatisch herkennen: Thunderbit’s AI leest je gescrapete pagina’s of CSV’s en stelt kolomnamen voor (“AI Suggest Fields”).

- Subpagina’s scrapen: Heb je een lijst met URL’s (zoals productpagina’s)? Thunderbit bezoekt ze en verrijkt je tabel met extra details—zonder extra code.

- Data verrijken: Vertalen, categoriseren of analyseren in één klik.

- Overal exporteren: Direct exporteren naar Google Sheets, Airtable, Notion, CSV of Excel.

Voorbeeld workflow:

- Gebruik Selenium om een lijst met product-URL’s en titels te scrapen.

- Exporteer de data naar CSV.

- Open Thunderbit, importeer je CSV en laat de AI velden voorstellen.

- Gebruik Thunderbit’s subpagina-scraping om meer details (zoals afbeeldingen of specificaties) per product op te halen.

- Exporteer je gestructureerde dataset naar Sheets of Notion.

Deze combinatie bespaart uren handmatig opschonen en laat je focussen op analyse, niet op data-worstelen. Meer weten? Bekijk .

Best practices en probleemoplossing voor Selenium webscraping

Webscraping is soms net vissen: de ene keer haal je een mooie vangst binnen, de andere keer zit je vast in het wier. Zo houd je je scripts betrouwbaar—en netjes:

Best practices

- Respecteer robots.txt en sitevoorwaarden: Check altijd of scrapen is toegestaan.

- Doseer je verzoeken: Overbelast servers niet—voeg pauzes toe en let op HTTP 429-fouten.

- Gebruik API’s als ze er zijn: Is de data publiek via een API? Gebruik die—dat is veiliger en stabieler.

- Scrape alleen openbare data: Vermijd persoonlijke of gevoelige info en let op privacywetgeving.

- Omgaan met pop-ups en CAPTCHAs: Gebruik Selenium om pop-ups te sluiten, maar wees voorzichtig met CAPTCHAs—die zijn lastig te automatiseren.

- Varieer user agents en wachttijden: Helpt om detectie en blokkades te voorkomen.

Veelvoorkomende fouten en oplossingen

| Fout | Betekenis | Oplossing |

|---|---|---|

NoSuchElementException | Element niet gevonden | Controleer je locator; gebruik waits |

| Timeout errors | Pagina of element duurt te lang | Verhoog wachttijd; check je netwerk |

| Driver/browser mismatch | Selenium kan browser niet starten | Update je driver en browser |

| Session crashes | Browser sloot onverwacht | Gebruik headless mode; beheer resources |

Meer tips? Zie .

Conclusie & belangrijkste inzichten

Dynamisch webscrapen is allang niet meer alleen voor hardcore developers. Met python selenium website scrapen kun je elke browser automatiseren, zelfs de lastigste JavaScript-sites aanpakken en precies de data verzamelen die je nodig hebt—voor sales, onderzoek of gewoon uit nieuwsgierigheid. Onthoud:

- Selenium is dé keuze voor dynamische, interactieve sites.

- De drie kernstappen: installatie, lokaliseren, extraheren & opslaan.

- Automatiseer je scripts voor regelmatige data-updates.

- Optimaliseer voor snelheid en stabiliteit met headless mode, slimme waits en efficiënte locators.

- Combineer Selenium met Thunderbit voor moeiteloze datastructurering en export—ideaal als je geen zin hebt in spreadsheet-gedoe.

Zelf aan de slag? Gebruik de codevoorbeelden hierboven, en als je klaar bent voor de volgende stap, probeer voor directe, AI-gedreven data-opruiming en export. Meer weten? Check de voor diepgaande tutorials en het laatste nieuws over webautomatisering.

Veel succes met scrapen—en moge je selectors altijd de juiste data vinden.

Veelgestelde vragen

1. Waarom Selenium gebruiken voor webscraping in plaats van BeautifulSoup of Scrapy?

Selenium is ideaal voor dynamische websites waar content pas na gebruikersacties of JavaScript zichtbaar wordt. BeautifulSoup en Scrapy zijn sneller voor statische HTML, maar kunnen niet omgaan met dynamische elementen of interacties zoals klikken en scrollen.

2. Hoe maak ik mijn Selenium-scraper sneller?

Gebruik headless mode, blokkeer afbeeldingen en onnodige resources, kies efficiënte locators en voeg willekeurige pauzes toe om menselijk gedrag na te bootsen. Zie voor meer tips.

3. Kan ik Selenium-scraping automatisch laten draaien?

Zeker! Gebruik Python’s schedule-library of de scheduler van je besturingssysteem (cron of Taakplanner) om scripts op vaste tijden te laten lopen. Zo blijft je data altijd actueel.

4. Wat is de beste manier om gescrapete data met Selenium te exporteren?

Gebruik Pandas om data op te slaan als CSV of Excel. Voor geavanceerdere exports (Google Sheets, Notion, Airtable) kun je je data importeren in en de one-click exportfuncties gebruiken.

5. Hoe ga ik om met pop-ups en CAPTCHAs in Selenium?

Pop-ups kun je sluiten door het sluitknopje te lokaliseren en aan te klikken. CAPTCHAs zijn veel lastiger—overweeg een handmatige oplossing of een captcha-service, en respecteer altijd de gebruiksvoorwaarden van de site.

Meer scraping-tutorials, AI-automatiseringstips of het laatste nieuws over zakelijke datatools? Abonneer je op de of check ons voor praktische demo’s.

Meer weten