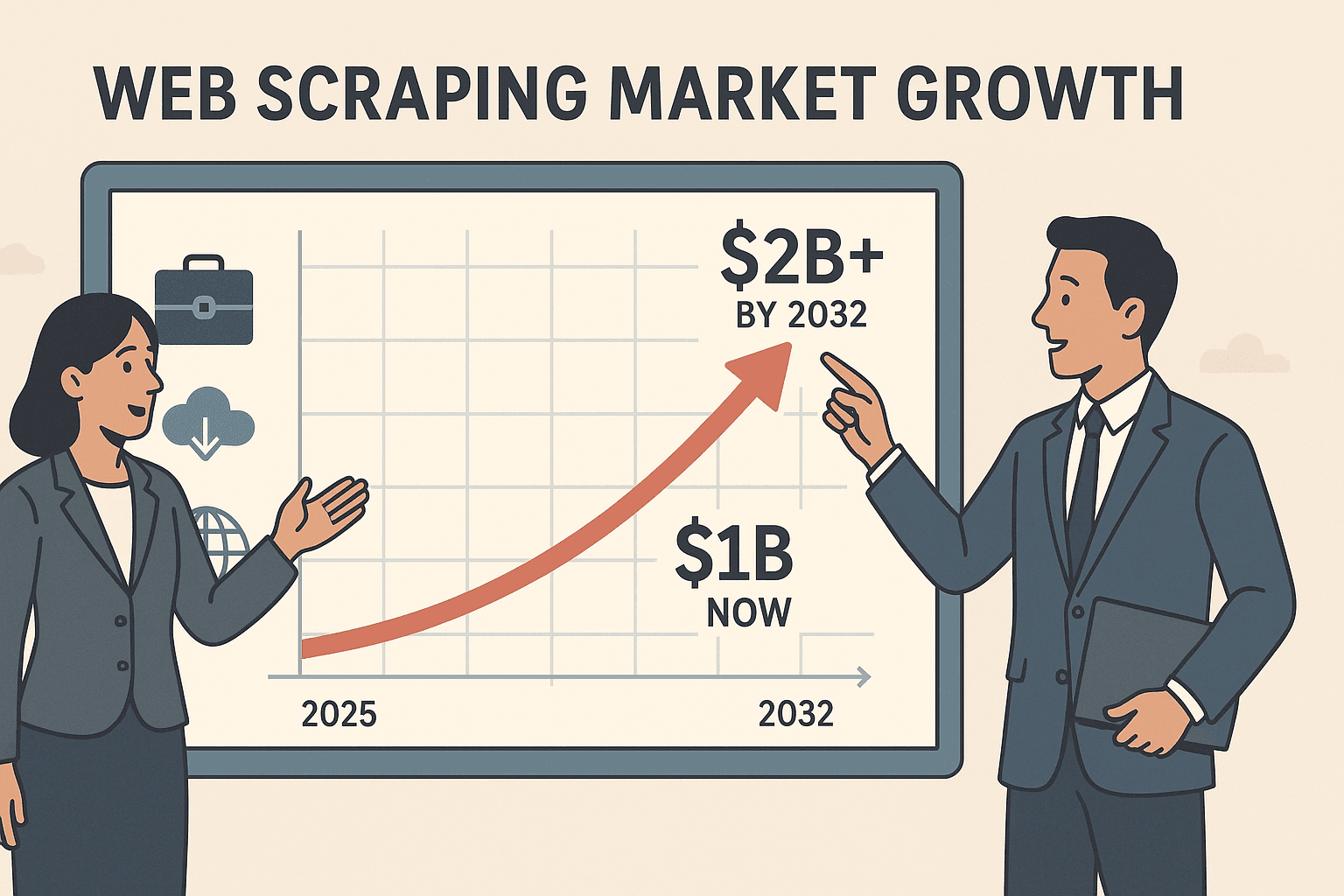

Laten we eerlijk zijn: als je in 2025 nog steeds met de hand data van websites aan het kopiëren en plakken bent, is dat net zoiets als een marathon lopen op slippers. De markt voor webscraping-software is inmiddels meer dan waard en zal tegen 2032 meer dan verdubbelen. Meer dan de helft van de Amerikaanse bedrijven verzamelt al externe webdata—om concurrenten te volgen, prijzen te monitoren en leads te genereren—want wie de meest actuele data heeft, loopt voorop.

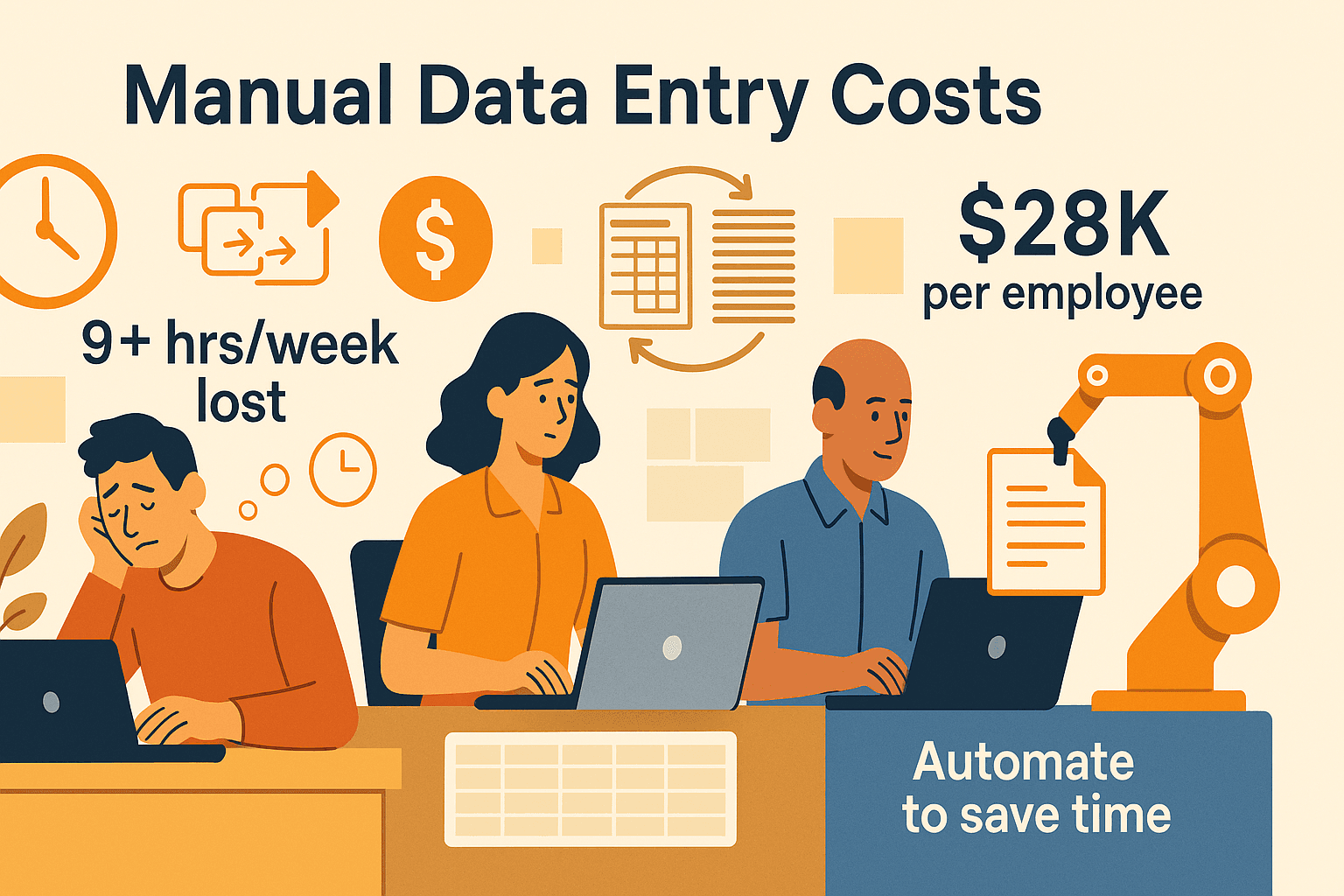

Maar hier wringt het: de meeste mensen op kantoor zijn geen programmeurs. Ik zie sales-, marketing- en operationele teams wekelijks meer dan 9 uur kwijt zijn aan saaie, herhalende data-invoer, wat bedrijven kost. En bijna 60% van de werknemers zegt dat dit soort taken tot burn-out leidt. Het goede nieuws? Websitegegevens scrapen is nu voor iedereen haalbaar—zelfs als je nog nooit hebt gecodeerd. We leggen uit hoe je dat aanpakt, welke tools je nodig hebt, en hoe je in een paar klikken van “ik heb deze data nodig” naar “hier is mijn spreadsheet” gaat.

Wat is Websitegegevens Scrapen?

Heel simpel: websitegegevens scrapen betekent dat je software gebruikt om automatisch info van webpagina’s te halen en die netjes te ordenen—denk aan tabellen, spreadsheets of databases. Zie het als een digitale assistent die honderden pagina’s afstruint, precies de info pakt die jij zoekt (zoals namen, prijzen, e-mails) en alles direct in Excel zet terwijl jij een bakje koffie haalt.

Handmatig data verzamelen—kopiëren en plakken van websites—werkt alleen als je een paar regels nodig hebt. Maar als je info van tientallen of duizenden pagina’s wilt halen, krijg je gegarandeerd zere polsen en veel fouten. Geautomatiseerde webscrapers nemen dit werk uit handen, halen precies de juiste velden op, en doen dit op grote schaal en met veel minder fouten ().

De basisstappen van webscraping:

- Bepaal welke data je wilt (bijvoorbeeld productprijzen, contactgegevens, reviews).

- Haal de data op met een tool of script.

- Exporteer de resultaten naar een formaat dat je kunt analyseren (CSV, Excel, Google Sheets, enz.).

Moderne webscrapers kunnen zelfs door meerdere pagina’s bladeren, op “volgende” klikken en subpagina’s bezoeken—zodat je álle data krijgt, niet alleen wat je op het scherm ziet.

Waarom Websitegegevens Scrapen Belangrijk is voor Zakelijke Teams

Waarom is deze skill onmisbaar voor sales-, marketing- en operationele teams?

- Leadgeneratie: Maak gerichte prospectlijsten door bedrijvengidsen, LinkedIn of deelnemerslijsten van events te scrapen. Geen verouderde lijsten meer kopen of urenlang Googelen.

- Prijsmonitoring: Houd concurrentieprijzen en voorraadniveaus bij op verschillende platforms. Retailers zoals John Lewis zagen hun omzet met stijgen dankzij gescrapete prijsdata.

- Marktonderzoek: Verzamel reviews, beoordelingen en social media-mentions om trends en klantgevoel realtime te spotten.

- Operationele efficiëntie: Houd productcatalogi, leveranciersinformatie of woningaanbod automatisch up-to-date.

Hier een overzicht van de voordelen:

| Belangrijkste voordeel | Wat betekent het? | Resultaat in de praktijk |

|---|---|---|

| Tijdbesparing | Automatiseer uren handmatig werk | +9 uur/week per medewerker (PRNewswire) |

| Nauwkeurigheid | Minder fouten, consistente data | Tot 99,5% accuraat (Scrapingdog) |

| Concurrentievoordeel | Sneller en actueler inzicht dan je concurrenten | Dynamische prijzen, betere targeting |

| Workflow-automatisering | Data wordt automatisch bijgewerkt | Dagelijkse/wekelijkse rapportages |

Niet gek dus dat die externe data gebruiken betere beslissingen nemen, en meer dan de helft omzetgroei ziet.

Stapsgewijs: Websitegegevens Scrapen Zonder te Coderen

Veel mensen vragen: “Hoe begin ik met scrapen als ik niet technisch ben?” Hier een simpel stappenplan:

1. Bepaal je Doel en Gegevensvelden

Wat wil je precies? Bijvoorbeeld een lijst van alle restaurants in je stad van Yelp, inclusief naam, adres en telefoonnummer? Of concurrentieprijzen van Amazon? Schrijf de velden op die je nodig hebt.

2. Kies de Juiste Tool

Geen programmeur? Sla Python-scripts over. Kies voor no-code tools zoals , een AI-gestuurde Chrome-extensie, of visuele scrapers zoals Octoparse of ParseHub.

3. Installeer je Tool

Installeer de gekozen tool (voor Thunderbit download je de ). Maak een account aan, log in en je kunt aan de slag.

4. Selecteer de Data op de Website

Ga naar de gewenste pagina. Met Thunderbit klik je op “AI Suggest Fields”—de AI scant de pagina en stelt de beste kolommen voor (zoals Naam, Prijs, E-mail).

5. Test je Scrape

Begin klein. Scrape één pagina of een paar items om te checken of de data klopt. Pas kolommen of prompts aan waar nodig.

6. Scrape de Volledige Dataset

Tevreden? Start dan de volledige scrape. Voor grote klussen kun je cloudmodus gebruiken (daarover straks meer). De tool regelt paginering en subpagina’s als dat nodig is.

7. Exporteer en Gebruik je Data

Exporteer naar Excel, Google Sheets, Airtable of Notion. Controleer een paar rijen om te zien of alles klopt.

Tip: Voorkom veelgemaakte fouten zoals vergeten paginering, te veel data tegelijk scrapen of het negeren van de gebruiksvoorwaarden van een site. Begin gericht, verbeter stapsgewijs, en je wordt snel een scraping-expert.

De Juiste Tool Kiezen: Thunderbit vs. Traditionele Scraping-oplossingen

Een vergelijking van de opties:

| Oplossing | Gebruiksgemak | Installatietijd | Onderhoud | Schaalbaarheid | Kosten | Ideaal voor |

|---|---|---|---|---|---|---|

| Thunderbit (AI No-Code) | Zeer hoog | Minuten | Laag | Hoog (cloud) | Gratis, $15+/maand | Sales, operations, niet-coders |

| Traditionele extensies | Gemiddeld | 30+ min | Gemiddeld | Beperkt | Gratis/laag | Simpele, geduldige gebruikers |

| Eigen code (Python) | Laag | Uren+ | Hoog | Zeer hoog | Ontwikkeltijd | Developers, datateams |

| Uitbesteding | Hoog | Dagen | Laag | Hoog | $$$ | Grote, eenmalige projecten |

Thunderbit springt eruit voor niet-technische gebruikers: geen code, AI-veldherkenning en een workflow die net zo makkelijk is als eten bestellen. Traditionele tools vragen meer handwerk, en eigen code is vooral voor engineers.

Thunderbit in de Praktijk: Websitegegevens Scrapen in Enkele Klika

Zo gebruik je bijvoorbeeld om een makelaarsgids te scrapen:

- Installeer de Chrome-extensie en log in.

- Navigeer naar de gewenste website (bijvoorbeeld een makelaarsgids).

- Klik op het Thunderbit-icoon om de zijbalk te openen.

- Klik op “AI Suggest Fields.” Thunderbit’s AI scant de pagina en stelt kolommen voor zoals Naam, Kantoor, Telefoon, E-mail.

- Controleer en pas velden aan—hernoem kolommen of voeg een eigen prompt toe als je data wilt categoriseren of formatteren.

- Klik op “Scrape.” Thunderbit haalt de data op in een tabel, inclusief paginering en zelfs oneindig scrollen.

- Exporteer naar Excel, Google Sheets of Notion—zonder extra kosten of verborgen toeslagen.

Als de naam van elke makelaar linkt naar een profielpagina, gebruik dan Subpagina-scraping: Thunderbit bezoekt elk profiel, haalt extra info op (zoals adres of jaren ervaring) en voegt dit toe aan je tabel. Geen losse tabbladen meer openen.

Browser Scraping vs. Cloud Scraping: Welke Modus Past bij Jou?

Thunderbit biedt twee modi:

- Browser Scraping: Draait in je eigen Chrome-browser. Ideaal voor data achter een login of gepersonaliseerde pagina’s (zoals je LinkedIn-account of interne dashboards). Het gebruikt jouw sessie en cookies, dus als jij het ziet, kan Thunderbit het scrapen.

- Cloud Scraping: Draait op de servers van Thunderbit. Supersnel voor openbare data—scrapet tot 50 pagina’s tegelijk, belast je computer niet en blijft doorgaan, zelfs als je je laptop dichtklapt. Perfect voor grote klussen zoals het scrapen van alle producten van een webshop.

Wanneer welke modus?

- Browsermodus: Sites waarvoor je moet inloggen, gepersonaliseerde feeds, kleine klussen.

- Cloudmodus: Grote hoeveelheden openbare data, geplande scrapes, of als je het proces wilt automatiseren.

Thunderbit regelt paginering en subpagina’s in beide modi, zodat je altijd complete datasets krijgt.

Dubbelklik-Efficiëntie: AI voor Slimmere Velden en Dataformaten

Een van mijn favoriete Thunderbit-functies is “AI Improve Fields.” Waarom is dit zo handig?

- Automatische opmaak: Standaardiseer telefoonnummers, prijzen of datums tijdens het scrapen—geen rommelige spreadsheets meer.

- Categorisatie: Voeg een kolom “Categorie” toe en laat de AI elke rij labelen (bijvoorbeeld Elektronica, Kleding, Meubels) op basis van de omschrijving.

- Vertaling: Scrape sites in andere talen en laat Thunderbit de velden direct vertalen naar het Nederlands (of 34+ andere talen).

- Eigen prompts: Wil je sentiment uit reviews halen of bedrijven op grootte taggen? Voeg gewoon een AI-prompt toe aan het veld.

Zo krijg je direct analyseklare data uit de tool, zonder uren handmatig schoonmaken.

Automatiseer je Workflow: Websitegegevens Scrapen op Afspraak

Waarom zou je het bij eenmalig scrapen laten? Met de Schedule-functie van Thunderbit kun je terugkerende scrapes instellen—dagelijks, wekelijks of wanneer je maar wilt.

- Beschrijf het schema in gewone taal (“elke maandag om 9 uur”).

- Kies je project en exportbestemming (Excel, Google Sheets, Airtable, Notion).

- Thunderbit voert de scrape automatisch uit en werkt je data bij—zonder handmatig werk.

Toepassingen:

- Sales: Dagelijkse updates van leadlijsten.

- E-commerce: Automatische prijsmonitoring.

- Operations: Voorraad- of stockalerts.

- Marktonderzoek: Nieuws- of reviewverzameling.

Met geplande scrapes blijft je data altijd actueel en heeft je team altijd de nieuwste informatie bij de hand.

Vergelijking van Populaire Website Scraping Tools: Snel Overzicht

Hier een vergelijking van de meest gebruikte opties:

| Tooltype | Gebruiksgemak | Installatietijd | Schaalbaarheid | Onderhoud | Kosten | Ideaal voor |

|---|---|---|---|---|---|---|

| Thunderbit (AI No-Code) | ⭐⭐⭐⭐⭐ | Minuten | Hoog | Laag | Gratis/$15+/maand | Sales, operations, niet-coders |

| Traditionele extensies | ⭐⭐⭐ | 30+ min | Gemiddeld | Gemiddeld | Gratis/laag | Simpele, geduldige gebruikers |

| Eigen code (Python) | ⭐ | Uren+ | Zeer hoog | Hoog | Ontwikkeltijd | Developers, datateams |

| Uitbesteding | ⭐⭐⭐⭐ | Dagen | Hoog | Laag | $$$ | Grote, eenmalige projecten |

Voor de meeste zakelijke gebruikers is Thunderbit de duidelijke winnaar qua snelheid, gebruiksgemak en prijs.

Samenvatting: Zo Scrape je Websitegegevens Efficiënt

- Webscraping is nu voor iedereen toegankelijk. Geen code nodig—kies de juiste tool en volg een paar simpele stappen.

- Bepaal vooraf je doelen en velden. Weet welke data je nodig hebt en waar je die vindt.

- Gebruik AI-tools zoals Thunderbit voor het snelste en makkelijkste resultaat—vooral als je niet technisch bent.

- Automatiseer repeterende taken met planning zodat je data zichzelf bijwerkt.

- Verfijn en formatteer je data direct tijdens het scrapen met AI-prompts—zo heb je direct analyseklare resultaten.

Zelf proberen? en start gratis je eerste scrape. Of check de voor meer tips en praktijkvoorbeelden.

Veelgestelde Vragen

1. Is webscraping legaal en veilig voor zakelijk gebruik?

Ja, zolang je alleen openbare data scrapt en de gebruiksvoorwaarden van websites respecteert. Vermijd het scrapen van persoonlijke of gevoelige informatie zonder toestemming en check altijd het beleid van de site.

2. Welke data kan ik met Thunderbit scrapen?

Je kunt tekst, getallen, datums, URL’s, e-mails, telefoonnummers, afbeeldingen en meer ophalen. Thunderbit’s AI kan velden zelfs categoriseren, labelen en vertalen tijdens het scrapen.

3. Kan ik data scrapen van sites waarvoor je moet inloggen?

Zeker—gebruik Thunderbit’s Browsermodus om data te scrapen van elke pagina die je in je browser kunt openen, ook achter een login.

4. Hoe gaat Thunderbit om met websites met veel pagina’s of subpagina’s?

Thunderbit ondersteunt automatische paginering en subpagina-scraping. Het volgt “volgende”-knoppen en bezoekt gelinkte detailpagina’s, en voegt alle data samen in één tabel.

5. Kan ik scrapes automatisch laten uitvoeren?

Ja! Met de Schedule-functie van Thunderbit kun je terugkerende scrapes instellen (dagelijks, wekelijks, enz.) en de resultaten direct exporteren naar Excel, Google Sheets, Airtable of Notion.

Websitegegevens scrapen hoeft geen hoofdpijn te zijn. Met de juiste tools en een duidelijk plan maak je van het web je eigen database—zonder code, zonder stress, alleen resultaat. Succes met scrapen!