Heb je ooit op een website gezeten en gedacht: “Kon ik deze waardevolle data maar direct in een spreadsheet krijgen, zonder urenlang te knippen en plakken?” Je bent zeker niet de enige. In 2025 is data scrapen niet meer alleen voor techneuten; het is een must-have skill voor bedrijven. Of je nu leads zoekt voor sales, prijzen van concurrenten wilt volgen als e-commerce manager, of gewoon snel webdata wilt binnenhalen: iedereen wil webdata, en liefst zo snel mogelijk. Het mooie is: met Python kun je webdata niet alleen makkelijk scrapen, het is ook verrassend toegankelijk—zelfs als je laatste programmeerervaring het aanpassen van je Hyves-profiel was.

In deze gids neem ik je stap voor stap mee in het scrapen van data van websites met Python. We beginnen bij de basis, laten zien hoe je zowel statische als dynamische sites aanpakt, en hoe je je workflow versnelt door Python te combineren met , onze AI-webscraper. Of je nu helemaal nieuw bent of je skills wilt uitbreiden, je vindt hier praktische tips, echte codevoorbeelden en lessen uit mijn jarenlange ervaring met SaaS en automatisering.

Wat is Webscraping en Waarom Python?

Laten we bij het begin beginnen. Webscraping is het automatisch verzamelen van informatie van websites. Zie het als je computer leren om een webpagina te ‘lezen’ en precies die gegevens te pakken die jij nodig hebt—zoals productprijzen, nieuwsberichten of contactgegevens—zodat je dit niet handmatig hoeft te doen (). Bedrijven gebruiken webscraping voor van alles: van realtime concurrentieanalyse tot marktonderzoek, leadgeneratie en zelfs het trainen van AI-modellen ().

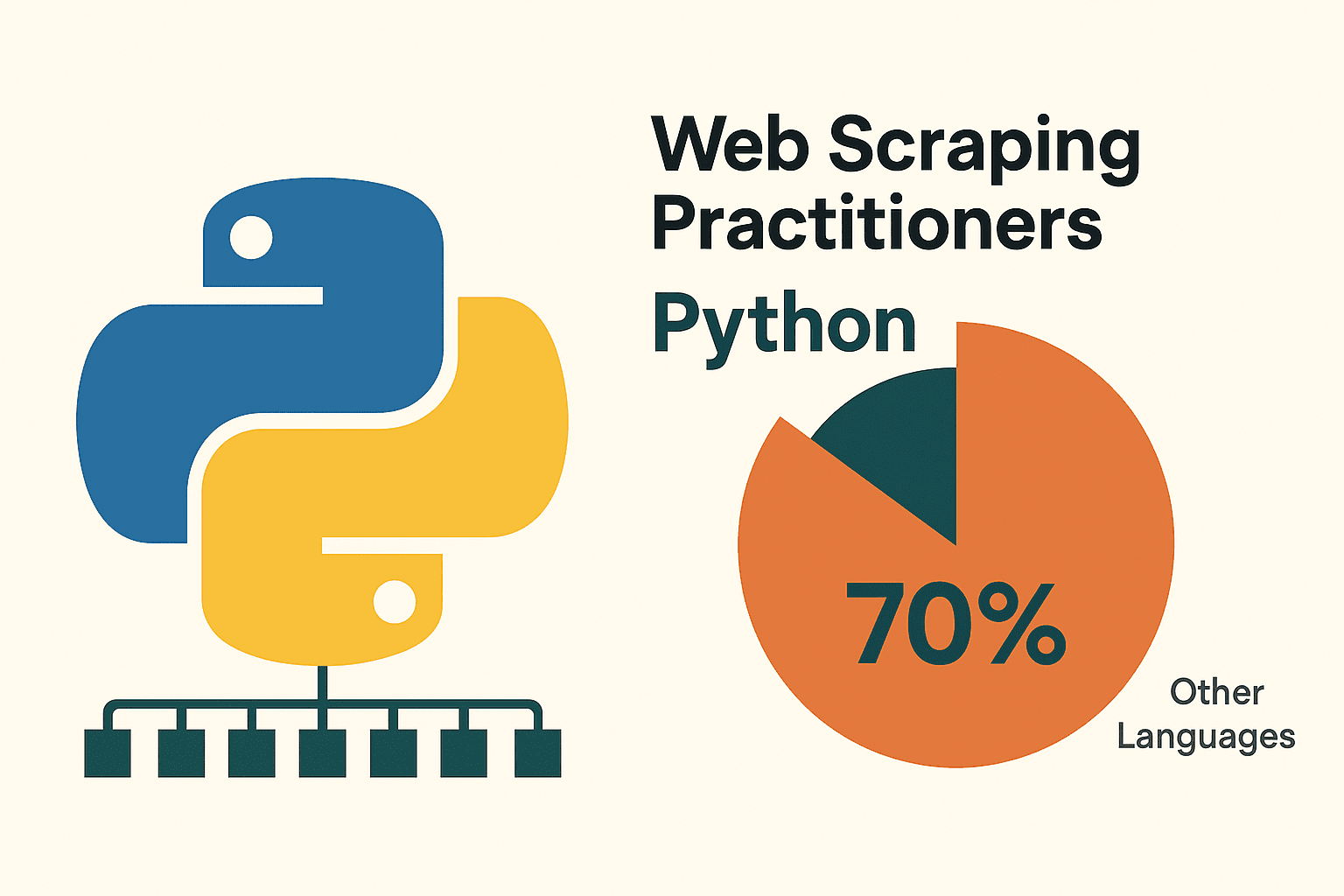

Waarom is Python zo populair voor scrapen? Allereerst is het makkelijk te leren—de syntax lijkt sterk op het Engels, wat het toegankelijk maakt voor beginners. Maar de echte kracht zit in het ecosysteem: libraries als requests, BeautifulSoup, Scrapy, Selenium en pandas regelen alles van het ophalen van webpagina’s tot het verwerken van HTML en het exporteren van schone data. Niet voor niets gebruikt ongeveer , veel meer dan andere talen.

Waarom Python Kiezen voor Webscraping?

Ik heb met veel programmeertalen geëxperimenteerd, maar Python blijft de favoriet voor webscraping—zeker als je net begint. Dit zijn de belangrijkste redenen:

- Eenvoud & Leesbaarheid: Python is overzichtelijk en makkelijk te begrijpen, waardoor je sneller scripts schrijft en fouten opspoort ().

- Uitgebreide Library-ondersteuning: Libraries als requests (voor HTTP), BeautifulSoup (HTML-parsing), Scrapy (voor grootschalig crawlen), Selenium (browserautomatisering) en pandas (data-analyse) dekken het hele scrapingproces ().

- Grote Community & Veel Hulpbronnen: Python heeft een enorme, actieve community. Loop je ergens vast, dan is de kans groot dat iemand het probleem al heeft opgelost en gedeeld.

Hoe verhoudt Python zich tot andere opties? Hier een kort overzicht:

| Methode | Voordelen | Nadelen |

|---|---|---|

| Python | Makkelijk te leren, veel libraries, ideaal voor data-analyse, veelzijdig | Je moet wat code schrijven, extra tools nodig voor zware JavaScript-sites |

| JavaScript/Node | Kan dynamische content direct aan, async-vriendelijk, zelfde taal als web front-end | Steilere leercurve, minder scraping-libraries, omslachtiger voor beginners |

| R (rvest) | Snel data extraheren voor onderzoek, goede integratie met R-analytics | Kleinere scraping-community, minder geschikt voor dynamische sites |

| No-Code Tools | Geen code nodig, snel opzetten, AI/visuele helpers (zoals Thunderbit) | Minder flexibel voor maatwerk, limieten op gebruik, minder controle |

(, )

Voor de meeste zakelijke gebruikers en data-enthousiastelingen is Python de ideale keuze: krachtig, flexibel en niet intimiderend.

Je Python-omgeving Klaarmaken voor Data Scraping

Voordat je kunt scrapen, moet je Python goed instellen. Geen stress—het is makkelijker dan een IKEA-kast in elkaar zetten, en je houdt geen schroeven over.

1. Installeer Python:

Download de nieuwste versie van Python 3 via . Op Windows: vink “Add Python to PATH” aan tijdens de installatie. Op Mac kun je Homebrew gebruiken (brew install python3). Linux-gebruikers hebben Python vaak al, anders werkt apt install python3 python3-pip ().

2. (Aanbevolen) Maak een Virtuele Omgeving:

Zo houd je de libraries van je project gescheiden. In je projectmap:

1python -m venv venv

2# Activeer de omgeving:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. Installeer de Belangrijkste Libraries:

Open je terminal en voer uit:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: Voor HTTP-verzoekenbeautifulsoup4: Voor HTML-parsingpandas: Voor dataverwerking/exportselenium: Voor dynamische sites (optioneel)lxml: Snelle HTML/XML-parsing

4. Kies een Code Editor:

- (met Python-extensie): Lichtgewicht, populair, ideaal voor beginners.

- : Volledig uitgerust, speciaal voor Python.

- : Interactief, perfect om te experimenteren en data te analyseren ().

5. (Voor Selenium) Installeer een WebDriver:

Selenium heeft een browserdriver nodig (zoals ChromeDriver). De makkelijkste manier is via webdriver_manager:

1pip install webdriver-managerEn in je script:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))Problemen met pip? Check of Python aan je PATH is toegevoegd en of je virtuele omgeving actief is.

Statische Websites Scrapen met Python: Stap voor Stap

Statische websites zijn het makkelijkst te scrapen. Kun je de data zien via “Paginabron weergeven” in je browser? Dan kun je het met Python binnenhalen.

We lopen door het scrapen van , een bekende oefensite.

Stap 1: Haal de Pagina op

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 betekent OKStap 2: Parse de HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")Stap 3: Haal de Data op

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")Stap 4: Paginering Afhandelen

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)En zo heb je in een paar regels code meerdere pagina’s gescrapet en de data opgeslagen als CSV. Niet verkeerd, toch? ()

Tip: Check altijd het robots.txt-bestand en de gebruiksvoorwaarden van een site voordat je gaat scrapen. En wees netjes—stuur niet te veel verzoeken achter elkaar. Een korte time.sleep(1) tussen verzoeken is wel zo beleefd.

Dynamische Websites Scrapen: Selenium Gebruiken met Python

Sommige websites zijn lastiger. Verschijnt de data pas na het laden van JavaScript (zoals bij oneindig scrollen, pop-ups of dashboards), dan heb je een tool nodig die zich als een echte browser gedraagt. Dat is waar Selenium van pas komt.

Stap 1: Start de Browser

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")Stap 2: Wacht tot de Content is Geladen

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)Stap 3: Scrollen of Klikken om Meer te Laden

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightStap 4: Data Uitlezen

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})Stap 5: Opslaan en Opruimen

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()Tips:

- Gebruik expliciete waits (

WebDriverWait) om fouten te voorkomen als elementen nog niet geladen zijn (). - Voor headless (zonder venster) modus, voeg

options.headless = Truetoe aan je Chrome-opties. - Zie je in de netwerk-tab van je browser een JSON API-endpoint? Dan kun je vaak Selenium overslaan en direct met

requestswerken—dat is veel sneller!

Thunderbit en Python Combineren voor Krachtige Dataworkflows

Nu wordt het pas echt interessant. Soms voelt scrapen met Python-libraries op een rommelige of complexe site als worstelen met een paling in een emmer snot. Daar komt om de hoek kijken.

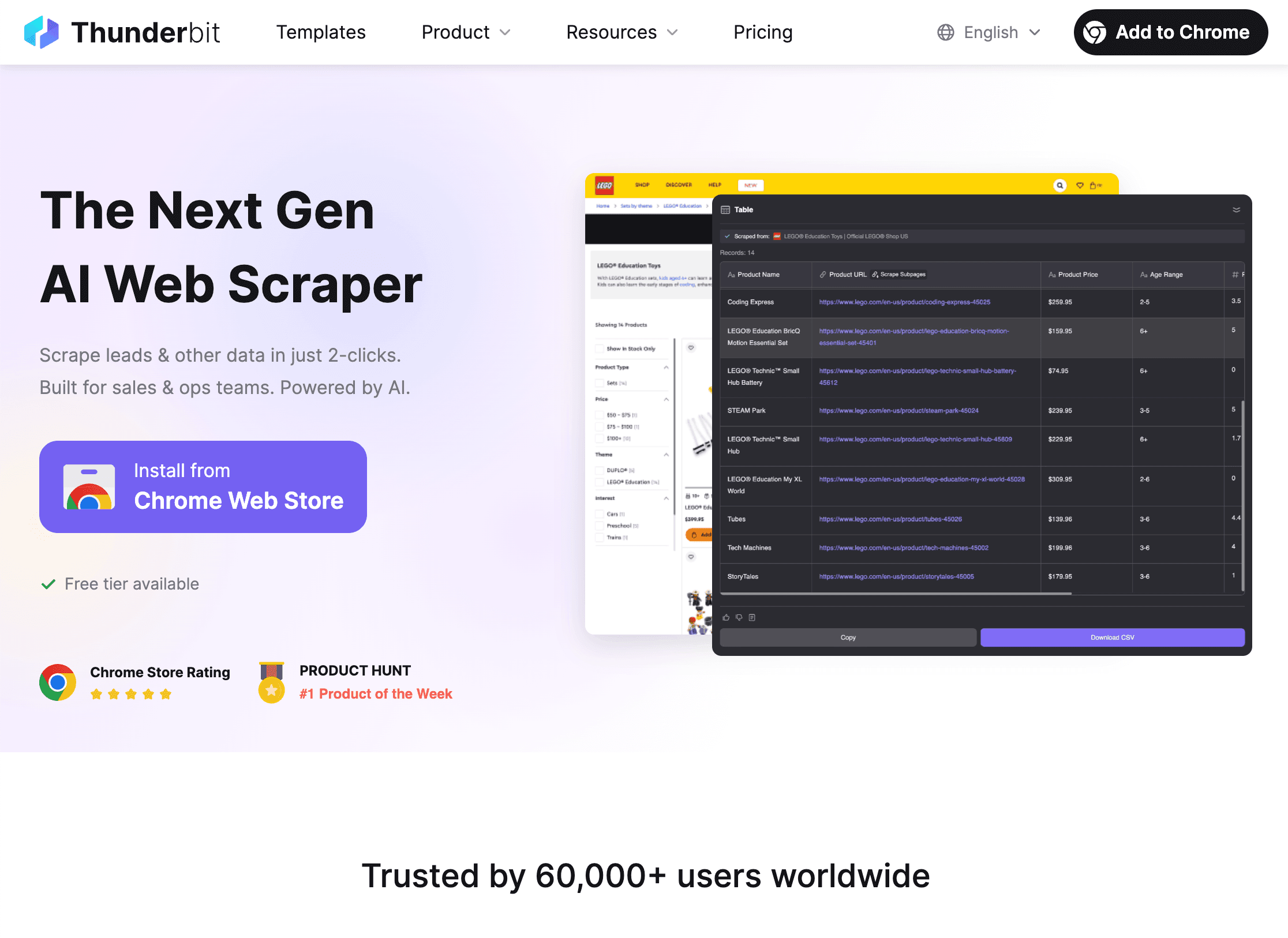

Thunderbit is een AI-webscraper Chrome-extensie waarmee je met een paar klikken data van elke website haalt—zonder te programmeren. Ideaal voor zakelijke gebruikers die snel data nodig hebben, maar ook perfect te combineren met Python voor geavanceerdere workflows.

Hoe Thunderbit + Python je workflow versnellen:

Hoe Thunderbit + Python je workflow versnellen:

-

Gebruik Thunderbit om data te scrapen:

- Open de .

- Klik op “AI Suggest Fields” en laat Thunderbit’s AI bepalen wat je moet extraheren.

- Paginering, subpagina’s en zelfs afbeeldingen of PDF’s pak je eenvoudig mee.

- Exporteer je data direct naar CSV, Excel, Google Sheets, Notion of Airtable.

-

Analyseer en bewerk je data in Python:

- Laad het geëxporteerde bestand in Python met pandas:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - Nu kun je filteren, opschonen, samenvoegen, visualiseren of geavanceerde analyses uitvoeren—wat je project ook vraagt.

- Laad het geëxporteerde bestand in Python met pandas:

-

Automatiseer de pipeline:

- Thunderbit ondersteunt geplande scraping, zodat je dagelijks verse data ontvangt.

- Combineer met Python-scripts voor automatische rapportages, meldingen of verdere verwerking.

Waarom beide gebruiken? Thunderbit bespaart je uren aan code en debugging, vooral bij lastige of eenmalige scrapingklussen. Python geeft je de vrijheid om die data te analyseren, bewerken en integreren in je bedrijfsprocessen. Het is als pindakaas en hagelslag—los lekker, samen nog beter ().

Veelvoorkomende Uitdagingen bij Python Webscraping

Webscraping verloopt niet altijd vlekkeloos. Dit zijn veelvoorkomende problemen—en hoe je ze oplost:

1. Geblokkeerd worden (403/429-fouten, CAPTCHAs):

- Wissel je User-Agent om echte browsers na te bootsen.

- Gebruik proxies om IP-adressen te roteren ().

- Voeg vertragingen toe tussen verzoeken (

time.sleep()). - Respecteer robots.txt en crawl-delay regels.

- Voor CAPTCHAs: gebruik Selenium voor handmatige oplossing of een CAPTCHA-dienst.

2. Dynamische content laadt niet:

- Gebruik Selenium om JavaScript-zware pagina’s te renderen.

- Zoek in de netwerk-tab naar interne API-calls—soms kun je data direct als JSON ophalen.

3. Problemen met inloggen of sessies:

- Gebruik

requests.Session()om cookies te bewaren. - Automatiseer inlogprocessen met Selenium indien nodig.

4. Website-structuur verandert:

- Schrijf robuuste selectors (gebruik liever IDs dan klassen).

- Houd wijzigingen in de gaten en pas je script aan.

- Thunderbit’s AI past zich automatisch aan lay-outwijzigingen aan, wat onderhoud scheelt.

5. Grote hoeveelheden data:

- Gebruik concurrency (

concurrent.futuresofasyncio) om sneller te scrapen. - Schrijf data stapsgewijs weg naar schijf of database om geheugenproblemen te voorkomen.

(, )

Troubleshooting: Je Scraping Scripts Debuggen en Optimaliseren

Gaat er iets mis (en dat gebeurt), check dan het volgende:

- HTTP 404/403/429: Controleer je URL, headers en het aantal verzoeken per tijdseenheid.

- Timeouts/Verbindingsfouten: Implementeer retries met exponential backoff.

- AttributeError/NoneType: Controleer of elementen bestaan voordat je ze aanspreekt; inspecteer de HTML die je binnenkrijgt.

- Encoding-problemen: Zet

response.encoding = 'utf-8'of geef encoding op bij het opslaan. - Selenium-element niet gevonden: Gebruik expliciete waits; check je selectors.

- Geheugenfouten: Schrijf data in batches weg, gebruik generators of een database bij grote datasets.

- Debuggen: Gebruik print-statements, logging of sla de HTML op voor inspectie.

Voor betere prestaties kun je asynchrone requests (aiohttp), threading of een framework als Scrapy gebruiken bij grote projecten. Maar maak het niet te ingewikkeld voor kleine klussen—duidelijkheid is belangrijker dan slimheid als je leert.

Best Practices voor Ethisch en Wettelijk Webscrapen

Met grote scrapingkracht komt grote verantwoordelijkheid. Zo blijf je netjes en legaal:

- Respecteer robots.txt en de gebruiksvoorwaarden: Staat er “niet scrapen”, doe het dan niet.

- Vermijd persoonlijke of gevoelige data: Focus op openbare informatie; verzamel geen data die je zelf niet gedeeld zou willen hebben.

- Wees beleefd: Beperk je verzoeken, scrape niet tijdens piekuren en overbelast servers niet.

- Identificeer jezelf: Gebruik een User-Agent met contactinfo als dat gepast is.

- Check de wetgeving: In de VS is het scrapen van openbare data meestal toegestaan, maar schending van voorwaarden of het scrapen van privédata kan problemen opleveren ().

- Gebruik een API als die er is: Een API is veiliger en stabieler.

(, )

Samenvatting & Belangrijkste Punten

Data scrapen met Python is een van de meest waardevolle skills in deze data-gedreven tijd. De belangrijkste punten op een rij:

- Python is dé keuze voor webscraping dankzij eenvoud, libraries en community ().

- Begin met statische sites via requests en BeautifulSoup; gebruik Selenium voor dynamische content.

- Thunderbit bespaart je uren bij lastige of eenmalige scrapingklussen—gebruik daarna Python voor analyse en automatisering.

- Pak uitdagingen aan met roterende headers, proxies, vertragingen en goede foutafhandeling.

- Scrape ethisch: Respecteer websites, vermijd gevoelige data en blijf binnen de wet.

Mijn tip? Begin klein—kies een simpele site, schrijf je eerste script en kijk wat je kunt binnenhalen. Ben je eenmaal vertrouwd, combineer dan Thunderbit en Python voor nog krachtigere workflows. En onthoud: elke fout is gewoon een puzzel die je kunt oplossen (soms met een beetje hulp van Stack Overflow).

Wil je Thunderbit in actie zien of meer leren over scrapen? Check de of abonneer je op ons voor tutorials en tips.

Veel succes met scrapen—moge je data altijd schoon zijn, je scripts soepel draaien en je IP-adres niet geblokkeerd raken.

Veelgestelde Vragen

1. Wat is webscraping en is het legaal?

Webscraping is het automatisch verzamelen van data van websites. Het scrapen van openbare data is in de VS en veel andere landen meestal toegestaan, maar je moet de voorwaarden van de site respecteren, geen gevoelige data verzamelen en privacywetten naleven ().

2. Waarom gebruiken de meeste mensen Python voor webscraping?

Python is gebruiksvriendelijk, heeft krachtige libraries voor elke stap (requests, BeautifulSoup, Selenium, pandas) en een grote community voor ondersteuning ().

3. Wanneer gebruik je Selenium in plaats van requests/BeautifulSoup?

Gebruik Selenium als de data pas zichtbaar wordt na het uitvoeren van JavaScript en niet direct in de HTML staat. Selenium automatiseert een echte browser en ziet wat een gebruiker ziet.

4. Hoe werkt Thunderbit samen met Python?

Met Thunderbit kun je complexe of ongestructureerde data met AI in een paar klikken scrapen en exporteren naar CSV/Excel/Sheets. Daarna kun je die data in Python laden voor bewerking, analyse of automatisering—dat scheelt je uren programmeerwerk.

5. Wat zijn de beste tips om blokkades te voorkomen bij scrapen?

Wissel je User-Agent, gebruik proxies, voeg vertragingen toe, respecteer robots.txt en scrape geen gevoelige of privédata. Voor grootschalig scrapen kun je anti-bot tools of diensten overwegen.

Zelf aan de slag met scrapen? Download de en ontdek hoe makkelijk het is om AI en Python te combineren voor je volgende dataproject. En onthoud: elke goede webscraper begon ooit met één regel code.

Meer weten