Ik weet het nog goed: de allereerste keer dat ik probeerde data van een website te plukken. Met een bakkie koffie naast me zat ik vol goede moed achter mijn laptop, vastbesloten om voorgoed af te rekenen met dat eindeloze knip- en plakwerk van productprijzen. Python opgestart, BeautifulSoup geïnstalleerd, en vol enthousiasme begonnen—om vervolgens hopeloos te verdwalen in een jungle van onbegrijpelijke HTML en foutmeldingen. Als je ooit hebt geprobeerd om met Python webdata te verzamelen, herken je het vast: een mix van nieuwsgierigheid, frustratie en soms de neiging om je laptop uit het raam te gooien.

Toch is webdata tegenwoordig goud waard. Bedrijven willen real-time inzichten—of het nu gaat om het volgen van concurrentieprijzen, het samenstellen van leadlijsten of het spotten van markttrends. Python webscraping is jarenlang dé go-to geweest, maar nu websites steeds slimmer worden en anti-scrapingmaatregelen steeds geavanceerder, voelt de klassieke, code-intensieve aanpak... tja, een tikje ouderwets. Daarom neem ik je vandaag mee in beide werelden: het vertrouwde Python webscraping-gereedschap én de nieuwe generatie AI-webscrapers zoals die het werk van sales-, e-commerce- en operationele teams compleet op z’n kop zetten.

Wat is Python Webscraping?

Laten we bij het begin beginnen: webscraping betekent simpelweg automatisch data van websites halen. In plaats van handmatig informatie te kopiëren, schrijf je een script dat dit klusje voor je klaart. Python is hiervoor razend populair bij beginners omdat het lekker leesbaar is, een enorme community heeft en een bak aan handige libraries biedt—zelfs als je geen hardcore programmeur bent.

Waarom Python?

- Makkelijk te leren: De Python-syntax is berucht simpel.

- Uitgebreide libraries: Tools als Requests, BeautifulSoup, Selenium en Scrapy dekken alles van simpele statische pagina’s tot complexe, JavaScript-gedreven sites.

- Grote community: Zit je vast? Grote kans dat iemand anders het probleem al heeft opgelost (of erover heeft gepost op Stack Overflow).

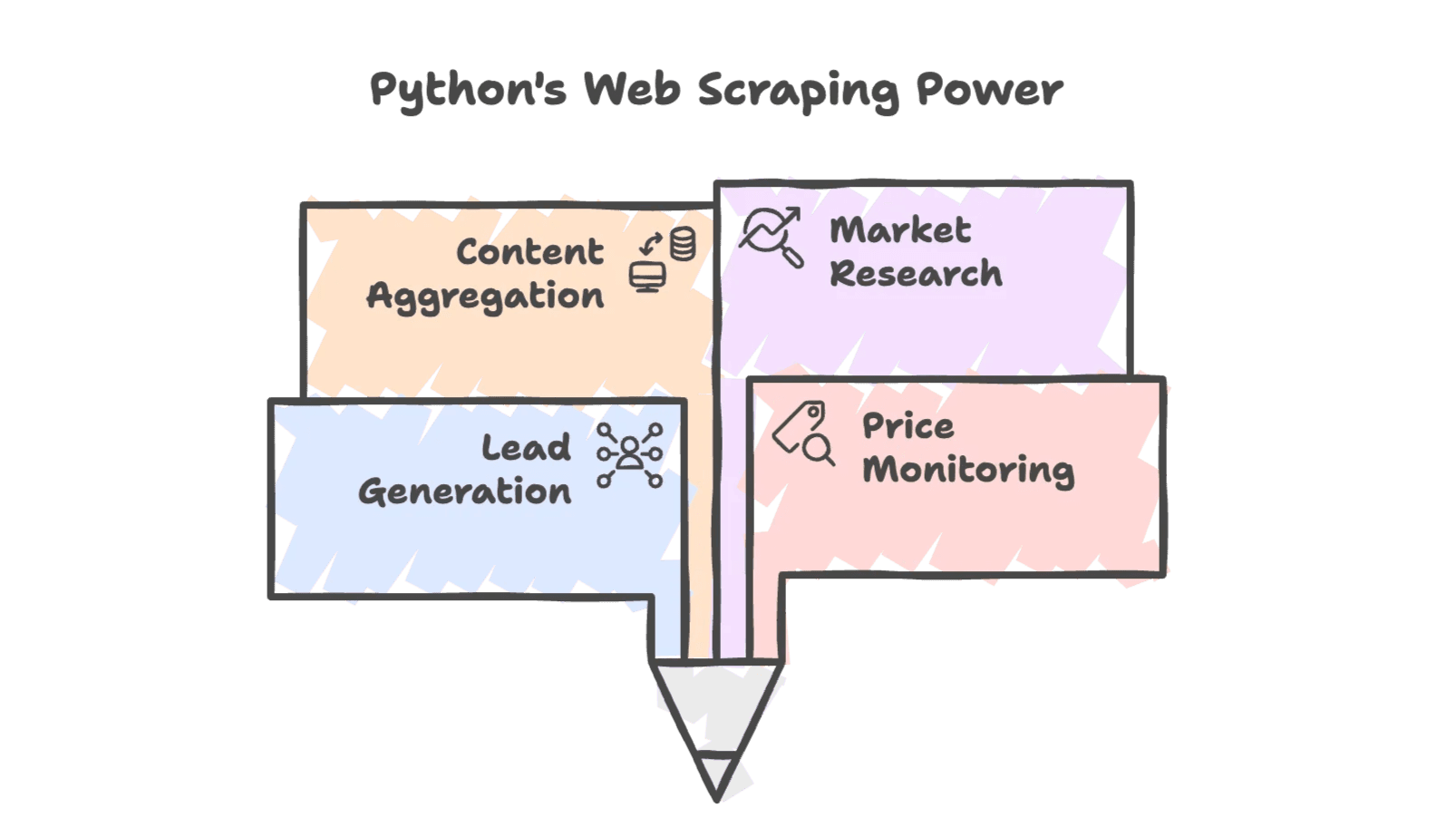

Typische Toepassingen

Python webscraping wordt in allerlei zakelijke situaties gebruikt:

- Leadgeneratie: Contactgegevens verzamelen uit bedrijvengidsen of sociale netwerken.

- Prijsmonitoring: Concurrentieprijzen volgen voor dynamische prijsstrategieën.

- Content aggregatie: Nieuws, reviews of productlijsten verzamelen.

- Marktonderzoek: Trends ophalen uit fora, social media of zoekresultaten.

En het is allang niet meer alleen voor techneuten—sales, e-commerce en zelfs makelaarskantoren vertrouwen op gescrapete data om voorop te blijven lopen. Sterker nog, gebruikt webscraping inmiddels om eigen datasets te bouwen voor analyses en lead scoring.

Waarom Gebruiken Bedrijven Python voor Webscraping?

De flexibiliteit van Python en de krachtige libraries maken het een logische keuze voor webscraping. Laten we eens kijken naar een paar praktijkvoorbeelden:

| Scenario | Hoe Python Webscraping Helpt | Voorbeeld van Voordeel (ROI) |

|---|---|---|

| Leadgeneratie | Bedrijvengidsen scrapen voor namen, e-mails, telefoonnummers | Binnen één nacht een prospectlijst van 500 personen, tegenover 50 handmatig |

| Prijsmonitoring | Regelmatig prijzen van concurrenten ophalen | Mogelijkheid tot dynamische prijzen—een retailer verhoogde de omzet met 4% dankzij gescrapete data |

| Voorraadmonitoring | Voorraadstatus van concurrenten checken | Klanten benaderen als concurrenten uitverkocht zijn, uren handmatig werk bespaard |

| Concurrentieonderzoek | Productdetails en reviews verzamelen | Meer dan 1.000 reviews van concurrenten analyseren voor marketing en productontwikkeling |

| Marktonderzoek | Data verzamelen uit fora, social media, zoekresultaten | Campagnes sturen op actuele markttrends, strategie afstemmen op echte interesse |

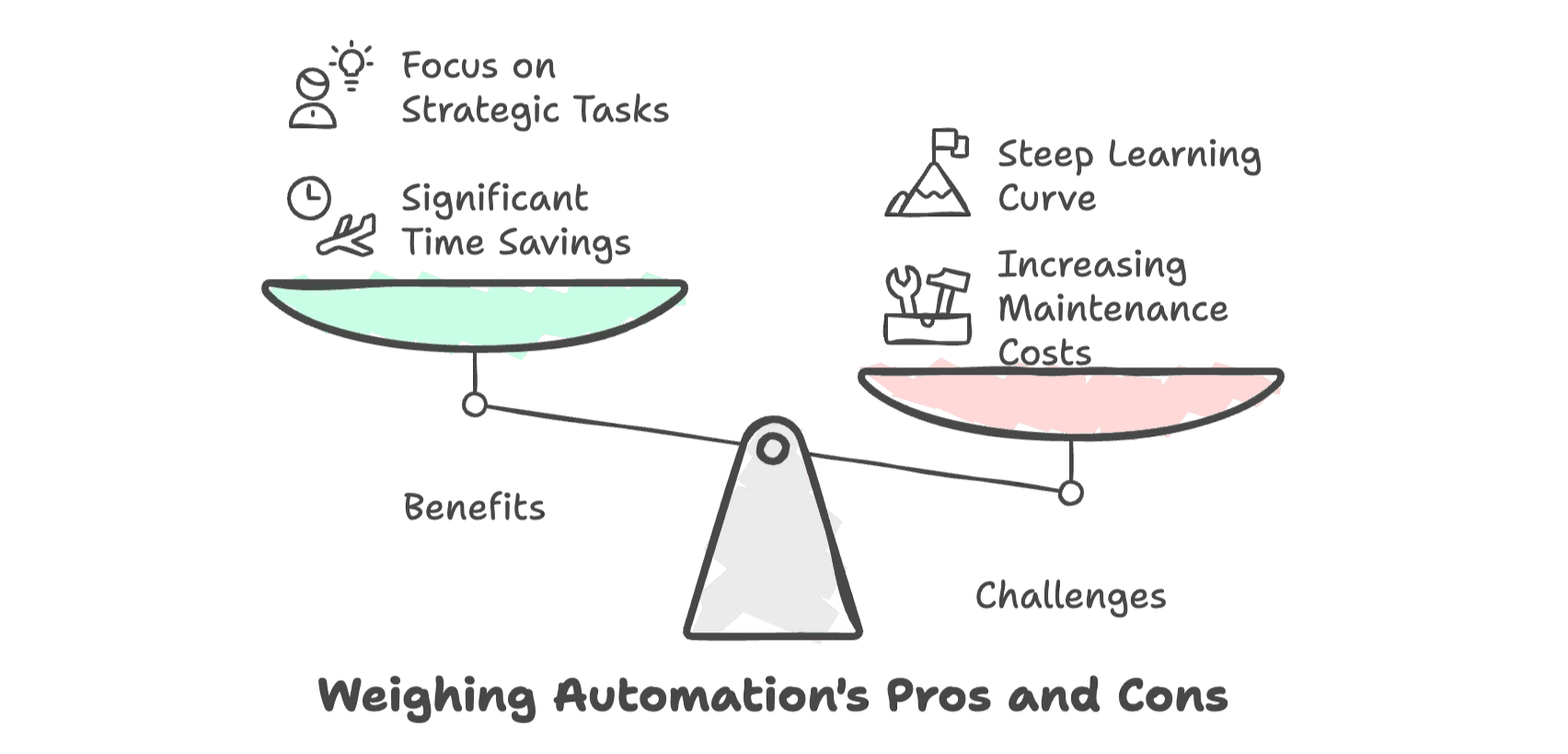

De meerwaarde is duidelijk: door data automatisch te verzamelen met Python bespaar je tot 80% van de tijd ten opzichte van handmatig werk (). Je team kan zich dus meer richten op deals sluiten of analyses maken, in plaats van op saaie klusjes.

Maar—en dit is een flinke maar—nu websites steeds slimmer worden, lopen de kosten (in tijd, frustratie en onderhoud) om je scripts draaiende te houden snel op. Voor niet-technische gebruikers is de leercurve steil en de frustratie soms groot.

Onmisbare Tools voor Python Webscraping

Als je net begint, biedt het Python-ecosysteem een aantal onmisbare tools. Een kort overzicht:

| Tool | Ideaal Voor | Kan JavaScript aan? | Leercurve | Snelheid & Schaal |

|---|---|---|---|---|

| Requests + BeautifulSoup | Simpele, statische pagina’s | Nee | Laag | Snel voor losse pagina’s |

| Selenium | Dynamische, JS-rijke sites; interactie | Ja | Gemiddeld | Trager per pagina |

| Scrapy | Grootschalig, gestructureerd crawlen | Gedeeltelijk (met plugins) | Hoog | Hoge prestaties, schaalbaar |

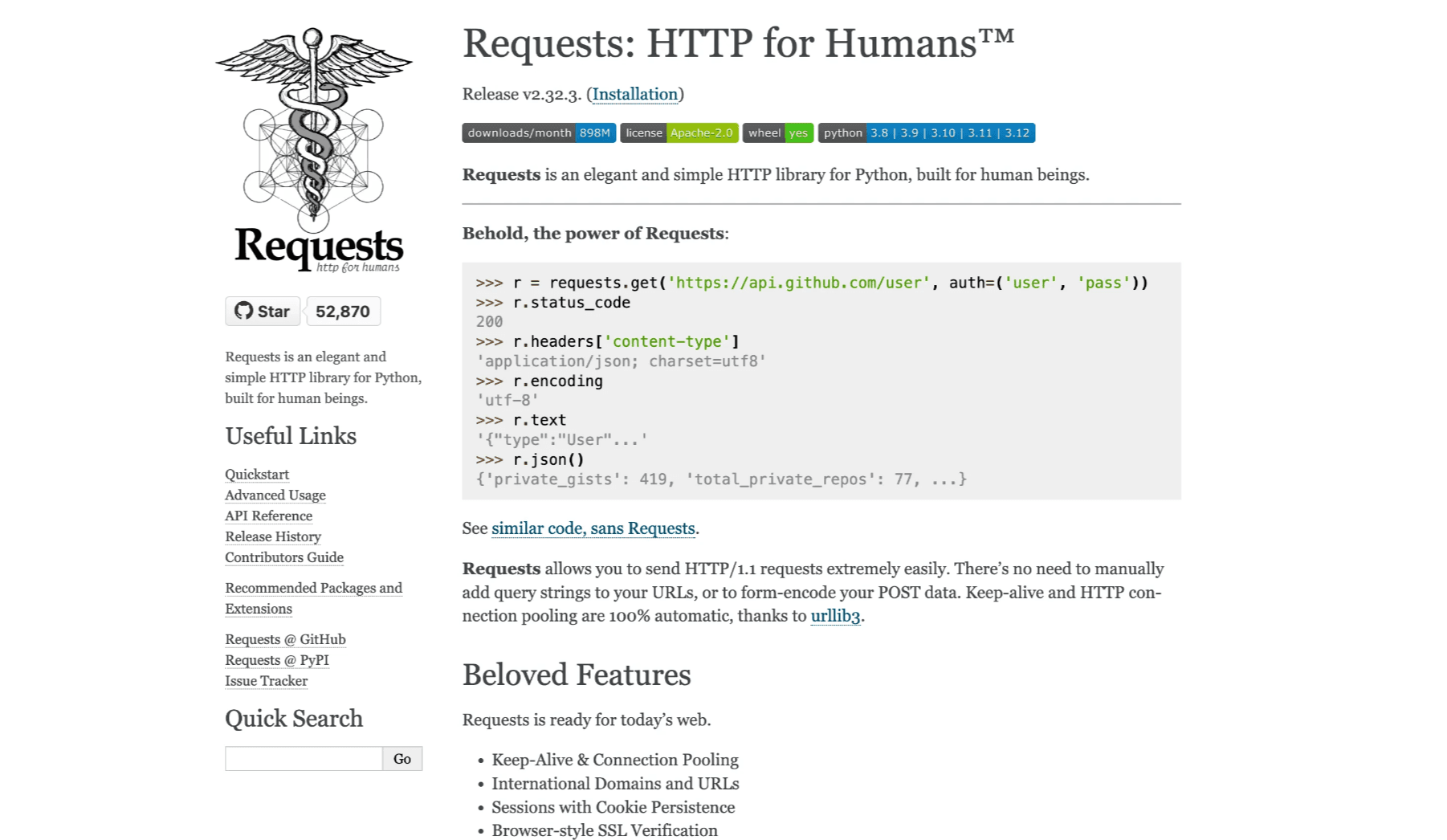

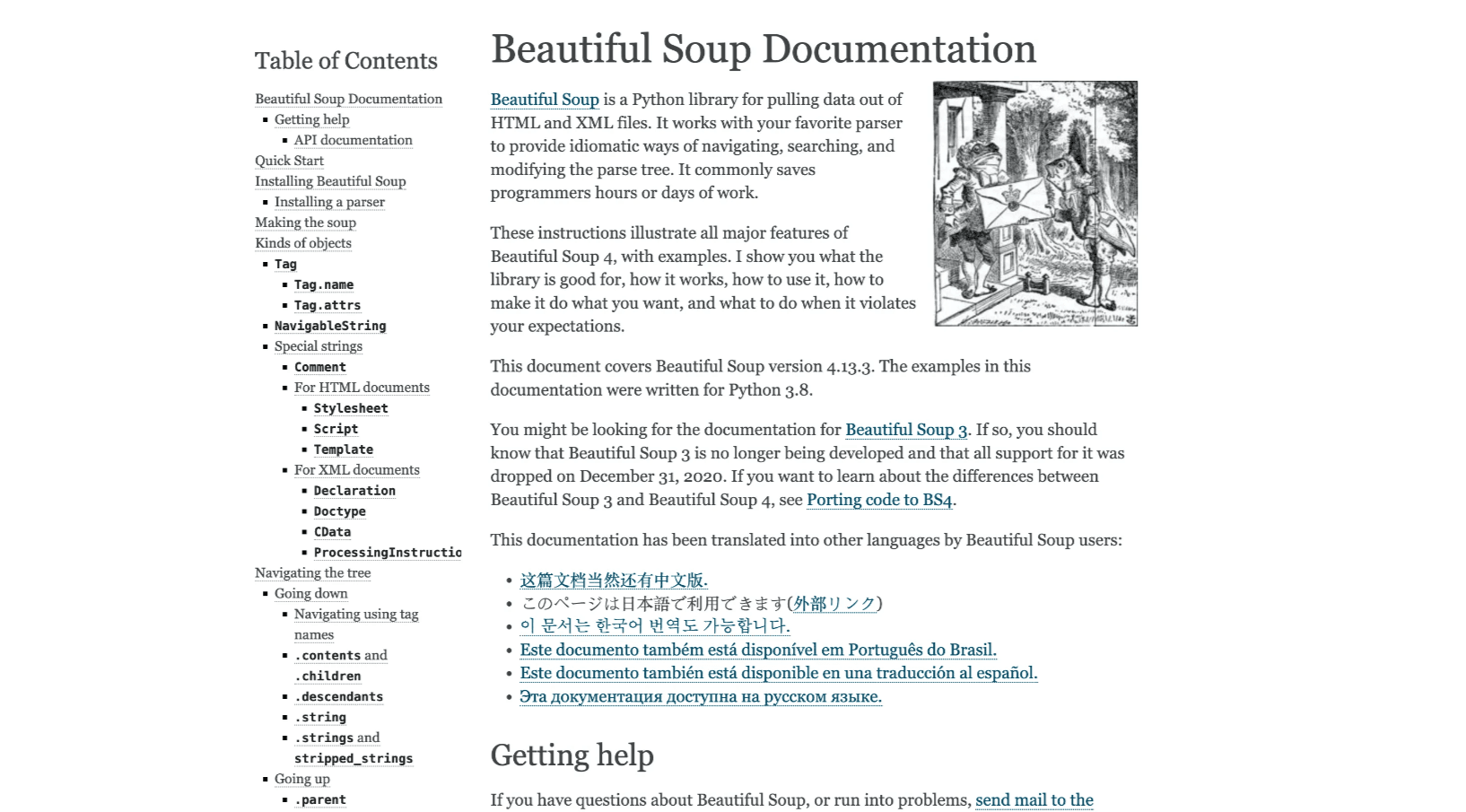

Requests + BeautifulSoup

De klassieker voor statische sites. Requests haalt de HTML op, BeautifulSoup maakt het makkelijk om de juiste data eruit te vissen. Lichtgewicht, simpel en ideaal voor kleine projecten (, ).

Selenium

Moet je data verzamelen die pas zichtbaar wordt na het laden van JavaScript? Dan is Selenium je beste maatje. Hiermee automatiseer je een echte browser, zodat je ook logins, klikken en scrollen aankan (). Nadeel: het is trager en wat lastiger op te zetten.

Scrapy

Voor grote projecten—denk aan het crawlen van duizenden pagina’s of het bouwen van een terugkerende datastroom—is Scrapy de krachtpatser. Een compleet framework voor het bouwen van robuuste spiders, met ondersteuning voor gelijktijdigheid en gestructureerde code (). De leercurve is steiler, maar het loont bij grootschalige klussen.

Stapsgewijs: Je Eerste Python Webscraper

Tijd om zelf aan de slag te gaan. We gaan boektitels en prijzen scrapen van —een demo-website speciaal voor webscraping-oefeningen.

Je Python-omgeving Inrichten

Zorg eerst dat Python geïnstalleerd is. Open daarna je terminal en voer uit:

1pip install requests beautifulsoup4Een fijne code-editor zoals VS Code of PyCharm is een aanrader. Je toekomstige zelf zal je dankbaar zijn voor de syntax-highlighting alleen al.

Je Eerste Webscraping Script Schrijven

Hier een simpel script om de homepage op te halen en de boekdata te parsen:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)Wat gebeurt er hier?

- We halen de HTML op met Requests.

- We parsen de HTML met BeautifulSoup.

- We zoeken alle boekvermeldingen.

- We halen de titel en prijs van elk boek eruit.

Gescrapete Data Exporteren

Om je data bruikbaar te maken, kun je deze opslaan als CSV-bestand:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)Nu kun je books.csv openen in Excel of Google Sheets en genieten van je verzamelde data.

Pro Tips:

- Check altijd je output op fouten of ontbrekende data.

- Zie je rare tekens? Zorg dat je UTF-8 encoding gebruikt.

- Werkt je script ineens niet meer? Kijk of de website-structuur is aangepast.

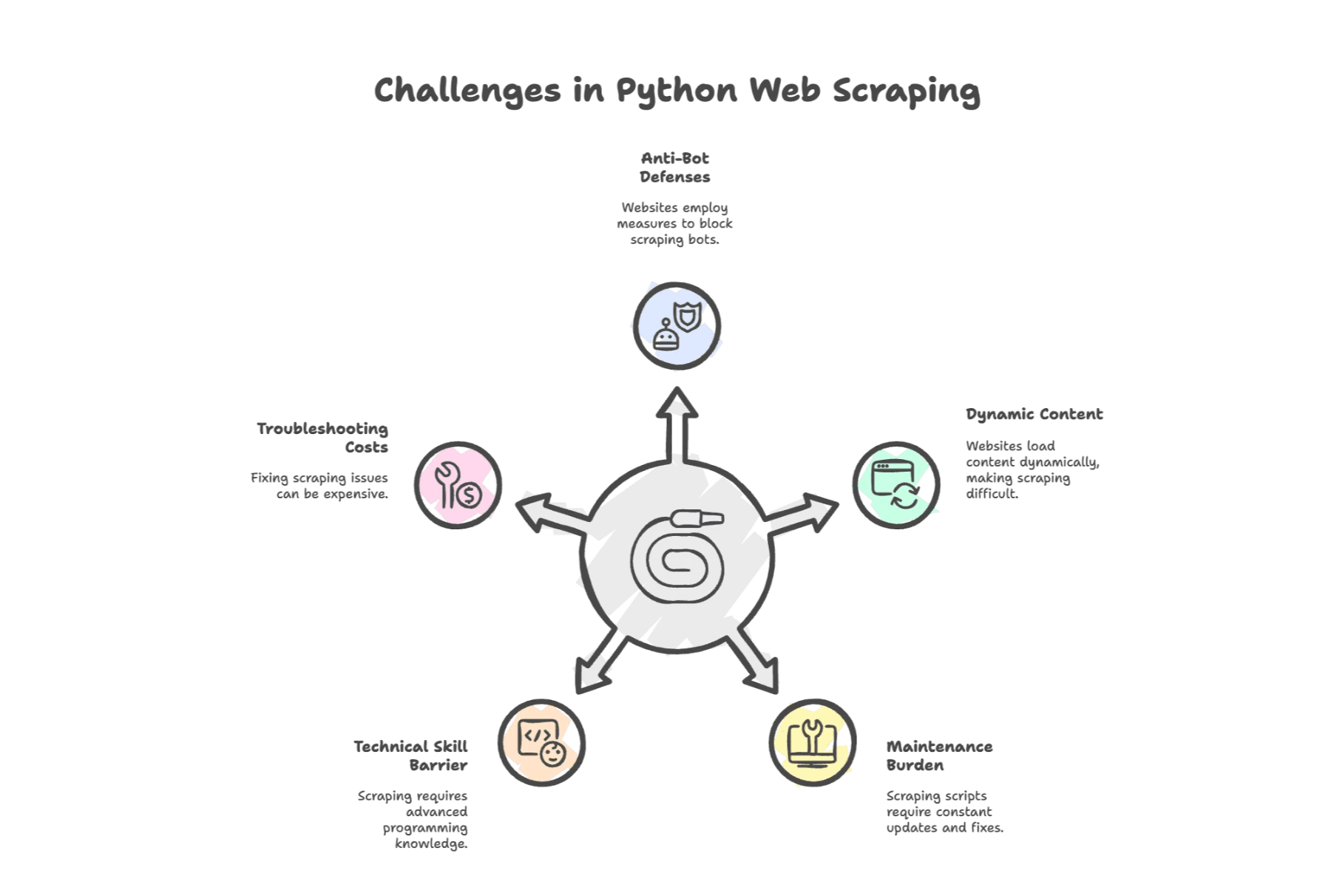

Veelvoorkomende Uitdagingen bij Python Webscraping

Hier wordt het spannend. Python webscraping is krachtig, maar niet zonder hobbels. Dit zijn de grootste struikelblokken:

1. Anti-botmaatregelen

Websites slaan terug. Uit een recent onderzoek blijkt dat blokkades (IP-bans, CAPTCHAs) als grootste obstakel ziet. Sites herkennen scripts en gooien barrières op—soms letterlijk, in de vorm van een CAPTCHA.

2. Dynamische Content

Moderne sites draaien op JavaScript. Als de data die je zoekt pas na het laden verschijnt, levert je Requests + BeautifulSoup-script niets op. Je zult dan Selenium moeten gebruiken of een API moeten achterhalen.

3. Onderhoudsintensief

Websites veranderen continu. Een kleine wijziging in de HTML kan je script breken. Uit onderzoek blijkt dat ontwikkelaars kwijt zijn aan het repareren van kapotte scrapers, en bedrijven jaarlijks $15.000 aan onderhoud spenderen.

4. Technische Drempel

Zelfs met de eenvoud van Python moet je HTML, CSS-selectors en soms HTTP-protocollen begrijpen. Voor niet-developers voelt dit als een nieuwe taal leren—en dat is het eigenlijk ook.

5. Foutopsporing Kost Tijd

Gaat er iets mis (en dat gebeurt), dan heb je soms proxies, headless browsers of externe diensten nodig. Elk uur debuggen is een uur minder voor je echte werk.

Geautomatiseerde Webscraping Tools: De Volgende Stap

Wat doe je als zakelijke gebruiker (of overbelaste sales-ops)? Dan zijn er geautomatiseerde webscraping tools—en tegenwoordig vooral AI-webscrapers.

Deze tools nemen het zware werk uit handen. Geen code meer schrijven voor elke site, geen nachtelijke debug-sessies. Gewoon aanwijzen, klikken en je data ophalen.

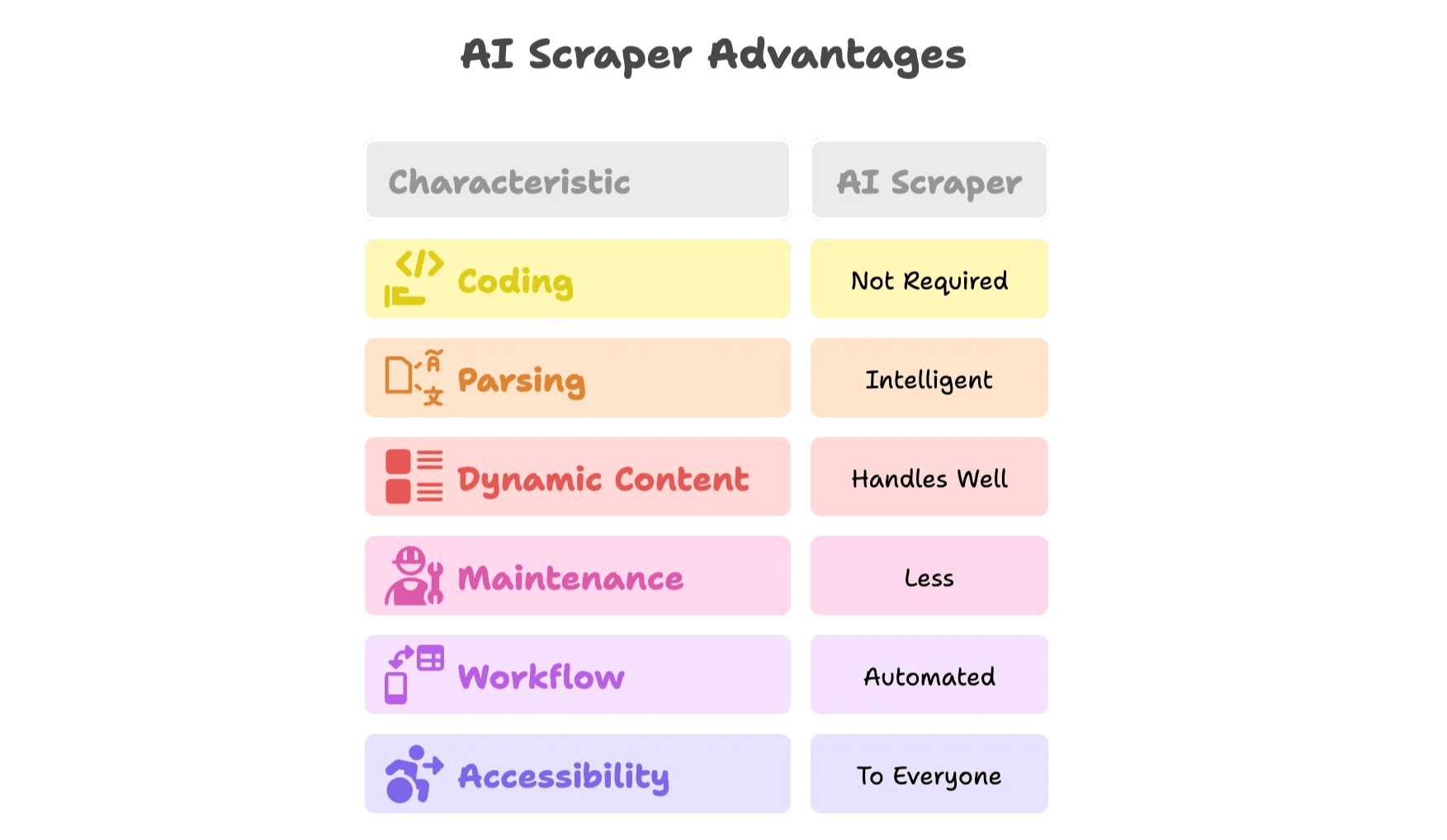

Wat Maakt een AI-webscraper Anders?

AI-webscrapers zijn een flinke stap vooruit. Waarom?

- Geen code nodig: Met visuele interfaces of browserextensies selecteer je de gewenste data, de AI doet de rest.

- Slimme dataherkenning: AI-modellen herkennen automatisch velden als namen, prijzen en e-mails—zonder dat je HTML hoeft te inspecteren.

- Kan dynamische content aan: AI-webscrapers draaien in echte browsers, dus kunnen ze JavaScript, scrollen en klikken verwerken.

- Minder onderhoud: Verandert een site? De AI past zich aan—of het team achter de tool werkt de templates bij.

- Workflow-automatisering: Plan scrapes in, exporteer direct naar Google Sheets, Airtable, Notion of Excel.

- Voor iedereen toegankelijk: Je hoeft niet meer te wachten op de “Python-expert” in je team.

Laten we kijken hoe dit werkt met .

Thunderbit: Een Slimmer Alternatief voor Python Webscraping

Ik heb Thunderbit mede opgericht omdat ik zag hoeveel tijd en energie teams verspilden aan handmatig scrapen. Onze missie? Webdata voor iedereen toegankelijk maken—zonder code, zonder gedoe, gewoon resultaat.

Belangrijkste Features van Thunderbit’s AI-webscraper

- 2-klik AI-webscraper: Open een website, klik op “AI Suggest Fields” en Thunderbit’s AI stelt direct de beste kolommen voor. Klik op “Scrape” en je bent klaar.

- Kant-en-klare templates: Voor populaire sites (Amazon, Zillow, LinkedIn, enz.) zijn er direct bruikbare templates—geen gedoe met instellen.

- Subpagina’s & paginering: Thunderbit klikt automatisch door naar subpagina’s (zoals productdetails) en verwerkt paginering of oneindig scrollen.

- Gratis data-export: Exporteer je data naar Excel, Google Sheets, Airtable of Notion—zonder betaalmuur of beperkingen.

- E-mail & telefoon extractors: Haal direct contactgegevens van elke pagina, ideaal voor sales en leadgeneratie.

- AI-gedreven datatransformatie: Vat samen, categoriseer, vertaal of formatteer data direct.

- Geplande scraping: Stel terugkerende scrapes in met natuurlijke taal.

- Cloud & browseropties: Kies voor snelle cloud-scraping of browser-scraping voor sites met login.

- Ondersteunt 34 talen: Thunderbit is gemaakt voor internationale teams.

Wil je het zelf proberen? Check onze en de voor tutorials en praktijkvoorbeelden.

Wanneer Overstappen van Python naar een AI-webscraper?

Hier een handige checklist om te bepalen wat bij jouw situatie past:

| Situatie | Python Script | AI-webscraper (Thunderbit) |

|---|---|---|

| Eenmalige, simpele statische pagina | ✔️ | ✔️ |

| Dynamische content (JS, logins, infinite scroll) | ⚠️ | ✔️ |

| Regelmatige sitewijzigingen, veel onderhoud | ⚠️ | ✔️ |

| Niet-technisch team, snelheid nodig | ⚠️ | ✔️ |

| Data-integratie met meerdere platforms (Sheets, CRM) | ⚠️ | ✔️ |

| Grootschalig, terugkerend scrapen | ⚠️ | ✔️ |

| Behoefte aan planning, verrijking of automatisering | ⚠️ | ✔️ |

Zie je veel ⚠️ in je huidige workflow? Dan is het tijd om een AI-webscraper te proberen.

Bonus: Tips voor Efficiënt en Duurzaam Webdata Verzamelen

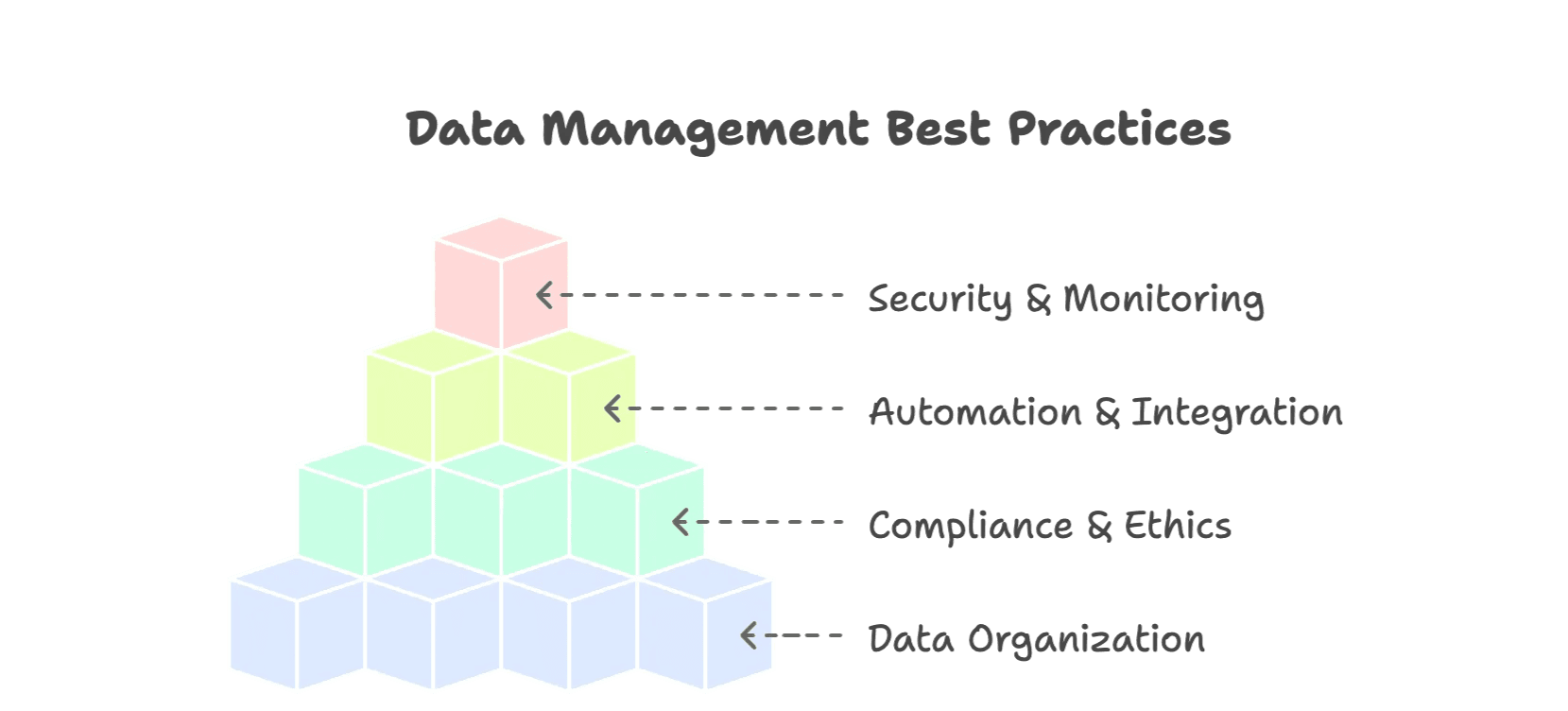

Of je nu Python of een AI-tool gebruikt, met deze best practices haal je meer uit je data:

1. Houd je Data Georganiseerd

- Gebruik gestructureerde formaten (CSV, Excel, databases).

- Normaliseer velden (datums, valuta, categorieën).

- Voeg metadata toe (bron, scrape-datum) voor context.

- Verwijder dubbele data en controleer op fouten.

2. Blijf Ethisch en Compliant

- Respecteer robots.txt en de gebruiksvoorwaarden van websites ().

- Overbelast sites niet—gebruik beleefde vertragingen.

- Vermijd het scrapen van persoonlijke of gevoelige data.

- Gebruik publieke API’s als die beschikbaar zijn.

3. Automatiseer en Integreer

- Plan terugkerende scrapes voor actuele data.

- Exporteer direct naar je workflowtools (Sheets, Airtable, Notion).

- Gebruik alerts of monitoring om fouten snel te signaleren.

4. Beveilig en Monitor

- Log je scraping-runs en fouten.

- Maak back-ups van je datasets.

- Beperk toegang tot gevoelige data.

Meer weten over best practices? Bekijk .

Conclusie: De Toekomst van Webscraping is Slimmer

We zijn een heel eind gekomen sinds de tijd van handmatig gecodeerde Python-scripts en eindeloos selectors fixen. Webdata is nu een strategisch bezit— gaat naar publieke webdata, en de markt voor AI-gedreven scrapingtools groeit naar verwachting tot .

Python blijft een uitstekende manier om de basis te leren en kleinere scrapingklussen te doen. Maar nu websites steeds complexer worden, moeten onze tools mee evolueren. AI-webscrapers zoals Thunderbit bieden een slimmere, efficiëntere manier om webdata te verzamelen en te gebruiken—precies zoals moderne teams werken.

Ben je meer tijd kwijt aan debuggen dan aan resultaat, of ben je benieuwd hoe modern scrapen eruitziet? Probeer Thunderbit: . Je sales-, e-commerce- of operationele team zal het verschil merken.