Laat me je meenemen naar het moment dat ik voor het eerst probeerde een website te scrapen voor zakelijke data. Ik zat aan de keukentafel, koffie in de ene hand, een half werkend Python-script in de andere, terwijl ik probeerde productprijzen van een concurrent binnen te hengelen. Ik dacht: “Hoe lastig kan het zijn?” Spoiler: ik eindigde met een CSV vol lege cellen en een nieuw respect voor iedereen die zegt: “Dat automatiseer je toch gewoon met Python.” Fast forward naar 2025: webscraping is de kurk waar datagedreven bedrijven op drijven—het voedt sales, e-commerce, marketing en operations met realtime inzichten die je met de hand nooit bij elkaar krijgt.

Maar let op: hoewel Python webscraping krachtiger is dan ooit, verandert het speelveld razendsnel. De markt voor webscraping groeit als kool—. Bijna om slimmer te kunnen beslissen. Maar de echte uitdaging is niet alleen code kloppen—het draait om de juiste tool kiezen, kunnen opschalen en niet gek worden van het onderhouden van een wirwar aan scripts. In deze ultieme gids neem ik je mee langs alle grote Python webscraping libraries (met codevoorbeelden), praktijkcases uit het bedrijfsleven, en waarom ik—ondanks mijn liefde voor Python—denk dat no-code oplossingen zoals in 2025 voor de meeste zakelijke gebruikers de beste keuze zijn.

Wat is Python Webscraping? Een Toegankelijke Uitleg

Heel simpel: webscraping is eigenlijk “automatisch kopiëren en plakken.” In plaats van een team stagiairs in te zetten om productprijzen, contactlijsten of reviews te verzamelen, gebruik je software die websites bezoekt, de data ophaalt die je nodig hebt, en alles netjes in een spreadsheet of database zet. Python webscraping betekent dat je hiervoor Python-scripts gebruikt—je haalt webpagina’s op, leest de HTML uit en filtert precies die info die je zoekt.

Zie het als een digitale assistent die dag en nacht websites voor je doorspit, zonder ooit een koffiepauze te nemen. De meest gescrapete data door bedrijven? Prijsinformatie, productdetails, contactgegevens, reviews, afbeeldingen, nieuwsartikelen en zelfs huizenaanbod. Sommige sites bieden hiervoor een API, maar de meeste niet—of ze beperken wat je mag ophalen. Webscraping maakt het mogelijk om op grote schaal openbare data te verzamelen, zelfs als er geen “download”-knop te vinden is.

Waarom Python Webscraping Onmisbaar is voor Zakelijke Teams

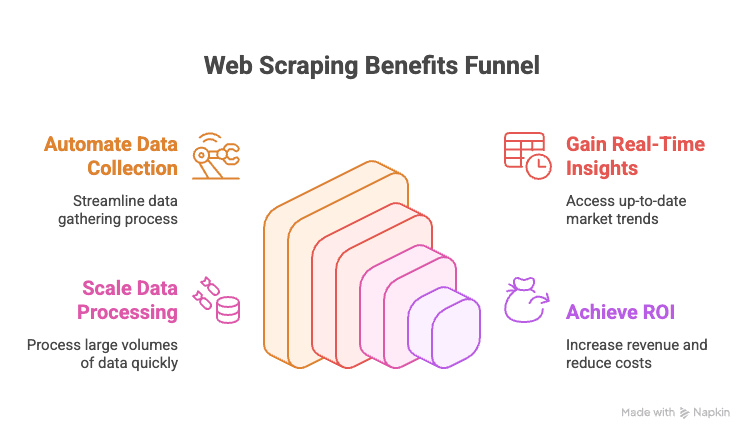

Eerlijk is eerlijk: als je in 2025 geen webscraping inzet, laat je kansen liggen. Waarom?

- Automatiseer handmatig datawerk: Nooit meer eindeloos kopiëren en plakken van concurrenten of bedrijvengidsen.

- Realtime inzichten: Altijd actuele prijzen, voorraad of markttrends bij de hand.

- Schaalbaarheid: Scrape duizenden pagina’s terwijl je je lunch opwarmt.

- Rendement: Bedrijven die datagedreven werken, realiseren .

Hier een overzicht van krachtige toepassingen:

| Afdeling | Voorbeeldtoepassing | Opgeleverde waarde |

|---|---|---|

| Sales | Leads verzamelen uit bedrijvengidsen, verrijken met e-mails | Grotere, beter getargete leadlijsten |

| Marketing | Prijzen, acties en reviews van concurrenten volgen | Slimmere campagnes, sneller schakelen |

| E-commerce | Productprijzen, voorraad en reviews monitoren | Dynamische prijzen, voorraadalerts |

| Operations | Leveranciersdata bundelen, rapportages automatiseren | Tijdbesparing, minder fouten |

| Vastgoed | Woningen van meerdere sites verzamelen | Meer aanbod, snellere klantreactie |

Kortom: webscraping is het geheime wapen voor snellere, slimmere en scherpere bedrijfsbeslissingen.

Overzicht: Alle Belangrijke Python Webscraping Libraries (Met Codevoorbeelden)

Zoals beloofd: een compleet overzicht. Python heeft een enorme verzameling libraries voor webscraping—van simpele downloads tot volledige browserautomatisering. Hier de belangrijkste, met codevoorbeelden:

urllib en urllib3: De Basis voor HTTP-verzoeken

Dit zijn de standaardtools van Python om HTTP-verzoeken te doen. Ze zijn vrij basic, wat omslachtig, maar betrouwbaar voor eenvoudige klussen.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # HTTP status code

6print(response.data[:100]) # eerste 100 bytes van de inhoudHandig als je geen extra afhankelijkheden wilt of volledige controle nodig hebt. Maar voor de meeste taken is requests gebruiksvriendelijker.

requests: De Populairste Python Webscraping Library

Als Python scraping een mascotte had, was het de requests library. Simpel, krachtig en regelt al het HTTP-werk voor je.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # geparste JSON-inhoud (als de response JSON is)Waarom zo populair? Het regelt cookies, sessies, redirects en meer—zodat jij je kunt focussen op de data. Let op: requests haalt alleen de HTML op. Om data eruit te halen, heb je een parser zoals BeautifulSoup nodig.

BeautifulSoup: Eenvoudig HTML Parsen en Data Extractie

BeautifulSoup is dé favoriet voor HTML-parsing in Python. Vergevingsgezind, makkelijk te leren en werkt perfect samen met requests.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"Ideaal voor kleine tot middelgrote projecten of als je net begint. Voor grote datasets of complexe queries kun je beter overstappen op lxml.

lxml en XPath: Snel en Krachtig HTML/XML Parsen

Heb je snelheid nodig of wil je XPath gebruiken (een querytaal voor XML/HTML), dan is lxml jouw tool.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")Met XPath kun je heel gericht data ophalen. lxml is snel en efficiënt, maar de leercurve is wat steiler dan bij BeautifulSoup.

Scrapy: Het Framework voor Grote Web Crawls

Scrapy is de zwaargewicht voor grote scrapingprojecten. Het is een compleet framework—denk aan Django, maar dan voor webscraping.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }Scrapy regelt asynchrone requests, volgt links, beheert pipelines en exporteert data in verschillende formaten. Voor kleine scripts is het wat veel, maar voor duizenden pagina’s is het onovertroffen.

Selenium, Playwright en Pyppeteer: Scrapen van Dynamische Websites

Als een site data laadt via JavaScript, heb je browserautomatisering nodig. Selenium en Playwright zijn hier de bekendste namen.

Selenium Voorbeeld:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Playwright Voorbeeld:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")Deze tools kunnen alles aan wat een mens ook kan, maar zijn trager en zwaarder dan puur HTTP-scrapen. Gebruik ze alleen als het echt nodig is.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML: Andere Handige Tools

-

MechanicalSoup: Automatiseert formulieren en navigatie, gebouwd op Requests en BeautifulSoup.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser: Lijkt op MechanicalSoup, maar wordt minder actief onderhouden.

-

PyQuery: HTML-parsing in jQuery-stijl.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML: Combineert HTTP-verzoeken, parsing en zelfs JavaScript-rendering.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

Handig als je snel formulieren, CSS-selectors of lichte JS-rendering wilt aanpakken.

Asyncio en Aiohttp: Python Webscraping Versnellen

Voor honderden of duizenden pagina’s is synchroon scrapen te traag. Met aiohttp en asyncio kun je gelijktijdig scrapen.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))Hiermee kun je tientallen pagina’s tegelijk ophalen en je scraping flink versnellen.

Gespecialiseerde Libraries: PRAW (Reddit), PyPDF2 en Meer

-

PRAW: Voor het scrapen van Reddit via de API.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2: Tekst uit PDF’s halen.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

Overige: Er zijn libraries voor Instagram, Twitter, OCR (Tesseract) en meer. Voor bijna elke datasoort is er wel een Python-library te vinden.

Vergelijkingstabel: Python Scraping Libraries

| Tool / Library | Gebruiksgemak | Snelheid & Schaal | Ideaal voor |

|---|---|---|---|

| Requests + BeautifulSoup | Makkelijk | Gemiddeld | Beginners, statische sites, snelle scripts |

| lxml (met XPath) | Gemiddeld | Snel | Grote volumes, complexe parsing |

| Scrapy | Moeilijk | Zeer snel | Enterprise, grote crawls, pipelines |

| Selenium / Playwright | Gemiddeld | Traag | JavaScript-rijke, interactieve sites |

| aiohttp + asyncio | Gemiddeld | Zeer snel | Hoge volumes, vooral statische pagina’s |

| MechanicalSoup | Makkelijk | Gemiddeld | Logins, formulieren, sessiebeheer |

| PyQuery | Gemiddeld | Snel | CSS-selector fans, DOM-manipulatie |

| Requests-HTML | Makkelijk | Variabel | Kleine klussen, lichte JS-rendering |

Stappenplan: Zelf een Python Webscraper Bouwen (Met Voorbeeld)

Laten we een praktijkvoorbeeld nemen: productlijsten scrapen van een (fictieve) e-commerce site, inclusief paginering en export naar CSV.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")Wat gebeurt hier?

- Doorloopt pagina’s, haalt HTML op, filtert producten, verzamelt naam en prijs, en stopt als er geen producten meer zijn.

- Exporteert de resultaten naar CSV voor eenvoudige analyse.

Wil je liever naar Excel exporteren? Gebruik pandas:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)Formulieren, Logins en Sessies Afhandelen in Python Webscraping

Veel sites vereisen een login of formulier. Zo pak je dat aan:

Met requests en een sessie:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")Met MechanicalSoup:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()Sessies zorgen ervoor dat je ingelogd blijft terwijl je meerdere pagina’s scrapt.

Dynamische Content en JavaScript-Pagina’s Scrapen

Staat de data niet in de HTML (view source laat lege divs zien), dan heb je browserautomatisering nodig.

Selenium Voorbeeld:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceOf, als je het API-endpoint vindt dat de JavaScript gebruikt, kun je met requests direct de JSON ophalen—dat is veel sneller.

Data Exporteren: CSV, Excel, Databases en Meer

-

CSV: Gebruik Python’s

csvmodule (zie hierboven). -

Excel: Gebruik pandas of openpyxl.

-

Google Sheets: Gebruik de

gspreadlibrary.1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

Databases: Gebruik

sqlite3,pymysql,psycopg2of SQLAlchemy voor SQL-databases. Voor NoSQL kun jepymongogebruiken voor MongoDB.

Python Webscraping vs. Moderne No-Code Oplossingen: Waarom Thunderbit in 2025 de Slimste Keuze is

Tijd voor de olifant in de kamer: onderhoud. Zelf scrapers bouwen is leuk—totdat je 100 verschillende sites moet scrapen, elk met hun eigen eigenaardigheden, en alles crasht vlak voor je deadline. Been there, done that, grijze haren rijker.

Daarom ben ik zo’n fan van . Dit is waarom het mijn favoriet is voor zakelijke gebruikers in 2025:

- Geen code nodig: Thunderbit biedt een visuele interface. Klik op “AI Velden Voorspellen”, pas de kolommen aan, druk op “Scrapen” en klaar. Geen Python, geen debugging, geen eindeloze Stack Overflow zoektochten.

- Schaalt naar duizenden pagina’s: Moet je 10.000 producten scrapen? Thunderbit’s cloud doet het voor je, zonder dat je scripts hoeft te monitoren.

- Geen onderhoud: Als je 100 concurrenten volgt voor e-commerce, is 100 Python-scripts onderhouden een ramp. Met Thunderbit kies of pas je een template aan, en de AI past zich automatisch aan bij layout-wijzigingen.

- Subpagina’s en paginering: Thunderbit volgt links naar subpagina’s, regelt paginering en kan zelfs extra data ophalen van productdetailpagina’s.

- Directe templates: Voor populaire sites (Amazon, Zillow, LinkedIn, enz.) zijn er kant-en-klare templates. Eén klik en je hebt je data.

- Gratis data-export: Exporteer naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

Kortom: ben je een zakelijke gebruiker die gewoon data wil? Thunderbit is als een persoonlijke databutler. Ben je een ontwikkelaar die graag sleutelt? Python blijft je speeltuin—maar soms wil je gewoon snel resultaat.

Best Practices voor Ethisch en Wettelijk Python Webscraping

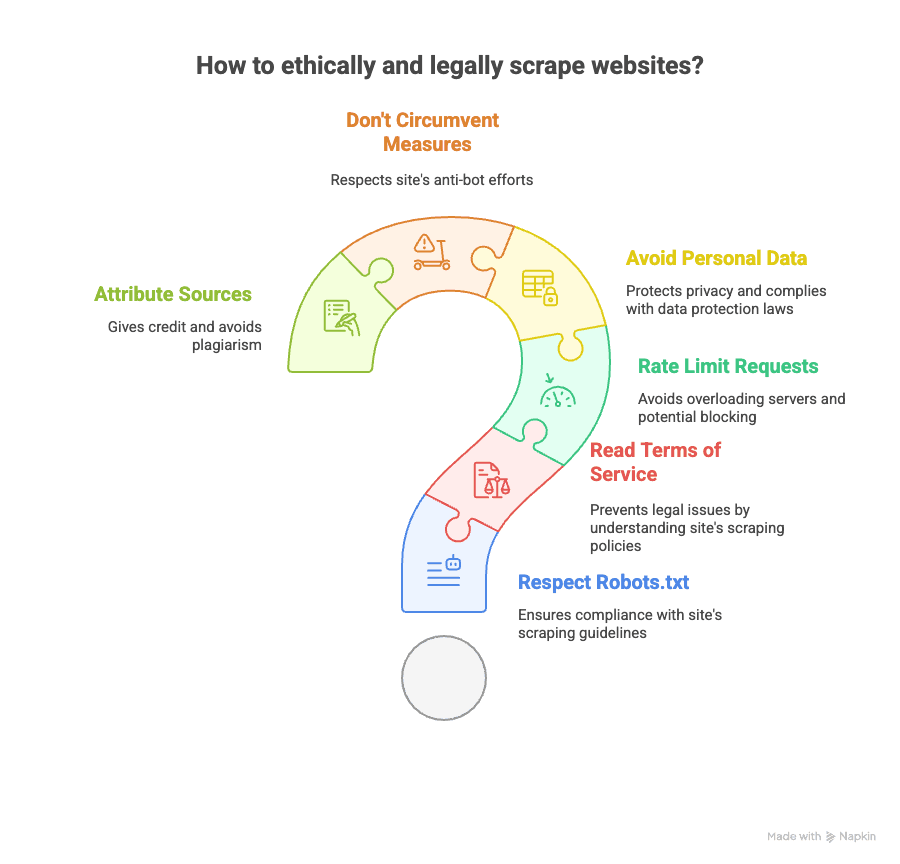

Webscraping is krachtig, maar brengt ook verantwoordelijkheid met zich mee. Zo blijf je netjes binnen de regels (en je karma):

- Check robots.txt: Respecteer wat een site wel en niet wil laten scrapen.

- Lees de gebruiksvoorwaarden: Sommige sites verbieden scraping expliciet. Overtreding kan leiden tot blokkades of zelfs juridische stappen.

- Rate limiting: Overbelast servers niet—bouw pauzes in tussen je verzoeken.

- Vermijd persoonsgegevens: Wees voorzichtig met het scrapen van e-mails, telefoonnummers of andere privacygevoelige data (denk aan AVG of CCPA).

- Omzeil geen anti-botmaatregelen: Als een site CAPTCHAs of zware blokkades gebruikt, denk dan goed na.

- Bronvermelding: Publiceer je analyses? Vermeld altijd waar je data vandaan komt.

Meer weten over de juridische kant? Lees deze en .

Meer Leren over Python Webscraping (Cursussen, Documentatie, Community’s)

Wil je verder de diepte in? Hier mijn favoriete bronnen:

- Officiële documentatie:

- Boeken:

- “Web Scraping with Python” van Ryan Mitchell

- “Automate the Boring Stuff with Python” van Al Sweigart

- Online gidsen:

- Video-tutorials:

- Corey Schafer’s YouTube-kanaal

- Community’s:

En natuurlijk: wil je zien hoe no-code scraping werkt? Bekijk het of de .

Samenvatting & Belangrijkste Inzichten: De Juiste Webscraping Oplossing Kiezen in 2025

- Python webscraping is enorm krachtig en flexibel. Houd je van code, wil je volledige controle en vind je onderhoud niet erg? Dan is dit een topkeuze.

- Voor elke scrapingbehoefte is er een Python-library—statische pagina’s, dynamische content, formulieren, API’s, PDF’s, noem maar op.

- Maar voor de meeste zakelijke gebruikers is het onderhouden van tientallen scripts een nachtmerrie. Wil je snel, op schaal en zonder technische kennis data verzamelen? Dan is de beste optie.

- Thunderbit’s AI-gedreven, no-code interface laat je elke website scrapen in een paar klikken, inclusief subpagina’s en paginering, en exporteert je data waar je maar wilt—zonder Python.

- Ethisch en wettelijk scrapen is belangrijk: Check altijd de regels van een site, respecteer privacy en scrape verantwoord.

Of je nu een Python-expert bent of gewoon snel data wilt zonder gedoe: de tools zijn in 2025 beter dan ooit. Mijn tip? Probeer beide aanpakken, kijk wat bij je past, en laat de robots het saaie werk doen—zolang ze zich maar netjes gedragen.

En ben je klaar met kapotte scripts? Probeer dan de . Je toekomstige zelf (en je koffievoorraad) zullen je dankbaar zijn.

Meer weten? Lees of voor praktische gidsen en de nieuwste scrapingstrategieën.