Laten we eerlijk zijn: niemand springt ’s ochtends uit bed met zin om handmatig 500 rijen productprijzen in een spreadsheet te plakken. (Mocht jij dat wél leuk vinden, petje af – en vergeet die polsbrace niet!) Of je nu in sales, operations of gewoon bezig bent om je bedrijf een stapje voor te blijven, je hebt vast wel eens zitten stoeien met het verzamelen van data van websites. Webdata is tegenwoordig onmisbaar en de vraag naar geautomatiseerde extractie groeit als kool—.

Na jaren in de SaaS- en automatiseringshoek heb ik alles wel voorbij zien komen: van heldhaftige Excel-macro’s tot Python-scripts die midden in de nacht aan elkaar zijn geknoopt. In deze gids laat ik je stap voor stap zien hoe je met een Python html parser echte data van het web haalt (ja, we gaan samen IMDb-filmscores verzamelen). Ook ontdek je waarom er in 2025 een slimmere manier is—AI-tools zoals waarmee je zonder code direct inzichten uit webpagina’s haalt.

Wat is een HTML-parser en waarom zou je er één in Python gebruiken?

Laten we bij het begin beginnen: wat doet een html parser eigenlijk? Zie het als je persoonlijke bibliothecaris voor het web. Zo’n parser leest de chaotische HTML-code van een webpagina en zet die om in een overzichtelijke boomstructuur. Zo kun je precies de data eruit vissen die je nodig hebt—titels, prijzen, links—zonder te verdwalen tussen de haakjes en divs.

Python is dé taal voor deze klus, en dat is niet voor niets. Het is lekker leesbaar, makkelijk te leren en heeft een enorme verzameling libraries voor webscraping en parsing. , dankzij de lage instapdrempel en actieve community.

De bekendste Python HTML-parsers

Dit zijn de belangrijkste libraries die je tegenkomt als je met een python html parser aan de slag gaat:

- BeautifulSoup: De klassieker, ideaal voor beginners.

- lxml: Supersnel en krachtig, met geavanceerde zoekmogelijkheden.

- html5lib: Kan zelfs de meest rommelige HTML aan, net als je browser.

- PyQuery: Hiermee kun je jQuery-achtige selectors in Python gebruiken.

- HTMLParser: De ingebouwde parser van Python—altijd beschikbaar, maar vrij basic.

Elke library heeft z’n eigen karakter, maar ze helpen allemaal om ruwe HTML om te zetten in gestructureerde data.

Belangrijke toepassingen: Hoe bedrijven profiteren van Python HTML-parsers

Webdata verzamelen is allang niet meer alleen voor techneuten of data scientists. Het is een kernactiviteit geworden, vooral in sales en operations. Waarom? Kijk maar:

| Toepassing (sector) | Typische data | Zakelijk resultaat |

|---|---|---|

| Prijsmonitoring (retail) | Prijzen van concurrenten, voorraadniveaus | Dynamische prijzen, betere marges (bron) |

| Concurrentieanalyse | Productlijsten, reviews, beschikbaarheid | Kansen ontdekken, leads genereren (bron) |

| Leadgeneratie (B2B sales) | Bedrijfsnamen, e-mails, contactpersonen | Automatisch prospects vinden, pipeline laten groeien (bron) |

| Marktsentiment (marketing) | Social posts, reviews, ratings | Directe feedback, trends signaleren (bron) |

| Vastgoeddata verzamelen | Aanbod, prijzen, makelaarsinfo | Marktanalyse, prijsstrategie (bron) |

| Recruitment intelligence | Kandidatenprofielen, salarissen | Talent vinden, salarisbenchmarks (bron) |

Kortom: als je nog steeds handmatig data overtypt, laat je tijd én geld liggen.

De Python HTML-parser toolkit: Populaire libraries vergeleken

Tijd om praktisch te worden. Hier een overzicht van de populairste python html parser libraries, zodat je snel de juiste kiest:

| Library | Gebruiksgemak | Snelheid | Flexibiliteit | Onderhoud | Ideaal voor |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Gemiddeld | Beginners, rommelige HTML |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Gemiddeld | Snelheid, XPath, grote documenten |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Laag | Browser-achtige parsing, kapotte HTML |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Gemiddeld | jQuery-fans, CSS-selectors |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Laag | Simpele, ingebouwde taken |

BeautifulSoup: De ideale start voor beginners

BeautifulSoup is de “hello world” van HTML-parsing. De syntax is logisch, de documentatie is duidelijk en het werkt zelfs met slecht opgebouwde HTML (). Nadeel: het is niet de snelste, zeker niet bij grote of complexe pagina’s, en ondersteunt standaard geen geavanceerde selectors zoals XPath.

lxml: Supersnel en krachtig

Wil je snelheid of XPath-queries gebruiken, dan is lxml jouw beste vriend (). Het is gebouwd op C-libraries, dus razendsnel, maar de installatie kan wat lastiger zijn en de leercurve is steiler.

Andere opties: html5lib, PyQuery en HTMLParser

- html5lib: Parseert HTML net als je browser—ideaal voor rommelige of afwijkende markup, maar wel traag ().

- PyQuery: Hiermee kun je jQuery-achtige selectors in Python gebruiken, handig als je uit de front-end wereld komt ().

- HTMLParser: De ingebouwde optie van Python—snel en altijd beschikbaar, maar minder uitgebreid qua functies.

Stap 1: Je Python HTML-parser omgeving opzetten

Voordat je kunt gaan parsen, moet je Python goed instellen. Zo pak je dat aan:

-

Installeer Python: Download via als je het nog niet hebt.

-

Installeer pip: Zit meestal bij Python 3.4+ inbegrepen, maar check met

pip --versionin je terminal. -

Installeer de libraries (voor deze tutorial gebruiken we BeautifulSoup en requests):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4is de parser.requestshaalt webpagina’s op.lxmlis een snelle parser die BeautifulSoup kan gebruiken.

-

Controleer je installatie:

1python -c "import bs4, requests, lxml; print('All good!')"

Tips bij problemen:

- Krijg je permissiefouten? Probeer

pip install --user ... - Op Mac/Linux heb je soms

python3enpip3nodig. - Zie je “ModuleNotFoundError”? Controleer je spelling en Python-omgeving.

Stap 2: Je eerste webpagina parsen met Python

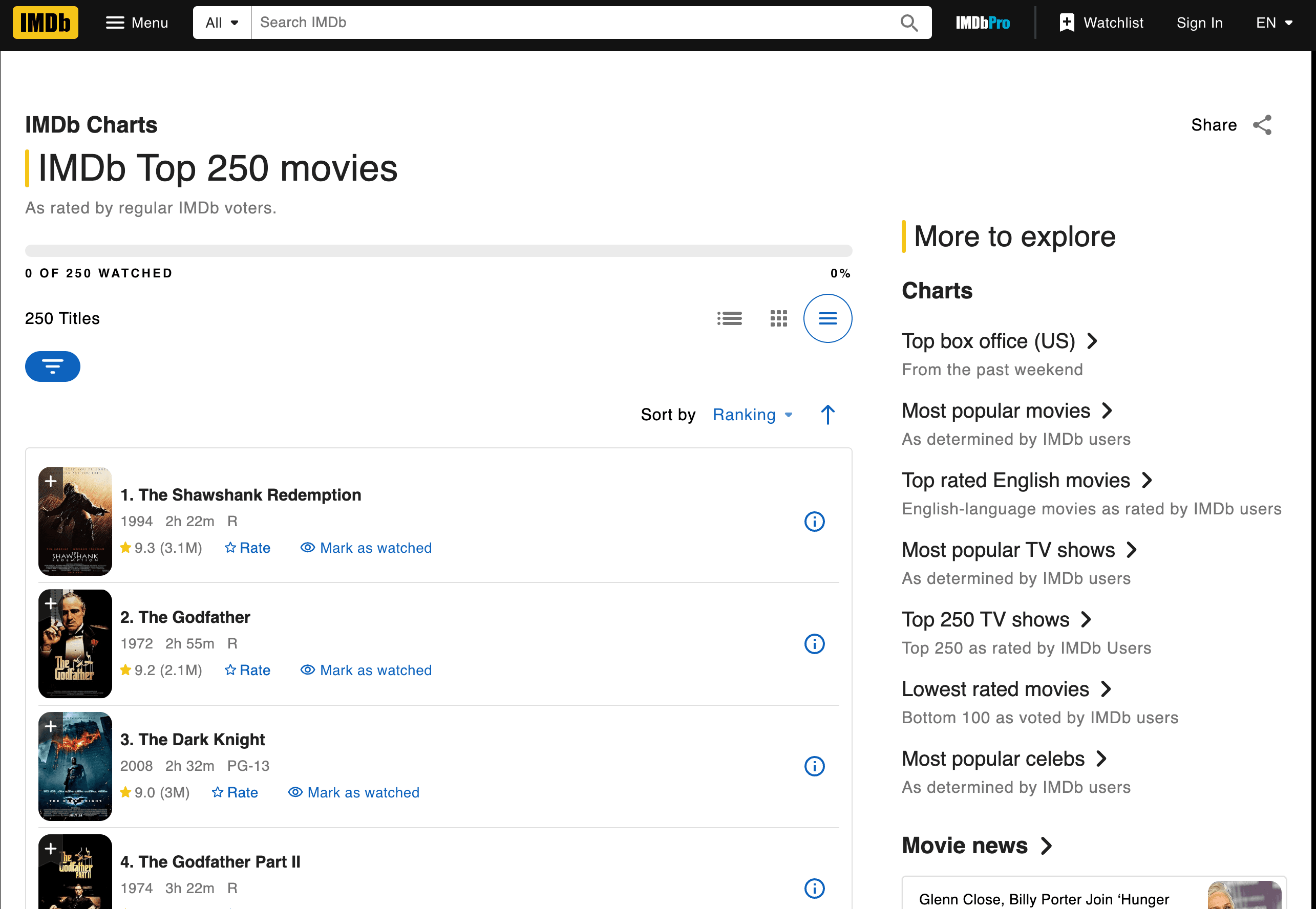

Tijd om aan de slag te gaan: we gaan de Top 250-films van IMDb scrapen. We halen de titels, jaartallen en scores op.

Pagina ophalen en parsen

Hier een voorbeeldscript:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Zoek alle cellen met titels en scores

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Doorloop de eerste 3 films als voorbeeld

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Rating: {rating}")Wat gebeurt er hier?

- Met

requests.get()halen we de pagina op. BeautifulSoupverwerkt de HTML.- We zoeken de juiste

<td>-elementen op basis van hun class. - We halen de tekst voor titel, jaar en score eruit.

Uitvoer:

11. The Shawshank Redemption (1994) -- Rating: 9.3

22. The Godfather (1972) -- Rating: 9.2

33. The Dark Knight (2008) -- Rating: 9.0Data extraheren: Titels, scores en meer vinden

Hoe wist ik welke tags en classes ik moest gebruiken? Door de HTML van de IMDb-pagina te inspecteren (rechtsklik > Element inspecteren in je browser). Zoek naar patronen—hier staat elke film in een <td class="titleColumn"> en de scores in <td class="ratingColumn imdbRating"> ().

Tip: Ga je een andere site scrapen? Begin altijd met het inspecteren van de HTML-structuur en zoek naar unieke class-namen of tags.

Resultaten opslaan en exporteren

Zo sla je de data op in een CSV-bestand:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Title', 'Year', 'Rating'])

13 writer.writerows(movies)Schoonmaaktips:

- Gebruik

.strip()om witruimte te verwijderen. - Controleer op ontbrekende data met

if-checks. - Voor export naar Excel kun je het CSV-bestand openen in Excel of met

pandasdirect een.xlsx-bestand maken.

Stap 3: Omgaan met HTML-wijzigingen en onderhoud

Nu wordt het spannend. Websites veranderen regelmatig hun opmaak—soms lijkt het wel alsof ze webscrapers willen dwarsbomen. Als IMDb bijvoorbeeld class="titleColumn" wijzigt naar class="movieTitle", geeft je script ineens lege resultaten. Geloof me, ik heb het vaak meegemaakt.

Als je script breekt: Praktische problemen

Veelvoorkomende issues:

- Selector niet gevonden: Je code vindt het opgegeven tag/class niet.

- Lege resultaten: De structuur van de pagina is veranderd, of de inhoud wordt nu via JavaScript geladen.

- HTTP-fouten: De site heeft anti-botmaatregelen toegevoegd.

Zo los je het op:

- Controleer of de HTML die je verwerkt overeenkomt met wat je in de browser ziet.

- Pas je selectors aan op de nieuwe structuur.

- Wordt de inhoud dynamisch geladen? Dan heb je misschien een browser-automation tool (zoals Selenium) of een API nodig.

Het echte probleem? Als je 10, 50 of 500 verschillende sites scraped, ben je meer tijd kwijt aan het repareren van scripts dan aan het analyseren van data ().

Stap 4: Schalen—De verborgen kosten van handmatig Python HTML-parsen

Stel, je wilt niet alleen IMDb scrapen, maar ook Amazon, Zillow, LinkedIn en nog een dozijn andere sites. Voor elke site heb je een apart script nodig. En elke keer dat een site verandert, moet je weer aan de bak.

De verborgen kosten:

- Onderhoud: .

- Infrastructuur: Je hebt proxies, foutafhandeling en monitoring nodig.

- Performance: Schalen betekent omgaan met limieten, gelijktijdigheid en meer.

- Kwaliteitscontrole: Meer scripts = meer kans op fouten.

Voor niet-technische teams is dit al snel niet meer te doen. Het is alsof je een team van stagiairs inhuurt om de hele dag data te kopiëren—alleen zijn de stagiairs nu Python-scripts die “ziek” zijn zodra een website verandert.

Verder dan Python HTML-parsers: Maak kennis met Thunderbit, de AI-oplossing

Nu wordt het interessant. Wat als je geen code meer hoeft te schrijven, geen onderhoud meer hebt, en altijd de data krijgt die je zoekt—ongeacht hoe de website verandert?

Dat is precies wat we met hebben gebouwd. Het is een AI-webscraper Chrome-extensie waarmee je met twee klikken gestructureerde data van elke website haalt. Geen Python, geen scripts, geen gedoe.

Python HTML-parsers vs. Thunderbit: Vergelijking

| Aspect | Python HTML-parsers | Thunderbit (zie prijzen) |

|---|---|---|

| Installatie | Veel werk (installeren, coderen, debuggen) | Snel (extensie installeren, klikken) |

| Gebruiksgemak | Vereist programmeerkennis | Geen code—wijzen en klikken |

| Onderhoud | Veel (scripts breken vaak) | Weinig (AI past zich automatisch aan) |

| Schaalbaarheid | Complex (scripts, proxies, infrastructuur) | Ingebouwd (cloud scraping, batchverwerking) |

| Data verrijken | Handmatig (meer code schrijven) | Ingebouwd (labelen, opschonen, vertalen, subpagina’s) |

Waarom zelf bouwen als AI het voor je kan oplossen?

Waarom kiezen voor AI bij webdata-extractie?

Thunderbit’s AI-agent leest de pagina, snapt de structuur en past zich aan als er iets verandert. Het is alsof je een superstagiair hebt die nooit slaapt en nooit moppert over veranderende class-namen.

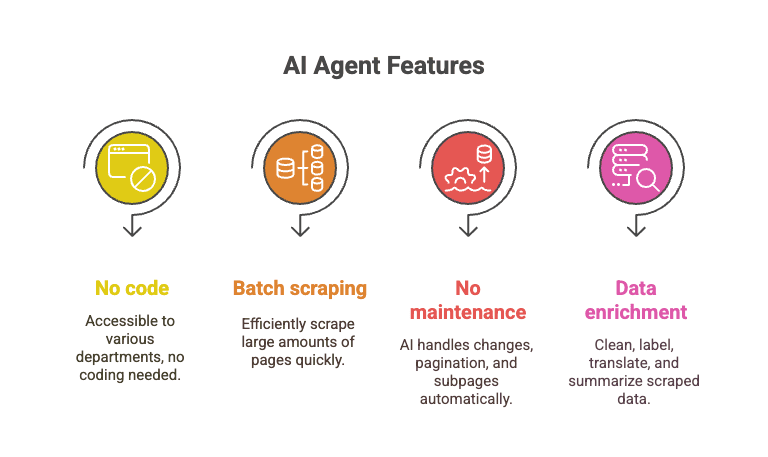

- Geen code nodig: Iedereen kan ermee werken—sales, operations, marketing, noem maar op.

- Batch scraping: Haal 10.000+ pagina’s binnen terwijl je met één Python-script nog aan het debuggen bent.

- Geen onderhoud: De AI regelt layout-wijzigingen, paginering, subpagina’s en meer.

- Data verrijken: Data direct opschonen, labelen, vertalen en samenvatten tijdens het scrapen.

Stel je voor: je haalt alle Top 250-films van IMDb én alle detailpagina’s en reviews binnen een paar klikken binnen—terwijl je Python-script nog vastloopt op regel 12 met een “NoneType”-fout.

Stapsgewijs: IMDb-filmscores scrapen met Thunderbit

Zo werkt het met Thunderbit:

- Installeer de .

- Ga naar de .

- Klik op het Thunderbit-icoon.

- Klik op “AI Suggest Fields.” Thunderbit leest de pagina en stelt kolommen voor (Titel, Jaar, Score).

- Controleer of pas de kolommen aan indien nodig.

- Klik op “Scrape.” Thunderbit haalt direct alle 250 rijen op.

- Exporteer naar Excel, Google Sheets, Notion of CSV—wat jij wilt.

Dat is alles. Geen code, geen debugging, geen “waarom is deze lijst leeg?”-momenten.

Wil je het in actie zien? Bekijk de voor demo’s, of lees onze voor een ander praktijkvoorbeeld.

Conclusie: Kies het juiste gereedschap voor jouw webdata

Python html parser libraries zoals BeautifulSoup en lxml zijn krachtig, flexibel en gratis. Ideaal voor ontwikkelaars die alles zelf willen regelen en niet bang zijn voor wat code. Maar ze vragen om technische kennis, doorlopend onderhoud en brengen verborgen kosten met zich mee—vooral als je grootschalig wilt scrapen.

Voor zakelijke gebruikers, sales-teams en iedereen die gewoon snel data wil (zonder code), zijn AI-tools zoals een verademing. Je kunt webdata op grote schaal verzamelen, opschonen en verrijken—zonder programmeren en zonder onderhoud.

Mijn tip? Gebruik Python als je graag codeert en alles zelf wilt aanpassen. Maar als je je tijd (en je geduld) waardeert, probeer dan Thunderbit. Waarom scripts bouwen en onderhouden als AI het zware werk voor je doet?

Meer leren over webscraping, data-extractie en AI-automatisering? Bekijk meer tutorials op de , zoals of .