De eerste keer dat ik iemand urenlang zag zwoegen om data van een website handmatig over te zetten naar een spreadsheet, vergeet ik nooit meer. Het voelde alsof je met een eetstokje een zwembad probeert leeg te scheppen. Inmiddels is procesautomatisering niet meer weg te denken—vooral als het gaat om webscraping. Maar nu steeds meer teams die saaie klusjes willen automatiseren, komt er een nieuwe vraag bovendrijven: Ga je voor de vertrouwde RPA (Robotic Process Automation) of kies je meteen voor AI-agents en een AI-webscraper?

Werk je in sales, e-commerce of operations? Dan herken je deze twijfel vast wel. De cijfers zijn duidelijk: , en nog eens 19% is van plan dat binnenkort te doen. Tegelijkertijd winnen AI-agents en AI-webscrapers snel terrein, want zij beloven zelfs de meest lastige en veranderlijke websites met een paar klikken te verwerken. Maar hoe maak je de juiste keuze? Laten we samen induiken wat procesautomatisering nu echt betekent, hoe RPA en AI-agents van elkaar verschillen, en waarom de toekomst van webscraping steeds meer lijkt op de AI-aanpak van .

Procesautomatisering uitgelegd: wat houdt het precies in?

Laten we bij het begin beginnen: procesautomatisering betekent simpelweg “laat software het saaie werk doen.” Zie het als de automatische wasstraat voor bedrijven—machines nemen de herhalende, handmatige taken over zodat mensen zich kunnen focussen op werk waar echt denkwerk bij komt kijken (of gewoon een goede bak koffie).

In het bedrijfsleven draait procesautomatisering om het stroomlijnen van dagelijkse processen, het verminderen van fouten en het vrijmaken van tijd voor je team. Bij webscraping betekent het dat je tools inzet om data van websites te verzamelen—denk aan productprijzen, contactgegevens of reviews—zonder dat je zelf elke pagina hoeft door te klikken. In plaats van urenlang kopiëren en plakken, stel je een digitale “robot” of agent in die het werk voor je doet. Het is net als een automatische e-mailbeantwoorder, maar dan voor het hele internet.

De voordelen zijn overduidelijk: . En uit eigen ervaring met het bouwen van SaaS- en automatiseringsproducten kan ik zeggen: als je webscraping eenmaal automatiseert, wil je nooit meer terug naar handmatig werk.

RPA uitgelegd: wat is Robotic Process Automation?

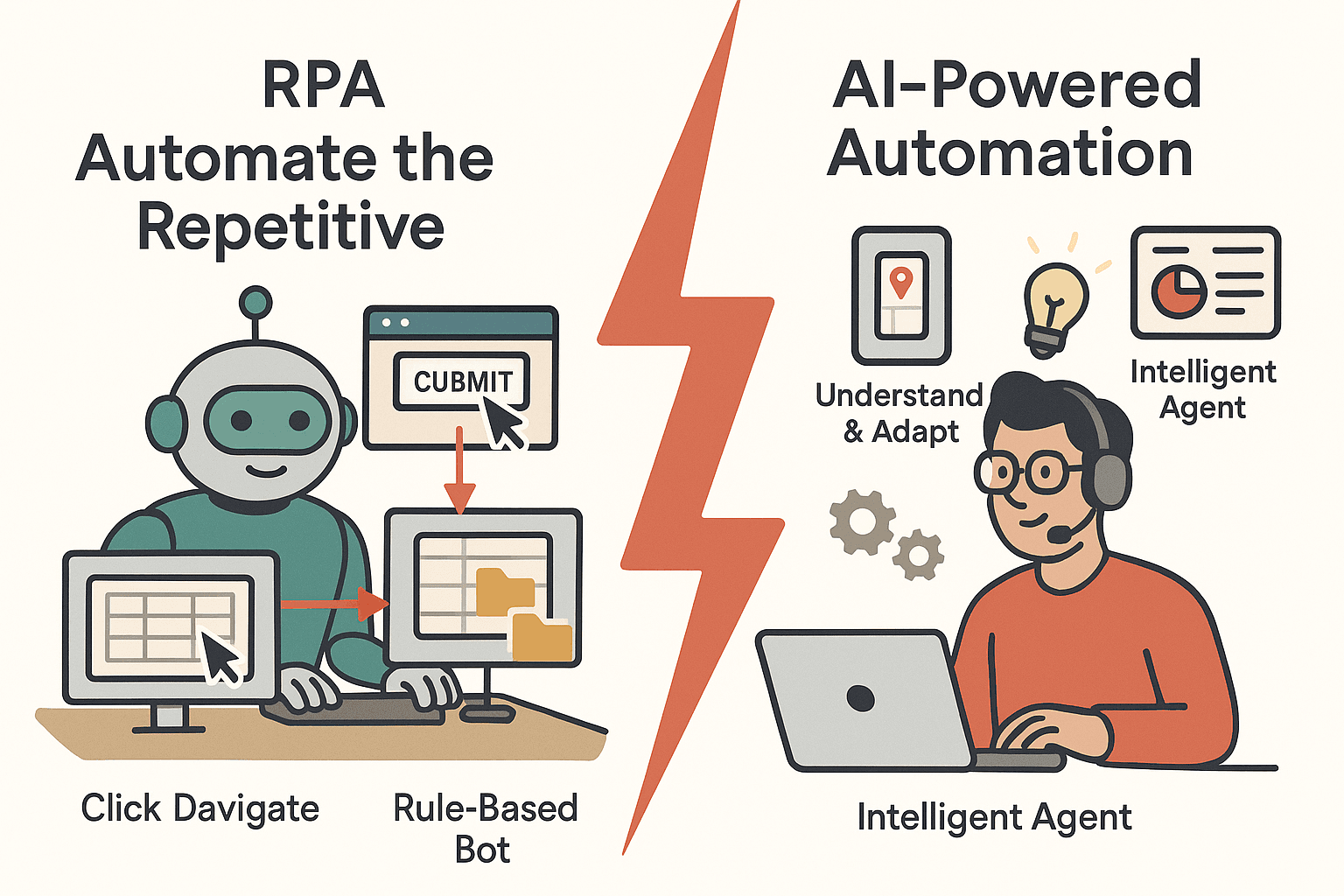

Robotic Process Automation (RPA) is de klassieker onder de procesautomatisering. RPA gebruikt software “robots” die menselijke handelingen op een computer nadoen—denk aan klikken, websites doorlopen, data kopiëren en plakken tussen applicaties. Deze bots volgen strikte, op regels gebaseerde instructies en zijn ideaal voor herhalende, gestructureerde taken.

Typische RPA-toepassingen bij webscraping

- Inloggen op een website en data uit specifieke velden halen

- Gegevens van webformulieren naar interne databases kopiëren

- Op geplande tijden rapporten downloaden van webportalen

RPA is een echte krachtpatser in sectoren als finance, e-commerce en operations. Zo kan een retailer RPA inzetten om elke nacht prijzen van concurrenten te verzamelen, of een financieel team om spreadsheets bij te werken met de laatste beurskoersen.

Sterke punten van RPA

- Betrouwbaarheid: Bots worden niet moe en maken geen typefouten. Ze werken 24/7 en zijn .

- Compliance: Elke stap wordt vastgelegd, wat audits eenvoudig maakt.

- Snel inzetbaar: Voor simpele, herhalende taken is RPA snel op te zetten—zonder ingewikkelde integraties.

Beperkingen van RPA

Maar er zit een addertje onder het gras: RPA is streng in de leer. Als een website zijn indeling aanpast, kan de bot vastlopen. Het is alsof je iemand leert autorijden door elke bocht uit het hoofd te laten leren—maar als de weg verandert, zijn ze de weg kwijt. RPA heeft moeite met:

- Dynamische content: Oneindig scrollen, pop-ups of veranderende layouts vragen om extra logica en onderhoud.

- Ongestructureerde data: Staat de data niet altijd op dezelfde plek, dan raakt RPA in de war.

- Onderhoud: .

Kortom: RPA is ideaal voor vaste, voorspelbare taken, maar niet het meest flexibele gereedschap.

Maak kennis met de nieuwkomer: wat is een AI-agent?

Hier komt de AI-agent—een slimme krachtpatser die zich razendsnel aanpast. In webscraping is een AI-agent een zelfstandig programma dat een doel krijgt (“haal alle productnamen en prijzen van deze site”) en zelf uitzoekt hoe dat te bereiken.

Hoe AI-agents verschillen van RPA

- Leren en aanpassen: AI-agents gebruiken machine learning en natuurlijke taalverwerking om te begrijpen, beslissen en handelen. Ze kunnen omgaan met ongestructureerde data, leren van nieuwe patronen en hun aanpak aanpassen.

- Contextueel begrip: In plaats van strikte regels te volgen, interpreteren AI-agents de inhoud van webpagina’s—ze herkennen patronen, begrijpen context en kunnen zelfs afbeeldingen of vrije tekst verwerken.

- Instructies in gewone taal: Vaak kun je een AI-agent gewoon in het Nederlands vertellen wat je wilt, en hij bedenkt zelf de stappen.

Zie RPA als een nauwkeurige administratief medewerker die alles volgens het boekje doet, terwijl een AI-agent meer lijkt op een slimme assistent die kan improviseren en zich aanpast aan nieuwe situaties.

De AI-webscraper: de volgende stap

AI-webscrapers gaan nog verder. Ze gebruiken geavanceerde modellen om automatisch data-velden te herkennen, paginering en oneindig scrollen te verwerken, en zelfs data van subpagina’s te halen—met minimale instellingen. Tools als lopen hierin voorop en maken procesautomatisering toegankelijk voor iedereen, niet alleen voor ontwikkelaars.

Procesautomatisering voor webscraping: waarom is het belangrijk?

Waarom zou je webscraping automatiseren? Omdat handmatig data verzamelen traag, foutgevoelig en niet schaalbaar is. Automatisering levert:

- Tijdbesparing: Bots kunnen honderden pagina’s in enkele minuten scrapen—wat vroeger dagen of weken kostte.

- Kostenbesparing: als je handmatig werk vervangt door automatisering.

- Nauwkeurigheid: Automatisering zorgt voor consistente, foutloze data.

- Schaalbaarheid: Geautomatiseerde scrapers kunnen duizenden producten of miljoenen records aan.

- Concurrentievoordeel: Snellere, actuele data betekent betere beslissingen en sneller reageren.

Hieronder een overzicht van veelvoorkomende webscraping-toepassingen en de voordelen van automatisering:

| Webscraping-toepassing | Wat wordt verzameld & waarom | Voordeel van automatisering |

|---|---|---|

| Concurrentieprijsmonitoring | Productprijzen, voorraad | Direct inzicht in prijzen, bespaart uren handmatig werk |

| Leadgeneratie | Namen, e-mails, telefoons | Vult sales pipeline 24/7, geeft verkopers meer tijd voor verkoop |

| Marktonderzoek | Reviews, beoordelingen | Snel meningen verzamelen, trends ontdekken |

| Productcatalogus samenstellen | Productdetails | Houdt databases actueel, versnelt time-to-market |

| Vastgoedaanbod | Prijzen, locaties | Dagelijkse marktinzichten, uitgebreide rapportages |

| Financiële data-extractie | Koersen, rapporten | Real-time updates, schaalbaar naar duizenden datapunten |

| Compliance monitoring | Merknamen, beleid | Consistente controle, directe meldingen, audit trails |

Kortom: .

RPA versus AI-agent: hoe automatiseren ze webscraping?

Hoe pakken RPA en AI-agents webscraping in de praktijk aan? Hier een vergelijking:

| Stap | RPA-aanpak | AI-agent-aanpak |

|---|---|---|

| Initiële setup | Gebruiker neemt elke handeling op, definieert velden | Gebruiker geeft URL en beschrijft gewenste data; AI herkent velden automatisch |

| Flexibiliteit | Kwetsbaar—breekt bij sitewijzigingen | Adaptief—kan omgaan met layoutwijzigingen, nieuwe patronen |

| Gestructureerde data | Werkt goed | Werkt goed |

| Ongestructureerde data | Moeilijk | Uitstekend—kan tekst, afbeeldingen, context verwerken |

| Paginering/scrollen | Vereist expliciete scripts | Herkent en verwerkt automatisch |

| Onderhoud | Hoog—elke wijziging vereist updates | Laag—AI past zich aan kleine wijzigingen aan |

| Technische kennis nodig | Gemiddeld—vereist setup | Laag—geen code, gewoon in natuurlijke taal |

| Schaalbaarheid | Beperkt door botlicenties | Cloud-native, eenvoudig op te schalen |

Wanneer blinkt welke uit?

- RPA is ideaal bij stabiele, voorspelbare websites met gestructureerde data—denk aan interne portalen of legacy-systemen.

- AI-agents zijn perfect voor dynamische, rommelige of vaak veranderende websites, of als je team niet technisch is.

RPA voor webscraping: de traditionele aanpak

Een praktijkvoorbeeld: met RPA (zoals UiPath of Automation Anywhere) doe je het volgende:

- Je neemt je handelingen op: browser openen, inloggen, door pagina’s klikken, data kopiëren.

- De bot speelt deze acties af, herhaalt ze en zet de data in je spreadsheet of database.

Veelvoorkomende uitdagingen:

- Websitewijzigingen: Een nieuwe banner of knopnaam kan de bot laten vastlopen.

- Paginering: Oneindig scrollen of “Laad meer”-knoppen vereisen extra scripting.

- Dynamische content: Bots moeten wachten tot content geladen is.

- Anti-botmaatregelen: CAPTCHAs en IP-blokkades kunnen RPA stoppen.

- Schaalbaarheid: Veel bots tegelijk draaien wordt snel duur en complex.

RPA werkt goed voor interne, voorspelbare sites—maar voor het open web kan het veel onderhoud vragen.

AI-webscraper: de nieuwe generatie procesautomatisering

Hoe pakt een AI-webscraper dezelfde klus aan?

- Open de website, klik op “AI Suggest Fields” en laat de AI de pagina scannen.

- De AI stelt een tabel voor met data die het kan verzamelen—productnamen, prijzen, beoordelingen, enz.

- Je past de suggesties aan of accepteert ze, en klikt op “Scrapen.”

- De AI-agent regelt automatisch paginering, volgt subpagina’s en exporteert de data naar Excel, Google Sheets, Airtable of Notion.

Belangrijkste voordelen:

- Minimale setup: Geen code, geen handmatig taggen—gewoon aangeven wat je wilt.

- Verwerkt subpagina’s en paginering: AI volgt automatisch links en knoppen.

- Slimme dataverwerking: AI kan data opschonen, formatteren en zelfs categoriseren tijdens het scrapen.

- Gebruiksvriendelijke export: Met één klik naar je favoriete tools.

Voor niet-technische gebruikers (en ook voor techneuten die hun tijd waarderen) is dit een enorme stap vooruit. Het is alsof je van een oude Nokia overstapt op een smartphone.

Thunderbit uitgelicht: AI-webscraper als AI-agent

Even over waar ik zelf in geloof (en waar ik heel wat nachten aan heb gewerkt): . Thunderbit is een AI-webscraper Chrome-extensie die zich ontwikkelt tot een volwaardige AI-agent voor webautomatisering. Ons doel? Webscraping zo makkelijk maken dat zelfs je oma het kan (en er misschien zelfs lol in krijgt).

Wat maakt Thunderbit uniek?

- AI Suggest Fields: Eén klik en de AI leest de pagina en stelt de beste kolommen voor om te scrapen.

- Subpagina-scraping: Thunderbit bezoekt automatisch subpagina’s (zoals productdetails) en verrijkt je datatabel—zonder extra instellingen.

- Paginering-detectie: Of het nu een “Volgende”-knop of oneindig scrollen is, Thunderbit’s AI herkent het en blijft scrapen.

- Directe data-export: Exporteer je data met één klik naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

- Geen code nodig: Alles is ontworpen voor zakelijke gebruikers, niet alleen voor developers.

- Cloud- of browserscraping: Kies voor scrapen in de cloud (snel, parallel) of in je eigen browser (ideaal voor ingelogde sites).

- Gratis AI-tools: Haal e-mails, telefoonnummers of afbeeldingen uit elke website met één klik.

- Geplande scraper: Stel terugkerende scrapes in met natuurlijke taal—“elke dag om 9 uur”—en Thunderbit regelt de rest.

Thunderbit is bedoeld als jouw “AI-webdata-assistent” in de browser. Het draait niet alleen om data scrapen—het gaat om het automatiseren van het hele proces, van extractie tot export, met zo min mogelijk gedoe. En we staan pas aan het begin. De toekomst is aan AI-agents die niet alleen het web lezen, maar er ook op kunnen handelen.

Wil je het proberen? .

De juiste tool kiezen: wanneer gebruik je RPA, AI-agent of beide?

Hoe kies je tussen RPA en AI-agents (zoals Thunderbit) voor je webscraping-automatisering? Hier een handig overzicht:

| Keuzefactor | RPA | AI-agent / AI-webscraper |

|---|---|---|

| Data is sterk gestructureerd en site is stabiel | ✅ | |

| Data is rommelig, ongestructureerd of site verandert vaak | ✅ | |

| Omgaan met dynamische content (oneindig scrollen, pop-ups) | ✅ | |

| Team heeft programmeerkennis/IT-skills | ✅ | ✅ |

| Team is niet-technisch | ✅ | |

| Compliance/audit vereist strikte, herhaalbare stappen | ✅ | |

| Snel opschalen of veel sites scrapen | ✅ | |

| Eenmalige of ad-hoc scraping | ✅ | |

| Doorlopende, herhalende processen | ✅ | ✅ |

| Sterke punten combineren | Hybride mogelijk | Hybride mogelijk |

Tip: Veel organisaties combineren beide aanpakken—RPA voor interne, gestructureerde workflows en AI-agents voor externe, dynamische webdata. De toekomst is hybride.

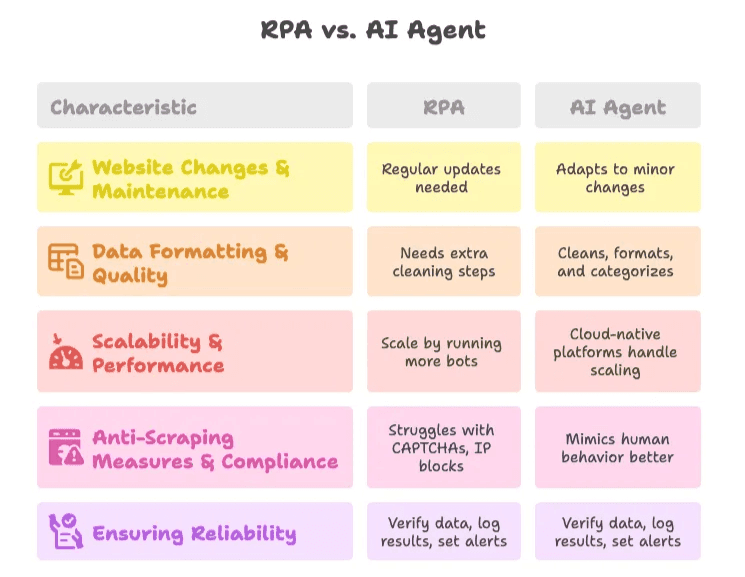

Veelvoorkomende uitdagingen bij webscraping-automatisering

1. Websitewijzigingen & onderhoud

- RPA: Vereist regelmatige updates bij sitewijzigingen. Gebruik modulaire scripts en monitoring om problemen snel te signaleren.

- AI-agent: Meer veerkrachtig—AI past zich aan kleine wijzigingen aan, maar controleer de resultaten regelmatig.

2. Dataformaat & kwaliteit

- RPA: Voeg extra stappen toe voor datacleaning, of koppel met scripts/Excel.

- AI-agent: AI kan data tijdens het scrapen opschonen, formatteren en zelfs categoriseren. Gebruik veldspecifieke prompts voor het beste resultaat.

3. Schaalbaarheid & prestaties

- RPA: Schaal op door meer bots te draaien, maar let op limieten en infrastructuurkosten.

- AI-agent: Cloud-native platforms zoals Thunderbit regelen de schaalbaarheid voor je.

4. Anti-scrapingmaatregelen & compliance

- RPA: Kan moeite hebben met CAPTCHAs en IP-blokkades. Gebruik alleen op sites waar je toestemming hebt.

- AI-agent: Sommige AI-agents bootsen menselijk gedrag beter na, maar respecteer altijd de gebruiksvoorwaarden en privacywetgeving.

5. Betrouwbaarheid waarborgen

- Best practice: Controleer altijd de gescrapete data, log resultaten en stel meldingen in voor afwijkingen. Doe regelmatig handmatige controles, zeker bij kritieke processen.

De toekomst van procesautomatisering: AI-agents nemen het voortouw

Nu wordt het pas echt interessant. De wereld verschuift van automatisering naar autonomie. AI-agents volgen niet alleen instructies, ze nemen steeds vaker zelf beslissingen, passen zich aan nieuwe situaties aan en doen zelfs suggesties op basis van de verzamelde data.

- .

- In 2028 zal .

- No-code en low-code platforms maken AI-agentontwikkeling toegankelijk voor iedereen, niet alleen voor IT’ers.

Bij Thunderbit bouwen we aan deze toekomst. Onze visie: procesautomatisering zo intuïtief maken dat iedereen webscraping, dataverzameling en zelfs workflow-uitvoering kan automatiseren met een paar klikken en een simpele prompt. We scrapen niet alleen data—wij bouwen de AI-agents die de volgende golf van bedrijfsautomatisering mogelijk maken.

Benieuwd naar de toekomst? Lees verder op de , of duik in onderwerpen als en .

Tot slot

Procesautomatisering draait allang niet meer alleen om handmatig werk vervangen—het gaat erom teams te versterken zodat ze meer kunnen doen, sneller en met minder gedoe. RPA en AI-agents hebben elk hun plek, maar de trend is duidelijk: AI-webscrapers zoals Thunderbit maken automatisering slimmer, flexibeler en toegankelijk voor iedereen.

Kopieer je nog steeds handmatig data? Leg die eetstokjes neer en laat de robots het zware werk doen. Wil je ontdekken wat AI-agents voor jouw bedrijf kunnen betekenen? . Je toekomstige zelf (en je team) zullen je dankbaar zijn.

Veelgestelde vragen

1. Wat is het verschil tussen RPA en AI-agents bij procesautomatisering?

RPA (Robotic Process Automation) volgt strikte, op regels gebaseerde instructies om herhalende taken te automatiseren, ideaal voor stabiele en gestructureerde omgevingen. AI-agents kunnen daarentegen context begrijpen, zich aanpassen aan veranderingen en ongestructureerde data verwerken met machine learning en natuurlijke taalverwerking—perfect voor dynamische, complexe webscraping-taken.

2. Waarom is procesautomatisering belangrijk voor webscraping?

Handmatig webscrapen is traag, foutgevoelig en niet schaalbaar. Automatisering bespaart tijd, verlaagt kosten, verbetert nauwkeurigheid en maakt realtime beslissingen mogelijk door continu actuele data van websites te verzamelen zonder handmatig werk.

3. Wanneer kies ik voor RPA in plaats van een AI-webscraper zoals Thunderbit?

RPA is het meest geschikt voor voorspelbare websites met gestructureerde data en als strikte compliance-documentatie vereist is. Heeft je team technische kennis en veranderen de doelwebsites zelden, dan is RPA een betrouwbare keuze.

4. Wat maakt Thunderbit anders dan traditionele scrapingtools?

Thunderbit gebruikt AI om velden automatisch te herkennen, paginering te verwerken, subpagina’s te scrapen en data met één klik te exporteren—zonder code. Het is ontworpen voor zakelijke gebruikers en ondersteunt scraping in de browser of in de cloud, waardoor automatisering toegankelijk wordt voor niet-developers.

5. Kunnen RPA en AI-agents samen worden gebruikt?

Ja. Veel bedrijven gebruiken RPA voor interne, stabiele processen en AI-agents zoals Thunderbit voor externe, dynamische websites. Deze hybride aanpak combineert de sterke punten van beide technologieën voor bredere en robuustere automatisering.

Verder lezen: