Het internet is in 2026 echt een jungle—de helft van al het verkeer bestaat inmiddels uit bots. Open-source webscrapers zijn de stille motoren achter de schermen, onmisbaar voor alles van prijsvergelijkingen tot het trainen van AI-modellen. Na jaren in SaaS en automatisering heb ik één ding geleerd: de juiste zelfgehoste webscraper kiezen bespaart je team maanden aan frustratie (en waarschijnlijk een paar slapeloze nachten vol debugging). Of je nu een paar productpagina’s wilt scrapen of miljoenen URL’s voor onderzoek wilt doorspitten, de open-source Firecrawl alternatieven in deze lijst bieden voor elke schaal, tech-stack en complexiteit een oplossing.

Maar let op: er is geen one-size-fits-all. Sommige teams hebben de brute kracht van Scrapy of de archiveringsskills van Heritrix nodig, terwijl anderen juist afhaken op het onderhoud van open-source libraries. Daarom zetten we de 9 beste open-source Firecrawl alternatieven voor 2026 op een rij, laten we zien waar elk pakket in uitblinkt en helpen we je de juiste tool te kiezen—zonder eindeloos trial-and-error.

Hoe kies je het beste open-source Firecrawl alternatief voor jouw organisatie?

Voordat je in de lijst duikt, eerst even de strategie. Het open-source webscraper landschap is diverser dan ooit, en je keuze hangt af van een paar belangrijke punten:

- Gebruiksgemak: Wil je een tool die je direct kunt aanklikken, of schrijf je liever zelf Python, Go of JavaScript?

- Schaalbaarheid: Gaat het om één website, of wil je miljoenen pagina’s over honderden domeinen crawlen?

- Type content: Is de doelwebsite statische HTML, of draait het op zware JavaScript en dynamische content?

- Integratie: Wil je de data exporteren naar Excel, in een database stoppen, of direct in je analytics-pipeline verwerken?

- Onderhoud: Heb je capaciteit om eigen code te onderhouden, of zoek je een tool die automatisch meebeweegt met site-wijzigingen?

Hier is een handig overzicht om je keuze makkelijker te maken:

| Scenario | Beste tool(s) |

|---|---|

| No-code, offline browsen | HTTrack |

| Grootschalig, multi-domein crawl | Scrapy, Apache Nutch, StormCrawler |

| Dynamische/JS-zware sites | Puppeteer |

| Formulieren/login automatiseren | MechanicalSoup |

| Statische site downloaden/archiveren | Wget, HTTrack, Heritrix |

| Go developer, hoge performance | Colly |

Laten we nu de top 9 open-source Firecrawl alternatieven voor 2026 induiken.

1. Scrapy: Beste keuze voor grootschalig crawlen met Python

is dé zwaargewicht onder de open-source webscrapers. Gebouwd in Python en favoriet bij ontwikkelaars die op grote schaal willen scrapen—denk aan miljoenen pagina’s, frequente updates en complexe sitestructuren.

Waarom Scrapy?

- Enorme schaal: Scrapy verwerkt duizenden verzoeken per seconde en wordt gebruikt door bedrijven die miljarden pagina’s per maand scrapen ().

- Uitbreidbaar & modulair: Schrijf je eigen spiders, voeg middleware toe voor proxies, logins en output naar JSON, CSV of databases.

- Actieve community: Veel plugins, uitgebreide documentatie en volop antwoorden op Stack Overflow.

- Bewezen in de praktijk: Wordt wereldwijd ingezet door e-commerce, nieuws- en onderzoeksteams.

Beperkingen: Steile leercurve voor niet-ontwikkelaars en je moet je spiders onderhouden als websites veranderen. Maar voor maximale controle en schaalbaarheid is Scrapy onovertroffen.

2. Apache Nutch: Beste voor enterprise zoekmachines

is de oervader van open-source webscrapers, ontworpen voor enterprise-niveau en internetbrede crawls. Wil je je eigen zoekmachine bouwen of miljoenen domeinen doorzoeken? Dan is Nutch je beste vriend.

Waarom Apache Nutch?

- Hadoop-schaal: Gebouwd op Hadoop, kan Nutch miljarden pagina’s crawlen over serverclusters ( gebruikt het voor publieke webcrawls).

- Batch crawling: Geef een lijst seed-URL’s en laat hem draaien—ideaal voor geplande, grootschalige jobs.

- Integratie: Werkt samen met Solr, Elasticsearch en big data pipelines.

Beperkingen: Complexe installatie (denk aan Hadoop-clusters en Java-configuratie), en vooral gericht op rauw crawlen, niet op gestructureerde data-extractie. Overkill voor kleine projecten, maar onovertroffen voor web-scale crawls.

3. Heritrix: Beste voor webarchivering & compliance

is de webscraper van het Internet Archive, speciaal ontwikkeld voor webarchivering en digitale bewaring.

Waarom Heritrix?

- Archiveringskwaliteit: Legt elke pagina, asset en link vast—perfect voor juridische compliance of historische snapshots.

- WARC-output: Slaat alles op in gestandaardiseerde Web ARChive-bestanden, klaar voor analyse of hergebruik.

- Web-based beheer: Crawls instellen en monitoren via een browserinterface.

Beperkingen: Zwaar (veel schijfruimte en geheugen nodig), geen JavaScript-ondersteuning en output in ruwe archieven in plaats van gestructureerde tabellen. Ideaal voor bibliotheken, archieven of gereguleerde sectoren.

4. Colly: Beste voor high-performance Go developers

is favoriet bij Go-ontwikkelaars: snel, lichtgewicht en extreem concurrerend.

Waarom Colly?

- Supersnel: Dankzij Go’s concurrency kan Colly duizenden pagina’s scrapen met minimale CPU/RAM ().

- Eenvoudige API: Definieer callbacks voor HTML-elementen, automatische cookie- en robots.txt-afhandeling.

- Ideaal voor statische sites: Perfect voor server-rendered pagina’s, API’s of integratie in een Go-backend.

Beperkingen: Geen ingebouwde JavaScript-rendering (voor dynamische sites moet je combineren met bijvoorbeeld Chromedp), en je moet Go beheersen.

5. MechanicalSoup: Beste voor eenvoudige formulierautomatisering

is een Python-library die het gat overbrugt tussen simpele HTTP-verzoeken en volledige browserautomatisering.

Waarom MechanicalSoup?

- Formulieren automatiseren: Eenvoudig inloggen, formulieren invullen en sessies behouden—ideaal voor scraping achter een login.

- Lichtgewicht: Gebruikt Requests en BeautifulSoup, dus snel en eenvoudig op te zetten.

- Perfect voor interactieve sites: Als je zoekformulieren moet invullen of data na inloggen wilt scrapen, is MechanicalSoup een goede keuze ().

Beperkingen: Geen JavaScript-ondersteuning, dus niet geschikt voor JS-zware sites. Beste voor statische of server-rendered pagina’s met eenvoudige interacties.

6. Puppeteer: Beste voor dynamische & JavaScript-rijke sites

is het Zwitserse zakmes voor het scrapen van moderne, JavaScript-gedreven websites. Het is een Node.js-library die volledige controle geeft over een headless Chrome-browser.

Waarom Puppeteer?

- Dynamische content: Scrape SPAs, infinite scroll en pagina’s die data via AJAX laden ().

- Gebruikersacties simuleren: Klikken, formulieren invullen, screenshots maken en zelfs CAPTCHAs oplossen (met plugins).

- Krachtige automatisering: Ideaal voor testen, monitoring en alles wat een echte gebruiker kan zien.

Beperkingen: Vraagt veel resources (draait volledige Chrome-instances), trager dan HTTP-only scrapers en voor schaalbaarheid is stevige hardware of cloud nodig.

7. Wget: Beste voor snelle command-line downloads

is de klassieke command-line tool voor het downloaden van statische websites en bestanden.

Waarom Wget?

- Eenvoud: Download complete sites of mappen met één commando—geen code nodig.

- Snelheid: Geschreven in C, dus razendsnel en efficiënt.

- Ideaal voor statische content: Perfect voor documentatiesites, blogs of bulk downloads ().

Beperkingen: Geen JavaScript-ondersteuning of formulierafhandeling, en downloadt ruwe pagina’s (geen gestructureerde data). Zie het als een digitale stofzuiger voor statische sites.

8. HTTrack: Beste voor offline browsen (no-code)

is de gebruiksvriendelijke variant van Wget, met een grafische interface voor het spiegelen van websites.

Waarom HTTrack?

- GUI-gemak: Stapsgewijze wizard maakt het toegankelijk voor niet-technische gebruikers.

- Offline browsen: Past links aan zodat je lokaal door gespiegelde sites kunt bladeren.

- Ideaal voor archivering: Perfect voor onderzoekers, marketeers of iedereen die een snapshot van een site wil zonder te coderen ().

Beperkingen: Geen ondersteuning voor dynamische content, kan traag zijn bij grote sites en niet bedoeld voor gestructureerde data-extractie.

9. StormCrawler: Beste voor real-time gedistribueerd crawlen

is de moderne, gedistribueerde webscraper voor teams die real-time, continue webdata op schaal nodig hebben.

Waarom StormCrawler?

- Real-time crawling: Gebouwd op Apache Storm, verwerkt data als streams—ideaal voor nieuwsmonitoring of zoekmachines ().

- Modulair & schaalbaar: Voeg parsing, indexing en eigen processing bolts toe naar wens.

- Gebruikt door Common Crawl: Aandrijver van de nieuwsdatabank van een van de grootste open webarchieven.

Beperkingen: Vereist Java-ontwikkeling en een Storm-cluster, dus vooral geschikt voor teams met ervaring in gedistribueerde systemen. Overkill voor kleine projecten.

Open-source Firecrawl alternatieven vergelijken: welke gratis concurrent past bij jouw behoeften?

Hier een overzicht van alle 9 tools naast elkaar:

| Tool | Beste toepassing | Belangrijkste voordelen | Nadelen | Taal / installatie |

|---|---|---|---|---|

| Scrapy | Grootschalig, frequent crawlen | Krachtig, schaalbaar, grote community | Steile leercurve, Python vereist | Python framework |

| Apache Nutch | Enterprise, web-scale crawlen | Hadoop-schaal, bewezen in de praktijk | Complexe setup, batch-georiënteerd | Java/Hadoop |

| Heritrix | Archivering, compliance crawlen | Complete site-capture, WARC-output | Zwaar, geen JS, ruwe archieven | Java app, web UI |

| Colly | Go devs, high-performance scraping | Snel, simpele API, concurrency | Geen JS, Go vereist | Go library |

| MechanicalSoup | Formulieren, login scraping | Lichtgewicht, sessiebeheer | Geen JS, beperkte schaal | Python library |

| Puppeteer | Dynamische/JS-zware sites | Volledige browsercontrole, automatisering | Veel resources, Node.js vereist | Node.js library |

| Wget | Statische site download, offline toegang | Simpel, snel, CLI | Geen JS, ruwe pagina’s | Command-line tool |

| HTTrack | Niet-tech gebruikers, site-archivering | GUI, makkelijk offline browsen | Geen JS, traag bij grote sites | Desktop app (GUI) |

| StormCrawler | Real-time, gedistribueerd crawlen | Schaalbaar, modulair, real-time | Java/Storm expertise vereist | Java/Storm cluster |

Zelf bouwen of kiezen voor een bestaand open-source Firecrawl alternatief?

Eerlijk is eerlijk: je eigen webscraper bouwen klinkt leuk—tot je vastloopt in onderhoud, proxies en anti-bot obstakels. De open-source tools hierboven bevatten jaren aan praktijkervaring en communitykennis. Volgens brancheonderzoek is gebruikmaken van bestaande oplossingen de snelste en meest betrouwbare manier om resultaat te boeken en het wiel niet opnieuw uit te vinden ().

- Kies open-source als: Je behoeften aansluiten bij bestaande tools, je ontwikkeltijd wilt besparen en community support waardeert.

- Bouw zelf als: Je unieke eisen hebt, veel in-house expertise en scraping core business is.

Let wel: open-source is niet "gratis" als je rekent op ontwikkeltijd, serveronderhoud en voortdurende updates tegen anti-scraping. Wil je wel de kracht van een webscraper, maar niet de code? Dan is er nog een alternatief.

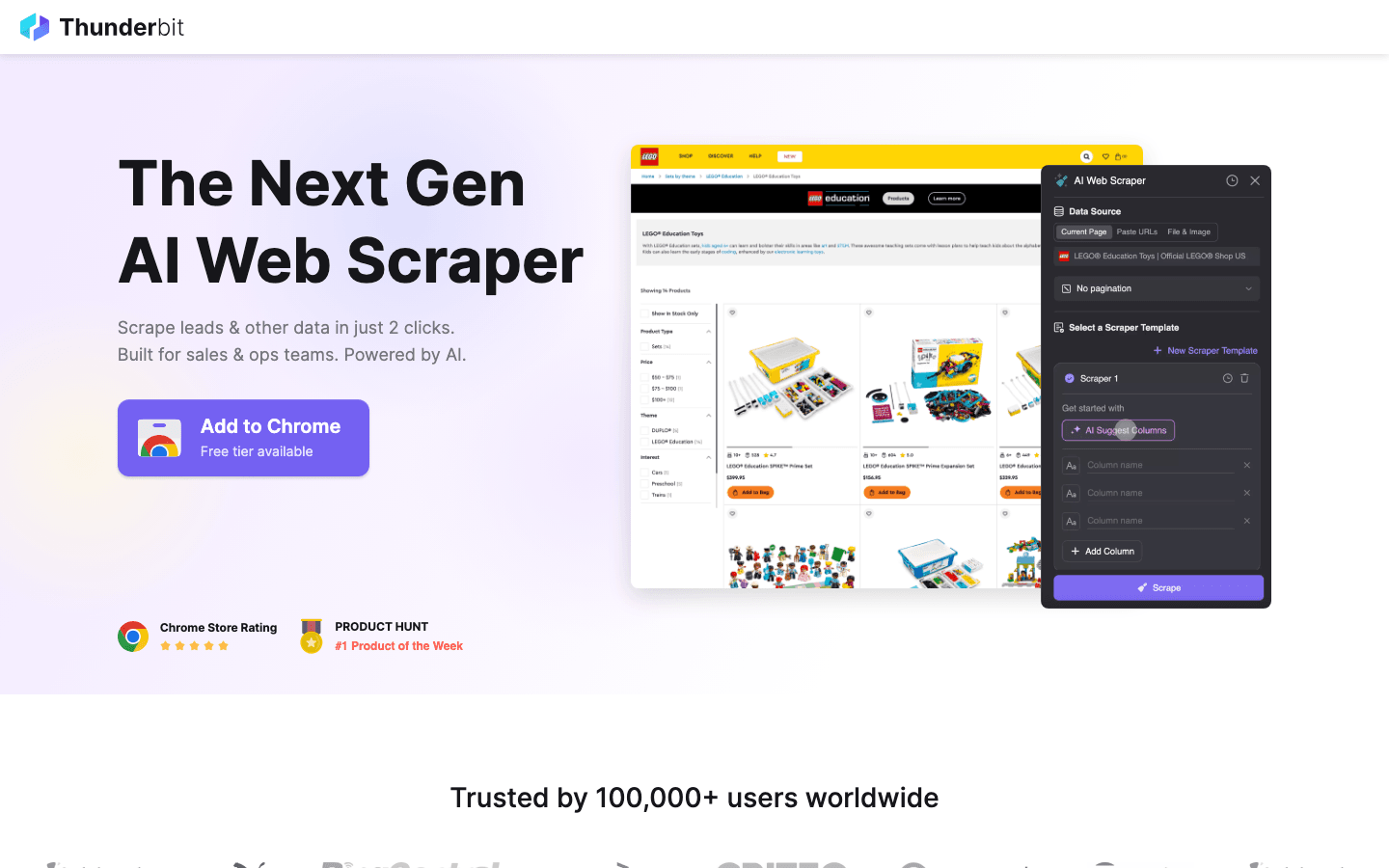

Bonus: Is open-source te complex? Probeer Thunderbit

De bovengenoemde tools zijn top voor ontwikkelaars, maar ze hebben allemaal dezelfde beperking: je moet kunnen coderen, ze worstelen met dynamische AI-anti-bots en vereisen continu onderhoud.

is mijn aanrader voor iedereen die deze barrières wil omzeilen. Het combineert krachtige scraping met gebruiksgemak.

Waarom Thunderbit overwegen boven open-source?

- Geen code nodig: In tegenstelling tot Scrapy of Puppeteer is Thunderbit een AI-webscraper voor Chrome. Je klikt op “AI Suggest Fields” en de scraper wordt automatisch gebouwd.

- Regelt het moeilijke werk: Dynamische content, infinite scroll en paginering worden automatisch door AI afgehandeld—geen handmatig scripten meer.

- Direct exporteren: Zet data in twee klikken om naar Excel, Google Sheets of Notion.

- Geen onderhoud: Je hoeft je code niet aan te passen als een website verandert—Thunderbit’s AI past zich automatisch aan.

Ben je sales, marketeer of onderzoeker en wil je direct data zonder Python of Go te leren? Dan is Thunderbit de perfecte aanvulling op de open-source tools uit deze lijst.

Zelf proberen? en ervaar het gemak.

Conclusie: De juiste zelfgehoste webscraper vinden voor 2026

Het aanbod aan open-source Firecrawl alternatieven is groter dan ooit. Of je nu de brute kracht van Scrapy of Nutch nodig hebt, of de archiveringskwaliteit van Heritrix—er is voor elke situatie een passende oplossing. Het belangrijkste is dat je de tool kiest die bij je behoefte past: ga niet over-engineeren voor een snelle datagrab, maar investeer wel als je op internetschaal crawlt.

En onthoud: als open-source te technisch of tijdrovend blijkt, staan AI-tools zoals Thunderbit klaar om het werk over te nemen.

Klaar om te starten? Zet Scrapy in voor je volgende dataproject, of voor eenvoudige, AI-gedreven scraping. Meer scraping-tips? Bekijk de voor diepgaande uitleg en tutorials.

Veelgestelde vragen

1. Wat is het grootste voordeel van open-source Firecrawl alternatieven? Open-source alternatieven bieden flexibiliteit, kostenbesparing en de mogelijkheid om je webscraper zelf te hosten en aan te passen. Je voorkomt vendor lock-in en profiteert van actieve community-ondersteuning en updates.

2. Welke tool is het beste voor niet-technische gebruikers die snel resultaat willen? is een goede open-source keuze voor offline browsen. Voor gestructureerde data (zoals Excel-tabellen) raden we de bonustool aan vanwege de AI-mogelijkheden.

3. Hoe pak ik dynamische, JavaScript-rijke websites aan? is hiervoor de beste optie—het bestuurt een echte browser en kan dus alles scrapen wat een gebruiker ziet, inclusief SPAs en AJAX-content.

4. Wanneer kies ik voor een zware webscraper als Apache Nutch of StormCrawler? Als je miljoenen pagina’s over veel domeinen wilt crawlen, of real-time, gedistribueerd wilt crawlen (zoals voor zoekmachines of nieuwsmonitoring), zijn deze tools gemaakt voor schaal en betrouwbaarheid.

5. Is het beter om zelf een webscraper te bouwen of een bestaande open-source oplossing te gebruiken? Voor de meeste teams is het sneller, goedkoper en betrouwbaarder om een bestaande open-source tool te gebruiken en aan te passen. Alleen als je zeer specifieke eisen hebt en de middelen om het langdurig te onderhouden, is zelf bouwen een optie.

Veel succes met crawlen—en moge je data altijd vers, gestructureerd en direct bruikbaar zijn.

Meer weten