De digitale nieuwsstroom dendert altijd door. Elke minuut verschijnen er verse headlines, ontstaan er nieuwe meningen en veranderen verhalen—sneller dan je je browser kunt verversen. Na jaren werken aan automatisering en AI-tools heb ik zelf gemerkt hoe het juiste nieuws op het juiste moment het verschil kan maken voor een zakelijke beslissing, een marketingactie of zelfs de reputatie van een bedrijf. Maar laten we eerlijk zijn: proberen deze informatiestroom handmatig bij te houden is alsof je bliksem probeert te vangen met een vlindernet. Daarom is nieuws scraping—het automatisch verzamelen van gestructureerde nieuwsdata van het web—onmisbaar geworden voor iedereen die real-time inzichten nodig heeft.

Maar let op: nieuws scraping draait niet alleen om het binnenhalen van headlines. Het gaat om precisie, snelheid en het volgen van de regels. Doe je het verkeerd, dan krijg je verouderde, incomplete of zelfs illegale data. Doe je het goed, dan heb je een actuele nieuwsrader die je altijd een stapje voor laat zijn. In deze gids deel ik de best practices voor nieuws scraping in 2025, gebaseerd op mijn ervaring bij en de nieuwste inzichten uit de sector. Of je nu werkt in business intelligence, PR, onderzoek, of gewoon een nieuwsjunk bent met een zwak voor spreadsheets—je vindt hier praktische tips, bewezen workflows en een paar lessen uit de praktijk (en af en toe een grapje—want zelfs webscrapers mogen lachen).

Wat is Nieuws Scraping en Waarom is het Belangrijk?

Heel simpel gezegd is nieuws scraping het automatisch verzamelen van nieuwsartikelen, headlines, auteurs, data en andere metadata van nieuwssites, zodat je een chaotische stroom aan verhalen omzet in gestructureerde, bruikbare data. In tegenstelling tot algemene webscraping, dat zich vaak richt op statische productpagina’s of bedrijvengidsen, draait nieuws scraping om actualiteit en continue updates—je bouwt eigenlijk je eigen gepersonaliseerde nieuwsfeed.

Waarom is dit zo belangrijk? Omdat , en bedrijven nieuwsfeeds steeds vaker als strategische informatiebron gebruiken. Of je nu markttrends volgt, concurrenten in de gaten houdt, sentiment analyseert of PR-crises beheert—met het juiste nieuws binnen handbereik heb je een flinke voorsprong.

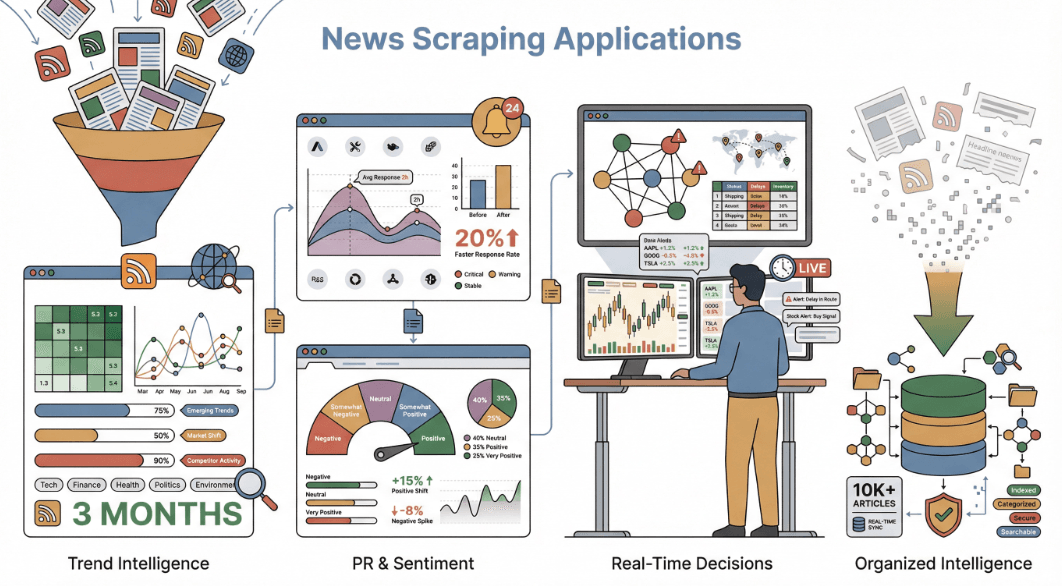

Zo zetten organisaties nieuws scraping in:

- Markt- & Trendanalyse: Ontdek trends maanden voordat ze in reguliere rapporten verschijnen. Bedrijven die nieuws uit meerdere bronnen verzamelen, signaleren brancheverschuivingen tot drie maanden eerder dan organisaties die alleen interne data gebruiken.

- Concurrentie- & PR-monitoring: Volg in real-time vermeldingen van je merk (of dat van je concurrenten). Merken die nieuws-sentiment monitoren, reageren .

- Sentimentanalyse & Onderzoek: Analyseer duizenden artikelen op toon, bias of narratief—zoals de die economen gebruiken.

- Directe Besluitvorming: Gebruik nieuwsdata in handelsalgoritmes, supply chain alerts of dashboards om direct te kunnen reageren op gebeurtenissen.

Kortom, nieuws scraping verandert de dagelijkse stroom aan headlines in gestructureerde inzichten—en dat is tegenwoordig onmisbaar.

Waarom Kiezen voor Nieuws Scraping in Plaats van Nieuws-API’s?

Misschien denk je: “Waarom niet gewoon een nieuws-API gebruiken? Daar zijn die toch voor?” Een logische vraag, die ik vaak hoor.

Nieuws-API’s (zoals NewsAPI.org of Google News API) bieden gestructureerde feeds met nieuwsberichten, samenvattingen en metadata van verschillende bronnen. Ze zijn ideaal voor snelle integratie en brede dekking, zeker als je alleen basisvelden als titel, datum en bron nodig hebt. Maar API’s hebben duidelijke beperkingen:

- Beperkte Data: De meeste API’s leveren alleen headline, bron, datum en soms een korte samenvatting. Wil je de volledige tekst, auteursinformatie, reacties of gerelateerde links? Dat is vaak niet mogelijk.

- Dekkingsgaten: API’s missen soms niche, lokale of betaalde publicaties.

- Geen Maatwerk: Je zit vast aan het schema en de updatefrequentie van de aanbieder.

- Kosten & Limieten: Kwalitatieve API’s zijn vaak prijzig of hebben strenge gebruikslimieten.

Nieuws scraping geeft je daarentegen volledige controle. Je kunt alles verzamelen wat zichtbaar is op de pagina—reacties, tags, media, gerelateerde artikelen, noem maar op. Je bent niet gebonden aan andermans schema of updatecyclus. En als je een compleet kennisnetwerk wilt bouwen—met alle ongestructureerde details die nieuws waardevol maken—is scraping de beste keuze.

Hier een snelle vergelijking:

| Data Field | News API | News Scraping |

|---|---|---|

| Headline/Title | Ja | Ja |

| Article URL | Ja | Ja |

| Source Name | Ja | Ja |

| Publication Date/Time | Ja | Ja |

| Author Name | Soms | Ja |

| Full Article Text | Soms (betaald) | Ja |

| Main Image URL | Vaak | Ja |

| Article Tags/Category | Misschien | Ja |

| Comments/Discussion | Nee | Ja |

| Related Articles Links | Nee | Ja |

| Social Engagement | Nee | Ja (indien zichtbaar) |

| Data Consistency | Hoog | Variabel (normaliseren) |

Met scraping leg je de volledige rijkdom van nieuws vast—ideaal voor geavanceerde analyses, sentimentmodellen of eigen dashboards.

Meer weten? Lees .

Nieuws Scraping Plannen: Blokkades Voorkomen en Data Nauwkeurig Houden

Laten we het hebben over een van de lastigste kanten van nieuws scraping: hoe vaak moet je scrapen, en hoe voorkom je dat je geblokkeerd wordt?

Bij nieuws draait alles om actualiteit. Scrape je te traag, dan mis je primeurs. Scrape je te agressief, dan wordt je IP-adres sneller geblokkeerd dan je “404 error” kunt zeggen. Het geheim is de juiste balans vinden—en daar komt planning bij kijken.

Best practices voor het plannen van nieuws scraping:

- Stem af op de updates van de site: Wordt je bron elk uur bijgewerkt? Scrape dan elk uur. Is het een dagelijkse nieuwsbrief? Dan is dagelijks voldoende. Voor snel bewegende sites (zoals CNN, Reuters of Google News) kan elke 30 minuten of zelfs vaker tijdens kantooruren nodig zijn ().

- Beperk je verzoeken: Overlaad de server niet. Bouw pauzes in tussen verzoeken en vermijd het razendsnel scrapen van honderden pagina’s achter elkaar.

- Respecteer robots.txt: Controleer altijd het robots.txt-bestand van de site op crawl-delays of verboden paden.

- Monitor op fouten: Zie je lege data of CAPTCHAs verschijnen? Dan scrape je waarschijnlijk te snel.

Bij Thunderbit hebben we de Geplande scraper speciaal hiervoor ontwikkeld. Je beschrijft simpelweg in gewone taal hoe vaak je wilt scrapen (“elke 4 uur op werkdagen”), en Thunderbit regelt de rest—van het spreiden van verzoeken tot het draaien in de cloud, zodat je dataflow soepel blijft zonder risico op blokkades. Bovendien kan Thunderbit tot 50 pagina’s tegelijk verwerken, waardoor je scraping lijkt op normaal gebruikersverkeer.

Meer weten over planning en anti-blokkade strategieën? Bekijk .

Data Extractie van Dynamische Nieuwscontent: Technieken voor Betrouwbare Resultaten

Moderne nieuwssites zijn zelden simpel. Ze gebruiken oneindig scrollen, “meer laden”-knoppen, AJAX-reacties en lay-outs die vaker veranderen dan mijn koffiebestelling. Dat maakt scraping… laten we zeggen “een uitdaging”.

Veelvoorkomende uitdagingen:

- Oneindig Scrollen & Paginering: De meeste nieuwsfeeds laden meer verhalen als je scrolt of op “volgende” klikt. Een simpele scraper mist zo 90% van de content.

- Dynamische Elementen: Reacties, afbeeldingen of gerelateerde links verschijnen soms pas na een klik of vertraging.

- Regelmatige Layout-wijzigingen: Nieuwssites passen hun HTML vaak aan, waardoor hardcoded scrapers snel stuklopen.

Hoe Thunderbit dit oplost:

- Automatische paginering & oneindig scrollen: Thunderbit’s AI herkent en verwerkt automatisch navigatie over meerdere pagina’s en eindeloos scrollen, zodat je álle verhalen binnenhaalt.

- AI-veldextractie: In plaats van kwetsbare selectoren gebruikt Thunderbit AI om de pagina te “lezen” en velden als headline, auteur en datum te vinden—zelfs als de site morgen verandert.

- Subpagina scraping: Wil je de volledige tekst? Thunderbit bezoekt automatisch elke artikel-link en haalt details van de subpagina, alles samengevoegd in één dataset.

- Browsermodus voor dynamische content: Thunderbit kan in je browsersessie draaien, JavaScript uitvoeren en wachten tot alle content geladen is—ideaal voor AJAX-rijke sites.

Een praktijkvoorbeeld: met Thunderbit kun je Google News scrapen en krijg je elke headline, bron en tijdstip—zelfs als nieuwe verhalen dynamisch laden. En verandert de site? Klik op “AI Velden Verbeteren” en Thunderbit past zich aan.

Meer technische details? Lees .

Blijf Legaal en Veilig: Naleving bij Nieuws Scraping

Even serieus: nieuws scraping zit in een juridisch en ethisch grijs gebied, dus het is belangrijk om je aan de regels te houden. Zo blijf je aan de juiste kant van de wet (en je geweten):

- Respecteer robots.txt en de gebruiksvoorwaarden: Controleer altijd wat de site toestaat. Is een sectie verboden? Niet scrapen.

- Scrape geen betaalde of privécontent: Verzamel alleen data die publiek toegankelijk is. Betaalmuur omzeilen is uit den boze.

- Gebruik alleen voor intern onderzoek: Scraping voor interne dashboards of analyses is veiliger dan het herpubliceren van volledige artikelen.

- Overbelast servers niet: Wees een goede webburger. Beperk je verzoeken en scrape niet op een manier die de site kan schaden.

- Ga zorgvuldig om met persoonsgegevens: Verzamel je auteursnamen of reacties? Houd rekening met privacywetgeving zoals de AVG.

Thunderbit helpt je compliant te blijven. Het scrape als jouw browser (met jouw inlog en rechten), omzeilt geen beveiliging en houdt je data lokaal. Alle exports zijn gratis en lokaal—jij bepaalt waar je data naartoe gaat.

Meer weten over juridische aspecten? Lees .

Thunderbit’s Unieke Voordelen voor Nieuws Scraping

Eerlijk is eerlijk, ik ben een beetje bevooroordeeld—maar Thunderbit is gebouwd om nieuws scraping voor iedereen makkelijk en krachtig te maken, niet alleen voor techneuten. Dit maakt ons uniek:

- AI-gestuurde veldherkenning: Klik op “AI Velden Voorspellen” en Thunderbit leest de pagina en stelt de juiste kolommen voor (headline, auteur, datum, inhoud, afbeelding, enz.)—zonder code, zonder giswerk.

- Subpagina & multi-pagina scraping: Volg automatisch links naar artikelen en haal volledige inhoud, reacties of gerelateerde links op.

- Dynamische content aan: Oneindig scrollen, AJAX, layout-wijzigingen—Thunderbit’s AI past zich aan, zodat je scraper niet steeds stukloopt.

- Cloud- & browsermodus: Kies voor snelle, parallelle cloud scraping bij openbare sites, of browsermodus voor sites met login of veel JavaScript.

- Gratis, flexibele export: Exporteer naar Excel, Google Sheets, Airtable, Notion of JSON—zonder betaalmuur of limieten.

- No-code eenvoud: Als je een browser kunt gebruiken, kun je met Thunderbit scrapen. Geen XPath, geen scripts, gewoon aanwijzen en klikken.

- Betaalbare prijzen: Gratis voor kleine projecten, betaalde plannen vanaf €15/maand—veel voordeliger dan de meeste zakelijke tools.

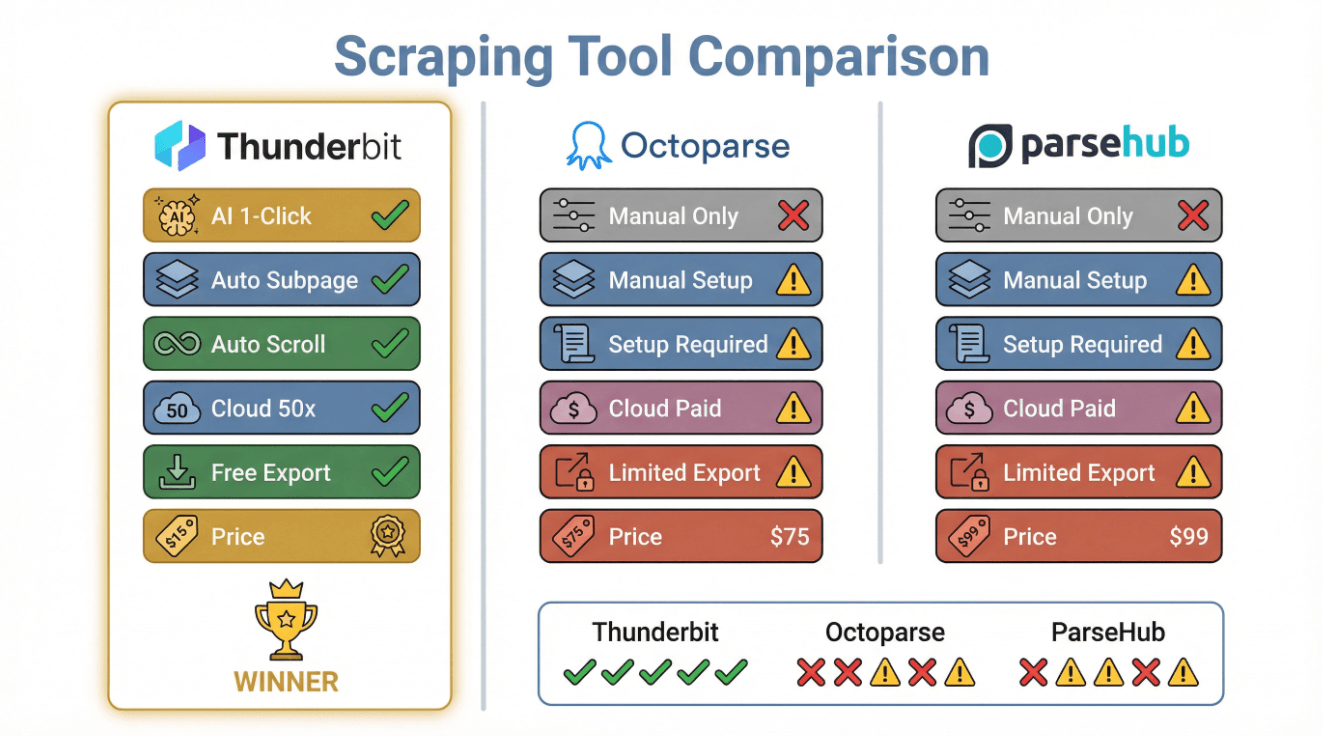

Hier een snelle feature-vergelijking:

| Feature | Thunderbit | Octoparse | ParseHub |

|---|---|---|---|

| AI Field Detection | Ja (1-klik) | Nee (handmatig) | Nee (handmatig) |

| Subpage Scraping | Ja (automatisch) | Ja (handmatig) | Ja (handmatig) |

| Infinite Scroll Handling | Ja (automatisch) | Ja (instellen) | Ja (instellen) |

| Cloud Scraping | Ja (50 tegelijk) | Ja (betaald) | Ja (betaald) |

| Free Export | Ja (alle plannen) | Beperkt | Beperkt |

| No-Code Setup | Ja | Ja | Ja |

| Pricing | Gratis/€15+/mnd | €75+/mnd | €99+/mnd |

Meer weten? Bekijk .

Best Practices voor Nauwkeurige en Snelle Nieuws Scraping

Hier een handige checklist voor elk nieuws scraping project:

- Kies betrouwbare bronnen: Focus op gerenommeerde, vaak geüpdatete nieuwssites of aggregators (zoals Google News, BBC, CNN, Reuters, TechCrunch).

- Stem scraping-frequentie af: Pas je schema aan op de updatesnelheid van de site—elk uur voor breaking news, dagelijks voor langzamere feeds.

- Omgaan met dynamische content: Gebruik tools (zoals Thunderbit) die overweg kunnen met oneindig scrollen, AJAX en layout-wijzigingen.

- Dedupliceren & valideren: Verwijder dubbele verhalen, controleer op ontbrekende velden en normaliseer formaten.

- Respecteer juridische grenzen: Controleer altijd robots.txt, TOS en vermijd betaalde/prive content.

- Monitor & pas aan: Stel meldingen in voor mislukte scrapes en controleer regelmatig je output op juistheid.

- Integreer & automatiseer: Exporteer data naar je favoriete tools (Sheets, Notion, Airtable) en bouw dashboards of alerts.

Hier een overzichtelijke tabel:

| Step | Best Practice |

|---|---|

| Source Selection | Betrouwbaar, relevant, divers |

| Scheduling | Afstemmen op updatesnelheid, verzoeken spreiden |

| Dynamic Handling | AI/automatisering voor scroll, paginering, AJAX |

| Data Quality | Dedupliceren, valideren, normaliseren |

| Compliance | robots.txt, TOS, privacywetgeving |

| Monitoring | Alerts, handmatige checks, aanpassen bij wijzigingen |

| Export & Use | Automatiseren naar Sheets, Notion, dashboards, alerts |

Een Robuuste Nieuws Scraping Workflow Bouwen: Stappenplan

Laten we praktisch worden. Zo stel je een nieuws scraping workflow op met —zonder code, zonder gedoe.

Stap 1: Bepaal je Nieuwsbronnen

- Kies je sites: Begin met grote namen (BBC, CNN, Reuters), branche-specifieke sites (TechCrunch, Medical News Today) en aggregators (Google News).

- Controleer toegankelijkheid: Zorg dat de content publiek beschikbaar is (niet achter een betaalmuur).

- Let op taal/regio: Thunderbit ondersteunt 34 talen, dus internationaal werken is geen probleem.

- Maak een lijst van je URL’s: Homepages, sectiepagina’s of zoekresultaten (bijv. Google News voor “AI regulering”).

Stap 2: Stel Thunderbit in voor Nieuws Scraping

- Installeer de .

- Open je doelpagina in Chrome.

- Klik op “AI Velden Voorspellen”: Thunderbit stelt kolommen voor zoals Titel, URL, Bron, Publicatietijd, Auteur, Afbeelding, enz.

- Controleer & pas aan: Voeg velden toe of hernoem ze indien nodig (bijv. “Categorie” als je nieuwssecties wilt volgen).

- Sla op als sjabloon: Handig voor herhaald gebruik op vergelijkbare pagina’s.

Stap 3: Plan en Monitor Scraping Taken

- Stel een schema in: Gebruik de planner van Thunderbit (“elke dag om 7:00” of “elk uur tijdens kantooruren”).

- Test met een handmatige run: Controleer of je de gewenste data binnenkrijgt.

- Monitor op fouten: Check regelmatig je output; zie je ontbrekende data of fouten, gebruik dan opnieuw “AI Velden Voorspellen” of pas je schema aan.

- Subpagina’s verwerken: Wil je de volledige tekst, gebruik dan Thunderbit’s subpagina scraping om extra velden op te halen.

Stap 4: Exporteer en Gebruik Nieuwsdata

- Exporteer naar je favoriete tool: Google Sheets, Airtable, Notion, Excel of JSON.

- Automatiseer dashboards: Koppel je spreadsheet aan Google Data Studio, Tableau of Power BI voor live nieuwsanalyses.

- Stel alerts in: Gebruik Zapier of IFTTT om meldingen te krijgen bij nieuwe headlines of trefwoorden.

- Blijf verbeteren: Pas velden, bronnen of schema’s aan naarmate je behoeften veranderen—Thunderbit maakt aanpassen eenvoudig.

Meer weten? Lees .

Conclusie: Belangrijkste Inzichten voor Effectieve Nieuws Scraping

Kort samengevat: in een wereld waar nieuws zich razendsnel verspreidt, is geautomatiseerde nieuws scraping dé manier om altijd op de hoogte, concurrerend en proactief te blijven. De best practices zijn simpel maar krachtig: kies de juiste bronnen, plan slim, ga goed om met dynamische content, blijf binnen de regels en monitor je resultaten.

Thunderbit maakt dit niet alleen mogelijk, maar ook toegankelijk voor iedereen—zonder code, zonder gedoe, gewoon nauwkeurige en actuele nieuwsdata klaar voor analyse, dashboards of alerts. Of je nu analist, PR-professional, onderzoeker of nieuwsfan bent, je bouwt in enkele minuten je eigen real-time nieuwsrader.

Ben je het handmatig zoeken naar nieuws zat? Probeer Thunderbit eens. Je toekomstige zelf (en je inbox) zullen je dankbaar zijn.

Meer tips? Bekijk de voor diepgaande artikelen, tutorials en het laatste nieuws over AI-gestuurde webscraping.

Veelgestelde Vragen

1. Waarom zou ik nieuws scrapen in plaats van een nieuws-API gebruiken?

Met nieuws scraping kun je rijkere, meer op maat gemaakte data verzamelen—zoals reacties, auteursinformatie, gerelateerde links en volledige artikelen—die de meeste API’s niet bieden. Ideaal voor uitgebreide datasets, sentimentanalyse of kennisnetwerken.

2. Hoe voorkom ik dat mijn IP wordt geblokkeerd bij nieuws scraping?

Gebruik planningsfuncties (zoals Thunderbit’s Geplande scraper) om verzoeken te spreiden, af te stemmen op de updates van de site en robots.txt te respecteren. Vermijd te snel scrapen en let op fouten of CAPTCHAs.

3. Wat is de beste manier om dynamische nieuwssites met oneindig scrollen of AJAX-content te scrapen?

Kies een scraper (zoals Thunderbit) die automatische paginering, oneindig scrollen en AI-veldextractie ondersteunt. Zo mis je geen enkel verhaal, ook niet als het dynamisch wordt geladen.

4. Is nieuws scraping legaal?

Publiek toegankelijke nieuwsdata scrapen voor intern gebruik is meestal toegestaan, maar controleer altijd robots.txt en de gebruiksvoorwaarden. Scrape nooit betaalde of privécontent en let op auteursrecht en privacywetgeving.

5. Wat maakt Thunderbit uniek geschikt voor nieuws scraping?

Thunderbit combineert AI-veldherkenning, subpagina scraping, dynamische contentverwerking en gratis export naar Excel, Sheets, Airtable en Notion—alles in een no-code, gebruiksvriendelijke omgeving. Ideaal voor zakelijke gebruikers die snel en accuraat nieuws willen verzamelen zonder technische rompslomp.

Zelf aan de slag met je eigen nieuwsdatastroom? en ontdek hoe eenvoudig nieuws scraping kan zijn.

Meer weten