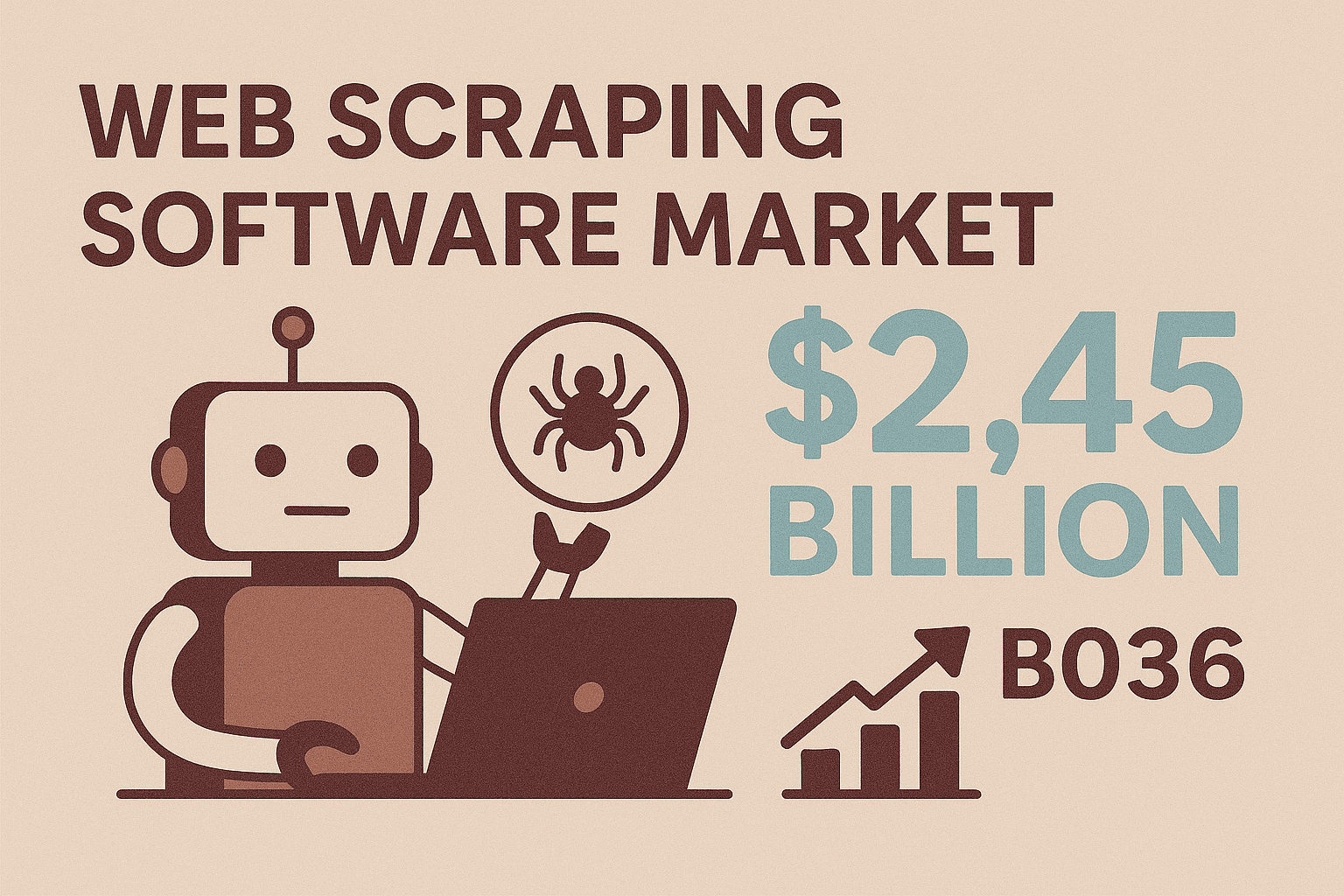

Er gaat niets boven het gevoel wanneer je een script ziet dat razendsnel een website afstruint en data binnenhaalt, terwijl jij relaxed aan je koffie zit. De tijd dat 'screen scraping' betekende dat je eindeloos moest kopiëren en plakken of de IT-afdeling moest smeken om weer een export, is echt voorbij. Tegenwoordig wordt java screen scraping gebruikt voor alles: van het genereren van leads tot het realtime monitoren van prijzen – en het is allang niet meer alleen voor hardcore programmeurs. Met een webscraping-markt die naar verwachting waard zal zijn, is het duidelijk dat bedrijven wereldwijd zoeken naar geautomatiseerde, flexibele manieren om het open web om te zetten in bruikbare data.

Of je nu een zakelijke gebruiker, salesprofessional of developer bent die gestructureerde data uit websites wil halen – vooral als er geen API beschikbaar is – java screen scraping is een skill waar je veel aan hebt. In deze gids neem ik je mee door de basics, laat ik zien hoe je aan de slag gaat met populaire Java-bibliotheken, bespreek ik veelvoorkomende uitdagingen en ontdek je hoe no-code tools zoals je workflow kunnen versnellen. Of je nu zelf een scraper wilt bouwen of AI het zware werk wilt laten doen, je vindt hier praktische stappen en tips uit de praktijk om slimmer te scrapen, niet harder.

Of je nu een zakelijke gebruiker, salesprofessional of developer bent die gestructureerde data uit websites wil halen – vooral als er geen API beschikbaar is – java screen scraping is een skill waar je veel aan hebt. In deze gids neem ik je mee door de basics, laat ik zien hoe je aan de slag gaat met populaire Java-bibliotheken, bespreek ik veelvoorkomende uitdagingen en ontdek je hoe no-code tools zoals je workflow kunnen versnellen. Of je nu zelf een scraper wilt bouwen of AI het zware werk wilt laten doen, je vindt hier praktische stappen en tips uit de praktijk om slimmer te scrapen, niet harder.

Java Screen Scraping: De Basis en Het Belang

Laten we bij het begin beginnen. Java screen scraping betekent dat je met Java-code automatisch informatie van websites haalt – je laat de computer dus het werk doen om een webpagina te lezen en de data te verzamelen die jij nodig hebt. In tegenstelling tot API’s, die data netjes en gestructureerd aanbieden (als ze al bestaan), werkt screen scraping direct met de voorkant van een site, net als een gebruiker in Chrome of Firefox.

Waarom is dit zo belangrijk? Omdat de meeste websites – zeker in e-commerce, vastgoed en B2B-directories – geen openbare API of bulkexport aanbieden. Screen scraping is dan dé manier om deze 'opgesloten' data toch te ontsluiten. Met Java heb je een flexibele toolkit: je kunt eigen regels schrijven, inloggen, knoppen aanklikken en zelfs complexe, dynamische content uitlezen. Daarom is java screen scraping dé oplossing als standaardtools tekortschieten of als je maatwerk nodig hebt voor jouw businesscase.

En de vraag blijft groeien. Bedrijven die moderne scrapingtools inzetten (vooral met AI) besparen op dataverzameling, met nauwkeurigheid tot wel 99%. Dat scheelt enorm veel tijd aan saaie, handmatige research.

Belangrijkste Zakelijke Toepassingen van Java Screen Scraping

Waar blinkt java screen scraping uit in de praktijk? Dit zijn de meest impactvolle business use cases:

| Toepassing | Zakelijke Meerwaarde | Voorbeeldscenario |

|---|---|---|

| Leadgeneratie | Automatiseer het verzamelen van prospectdata, vergroot je salesfunnel, bespaar uren | Scrape LinkedIn of online directories voor namen, functies, e-mails, telefoonnummers |

| Prijsmonitoring | Volg concurrentieprijzen realtime, maak dynamische prijsstelling mogelijk, bespaar analistentijd | Crawl webshops voor dagelijkse prijs- en voorraadupdates |

| Productdata Extractie | Verzamel productinformatie van meerdere bronnen, houd je catalogus actueel | Haal productnamen, specificaties, afbeeldingen, reviews van leveranciers of concurrenten |

| Marktonderzoek | Verzamel grootschalige, actuele datasets voor analyse | Scrape honderden productreviews of vastgoedadvertenties voor trendanalyse |

| Concurrentieanalyse | Signaleer trends, volg nieuwe features, analyseer klantbeoordelingen | Verzamel productpagina’s, klantreviews of nieuwsberichten van concurrenten |

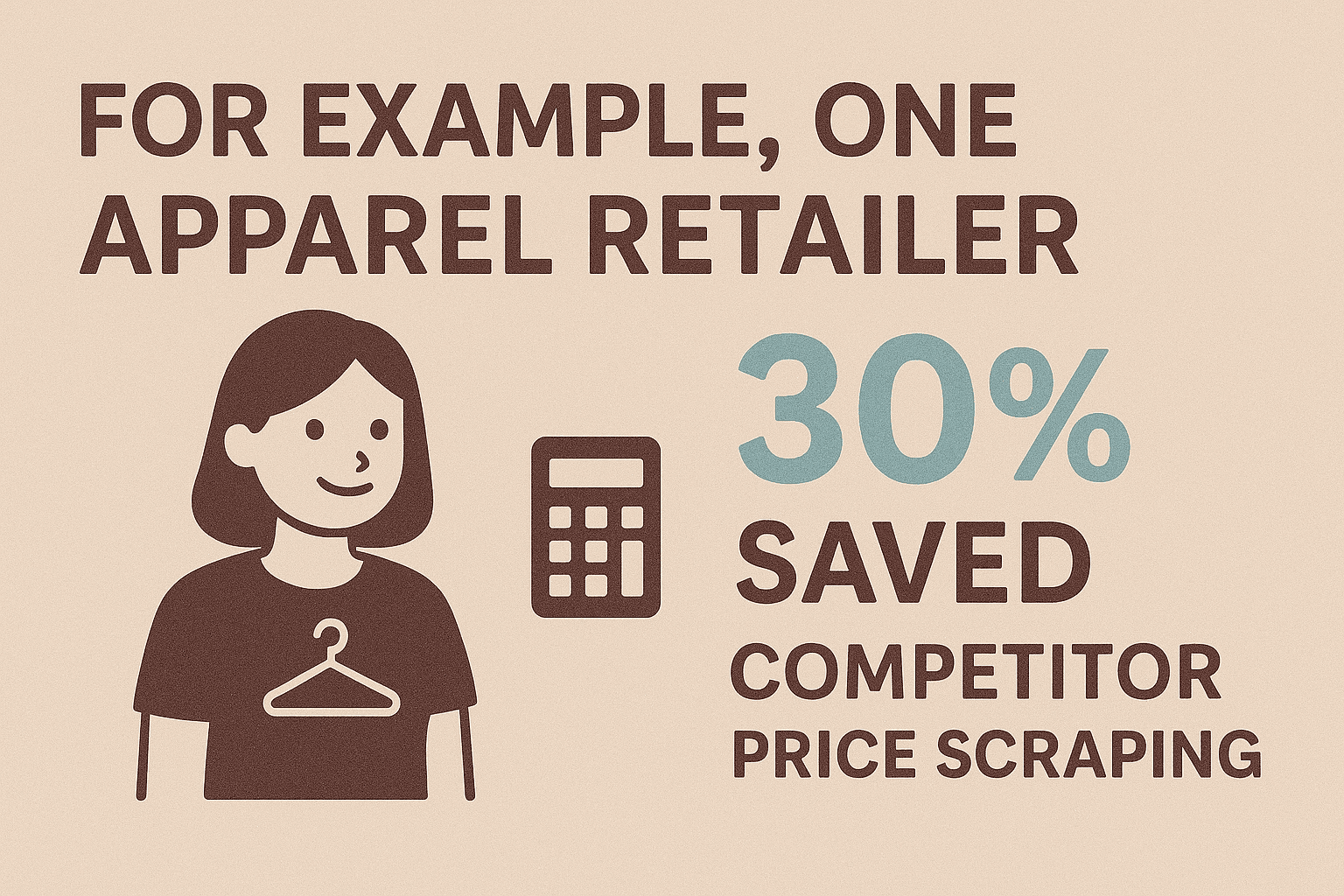

Zo bespaarde een kledingretailer die concurrentieprijzen automatisch scrapete en kreeg realtime inzicht in de markt. Salesafdelingen bouwen met scraping in een paar uur leadlijsten waar ze anders weken mee bezig zouden zijn. En met meer dan is scraping voor e-commercebedrijven essentieel om concurrerend te blijven.

Kortom: als je webdata nodig hebt en er is geen API, is screen scraping vaak de enige praktische oplossing.

Kortom: als je webdata nodig hebt en er is geen API, is screen scraping vaak de enige praktische oplossing.

Aan de Slag: Onmisbare Tools en Bibliotheken voor Java Screen Scraping

Het Java-ecosysteem biedt volop bibliotheken die screen scraping toegankelijk maken – ook als je geen fulltime developer bent. Dit zijn de populairste opties:

1. Selenium WebDriver

- Wat het doet: Automatiseert een echte browser (Chrome, Firefox) om te werken met dynamische, JavaScript-rijke sites.

- Ideaal voor: Scrapen van sites die inloggen, klikken of gebruikersgedrag vereisen.

- Sterke punten: Kan alles aan wat een mens ziet; perfect voor complexe workflows.

- Nadelen: Langzamer en zwaarder; vereist browserdrivers.

Voorbeeldcode:

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- Wat het doet: Haalt statische HTML op en parseert deze met een eenvoudige, jQuery-achtige API.

- Ideaal voor: Snel scrapen van statische pagina’s, blogs, nieuws of productoverzichten.

- Sterke punten: Lichtgewicht, snel, gebruiksvriendelijk, kan slecht opgemaakte HTML aan.

- Nadelen: Kan geen JavaScript uitvoeren of AJAX-content ophalen.

Voorbeeldcode:

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- Wat het doet: Simuleert een headless browser in Java, voert deels JavaScript uit.

- Ideaal voor: Matig dynamische sites waar je browsergedrag wilt zonder de overhead van Selenium.

- Sterke punten: Geen externe browser nodig; ondersteunt HTTP-verzoeken, cookies en eenvoudige scripts.

- Nadelen: Minder krachtig dan Selenium bij moderne JS-frameworks.

Voorbeeldcode:

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. Overige Aanraders

- WebMagic, Gecco: Frameworks voor grootschalig crawlen en extractie.

- Htmleasy: Super simpel, ideaal voor snelle prototypes.

Vergelijking van Java Screen Scraping Bibliotheken

| Bibliotheek | Ondersteuning Dynamische Content | Gebruiksgemak | Ideale Toepassing |

|---|---|---|---|

| Selenium | Ja | Gemiddeld | JS-rijke sites, logins, interactieve workflows |

| Jsoup | Nee | Makkelijk | Statische pagina’s, snelle prototypes |

| HtmlUnit | Gedeeltelijk | Gemiddeld | Lichtgewicht headless scraping, eenvoudige JS |

| Htmleasy | Nee | Zeer makkelijk | Simpele, statische sites, snelle datagrabs |

| WebMagic/Gecco | Nee (JS) | Gemiddeld | Grootschalig crawlen, multi-page extractie |

Snelstart-checklist:

- Kies je bibliotheek (Selenium voor dynamisch, Jsoup voor statisch).

- Zet je Java-project op (voeg dependencies toe via Maven/Gradle).

- Inspecteer de HTML van je doelwebsite met browser DevTools.

- Schrijf een testscraper om een eenvoudig element op te halen en te printen.

- Breid je extractielogica uit en pak paginering aan.

- Exporteer je data (CSV, JSON of direct naar een database).

Stapsgewijs: Je Eerste Java Screen Scraper Bouwen

Laten we een simpel voorbeeld doorlopen: productnamen en prijzen halen van een demo e-commercepagina met Jsoup.

Stap 1: Project Opzetten

Voeg Jsoup toe aan je Maven pom.xml:

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>Stap 2: Webpagina Ophalen

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();Stap 3: Data Parsen en Extracten

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}Stap 4: Paginering Afhandelen

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // Herhaal extractielogica

6 nextLink = doc.selectFirst("a.next");

7}Stap 5: Data Exporteren (CSV Voorbeeld)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Productnaam,Prijs\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();Of, voor JSON:

1List<Product> products = new ArrayList<>();

2// vul products in de loop

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());Data Output: JSON, CSV en Meer

- CSV: Ideaal voor spreadsheets, snelle analyse of delen met niet-technische collega’s.

- JSON: Perfect voor programmatisch gebruik, API’s of geneste data.

- Excel: Gebruik Apache POI als je native

.xlsx-bestanden wilt. - Database: Direct invoeren via JDBC voor permanente opslag.

Kies het formaat dat past bij je workflow. Voor de meeste zakelijke gebruikers zijn CSV of Excel het meest praktisch.

Veelvoorkomende Uitdagingen bij Java Screen Scraping (en Oplossingen)

Screen scraping verloopt niet altijd vlekkeloos. Dit zijn de meest voorkomende obstakels – en hoe je ze tackelt:

1. Dynamische Content (JavaScript/AJAX)

- Probleem: Data laadt pas na het renderen; Jsoup ziet het niet.

- Oplossing: Gebruik Selenium WebDriver om een echte browser te besturen, of spoor de onderliggende AJAX-calls op en simuleer deze in Java.

2. Anti-botmaatregelen

- Probleem: Sites blokkeren of vertragen geautomatiseerde verzoeken.

- Oplossing: Houd je aan crawl-rates, randomiseer user agents, roteer IP’s en boots menselijk gedrag na. Voor zware scraping: gebruik proxy’s of stealth-plugins voor Selenium.

3. Wijzigingen in Website-structuur

- Probleem: HTML-layout verandert, waardoor je selectors breken.

- Oplossing: Centraliseer selectors in je code, gebruik robuuste CSS-klassen of data-attributen en log fouten voor snelle troubleshooting. Wees voorbereid om je scraper aan te passen.

4. Datakwaliteit en Opschoning

- Probleem: Inconsistente formaten, ontbrekende waarden of rommelige tekst.

- Oplossing: Gebruik Java’s stringfuncties en regex om data tijdens het scrapen op te schonen. Normaliseer formaten (zoals telefoonnummers, prijzen) en ga netjes om met null-waarden.

5. Performance en Schaalbaarheid

- Probleem: Duizenden pagina’s scrapen duurt lang.

- Oplossing: Gebruik Java’s concurrency-tools (ExecutorService, threadpools) om verzoeken te paralleliseren, maar overbelast de doelsite niet. Schrijf resultaten direct weg naar bestanden om geheugenproblemen te voorkomen.

Meer best practices vind je in de .

Waarom Thunderbit de Ideale Partner is voor Java Screen Scraping

Laten we het grootste struikelblok bespreken: onderhoud. Java-scrapers schrijven en bijhouden kan veel tijd kosten – zeker als sites hun layout aanpassen of anti-botmaatregelen toevoegen. Hier komt om de hoek kijken.

Thunderbit is een AI-webscraper Chrome-extensie zonder code, speciaal voor zakelijke gebruikers, sales, marketeers en iedereen die webdata wil automatiseren – zonder te programmeren. Waarom is het zo’n gamechanger voor zowel Java-ontwikkelaars als niet-programmeurs?

- AI-gedreven veldherkenning: Klik op “AI Suggest Fields” en Thunderbit’s AI analyseert de pagina en stelt automatisch de beste kolommen voor (zoals productnamen, prijzen, e-mails, enz.).

- 2-Kliks Scraping: Eén klik om AI de data te laten vinden, nog één om te scrapen. Geen selectors instellen of scripts schrijven.

- Subpagina’s Scrapen: Thunderbit volgt links (zoals productdetailpagina’s) en verrijkt je tabel met extra info – zonder handmatig coderen.

- Directe Templates: Voor populaire sites (Amazon, Zillow, Shopify) zijn er kant-en-klare templates voor direct gestructureerd scrapen.

- Gegevenstype-herkenning: Herkent e-mails, telefoonnummers, data, afbeeldingen en meer – en exporteert schone, direct bruikbare data.

- No-code Toegankelijkheid: Iedereen in je team kan ermee werken, zodat ontwikkelaars zich op belangrijker werk kunnen richten.

- Onderhoudsvrij: Wijzigt een site? Klik opnieuw op “AI Suggest Fields” – Thunderbit’s AI past zich automatisch aan.

Thunderbit is ideaal voor snelle projecten, prototypes of als aanvulling op je Java-workflow wanneer je snel data nodig hebt en geen uren wilt besteden aan coderen of debuggen.

Thunderbit en Java Combineren: Bouw een Complete Datapijplijn

De echte kracht zit in de combinatie van Thunderbit’s gebruiksgemak en de verwerkingskracht van Java. Zo bouw je een robuuste, end-to-end datapijplijn:

- Scrapen met Thunderbit: Gebruik Thunderbit om data van je doelwebsite te halen. Plan terugkerende scrapes of gebruik instant-templates voor bekende sites.

- Data Exporteren: Exporteer je resultaten naar CSV, Excel, , Airtable of Notion – allemaal formaten die Java eenvoudig kan lezen.

- Verwerken met Java: Schrijf een Java-applicatie die de geëxporteerde data ophaalt (bijvoorbeeld via de Google Sheets API of door het CSV-bestand te lezen), opschoont of verrijkt en integreert met je interne systemen (CRM, database, analytics).

- Automatiseer de Workflow: Plan Thunderbit op vaste tijden en laat je Java-script automatisch draaien na elke scrape. Zo loopt je datapijplijn volledig automatisch.

Voorbeeld: Stel, je salesteam wil elke maandag een verse lijst met leads uit een bedrijvengids. Thunderbit scrapet de site en exporteert naar Google Sheets. Je Java-app leest het sheet, verwijdert dubbele leads en zet nieuwe contacten in je CRM. Wijzigt de site? Pas gewoon de Thunderbit-configuratie aan – je hoeft geen Java-code te herschrijven.

Deze hybride aanpak geeft je het beste van twee werelden: Thunderbit regelt het lastige, veranderlijke web, Java verzorgt je businesslogica en integratie.

Geavanceerde Tips: Java Screen Scraping Schalen en Automatiseren

Als je scrapingbehoefte groeit, wil je kunnen opschalen en automatiseren:

- Paralleliseren: Gebruik Java’s threadpools om meerdere pagina’s tegelijk te scrapen, maar beperk het aantal om blokkades te voorkomen.

- Plannen: Automatiseer scrapes met Java’s Quartz-bibliotheek of gebruik Thunderbit’s ingebouwde scheduler (gewoon je schema in normaal Nederlands beschrijven).

- Foutafhandeling: Implementeer retries, time-outs en notificaties (e-mail of Slack) bij mislukte runs.

- Cloud Scraping: Thunderbit’s cloudmodus kan 50 pagina’s tegelijk scrapen – ideaal voor grote klussen zonder je eigen computer te belasten.

- Onderhoud: Documenteer je scrapers, centraliseer selectors en log afwijkingen voor snelle troubleshooting. Met Thunderbit zijn updates meestal zo simpel als opnieuw op “AI Suggest Fields” klikken.

Voor echt massale schaal (miljoenen pagina’s) kun je denken aan distributed frameworks zoals Apache Nutch of cloud scraping-API’s – maar voor de meeste zakelijke toepassingen is een mix van Thunderbit en Java ruim voldoende en veel minder gedoe.

Samenvatting & Belangrijkste Inzichten

Java screen scraping is een krachtige manier om webdata te ontsluiten – of je nu leads verzamelt, concurrenten volgt of marktonderzoek doet. Dit zijn de belangrijkste punten:

- Java biedt flexibiliteit en controle voor maatwerk en complexe scraping – vooral als je moet inloggen, met dynamische content werkt of unieke businesslogica hebt.

- Thunderbit brengt AI-gedreven, no-code eenvoud naar webscraping, waardoor het voor iedereen toegankelijk wordt en je in minuten aan de slag kunt.

- De combinatie van beide levert snelle, robuuste datapijplijnen op: scrape met Thunderbit, verwerk en integreer met Java.

- Automatiseer en schaal met parallelisatie, planning en cloud scraping – zonder te verdrinken in onderhoud.

- De toekomst is hybride: Naarmate AI-tools als Thunderbit slimmer worden, zullen de beste scrapers code en no-code combineren voor maximale efficiëntie.

Klaar om je dataverzameling naar een hoger niveau te tillen? , bouw je eerste Java-scraper en ontdek hoeveel tijd (en frustratie) je bespaart. Meer tips en verdiepende artikelen vind je op de .

Veelgestelde Vragen

1. Wat is java screen scraping en hoe verschilt het van webscraping?

Java screen scraping betekent dat je met Java-code data direct uit de voorkant van een website haalt (de weergegeven pagina), vooral als er geen API is. Het is een vorm van webscraping, maar de term 'screen scraping' benadrukt dat je data ophaalt zoals een gebruiker het ziet, niet uit gestructureerde backend-bronnen.

2. Wanneer kies ik voor java screen scraping in plaats van een no-code tool?

Gebruik Java als je maatwerk nodig hebt, complexe logins moet afhandelen, met dynamische content werkt of scraping wilt integreren met je bedrijfsprocessen. No-code tools zoals Thunderbit zijn ideaal voor snelle taken, prototypes of als je niet-technische collega’s wilt laten scrapen.

3. Wat zijn de meest voorkomende uitdagingen bij java screen scraping en hoe los ik ze op?

Veelvoorkomende issues zijn dynamische content (oplossen met Selenium), anti-botmaatregelen (gebruik vertragingen, proxy’s en realistische headers), wijzigingen in site-structuur (centraliseer selectors) en datacleaning (gebruik Java’s string- en regex-tools). Voor grote klussen: gebruik concurrency en goede foutafhandeling.

4. Hoe vult Thunderbit java screen scraping aan?

Thunderbit’s AI Chrome-extensie maakt het eenvoudig om data van elke website te halen – zonder code. Perfect voor snelle klussen, prototypes of als aanvulling op je Java-workflow als je tijd wilt besparen of onderhoud wilt vermijden. Je exporteert data in formaten die Java kan verwerken, voor een naadloze pijplijn.

5. Kan ik een volledige datapijplijn automatiseren met Thunderbit en Java?

Zeker! Plan terugkerende scrapes met Thunderbit, exporteer naar Google Sheets of CSV en gebruik een Java-app om de data op te halen, verwerken en integreren. Deze hybride aanpak combineert de snelheid en flexibiliteit van Thunderbit met de kracht van Java.