Het internet in 2025 is echt een jungle—meer dan de helft van al het verkeer komt niet eens van mensen. Geloof het of niet: bots en crawlers zijn nu goed voor meer dan 50% van alle online activiteit (). En van die bots is maar een klein deel “vriendelijk”: denk aan zoekmachines, social media bots en analytics tools. De rest? Die werken niet altijd in jouw voordeel. Als iemand die jarenlang met automatisering en AI-tools heeft gewerkt bij , heb ik van dichtbij gezien hoe de juiste (of juist verkeerde) crawler je SEO kan maken of breken, je analytics kan verstoren, je bandbreedte kan opslurpen of zelfs een serieus beveiligingsrisico kan vormen.

Of je nu een bedrijf runt, een website beheert of gewoon je digitale omgeving netjes wilt houden, weten wie er op je server klopt is belangrijker dan ooit. Daarom heb ik deze gids voor 2025 gemaakt met de belangrijkste crawlers—wat ze doen, hoe je ze herkent en hoe je je site openhoudt voor de goede bots terwijl je de slechte buiten de deur houdt.

Wat Maakt een Crawler “Bekend”? User-Agent, IP’s en Verificatie

Laten we bij het begin beginnen: wat bedoelen we met een “bekende” crawler? Kort gezegd is dat een bot die zichzelf netjes voorstelt met een herkenbare user-agent string (zoals Googlebot/2.1 of bingbot/2.0) en het liefst crawlt vanaf officiële IP-ranges of ASN-blokken die je kunt checken (). Grote namen als Google, Microsoft, Baidu, Yandex en DuckDuckGo publiceren documentatie over hun bots en bieden vaak tools of JSON-bestanden met hun officiële IP-adressen (, , ).

Maar let op: alleen vertrouwen op de user-agent is niet slim. Spoofing komt vaak voor—malafide bots doen zich graag voor als Googlebot of Bingbot om je beveiliging te omzeilen (). Daarom is dubbele verificatie de gouden standaard: check zowel de user-agent als het IP-adres (of ASN), bijvoorbeeld via reverse DNS of gepubliceerde lijsten. Gebruik je een tool als , dan kun je dit proces automatiseren—logs uitlezen, user-agents matchen en IP’s cross-checken om een betrouwbare, actuele lijst te krijgen van wie je site bezoekt.

Hoe Gebruik je Deze Crawlerlijst?

Wat kun je nu eigenlijk met zo’n lijst van bekende crawlers? Hier zijn mijn tips:

- Allowlisting: Zorg dat de bots die je wilt (zoekmachines, social media previewers) nooit per ongeluk worden geblokkeerd door je firewall, CDN of WAF. Gebruik hun officiële IP’s en user-agents voor nauwkeurige allowlisting.

- Analytics Filtering: Filter botverkeer uit je analytics zodat je cijfers alleen echte bezoekers tonen—en niet alleen Googlebot en AhrefsBot die je site rondjes laten draaien ().

- Botbeheer: Stel crawl-delay of throttling in voor opdringerige SEO-tools, en blokkeer of daag onbekende of verdachte bots uit.

- Automatische Loganalyse: Gebruik AI-tools (zoals Thunderbit) om crawler-activiteit in je logs te extraheren, classificeren en labelen. Zo ontdek je trends, herken je nep-bots en houd je je beleid actueel.

Je crawlerlijst up-to-date houden is geen eenmalige klus. Nieuwe bots duiken op, oude veranderen van gedrag en aanvallers worden elk jaar slimmer. Door updates te automatiseren—bijvoorbeeld door officiële documentatie of GitHub-repos te scrapen met Thunderbit—bespaar je veel tijd en frustratie.

1. Thunderbit: AI-gestuurde Crawlerherkenning en Databeheer

is niet zomaar een AI-webscraper—het is een data-assistent voor teams die inzicht willen in crawlerverkeer en dit willen beheren. Dit maakt Thunderbit uniek:

- Semantische Voorbewerking: Thunderbit zet webpagina’s en logs eerst om naar gestructureerde Markdown-content. Dankzij deze “semantische” voorbewerking snapt de AI de context, velden en logica van wat er gelezen wordt. Ideaal voor complexe, dynamische of JavaScript-rijke pagina’s (zoals Facebook Marketplace of lange commentaren) waar gewone webscrapers tekortschieten.

- Dubbele Verificatie: Thunderbit haalt razendsnel officiële crawler-IP-documentatie en ASN-lijsten op en vergelijkt die met je serverlogs. Het resultaat? Een “vertrouwde crawler allowlist” waarop je kunt bouwen—geen handmatig gezoek meer.

- Automatische Logextractie: Geef Thunderbit je ruwe logs en het zet ze om in gestructureerde tabellen (Excel, Sheets, Airtable), met labels voor frequente bezoekers, verdachte paden en bekende bots. Je kunt deze resultaten direct koppelen aan je WAF of CDN voor automatische blokkering, throttling of CAPTCHA’s.

- Compliance en Audit: Thunderbit’s semantische extractie zorgt voor een heldere audit trail—wie heeft wat bezocht, wanneer, en hoe is het afgehandeld. Dat is ideaal voor GDPR, CCPA en andere regelgeving.

Ik heb teams gezien die hun werkdruk rond crawlerbeheer met 80% zagen dalen dankzij Thunderbit—en eindelijk grip kregen op welke bots nuttig zijn, welke schade doen en welke zich alleen maar voordoen als legitiem.

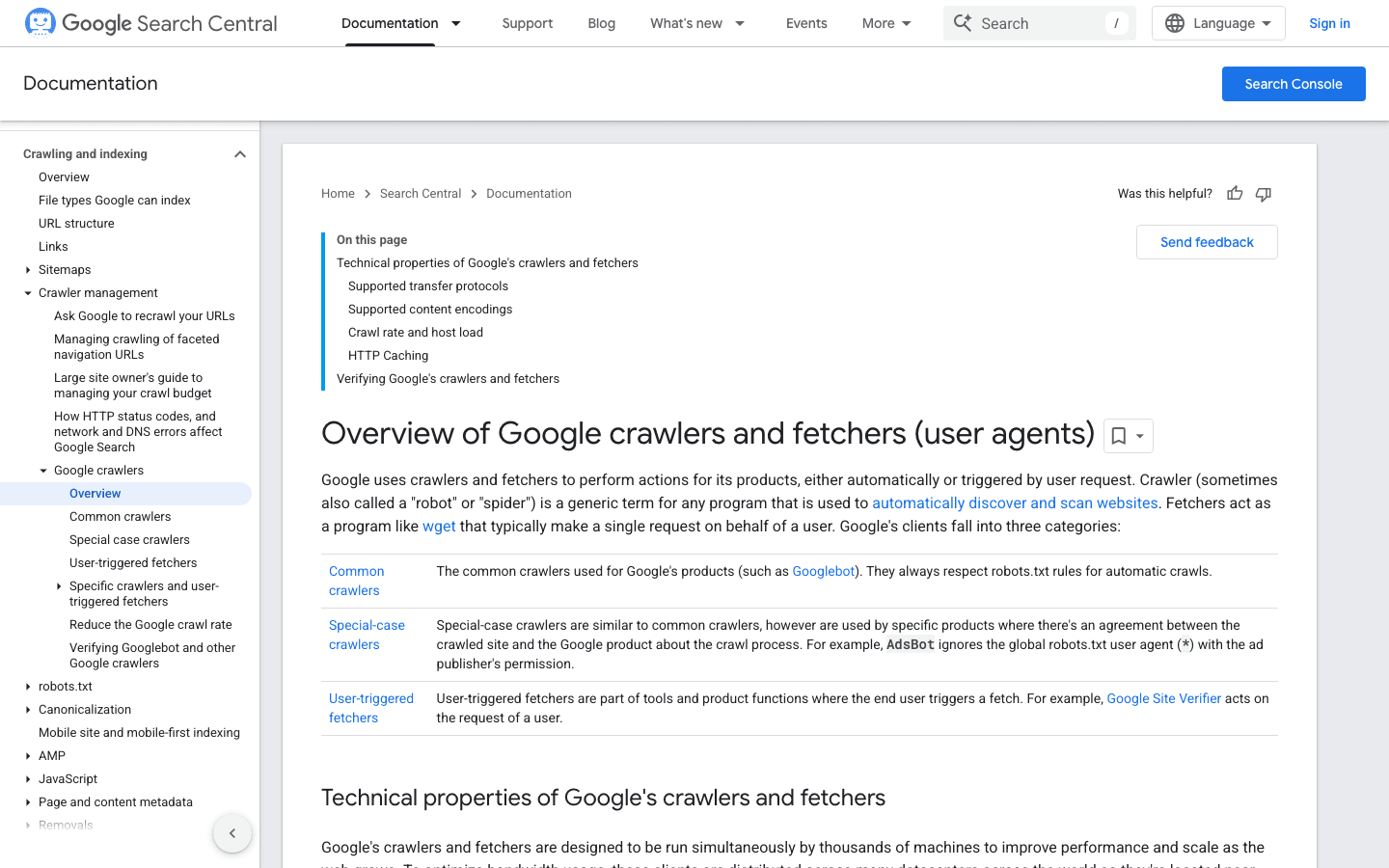

2. Googlebot: De Standaard voor Zoekmachines

is dé referentie onder webcrawlers. Deze bot indexeert je site voor Google Search—blokkeer je hem, dan kun je je digitale etalage net zo goed sluiten.

- User-Agent:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Verificatie: Gebruik of de .

- Beheeradvies: Sta Googlebot altijd toe. Gebruik robots.txt om het crawlgedrag te sturen (niet te blokkeren) en pas indien nodig de crawlrate aan in Google Search Console.

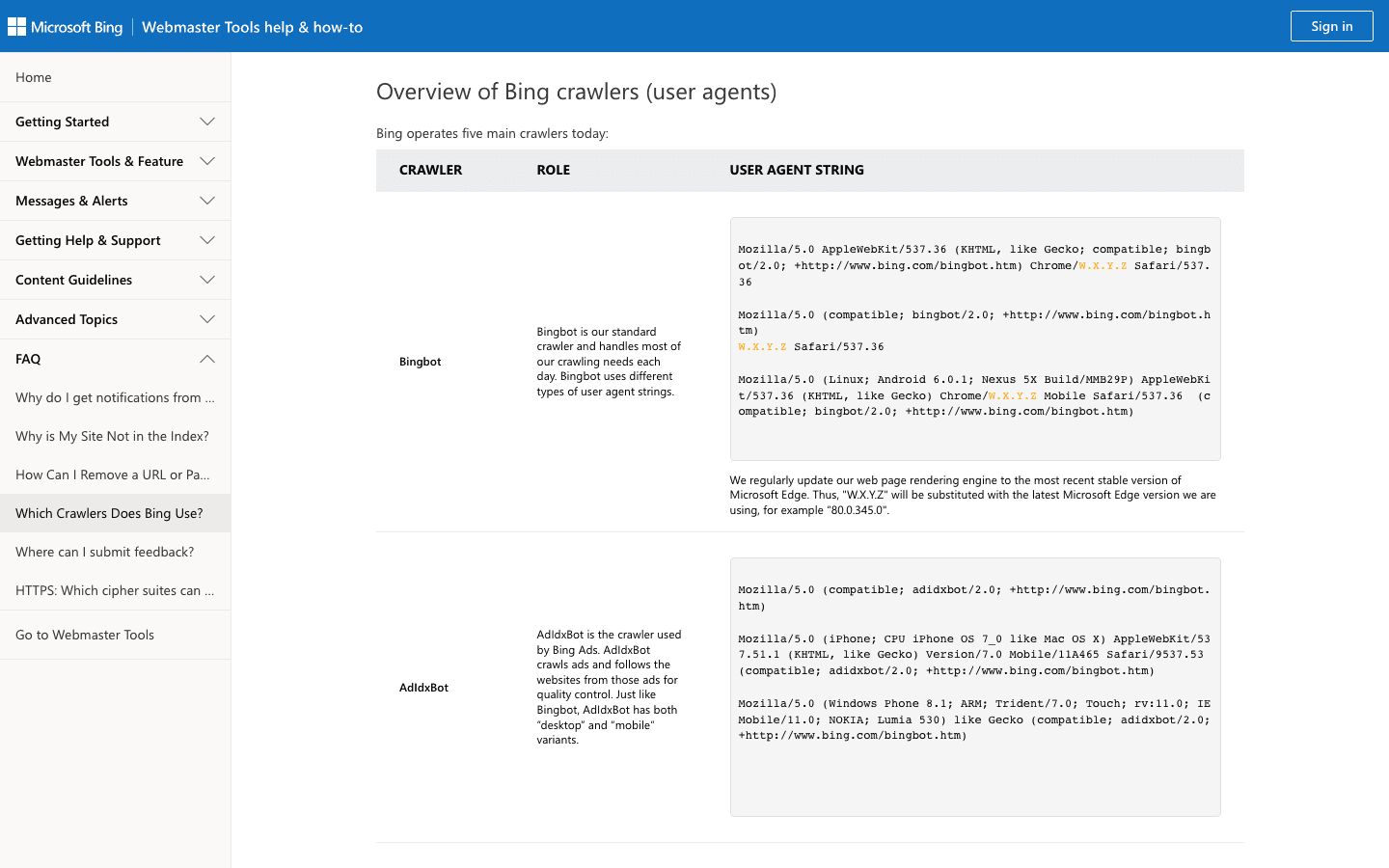

3. Bingbot: Microsoft’s Webverkenner

verzorgt de zoekresultaten van Bing en Yahoo. Voor de meeste sites is dit de op één na belangrijkste crawler.

- User-Agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - Verificatie: Gebruik en de .

- Beheeradvies: Sta Bingbot toe, beheer de crawlrate via Bing Webmaster Tools en gebruik robots.txt voor fijnregeling.

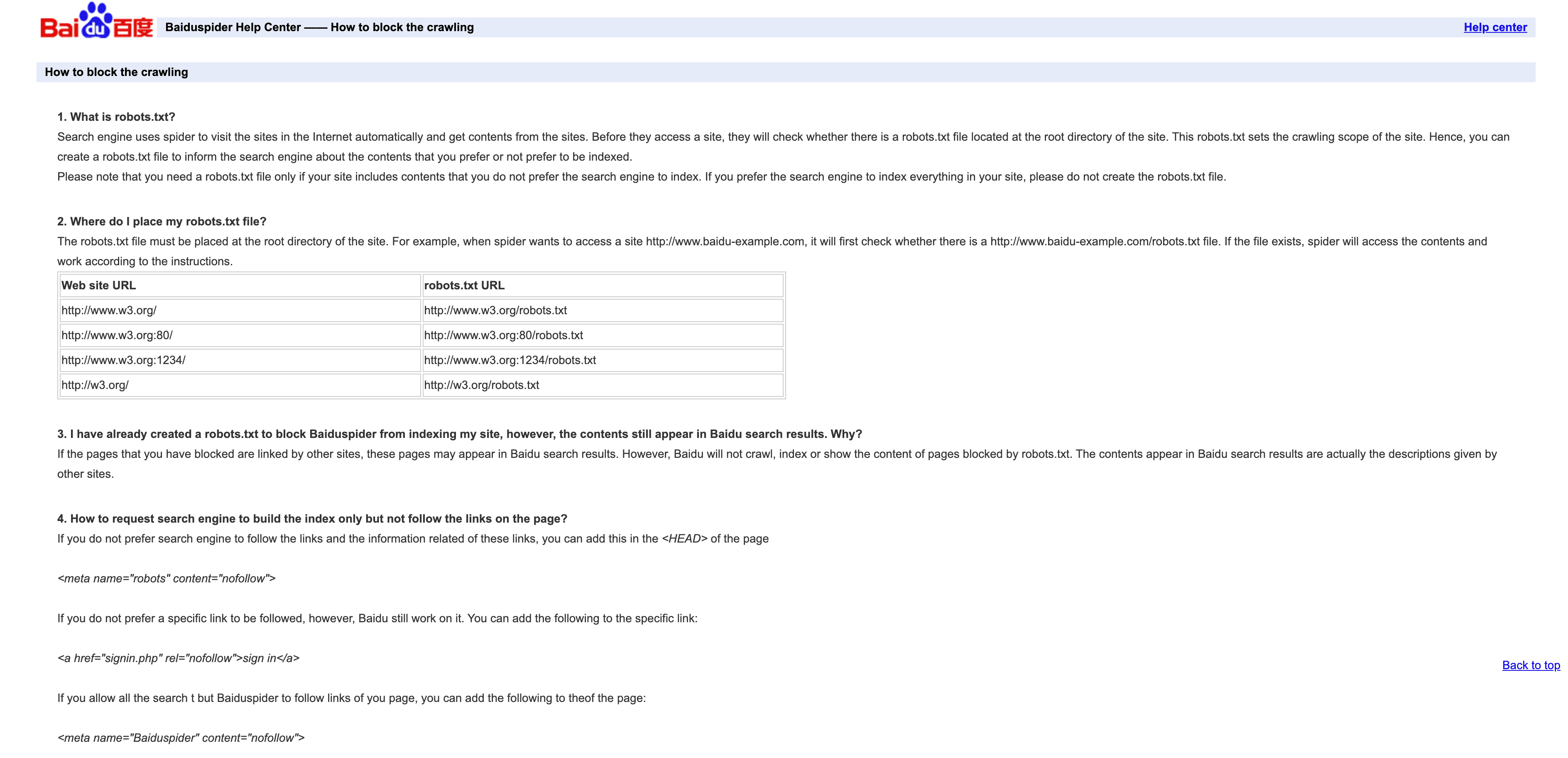

4. Baiduspider: De Grootste Zoekbot van China

is de toegangspoort tot Chinees zoekverkeer.

- User-Agent:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - Verificatie: Geen officiële IP-lijst; controleer op

.baidu.comin reverse DNS, maar let op beperkingen. - Beheeradvies: Sta toe als je Chinees verkeer wilt. Gebruik robots.txt voor regels, maar Baiduspider negeert die soms. Geen interesse in China? Overweeg te beperken of blokkeren om bandbreedte te besparen.

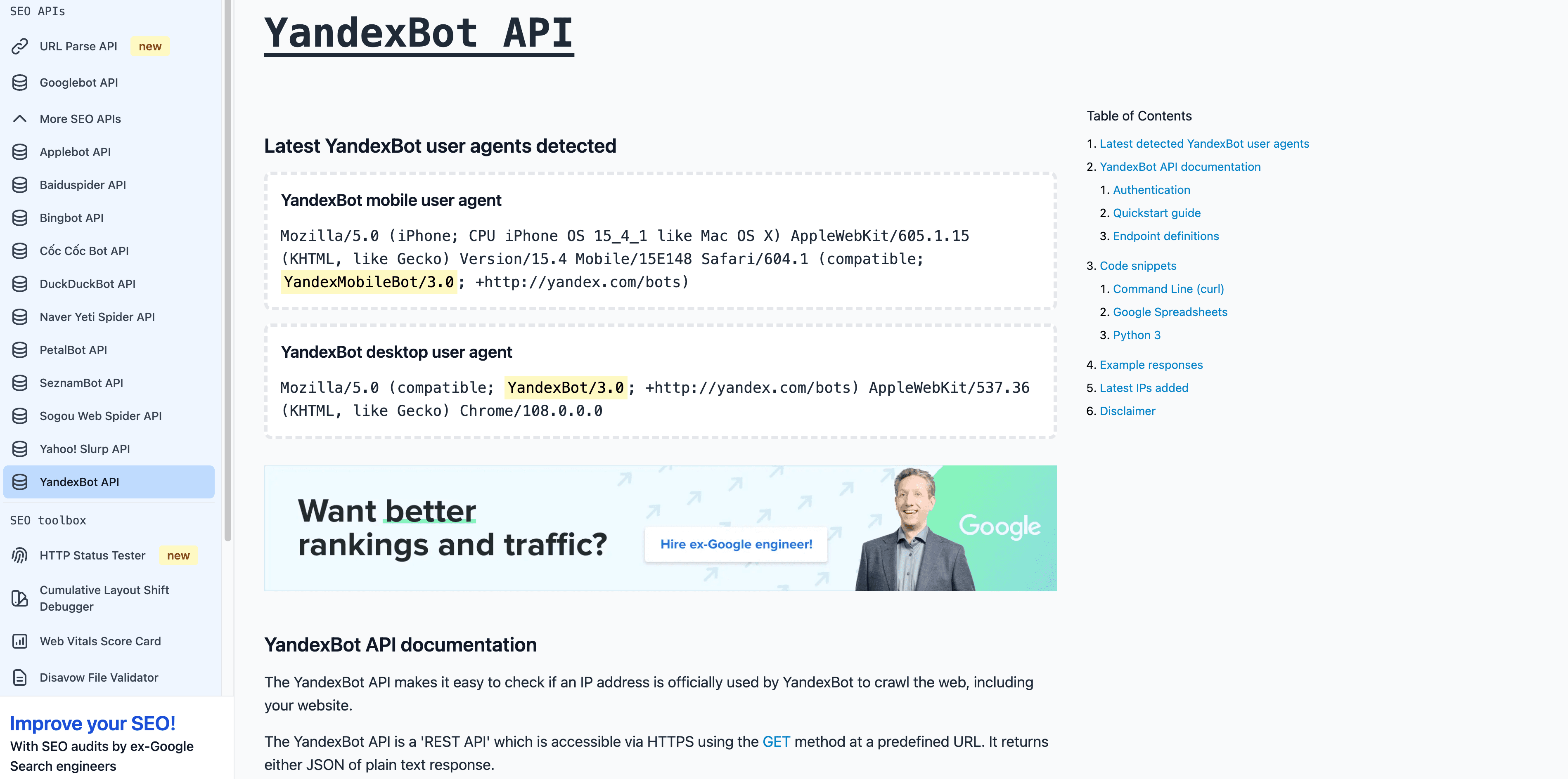

5. YandexBot: De Zoekbot van Rusland

is essentieel voor Rusland en de GOS-landen.

- User-Agent:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - Verificatie: Reverse DNS moet eindigen op

.yandex.ru,.yandex.netof.yandex.com. - Beheeradvies: Sta toe als je Russische gebruikers wilt bereiken. Gebruik Yandex Webmaster voor crawlbeheer.

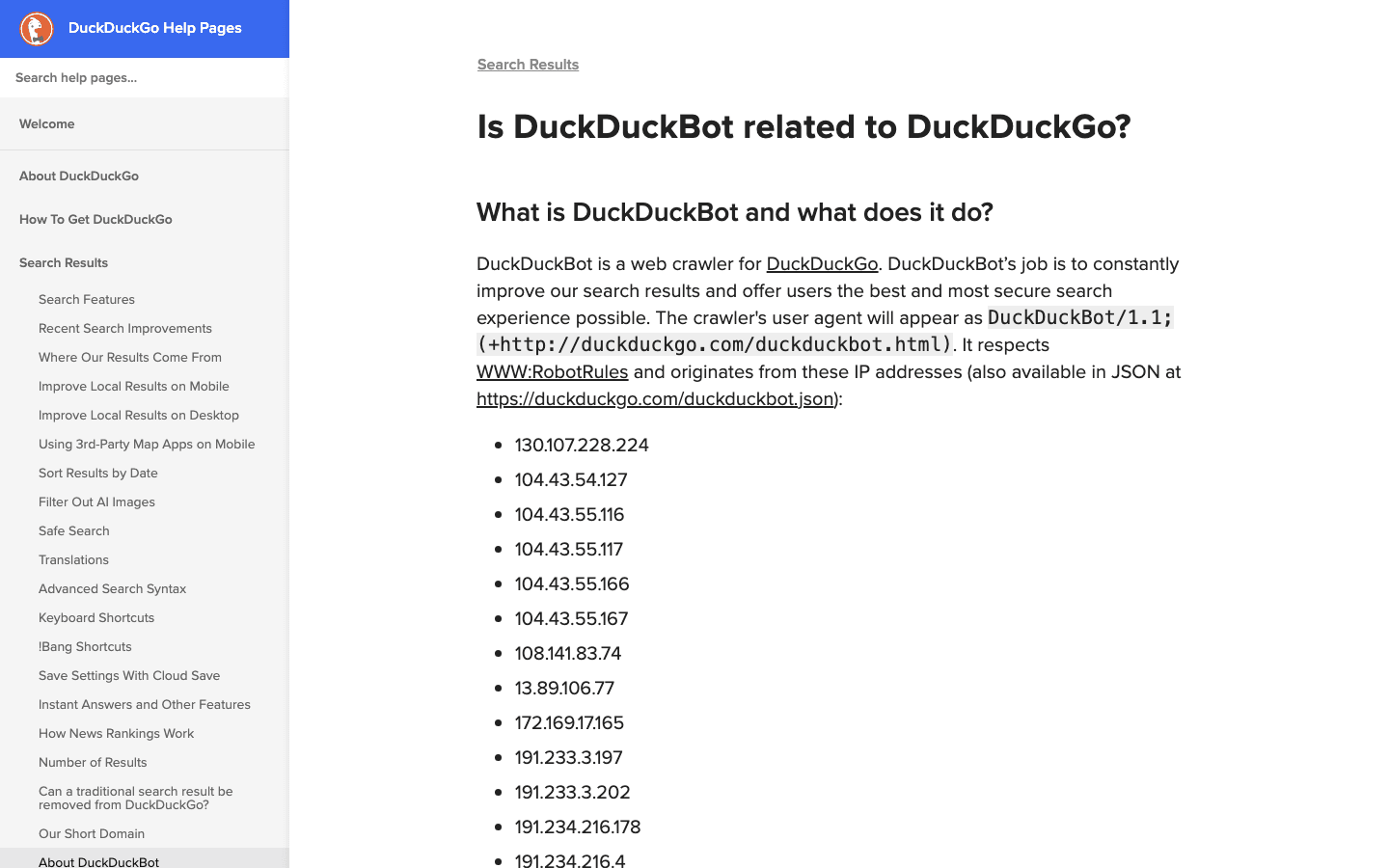

6. DuckDuckBot: Privacygerichte Zoekbot

is de crawler van DuckDuckGo, gericht op privacy.

- User-Agent:

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - Verificatie: .

- Beheeradvies: Sta toe tenzij je geen privacygerichte gebruikers wilt. Lage crawlbelasting, eenvoudig te beheren.

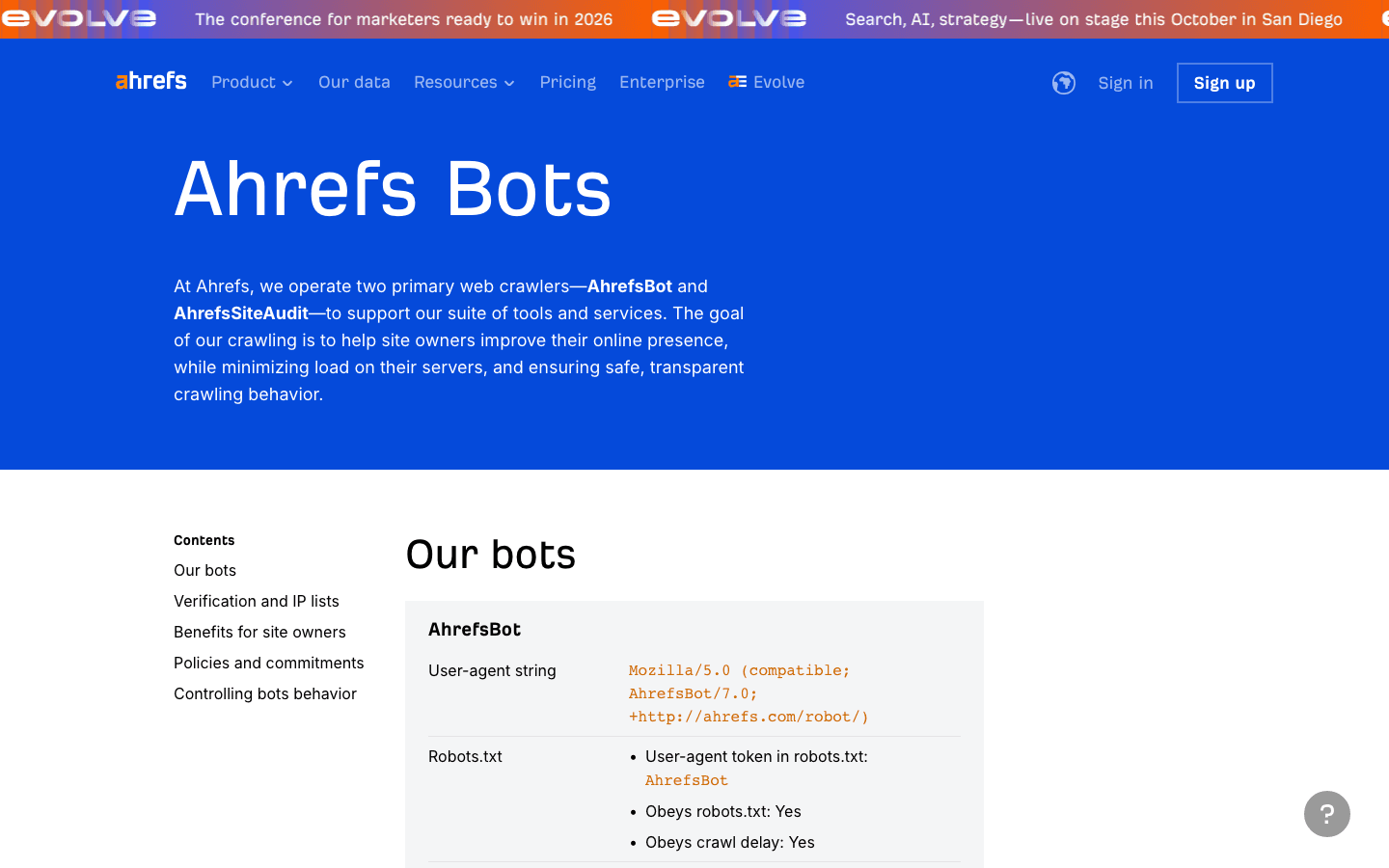

7. AhrefsBot: SEO- en Backlinkanalyse

is een van de populairste SEO-tool crawlers—handig voor backlinkanalyse, maar kan veel bandbreedte gebruiken.

- User-Agent:

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - Verificatie: Geen publieke IP-lijst; verifieer via UA en reverse DNS.

- Beheeradvies: Sta toe als je Ahrefs gebruikt. Gebruik robots.txt voor crawl-delay of blokkering. Je kunt .

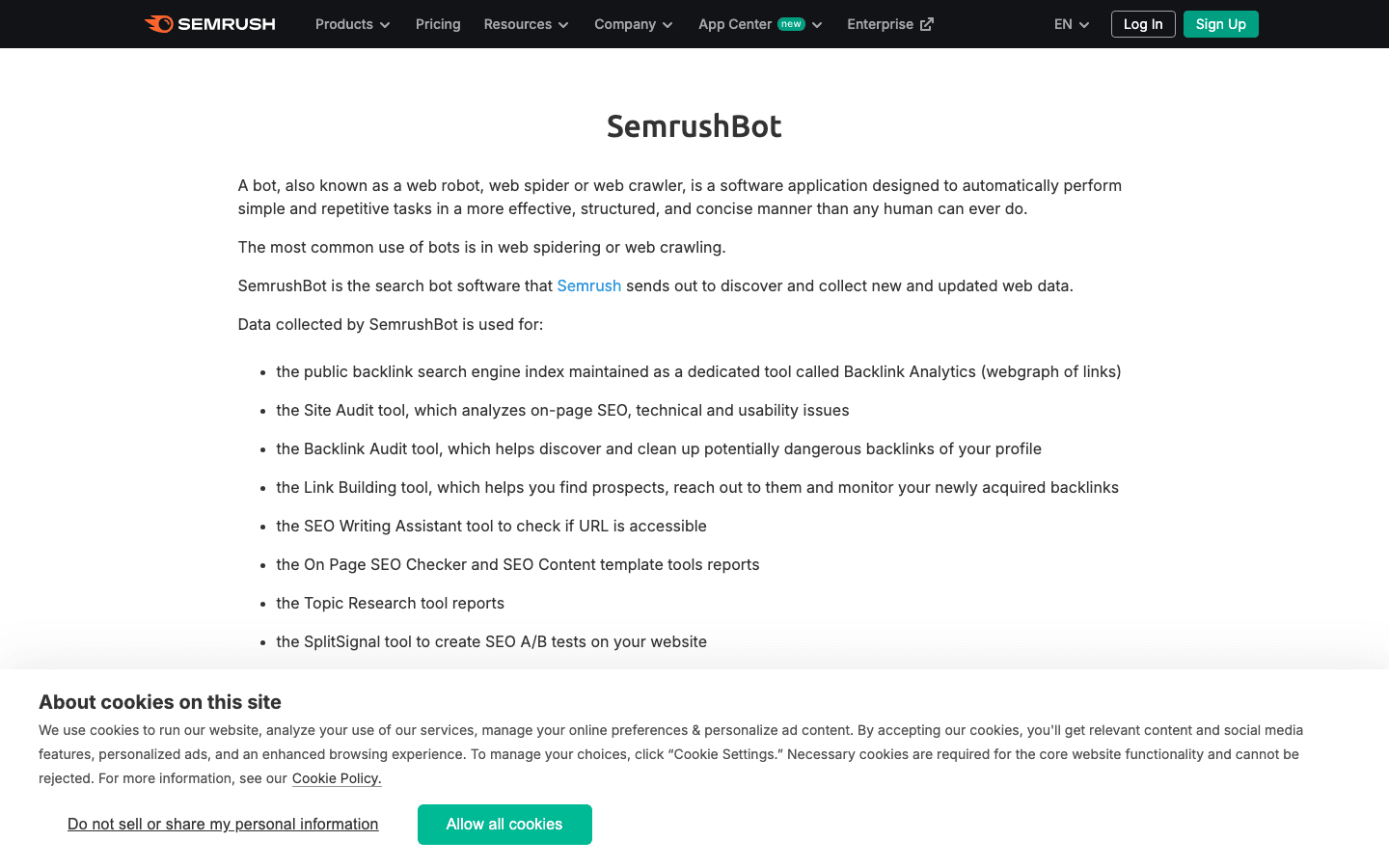

8. SemrushBot: SEO-concurrentieanalyse

is een andere grote SEO-crawler.

- User-Agent:

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(plus varianten zoalsSemrushBot-BA,SemrushBot-SI, enz.) - Verificatie: Op basis van user-agent; geen publieke IP-lijst.

- Beheeradvies: Sta toe als je Semrush gebruikt, anders beperken of blokkeren via robots.txt of serverregels.

9. FacebookExternalHit: Social Media Preview Bot

haalt Open Graph-data op voor Facebook- en Instagram-linkvoorbeelden.

- User-Agent:

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - Verificatie: Op basis van user-agent; IP’s behoren tot Facebook’s ASN.

- Beheeradvies: Sta toe voor rijke social previews. Blokkeren betekent geen thumbnails of samenvattingen op Facebook/Instagram.

10. Twitterbot: X (Twitter) Link Preview Crawler

haalt Twitter Card-data op voor X (Twitter).

- User-Agent:

Twitterbot/1.0 - Verificatie: Op basis van user-agent; Twitter ASN (AS13414).

- Beheeradvies: Sta toe voor Twitter-previews. Gebruik Twitter Card meta tags voor optimale weergave.

Vergelijkingstabel: Overzicht van Crawlers

| Crawler | Doel | User-Agent Voorbeeld | Verificatiemethode | Zakelijke Impact | Beheeradvies |

|---|---|---|---|---|---|

| Thunderbit | AI log/crawler analyse | N.v.t. (tool, geen bot) | N.v.t. | Databeheer, botclassificatie | Gebruik voor logextractie, allowlist opbouw |

| Googlebot | Google Search indexering | Googlebot/2.1 | DNS & IP-lijst | Essentieel voor SEO | Altijd toestaan, beheer via Search Console |

| Bingbot | Bing/Yahoo Search | bingbot/2.0 | DNS & IP-lijst | Belangrijk voor Bing/Yahoo SEO | Toestaan, beheer via Bing Webmaster Tools |

| Baiduspider | Baidu Search (China) | Baiduspider/2.0 | Reverse DNS, UA string | Belangrijk voor China SEO | Toestaan bij focus op China, monitor bandbreedte |

| YandexBot | Yandex Search (Rusland) | YandexBot/3.0 | Reverse DNS naar .yandex.ru | Belangrijk voor Rusland/Oost-Europa | Toestaan bij focus op RU/CIS, gebruik Yandex tools |

| DuckDuckBot | DuckDuckGo Search | DuckDuckBot/1.1 | Officiële IP-lijst | Privacygericht publiek | Toestaan, lage impact |

| AhrefsBot | SEO/backlink analyse | AhrefsBot/7.0 | UA string, reverse DNS | SEO-tool, kan veel bandbreedte gebruiken | Toestaan/beperken/blokkeren via robots.txt |

| SemrushBot | SEO/concurrentieanalyse | SemrushBot/1.0 (plus varianten) | UA string | SEO-tool, kan agressief zijn | Toestaan/beperken/blokkeren via robots.txt |

| FacebookExternalHit | Social link previews | facebookexternalhit/1.1 | UA string, Facebook ASN | Social media engagement | Toestaan voor previews, gebruik OG tags |

| Twitterbot | Twitter link previews | Twitterbot/1.0 | UA string, Twitter ASN | Twitter engagement | Toestaan voor previews, gebruik Twitter Card tags |

Je Crawlerlijst Beheren: Best Practices voor 2025

- Regelmatig Updaten: De wereld van crawlers verandert snel. Plan kwartaalreviews in en gebruik tools als Thunderbit om officiële lijsten te scrapen en te vergelijken ().

- Verifieer, Vertrouw Niet: Controleer altijd zowel user-agent als IP/ASN. Laat geen nep-bots je analytics vervuilen of je data scrapen ().

- Allowlist Goede Bots: Zorg dat zoek- en social crawlers nooit geblokkeerd worden door anti-botregels of firewalls.

- Beperk of Blokkeer Agressieve Bots: Gebruik robots.txt, crawl-delay of serverregels voor SEO-tools die te veel verzoeken doen.

- Automatiseer Loganalyse: Gebruik AI-tools (zoals Thunderbit) om crawleractiviteit te extraheren, classificeren en labelen—zo bespaar je tijd en ontdek je trends die je anders mist.

- Balans tussen SEO, Analytics en Security: Blokkeer niet de bots die je business vooruithelpen, maar laat de slechte ook niet vrij spel hebben.

Conclusie: Houd je Crawlerlijst Actueel en Waardevol

In 2025 is het beheren van je crawlerlijst geen IT-bijzaak meer—het is essentieel voor SEO, analytics, beveiliging en compliance. Nu bots het grootste deel van het webverkeer uitmaken, moet je weten wie je site bezoekt, waarom en wat je ermee doet. Houd je lijst actueel, automatiseer waar mogelijk en gebruik tools als om voorop te blijven lopen. Het web wordt alleen maar drukker—en een slimme, actiegerichte crawlerstrategie is je beste verdediging (en aanval) in een wereld vol bots.

Veelgestelde Vragen

1. Waarom is het belangrijk om een actuele crawlerlijst te hebben?

Omdat bots nu meer dan de helft van al het webverkeer uitmaken, en slechts een klein deel daarvan nuttig is. Een actuele lijst zorgt ervoor dat je de goede bots (voor SEO en social previews) toelaat en de slechte blokkeert of beperkt, zodat je analytics, bandbreedte en data veilig blijven.

2. Hoe herken ik of een crawler echt is of nep?

Vertrouw niet alleen op de user-agent—controleer altijd het IP-adres of ASN via officiële lijsten of reverse DNS. Tools als Thunderbit kunnen dit proces automatiseren door logs te matchen met gepubliceerde bot-IP’s en user-agents.

3. Wat moet ik doen als een onbekende bot mijn site crawlt?

Onderzoek de user-agent en het IP-adres. Staat deze niet op je allowlist en komt het niet overeen met een bekende bot, overweeg dan te beperken, uit te dagen of te blokkeren. Gebruik AI-tools om nieuwe crawlers te classificeren en te monitoren.

4. Hoe helpt Thunderbit bij crawlerbeheer?

Thunderbit gebruikt AI om crawleractiviteit uit logs te extraheren, structureren en classificeren, zodat je eenvoudig allowlists kunt opbouwen, nep-bots herkent en beleid automatisch kunt afdwingen. De semantische voorbewerking is vooral krachtig voor complexe of dynamische sites.

5. Wat is het risico als ik een grote crawler zoals Googlebot of Bingbot blokkeer?

Als je zoekmachinecrawlers blokkeert, kan je site uit de zoekresultaten verdwijnen, waardoor je organisch verkeer wegvalt. Controleer altijd je firewall, robots.txt en anti-botregels om te voorkomen dat je per ongeluk de belangrijkste bots buitensluit.

Meer weten: