Stel je het volgende scenario voor: het is maandagochtend, je zit aan je koffie en je inbox loopt alweer vol met meldingen. Wéér haalt een AI-tool het nieuws vanwege een datalek. Je CEO wil uitleg, de juridische afdeling is alert en je klanten? Die stellen kritische vragen over wat er met hun gegevens gebeurt in al die ‘slimme’ systemen die je het afgelopen kwartaal hebt uitgerold. Welkom in 2026, waar ai gegevensprivacy niet langer alleen een IT-ding is, maar een strategisch speerpunt op directieniveau dat het imago van je merk én je carrière kan maken of breken.

De realiteit is dat AI inmiddels niet meer weg te denken is uit het bedrijfsleven, van sales en marketing tot vastgoed en e-commerce. Maar hoe breder AI wordt ingezet, hoe groter de risico’s. Alleen al het afgelopen jaar steeg het aantal incidenten rond ai privacy statistieken met maar liefst 56%, en wereldwijd vertrouwt nog maar 47% van de mensen AI-bedrijven met hun persoonlijke data—en dat percentage daalt snel (, ). Als iemand die jarenlang SaaS- en automatiseringsplatforms heeft gebouwd (en nu medeoprichter is van ), kan ik je vertellen: de nieuwste ai privacy statistieken kennen is geen vinkje op de compliance-checklist, maar het verschil tussen bloeien en overleven in het digitale tijdperk.

De stand van zaken rond AI-privacy in 2026: Belangrijkste cijfers

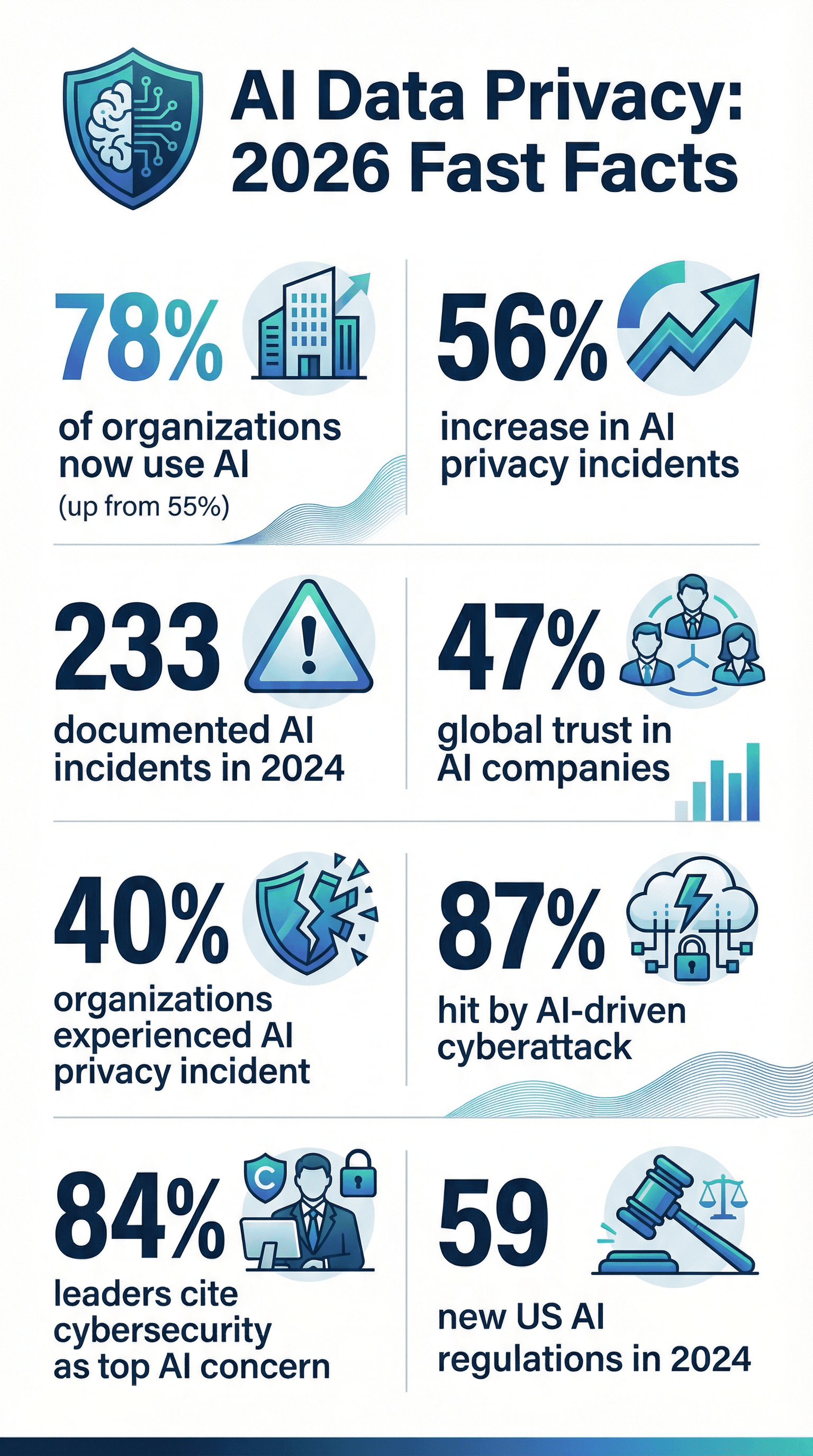

Laten we meteen ter zake komen. Zoek je de kerncijfers voor je volgende boardmeeting of klantpresentatie? Dit zijn de meest opvallende ai privacy statistieken voor 2026:

- AI is overal: 78% van de organisaties gebruikte AI in 2024, tegenover 55% een jaar eerder ().

- Incidenten nemen toe: Het aantal privacy- en beveiligingsincidenten rond AI steeg met 56% in één jaar, met 233 geregistreerde gevallen in 2024 ().

- Datalekken zijn aan de orde van de dag: 40% van de organisaties heeft al een AI-gerelateerd privacy-incident meegemaakt (), en 21% werd het afgelopen jaar getroffen door een cyberaanval ().

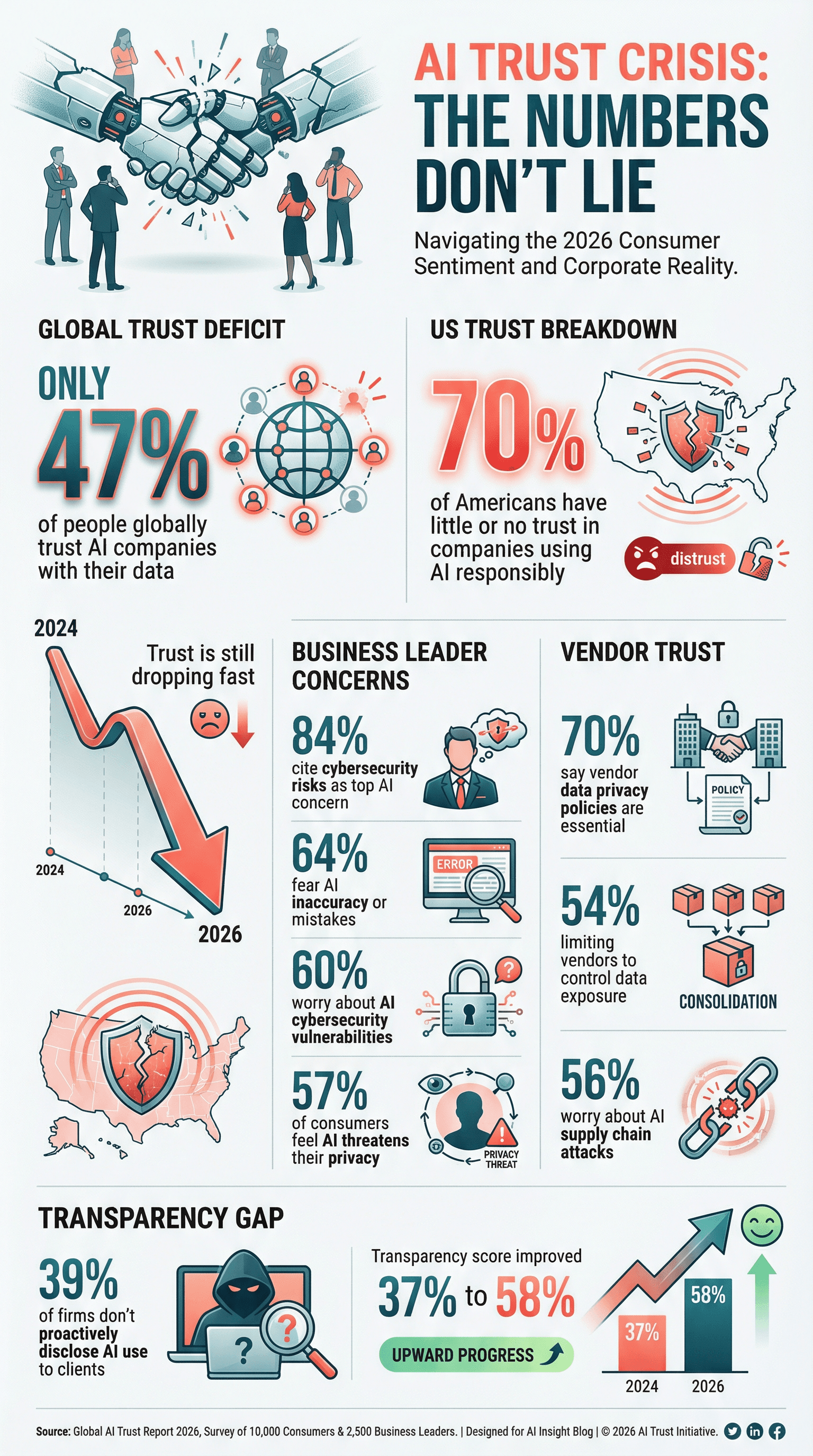

- Weinig vertrouwen: Slechts 47% van de mensen wereldwijd vertrouwt AI-bedrijven met hun data, en in de VS heeft 70% weinig tot geen vertrouwen dat bedrijven AI op een verantwoorde manier inzetten ().

- Privacy is topprioriteit: 61% van de organisaties zet cybersecurity—waaronder ai gegevensprivacy—nu in hun top drie strategische prioriteiten ().

- Strenge leveranciersselectie: 70% van de organisaties vindt het privacybeleid van een leverancier doorslaggevend bij het kiezen van AI- en techpartners ().

- AI-risico’s baren zorgen: 84% van de zakelijke leiders noemt cybersecurityrisico’s als grootste zorg bij AI-adoptie ().

- Regelgeving neemt toe: Amerikaanse federale instanties introduceerden 59 AI-gerelateerde regels in 2024, meer dan het dubbele van het jaar ervoor ().

- Beleid blijft achter: Slechts 43% van de bedrijven heeft een AI-governancebeleid, al werkt 77% er actief aan (, ).

- AI-gedreven cyberaanvallen zijn de norm: 87% van de organisaties kreeg het afgelopen jaar te maken met een AI-gedreven cyberaanval ().

Deze cijfers zijn geen weetjes, maar een wake-upcall voor iedereen die verantwoordelijk is voor data, compliance of digitale transformatie.

Waarom AI-privacy belangrijker is dan ooit

AI is niet zomaar een IT-upgrade—het verandert fundamenteel hoe organisaties data verzamelen, verwerken en gebruiken. In tegenstelling tot traditionele software leren AI-systemen vaak van enorme, rommelige datasets, van klantmails tot medische dossiers. Het verraderlijke? AI-modellen kunnen informatie ‘onthouden’ en onverwacht reproduceren, waardoor gevoelige data onbedoeld naar buiten kan komen ().

De schaal is gigantisch. Eén AI-model kan miljoenen records verwerken of data van het hele web verzamelen—soms zonder expliciete toestemming. De verantwoordelijkheid om die data te beschermen is dus groter dan ooit. En omdat AI razendsnel beslissingen neemt (denk aan: kredietaanvragen goedkeuren, sollicitanten screenen), kunnen fouten of vooroordelen zich in no-time verspreiden, met privacy- en zelfs mensenrechtenproblemen tot gevolg.

Denk je: “We hebben een privacybeleid, dus we zitten goed”? Helaas, AI brengt nieuwe risico’s met zich mee—zoals datavervuiling, modelinversie en aanvallen die traditionele beveiliging niet aankan. En de reputatieschade na een AI-privacy-incident? Die is enorm. Klanten vertrekken, toezichthouders delen boetes uit en je merk kan jaren nodig hebben om te herstellen. In 2026 draait ai gegevensprivacy niet alleen om regels naleven, maar om overleven.

AI-privacycijfers: Adoptie, zorgen en compliance

AI is bijna overal ingeburgerd

Laten we eerlijk zijn: AI is geen ‘opkomende technologie’ meer. Het is mainstream. In 2024 gebruikte 78% van de organisaties AI, tegenover 55% een jaar eerder (). In sectoren als juridisch en financieel ligt dat percentage nog hoger—42% van de advocatenkantoren gebruikte AI-tools in 2025, bijna een verdubbeling ten opzichte van het jaar ervoor (). Door deze explosieve groei wordt er meer data verzameld, geanalyseerd en soms ook blootgesteld.

Privacyzorgen nemen toe

Met grote kracht komt grote verantwoordelijkheid—en veel onrust. 57% van de consumenten wereldwijd vindt dat AI een serieuze bedreiging vormt voor hun privacy (). In de VS vertrouwt 70% van de mensen die AI kennen bedrijven nauwelijks of niet met AI-verzamelde data (). Ook bij leidinggevenden leeft de zorg: 64% vreest fouten of onnauwkeurigheid door AI, en 60% noemt AI-gerelateerde cyberrisico’s als groot probleem ().

Met grote kracht komt grote verantwoordelijkheid—en veel onrust. 57% van de consumenten wereldwijd vindt dat AI een serieuze bedreiging vormt voor hun privacy (). In de VS vertrouwt 70% van de mensen die AI kennen bedrijven nauwelijks of niet met AI-verzamelde data (). Ook bij leidinggevenden leeft de zorg: 64% vreest fouten of onnauwkeurigheid door AI, en 60% noemt AI-gerelateerde cyberrisico’s als groot probleem ().

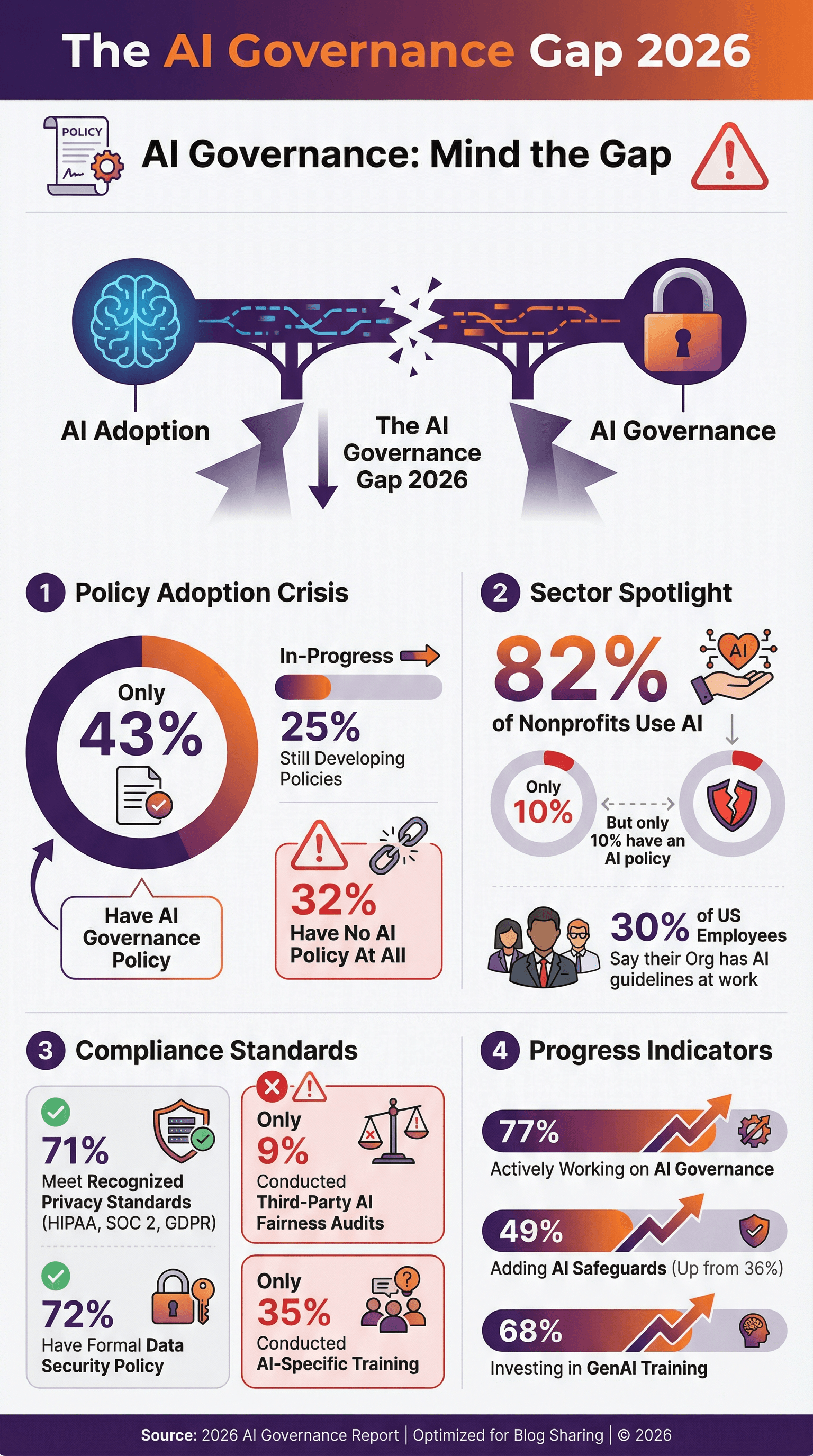

Compliance: Een bewegend doelwit

Organisaties proberen te voldoen aan regels als GDPR, CCPA, HIPAA en SOC 2—maar AI zorgt vaak voor nieuwe uitdagingen. 71% van de organisaties zegt aan erkende privacy-standaarden te voldoen (), en 72% heeft een formeel databeveiligingsbeleid. Maar minder dan de helft heeft een specifiek AI-governance- of ethiekbeleid. Slechts 43% van de organisaties heeft zo’n beleid, en nog eens 25% werkt eraan (, ). De rest? Die varen blind.

Adoptie van AI-privacybeleid

Formele AI-privacyregels zijn razendsnel van ‘nice-to-have’ naar ‘must-have’ gegaan. Maar de cijfers laten zien dat er nog een flinke kloof is:

- Slechts 43% van de bedrijven heeft een AI-governancebeleid, met nog eens 25% in ontwikkeling ().

- In de VS zegt slechts 30% van de werknemers dat hun organisatie richtlijnen of beleid heeft voor AI op de werkvloer ().

- Bij non-profits gebruikt 82% AI, maar heeft slechts 10% een AI-beleid ().

- Het goede nieuws? 77% van de organisaties werkt actief aan AI-governance, en bij intensieve AI-gebruikers loopt dat op tot bijna 90% ().

Voorlopers passen hun beleid aan met verboden AI-toepassingen, verplichte menselijke controle en afspraken over eerlijkheid en transparantie. Nog niet begonnen? Wacht niet tot een incident of nieuwe wet je dwingt.

AI-privacy-audits en certificeringen

Beleid is mooi, maar audits en certificaten laten zien dat je het echt serieus neemt.

- 71% van de bedrijven voldoet aan erkende standaarden als HIPAA, SOC 2 of GDPR ().

- 51% eist HIPAA-compliance van leveranciers voor gezondheidsdata, en 45% verlangt end-to-end encryptie ().

- Slechts 9% van de organisaties heeft een externe audit laten uitvoeren op AI-bias of eerlijkheid—maar dat aantal zal stijgen naarmate regelgeving toeneemt ().

Certificeringen als SOC 2, ISO 27001 en HITRUST worden steeds belangrijker als bewijs van betrouwbaarheid. Ben je leverancier? Klanten gaan om bewijs vragen. Ben je inkoper? Check of je partners voldoen.

AI-cybersecurity: Dreigingen, incidenten en respons

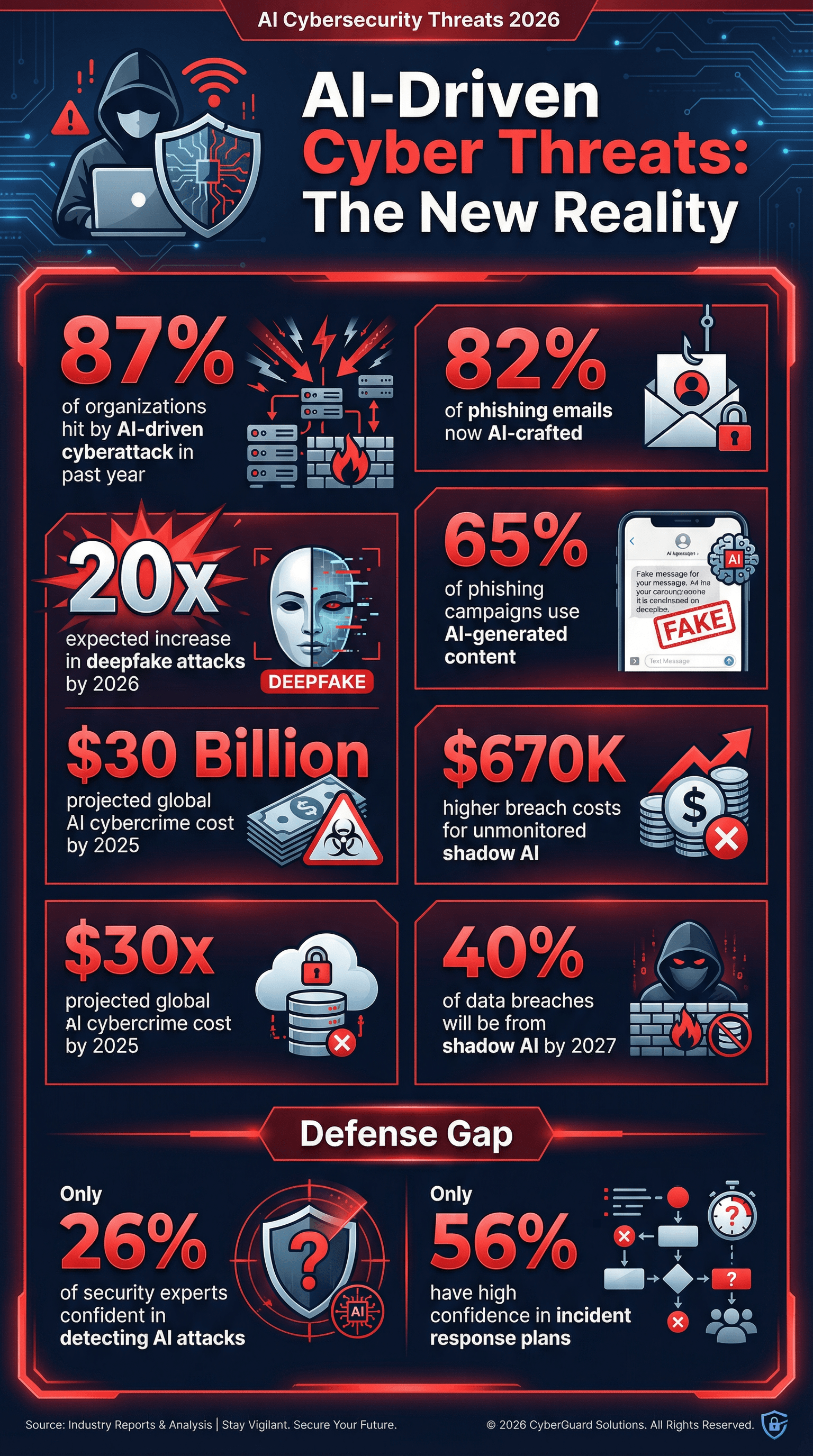

Laten we het beestje bij de naam noemen: AI is niet alleen doelwit van cyberaanvallen, maar ook een wapen voor aanvallers. En de cijfers zijn ronduit zorgwekkend.

- 87% van de organisaties kreeg het afgelopen jaar te maken met een AI-gedreven cyberaanval ().

- 65% van de phishingcampagnes gebruikt nu AI-gegenereerde content om betrouwbare communicatie na te bootsen ().

- 82% van de phishingmails wordt geschat met AI gemaakt te zijn ().

- Deepfake-aanvallen zullen naar verwachting 20 keer vaker voorkomen in 2026 ().

- Shadow AI (ongeautoriseerd AI-gebruik door medewerkers) is een groeiend risico—Gartner voorspelt dat 40% van de datalekken in 2027 te wijten zal zijn aan misbruik van AI of ‘shadow AI’-systemen ().

En een cijfer waar CISO’s van wakker liggen: slechts 26% van de security-experts heeft veel vertrouwen in het detecteren van AI-gedreven aanvallen (). Dat is alsof je verstoppertje speelt met een illusionist van wereldklasse.

AI-gedreven cyberaanvallen: Wat laten de cijfers zien?

- 87% van de organisaties kreeg het afgelopen jaar te maken met een AI-ondersteunde aanval ().

- Phishing wordt slimmer: Eind 2025 was meer dan 82% van de phishingmails AI-gegenereerd ().

- Deepfakes nemen explosief toe: Deepfake audio/video-aanvallen zullen naar verwachting 20 keer vaker voorkomen in 2026.

- Shadow AI is risicovol: In 2027 zal 40% van de datalekken te wijten zijn aan misbruik van AI of ‘shadow AI’ ().

- Kosten van datalekken stijgen: Organisaties zonder toezicht op AI of met shadow AI hadden gemiddeld $670.000 hogere kosten per datalek dan bedrijven met strengere controle ().

- Wereldwijde schade: AI-gedreven cybercriminaliteit zal naar verwachting $30 miljard bedragen in 2025 ().

Doe je nog geen phishingtests met AI-mails of test je je beveiliging niet tegen deepfakes? Dan neem je een groot risico.

Investeringen in AI-cybersecurity

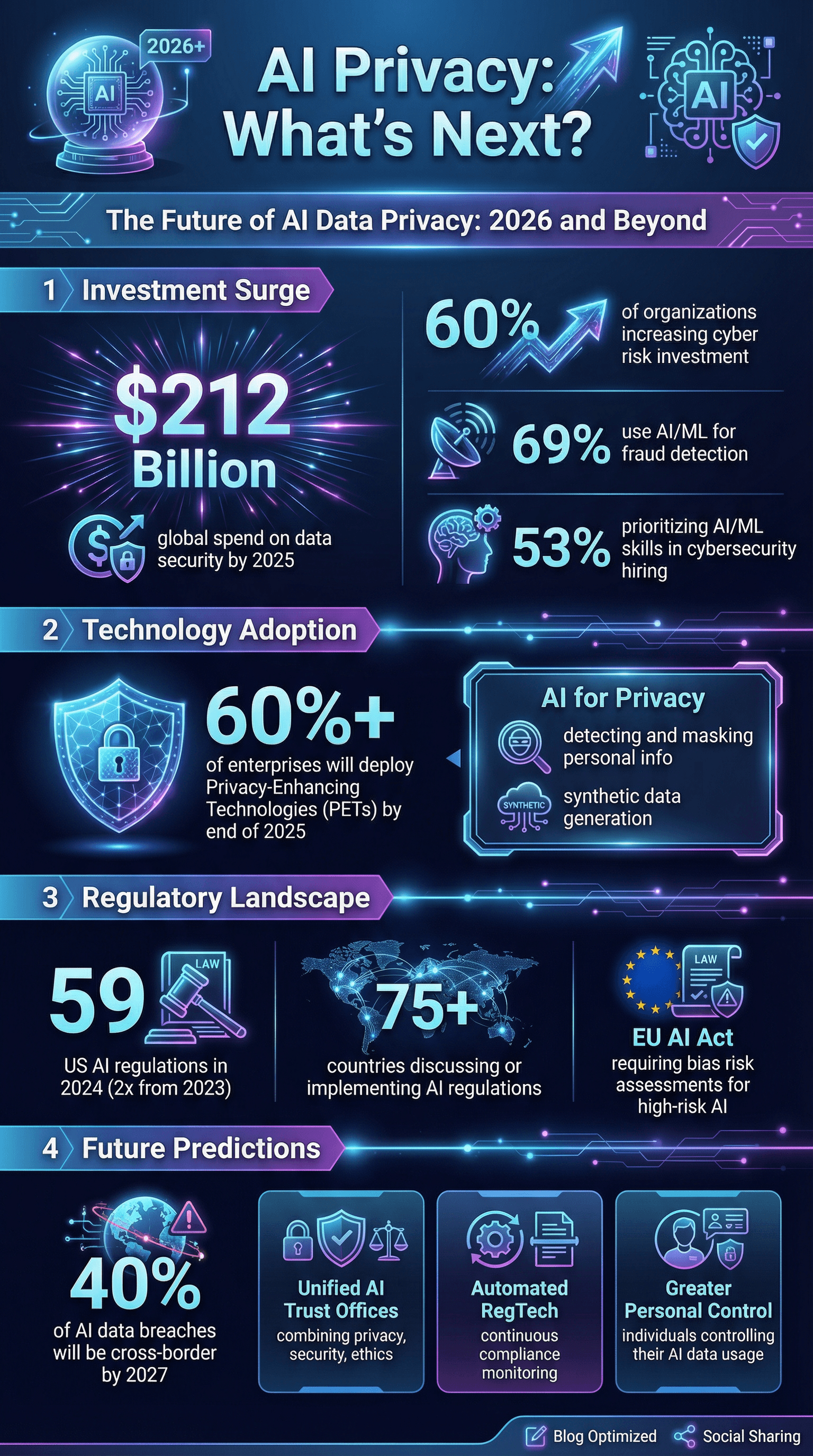

Het goede nieuws? Organisaties investeren meer dan ooit in ai cybersecurity:

- 60% van de organisaties verhoogt de investeringen in cyberrisicobeheersing, mede door AI ().

- 69% gebruikt AI of machine learning voor fraudedetectie en -preventie ().

- 53% geeft prioriteit aan AI- en ML-vaardigheden bij cybersecurity-werving ().

- Wereldwijde uitgaven aan databeveiliging en risicomanagement zullen naar verwachting $212 miljard bedragen in 2025 ().

Toch is er een gat: slechts 56% van de organisaties heeft veel vertrouwen in hun incident response-plannen voor cyberaanvallen, en nog minder hebben specifieke plannen voor AI-incidenten.

AI-databeheer: Training, toezicht en bias-mitigatie

Je kunt de beste technologie hebben, maar als je mensen en processen niet op orde zijn, blijf je kwetsbaar.

- Slechts 35% van de organisaties heeft AI-specifieke training gegeven over privacy, security of ethiek ().

- 68% van de bedrijven investeert in generatieve AI-training voor medewerkers ().

- 30% vertrouwt op menselijke controle als maatregel voor AI-beveiliging ().

- Slechts 9% gebruikt onafhankelijke audits voor AI-bias ().

- 49% is bezig met het toevoegen van AI-governance-maatregelen, een stijging ten opzichte van 36% het jaar ervoor.

Bias is ook een groot privacyprobleem. AI-systemen die persoonlijke data anders behandelen op basis van bijvoorbeeld geslacht of afkomst, kunnen leiden tot ongelijke privacy-schade en zelfs juridische problemen. 46% van de bestuurders noemt verantwoord AI-gebruik—waaronder eerlijkheid—als topprioriteit voor hun AI-investeringen (). Maar het meten en aanpakken van bias is voor de meeste organisaties nog een uitdaging.

AI-bias en eerlijkheid: Privacygevolgen

- AI-incidenten met bias of veiligheidsproblemen nemen elk jaar fors toe ().

- 25% minder genderongelijkheid in aanbevelingen voor sollicitanten na bias-mitigatie bij sommige bedrijven.

- De druk vanuit regelgeving neemt toe: de EU’s GDPR en de aankomende AI Act vereisen bias-risicobeoordelingen voor ‘hoog-risico’ AI-systemen.

Test je AI niet op bias? Dan loop je niet alleen reputatieschade, maar ook juridische en commerciële risico’s.

Leveranciers- en ecosysteemrisico’s: Consolidatie en derde partijen

Geen enkel bedrijf staat op zichzelf. De meeste organisaties zijn afhankelijk van een netwerk van leveranciers, cloudproviders en partners—en die brengen allemaal privacyrisico’s met zich mee.

- 54% van de bedrijven beperkt het aantal leveranciers om kosten en data-exposure te beheersen ().

- 70% van de bedrijven vindt privacybeleid essentieel bij het selecteren van techleveranciers.

- 56% maakt zich zorgen over AI-gedreven aanvallen op de supply chain ().

De trend: minder leveranciers, strengere privacy-eisen en partners behandelen als verlengstuk van je eigen beveiliging.

Druk vanuit regelgeving en klanten: Transparantie en verantwoording bij AI-privacy

Toezichthouders en klanten stellen steeds hogere eisen. In 2024 waren er in de VS 59 AI-gerelateerde regelgevende acties, meer dan het dubbele van het jaar ervoor. Wereldwijd hebben minstens 75 landen AI-regelgeving besproken of ingevoerd ().

- Transparantie is de norm: Klanten verwachten openheid over AI-gebruik, maar 39% van de bedrijven geeft toe dat ze klanten niet proactief informeren ().

- Auditklaar zijn is essentieel: Zorg dat je bewijs van compliance kunt tonen—HIPAA, SOC 2, AI-tool-lijsten en databeheermaatregelen.

- Transparantiescores van grote AI-ontwikkelaars stegen van 37% naar 58% in slechts zes maanden ().

Niet klaar voor een audit of kritische klantvragen? Dan ben je niet klaar voor 2026.

De toekomst van AI-privacy: Verwachtingen en trends

Wat kunnen we verwachten? Dit zijn de belangrijkste ontwikkelingen volgens experts:

- Privacy als concurrentievoordeel: Bedrijven die kunnen aantonen dat hun AI veilig, privacyvriendelijk en ethisch is, winnen het vertrouwen van klanten ().

- Geïntegreerd toezicht: Verwacht aparte ‘AI Trust’-afdelingen die privacy, security en ethiek combineren.

- Privacy-Enhancing Technologies (PETs): Meer dan 60% van de bedrijven wil PETs inzetten tegen eind 2025 ().

- Geautomatiseerde compliance: RegTech voor AI wordt onmisbaar, met tools die AI-systemen continu monitoren op compliance.

- Internationale datarisico’s: In 2027 zal 40% van de AI-datalekken ontstaan door grensoverschrijdend datamisbruik ().

- Meer persoonlijke controle: Verwacht tools waarmee individuen zelf bepalen hoe hun data in AI wordt gebruikt.

- AI voor privacy: AI wordt ingezet om persoonlijke info te detecteren en te maskeren, synthetische data te genereren en meer.

- Incident response en veerkracht: Organisaties verschuiven van alleen preventie naar veerkracht, inclusief verzekeringen voor AI-incidenten en oefenen met herstel na datavervuiling of modelcorruptie.

Als iemand die gek is op automatisering en AI (en gezond paranoïde over privacy), geloof ik dat de winnaars van het komende decennium privacy en security als kernwaarde behandelen—niet als bijzaak.

Belangrijkste lessen: Wat betekenen de AI-privacycijfers van 2026 voor jouw organisatie?

Tot slot, een aantal concrete acties—want niemand wil volgend jaar het negatieve voorbeeld zijn:

- Maak ai gegevensprivacy een integraal onderdeel van je strategie. Niet achteraf toevoegen, maar vanaf het begin inbouwen.

- Voer grondige AI-risicoanalyses uit. Ken je AI-systemen, datastromen en risicopunten.

- Investeer in AI-specifieke training en governance. Laat je team niet de zwakke schakel zijn.

- Versterk technische beveiliging met AI in gedachten. Gebruik AI om AI te bestrijden—zet geavanceerde monitoring en detectie in.

- Zet in op streng leveranciersbeheer. Consolidatie, controle en bewijs van compliance zijn essentieel.

- Wees transparant. Vertel klanten en gebruikers wanneer en hoe je AI inzet—voordat iemand anders het doet.

- Implementeer privacyverhogende technologieën. Anonimiseer, versleutel en minimaliseer data waar mogelijk.

- Bereid je voor op het ergste. Heb een AI-incident responseplan en test dit regelmatig.

- Blijf op de hoogte van veranderende wetgeving en standaarden. De regels veranderen snel—wees voorbereid.

- Maak vertrouwen je kompas. In 2026 en daarna is vertrouwen je grootste kapitaal.

Bronnen en verder lezen

Wil je dieper duiken of heb je cijfers nodig voor je volgende presentatie? Dit zijn de beste bronnen die ik heb gebruikt voor dit overzicht:

- )

Meer weten over AI, automatisering en privacy? Check de of lees onze gidsen over en .