Webcrawlers zijn eigenlijk de onzichtbare helden van het internet. Elke keer dat je een nieuw recept zoekt, prijzen vergelijkt voor je favoriete sneakers of alvast hotels checkt voor je volgende trip, is de kans groot dat een webcrawler het zware werk al voor je heeft gedaan door info te verzamelen en te ordenen. Sterker nog, tegenwoordig is afkomstig van bots en crawlers, niet van mensen. Terwijl jij lekker ligt te slapen, zijn deze digitale speurneuzen dag en nacht bezig om het web in kaart te brengen, zodat jij altijd snel bij de juiste info kunt.

Maar wat zijn webcrawlers nou precies? Waarom zijn ze zo belangrijk voor bedrijven, onderzoekers en eigenlijk iedereen die up-to-date data nodig heeft? En hoe zorgen moderne tools zoals ervoor dat webcrawling voor iedereen toegankelijk wordt, niet alleen voor programmeurs of grote techspelers? Als iemand die al jaren werkt met automatisering en AI-tools, heb ik van dichtbij gezien hoe webcrawlers zijn veranderd van mysterieuze ‘spiders’ tot onmisbare tools voor het bedrijfsleven. Laten we samen de wereld van webcrawlers induiken: wat doen ze, hoe werken ze en waarom zijn ze in 2025 dé basis voor slimme data-toegang.

Webcrawlers: De dataspeurders van het web

Wat zijn webcrawlers nou eigenlijk? In de kern zijn webcrawlers (ook wel spiders of bots genoemd) geautomatiseerde programma’s die het internet systematisch afstruinen, van de ene webpagina naar de andere, en onderweg info verzamelen. Zie ze als onvermoeibare assistenten: ze werken 24/7, klagen nooit en kunnen miljoenen pagina’s per dag bezoeken.

Een webcrawler start met een lijstje webadressen (de zogenaamde 'seeds'), bezoekt elk adres en volgt de links die hij tegenkomt om nieuwe pagina’s te ontdekken. Tijdens deze tocht kopieert hij content, indexeert data en bouwt zo een soort plattegrond van het altijd veranderende web (). Zo weten zoekmachines als Google wat er allemaal online staat, en blijven prijsvergelijkers of marktonderzoekstools altijd actueel.

Kortom: webcrawlers zorgen ervoor dat het internet doorzoekbaar, vergelijkbaar en bruikbaar blijft.

Verschillende soorten webcrawlers en hun functies

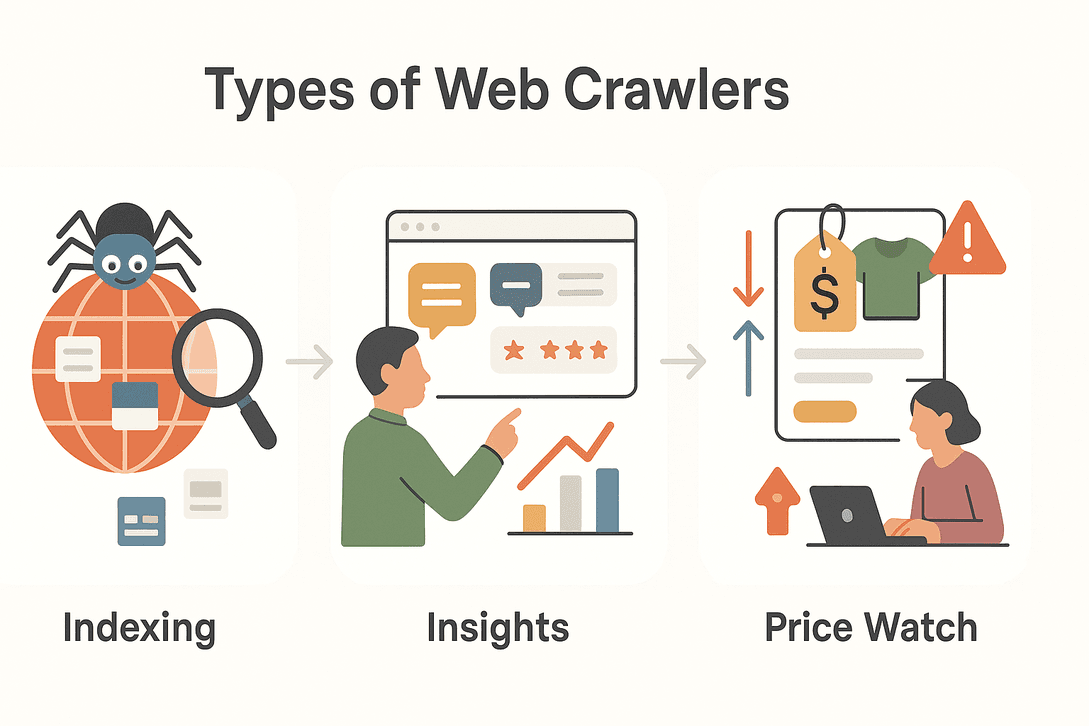

Niet elke webcrawler doet hetzelfde. Afhankelijk van het doel zijn er verschillende soorten crawlers, elk met hun eigen specialiteit. Hier een overzicht van de belangrijkste types:

Niet elke webcrawler doet hetzelfde. Afhankelijk van het doel zijn er verschillende soorten crawlers, elk met hun eigen specialiteit. Hier een overzicht van de belangrijkste types:

| Type | Kernfunctie | Typisch gebruik |

|---|---|---|

| Zoekmachinecrawlers | Indexeren van het web voor zoekresultaten | Googlebot, Bingbot die nieuwe sites doorzoeken |

| Data mining crawlers | Grote datasets verzamelen voor analyse | Marktonderzoek, academisch onderzoek |

| Prijsmonitoring crawlers | Productprijzen en beschikbaarheid volgen | Prijsvergelijking, dynamische prijsstrategieën |

| Content aggregatie crawlers | Artikelen, nieuws of posts verzamelen | Nieuwsportals, contentcuratie |

| Leadgeneratie crawlers | Contactgegevens en bedrijfsinformatie extraheren | Sales prospecting, B2B-bedrijvengidsen |

Laten we een paar van deze types wat verder uitlichten:

Zoekmachinecrawlers

Als je iets op Google zoekt, vertrouw je op het werk van zoekmachinecrawlers. Deze bots struinen dag en nacht het web af, ontdekken nieuwe pagina’s, werken oude bij en indexeren content zodat jij het terugvindt in de zoekresultaten. Zonder crawlers zouden zoekmachines niet weten wat er allemaal online gebeurt ().

Data mining en marktonderzoek crawlers

Bedrijven en onderzoekers gebruiken crawlers om enorme hoeveelheden data te verzamelen voor analyse. Wil je weten hoe vaak een merk genoemd wordt op internet? Of de stemming rond een nieuw product volgen? Data mining crawlers scannen fora, reviews, social media en meer, en maken van de chaos op het web gestructureerde inzichten ().

Prijsmonitoring en producttracking crawlers

In de snelle wereld van e-commerce veranderen prijzen en productdetails constant. Prijsmonitoring crawlers houden concurrenten in de gaten, signaleren prijsdalingen, voorraadwijzigingen of nieuwe producten. Zo kunnen bedrijven hun prijzen snel aanpassen en blijven ze scherp in de markt ().

Waarom webcrawlers onmisbaar zijn voor moderne data-toegang

Het internet is simpelweg te groot om handmatig bij te houden. Er zijn (en dat aantal groeit elke minuut). Webcrawlers maken het mogelijk om:

- Data op grote schaal te verzamelen: Miljoenen pagina’s in een paar uur bezoeken.

- Altijd actueel te blijven: Voortdurend veranderingen, nieuwe content of nieuws in de gaten houden.

- Direct toegang tot actuele info: Snel inspelen op marktontwikkelingen, prijswijzigingen of trends.

- Datagedreven beslissingen te nemen: Alles van zoekmachines tot marktonderzoek, risicobeheer en financiële analyses draait op crawlers ().

In een tijd waarin , zijn webcrawlers de motoren die de datastroom op gang houden.

Veelvoorkomende toepassingen van webcrawlers in verschillende sectoren

Webcrawlers zijn allang niet meer alleen voor techreuzen of zoekmachines. In allerlei sectoren worden ze ingezet:

| Sector | Toepassing | Voordeel |

|---|---|---|

| Sales | Leadgeneratie | Gericht prospectlijsten bouwen uit bedrijvengidsen |

| E-commerce | Prijsmonitoring | Concurrentieprijzen, voorraad en producten volgen |

| Marketing | Content aggregatie | Nieuws, artikelen en social media verzamelen |

| Vastgoed | Woningen samenvoegen | Overzicht van aanbod uit verschillende bronnen |

| Reizen | Prijs- en hotelvergelijking | Prijzen, beschikbaarheid en voorwaarden monitoren |

| Financiën | Risicobewaking | Nieuws, rapportages en sentiment volgen |

Praktijkvoorbeeld:

Een makelaarskantoor gebruikt crawlers om woningdetails, foto’s en voorzieningen van verschillende websites te verzamelen, zodat klanten een compleet en actueel overzicht krijgen ().

Een e-commerce team zet crawlers in om SKU’s en prijzen van concurrenten te monitoren en hun eigen strategie direct aan te passen ().

Hoe werkt een webcrawler? Stap-voor-stap uitgelegd

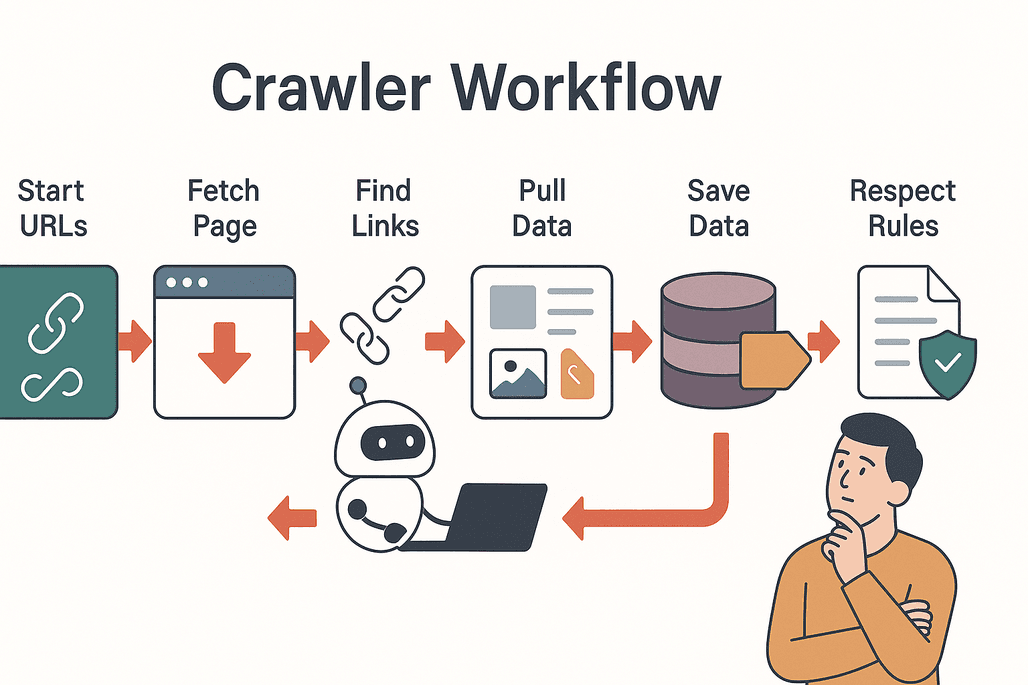

Zo werkt een doorsnee webcrawler:

Zo werkt een doorsnee webcrawler:

- Start met seeds: De crawler begint met een lijstje start-URL’s.

- Bezoeken en ophalen: Elke pagina wordt bezocht en de inhoud wordt opgehaald.

- Links extraheren: Alle links op de pagina worden verzameld.

- Links volgen: Nieuwe, nog niet bezochte links worden toegevoegd aan de wachtrij.

- Data extraheren: Relevante info (tekst, afbeeldingen, prijzen, etc.) wordt netjes opgeslagen.

- Resultaten opslaan: De data wordt opgeslagen in een database of geëxporteerd voor analyse.

- Regels respecteren: De crawler checkt het

robots.txt-bestand van elke site om te zien wat wel en niet mag ().

Best practices:

- Wees netjes bij het crawlen (overbelast servers niet).

- Respecteer privacy en juridische grenzen.

- Voorkom dubbele content en onnodige verzoeken.

Uitdagingen en aandachtspunten bij webcrawling

Webcrawling gaat niet altijd vanzelf. Veelvoorkomende uitdagingen zijn:

- Serverbelasting: Te veel verzoeken kunnen een website traag maken of zelfs platleggen.

- Dubbele content: Crawlers kunnen dezelfde pagina’s steeds opnieuw bezoeken of vastlopen in loops.

- Privacy en wetgeving: Niet alle data mag zomaar gebruikt worden—check altijd de gebruiksvoorwaarden en privacyregels.

- Technische barrières: Sommige sites gebruiken CAPTCHAs, dynamische content of anti-botmaatregelen om crawlers buiten de deur te houden ().

Tips voor succes:

- Gebruik een vriendelijk crawltempo.

- Houd veranderingen in de website-structuur in de gaten.

- Blijf op de hoogte van privacywetgeving.

Thunderbit: Webcrawlers voor iedereen binnen handbereik

En nu wordt het pas echt interessant. Vroeger moest je kunnen programmeren, instellingen tweaken en veel tijd kwijt zijn aan troubleshooting om een webcrawler te gebruiken. Met is dat verleden tijd.

Thunderbit is een AI-webscraper Chrome-extensie speciaal voor zakelijke gebruikers—je hebt geen technische kennis nodig. Wat maakt Thunderbit zo bijzonder?

- Instructies in gewone taal: Geef gewoon aan welke data je wilt (“Haal alle productnamen en prijzen van deze pagina”), en de AI regelt het.

- AI-veld suggesties: Klik op “AI Suggest Fields” en Thunderbit leest de pagina en stelt automatisch de beste kolommen voor.

- Subpagina scraping: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals productdetails of LinkedIn-profielen) en verrijkt je dataset.

- Directe sjablonen: Voor populaire sites (Amazon, Zillow, Shopify, enz.) zijn er kant-en-klare sjablonen voor éénklik-data-extractie.

- Eenvoudig exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable of Notion—zonder extra gedoe.

- Gratis data-export: Download je resultaten als CSV of JSON, helemaal gratis.

Thunderbit wordt vertrouwd door , van sales- en e-commerceteams tot vastgoedprofessionals.

Thunderbit versus traditionele webcrawlers

Hoe steekt Thunderbit af tegen de klassieke aanpak?

| Functie | Thunderbit | Traditionele crawlers |

|---|---|---|

| Installatietijd | 2 klikken (AI regelt alles) | Uren/dagen (handmatig instellen, coderen) |

| Technische kennis nodig | Geen (instructies in gewone taal) | Veel (coderen, selectors, scripting) |

| Flexibiliteit | Werkt op elke site, past zich aan | Breekt bij layout-wijzigingen |

| Subpagina scraping | Ingebouwd, geen extra werk | Handmatig scripten vereist |

| Exportopties | Excel, Sheets, Airtable, Notion, CSV, JSON | Meestal alleen CSV/JSON |

| Onderhoud | AI past zich automatisch aan | Regelmatig handmatig aanpassen |

Met Thunderbit hoef je geen developer te zijn of uren te besteden aan instellingen. Gewoon aanwijzen, klikken en de AI doet de rest ().

Zelf aan de slag met webcrawlers via Thunderbit

Wil je het zelf proberen? Zo start je binnen een paar minuten met Thunderbit:

- Installeer de .

- Open de website die je wilt crawlen.

- Klik op het Thunderbit-icoon en kies “AI Suggest Fields.” De AI stelt kolommen voor op basis van de pagina.

- Pas velden aan indien nodig en klik op “Scrape.” Thunderbit haalt de data op, ook van subpagina’s als je dat wilt.

- Exporteer je resultaten naar Excel, Google Sheets, Airtable, Notion of download als CSV/JSON.

Dat is alles—geen sjablonen, geen code, geen gedoe. Of je nu prijzen volgt, een leadlijst bouwt of nieuws verzamelt, met Thunderbit is webcrawling net zo makkelijk als eten bestellen.

Conclusie: Webcrawlers zijn de sleutel tot slimme data-toegang

Webcrawlers zijn de stille motoren van onze digitale wereld. Ze maken informatie toegankelijk, doorzoekbaar en bruikbaar voor iedereen. Van zoekmachines tot sales, van e-commerce tot vastgoed: crawlers zijn onmisbaar voor iedereen die betrouwbare, actuele data nodig heeft.

En dankzij moderne AI-tools zoals hoef je geen programmeur te zijn om hiervan te profiteren. Met een paar klikken maak je van het web een gestructureerde, bruikbare databron—voor slimmere beslissingen en nieuwe kansen.

Benieuwd wat webcrawlers voor jouw bedrijf kunnen betekenen? en ontdek vandaag nog verborgen webdata. Meer tips en verdieping vind je op de .

Veelgestelde vragen

1. Wat is een webcrawler precies?

Een webcrawler is een geautomatiseerd programma (ook wel spider of bot genoemd) dat systematisch het internet afspeurt, webpagina’s bezoekt, links volgt en informatie verzamelt voor indexering of analyse.

2. Wat is het verschil tussen een webcrawler en een webscraper?

Webcrawlers zijn bedoeld om grote delen van het web te ontdekken en in kaart te brengen door links te volgen. Webscrapers richten zich op het gericht verzamelen van specifieke data van geselecteerde pagina’s. Veel moderne tools (zoals Thunderbit) combineren beide functies.

3. Waarom zijn webcrawlers belangrijk voor bedrijven?

Webcrawlers geven bedrijven toegang tot actuele informatie op grote schaal—of het nu gaat om prijsmonitoring, content verzamelen of het bouwen van prospectlijsten. Ze ondersteunen realtime beslissingen en houden bedrijven concurrerend.

4. Is het legaal om webcrawlers te gebruiken?

Webcrawling is meestal toegestaan als je je aan de regels van de website en privacywetgeving houdt. Check altijd het robots.txt-bestand en respecteer de privacyregels.

5. Hoe maakt Thunderbit webcrawling makkelijker?

Thunderbit gebruikt AI om het instellen, veldselectie en data-extractie te automatiseren. Met instructies in gewone taal en kant-en-klare sjablonen kan iedereen data van websites halen—zonder technische kennis. Je kunt de data direct exporteren naar Excel, Google Sheets, Airtable of Notion.

Meer weten