Het internet zit bomvol data. Of je nu werkt in sales, operations of een andere zakelijke functie, je hebt vast wel eens de druk gevoeld om al die online chaos om te zetten in bruikbare inzichten. Steeds meer teams willen hun dataverzameling automatiseren—denk aan leadgeneratie, prijsmonitoring of marktonderzoek. En laten we eerlijk zijn: niemand zit te wachten op een dag vol eindeloos kopiëren en plakken van websites. Hier komt webscraping om de hoek kijken, en Python is daarbij dé favoriete programmeertaal.

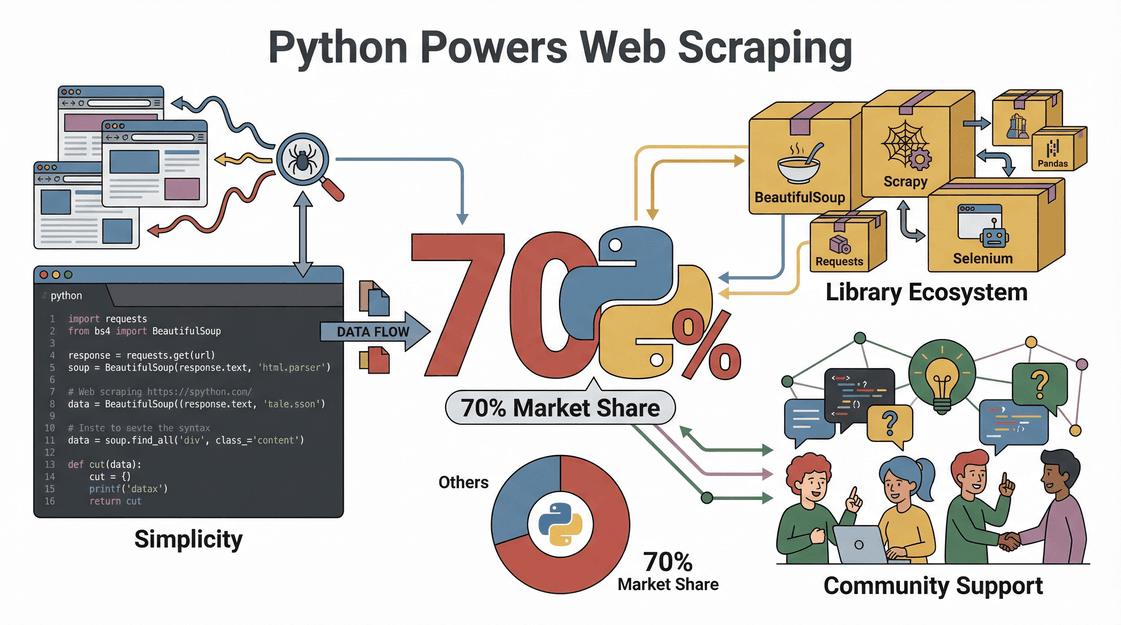

De populariteit van Python voor webscraping is geen toeval—de cijfers liegen er niet om. Bijna draait op Python, dankzij de makkelijke syntax, het enorme aanbod aan libraries en een actieve community die altijd wel een oplossing heeft. In deze gids neem ik je stap voor stap mee in webscraping met Python: van het opzetten van je omgeving tot het schrijven van je eerste script. Ook laat ik zien hoe het nóg makkelijker maakt—voor als je liever klikt dan codeert.

Wat is Webscraping en Waarom Python?

Laten we bij het begin beginnen. Webscraping is het automatisch verzamelen van gegevens van websites—zie het als een digitale assistent die razendsnel info van een pagina haalt en in een spreadsheet plakt, zonder ooit te klagen over een koffiepauze. Bedrijven zetten webscraping in voor allerlei doelen, van .

Waarom kiezen zoveel mensen voor Python bij webscraping?

- Lekker toegankelijk: Python heeft een duidelijke, leesbare syntax, waardoor je er snel mee aan de slag kunt, ook als je geen hardcore programmeur bent.

- Veel handige libraries: Met libraries als Requests, BeautifulSoup, Selenium en Scrapy kun je alles aan, van simpele HTML-pagina’s tot complexe, JavaScript-gedreven sites.

- Actieve community: Loop je vast? Grote kans dat iemand op Stack Overflow of GitHub het probleem al heeft opgelost.

- Snel en flexibel: Python-scripts zijn makkelijk aan te passen voor nieuwe websites of datastructuren, en ze schalen goed van kleine tot grote projecten.

Kortom: Python is het Zwitsers zakmes van webscraping—krachtig, flexibel en supervriendelijk voor beginners.

De Zakelijke Meerwaarde: Wat Webscraping met Python Oplevert

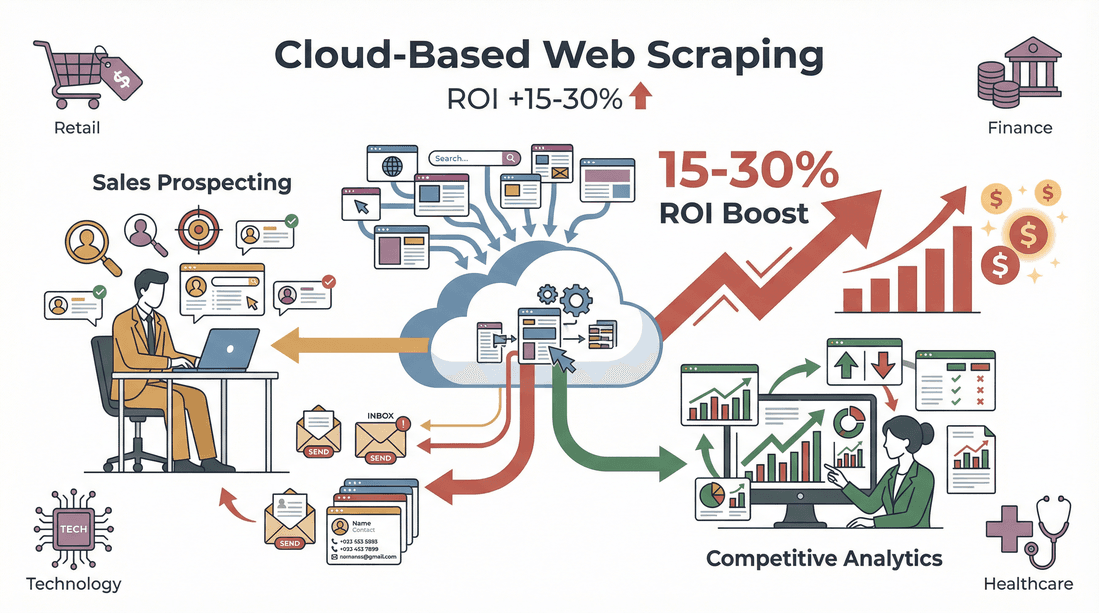

Webscraping is niet alleen een technische truc—het is een echte versneller voor je business. Zo zetten bedrijven Python-scraping in om voorsprong te nemen:

| Toepassing | Hoe Python Helpt | Zakelijk Effect |

|---|---|---|

| Leadgeneratie | Contactgegevens uit directories, LinkedIn, etc. halen | Je CRM vullen met actuele, relevante leads |

| Prijsmonitoring | Prijzen van concurrenten op e-commerce sites volgen | Dynamische prijzen mogelijk maken en concurrerend blijven |

| Marktonderzoek | Reviews, artikelen of social media verzamelen | Trends signaleren en datagedreven beslissingen nemen |

| Vastgoedgegevens verzamelen | Woningen van meerdere sites scrapen | Up-to-date, centrale marktdatabase opbouwen |

| Productcatalogus beheren | Specificaties en voorraad bij leveranciers ophalen | Voorraad automatisch bijwerken en minder fouten |

En het rendement? In een bleek dat recruiters 8 uur per week besparen door leads automatisch te scrapen. In verschillende sectoren heeft voor sales en concurrentieanalyse.

Je Python-omgeving Klaarmaken voor Webscraping

Voordat je kunt scrapen, moet Python goed geïnstalleerd zijn. Zo pak je dat aan—ook als je nog weinig ervaring hebt met programmeren.

1. Installeer Python

- Download Python: Ga naar de en kies de nieuwste versie (3.10+ is een veilige keuze).

- Voeg Python toe aan PATH: Op Windows, vink tijdens de installatie “Add Python to PATH” aan. Zo kun je Python makkelijk via de command line starten ().

2. Maak een Virtuele Omgeving aan

Met een virtuele omgeving houd je de libraries van je project netjes gescheiden en voorkom je conflicten.

1# Op Windows

2python -m venv venv

3venv\Scripts\activate

4# Op Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. Kies een Code Editor

- VS Code: Gratis, lichtgewicht en veel uitbreidingen beschikbaar.

- PyCharm: Ideaal voor grotere projecten, met slimme suggesties.

- Jupyter Notebook: Perfect om te experimenteren en data te visualiseren.

4. Tips bij Problemen

- Worden Python-commando’s niet herkend? Controleer je PATH-instellingen.

- Krijg je permissiefouten? Start je terminal als administrator.

- Op Mac kan het nodig zijn Xcode Command Line Tools te installeren (

xcode-select --install).

De Beste Python Libraries voor Webscraping

De kracht van Python zit in de libraries. Dit zijn de populairste opties en wanneer je ze gebruikt:

| Library | Ideaal Voor | Gebruiksgemak | Snelheid | JavaScript Support | Schaalbaarheid |

|---|---|---|---|---|---|

| Requests | Webpagina’s ophalen (HTTP) | Makkelijk | Snel | Nee | Goed |

| BeautifulSoup | HTML/XML parseren | Zeer makkelijk | Gemiddeld | Nee | Goed |

| lxml | Supersnel XML/HTML parseren | Gemiddeld | Zeer snel | Nee | Goed |

| Selenium | Interactie met dynamische sites | Gemiddeld | Traag | Ja (volledige browser) | Matig |

| Scrapy | Grootschalig, geautomatiseerd scrapen | Gemiddeld | Zeer snel | Gedeeltelijk/Ja | Uitstekend |

- Requests is ideaal voor simpele HTTP-verzoeken.

- BeautifulSoup is geliefd vanwege de eenvoudige syntax—perfect om HTML te parseren en data te extraheren.

- lxml is razendsnel bij grote documenten, maar iets minder vergevingsgezind voor beginners.

- Selenium opent echt een browservenster, zodat je ook JavaScript-gedreven sites kunt scrapen.

- Scrapy is een compleet framework voor robuuste, schaalbare webscrapers—perfect voor grote projecten.

Voor de meeste beginners is de combinatie Requests + BeautifulSoup ideaal ().

Stap voor Stap: Webscraping met Python

Laten we een praktijkvoorbeeld nemen: productdata scrapen van een (fictieve) e-commercesite.

1. Inspecteer de Website-structuur

Open de Developer Tools van je browser (meestal F12 of rechtsklik > Inspecteren). Zoek de HTML-elementen die de data bevatten die je wilt hebben—zoals producttitels, prijzen of beoordelingen. Dit is essentieel: je moet weten wat je in je code gaat targeten ().

2. Stuur een HTTP-verzoek

Gebruik Requests om de pagina op te halen.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. Parse HTML met BeautifulSoup

Haal de gewenste data eruit.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. Data Extraheren en Opschonen

Loop door elk product en verzamel de details.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # Prijs omzetten voor berekeningen

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. Data Exporteren naar CSV/Excel

Gebruik Pandas om je resultaten op te slaan.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

En klaar—gestructureerde data, direct klaar voor analyse of import in je CRM.

Omgaan met Dynamische Content en Paginering

Niet elke website werkt mee. Sommige laden data via JavaScript of verdelen resultaten over meerdere pagina’s. Zo pak je dat aan:

Dynamische Content Scrapen

Zie je lege resultaten of ontbrekende data? Dan laadt de site waarschijnlijk content dynamisch. Gebruik dan Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# Gebruik BeautifulSoup zoals eerder()

Paginering Afhandelen

Om meerdere pagina’s te scrapen, loop je door de paginanummers of klik je automatisch op “Volgende”.

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # Parse en extraheren zoals eerder()

Voor grote projecten kan Scrapy het crawlen van honderden pagina’s automatiseren ().

Je Gescrapete Data Exporteren en Gebruiken

Heb je de data binnen? Dan kun je ermee aan de slag.

- Exporteren naar CSV/Excel: Zoals hierboven, met Pandas.

- Opschonen en normaliseren: Verwijder dubbele rijen, corrigeer typefouten en maak formaten consistent ().

- Integreren in workflows: Importeer je CSV in Salesforce, HubSpot of je favoriete analysetool. Je kunt dit zelfs automatiseren met Python-scripts.

Thunderbit: Python Webscraping Eenvoudig voor Zakelijke Teams

Eerlijk is eerlijk—Python is krachtig, maar niet altijd de snelste route als je geen programmeur bent. Daarom hebben we ontwikkeld: een speciaal voor zakelijke gebruikers die snel resultaat willen, zonder gedoe.

Dit maakt Thunderbit onmisbaar voor sales- en operationele teams:

- AI-veldherkenning: Klik op “AI Suggest Fields” en Thunderbit scant de pagina, stelt kolommen voor (zoals Naam, Prijs, E-mail) en zet de extractie voor je klaar—geen handmatig veldselecteren meer.

- Subpagina’s scrapen: Thunderbit bezoekt automatisch subpagina’s (zoals productdetails of LinkedIn-profielen) en verrijkt je tabel met extra info.

- Paginering en dynamische content: Kan moeiteloos omgaan met paginering en oneindig scrollen—zonder code.

- Directe sjablonen: Voor populaire sites (Amazon, Zillow, Shopify, enz.) kies je gewoon een sjabloon en klik je op “Scrapen”.

- Gratis data-export: Exporteer direct naar Excel, Google Sheets, Airtable of Notion—zonder extra stappen.

- Geen onderhoud: Thunderbit’s AI past zich aan websitewijzigingen aan, zodat je niet steeds scripts hoeft te repareren.

Ik zie gebruikers die binnen vijf minuten van “Ik heb deze data nodig, maar weet niet waar te beginnen” naar “Hier is mijn spreadsheet, klaar voor gebruik” gaan. En ja, er is een om het risicoloos te proberen.

Thunderbit en Python Combineren: De Ultieme Data-toolkit

Ben je een power user of data-analist? Je hoeft niet te kiezen tussen Thunderbit en Python—je kunt ze samen gebruiken. Zo doe ik dat zelf:

- Gebruik Thunderbit voor extractie: Snel gestructureerde data scrapen van lastige of onbekende sites, exporteren naar CSV of Excel.

- Verwerk met Python: Laad de geëxporteerde data in Pandas voor opschoning, analyse of verdere automatisering.

- Automatiseer workflows: Plan periodieke scrapes met Thunderbit en laat Python-scripts de data verwerken en uploaden waar nodig.

Met deze hybride aanpak werk je snel, flexibel en hoef je niet telkens het wiel opnieuw uit te vinden.

Juridische en Ethische Aspecten van Webscraping

Laten we het onbesproken onderwerp aanpakken: is webscraping legaal? Het korte antwoord: ja—mits je je aan de regels houdt.

- Respecteer robots.txt en de gebruiksvoorwaarden: Sommige sites verbieden scraping expliciet; controleer dit altijd vooraf ().

- Scrape geen persoonlijke of auteursrechtelijk beschermde data: Beperk je tot publiek toegankelijke, feitelijke informatie.

- Beperk je verzoeken: Overbelast servers niet. Bouw vertragingen in en respecteer limieten ().

- Voldoe aan privacywetgeving: Verzamel je e-mails of persoonsgegevens? Zorg dat je voldoet aan GDPR, CCPA en andere regels ().

Thunderbit helpt gebruikers compliant te blijven door alleen te scrapen wat zichtbaar en toegankelijk is in je browser, en door het makkelijk te maken om sitebeperkingen te respecteren.

Problemen Oplossen en Best Practices voor Python Webscraping

Zelfs de beste webscrapers lopen soms vast. Dit is mijn checklist voor probleemoplossing:

- Geblokkeerde verzoeken: Wissel van user agent, gebruik proxies of vertraag je verzoeken ().

- Parserfouten: Controleer je HTML-selectors—websites veranderen hun layout regelmatig.

- Ontbrekende data: Check of de content niet dynamisch geladen wordt (gebruik eventueel Selenium).

- Captcha’s of login-muren: Sommige sites weren bots actief; overweeg alternatieven of handmatige extractie.

Best practices:

- Test je webscraper altijd eerst op een kleine dataset.

- Log fouten en vang uitzonderingen netjes af.

- Respecteer de regels van de site en scrape geen gevoelige of afgeschermde data.

- Documenteer je code en houd deze modulair voor eenvoudige updates.

- Plan regelmatig onderhoud—websites veranderen, dus je webscrapers ook ().

Samenvatting & Belangrijkste Inzichten

Webscraping met Python is een superkracht voor moderne bedrijven—je verandert het rommelige web in bruikbare, gestructureerde data. Dit moet je onthouden:

- Python is dé keuze voor webscraping dankzij het gebruiksgemak, krachtige libraries en actieve community.

- De workflow is overzichtelijk: inspecteer de site, haal de pagina op, parse de HTML, extraheren en opschonen, exporteren naar CSV of Excel.

- Thunderbit maakt scrapen toegankelijk voor niet-programmeurs, met automatische veldherkenning, subpagina-extractie en data-export in een paar klikken.

- Combineer Thunderbit en Python voor het beste van twee werelden: snelle extractie en krachtige dataverwerking.

- Blijf legaal en ethisch: respecteer de regels van websites, vermijd persoonlijke data en houd je webscrapers netjes.

Klaar om te beginnen? Bouw je eerste Python-webscraper—of, als je geen zin hebt om te coderen, en ontdek hoe makkelijk dataverzameling kan zijn. Meer tips en verdiepende artikelen vind je op de .

Veelgestelde Vragen

1. Wat is webscraping en waarom is Python hiervoor zo populair?

Webscraping is het automatisch verzamelen van data van websites. Python is populair vanwege de eenvoudige syntax, krachtige libraries (zoals Requests en BeautifulSoup) en een grote community die zowel beginners als experts ondersteunt ().

2. Welke Python-libraries kan ik het beste gebruiken voor webscraping?

Voor de meeste projecten kun je starten met Requests (voor het ophalen van pagina’s) en BeautifulSoup (voor het parseren van HTML). Voor dynamische of JavaScript-gedreven sites gebruik je Selenium. Voor grootschalige of complexe projecten is Scrapy een uitstekende keuze ().

3. Hoe verhoudt Thunderbit zich tot Python-webscraping?

Thunderbit is een AI-gedreven Chrome-extensie waarmee je in twee klikken data kunt scrapen—zonder te programmeren. Ideaal voor zakelijke gebruikers die snel resultaat willen, terwijl Python meer flexibiliteit biedt voor maatwerk of grote projecten ().

4. Is webscraping legaal?

Webscraping is doorgaans legaal als je je beperkt tot openbare data, robots.txt en de gebruiksvoorwaarden respecteert, en geen persoonlijke of auteursrechtelijk beschermde informatie verzamelt. Controleer altijd de regels van de site voordat je gaat scrapen ().

5. Hoe kan ik Thunderbit en Python combineren voor geavanceerde workflows?

Gebruik Thunderbit om snel gestructureerde data te extraheren en exporteer deze naar CSV of Excel. Gebruik vervolgens Python (met Pandas of andere libraries) om de data op te schonen, analyseren of verder te automatiseren—zo profiteer je van het beste van beide werelden.

Wil je van het web de beste databron voor je bedrijf maken? Probeer Python en Thunderbit—en laat de data het werk doen.

Meer weten