Het internet staat bomvol data—zoveel zelfs dat we in 2024 wereldwijd de mijlpaal van aan digitale informatie hebben bereikt. Geloof het of niet: meer dan 90% van alle data is in de afgelopen twee jaar ontstaan. Voor bedrijven betekent dit dat jouw volgende gouden inzicht, lead of concurrentievoordeel waarschijnlijk ergens online te vinden is—als je maar weet hoe je het moet pakken.

En daar komt webscraping om de hoek kijken. Of je nu in sales, e-commerce of marktonderzoek zit: automatisch data verzamelen en structureren van websites is een enorme gamechanger. En maak je geen zorgen als je geen programmeur bent—met Python is webscraping verrassend makkelijk. In deze praktische handleiding neem ik je stap voor stap mee, van installatie tot het opschonen van data. Ook laat ik je een no-code alternatief zien met als je snel resultaat wilt.

Wat is Python Webscraping?

Laten we bij het begin beginnen: webscraping is het automatisch verzamelen van gegevens van websites. Stel je voor dat je productprijzen wilt verzamelen uit een webshop, een lijst met leads wilt maken uit een bedrijvengids, of concurrentennieuws wilt volgen. In plaats van alles handmatig te kopiëren en plakken (wie heeft daar tijd voor?), schrijf je een script dat het werk voor je doet.

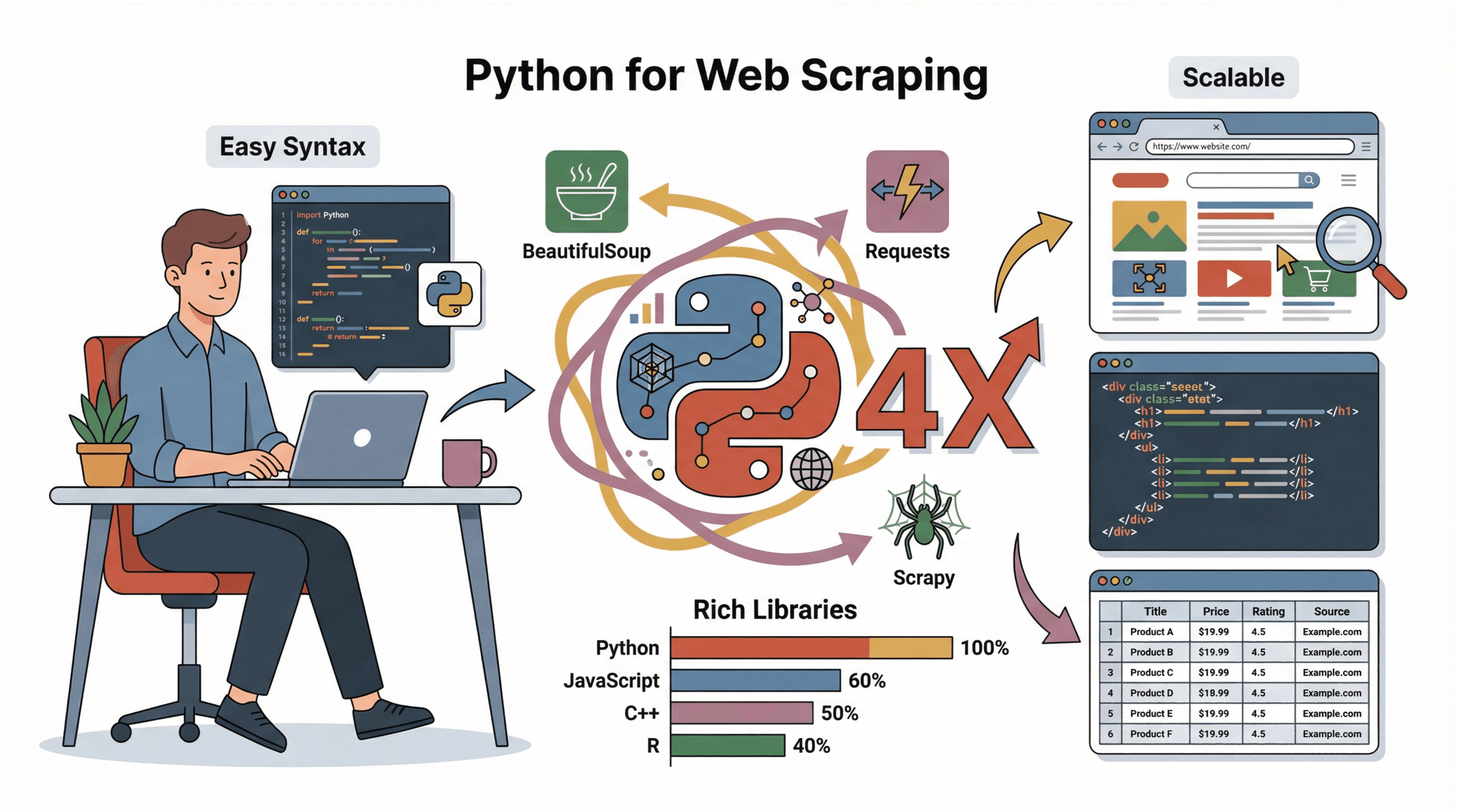

Python webscraping betekent dat je de programmeertaal Python gebruikt om dit proces te automatiseren. Dankzij de overzichtelijke syntax en krachtige bibliotheken is Python dé favoriet voor webscraping, zelfs voor mensen zonder veel programmeerkennis. Je haalt webpagina’s op, filtert de inhoud en slaat gestructureerde data op in een paar minuten.

Bedrijven gebruiken webscraping onder andere voor:

- Leadgeneratie: Lijsten met potentiële klanten maken uit directories of reviewwebsites.

- Prijsmonitoring: Prijzen van concurrenten of productbeschikbaarheid volgen.

- Marktonderzoek: Nieuws, reviews of social media-berichten verzamelen.

- Operationeel gebruik: Leveranciersinformatie, vacatures of woningaanbod verzamelen.

Kortom: als de data op een website staat, kun je het met Python snel en op grote schaal binnenhalen.

Waarom Python de Beste Keuze is voor Webscraping

Ik heb heel wat programmeertalen geprobeerd voor scraping (en ja, vaak gedacht: “waarom werkt dit niet?!”). Maar Python steekt er met kop en schouders bovenuit, en wel hierom:

Ik heb heel wat programmeertalen geprobeerd voor scraping (en ja, vaak gedacht: “waarom werkt dit niet?!”). Maar Python steekt er met kop en schouders bovenuit, en wel hierom:

- Makkelijk te leren: De syntax van Python is helder en begrijpelijk, ook voor beginners.

- Uitgebreide bibliotheken: Met tools als , en wordt data ophalen, filteren en opslaan kinderspel.

- Grote community: Er zijn talloze tutorials, forums en codevoorbeelden voor elk scraping-probleem.

- Schaalbaarheid: Python werkt voor snelle eenmalige scripts én voor grote, complexe scrapingprojecten.

Vergeleken met JavaScript, C++ of R is Python veel toegankelijker en ideaal voor snelle prototypes en data-analyse (). Daarom is het de standaardkeuze voor zowel beginners als grote bedrijven.

Aan de Slag: Je Python Scraping-omgeving Inrichten

Voordat je kunt scrapen, moet je Python en een paar belangrijke bibliotheken installeren. Zo pak je dat aan, zelfs als je nog nooit met Python hebt gewerkt:

-

Installeer Python:

- Download de nieuwste versie via .

- Op Windows: vink “Add Python to PATH” aan tijdens de installatie.

- Op Mac: gebruik met

brew install python3. - Op Linux: gebruik je pakketbeheerder:

sudo apt install python3 python3-pip.

-

Installeer pip (Python’s pakketbeheer):

- Meestal wordt pip standaard meegeleverd. Controleer met

pip --version. - Niet gevonden? Installeer het via de installer of gebruik

python -m ensurepip --upgrade.

- Meestal wordt pip standaard meegeleverd. Controleer met

-

Maak een virtuele omgeving aan (optioneel, maar slim):

- In je projectmap:

python -m venv env - Activeer de omgeving:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- In je projectmap:

-

Installeer de benodigde bibliotheken:

- Met de virtuele omgeving actief:

1pip install requests beautifulsoup4 pandas scrapy - Voor geavanceerde scraping (dynamische sites) kun je ook

seleniuminstalleren.

- Met de virtuele omgeving actief:

-

Kies een editor:

- Voor beginners zijn , of fijne keuzes.

Problemen oplossen:

- Wordt

pipniet herkend? Probeerpython -m pip install .... - Krijg je permissiefouten? Start je terminal als administrator of gebruik

sudoop Mac/Linux. - Op Windows: herstart je terminal na het installeren van Python.

Een Website Inspecteren voor het Scrapen

Voordat je code schrijft, moet je weten hoe de website is opgebouwd. Zo pak ik dat aan:

-

Open de ontwikkelaarstools:

- In Chrome: rechtsklik op een element en kies “Inspecteren”, of druk op

F12. - Je ziet nu de HTML-structuur in het tabblad “Elements”.

- In Chrome: rechtsklik op een element en kies “Inspecteren”, of druk op

-

Zoek de gewenste data:

- Gebruik het “Element selecteren”-icoon (muispijl) om op het gewenste stukje data te klikken (bijvoorbeeld een producttitel of prijs).

- De bijbehorende HTML wordt gemarkeerd.

-

Herken patronen:

- Let op unieke tags, klassen of ID’s. Bijvoorbeeld:

<h2 class="product-title">Laptop XYZ</h2>. - Kijk of de data in een lijst (

<ul>,<div class="item">, etc.) of een tabel staat.

- Let op unieke tags, klassen of ID’s. Bijvoorbeeld:

-

Controleer op paginering:

- Zoek naar “Volgende”-knoppen of paginanummers in de HTML. Zie je URL’s als

?page=2, dan kun je deze in je script herhalen.

- Zoek naar “Volgende”-knoppen of paginanummers in de HTML. Zie je URL’s als

-

Is de inhoud dynamisch?

- Staat de data niet in de broncode (

Ctrl+U)? Dan wordt deze waarschijnlijk met JavaScript geladen. Je hebt dan Selenium nodig of je zoekt naar een API-endpoint.

- Staat de data niet in de broncode (

Voor een visuele uitleg is erg handig.

Webpagina’s Ophalen met Requests

De bibliotheek is dé standaard om webpagina’s te downloaden in Python. Een basisvoorbeeld:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # Geeft een foutmelding bij slechte respons

6html = response.textTips:

- Gebruik altijd een realistische

User-Agentom blokkades te voorkomen (). - Controleer

response.status_code(200 = OK, 404 = niet gevonden, 403 = verboden, 429 = te veel verzoeken).

HTML Parseren met BeautifulSoup: De Data Extracten die je Nodig Hebt

Nu je de HTML hebt, kun je de interessante data eruit halen. maakt dit supermakkelijk:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]Veelvoorkomende taken:

- Tekst ophalen:

element.get_text(strip=True) - Links verzamelen:

[a['href'] for a in soup.select('a')] - Zoeken op klasse:

soup.find_all('span', class_='price') - Afbeeldingen ophalen:

[img['src'] for img in soup.select('img')] - Tabellen verwerken: Gebruik

soup.select('table')en loop door de rijen/cellen.

Tips bij rommelige HTML:

- Gebruik

soup.select_one()voor het eerste resultaat. - Controleer op

Noneals een veld ontbreekt voordat je een attribuut opvraagt. - Bij onregelmatige layouts kun je aangepaste logica of reguliere expressies gebruiken.

Scrapy Framework: Efficiënt en Schaalbaar Webscrapen

Als je scrapingproject groter wordt (denk aan honderden of duizenden pagina’s), is je beste vriend. Scrapy is een compleet framework voor het crawlen van websites, het afhandelen van verzoeken, het volgen van links en het exporteren van data.

Waarom Scrapy?

- Snelheid: Scrapy haalt meerdere pagina’s tegelijk op (asynchroon).

- Handige functies: Automatische retries, caching en export naar CSV/JSON.

- Schaalbaarheid: Ideaal voor grote projecten of periodieke scrapes.

Basis Scrapy workflow:

- Installeren:

pip install scrapy - Project starten:

scrapy startproject mijnproject - Maak een Spider-klasse met

start_urlsen eenparse-methode. - Gebruik

yieldom links te volgen of data te extraheren. - Run:

scrapy crawl spidernaam -o output.csv

Voor een snelle start: zie .

No-Code Alternatief: Thunderbit’s AI-webscraper voor Direct Resultaat

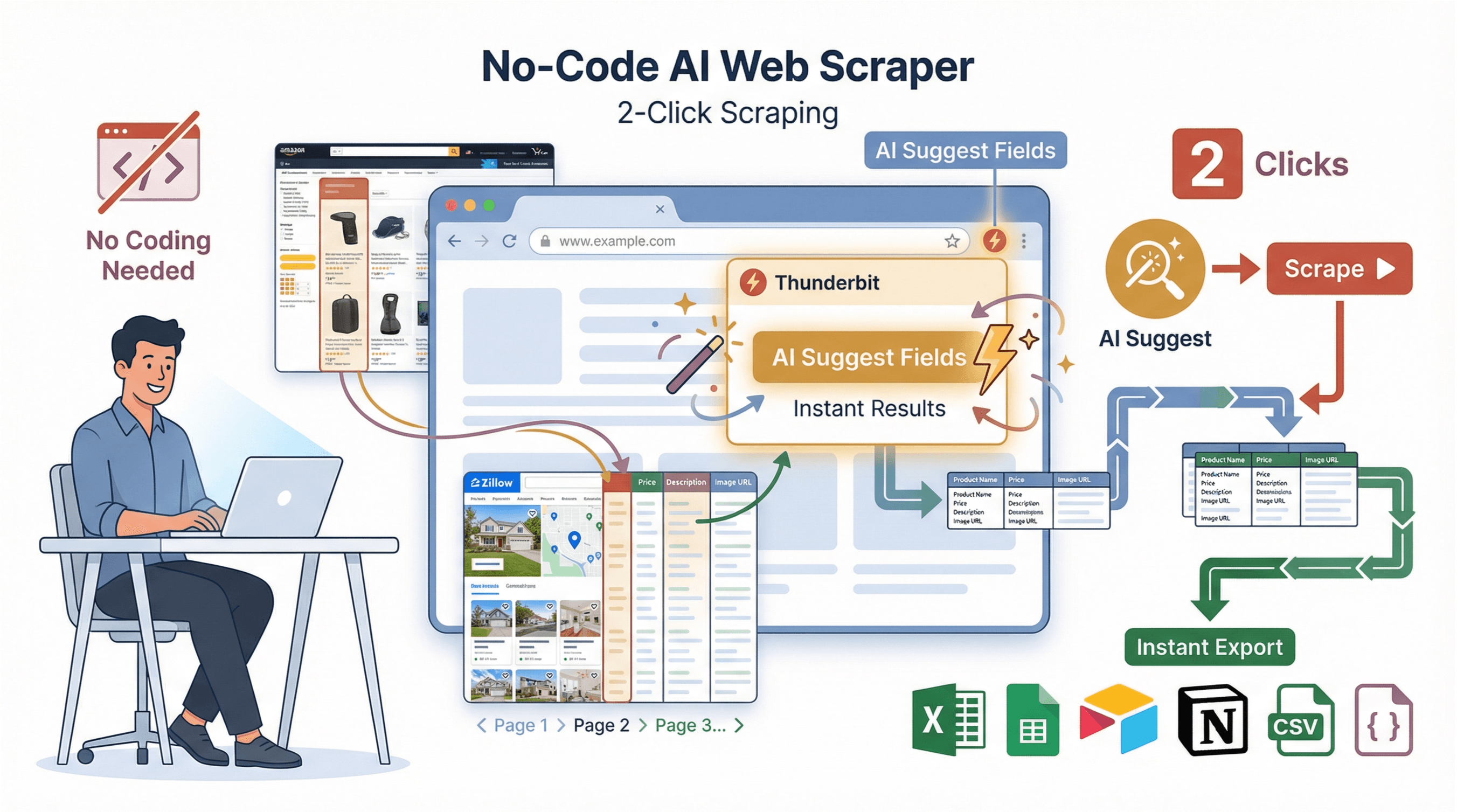

Niet iedereen heeft zin om te stoeien met code, afhankelijkheden of foutmeldingen. Daarom hebben we ontwikkeld: een AI-webscraper Chrome-extensie speciaal voor zakelijke gebruikers die in twee klikken resultaat willen.

Niet iedereen heeft zin om te stoeien met code, afhankelijkheden of foutmeldingen. Daarom hebben we ontwikkeld: een AI-webscraper Chrome-extensie speciaal voor zakelijke gebruikers die in twee klikken resultaat willen.

Zo werkt Thunderbit:

- AI Suggest Fields: Klik op “AI Suggest Fields” en Thunderbit leest de pagina en stelt automatisch de beste kolommen voor.

- 2-Kliks Scraping: Klik op “Scrape” en Thunderbit regelt alles—paginering, subpagina’s en zelfs rommelige layouts.

- Subpagina’s Scrapen: Meer details nodig? Thunderbit bezoekt automatisch elke subpagina (zoals productdetails of profielen) en vult je tabel aan.

- Directe Templates: Voor populaire sites (Amazon, Zillow, Instagram, Shopify) zijn er kant-en-klare templates voor 1-klik export.

- Gratis Data Export: Exporteer naar Excel, Google Sheets, Airtable, Notion, CSV of JSON—zonder betaalmuur of gedoe.

Thunderbit vs. Python: Een Snelle Vergelijking

| Functie | Python (Handmatig) | Thunderbit (No-Code) |

|---|---|---|

| Installatietijd | 30–60 minuten | 2 minuten |

| Programmeren nodig | Ja | Nee |

| Paginering afhandelen | Met eigen code | Ja, automatisch |

| Subpagina’s scrapen | Handmatig loops | 1 klik |

| Data exporteren | Zelf code schrijven voor CSV/Excel | 1-klik naar Sheets/Excel/Notion |

| Onderhoud | Handmatig bijwerken bij sitewijzigingen | AI past zich automatisch aan |

| Beste voor | Maatwerk, integraties | Snel resultaat, niet-programmeurs |

Meer weten? Bekijk .

Data Opschonen en Opslaan: Maak Je Gescrapete Data Waardevol

Ruwe data uit scraping is zelden direct bruikbaar. Zo maak je het netjes met :

1import pandas as pd

2# Stel je hebt een lijst met dicts genaamd scraped_data

3df = pd.DataFrame(scraped_data)

4# Dubbele rijen verwijderen

5df = df.drop_duplicates()

6# Rijen met ontbrekende waarden filteren

7df = df.dropna(subset=['title', 'price'])

8# Prijs omzetten naar float (verwijder $ en komma’s)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# Opslaan als CSV

11df.to_csv('results.csv', index=False)Best practices:

- Controleer altijd op ontbrekende of inconsistente data.

- Normaliseer formaten (zoals datums, prijzen).

- Sla data op als CSV voor eenvoudig delen, of gebruik Excel/Google Sheets voor samenwerking.

- Voor grote datasets kun je een database gebruiken (zoals SQLite of PostgreSQL).

Stapsgewijze Python Webscraping Tutorial: Van Begin tot Eind

Laten we alles samenbrengen met een praktijkvoorbeeld: producttitels en prijzen scrapen van een voorbeeld-webshop.

1. Inspecteer de Website

Stel je wilt scrapen. Inspecteer de pagina en let op:

- Boekentitels staan in

<h3>-tags binnen<article class="product_pod">. - Prijzen staan in

<p class="price_color">.

2. Haal de Pagina op

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. Parse en Extraheer Data

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. Maak de Data Schoon en Sla Op

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"Saved {len(df)} books to books.csv")5. Tips bij Problemen

- Is

booksleeg? Controleer je CSS-selectors. - Krijg je encoding-fouten? Open het CSV-bestand met UTF-8 encoding.

- Voor meerdere pagina’s: loop door URL’s als

http://books.toscrape.com/catalogue/page-2.html.

Extra tip: Voor dynamische sites of complexere flows kun je Selenium of Scrapy gebruiken—of laat Thunderbit het werk doen.

Conclusie & Belangrijkste Inzichten

Webscraping met Python opent talloze mogelijkheden voor bedrijven, van leadgeneratie tot marktinzichten. Dit hebben we behandeld:

- Python is de beste keuze voor webscraping dankzij eenvoud en krachtige bibliotheken.

- Requests en BeautifulSoup zijn je basis voor het ophalen en parsen van HTML.

- Scrapy is ideaal voor grootschalige, robuuste scrapingprojecten.

- Thunderbit biedt een no-code, AI-gedreven alternatief voor direct resultaat—perfect voor wie snel data wil zonder te programmeren.

- Data opschonen en opslaan is essentieel om van ruwe data bruikbare inzichten te maken.

Wil je verder aan de slag? Bouw je eigen scraper op een oefenwebsite, of en ontdek hoe snel je gestructureerde data uit elke website haalt. Meer tips en tutorials vind je op de .

Veel succes met scrapen—en moge je data altijd schoon, gestructureerd en direct bruikbaar zijn.

Veelgestelde Vragen

1. Is webscraping legaal?

Webscraping is meestal toegestaan als je openbare data verzamelt, maar respecteer altijd de gebruiksvoorwaarden van een website, robots.txt en privacywetgeving zoals de AVG. Verzamel geen persoonsgegevens zonder toestemming en probeer nooit beveiliging of inlogschermen te omzeilen ().

2. Wat is het verschil tussen Requests, BeautifulSoup en Scrapy?

- Requests haalt webpagina’s op.

- BeautifulSoup filtert en extraheert data uit HTML.

- Scrapy is een compleet framework voor grootschalig crawlen en data-extractie, inclusief meerdere pagina’s en export.

3. Wat als de website data laadt met JavaScript?

Staat de data niet in de HTML? Gebruik dan of Playwright om een browser te automatiseren, of zoek naar API-endpoints in de netwerkverzoeken.

4. Hoe voorkom ik dat ik geblokkeerd word tijdens het scrapen?

Gebruik realistische headers (vooral User-Agent), voeg willekeurige vertragingen toe tussen verzoeken en overbelast de server niet. Voor grootschalige scraping kun je IP’s roteren of proxies gebruiken ().

5. Kan ik data scrapen zonder te programmeren?

Zeker! Met kun je elke website in twee klikken scrapen met AI—geen code nodig. Installeer de Chrome-extensie, geef aan wat je wilt, en exporteer je data direct.

Meer handleidingen en geavanceerde tips vind je op de .

Meer leren