Het internet staat bomvol data—zoveel zelfs dat de wereldwijde markt voor webscraping software naar verwachting zal aantikken. Of je nu data-analist bent, marketeer, of gewoon nieuwsgierig, de skill om gegevens van een website te halen wordt steeds belangrijker. En als je een beetje op mij lijkt, heb je geen zin in eindeloos knippen en plakken, maar wil je direct naar het leuke deel: bruikbare inzichten, overzichtelijke spreadsheets en misschien zelfs wat automatisering.

Hier komt Python om de hoek kijken. Zie het als het Zwitsers zakmes voor data—makkelijk genoeg voor beginners, maar krachtig genoeg voor alles: van één pagina scrapen tot duizenden sites doorspitten. In deze praktische webscraping tutorial laat ik je de basics zien van webscraping met Python, leer je omgaan met dynamische websites en maak je kennis met , onze AI-gedreven, no-code webscraper waarmee data halen net zo simpel wordt als een maaltijd bestellen. Of je nu wilt leren programmeren of gewoon snel resultaat wilt, je zit hier goed.

Wat is Webscraping en Waarom Python Gebruiken om Gegevens van een Website te Halen?

Webscraping is het automatisch verzamelen van info van websites en die omzetten naar een gestructureerd formaat—denk aan spreadsheets, CSV’s of databases—voor analyse of zakelijk gebruik (). In plaats van handmatig data te kopiëren, doet een webscraper hetzelfde werk als een mens, maar dan razendsnel en op grote schaal.

Waarom is dit zo waardevol? Omdat in de zakenwereld van nu data-gedreven beslissingen centraal staan. vertrouwt op data (vaak gescrapet) voor alles van prijsstrategieën tot marktonderzoek en leadgeneratie. Stel je voor dat je dagelijks concurrentieprijzen kunt volgen, vastgoedaanbod kunt verzamelen of je eigen leadlijst bouwt—zonder gedoe.

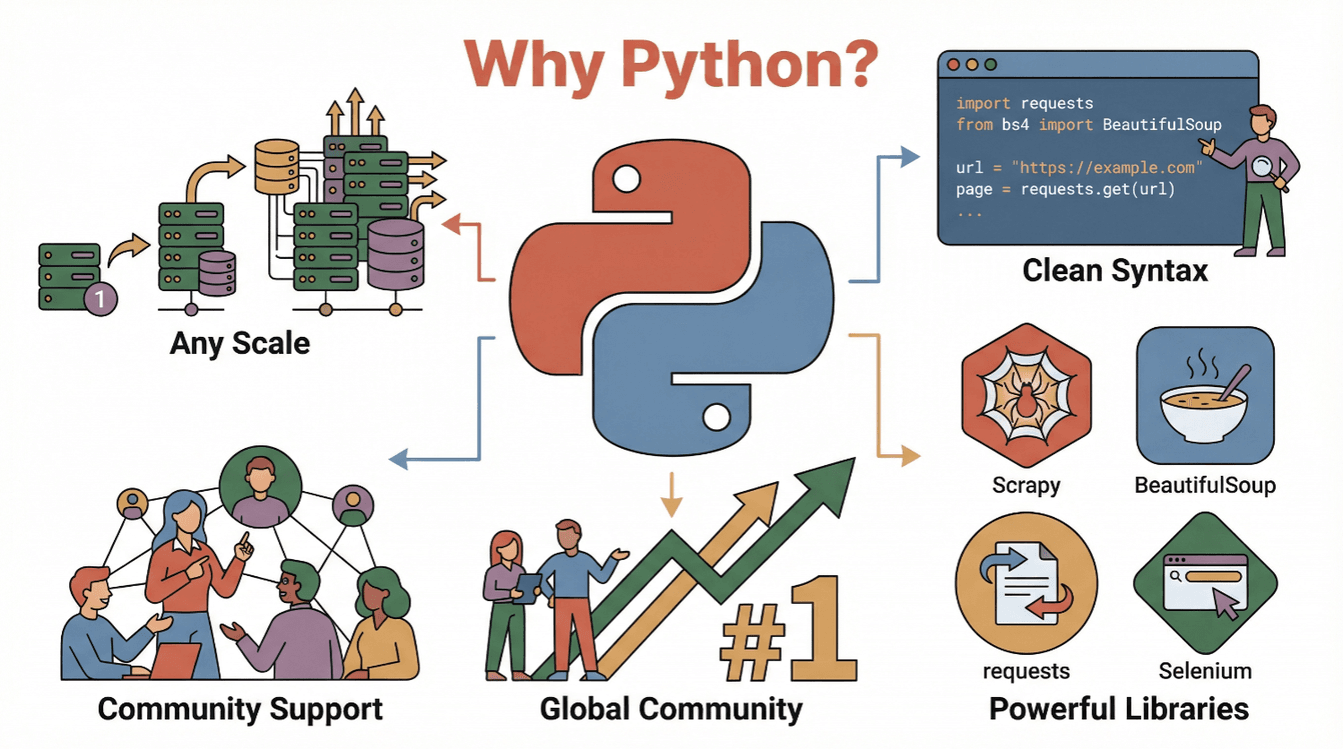

Waarom Python? Hierom:

- Lekker leesbaar & simpel: Python heeft een duidelijke, toegankelijke syntax waardoor je snel scraping scripts kunt schrijven en snappen ().

- Groot ecosysteem: Libraries als

requests,BeautifulSoup,ScrapyenSeleniummaken scrapen, parsen en browseracties automatiseren supermakkelijk. - Sterke community: Python is , dus je vindt altijd tutorials, forums en codevoorbeelden.

- Schaalbaar: Python kan alles aan, van simpele scripts tot grote crawlers.

Kortom: Python is jouw toegangsticket tot de wereld van webdata, of je nu net begint of al wat ervaring hebt.

Aan de Slag: De Basis van Python Webscraping

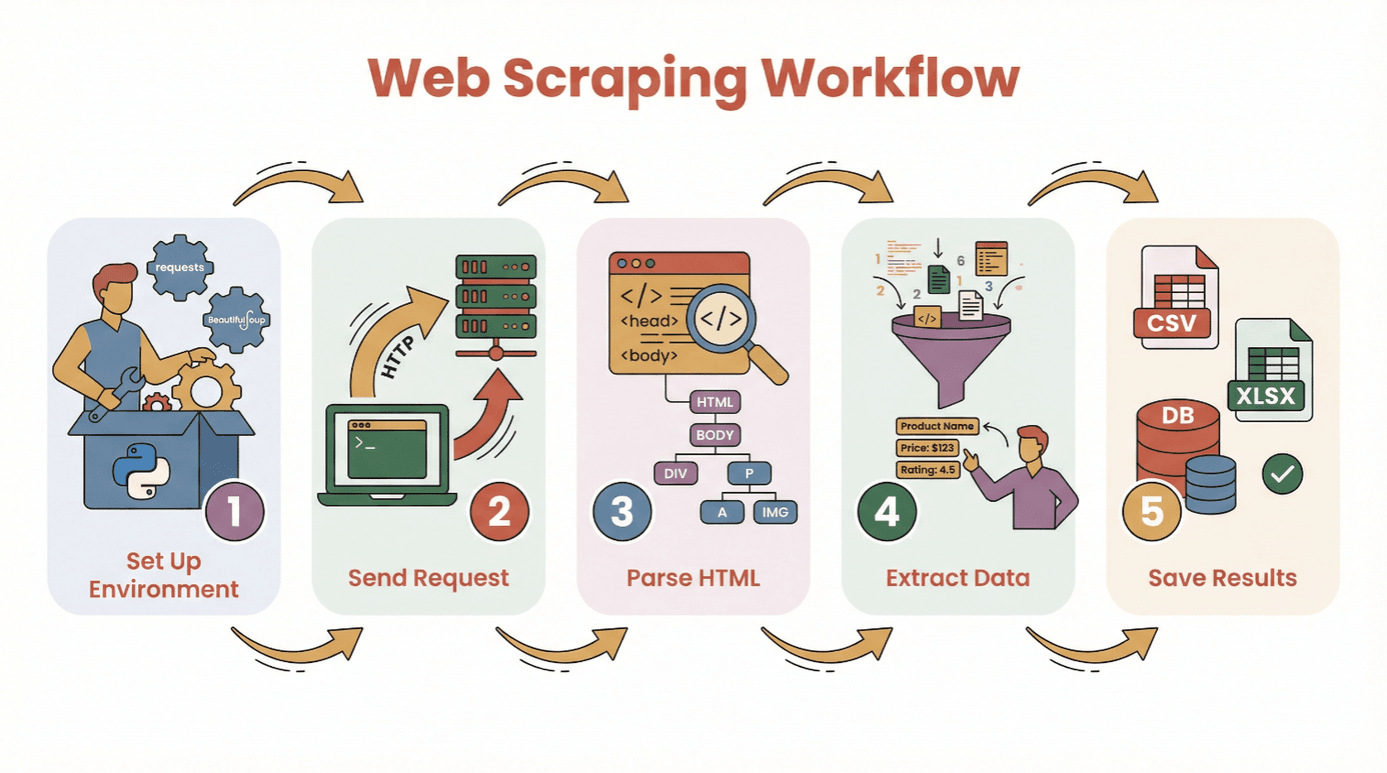

Voordat we de code induiken, eerst het basisproces om gegevens van een website te halen met Python:

- Installeer je omgeving: Zet Python en de benodigde libraries (

requests,BeautifulSoup, etc.) klaar. - Stuur een verzoek: Gebruik Python om de HTML van de gewenste webpagina op te halen.

- Parse de HTML: Gebruik een parser om de structuur van de pagina te doorlopen.

- Haal de data eruit: Zoek en verzamel de info die je nodig hebt.

- Sla de resultaten op: Bewaar je data in een CSV, Excel-bestand of database voor verdere analyse.

Je hoeft geen programmeerwonder te zijn om te beginnen. Als je Python kunt installeren en een script kunt draaien, ben je al halverwege. Voor absolute beginners is een of een Jupyter notebook handig, maar een simpele teksteditor werkt ook prima.

Essentiële libraries:

requests— om webpagina’s op te halenBeautifulSoup— om HTML te parsenpandas— om data op te slaan en op te schonen (optioneel, maar sterk aanbevolen)

De Juiste Python Webscraping Library Kiezen: BeautifulSoup, Scrapy of Selenium?

Niet elke Python webscraping tool is hetzelfde. Hier een kort overzicht van de drie populairste opties:

| Tool | Beste Voor | Sterke punten | Nadelen |

|---|---|---|---|

| BeautifulSoup | Simpele, statische pagina’s; beginners | Makkelijk te gebruiken, weinig setup, goede documentatie | Minder geschikt voor grote crawls of dynamische content |

| Scrapy | Grootschalig, meerdere pagina’s crawlen | Snel, asynchroon, ingebouwde pipelines, regelt crawling en dataopslag | Steilere leercurve, overkill voor kleine klussen, draait geen JavaScript |

| Selenium | Dynamische/JavaScript-rijke sites, automatisering | Kan JS laden, simuleert gebruikersacties, ondersteunt logins en klikken | Langzamer, vraagt meer van je computer, complexere setup |

BeautifulSoup: Ideaal voor Simpele HTML Parsing

BeautifulSoup is ideaal voor beginners en kleine projecten. Met een paar regels code kun je HTML parsen en elementen eruit halen. Als je doelwebsite vooral statisch is (dus geen ingewikkelde JavaScript), is BeautifulSoup + requests alles wat je nodig hebt.

Voorbeeld:

1import requests

2from bs4 import BeautifulSoup

3url = "https://example.com"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6titles = [h2.text for h2 in soup.find_all('h2', class_='product-title')]

7print(titles)Wanneer gebruiken: Eenmalige scrapes, simpele blogs, productpagina’s of directories.

Scrapy: Voor Grootschalige of Gestructureerde Crawls

Scrapy is een compleet framework voor het crawlen van hele websites of duizenden pagina’s. Het werkt asynchroon (dus snel), ondersteunt pipelines voor het opschonen/opslaan van data en volgt automatisch links.

Voorbeeld:

1import scrapy

2class ProductSpider(scrapy.Spider):

3 name = "products"

4 start_urls = ["https://example.com/products"]

5 def parse(self, response):

6 for item in response.css('div.product'):

7 yield {

8 'name': item.css('h2::text').get(),

9 'price': item.css('span.price::text').get()

10 }Wanneer gebruiken: Grote projecten, geplande crawls, of als je snelheid en structuur nodig hebt.

Selenium: Voor Dynamische en JavaScript-Intensieve Websites

Selenium bestuurt een echte browser (zoals Chrome of Firefox), waardoor je sites kunt scrapen die data met JavaScript laden, inloggen vereisen of knoppen moeten aanklikken.

Voorbeeld:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://example.com/login")

5driver.find_element(By.NAME, "username").send_keys("myuser")

6driver.find_element(By.NAME, "password").send_keys("mypassword")

7driver.find_element(By.XPATH, "//button[@type='submit']").click()

8dashboard = driver.find_element(By.ID, "dashboard").text

9print(dashboard)

10driver.quit()Wanneer gebruiken: Social media, beurssites, infinite scroll of alles wat leeg lijkt als je ‘view source’ bekijkt.

Stapsgewijs: Gegevens van een Website Halen met Python (Beginner Tutorial)

Laten we een echt voorbeeld doorlopen met requests en BeautifulSoup. We scrapen een eenvoudige boekenwebsite voor titels, auteurs en prijzen.

Stap 1: Je Python Omgeving Inrichten

Installeer eerst de benodigde libraries:

1pip install requests beautifulsoup4 pandasImporteer ze vervolgens in je script:

1import requests

2from bs4 import BeautifulSoup

3import pandas as pdStap 2: Een Verzoek Sturen naar de Website

Haal de HTML op:

1url = "http://books.toscrape.com/catalogue/page-1.html"

2response = requests.get(url)

3if response.status_code == 200:

4 html = response.text

5else:

6 print(f"Pagina ophalen mislukt: {response.status_code}")Stap 3: HTML Inhoud Parssen

Maak een BeautifulSoup object aan:

1soup = BeautifulSoup(html, 'html.parser')Zoek alle boekcontainers:

1books = soup.find_all('article', class_='product_pod')

2print(f"{len(books)} boeken gevonden op deze pagina.")Stap 4: De Gegevens Uithalen die je Nodig Hebt

Loop door elk boek en verzamel de details:

1data = []

2for book in books:

3 title = book.h3.a['title']

4 price = book.find('p', class_='price_color').text

5 data.append({"Title": title, "Price": price})Stap 5: Data Opslaan voor Analyse

Zet om naar een DataFrame en sla op:

1df = pd.DataFrame(data)

2df.to_csv('books.csv', index=False)Nu heb je een nette CSV klaar voor analyse!

Tips bij Problemen:

- Krijg je lege resultaten? Check of de data met JavaScript wordt geladen (zie volgende sectie).

- Bekijk altijd de HTML-structuur met de dev tools van je browser.

- Ga slim om met ontbrekende data via

get_text(strip=True)en if-checks.

Omgaan met Dynamische Content: Data Halen van JavaScript-Rendered Websites

Moderne websites gebruiken vaak JavaScript. Soms staat de data die je zoekt niet direct in de HTML, maar wordt deze pas na het laden toegevoegd. Als je scraper niets vindt, heb je waarschijnlijk met dynamische content te maken.

Hoe los je dit op?

- Selenium: Simuleert een echte browser, wacht tot de content geladen is en kan knoppen aanklikken of scrollen.

- Playwright/Puppeteer: Geavanceerder, maar vergelijkbaar idee (headless browsers).

Mini Selenium Gids:

- Installeer Selenium en een browser driver (zoals ChromeDriver).

- Gebruik expliciete wachttijden zodat de content kan laden.

- Haal de gerenderde HTML op en parse eventueel met BeautifulSoup.

Voorbeeld:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.support.ui import WebDriverWait

4from selenium.webdriver.support import expected_conditions as EC

5driver = webdriver.Chrome()

6driver.get("https://example.com/dynamic")

7WebDriverWait(driver, 10).until(

8 EC.presence_of_element_located((By.CLASS_NAME, "dynamic-content"))

9)

10html = driver.page_source

11soup = BeautifulSoup(html, 'html.parser')

12# Data extraheren zoals eerder

13driver.quit()Wanneer heb je Selenium nodig?

- Als

requests.get()HTML zonder data oplevert, maar je het wel in je browser ziet. - Als de site infinite scroll, pop-ups of login vereist.

Webscraping Makkelijker Maken met AI: Gegevens Halen met Thunderbit

Eerlijk is eerlijk—soms wil je gewoon de data, niet de code. Daar komt om de hoek kijken. Thunderbit is een AI-webscraper voor Chrome waarmee je met een paar klikken data van elke website haalt—zonder Python.

Hoe werkt Thunderbit?

- Installeer de .

- Open de website waarvan je data wilt halen.

- Klik op het Thunderbit-icoon en kies “AI Suggest Fields.” Thunderbit’s AI scant de pagina en stelt voor welke data je kunt extraheren (zoals productnamen, prijzen, e-mails).

- Pas velden aan indien nodig en klik op “Scrape.”

- Exporteer je data direct naar Excel, Google Sheets, Notion of Airtable.

Waarom Thunderbit zo handig is:

- Geen code nodig. Zelfs mijn moeder kan het gebruiken (en die belt me nog voor wifi-problemen).

- Kan subpagina’s en paginering aan. Wil je productdetails van meerdere pagina’s? Thunderbit klikt door en voegt alles samen.

- Natuurlijke taal instructies. Zeg gewoon wat je wilt (“haal alle producttitels en prijzen op”) en de AI regelt het.

- Directe sjablonen voor populaire sites. Amazon, Zillow, LinkedIn en meer—met één klik klaar.

- Gratis data export. Download als CSV, Excel of stuur direct naar je favoriete tools.

Thunderbit wordt vertrouwd door meer dan , en met de gratis versie kun je tot 6 pagina’s scrapen (of 10 met een proefboost). Voor bedrijven is het een enorme tijdbespaarder—en voor techneuten een handige manier om snel te prototypen voordat je een eigen Python webscraper bouwt.

Na het Scrapen: Data Opschonen en Analyseren met Pandas en NumPy

Data ophalen is pas het begin. Rauwe webdata is vaak rommelig—dubbele rijen, ontbrekende waarden, vreemde formaten. Daar komen de Python libraries pandas en NumPy goed van pas.

Veelvoorkomende opschoontaken:

- Dubbele rijen verwijderen:

df.drop_duplicates(inplace=True) - Omgaan met ontbrekende waarden:

df.fillna('Onbekend')ofdf.dropna() - Datatypes omzetten:

df['Price'] = df['Price'].str.replace('$','').astype(float) - Datums parsen:

df['Date'] = pd.to_datetime(df['Date']) - Uitschieters filteren:

df = df[df['Price'] > 0]

Basisanalyse:

- Samenvattende statistieken:

df.describe() - Groeperen op categorie:

df.groupby('Category')['Price'].mean() - Snelle grafieken:

df['Price'].hist()ofdf.groupby('Category')['Price'].mean().plot(kind='bar')

Voor geavanceerdere berekeningen of snelle array-bewerkingen is NumPy ideaal. Maar voor de meeste zakelijke toepassingen is pandas meer dan voldoende.

Bronnen: Ben je nieuw met pandas? Check dan de gids.

Best Practices en Tips voor Succesvol Python Webscraping

Webscraping is krachtig, maar brengt ook verantwoordelijkheden met zich mee. Hier mijn checklist om professioneel (en netjes) te scrapen:

- Respecteer robots.txt en de gebruiksvoorwaarden. Check altijd of scrapen is toegestaan ().

- Overbelast servers niet. Voeg vertragingen toe tussen verzoeken (

time.sleep(2)) en scrape op menselijk tempo. - Gebruik realistische headers. Stel een User-Agent string in die een browser nabootst.

- Vang fouten netjes op. Gebruik try/except en probeer mislukte verzoeken opnieuw.

- Gebruik proxies indien nodig. Voor grootschalig scrapen kun je proxy pools inzetten om IP-blokkades te voorkomen.

- Wees ethisch en juridisch correct. Scrape geen persoonlijke data of content achter logins zonder toestemming.

- Documenteer je proces. Houd bij wat je hebt gescrapet, waar en wanneer.

- Gebruik officiële API’s als die er zijn. Soms is er een betere manier dan HTML scrapen.

Meer tips? Check de .

Conclusie & Belangrijkste Leerpunten

Webscraping met Python is een superkracht voor iedereen die van de chaos van het web gestructureerde, bruikbare data wil maken. Of je nu code gebruikt (requests, BeautifulSoup, Scrapy of Selenium) of een no-code tool als , je hebt alles in huis om gegevens van een website te halen en nieuwe inzichten te ontdekken.

Onthoud:

- Begin simpel—scrape eerst één pagina voordat je grote projecten aanpakt.

- Kies het juiste gereedschap (BeautifulSoup voor basis, Scrapy voor schaal, Selenium voor dynamische sites, Thunderbit voor no-code).

- Maak je data schoon en analyseer met pandas en NumPy.

- Scrape altijd verantwoord en ethisch.

Zelf proberen? Start met een klein project—scrape bijvoorbeeld de headlines van vandaag of een lijst met producten—en zie hoe snel je van een webpagina naar een nette spreadsheet gaat. En wil je geen code schrijven? en laat AI het werk doen.

Voor meer tutorials, tips en webscraping inspiratie, check de .

Veelgestelde Vragen

1. Wat is webscraping en waarom is Python hiervoor populair?

Webscraping is het automatisch verzamelen van data van websites. Python is hiervoor populair vanwege de leesbare syntax, krachtige libraries (zoals BeautifulSoup, Scrapy en Selenium) en de grote community ().

2. Welke Python library moet ik gebruiken voor webscraping?

Gebruik BeautifulSoup voor simpele, statische pagina’s; Scrapy voor grootschalige of multi-page crawls; en Selenium voor dynamische of JavaScript-rijke websites. Elke tool heeft zijn eigen sterke punten, afhankelijk van je doel ().

3. Hoe ga ik om met websites die data met JavaScript laden?

Voor content die met JavaScript wordt geladen, gebruik je Selenium (of Playwright) om een browser te simuleren en te wachten tot de data zichtbaar is. Soms kun je via de netwerktools een onderliggende API vinden.

4. Wat is Thunderbit en hoe maakt het webscraping eenvoudiger?

is een AI-webscraper voor Chrome waarmee je zonder code data van elke website haalt. De AI stelt velden voor, regelt subpagina’s en paginering, en exporteert direct naar Excel, Google Sheets, Notion of Airtable.

5. Hoe kan ik gescrapete data in Python opschonen en analyseren?

Gebruik pandas om dubbele rijen te verwijderen, ontbrekende waarden te verwerken, datatypes om te zetten en analyses uit te voeren. NumPy is handig voor numerieke bewerkingen. Voor visualisaties kun je met pandas snel grafieken maken, bijvoorbeeld met Matplotlib ().

Veel succes met scrapen—en moge je data altijd schoon, gestructureerd en klaar voor gebruik zijn.

Meer weten