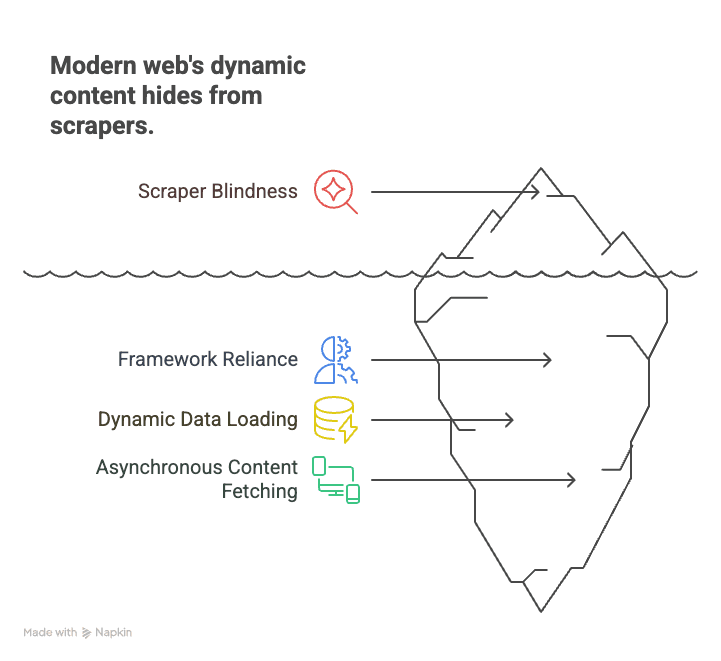

Heb je ooit geprobeerd om data te verzamelen van een moderne website—denk aan een vastgoedsite, een webshop of zelfs je favoriete social media feed—en liep je vast? Je laadt de pagina, checkt de HTML, en... niks. De info die je zoekt (prijzen, aanbiedingen, reviews) is nergens te vinden. Dat komt omdat het web tegenwoordig niet meer alleen uit HTML bestaat—bijna 99% van alle websites gebruikt JavaScript om content te tonen (). Klassieke crawlers zijn net als het lezen van een filmscript zonder de film te kijken—je mist alles wat er live gebeurt.

Na jaren in SaaS en automatisering heb ik gezien hoe deze ontwikkeling veel zakelijke gebruikers, sales teams en onderzoekers voor raadsels stelt. Maar er is goed nieuws: javascript crawling is niet langer alleen voor developers. Met de juiste aanpak (en een beetje hulp van AI-tools zoals ) kan iedereen data halen uit zelfs de meest dynamische en interactieve websites. In deze gids leg ik uit wat javascript crawling is, waarom het belangrijk is, en hoe je ermee aan de slag kunt—zonder te hoeven programmeren.

Wat is JavaScript Crawling? En waarom is het essentieel voor moderne webdata?

Laten we bij het begin beginnen. javascript crawling betekent dat je een tool of bot gebruikt die een webpagina volledig laadt, alle JavaScript uitvoert, en vervolgens de content verzamelt die na het uitvoeren van de scripts zichtbaar wordt. Dit is een enorme stap vooruit ten opzichte van ouderwets HTML-scrapen, waarbij je alleen de ruwe broncode van de server ophaalt. Op moderne websites is die HTML vaak slechts een skelet—de echte inhoud (producten, reviews, prijzen) wordt pas door JavaScript toegevoegd, soms pas na scrollen, klikken of andere interactie.

Waarom is dit belangrijk? Omdat het hedendaagse web draait op frameworks als React, Angular en Vue. Deze single-page applicaties (SPA's) laden data dynamisch, waardoor statische scrapers het grootste deel van de inhoud missen. Bijvoorbeeld:

- E-commerce: Prijzen en voorraad verschijnen pas na scrollen of het kiezen van een filter.

- Vastgoed: Woningen worden pas zichtbaar als je naar beneden scrolt, met details die live worden geladen.

- Social media: Berichten, reacties en likes worden asynchroon opgehaald en staan niet in de initiële HTML.

Klassieke crawlers zien alleen een lege pagina en missen alles wat ertoe doet. javascript crawling werkt juist als een echte browser: je opent de pagina, laat alle scripts draaien, en verzamelt wat je ziet—precies zoals een mens dat zou doen.

Kortom: Wil je in 2025 data verzamelen van bijna elke moderne website, dan moet je javascript crawling beheersen. Anders mis je het grootste deel van de informatie ().

Belangrijkste uitdagingen bij JavaScript Crawling (en hoe je ze oplost)

javascript crawling is niet simpelweg "scrapen met een extra stapje". Het brengt zijn eigen uitdagingen met zich mee. Dit zijn de grootste obstakels—en zo pak je ze aan.

Dynamische Content Rendering

Het probleem: De meeste content staat niet in de HTML. Die wordt pas via JavaScript geladen nadat de pagina geopend is—soms pas na scrollen, klikken of een netwerkverzoek. Haal je alleen de HTML op, dan krijg je lege containers of tijdelijke placeholders.

De oplossing: Gebruik een headless browser—een tool die een echte browser nabootst, alle scripts uitvoert en wacht tot de content zichtbaar is. Tools als en zijn hier de standaard. Hiermee kun je:

- Een pagina openen en JavaScript laten draaien.

- Wachten tot specifieke elementen geladen zijn (zoals “.product-list”).

- De volledig weergegeven content uit de DOM halen.

Deze aanpak is nu de norm voor het scrapen van dynamische websites ().

Anti-botmaatregelen en automatiseringsblokkades

Het probleem: Websites worden steeds slimmer in het herkennen en blokkeren van bots. Je kunt onder andere tegenkomen:

- CAPTCHAs

- IP-blokkades of limieten op het aantal verzoeken

- Browser fingerprinting (controleren of je een echte gebruiker bent)

- Honeypots (neplinkjes om bots te vangen)

De oplossing: Scrape verantwoord en boots menselijk gedrag na:

- Respecteer robots.txt en de gebruiksvoorwaarden.

- Vertraag je verzoeken—voeg willekeurige pauzes toe, overbelast de server niet.

- Wissel van IP-adres als je op grote schaal scrapt (maar doe dit ethisch).

- Gebruik echte browserheaders en vermijd duidelijke botsignalen.

- Scrape niet achter logins en omzeil geen CAPTCHAs zonder toestemming.

Thunderbit moedigt gebruikers aan om alleen publiek toegankelijke data te scrapen en verwerkt best practices voor naleving standaard in het platform ().

Oneindig scrollen en gebruikersacties

Het probleem: Veel sites gebruiken oneindig scrollen of vereisen klikken om meer data te laden. Als je scraper alleen de eerste zichtbare content pakt, mis je het grootste deel van de data.

De oplossing: Gebruik browserautomatisering om:

- Scrollen te simuleren (meer resultaten laden zoals een gebruiker zou doen).

- “Laad meer”-knoppen of tabbladen aan te klikken.

- Wachten tot nieuwe content verschijnt voordat je data verzamelt.

De AI van Thunderbit herkent deze patronen en regelt scrollen of paginering automatisch, zodat je geen eigen scripts hoeft te schrijven ().

Prestaties en schaalbaarheid behouden

Het probleem: Voor elke pagina een headless browser draaien kost veel rekenkracht. Honderden of duizenden pagina’s scrapen is traag en zwaar voor je computer.

De oplossing: Gebruik gelijktijdig crawlen—meerdere browsers of tabbladen tegelijk. Of nog beter: laat het zware werk over aan de cloud. Thunderbit’s cloud scraping accelerator (ook wel Lightning Network) kan tot 50 pagina’s tegelijk verwerken, waardoor grote klussen veel sneller gaan ().

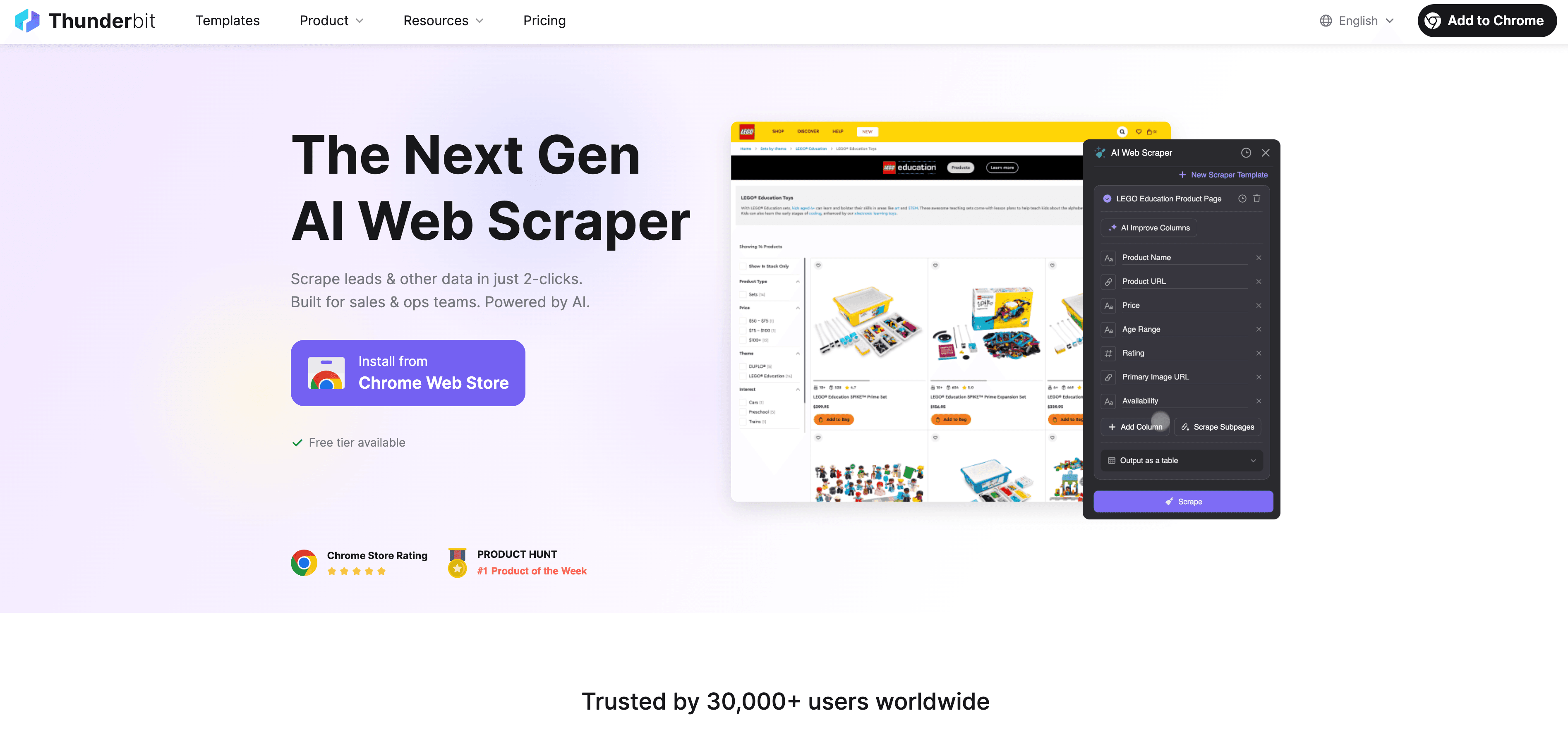

Thunderbit: JavaScript Crawling eenvoudig en krachtig maken

Laten we eerlijk zijn: de meeste zakelijke gebruikers willen geen code schrijven, selectors debuggen of scripts in de gaten houden. Daarom hebben we ontwikkeld—een AI-webscraper speciaal voor niet-developers die data willen uit dynamische, JavaScript-rijke websites.

Zo maakt Thunderbit javascript crawling makkelijk:

- AI Suggest Fields: Klik op “AI Suggest Fields” en Thunderbit’s AI scant de pagina, stelt de beste kolommen voor en kiest automatisch de juiste gegevenstypen. Geen giswerk meer.

- Natuurlijke taal extractie: Beschrijf in gewone taal wat je wilt (“Haal productnaam, prijs en beoordeling op”) en Thunderbit regelt de rest.

- Dynamische content verwerken: Thunderbit draait in een echte browser (lokaal of in de cloud), voert alle JavaScript uit en wacht tot de content geladen is—net als een mens.

- Subpagina’s & paginering: Meerdere pagina’s of subpagina’s (zoals productdetails) scrapen? Thunderbit doet dit automatisch en voegt alles samen in één tabel.

- Cloud versnelling: Voor grote klussen verwerkt Thunderbit’s Lightning Network tot 50 pagina’s tegelijk in de cloud, zodat je computer niet overbelast raakt.

- No-code, gebruiksvriendelijke interface: Als je met Excel overweg kunt, kun je ook met Thunderbit werken. Alles werkt via aanwijzen en klikken, zonder technische installatie.

- Gratis data exporteren: Exporteer je data naar Excel, Google Sheets, Airtable, Notion of JSON—zonder extra kosten.

Thunderbit wordt wereldwijd vertrouwd door meer dan 30.000 gebruikers, van sales tot e-commerce en vastgoed ().

AI Suggest Fields & Natuurlijke Taal Extractie

Hier blinkt Thunderbit echt uit. In plaats van zelf in de HTML te zoeken of XPath-selectors te schrijven, klik je gewoon op een knop en doet de AI het zware werk. Thunderbit leest de pagina, begrijpt de structuur en stelt precies voor wat je moet verzamelen. Wil je iets specifieks? Typ het in gewone taal—de AI koppelt je verzoek aan de juiste elementen.

Dit is een doorbraak voor beginners. Je hoeft niets te weten van HTML, CSS of JavaScript. Gewoon aangeven wat je wilt, en de AI regelt de rest ().

Paginering en subpagina’s scrapen

Thunderbit is niet beperkt tot één pagina. Je kunt:

- Paginering automatisch herkennen en verwerken (zoals “Volgende” aanklikken of scrollen voor meer resultaten).

- Subpagina’s scrapen (zoals productdetails, auteursprofielen of reviews) en de data samenvoegen in je hoofd-tabel.

- Oneindig scrollen aan door gebruikersacties te simuleren, zodat je alle data krijgt, niet alleen wat eerst zichtbaar is.

Bijvoorbeeld: een e-commerce categorie met 20 pagina’s producten scrapen? Thunderbit klikt automatisch door alle pagina’s en combineert de resultaten. Details van elke productpagina nodig? Gebruik subpagina-scraping en Thunderbit bezoekt elke link, haalt de extra info op en verrijkt je dataset ().

Lightning Network & Cloud Versnelling: JavaScript Crawling op schaal

Moet je honderden of duizenden pagina’s scrapen, dan is handmatig geen optie. Hier komt Thunderbit’s Lightning Network van pas.

- Cloud scraping: Laat het zware werk over aan Thunderbit’s cloudservers (in de VS, EU en Azië). De cloud verwerkt tot 50 pagina’s tegelijk, waardoor grote klussen razendsnel gaan.

- Gelijktijdig crawlen: In plaats van te wachten tot elke pagina in je browser laadt, verdeelt Thunderbit de klus over veel cloudwerkers. 1.000 productpagina’s scrapen? De cloud is in minuten klaar, niet in uren.

- Geplande scraping: Prijzen of aanbiedingen dagelijks monitoren? Stel een geplande scrape in gewone taal in (“elke dag om 9:00 uur”) en Thunderbit voert de taak automatisch uit, met export naar je Google Sheet of database ().

Dit is ideaal voor sales, e-commerce en operationele teams die op grote schaal actuele data nodig hebben—zonder developers of eigen servers.

Meerdere pagina’s en bulkdata verzamelen

Met Thunderbit kun je eenvoudig:

- Hele directories of catalogi scrapen (bijvoorbeeld alle producten in een categorie, alle aanbiedingen in een regio).

- Resultaten exporteren naar Excel, Google Sheets, Airtable of Notion met één klik.

- Uren (of dagen) handmatig werk besparen—een gebruiker verzamelde honderden vastgoedaanbiedingen, inclusief makelaarsgegevens, in minder dan 10 minuten.

Stapsgewijze handleiding: Zo start je met JavaScript Crawling in Thunderbit

Wil je het zelf proberen? Zo begin je met Thunderbit—ook als je nog nooit een website hebt gescrapet.

Je eerste crawl instellen

- Installeer Thunderbit: Download de . Maak gratis een account aan.

- Kies je doelwit: Navigeer naar de website die je wilt scrapen. Is inloggen nodig, doe dat dan eerst (Thunderbit werkt in je eigen browser).

- Open Thunderbit: Klik op het Thunderbit-icoon in je Chrome-toolbar. Kies je gegevensbron (huidige pagina, lijst met URL’s of upload een bestand).

- Kies de uitvoermodus: Voor kleine klussen of sites met login gebruik je Browsermodus. Voor grote klussen schakel je over naar Cloudmodus voor parallelle scraping.

- AI Suggest Fields: Klik op “AI Suggest Fields”. Thunderbit’s AI scant de pagina en stelt kolommen voor (zoals “Productnaam”, “Prijs”, “Afbeeldings-URL”).

- Kolommen aanpassen: Hernoem, voeg toe of verwijder velden naar wens. Voeg eventueel AI-instructies toe om data te formatteren of te categoriseren.

- Paginering/scrollen instellen: Gebruikt de site paginering of oneindig scrollen? Zet de juiste optie aan in Thunderbit.

- Klik op “Scrape”: Thunderbit laadt de pagina(’s), voert alle JavaScript uit en zet de data in een tabel.

Data bekijken en exporteren

- Resultaten bekijken: Thunderbit toont je data in een tabel. Controleer of alles compleet en correct is.

- Exporteren: Klik op “Exporteren” om te downloaden als Excel, CSV, JSON, of stuur direct naar Google Sheets, Airtable of Notion.

- Controleren: Vergelijk een paar rijen met de live site om te checken of alles klopt.

- Problemen oplossen: Mis je data? Probeer eerst te scrollen, pas de AI-instructies aan, of schakel over naar Cloudmodus voor betere prestaties.

Voor meer uitleg, bekijk de of het .

Best practices voor veilig en verantwoord JavaScript Crawling

Met grote scraping-mogelijkheden komt ook grote verantwoordelijkheid. Zo blijf je binnen de regels (en ethiek):

- Respecteer robots.txt en de gebruiksvoorwaarden: Controleer altijd of de site scraping toestaat. Staat er “geen bots”, respecteer dat dan ().

- Vermijd het scrapen van persoonsgegevens: GDPR en CCPA beschermen namen, e-mails en profielen—ook als ze openbaar zijn. Verzamel alleen persoonlijke info als je een legitieme reden en toestemming hebt.

- Omzeil geen logins of CAPTCHAs: Dat is juridisch grijs gebied (of erger). Blijf bij openbare data.

- Vertraag je verzoeken: Overbelast servers niet. Thunderbit’s cloudmodus spreidt verzoeken en roteert IP’s om blokkades te voorkomen.

- Gebruik data ethisch: Publiceer geen auteursrechtelijk beschermde content en misbruik geen verzamelde info.

- Verwijder op verzoek: Vraagt iemand om zijn data te verwijderen, doe dat dan direct.

Thunderbit is ontworpen om naleving te stimuleren—alleen openbare data, geen hacking, en duidelijke exportopties voor verantwoord gebruik.

Juridische risico’s vermijden

- Blijf bij openbare, niet-persoonlijke data.

- Scrape geen sites die het expliciet verbieden.

- Twijfel je? Vraag toestemming of gebruik de officiële API.

- Houd bij wat je wanneer hebt gescrapet.

- Geef direct gehoor aan verzoeken om te stoppen.

Meer weten? Lees .

JavaScript Crawling vergelijken: Thunderbit vs. traditionele tools

| Aspect | Puppeteer/Playwright (Code) | Sitebulb (SEO Crawler) | Thunderbit (AI No-Code) |

|---|---|---|---|

| Installatietijd | Uren (coderen vereist) | Gemiddeld (configuratie) | Minuten (wijzen & klikken) |

| Vereiste kennis | Hoog (alleen developers) | Gemiddeld | Laag (iedereen) |

| JavaScript-content verwerken | Ja (handmatig scripten) | Ja (voor SEO) | Ja (AI, automatisch) |

| Paginering/subpagina’s | Handmatig scripten | Beperkt | Automatisch (AI herkent) |

| Onderhoud | Hoog (breekt bij wijzigingen) | Gemiddeld | Laag (AI past zich aan) |

| Schaalbaarheid | Handmatig (code schrijven) | Beperkt | Ingebouwde cloud (50x) |

| Exportopties | Handmatig (code schrijven) | CSV/Excel | Excel, Sheets, Notion |

| Ideaal voor | Developers, maatwerk | SEO-audits | Zakelijke gebruikers, analisten |

Thunderbit is de duidelijke winnaar voor zakelijke gebruikers die snel resultaat willen, zonder technische rompslomp ().

Samenvatting & belangrijkste punten

javascript crawling is geen nichevaardigheid meer—het is onmisbaar voor iedereen die in 2025 webdata nodig heeft. Bijna 99% van de websites draait op client-side scripts, dus klassiek scrapen werkt simpelweg niet meer (). Het goede nieuws? Je hoeft geen developer te zijn om het te leren.

Onthoud vooral:

- Dynamische content is overal: Wil je moderne sites scrapen, dan heb je een tool nodig die JavaScript uitvoert.

- Uitdagingen zijn er, maar zijn oplosbaar: Headless browsers, slim wachten en cloudversnelling maken zelfs de lastigste data bereikbaar.

- Thunderbit maakt het eenvoudig: Met AI-veldherkenning, natuurlijke taal, subpagina- en pagineringsondersteuning en cloudversnelling kan iedereen krachtige javascript crawling inzetten.

- Blijf compliant: Respecteer altijd de regels van de site, privacywetgeving en ethische richtlijnen.

- Begin vandaag nog: Installeer Thunderbit, kies een site en ontdek hoeveel data je met een paar klikken kunt verzamelen.

Meer weten? Bekijk de voor meer handleidingen, of onze voor stap-voor-stap demo’s.

Veel succes met crawlen—en moge je data altijd dynamisch, compleet en klaar voor gebruik zijn.

Veelgestelde vragen

1. Wat is javascript crawling en hoe verschilt het van traditioneel scrapen?

javascript crawling gebruikt een tool die een webpagina laadt, alle JavaScript uitvoert en de content verzamelt die daarna zichtbaar wordt. Traditioneel scrapen haalt alleen de ruwe HTML op en mist zo het grootste deel van de data op moderne sites.

2. Waarom heb ik javascript crawling nodig voor zakelijke data?

Omdat vrijwel alle moderne websites JavaScript gebruiken om content dynamisch te laden. Zonder javascript crawling mis je productlijsten, reviews, prijzen en andere belangrijke data.

3. Hoe maakt Thunderbit javascript crawling makkelijk voor beginners?

Thunderbit gebruikt AI om velden voor te stellen, dynamische content te verwerken en paginering en subpagina’s te automatiseren. Je kunt in gewone taal aangeven wat je wilt—coderen is niet nodig.

4. Is javascript crawling legaal? Waar moet ik op letten?

javascript crawling is legaal als je het verantwoord doet—blijf bij openbare data, respecteer robots.txt en de gebruiksvoorwaarden, en verzamel geen persoonlijke info zonder toestemming. Thunderbit stimuleert naleving en verantwoord gebruik.

5. Hoe schaal ik javascript crawling op voor grote klussen?

Met Thunderbit’s Lightning Network (cloud scraping) kun je tot 50 pagina’s tegelijk scrapen, ideaal voor grote projecten zoals prijsmonitoring of leadgeneratie over duizenden pagina’s.

Meer weten: